Bezpieczeństwo cybernetyczne

Jak zabezpieczyć dane treningowe AI

Sztuczna inteligencja (AI) potrzebuje danych, i to mnóstwa. Zebranie niezbędnych informacji nie zawsze jest wyzwaniem w dzisiejszym środowisku, z wieloma dostępnymi publicznymi zestawami danych i tak dużą ilością danych generowanych każdego dnia. Zabezpieczenie ich to jednak inna sprawa.

Ogromny rozmiar zestawów danych szkoleniowych AI i wpływ modeli AI przyciągają uwagę cyberprzestępców. Wraz ze wzrostem zależności od AI zespoły rozwijające tę technologię powinny zachować ostrożność, aby zapewnić bezpieczeństwo swoich danych szkoleniowych.

Dlaczego dane szkoleniowe AI wymagają lepszego zabezpieczenia

Dane, których używasz do trenowania modelu AI, mogą odzwierciedlać osoby, firmy lub wydarzenia ze świata rzeczywistego. W związku z tym możesz zarządzać znaczną ilością danych osobowych (PII), co spowodowałoby poważne naruszenia prywatności w przypadku ujawnienia. W 2023 r. Microsoft doświadczył takiego incydentu, przypadkowo ujawniając 38 terabajtów prywatnych informacji podczas projektu badawczego dotyczącego sztucznej inteligencji.

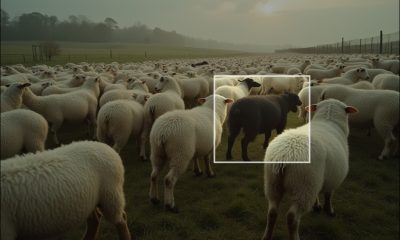

Zestawy danych szkoleniowych AI mogą być również podatne na bardziej szkodliwe ataki przeciwników. Cyberprzestępcy mogą zmienić niezawodność modelu uczenia maszynowego, manipulując jego danymi szkoleniowymi, jeśli uzyskają do nich dostęp. Jest to typ ataku znany jako zatruwanie danych, a twórcy AI mogą nie zauważyć efektów, dopóki nie będzie za późno.

Badania pokazują, że zatrucie zaledwie 0.001% zbioru danych wystarczy, aby zepsuć model AI. Bez odpowiednich zabezpieczeń atak taki jak ten może prowadzić do poważnych konsekwencji, gdy model zostanie wdrożony w świecie rzeczywistym. Na przykład uszkodzony algorytm autonomicznej jazdy może nie zauważyć pieszych. Alternatywnie, narzędzie AI skanujące CV może generować stronnicze wyniki.

W mniej poważnych okolicznościach atakujący mogliby ukraść zastrzeżone informacje z zestawu danych szkoleniowych w akcie szpiegostwa przemysłowego. Mogą również zablokować autoryzowanym użytkownikom dostęp do bazy danych i zażądać okupu.

Ponieważ AI staje się coraz ważniejsza dla życia i biznesu, cyberprzestępcy mogą zyskać więcej, atakując bazy danych szkoleniowych. Wszystkie te zagrożenia stają się z kolei dodatkowo niepokojące.

5 kroków do zabezpieczenia danych szkoleniowych AI

W świetle tych zagrożeń, traktuj bezpieczeństwo poważnie podczas trenowania modeli AI. Oto pięć kroków, które należy wykonać, aby zabezpieczyć dane treningowe AI.

1. Minimalizuj poufne informacje w zestawach danych szkoleniowych

Jednym z najważniejszych środków jest usunięcie ilości poufnych szczegółów z zestawu danych treningowych. Im mniej PII lub innych cennych informacji znajduje się w bazie danych, tym mniejszym celem dla hakerów jest naruszony. Naruszenie będzie również mniej dotkliwe, jeśli wystąpi w tych scenariuszach.

Modele AI często nie muszą korzystać z informacji ze świata rzeczywistego w fazie szkolenia. Dane syntetyczne są cenną alternatywą. Modele trenowane na danych syntetycznych mogą być tak jakby nie dokładniej niż inne, więc nie musisz się martwić o problemy z wydajnością. Upewnij się tylko, że wygenerowany zestaw danych przypomina i działa jak dane ze świata rzeczywistego.

Alternatywnie możesz wyczyścić istniejące zestawy danych z poufnych szczegółów, takich jak nazwiska osób, adresy i informacje finansowe. Jeśli takie czynniki są niezbędne dla Twojego modelu, rozważ zastąpienie ich danymi zastępczymi lub zamianę ich między rekordami.

2. Ogranicz dostęp do danych szkoleniowych

Po skompilowaniu zestawu danych treningowych musisz ograniczyć do niego dostęp. Postępuj zgodnie z zasadą najmniejszych uprawnień, która mówi, że każdy użytkownik lub program powinien mieć dostęp tylko do tego, co jest niezbędne do prawidłowego wykonania zadania. Każdy, kto nie jest zaangażowany w proces treningowy, nie musi widzieć ani wchodzić w interakcję z bazą danych.

Pamiętaj, że ograniczenia uprawnień są skuteczne tylko wtedy, gdy wdrożysz również niezawodny sposób weryfikacji użytkowników. Nazwa użytkownika i hasło nie wystarczą. Uwierzytelnianie wieloskładnikowe (MFA) jest niezbędne, ponieważ zatrzymuje 80% do 90% wszystkich ataków przeciwko kontom, ale nie wszystkie metody MFA są sobie równe. MFA oparte na tekście i aplikacji jest ogólnie bezpieczniejsze niż alternatywy oparte na e-mailu.

Pamiętaj, aby ograniczyć oprogramowanie i urządzenia, a nie tylko użytkowników. Jedynymi narzędziami z dostępem do bazy danych treningowych powinien być sam model AI i wszelkie programy, których używasz do zarządzania tymi spostrzeżeniami podczas treningu.

3. Szyfruj i twórz kopie zapasowe danych

Szyfrowanie to kolejny kluczowy środek ochronny. Chociaż nie wszystkie algorytmy uczenia maszynowego mogą aktywnie trenować na zaszyfrowanych danych, możesz je szyfrować i odszyfrowywać podczas analizy. Następnie możesz je ponownie zaszyfrować po zakończeniu. Alternatywnie, zajrzyj do struktur modeli, które mogą analizować informacje podczas szyfrowania.

Ważne jest przechowywanie kopii zapasowych danych treningowych na wypadek, gdyby coś się z nimi stało. Kopie zapasowe powinny znajdować się w innym miejscu niż kopia główna. W zależności od tego, jak krytyczny jest Twój zestaw danych, może być konieczne przechowywanie jednej kopii zapasowej offline i jednej w chmurze. Pamiętaj również o szyfrowaniu wszystkich kopii zapasowych.

Jeśli chodzi o szyfrowanie, wybieraj metodę ostrożnie. Wyższe standardy są zawsze lepsze, ale możesz rozważyć algorytmy kryptografii odporne na kwantowe ataki, ponieważ rośnie zagrożenie atakami kwantowymi.

4. Monitoruj dostęp i użytkowanie

Nawet jeśli wykonasz te inne kroki, cyberprzestępcy mogą przełamać Twoje zabezpieczenia. W związku z tym musisz stale monitorować wzorce dostępu i użytkowania za pomocą danych szkoleniowych AI.

Rozwiązanie do automatycznego monitorowania jest prawdopodobnie tutaj konieczne, ponieważ niewiele organizacji ma personel, który może obserwować podejrzane działania przez całą dobę. Automatyzacja jest również znacznie szybsza w działaniu, gdy dzieje się coś niezwykłego, co prowadzi do O 2.22 USD niższe koszty naruszenia danych średnio dzięki szybszym i skuteczniejszym reakcjom.

Rejestruj każdą sytuację, gdy ktoś lub coś uzyskuje dostęp do zestawu danych, żąda dostępu do niego, zmienia go lub w inny sposób wchodzi z nim w interakcję. Oprócz obserwowania potencjalnych naruszeń w tej aktywności, regularnie przeglądaj ją pod kątem większych trendów. Zachowanie autoryzowanych użytkowników może się zmieniać w czasie, co może wymagać zmiany uprawnień dostępu lub biometrii behawioralnej, jeśli używasz takiego systemu.

5. Regularnie dokonuj ponownej oceny ryzyka

Podobnie zespoły programistów AI muszą zdać sobie sprawę, że cyberbezpieczeństwo to ciągły proces, a nie jednorazowa naprawa. Metody ataków ewoluują szybko — niektóre luki i zagrożenia mogą prześlizgnąć się przez szpary, zanim je zauważysz. Jedynym sposobem na zachowanie bezpieczeństwa jest regularna ponowna ocena postawy bezpieczeństwa.

Przynajmniej raz w roku przejrzyj swój model AI, jego dane treningowe i wszelkie incydenty bezpieczeństwa, które wpłynęły na którykolwiek z nich. Przeprowadź audyt zestawu danych i algorytmu, aby upewnić się, że działa on prawidłowo i nie ma w nim żadnych zatrutych, wprowadzających w błąd lub w inny sposób szkodliwych danych. Dostosuj swoje kontrole bezpieczeństwa w razie potrzeby do wszelkich nietypowych zdarzeń, które zauważysz.

Testy penetracyjne, w których eksperci ds. bezpieczeństwa testują Twoje zabezpieczenia, próbując je przełamać, są również korzystne. Wszystko oprócz 17% specjalistów ds. cyberbezpieczeństwa przeprowadzają testy penetracyjne przynajmniej raz w roku, a 72% z nich, które to robią, uważa, że zapobiegło to naruszeniu bezpieczeństwa w ich organizacji.

Cyberbezpieczeństwo jest kluczem do bezpiecznego rozwoju sztucznej inteligencji

Etyczny i bezpieczny rozwój AI staje się coraz ważniejszy, ponieważ potencjalne problemy związane z poleganiem na uczeniu maszynowym stają się coraz bardziej widoczne. Zabezpieczenie bazy danych treningowych jest kluczowym krokiem w zaspokojeniu tego zapotrzebowania.

Dane szkoleniowe AI są zbyt cenne i podatne na zignorowanie cyberzagrożeń. Wykonaj dziś pięć poniższych kroków, aby zapewnić bezpieczeństwo swojemu modelowi i jego zestawowi danych.