Robotyka

Jak roboty uczą się prosić o pomoc

W rozwijającym się świecie robotyki wyróżnia się przełomowa współpraca pomiędzy Uniwersytetem Princeton i Google. Inżynierowie z tych prestiżowych instytucji opracowali innowacyjną metodę, która uczy roboty kluczowej umiejętności: rozpoznawania, kiedy potrzebują pomocy i tego, jak o nią poprosić. Rozwój ten oznacza znaczący krok naprzód w robotyce, wypełniając lukę między autonomicznym funkcjonowaniem a interakcją człowiek-robot.

Podróż w kierunku bardziej inteligentnych i niezależnych robotów zawsze była utrudniana przez jedno istotne wyzwanie: złożoność i niejednoznaczność ludzkiego języka. W przeciwieństwie do binarnej przejrzystości kodów komputerowych, język ludzki jest pełen niuansów i subtelności, co czyni go labiryntem dla robotów. Na przykład polecenie tak proste, jak „podnieś miskę”, może stać się skomplikowanym zadaniem, gdy dostępnych jest wiele misek. Roboty, wyposażone do wyczuwania otoczenia i reagowania na język, często znajdują się na rozdrożu w obliczu takich niepewności językowych.

Kwantyfikacja niepewności

Aby sprostać temu wyzwaniu, zespół Princeton i Google wprowadził nowatorskie podejście, które pozwala ilościowo określić „niejasność” ludzkiego języka. Technika ta zasadniczo mierzy poziom niepewności poleceń językowych i wykorzystuje tę metrykę do kierowania działaniami robota. W sytuacjach, w których polecenie może prowadzić do wielu interpretacji, robot może teraz ocenić poziom niepewności i zdecydować, kiedy zwrócić się o dalsze wyjaśnienia. Na przykład w środowisku z wieloma misami wyższy stopień niepewności może skłonić robota do zapytania, którą miskę podnieść, unikając w ten sposób potencjalnych błędów lub nieefektywności.

Takie podejście nie tylko umożliwia robotom lepsze zrozumienie języka, ale także zwiększa ich bezpieczeństwo i wydajność w wykonywaniu zadań. Integrując duże modele językowe (LLM), takie jak te stojące za ChatGPT, badacze zrobili znaczący krok w kierunku lepszego dostosowania działań robotów do ludzkich oczekiwań i potrzeb.

Rola modeli wielkojęzykowych

Integracja LLM odgrywa kluczową rolę w tym nowym podejściu. LLM odgrywają kluczową rolę w przetwarzaniu i interpretowaniu ludzkiego języka. W tym kontekście służą one do oceny i pomiaru niepewności występującej w poleceniach językowych wydawanych robotom.

Jednak poleganie na LLM nie jest pozbawione wyzwań. Jak zauważył zespół badawczy, wyniki programów LLM mogą czasami być niewiarygodne.

Anirudha Majumdar, adiunkt w Princeton, podkreśla znaczenie tej równowagi:

„Ślepe podążanie za planami wygenerowanymi przez LLM może spowodować, że roboty będą działać w niebezpieczny lub niegodny zaufania sposób, dlatego potrzebujemy, aby nasze roboty oparte na LLM wiedziały, kiedy nie wiedzą”.

Podkreśla to konieczność stosowania zróżnicowanego podejścia, w którym LLM wykorzystuje się jako narzędzia wskazówek, a nie nieomylnych decydentów.

Praktyczne zastosowanie i testowanie

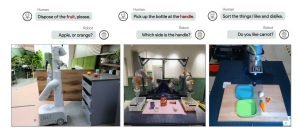

Praktyczność tej metody została przetestowana w różnych scenariuszach, ilustrując jej wszechstronność i skuteczność. Jeden z takich testów obejmował ramię robota, którego zadaniem było sortowanie zabawkowych artykułów spożywczych na różne kategorie. Ta prosta konfiguracja wykazała zdolność robota do skutecznego poruszania się po zadaniach przy użyciu jednoznacznych wyborów.

Zdjęcie: Uniwersytet Princeton

Złożoność znacznie wzrosła w innym eksperymencie obejmującym ramię robota zamontowane na platformie na kółkach w biurowej kuchni. W tym przypadku robot musiał stawić czoła wyzwaniom w świecie rzeczywistym, takim jak zidentyfikowanie odpowiedniego przedmiotu do umieszczenia w kuchence mikrofalowej, gdy przedstawiono mu wiele opcji.

Dzięki tym testom roboty z powodzeniem wykazały zdolność do wykorzystywania ilościowej niepewności do podejmowania decyzji lub szukania wyjaśnień, potwierdzając w ten sposób praktyczną użyteczność tej metody.

Przyszłe implikacje i badania

Patrząc w przyszłość, implikacje tych badań wykraczają daleko poza obecne zastosowania. Zespół kierowany przez Majumdara i absolwenta Allena Rena bada, w jaki sposób można zastosować to podejście do bardziej złożonych problemów związanych z percepcją robotów i sztuczną inteligencją. Obejmuje to scenariusze, w których roboty muszą łączyć informacje dotyczące wzroku i języka, aby podejmować decyzje, co jeszcze bardziej zmniejsza lukę między rozumieniem przez roboty a interakcją między ludźmi.

Trwające badania mają na celu nie tylko zwiększenie zdolności robotów do wykonywania zadań z większą dokładnością, ale także poruszania się po świecie ze zrozumieniem zbliżonym do ludzkiego poznania. Badania te mogą utorować drogę robotom, które będą nie tylko wydajniejsze i bezpieczniejsze, ale także lepiej dostosowane do zróżnicowanych wymagań środowiska ludzkiego.

Można znaleźć opublikowane badania tutaj.