Artificial Intelligence

AnimateLCM: przyspieszenie animacji spersonalizowanych modeli dyfuzji

W ciągu ostatnich kilku lat modele dyfuzyjne odniosły ogromny sukces i uznanie w zadaniach związanych z generowaniem obrazu i wideo. W szczególności modele dyfuzji wideo cieszą się dużym zainteresowaniem ze względu na ich zdolność do tworzenia filmów o wysokiej spójności i wierności. Modele te generują wysokiej jakości filmy dzięki zastosowaniu w swojej architekturze iteracyjnego procesu odszumiania, który stopniowo przekształca wielowymiarowy szum Gaussa w rzeczywiste dane.

Stable Diffusion to jeden z najbardziej reprezentatywnych modeli do zadań związanych z generowaniem obrazu, wykorzystujący autoenkoder wariacyjny (VAE) do mapowania rzeczywistego obrazu i ukrytych cech o zmniejszonej próbce. Pozwala to modelowi obniżyć koszty generowania, a mechanizm wzajemnej uwagi w jego architekturze ułatwia generowanie obrazu uwarunkowanego tekstem. Niedawno platforma Stable Diffusion stworzyła podstawę dla kilku adapterów typu plug-and-play, umożliwiających bardziej innowacyjne i efektywne generowanie obrazu lub wideo. Jednakże iteracyjny proces generowania stosowany w większości modeli dyfuzji wideo sprawia, że proces generowania obrazu jest czasochłonny i stosunkowo kosztowny, co ogranicza jego zastosowania.

W tym artykule omówimy AnimateLCM, spersonalizowany model rozpowszechniania z adapterami, którego celem jest generowanie filmów o wysokiej jakości przy minimalnych krokach i kosztach obliczeniowych. Struktura AnimateLCM jest inspirowana modelem spójności, który przyspiesza próbkowanie w minimalnych krokach poprzez wyodrębnienie wstępnie wyszkolonych modeli dyfuzji obrazu. Co więcej, pomyślne rozszerzenie modelu spójności, modelu spójności ukrytej (LCM), ułatwia warunkowe generowanie obrazu. Zamiast uczyć się spójności bezpośrednio na surowym zestawie danych wideo, środowisko AnimateLCM proponuje zastosowanie strategii uczenia się spójności oddzielonej od sprzężenia. Strategia ta oddziela destylację priorytetów generowania ruchu od priorytetów generowania obrazu, umożliwiając modelowi poprawę jakości wizualnej wygenerowanej treści i jednoczesną poprawę efektywności treningu. Dodatkowo model AnimateLCM oferuje możliwość szkolenia adapterów od podstaw lub dostosowywania istniejących adapterów do opracowanego modelu spójności wideo. Ułatwia to łączenie adapterów typu plug-and-play w rodzinie stabilnych modeli dyfuzyjnych w celu uzyskania różnych funkcji bez szkody dla prędkości próbki.

Celem tego artykułu jest szczegółowe omówienie struktury AnimateLCM. Badamy mechanizm, metodologię i architekturę frameworka, a także jego porównanie z najnowocześniejszymi frameworkami do generowania obrazów i wideo. Więc zacznijmy.

AnimateLCM: Animacja spersonalizowanych modeli dyfuzji

Modele dyfuzyjne stały się podstawą zadań generowania obrazu i generowania wideo ze względu na ich wydajność i możliwości w zakresie zadań generatywnych. Większość modeli dyfuzji opiera się na iteracyjnym procesie odszumiania podczas generowania obrazu, który stopniowo przekształca wielowymiarowy szum Gaussa w rzeczywiste dane. Chociaż metoda zapewnia w miarę zadowalające wyniki, proces iteracyjny i liczba powtarzających się próbek spowalnia proces generowania, a także zwiększa wymagania obliczeniowe modeli dyfuzyjnych, które są znacznie wolniejsze niż inne struktury generatywne, takie jak GAN lub Generatywne sieci przeciwstawne. W ciągu ostatnich kilku lat zaproponowano modele spójności lub CM jako alternatywę dla iteracyjnych modeli dyfuzyjnych w celu przyspieszenia procesu generowania przy jednoczesnym zachowaniu stałych wymagań obliczeniowych.

Najważniejszą cechą modeli spójności jest to, że uczą się mapowań spójności, które utrzymują spójność trajektorii wprowadzonych przez wstępnie wytrenowane modele dyfuzji. Proces uczenia się modeli spójności pozwala generować obrazy o wysokiej jakości w minimalnych krokach, a także eliminuje potrzebę wykonywania iteracji wymagających intensywnych obliczeń. Co więcej, model spójności ukrytej lub LCM zbudowany na bazie stabilne ramy dyfuzji można zintegrować z internetowym interfejsem użytkownika za pomocą istniejących adapterów, aby uzyskać szereg dodatkowych funkcji, takich jak tłumaczenie obrazu na obraz w czasie rzeczywistym. Dla porównania, chociaż istniejące modele dyfuzji wideo zapewniają akceptowalne wyniki, w dziedzinie akceleracji próbki wideo nadal nie poczyniono postępów, co ma ogromne znaczenie ze względu na wysokie koszty obliczeniowe generacji wideo.

To prowadzi nas do AnimateLCM, platformy generowania wideo o wysokiej wierności, która wymaga minimalnej liczby kroków do zadań związanych z generowaniem wideo. Zgodnie z modelem spójności ukrytej środowisko AnimateLCM traktuje proces odwrotnej dyfuzji jako rozwiązywanie przepływu prawdopodobieństwa zwiększonego za pomocą CFG lub bezpłatnego wskazówek klasyfikatora i uczy model przewidywania rozwiązania takich przepływów prawdopodobieństwa bezpośrednio w przestrzeni ukrytej. Zamiast jednak przeprowadzać uczenie się spójności bezpośrednio na surowych danych wideo, co wymaga wysokich zasobów szkoleniowych i obliczeniowych i często prowadzi do niskiej jakości, środowisko AnimateLCM proponuje oddzielną strategię spójnego uczenia się, która oddziela destylację spójności przed generowaniem ruchu i generowaniem obrazu.

Struktura AnimateLCM najpierw przeprowadza destylację konsystencji, aby dostosować podstawowy model dyfuzji obrazu do modelu spójności obrazu, a następnie przeprowadza inflację 3D zarówno do modeli spójności obrazu, jak i dyfuzji obrazu, aby uwzględnić funkcje 3D. Ostatecznie platforma AnimateLCM uzyskuje model spójności wideo, przeprowadzając destylację spójności danych wideo. Ponadto, aby złagodzić potencjalne uszkodzenie funkcji w wyniku procesu rozpowszechniania, środowisko AnimateLCM proponuje również zastosowanie strategii inicjalizacji. Ponieważ platforma AnimateLCM jest zbudowana na bazie platformy Stable Diffusion, może zastąpić wagi przestrzenne wytrenowanego modelu spójności wideo publicznie dostępnymi spersonalizowanymi wagami dyfuzji obrazu, aby osiągnąć innowacyjne wyniki generowania.

Dodatkowo, aby od podstaw wytrenować określone adaptery lub lepiej dopasować je do publicznie dostępnych adapterów, środowisko AnimateLCM oferuje skuteczną strategię przyspieszania dla adapterów, która nie wymaga szkolenia konkretnych modeli nauczycieli.

Wkład platformy AnimateLCM można bardzo dobrze podsumować w następujący sposób: Proponowana struktura AnimateLCM ma na celu osiągnięcie wysokiej jakości, szybkości i wierności generowania wideo i aby to osiągnąć, platforma AnimateLCM proponuje strategię oddzielonej destylacji, która oddziela ruch i obraz poprzednie pokolenia, co skutkuje lepszą jakością wytwarzania i zwiększoną efektywnością szkolenia.

InstantID: Metodologia i architektura

W swej istocie platforma InstantID czerpie inspirację z modeli dyfuzji i strategii szybkości próbkowania. Modele dyfuzyjne, znane również jako modele generatywne oparte na wynikach, wykazały niezwykłe możliwości generowania obrazu. Kierując się kierunkiem punktacji, strategia próbkowania iteracyjnego realizowana przez modele dyfuzyjne stopniowo odszumia dane zniekształcone szumem. Efektywność modeli dyfuzyjnych jest jednym z głównych powodów, dla których większość z nich korzysta z nich modele dyfuzji wideo poprzez trening na dodanych warstwach tymczasowych. Z drugiej strony strategie szybkości próbkowania i przyspieszania próbkowania pomagają uporać się z niskimi prędkościami generowania w modelach dyfuzyjnych. Metoda przyspieszania oparta na destylacji dostraja oryginalne wagi dyfuzji za pomocą udoskonalonej architektury lub harmonogramu, aby zwiększyć prędkość generowania.

Idąc dalej, platforma InstantID opiera się na stabilnym modelu dyfuzji, który umożliwia InstantID stosowanie odpowiednich pojęć. Model traktuje dyskretny proces dyfuzji w przód jako SDE z zachowaniem wariancji w czasie ciągłym. Co więcej, model stabilnej dyfuzji jest rozszerzeniem DDPM lub probabilistycznego modelu dyfuzji odszumiającej, w którym punkt danych szkoleniowych jest stopniowo zakłócany przez dyskretny łańcuch Markowa z budową zaburzeń umożliwiającą dystrybucję zaszumionych danych w różnych krokach czasowych zgodnie z rozkładem.

Aby uzyskać generowanie wideo o wysokiej jakości przy minimalnej liczbie kroków, środowisko AnimateLCM oswaja stabilne modele wideo oparte na dyfuzji, aby podążały za właściwością spójności. Ogólna struktura szkoleniowa platformy AnimateLCM składa się z oddzielonej od siebie strategii spójnego uczenia się, umożliwiającej swobodne dostosowywanie się nauczyciela i efektywną spójną naukę.

Przejście od modeli dyfuzji do modeli spójności

Struktura AnimateLCM wprowadza własną adaptację modelu stabilnej dyfuzji, czyli DM, do modelu spójności, czyli CM, zgodnie z projektem ukrytego modelu spójności, czyli LCM. Warto zauważyć, że chociaż modele stabilnej dyfuzji zazwyczaj przewidują szum dodany do próbek, są one niezbędnymi modelami dyfuzji sigma. Kontrastuje to z modelami spójności, których celem jest bezpośrednie przewidzenie rozwiązania trajektorii PF-ODE. Co więcej, w stabilnych modelach dyfuzyjnych z określonymi parametrami istotne jest, aby model wykorzystywał strategię naprowadzania bez klasyfikatorów w celu generowania obrazów o wysokiej jakości. Jednakże platforma AnimateLCM wykorzystuje pozbawiony klasyfikatorów, wspomagany solwerem ODE do próbkowania sąsiadujących par na tych samych trajektoriach, co zapewnia lepszą wydajność i lepszą jakość. Co więcej, istniejące modele wykazały, że na jakość wytwarzania i efektywność szkolenia duży wpływ ma liczba dyskretnych punktów na trajektorii. Mniejsza liczba dyskretnych punktów przyspiesza proces uczenia, podczas gdy większa liczba dyskretnych punktów powoduje mniejsze obciążenie podczas uczenia.

Oddzielone uczenie się spójności

W przypadku procesu destylacji konsystencji programiści zaobserwowali, że dane użyte do uczenia mają duży wpływ na jakość ostatecznej generacji modeli konsystencji. Jednak głównym problemem związanym obecnie z publicznie dostępnymi zbiorami danych jest to, że często składają się one z danych znaku wodnego lub są niskiej jakości i mogą zawierać zbyt krótkie lub niejednoznaczne podpisy. Co więcej, uczenie modelu bezpośrednio na filmach o dużej rozdzielczości jest kosztowne obliczeniowo i czasochłonne, co sprawia, że dla większości badaczy jest to opcja niewykonalna.

Biorąc pod uwagę dostępność filtrowanych zbiorów danych wysokiej jakości, środowisko AnimateLCM proponuje oddzielenie destylacji priorytetów ruchu od priorytetów generowania obrazu. Mówiąc dokładniej, środowisko AnimateLCM najpierw przekształca stabilne modele dyfuzji w modele spójności obrazu z filtrowanymi, wysokiej jakości zbiorami danych tekstowych obrazów o lepszej rozdzielczości. Następnie framework uczy lekkich wag LoRA w warstwach stabilnego modelu dyfuzji, zamrażając w ten sposób wagi stabilnego modelu model dyfuzyjny. Gdy model dostroi wagi LoRA, działa jako wszechstronny moduł przyspieszający i wykazał swoją kompatybilność z innymi spersonalizowanymi modelami w stabilnych społecznościach dyfuzyjnych. W celu wnioskowania struktura AnimateLCM łączy wagi LoRA z oryginalnymi wagami, nie zakłócając szybkości wnioskowania. Gdy framework AnimateLCM uzyska model spójności na poziomie generowania obrazu, zamraża wagi modelu stabilnego dyfuzji i wagi LoRA. Co więcej, model powiększa jądra splotu 2D do jąder pseudo-3D, aby wytrenować modele spójności na potrzeby generowania wideo. Model dodaje także warstwy tymczasowe z zerową inicjalizacją i połączeniem resztkowym na poziomie bloku. Ogólna konfiguracja pomaga zapewnić, że wyniki modelu nie będą miały wpływu podczas jego pierwszego uczenia. Struktura AnimateLCM pod przewodnictwem modeli dyfuzji wideo z otwartych źródeł uczy warstw czasowych rozszerzonych na podstawie stabilnych modeli dyfuzji.

Należy pamiętać, że chociaż przestrzenne wagi LoRA mają na celu przyspieszenie procesu próbkowania bez uwzględnienia modelowania czasowego, a moduły czasowe są opracowywane przy użyciu standardowych technik dyfuzji, ich bezpośrednia integracja zwykle zakłóca reprezentację na początku uczenia. Stwarza to poważne wyzwania w skutecznym i wydajnym łączeniu ich przy minimalnym konflikcie. W wyniku badań empirycznych w środowisku AnimateLCM zidentyfikowano skuteczne podejście do inicjalizacji, które nie tylko wykorzystuje priorytety spójności z przestrzennych wag LoRA, ale także łagodzi niekorzystne skutki ich bezpośredniego połączenia.

Na początku uczenia spójności wstępnie wyszkolone przestrzenne wagi LoRA są integrowane wyłącznie z modelem spójności online, oszczędzając wstawianie docelowego modelu spójności. Strategia ta zapewnia, że model docelowy, służący jako przewodnik edukacyjny dla modelu online, nie generuje błędnych przewidywań, które mogłyby negatywnie wpłynąć na proces uczenia się modelu online. Przez cały okres szkolenia wagi LoRA są stopniowo włączane do docelowego modelu konsystencji poprzez proces wykładniczej średniej ruchomej (EMA), osiągając optymalną równowagę wag po kilku iteracjach.

Nauczycielska adaptacja bezpłatna

Modele Stable Diffusion i adaptery typu plug and play często idą w parze. Jednakże zaobserwowano, że chociaż adaptery typu plug and play działają w pewnym stopniu, mają tendencję do utraty kontroli nad szczegółami, nawet jeśli większość z tych adapterów jest przeszkolona w zakresie modeli dyfuzji obrazu. Aby przeciwdziałać temu problemowi, środowisko AnimateLCM wybiera adaptację bezpłatną dla nauczyciela, prostą, ale skuteczną strategię, która albo dostosowuje istniejące adaptery w celu zapewnienia lepszej kompatybilności, albo szkoli adaptery od podstaw lub. Podejście to umożliwia platformie AnimateLCM osiągnięcie kontrolowanego generowania wideo i generowania obrazu na wideo w minimalnej liczbie kroków, bez konieczności stosowania modeli nauczycieli.

AnimateLCM: eksperymenty i wyniki

Struktura AnimateLCM wykorzystuje Stable Diffusion v1-5 jako model podstawowy i implementuje moduł DDIM ODE do celów szkoleniowych. W ramach tej platformy zastosowano także wersję Stable Diffusion v1-5 z wagami ruchu z otwartych źródeł jako model dyfuzji wideo dla nauczycieli, a eksperymenty przeprowadzono na zestawie danych WebVid2M bez żadnych dodatkowych lub rozszerzonych danych. Co więcej, platforma wykorzystuje zbiór danych TikTok z krótkimi napisami tekstowymi z napisami BLIP w celu kontrolowanego generowania wideo.

Wyniki jakościowe

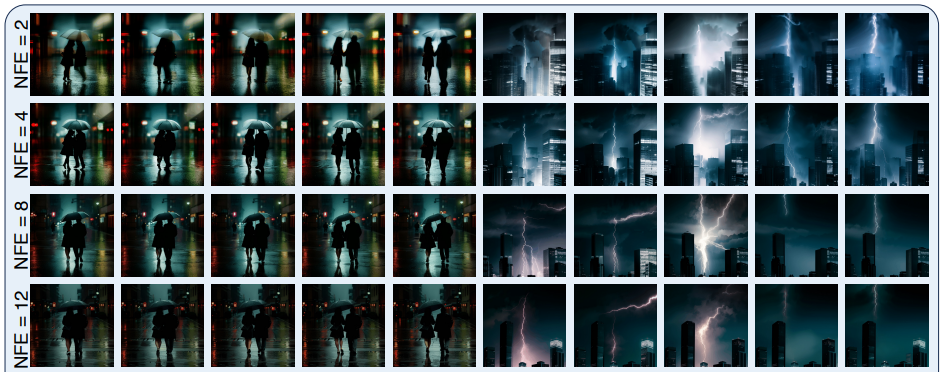

Na poniższym rysunku przedstawiono wyniki czteroetapowej metody generowania zaimplementowanej w środowisku AnimateLCM w zakresie generowania tekstu na wideo, generowania obrazu na wideo i kontrolowanego generowania wideo.

Jak można zaobserwować, wyniki uzyskane przez każdy z nich są zadowalające, a wygenerowane wyniki pokazują zdolność środowiska AnimateLCM do podążania za właściwością spójności nawet przy różnych krokach wnioskowania, przy zachowaniu podobnego ruchu i stylu.

Wyniki ilościowe

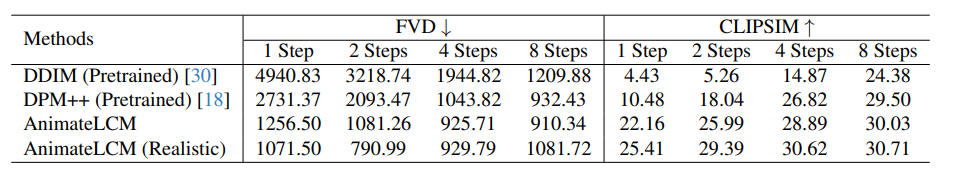

Poniższy rysunek ilustruje wyniki ilościowe i porównanie środowiska AnimateLCM z najnowocześniejszymi metodami DDIM i DPM++.

Jak można zaobserwować, środowisko AnimateLCM znacznie przewyższa istniejące metody, szczególnie w trybie niskoetapowym, obejmującym od 1 do 4 kroków. Co więcej, metryki programu AnimateLCM wyświetlane w tym porównaniu są oceniane bez korzystania z bezpłatnych wskazówek CFG lub klasyfikatorów, co pozwala platformie zaoszczędzić prawie 50% czasu wnioskowania i szczytowego kosztu pamięci wnioskowania. Co więcej, aby jeszcze bardziej zweryfikować jego działanie, wagi przestrzenne w ramach AnimateLCM zostały zastąpione publicznie dostępnym, spersonalizowanym, realistycznym modelem, który zapewnia dobrą równowagę między wiernością a różnorodnością, co pomaga w dalszym zwiększaniu wydajności.

Final Thoughts

W tym artykule omówiliśmy AnimateLCM, spersonalizowany model rozpowszechniania z adapterami, którego celem jest generowanie filmów o wysokiej jakości przy minimalnych krokach i kosztach obliczeniowych. Struktura AnimateLCM jest inspirowana modelem spójności, który przyspiesza próbkowanie w minimalnych krokach poprzez wyodrębnienie wstępnie wyszkolonych modeli dyfuzji obrazu, a także pomyślnym rozszerzeniem modelu spójności, ukrytego modelu spójności lub LCM, który ułatwia warunkowe generowanie obrazów. Zamiast przeprowadzać uczenie się spójności bezpośrednio na surowym zestawie danych wideo, środowisko AnimateLCM proponuje zastosowanie strategii uczenia się spójności oddzielonej od siebie, która oddziela destylację priorytetów generowania ruchu od priorytetów generowania obrazu, umożliwiając modelowi poprawę jakości wizualnej wygenerowanej treści i jednocześnie poprawić efektywność treningu.