Andersons vinkel

Skjønnhetsfiltre er et potensielt verktøy for deepfake-angrep

Skjønnhetsfiltre gjør nå mer enn å skjule urenheter: de kan hjelpe deepfakes og ansiktsmorfer med å slippe forbi deteksjonssystemer. En ny studie viser at selv subtile utjevningseffekter forvirrer AI-detektorer, slik at falske bilder ser ekte ut og ekte bilder ser falske ut. Hvis trenden fortsetter, kan skjønnhetsfiltre møte restriksjoner i sammenhenger med høy innsats, fra grensekontroll til Zoom-samtaler i bedrifter.

I en akademisk rapport fra 2024 samarbeid Mellom Spania og Italia rapporterte forskere at 90 % av kvinner i alderen 18–30 brukte skjønnhetsfiltre før de la ut bilder på sosiale medier. I denne forstand er skjønnhetsfiltre algoritmiske eller AI-støttede metoder for å endre ansiktsutseende slik at det angivelig er forbedret i forhold til den opprinnelige kilden:

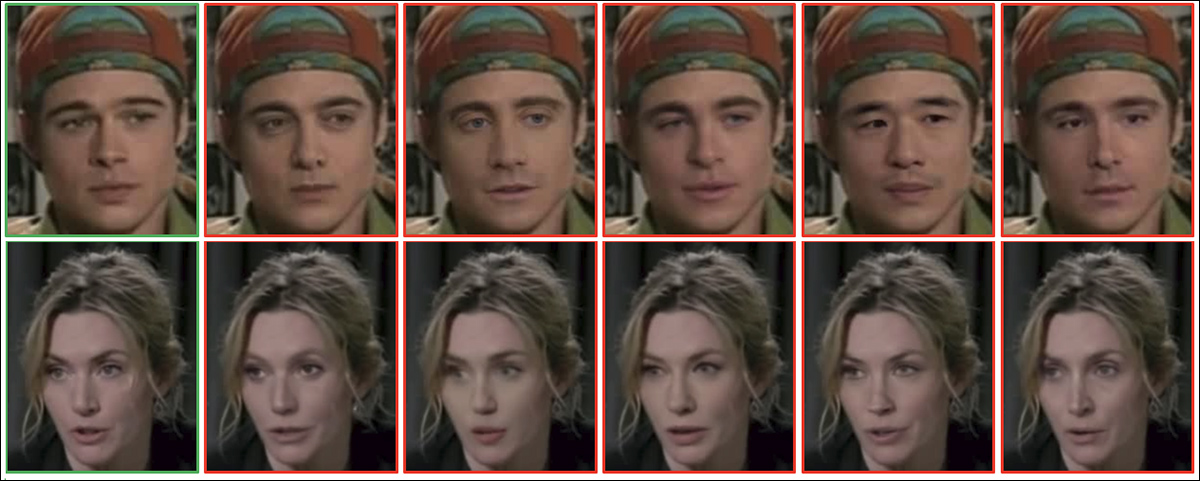

Fra studien fra 2024: eksempel på kvinnelige (venstre) og mannlige (høyre) ansikter vist før og etter skjønnhetsfiltrering. Filteret endrer trekk som hudtone, øyne, nese, lepper, hake og kinnbein for å forbedre opplevd attraktivitet. Kilde: https://arxiv.org/pdf/2407.11981

Slike filtre er også allment tilgjengelige som innebygde funksjoner eller tilleggsfunksjoner i populære videobaserte systemer, inkludert Snapchat og Zoom, og tilbyr muligheten til å glatte ut «uperfekt» hud og til og med endre motivets alder, helt opp til det punktet hvor identiteten kan sies å være vesentlig endret:

Klikk for å spille: Tre kvinner slår av «forskjønnings»-filtrene sine for videoer, noe som avslører i hvilken grad fysiognomiene deres endres av algoritmene eller AI. Kilde: https://www.youtube.com/watch?v=gtCpea_5qxw

Fenomenet så ut til å nå metningspunktet så snart teknologien var relativt moden; en 2020 studere fra City University of London avslørte at 90 % av unge Snapchat-brukere i USA, Frankrike og Storbritannia brukte filtre i appene sine, mens Meta rapporterte at mer enn 600 millioner unge mennesker på det tidspunktet hadde brukt filtre på Facebook eller Instagram.

Psychology Today utforsker de negative effektene av slike filtre på mental helse rapporterer gjentok at av de undersøkte brukte 90 % av unge kvinner, med en gjennomsnittsalder på 20, enten filtre eller redigerte bildene sine på en eller annen måte. De mest populære filtrene var de som ble brukt til å jevne ut hudtoner, gi et solbrunt utseende, bleke tenner og til og med redusere kroppsstørrelse.

Face Off

Ettersom ansiktsfiltre skal dra nytte av 2025 revolusjon innen videosyntese, og mer generelt fra den pågående interessen i denne forskningssektoren, skurer graden av hvorvidt vi kan «gjenskape» eller forestille oss selv på nytt i direktesendte videochatter i økende grad mot sikkerhetsmiljøets bekymring for svindel eller kriminelle deepfake-videoteknikker.

Et problem er at spekteret av «enkle» tester utviklet de siste årene for å avsløre en video-deepfaker, som muligens prøver å svindle store pengesummer i en bedriftssammenheng, blir uunngåelig mindre effektive ettersom disse akilleshælene tas med i betraktning i treningsdata og ved inferenstidspunktet:

Klikk for å spille: For tre eller fire år siden var det å vifte med hånden foran et deepfaked-ansikt en pålitelig test for videosamtaler, men vi kan se at dedikert innsats fra blant annet TikTok gjør dype inngrep i de klassiske «tells». Kilder: Ibid og https://archive.is/mofRV#wavehands

Enda viktigere er det at den utbredte bruken av ansiktsendrende/forskjønnende filtre gjør situasjonen mer uklar for en ny og fremvoksende generasjon av deepfake-detektorer som har som oppgave å holde bedragere unna videochatter i møterom, og unna sårbare potensielle ofre for «kidnapping» og «bedrageri».

Det er lettere å overbevise deepfakes, enten det er med bilde eller video, hvis oppløsningen på bildet er lav eller bildet på en eller annen måte forringet, siden det underliggende forfalskningssystemet kan skjule sine egne mangler bak det som ser ut til å være tilkoblings- eller plattformproblemer.

De mest populære forskjønningsfiltrene fjerner faktisk noe av det mest nyttige materialet for å identifisere video-deepfakes, som hudtekstur og andre ansiktsdetaljer – og det er verdt å vurdere at jo eldre et ansikt er, desto flere slike detaljer er det sannsynlig at det inneholder, og derfor kan bruk av vanity-aldringsfiltre være en spesiell fristelse i slike tilfeller.

Hvis et detaljfritt «android»-stilutseende er moten, kan det hende at deepfake-detektorer mangler materialet de trenger for å skille mellom ekte og falske bilder og videopersoner. Kilde: https://www.instagram.com/reel/DMyGerPtTPF/?hl=en

Royal Societys slutten av 2024 papir Det som er vakkert er fortsatt bra: attraktivitetshaloeffekten i skjønnhetsfiltrenes æra bekreftet at bruk av filtre universelt øker generell attraktivitet for begge kjønn (selv om økt attraktivitet har en tendens til å senke den generelle estimeringen av intelligens hos kvinner som er skjønnhetsfiltrerte).

Derfor er det rimelig å si at dette er en populær teknologi; at den fungerer; og at det ville være et slags kultursjokk dersom den plutselig skulle bli underlagt sikkerhetsbegrensninger, eller forbudt i ulike sammenhenger.

Likevel, i en periode hvor video-deepfakes truer med å bli uutslettelig fra ekte videodeltakere, både i utseende og tale, er det mulig at den rene globale «støyen» fra skjønnhetsfiltre kanskje må dempes i fremtiden, av sikkerhetsmessige årsaker.

Glatte kriminelle

Problemstillingen har nylig blitt undersøkt i en nytt papir fra Universitetet i Cagliari i Italia, med tittelen Villedende skjønnhet: Evaluering av effekten av skjønnhetsfiltre på deteksjon av deepfake- og morphing-angrep.

I den nye studien brukte forskere skjønnhetsfiltre på ansikter fra to referansedatasett, og testet flere deepfake- og morphing-angrepsdetektorer på både de originale og endrede bilder.

I nesten alle tilfeller falt deteksjonsnøyaktigheten etter forskjønning; de mest dramatiske fallene skjedde da filtre glattet ut rynker, lysnet hudtonen eller subtilt omformet ansiktstrekk. Disse endringene fjernet eller forvrengte selve signalene som deteksjonsmodeller er avhengige av.

For eksempel mistet den best presterende modellen på MorphDB mer enn 9 % nøyaktighet etter filtrering, og problemet vedvarte på tvers av flere deteksjonsarkitekturer, noe som indikerer at nåværende systemer ikke er robuste mot vanlige kosmetiske forbedringer.

Forfatterne konkluderer med:

«[Forskjønnings]filtre utgjør en trussel mot integriteten til biometriske autentiserings- og rettsmedisinske analysesystemer, noe som gjør robust deteksjon av deepfake- og morph-angrep under slike forhold til en kritisk åpen utfordring.»

«Fremtidig arbeid bør prioritere utviklingen av digitale manipulasjonsdeteksjonssystemer som er robuste mot slike subtile, reelle endringer, enten de er ondsinnede eller ikke, for å sikre pålitelig identitetsgjenkjenning og innholdsverifisering i hverdagslige og sikkerhetskritiske sammenhenger.»

Metode og data

For å evaluere hvordan skjønnhetsfiltre påvirker deepfake og morfdeteksjon, forskerne brukte et progressivt utjevningsfilter og testet resultatene på to referansekonvolusjonelle nevrale nettverk (CNN) godt knyttet til målproblemet: AlexNet og VGG19.

Hvert av de to testede referansedatasettene inneholdt eksempler på passende ansiktsmanipulasjoner. Det første var KjendisDF, en storskala video-benchmark med 590 ekte og 5,639 forfalskede klipp laget med avanserte ansiktsbytteteknikker. Samlingen tilbyr et variert utvalg av lysforhold, hodepositurer og naturlige uttrykk på tvers av 59 individer, noe som gjør den godt egnet for å evaluere robustheten til deepfake-detektorer i virkelige mediescenarioer:

Eksempler på berørte ansiktsbilder, fra CelebDF. Kilde: https://github.com/yuezunli/celeb-deepfakeforensics

Den andre var AMSL (registrering kreves), et datasett for morphing-angrep bygget fra Face Research Lab London samling, som inneholder både ekte og syntetisk blandede ansikter. Datasettet inkluderer nøytrale og smilende uttrykk fra 102 personer, og ble strukturert for å gjenspeile realistiske utfordringer for biometriske autentiseringssystemer som brukes i sammenhenger som grensekontroll.

Bilder fra kildedatasettet Face Research Lab London set (FRLL), brukt i AMSL. Kilde: https://figshare.com/articles/dataset/Face_Research_Lab_London_Set/5047666?file=8541955

Hvert nettverk ble trent på 80 % av deepfake- eller morphing-datasettet, mens de resterende 20 % ble brukt til valideringFor å teste robusthet mot forskjønning, brukte forskerne deretter et progressivt utjevningsfilter på testbildene, og økte uskarphetsradiusen fra 3 % til 5 % av ansiktshøyden:

Eksempelansikter fra CelebDF- (øverst) og AMSL- (nederst) datasettene, vist før og etter bruk av et utjevningsbasert skjønnhetsfilter. Filterradiusen ble skalert i forhold til ansiktshøyden, med c = 3 % og c = 5 % som ga gradvis sterkere effekter.

Når det gjelder målinger, ble hver modell evaluert ved hjelp av lik feilrate (EER) på både den originale og den forskjønnede testprøven. Analysen rapporterte også feilraten for Bona Fide-presentasjonsklassifisering (BPCER), eller falsk positiv rate, og feilraten for angrepspresentasjonsklassifisering (APCER), eller falsk negativ rate, ved å bruke terskelen som er satt på de opprinnelige dataene.

Morfiserte ansikter fra AMSL-datasettet.

For å vurdere ytelsen ytterligere, ble arealet under ROC-kurven (AUC) og poengsumfordelingen for ekte og falske bilder ble undersøkt.

Tester

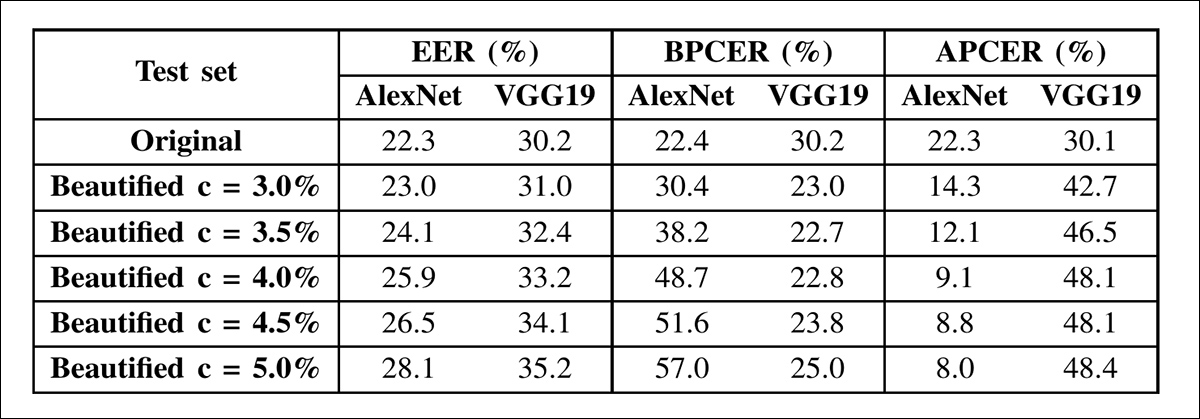

I resultatene av dypfalskedeteksjon viste begge nettverkene økende like feilrater etter hvert som forskjønningsintensiteten økte. AlexNets EER økte fra 22.3 % på de originale bildene til 28.1 % på det høyeste utjevningsnivået, mens VGG19s økte fra 30.2 % til 35.2 %. Ytelsesfallet fulgte forskjellige mønstre i hvert tilfelle:

Resultater for deepfake-deteksjon på CelebDF-datasettet ved hjelp av AlexNet og VGG19. Begge modellene ble testet på originale og forskjønnede bilder med økende nivåer av ansiktsutjevning. Målingene som vises inkluderer Equal Error Rate (EER), Bona Fide Presentation Classification Error Rate (BPCER) og Attack Presentation Classification Error Rate (APCER), ved bruk av terskler fastsatt fra det opprinnelige testsettet. Deteksjonsnøyaktigheten avtok etter hvert som forskjønnelsesintensiteten økte, selv om degraderingsmønsteret varierte mellom arkitekturene.

Etter hvert som forskjønningen økte, ble det mer sannsynlig at AlexNet forvekslet ekte ansikter med forfalskninger, noe som ble vist ved en jevn økning i andelen falske positiver (BPCER). VGG19, derimot, slet stort sett med å fange opp forfalskningene selv, med en økende andel falske negative resultater (APCER). De to modellene reagerte ulikt på filtrene, noe som indikerer at selv kjente arkitekturer kan feile på forskjellige måter når de møter kosmetiske endringer.

For å bedre forstå disse resultatene, brukte forskerne forskjønningsfilteret separat på ekte og falske bilder og målte effekten på deteksjonsytelsen. Denne oversikten, vist i resultattabellen nedenfor, tydeliggjør kilden til hver modells sårbarhet:

Deteksjonsnøyaktighet for AlexNet og VGG19 under delvis forskjønning på CelebDF-datasettet. Tabellen rapporterer tre scenarier: forskjønnet ekte vs. forskjønnet falskhet (F-Real vs. F-Fake); forskjønnet ekte vs. original falskhet (F-Real vs. O-Fake); og original ekte vs. forskjønnet falskhet (O-Real vs. F-Fake), med en reduksjon i nøyaktighet som indikerer redusert detektorytelse. AlexNet ble mest påvirket når ekte bilder ble forskjønnet, mens VGG19 slet mest når forskjønnelse ble brukt på falske bilder.

For AlexNet falt deteksjonsytelsen når ekte bilder ble forskjønnet, men ble bedre når bare falske bilder ble glattet ut. For VGG19 forbedret ytelsen seg noe med forskjønnede ekte bilder, men ble verre når deepfakes ble filtrert. I alle tilfeller, sterkere forskjønning redusert nøyaktighet.

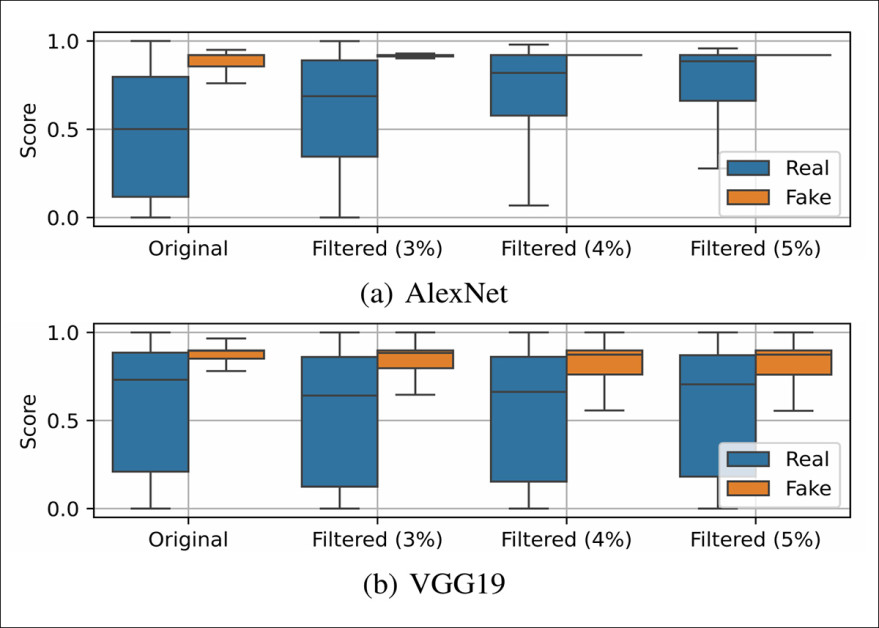

Boksplott som viser utdatafordelingene av AlexNet og VGG19 på ekte og falske prøver fra CelebDF-datasettet, under økende nivåer av forskjønning. Etter hvert som utjevningen intensiveres, blir poengfordelingene for ekte og falske bilder mindre separerbare, noe som indikerer redusert deteksjonspålitelighet. AlexNet blir mindre sikker på å identifisere ekte ansikter, mens VGG19 blir mer sannsynlig å feilklassifisere falske ansikter.

Forskjønnelse gjorde AlexNets resultater mer ensartede på tvers av både ekte og falske prøver, mens VGG19 viste større spredning innenfor hver klasse. Til tross for disse kontrasterende effektene på variasjon i poengsum, mistet begge modellene nøyaktighet. For AlexNet flyttet poengsummene for ekte ansikter seg nærmere de for deepfakes. For VGG19 begynte poengsummene for ekte og falske bilder å overlappe hverandre, noe som reduserte modellens evne til å skille dem fra hverandre.

Papiret sier:

«Disse resultatene har viktige implikasjoner og avslører at det er nødvendig å vurdere potensiell bruk av forskjønningsfiltre i deepfake-deteksjon, siden disse kan ha en uforutsigbar innvirkning på ytelsen. Spesielt reagerer forskjellige arkitekturer forskjellig på ansiktsmanipulasjoner, selv om disse manipulasjonene ikke er ment å lure.»

«For eksempel, basert på den spesifikke deepfake-detektoren, kan forskjønningsfiltrene endre resultatet betydelig, slik at ekte bilder identifiseres som forfalskninger og, enda viktigere, la deepfakes lure deteksjonen.»

«Derfor er det nødvendig å fokusere på utviklingen av detektorer som er mer robuste mot slike subtile, ikke strengt tatt ondsinnede endringer som kan tjene som kamuflasje for ondsinnede deepfake-manipulasjoner.»

I morphing-angrepsscenarioet ble et syntetisk bilde laget ved å blande ansiktstrekk fra to individer. Dette bildet ble brukt til å lure ansiktsgjenkjenningssystemer, slik at begge kildeidentitetene kunne autentiseres som den samme personen. Slike angrep anses som spesielt relevante i sikkerhetssammenhenger, der biometriske systemer kunne bli villedet til å akseptere det morfede bildet for offisiell identifikasjon.

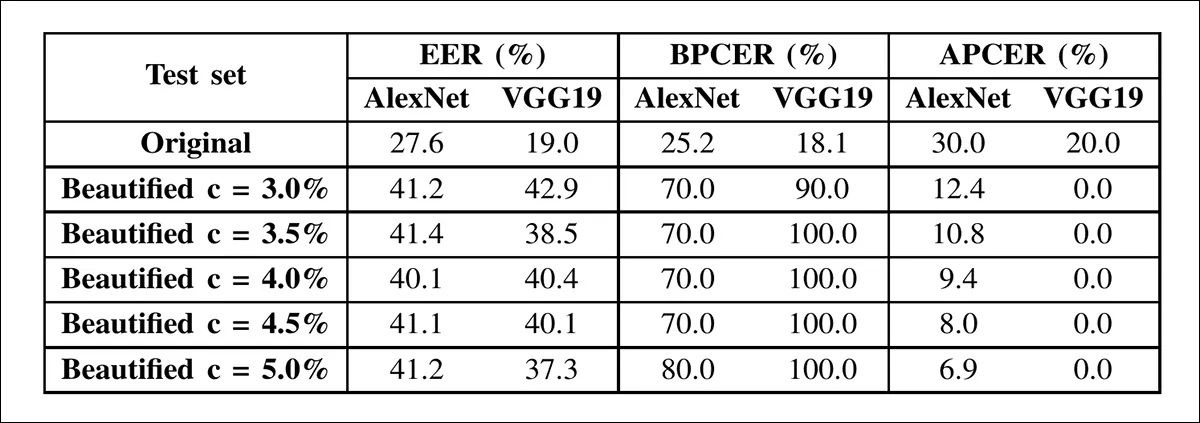

Tabellen ovenfor viser resultater for deteksjon av morphing-angrep på AMSL-bilder før og etter forskjønning, der begge nettverkene viser bratte feiløkninger etter hvert som utjevningsintensiteten øker.

I morphing-angrepsscenarioet ble ytelsen kraftigere redusert enn i deepfake-deteksjon. AlexNets EER økte fra 27.6 % til 41.2 %, og VGG19s fra 19.0 % til 37.3 %, hovedsakelig drevet av falske positiver: ekte ansikter feilklassifisert som morfer. Med en utjevningsradius på 3 % nådde VGG19s falske positive rate 90 %.

Dette mønsteret holdt seg når filtre ble brukt selektivt. Utjevning av ekte ansikter svekket deteksjonen, mens utjevning av kun morfiserte ansikter forbedret resultatene. Etter hvert som utjevningen intensiverte, viste begge nettverkene redusert separasjon mellom ekte og falske poengsummer, der VGG19 ble spesielt ustabil.

Disse funnene, ifølge forfatterne, antyder at skjønnhetsfiltre kan hjelpe morfer med å unngå å bli oppdaget enda mer effektivt enn deepfakes, noe som reiser alvorlige sikkerhetsbekymringer.

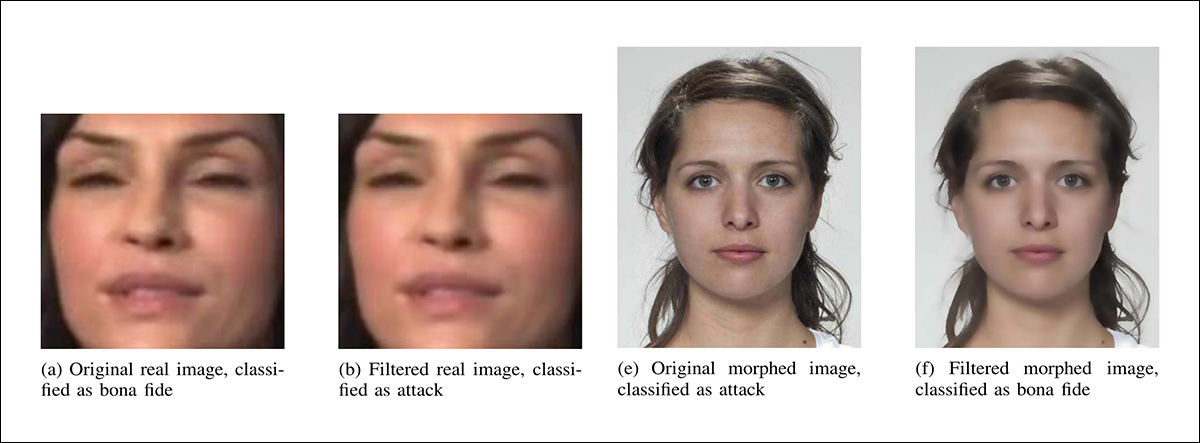

Delvise eksempler (på grunn av plassmangel) på hvordan minimal forskjønning (3 % utjevningsradius) endret AlexNets klassifiseringer. Til venstre er et ekte bilde feilklassifisert som et angrep etter filtrering, og til høyre er et morfisert bilde feilklassifisert som ekte etter filtrering.

Til slutt fant forskerne at selv milde forskjønningsfiltre kan forringe ytelsen til toppmoderne deepfake- og morphing-detektorer betydelig.

Virkningen varierte avhengig av arkitekturen, med AlexNet som viste gradvis nedgang, og VGG19 som kollapset under minimal filtrering. Siden disse filtrene er vanlige og ikke iboende skadelige, utgjør deres evne til å skjule angrep en praktisk trussel, ifølge forfatterne, spesielt i biometriske systemer. Artikkelen understreker behovet for deteksjonsmodeller som er robuste mot slike subtile bildemanipulasjoner.

Konklusjon

En grunn til at det kan være vanskelig å trene deepfake-deteksjonssystemer som kan ignorere forskjønningsfiltre, er mangelen på kontrasterende materiale. Til syvende og sist er det den «forskjønnede» versjonen som blir bredt spredt, og i motsetning til videoen vi la inn tidligere som en illustrasjon, er det svært sjelden at et «før»-bilde brukes.

En annen hindring er at mange av filtrene utfører akkurat den typen utjevning som er typisk for komprimeringsoperasjoner når man lagrer bilder eller komprimerer video (en velsignelse for leverandørenes båndbredde, i tillegg til å være en digital skin-makeover for de som bruker filteret).

Forskningssektoren for deepfake-deteksjon er allerede dypt engasjert i å bekjempe tilfeller av reell bildeforringelse på grunn av problemer som kameraer av dårlig kvalitet, overdreven komprimering eller hakkete nettverkstilkobling – alle slike forhold er en direkte fordel for deepfake-svindlere som er tvunget til å prøve mye hardere i et scenario med høy kvalitet og høy oppløsning.

Hvorvidt forskjønningsfiltre til slutt blir truet som en sikkerhetsrisiko, ser sannsynligvis ut til å avhenge av i hvilken grad de viser seg å være et hinder for deepfake-screeningmetoder, eller ender opp med å utgjøre en slags de facto brannmur som gagner gjerningsmenn mer enn de som bekjemper dem.

Først publisert onsdag 24. september 2025