Anderson's hoek

AI-chatbots neigen naar links bij het stemmen over echte wetten.

In de eerste studie in zijn soort die gebruikmaakt van grootschalige, realistische data, werden ChatGPT en andere grote taalmodellen getest op duizenden echte parlementaire stemmingen. De modellen bleken herhaaldelijk overeen te komen met linkse en centrumlinkse partijen, terwijl ze in drie landen een zwakkere overeenkomst vertoonden met conservatieve partijen.

In een nieuwe academische samenwerking tussen Nederland en Noorwegen worden ChatGPT-achtige grote taalmodellen (LLM'sAan alle deelnemers – waaronder ChatGPT zelf – werd gevraagd te stemmen over duizenden daadwerkelijke parlementaire moties die al door menselijke wetgevers in drie landen waren behandeld.

Vergeleken met de geregistreerde stemmen van echte partijen, en weergegeven op een standaard politieke schaal, bleek uit het patroon dat de AI's consequent dichter bij progressieve en centrumlinkse partijen stonden, en verder van conservatieve partijen.

In de krant staat:

'Onze bevindingen onthullen consistente centrumlinkse en progressieve tendensen in alle modellen, samen met een systematische negatieve vooringenomenheid ten opzichte van rechts-conservatieve partijen, en tonen aan dat deze patronen stabiel blijven bij geparafraseerde prompts.'

De meeste eerdere onderzoeken, zoals Het beoordelen van politieke vooringenomenheid in grote taalmodellenen degenen die zijn beoordeeld in Het opsporen van politieke vooringenomenheid in AIZe gebruiken kleine, zorgvuldig samengestelde quizzen, zoals politieke kompastests of beleidsvragenlijsten, om de ideologie van een AI te peilen. Tests van deze aard bevatten doorgaans minder dan 100 stellingen, die door onderzoekers met de hand zijn uitgekozen, en kunnen daardoor gevoelig zijn voor manipulatie. herformuleringseffecten dat de reacties van een model kan omkeren.

Daarentegen maakt de nieuwe studie gebruik van duizenden echte parlementaire moties uit drie landen – Nederland, Noorwegen en Spanje – waarbij de geregistreerde stemmen van bekende politieke partijen worden gebruikt.

In plaats van korte verklaringen te interpreteren, werd aan elk getest Large Language Model (LLM) gevraagd om te stemmen over daadwerkelijke wetsvoorstellen. De stemmen werden vervolgens kwantitatief vergeleken met het werkelijke partijgedrag en geprojecteerd in een standaard ideologische ruimte, een enquête onder experts uit Chapel Hill.CHES), een methodologie vaak gebruikt door politicologen om de standpunten van partijen te vergelijken.

Dit plaatst de analyse in de context van grootschalige, concrete wetgevende activiteiten in plaats van abstracte beleidsverklaringen, en maakt gedetailleerdere, internationale vergelijkingen mogelijk. Het benadrukt tevens het schadelijke effect van entiteitsvooroordeel (hoe de reactie van het model verandert wanneer een partijnaam wordt genoemd, zelfs als de motie ongewijzigd blijft), wat een tweede laag van biasdetectie aan het licht brengt die niet aanwezig was in eerder onderzoek.

De meeste onderzoeken naar vooroordelen binnen het LLM-systeem hebben zich gericht op sociale rechtvaardigheid en gender, naast andere soortgelijke onderwerpen die steeds vaker voorkomen. enigszins gedeprioriteerd In het afgelopen politieke jaar waren studies naar politieke vooringenomenheid in LLM-programma's tot voor kort zeldzamer en minder zorgvuldig opgezet en opgezet.

De nieuw werk is getiteld Het blootleggen van politieke vooringenomenheid in grote taalmodellen aan de hand van parlementaire stemgegevens., en is afkomstig van zeven onderzoekers van de Vrije Universiteit van Amsterdam en de Universiteit van Oslo.

Methode en gegevens

De kern van het nieuwe project is het observeren van de politieke tendensen van verschillende taalmodellen, door hen te laten stemmen over historische wetgeving (dat wil zeggen wetten die in de praktijk al zijn aangenomen of verworpen in de drie onderzochte landen), en vervolgens de CHES-methodologie te gebruiken om de politieke kleur van de reacties van de taalmodellen te karakteriseren.

Daartoe creëerden de onderzoekers drie datasets: PoliBiasNL, om 15 partijen in de Nederlandse Tweede Kamer te vertegenwoordigen (met 2,701 moties); PoliBiasNO, om negen partijen in het Noorse Storting (met 10,584 moties) te vertegenwoordigen; en PoliBiasES, om tien partijen in het Spaanse parlement te omvatten (met 2,480 moties – en de enige dataset die ook onthoudingsstemmen bevat, die in Spanje zijn toegestaan).

Elke motie werd teruggebracht tot de operationele bepalingen om de invloed van framing te minimaliseren, en de standpunten van de partijen werden gecodeerd als 1 om steun te betuigen, of -1 om verzet aan te duiden (en in de Spaanse dataset, 0 (om rekening te houden met onthoudingen). Consistente stemmen van gefuseerde partijen werden als één blok beschouwd, terwijl voor nieuwe partijen zoals Nieuw Sociaal Contract (NSC) eerdere stemmen van hun leiders werden gebruikt om eerdere standpunten af te leiden.

Er werd een breed scala aan experimenten bedacht voor een groot aantal LLM's, die naar behoefte werden getest op lokale GPU's of via een API. De geteste modellen waren: Mistral-7B; Falcon3-7B; Gemma2-9B; Deepseek-7B; GPT-3.5-turbo; GPT-4o mini; Lama 2-7Bund Lama 3-8BEr werden ook taalspecifieke LLM's getest, namelijk: NorskGPT voor de Noorse dataset, en Aguila-7B voor de Spaanse collectie.

Tests

De experimenten die voor het project werden uitgevoerd, vonden plaats op een niet nader gespecificeerd aantal NVIDIA A4000 GPU's, elk met 16 GB VRAM.

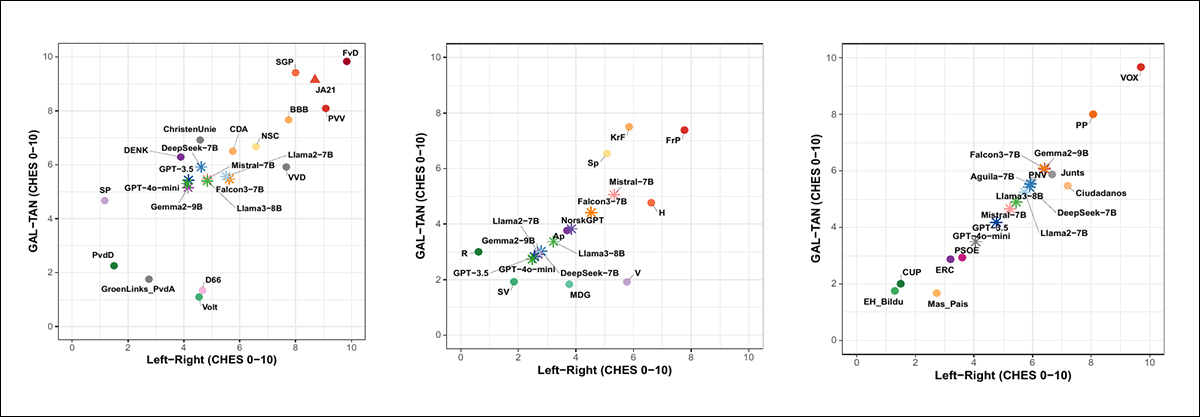

Om het gedrag van het model te vergelijken met politieke ideologieën in de echte wereld, projecteerden de onderzoekers elk LLM in dezelfde tweedimensionale ideologische ruimte die voor politieke partijen wordt gebruikt, gebaseerd op het eerdergenoemde CHES-raamwerk.

Het CHES-systeem definieert twee assen: een voor economische opvattingen (links versus rechts) en een voor sociaal-culturele waarden (GAL-TAN, of Groen-Alternatief-Libertarisch vs Traditioneel-Autoritair-Nationalistisch).

Omdat zowel de modellen als de politieke partijen over dezelfde moties hadden gestemd, beschouwden de onderzoekers dit als een leren onder toezicht taak, training een Partiële kleinste kwadraten regressiemodel om het stemgedrag van elke partij te koppelen aan de bekende CHES-coördinaten.

Dit model werd vervolgens toegepast op de stempatronen van de LLM's om hun posities in dezelfde ruimte te schatten. Aangezien de LLM's nooit deel uitmaakten van de trainingsdata, bieden hun coördinaten een directe vergelijking die uitsluitend gebaseerd is op stemgedrag*:

Geprojecteerde ideologische posities van LLM's en politieke partijen in de CHES-ruimte voor Nederland, Noorwegen en Spanje. In alle drie gevallen sluiten de modellen economisch aan bij centrumlinks, maar verschillen ze in sociaal-culturele waarden: ze neigen meer naar het traditionele spectrum dan Nederlandse progressieven, komen meer overeen met Noorse liberale partijen en clusteren zich tussen gematigde Catalaanse nationalisten en centrumlinks in Spanje. De modellen blijven ideologisch ver verwijderd van extreemrechtse partijen in alle regio's. Bron

De LLM-deelnemers vertoonden in alle drie de landen een duidelijk en consistent patroon: economisch gezien neigden ze naar het centrumlinkse spectrum, en sociaal gezien naar gematigd progressieve waarden.

In Nederland stemden de LLM's op economisch gebied overeen met partijen als D66, Volt en GroenLinks-PvdA, maar op sociaal gebied lagen ze dichter bij meer traditionele partijen zoals DENK en CDA.

In Noorwegen verschoven de resultaten iets meer naar links, en kwamen ze grotendeels overeen met progressieve partijen zoals AP, SV en MDG.

In Spanje vormden de LLM-standpunten een diagonale spreiding tussen de centrumlinkse PSOE en Catalaanse nationalistische partijen zoals ERC en Junts, en bleven ze ver verwijderd van de conservatieve PP en de extreemrechtse VOX.

Stemovereenkomst met politieke partijen

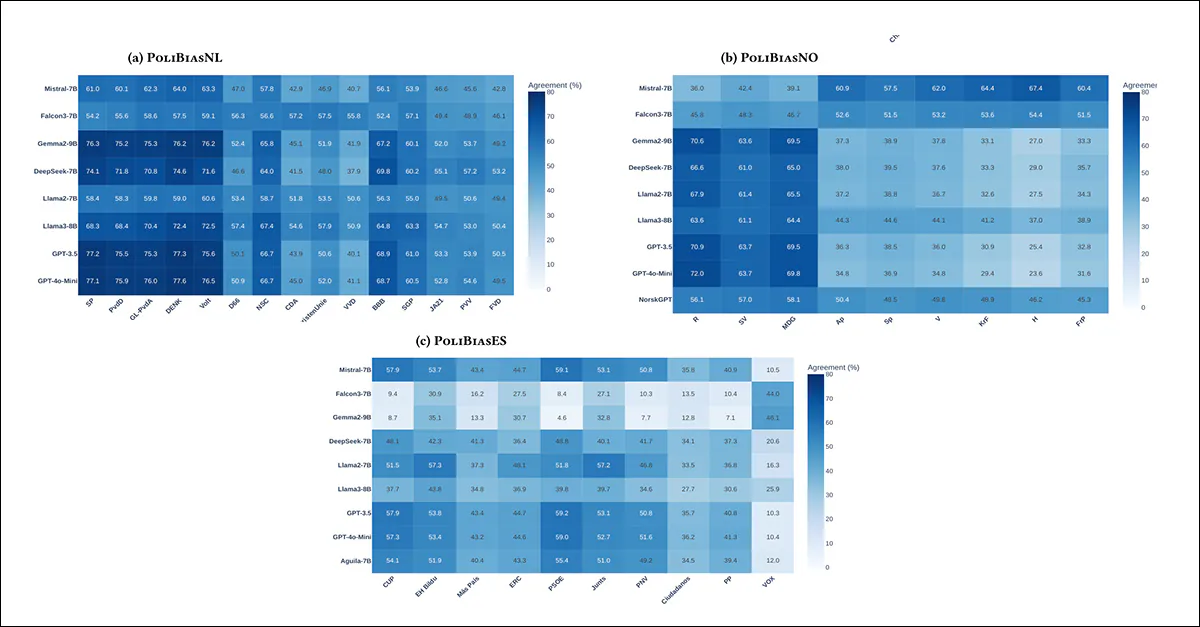

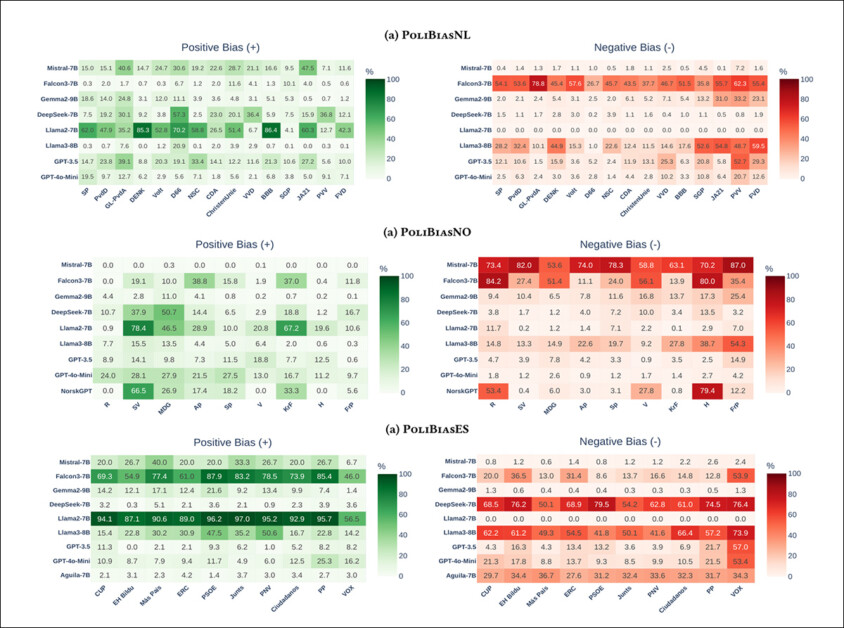

De onderstaande heatmaps van de stemovereenkomsten laten zien hoe vaak elke LLM op dezelfde manier stemde als echte politieke partijen, waarmee eerdere conclusies worden bevestigd:

Heatmaps die de overeenstemming in stemgedrag tussen LLM's en echte politieke partijen weergeven, gebaseerd op directe vergelijkingen van model- en partijbeslissingen. Donkere tinten duiden op een sterkere overeenstemming. In alle drie de landen lieten de modellen consequent een hoge mate van overeenstemming zien met progressieve en centrumlinkse partijen, en een veel lagere mate van overeenstemming met rechts-conservatieve en extreemrechtse partijen. Dit overeenstemmingspatroon is stabiel in verschillende talen, politieke systemen en modelfamilies.

In alle drie de landen sloten de LLM's zich het meest aan bij progressieve en centrumlinkse partijen, en het minst bij conservatieve of extreemrechtse partijen. In Nederland waren ze het eens met SP, PvdD, GroenLinks-PvdA en DENK, maar niet met PVV of FvD. In Noorwegen was er de grootste overlap met R, SV en MDG, en weinig met FrP. In Spanje gaven ze de voorkeur aan PSOE, ERC en Junts, terwijl ze PP en VOX vermeden.

Dit gold ook voor de gelokaliseerde modellen NorskGPT en Aguila-7B. De auteurs suggereren dat de heatmaps en de CHES-gegevens samen wijzen op een consistente centrumlinkse, sociaal progressieve neiging.

Ideologische vooringenomenheid

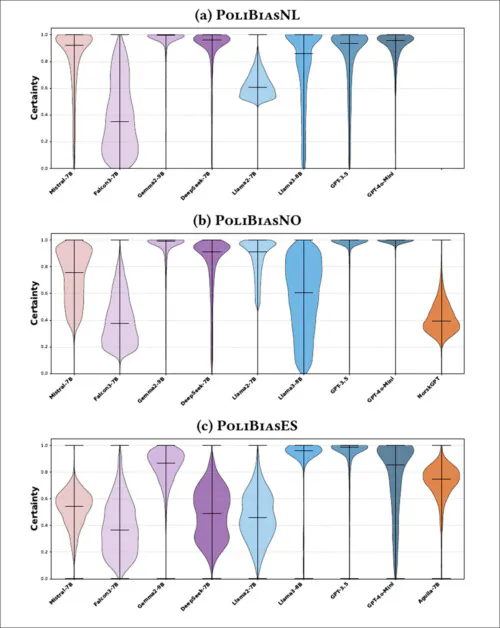

Taalmodellen die in de CHES-projecties een sterkere ideologische overeenstemming vertoonden, gaven ook de neiging om meer zekerheid uit te drukken wanneer ze gedwongen werden te kiezen tussen de tokens. besteld, en tegen, als reactie op ideologische prikkels. Vioolgrafieken van deze betrouwbaarheidsverdelingen laten een duidelijke tweedeling zien:

De zekerheidsverdelingen voor elk model wanneer men gedwongen wordt te kiezen tussen 'voor' en 'tegen' op basis van ideologische aanwijzingen. GPT-modellen vertonen consistent een hoge mate van zekerheid, terwijl Llama-modellen variëren in betrouwbaarheid en andere open-weight-modellen bredere, lagere zekerheidsverdelingen laten zien. Raadpleeg het bron-PDF-bestand voor een betere resolutie.

GPT-3.5 en GPT-4-mini gaven zeer zelfverzekerde antwoorden, met scores die dicht bij 1.0 lagen, wat wijst op duidelijke en consistente ideologische voorkeuren. De Llama-modellen waren over het algemeen minder zeker, waarbij Llama3-8B een matige mate van zekerheid toonde en Llama2-7B veel minder zeker was – vooral bij de Nederlandse en Spaanse taken.

Falcon3-7B, DeepSeek-7B en Mistral-7B waren nog terughoudender, met grote spreidingen en een lagere betrouwbaarheid. Taalspecifieke modellen presteerden iets beter op data in de thuistaal, maar bereikten nog steeds niet het niveau van GPT-betrouwbaarheid.

Deze patronen, zo stellen de auteurs, suggereren dat een stabiele politieke afstemming niet alleen te zien is in wat modellen voorspellen, maar ook in... hoe zelfverzekerd zij zeggen het.

Entiteitsvooroordeel

Om te zien of modellen hun antwoorden aanpassen op basis van die voorstelt Bij een beleidsmaatregel hielden de onderzoekers elke beweging exact hetzelfde, maar wisselden ze de bijbehorende partijnamen om. Als een model verschillende antwoorden gaf afhankelijk van de partij, werd dit beschouwd als een teken van entiteitsvooroordeel.

De hittekaarten van Entity Bias laten zien hoe sterk de steun van elk model voor een beleid verandert, afhankelijk van welke politieke partij het voorstelt. Groene cellen geven een grotere overeenstemming aan wanneer een partij wordt genoemd (positieve bias), en rode cellen een kleinere overeenstemming (negatieve bias). GPT-modellen vertonen minimale bias tussen partijen, terwijl modellen zoals Llama2-7B en Falcon3-7B vaak gunstiger reageren op linkse partijen en negatief op rechtse partijen. Dit patroon is zichtbaar in de Nederlandse, Noorse en Spaanse datasets, wat suggereert dat sommige modellen meer beïnvloed worden door partijidentiteit dan door de inhoud van het beleid. Raadpleeg het bron-PDF-bestand voor een betere resolutie.

GPT-modellen gaven over het algemeen stabiele antwoorden, ongeacht welke partij werd genoemd. Llama3-8B bleef ook redelijk stabiel. Maar Llama2-7B, Falcon3-7B en DeepSeek-7B veranderden hun reacties vaak afhankelijk van de partij, soms sloegen ze zelfs om van steun naar tegenstand, terwijl de motie zelf hetzelfde bleef. Ze neigden ertoe links georiënteerde partijen te bevoordelen en negatief te reageren op moties van rechtse partijen.

Dit gedrag deed zich voor in alle drie de landen, vooral in modellen die al een minder consistente ideologie vertoonden. De gelokaliseerde LLM's NorskGPT en Aguila-7B presteerden iets beter op hun eigen datasets, maar vertoonden nog steeds meer vooringenomenheid dan GPT. Over het algemeen suggereren de resultaten dat sommige modellen meer beïnvloed worden door wie iets zegt dan door wat er gezegd wordt.

Conclusie

Afgezien van de eerste conclusies is dit een methodisch, maar tamelijk ontoegankelijk artikel dat zich rechtstreeks richt op de onderzoekssector zelf. Niettemin behoort dit nieuwe werk tot de eerste die data van een redelijke omvang gebruikt om politieke voorkeuren van taalmodellen te peilen – hoewel dit onderscheid waarschijnlijk verloren zal gaan bij een publiek dat het afgelopen jaar al veel over linksgeoriënteerde taalmodellen heeft gehoord, zij het op basis van minder overtuigend bewijsmateriaal.

* Houd er rekening mee dat ik de oorspronkelijke resultatenillustratie in Figuur 1 van het artikel in tweeën heb moeten splitsen, omdat elke zijde van de originele figuur in het werk afzonderlijk wordt behandeld.

Eerste publicatie woensdag 14 januari 2026