인공 지능

연구원들은 GPU의 대안을 만듭니다

Rice University의 컴퓨터 과학자들은 Intel의 공동 작업자와 함께 GPU에 대한 보다 비용 효율적인 대안을 개발했습니다. 새로운 알고리즘은 "SLIDE(Sub-Linear Deep Learning Engine)"라고 불리며 특수 가속 하드웨어 없이 범용 중앙 처리 장치(CPU)를 사용합니다.

결과는 머신러닝 시스템 컨퍼런스 MLSys가 열리는 오스틴 컨벤션 센터에서 발표됐다.

인공 지능(AI)의 가장 큰 과제 중 하나는 그래픽 처리 장치(GPU)와 같은 특수 가속 하드웨어를 둘러싼 것입니다. 새로운 개발 이전에는 딥 러닝 기술의 속도를 높이려면 이 특수 가속 하드웨어의 사용이 필요하다고 믿었습니다.

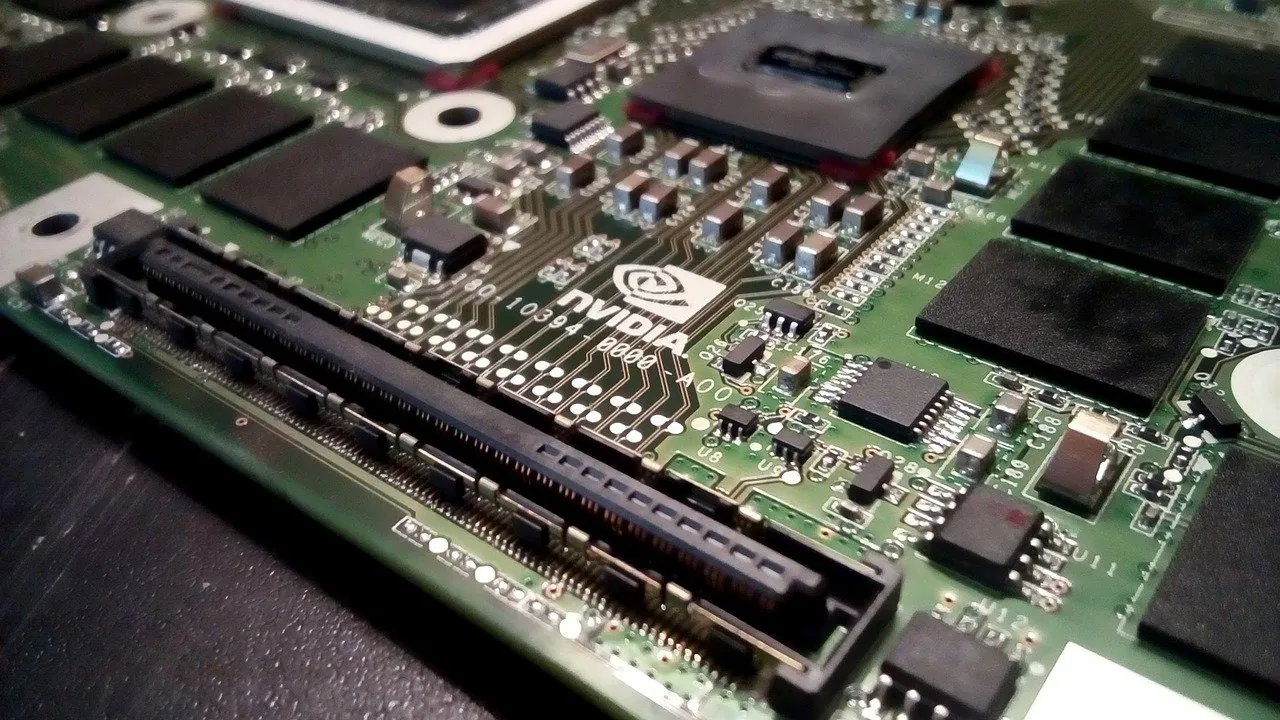

많은 기업들이 디지털 비서, 안면 인식, 제품 추천 시스템 등의 기술을 담당하는 딥 러닝을 위한 GPU 및 특수 하드웨어에 대한 투자를 매우 중요하게 생각하고 있습니다. 그러한 회사 중 하나는 Tesla V100 Tensor Core GPU를 만드는 Nvidia입니다. Nvidia는 최근 작년에 비해 41분기 매출이 XNUMX% 증가했다고 보고했습니다.

SLIDE의 개발은 완전히 새로운 가능성을 열어줍니다.

안슈말리 슈리바스타바(Anshumali Shrivastava)는 라이스 브라운 공대 조교수이며 대학원생인 Beidi Chen 및 Tharun Medini와 함께 SLIDE를 발명하는 데 도움을 주었습니다.

Shrivastava는 "우리의 테스트는 SLIDE가 완전히 연결된 대규모 아키텍처가 있는 업계 규모의 권장 데이터 세트에서 GPU 하드웨어 가속을 능가할 수 있는 CPU에서 딥 러닝을 구현한 최초의 스마트 알고리즘임을 보여줍니다."라고 말했습니다.

SLIDE는 딥 러닝에 대한 완전히 다른 접근 방식으로 인해 GPU의 문제를 극복합니다. 현재 심층 신경망의 표준 훈련 기법은 "역전파"이며 행렬 곱셈이 필요합니다. 이 워크로드에는 GPU를 사용해야 하므로 연구원들은 해시 테이블로 해결할 수 있도록 신경망 훈련을 변경했습니다.

이 새로운 접근 방식은 SLIDE의 계산 오버헤드를 크게 줄입니다. Amazon 및 Google과 같은 회사가 클라우드 기반 딥 러닝에 사용하는 현재 최고의 GPU 플랫폼에는 100개의 Tesla V100,000이 있으며 가격표는 약 $XNUMX입니다.

Shrivastava는 "실험실에 하나가 있고 테스트 사례에서 우리는 V100에 완벽한 워크로드를 가져왔습니다. 하나는 GPU 메모리에 맞는 대규모의 완전히 연결된 네트워크에서 100억 개 이상의 매개변수가 있는 워크로드입니다."라고 Shrivastava는 말했습니다. “우리는 최고의 (소프트웨어) 패키지인 Google의 TensorFlow로 그것을 훈련시켰고 훈련하는 데 3시간 반이 걸렸습니다.

"그런 다음 우리는 우리의 새로운 알고리즘이 GPU가 아닌 44코어 Xeon급 CPU에서 XNUMX시간 만에 교육을 수행할 수 있음을 보여주었습니다."라고 그는 계속했습니다.

해싱은 1990년대 인터넷 검색을 위해 발명된 일종의 데이터 인덱싱 방법이다. 수치적 방법은 많은 양의 정보를 해시라고 하는 일련의 숫자로 인코딩하는 데 사용됩니다. 해시를 나열하여 빠르게 검색할 수 있는 테이블을 생성합니다.

Chen은 "TensorFlow 또는 PyTorch에서 우리 알고리즘을 구현하는 것은 이치에 맞지 않았을 것입니다. 그들이 가장 먼저 하고 싶은 일은 무엇이든 행렬 곱셈 문제로 변환하는 것이기 때문입니다."라고 말했습니다. “그것이 바로 우리가 벗어나고 싶었던 것입니다. 그래서 처음부터 우리만의 C++ 코드를 작성했습니다.”

Shrivastava에 따르면 SLIDE의 가장 큰 장점은 데이터 병렬이라는 것입니다.

"데이터 병렬이라는 말은 내가 훈련하고 싶은 두 개의 데이터 인스턴스가 있는 경우 하나는 고양이 이미지이고 다른 하나는 버스 이미지라고 가정하면 서로 다른 뉴런을 활성화할 가능성이 높으며 SLIDE가 업데이트하거나 훈련할 수 있음을 의미합니다. 이 두 가지에 대해 독립적으로”라고 그는 말했습니다. "이것은 CPU의 병렬 처리를 훨씬 더 잘 활용하는 것입니다."

"GPU에 비해 단점은 큰 메모리가 필요하다는 것입니다."라고 그는 말했습니다. "메인 메모리에는 캐시 계층 구조가 있으며, 이를 주의하지 않으면 캐시 미스가 많이 발생하는 캐시 스래싱이라는 문제에 직면할 수 있습니다."

SLIDE는 딥 러닝을 구현하는 새로운 방법의 문을 열었으며 Shrivastava는 이것이 시작일 뿐이라고 믿습니다.

"우리는 단지 표면을 긁었습니다."라고 그는 말했습니다. “최적화를 위해 아직 할 수 있는 일이 많습니다. 예를 들어 벡터화나 Intel Deep Learning Boost와 같은 CPU의 내장 가속기를 사용하지 않았습니다. 더 빠르게 만들기 위해 사용할 수 있는 다른 트릭이 많이 있습니다.”