인공 지능

GPU는 심층 신경망 훈련에서 더 빠를 뿐만 아니라 더 우수할 수 있습니다.

Sony와 협력하는 폴란드와 일본의 연구원들은 CPU가 아닌 GPU에서 훈련된 기계 학습 시스템이 훈련 과정에서 오류가 적고 우수한 결과를 생성할 수 있다는 증거를 발견했습니다. 이는 GPU가 단순히 그러한 작업을 더 빠르게 수행한다는 일반적인 이해와 모순됩니다. 그 어떤 것보다 낫습니다.

XNUMXD덴탈의 연구제목 GPU 불확실성이 예측 심층 신경망 훈련에 미치는 영향, Sony Computer Science Laboratories와 함께 Adam Mickiewicz University 및 XNUMX개의 일본 대학의 심리학 및 인지 과학 학부 출신입니다.

연구는 다음과 같이 제안합니다. '불확실성' 다양한 하드웨어 및 소프트웨어 구성에 직면하여 더 비싼 것을 선호하는 심층 신경망(및 점점 희소해지는) 그래픽 처리 장치이며 테스트에서 CPU에서만 독점적으로 훈련된 심층 신경망이 동일한 Epoch(세션 과정에서 시스템이 훈련 데이터를 재처리하는 횟수) 동안 더 높은 오류율을 생성하는 것으로 나타났습니다.

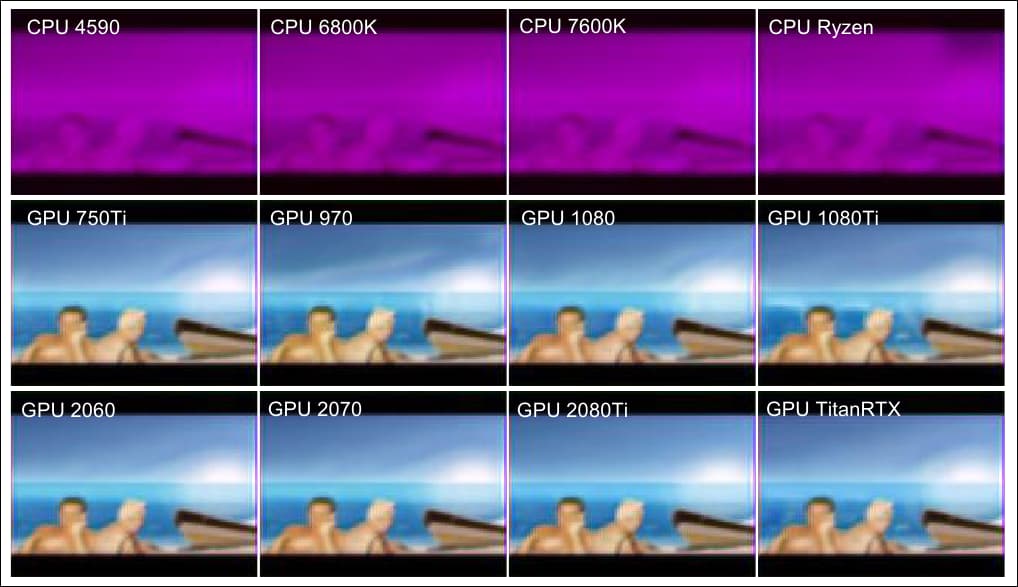

논문의 이 추가 예에서 다양한 GPU에서 얻은 유사한 결과 품질과 (첫 번째 행) 성능이 매우 뛰어난 다양한 CPU에서 얻은 열등한 결과를 볼 수 있습니다(하단 두 행).. 출처: https://arxiv.org/pdf/2109.01451.pdf

이상한 현상

이러한 예비 결과는 널리 사용되는 기계 학습 알고리즘에 균일하게 적용되지 않으며 간단한 자동 인코더 아키텍처의 경우 현상이 나타나지 않습니다.

그럼에도 불구하고 이 작업은 복잡한 신경망에서 훈련의 효율성에 대한 가능한 '탈출 속도'를 암시합니다. 여기서 동일한 작업을 더 낮은 속도와 더 큰 훈련 시간으로 처리하는 것은 수학적 반복 루틴에서 기대하는 성능의 패리티를 얻지 못합니다.

연구원들은 이러한 성능 차이가 특정 유형의 신경망에만 국한될 수 있으며, 종종 극복해야 할 장애물로 여겨지는 GPU 관련 처리의 불확실한 측면이 주목할만한 이점을 제공할 뿐만 아니라 결국 의도적으로 이후 시스템에 통합되었습니다. 이 논문은 또한 이번 발견이 뇌와 관련된 계산 처리에 대한 더 깊은 통찰력을 제공할 수 있다고 제안합니다.

GPU에서 이러한 방식으로 결과의 효율성과 품질을 높이는 특성을 식별하면 '블랙 박스' AI 아키텍처에 대한 더 깊은 통찰력을 얻을 수 있고 심지어 CPU 성능을 향상시킬 수 있는 잠재력이 있습니다. 하지만 현재로서는 근본 원인을 파악하기 어렵습니다.

자동 인코더 대. 프레드넷

연구원들은 이상 현상을 연구할 때 기본 자동 인코더와 하버드 대학의 예측 신경망을 사용했습니다. 프레드넷, 인간 대뇌 피질의 행동을 탐구하고 복제하려고 시도하도록 설계된 2016년 연구.

두 시스템 모두 비지도 학습(레이블이 생략된 데이터 포함)을 통해 적절한 이미지를 합성하도록 설계된 심층 신경망이지만, 오토인코더는 배치당 하나의 이미지를 선형적으로 처리하여 반복 파이프라인에서 다음 이미지로 출력을 생성합니다. 오토인코더는 다음과 같이 훈련되었습니다. MNIST 손글씨 데이터베이스.

연구원 테스트의 오토인코더는 MNIST 데이터베이스에서 훈련되었으며, 이는 60,000×28 픽셀의 28개의 훈련 이미지, 그레이 스케일 유도를 위한 앤티 앨리어싱 및 10,000개의 테스트 이미지로 구성됩니다.

대조적으로 PredNet은 복잡한 비디오 입력을 평가하며 이 연구의 경우 FPSI 데이터 세트, 플로리다 주 올랜도에 있는 디즈니 월드에서 하루의 광범위한 신체 착용 비디오 영상을 제공합니다(디즈니는 2012년 논문의 연구원 중 한 명이었습니다).

Disney World의 어느 날 XNUMX인칭 시점을 보여주는 FPSI의 이미지 시퀀스.

두 아키텍처는 복잡성 측면에서 매우 다릅니다. 오토인코더는 목표 값을 예측하기보다는 이미지를 재구성하도록 설계되었습니다. 대조적으로 PredNet은 4개의 레이어를 갖추고 있으며 각 레이어는 LSTM(Convolutional Long Short-Term Memory)을 사용하는 표현 뉴런으로 구성됩니다.

계층은 네트워크 전체에 전파되는 오류 용어를 생성하기 위해 대상과 비교되는 컨텍스트 예측을 출력합니다. 두 모델은 각각 비지도 학습을 활용합니다.

Autoencoder의 단순하고 선형적인 아키텍처와 PredNet의 보다 미로적이고 재귀적인 네트워크입니다.

두 시스템 모두 GPU가 없는 CPU(Intel i5-4590, i7-6800K, i5-7600K 또는 AMD Ryzen-5-3600) 및 GPU가 있는 CPU(Intel i5-7600K + NVIDIA)를 포함한 일련의 하드웨어 및 소프트웨어 구성에서 테스트되었습니다. GTX-750Ti, i5-7600K + GTX-970, i7-6700K + GTX-1080, i7-7700K + GTX-1080Ti, i7-9700 + RTX-2080Ti, i5-7600K + RTX-2060 슈퍼, AMD Ryzen-5- 3600 + RTX-2070 슈퍼 또는 i5-9400 + Titan-RTX).

대화식 프로세스 뷰어 htop 모든 교육이 단일 스레드(Intel i7-6800K), 5개 스레드(Intel i4590-5 및 i7600-5K) 또는 3600개 스레드(AMD Ryzen-XNUMX-XNUMX)에서 수행되도록 하는 데 사용되었습니다. ).

안장점

오토인코더에서 cuDNN이 있거나 없는 모든 구성의 평균 차이는 중요하지 않았습니다. PredNet의 경우 CPU와 GPU 교육 간의 손실 평가 및 품질에서 눈에 띄는 차이가 있어 결과가 더욱 놀라웠습니다.

5000개의 CPU와 250개의 GPU에 걸친 PredNet 훈련의 평균 손실 결과는 네트워크가 1000개의 배치에서 50개의 비디오 프레임에 대해 훈련되었으며 마지막 XNUMX개 프레임(XNUMX개의 배치)에 대한 평균 손실이 묘사되었습니다. cuDNN이 꺼졌습니다.

연구원들은 다음과 같이 결론을 내립니다. '메커니즘은 불분명하지만 GPU 하드웨어는 DNN의 훈련을 발전시킬 수 있는 능력이 있는 것 같습니다.'

결과는 GPU가 안장점(경사면의 바닥을 설명하는 경사 하강 영역)을 피하는 데 더 나을 수 있음을 나타냅니다.

경사 하강법에서 기울기의 최하점은 명백한 이유로 명명된 '안장점'입니다. 출처: https://www.pinterest.com.au/pin/436849232581124086/

장애물이기는 하지만 안장점은 확률적 경사하강법(SGD)의 최적화에 대한 최근의 생각에서 쉽게 해결되었기 때문에 대체로 무시되었지만, 새로운 논문은 GPU가 이를 피하기 위해 고유하게 준비되었을 수 있을 뿐만 아니라 안장 지점을 다시 방문해야 합니다.