Intelligenza Artificiale

Perché gli studenti LLM pensano troppo ai puzzle facili ma rinunciano a quelli difficili

L'intelligenza artificiale ha fatto notevoli progressi, con i Large Language Models (LLM) e le loro controparti avanzate, Modelli di ragionamento di grandi dimensioni (LRM), ridefinendo il modo in cui le macchine elaborano e generano testi simili a quelli umani. Questi modelli possono scrivere saggi, rispondere a domande e persino risolvere problemi matematici. Tuttavia, nonostante le loro impressionanti capacità, questi modelli mostrano un comportamento curioso: spesso complicano eccessivamente i problemi semplici mentre hanno difficoltà con quelli complessi. Un recente studio I ricercatori Apple forniscono preziose informazioni su questo fenomeno. Questo articolo esplora perché gli LLM e gli LRM si comportano in questo modo e cosa significa per il futuro dell'IA.

Comprensione degli LLM e degli LRM

Per capire perché gli LLM e gli LRM si comportino in questo modo, dobbiamo prima chiarire cosa sono questi modelli. Gli LLM, come GPT-3 o BERT, vengono addestrati su vasti set di dati testuali per predire la parola successiva in una sequenza. Questo li rende eccellenti in compiti come la generazione di testo, la traduzione e la sintesi. Tuttavia, non sono intrinsecamente progettati per il ragionamento, che implica la deduzione logica o la risoluzione di problemi.

Gli LRM sono una nuova classe di modelli progettati per colmare questa lacuna. Incorporano tecniche come Catena di pensiero (CoT) prompting, in cui il modello genera passaggi di ragionamento intermedi prima di fornire una risposta definitiva. Ad esempio, quando si risolve un problema di matematica, un LRM potrebbe scomporlo in passaggi, proprio come farebbe un essere umano. Questo approccio migliora le prestazioni nei compiti complessi, ma presenta delle difficoltà quando si affrontano problemi di varia complessità, come rivela lo studio di Apple.

Lo studio di ricerca

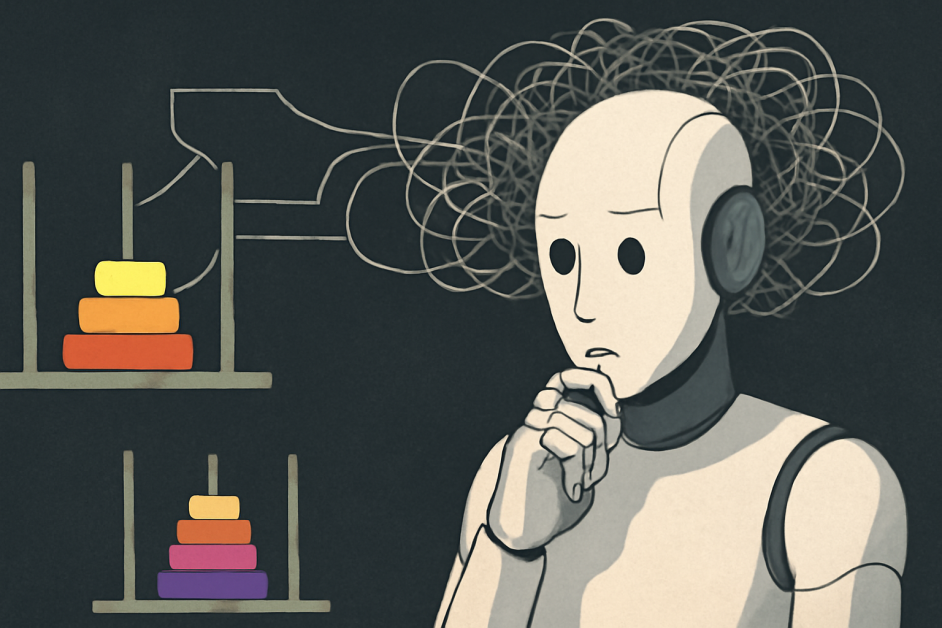

Il team di ricerca Apple ha adottato una strategia diversa approccio Per valutare le capacità di ragionamento di LLM e LRM. Invece di affidarsi a parametri di riferimento tradizionali come test di matematica o di programmazione, che possono essere influenzati dalla contaminazione dei dati (dove i modelli memorizzano le risposte), hanno creato ambienti di puzzle controllati. Tra questi, puzzle noti come Torre di Hanoi, Salto della dama, Attraversamento del fiumee Blocks World. Ad esempio, la Torre di Hanoi prevede lo spostamento di dischi tra i pioli seguendo regole specifiche, con una complessità crescente all'aumentare del numero di dischi aggiunti. Regolando sistematicamente la complessità di questi puzzle, mantenendo al contempo strutture logiche coerenti, i ricercatori osservano le prestazioni dei modelli in un ampio spettro di difficoltà. Questo metodo ha permesso loro di analizzare non solo le risposte finali, ma anche i processi di ragionamento, che offrono una visione più approfondita del modo in cui questi modelli "pensano".

Risultati sul ripensamento e la rinuncia

Lo studio ha individuato tre distinti regimi di prestazione in base alla complessità del problema:

- A bassi livelli di complessità, gli LLM standard spesso hanno prestazioni migliori degli LRM perché gli LRM tendono a pensare troppo, generando passaggi extra non necessari, mentre gli LLM standard sono più efficienti.

- Per problemi di media complessità, gli LRM mostrano prestazioni superiori grazie alla loro capacità di generare tracce di ragionamento dettagliate che li aiutano ad affrontare queste sfide in modo efficace.

- Nei problemi ad elevata complessità, sia gli LLM che gli LRM falliscono completamente; gli LRM, in particolare, subiscono un crollo totale in termini di accuratezza e riducono il loro sforzo di ragionamento nonostante la maggiore difficoltà.

Per enigmi semplici, come la Torre di Hanoi con uno o due dischi, gli LLM standard erano più efficienti nel fornire risposte corrette. Gli LRM, tuttavia, spesso si soffermavano eccessivamente su questi problemi, generando lunghe tracce di ragionamento anche quando la soluzione era semplice. Ciò suggerisce che gli LRM potrebbero imitare spiegazioni esagerate provenienti dai loro dati di training, il che potrebbe portare a inefficienza.

In scenari di media complessità, gli LRM hanno ottenuto risultati migliori. La loro capacità di produrre passaggi di ragionamento dettagliati ha permesso loro di affrontare problemi che richiedevano più passaggi logici. Questo permette loro di ottenere risultati migliori rispetto agli LLM standard, che faticavano a mantenere la coerenza.

Tuttavia, per enigmi altamente complessi, come la Torre di Hanoi con molti dischi, entrambi i modelli hanno fallito completamente. Sorprendentemente, i LRM hanno ridotto il loro sforzo di ragionamento all'aumentare della complessità oltre un certo limite, pur disponendo di risorse computazionali sufficienti. Questo comportamento di "rinuncia" indica una limitazione fondamentale nella loro capacità di scalare le capacità di ragionamento.

Perché questo accade

L'eccessiva riflessione sui puzzle semplici deriva probabilmente dal modo in cui vengono addestrati gli LLM e gli LRM. Questi modelli apprendono da vasti set di dati che includono spiegazioni sia concise che dettagliate. Per i problemi semplici, potrebbero generare automaticamente tracce di ragionamento verbose, imitando i lunghi esempi presenti nei loro dati di addestramento, anche quando una risposta diretta sarebbe sufficiente. Questo comportamento non è necessariamente un difetto, ma un riflesso del loro addestramento, che privilegia il ragionamento rispetto all'efficienza.

Il fallimento nei puzzle complessi riflette l'incapacità di LLM e LRM di imparare a generalizzare le regole logiche. Con l'aumentare della complessità del problema, la loro dipendenza dal pattern matching si affievolisce, portando a ragionamenti incoerenti e a un crollo delle prestazioni. Lo studio ha rilevato che gli LRM non riescono a utilizzare algoritmi espliciti e ragionano in modo incoerente tra i diversi puzzle. Ciò evidenzia che, sebbene questi modelli possano simulare il ragionamento, non ne comprendono appieno la logica sottostante come fanno gli esseri umani.

Diverse Prospettive

Questo studio ha acceso il dibattito nella comunità dell'intelligenza artificiale. Alcuni esperti discutere che questi risultati potrebbero essere fraintesoSuggeriscono che, sebbene gli LLM e gli LRM possano non ragionare come gli esseri umani, dimostrano comunque un'efficace capacità di problem-solving entro certi limiti di complessità. Sottolineano che il "ragionamento" nell'IA non deve necessariamente rispecchiare la cognizione umana per essere prezioso. Analogamente, discussioni Su piattaforme come Hacker News, si elogia l'approccio rigoroso dello studio, ma si sottolinea la necessità di ulteriori ricerche per migliorare il ragionamento dell'IA. Queste prospettive sottolineano il dibattito in corso su cosa costituisca il ragionamento nell'IA e come dovremmo valutarlo.

Implicazioni e direzioni future

I risultati dello studio hanno implicazioni significative per lo sviluppo dell'IA. Sebbene i modelli di ragionamento a lungo termine rappresentino un progresso nell'imitazione del ragionamento umano, i loro limiti nella gestione di problemi complessi e nell'adattabilità degli sforzi di ragionamento suggeriscono che i modelli attuali sono ben lungi dal raggiungere un ragionamento generalizzabile. Ciò evidenzia la necessità di nuovi metodi di valutazione che si concentrino sulla qualità e l'adattabilità dei processi di ragionamento, non solo sull'accuratezza delle risposte finali.

La ricerca futura dovrebbe mirare a migliorare la capacità dei modelli di eseguire accuratamente i passaggi logici e di adattare il loro sforzo di ragionamento in base alla complessità del problema. Sviluppare benchmark che riflettano compiti di ragionamento reali, come la diagnosi medica o l'argomentazione legale, potrebbe fornire approfondimenti più significativi sulle capacità dell'IA. Inoltre, affrontare l'eccessiva dipendenza dei modelli dal riconoscimento di pattern e migliorare la loro capacità di generalizzare regole logiche sarà fondamentale per il progresso del ragionamento dell'IA.

Conclusione

Lo studio fornisce un'analisi critica delle capacità di ragionamento di LLM e LRM. Dimostra che, sebbene questi modelli analizzino eccessivamente i puzzle semplici, hanno difficoltà con quelli più complessi, esponendone sia i punti di forza che i limiti. Sebbene funzionino bene in determinate situazioni, la loro incapacità di affrontare problemi altamente complessi evidenzia il divario tra il ragionamento simulato e la vera comprensione. Lo studio sottolinea la necessità di sviluppare un sistema di intelligenza artificiale in grado di ragionare in modo adattivo su diversi livelli di complessità, consentendogli di affrontare problemi di diversa complessità, proprio come fanno gli esseri umani.