Intelligenza Artificiale

Il districamento è la prossima rivoluzione dei deepfake

L'aumento dei dati CGI viene utilizzato in un nuovo progetto per ottenere un maggiore controllo sulle immagini deepfake. Sebbene non sia ancora possibile utilizzare efficacemente le teste CGI per colmare le lacune mancanti nei set di dati facciali deepfake, una nuova ondata di ricerca per districare l'identità dal contesto significa che presto potrebbe non essere necessario.

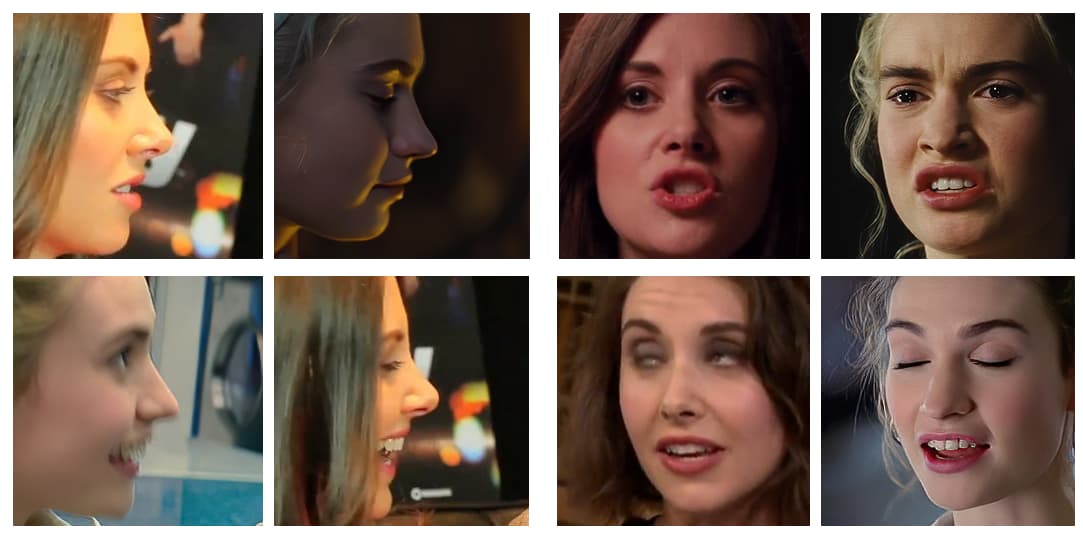

I creatori di alcuni dei video deepfake virali di maggior successo degli ultimi anni selezionano i loro video di origine con molta attenzione, evitando riprese di profilo prolungate (ovvero il tipo di foto segnaletiche laterali rese popolari dalle procedure di arresto della polizia), angoli acuti ed espressioni insolite o esagerate . Sempre più spesso, i video dimostrativi prodotti dai deepfaker virali sono compilation modificate che selezionano gli angoli e le espressioni "più semplici" per il deepfake.

Infatti, il video target più accomodante in cui inserire una celebrità deepfake è quello in cui la persona originale (la cui identità verrà cancellata dal deepfake) guarda dritto alla telecamera, con una gamma minima di espressioni.

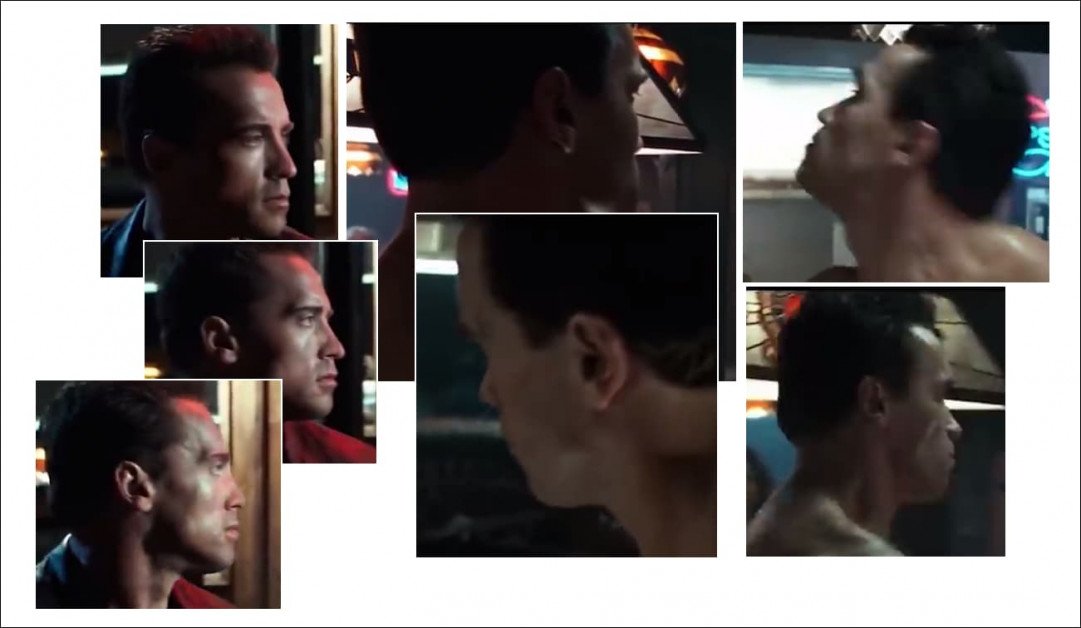

La maggior parte dei deepfake popolari degli ultimi anni ha mostrato soggetti direttamente di fronte alla telecamera, e recanti solo espressioni popolari (come sorridere), che possono essere facilmente estratte dall'output dei paparazzi sul tappeto rosso, o (come con il falso del 2019 di Sylvester Stallone come Terminator, nella foto a sinistra), idealmente senza alcuna espressione, poiché le espressioni neutre sono estremamente comuni, rendendole facili da incorporare nei modelli deepfake.

Perché tecnologie deepfake come DeepFaceLab e Cambia faccia eseguire molto bene questi scambi più semplici, siamo sufficientemente abbagliati da ciò che realizzano da non notare ciò di cui sono incapaci e, spesso, non tentano nemmeno:

Prende da un acclamato video deepfake in cui Arnold Schwarzenegger viene trasformato in Sylvester Stallone, a meno che gli angoli non siano troppo complicati. I profili rimangono un problema duraturo con gli attuali approcci deepfake, in parte perché il software open source utilizzato per definire le pose facciali nei framework deepfake non è ottimizzato per le viste laterali, ma principalmente a causa della mancanza di materiale sorgente adatto in uno o entrambi i necessari set di dati. Fonte: https://www.youtube.com/watch?v=AQvCmQFScMA

Una nuova ricerca da Israele propone un nuovo metodo di utilizzo di dati sintetici, come le teste CGI, per portare il deepfaking negli anni '2020, separando veramente le identità facciali (ovvero le caratteristiche facciali essenziali di "Tom Cruise", da tutti gli angoli) dal loro contesto (ovvero guardando in alto, guardando di traverso, accigliato, accigliato nel buio, sopracciglia corrugate, occhi chiusi, Ecc.).

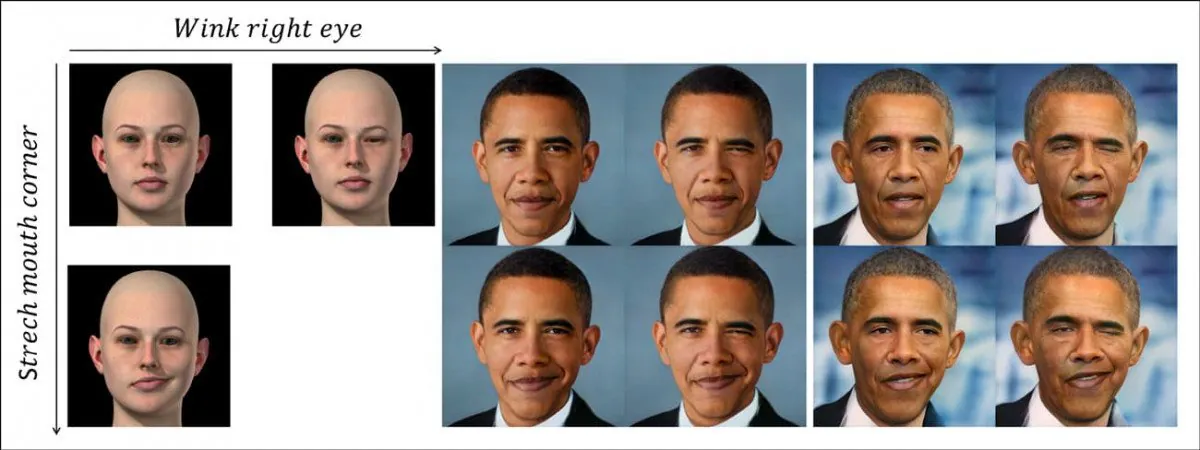

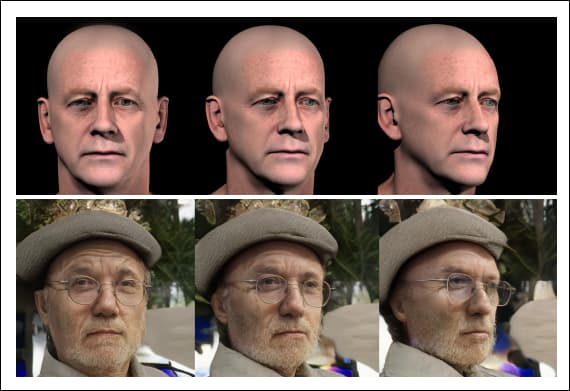

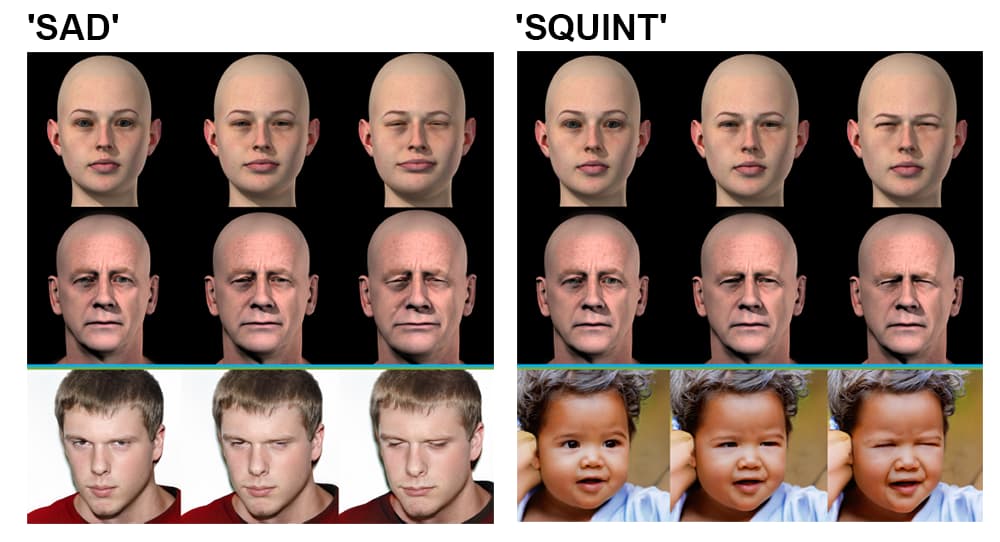

Il nuovo sistema separa in modo discreto la posa e il contesto (ad es. strizzando l'occhio) dalla codifica dell'identità dell'individuo, utilizzando dati facciali sintetici non correlati (foto a sinistra). Nella riga in alto, vediamo un 'occhiolino' trasferito sull'identità di Barack Obama, suggerito dal percorso non lineare appreso dello spazio latente di un GAN, rappresentato dall'immagine CGI a sinistra. Nella riga in basso, vediamo la sfaccettatura allungata dell'angolo della bocca trasferita sull'ex presidente. In basso a destra, vediamo entrambe le caratteristiche applicate contemporaneamente. Fonte: https://arxiv.org/pdf/2111.08419.pdf

Questo non è semplice burattino di testa deepfake, una tecnica più adatta per gli avatar e la sincronizzazione labiale parziale del viso e che ha un potenziale limitato per trasformazioni video deepfake a tutti gli effetti.

Piuttosto, questo rappresenta una via da seguire per una separazione fondamentale della strumentalità (come ad esempio 'cambia l'angolazione della testa', 'creare un cipiglio') dall'identità, offrendo un percorso verso un framework deepfake basato sulla sintesi di immagini di alto livello piuttosto che "derivato".

Il nuovo documento è intitolato Delta-GAN-Encoder: codifica delle modifiche semantiche per l'editing esplicito delle immagini, utilizzando pochi campioni sintetici, e proviene dai ricercatori del Technion – Israel Institute of Technology.

Per capire cosa significa il lavoro, diamo un'occhiata a come i deepfake sono attualmente prodotti ovunque dai siti porno deepfake a Luce industriale e magia (poiché il repository open source DeepFaceLab è attualmente dominante sia nel deepfaking "amatoriale" che in quello professionale).

Cosa trattiene l'attuale tecnologia Deepfake?

I deepfake sono attualmente creati addestrando un codificatore/decodificatore modello di apprendimento automatico su due cartelle di immagini di volti: la persona su cui vuoi "dipingere" (nell'esempio precedente, è Arnie) e la persona che vuoi sovrapporre al filmato (Sly).

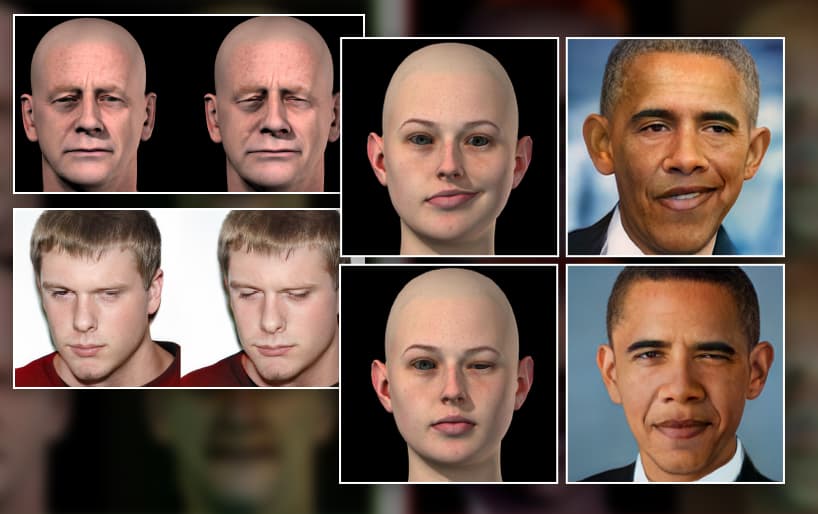

Esempi di diverse pose e condizioni di illuminazione su due diversi set di volti. Si noti l'espressione distintiva alla fine della terza riga nella colonna A, che è improbabile che abbia un equivalente vicino nell'altro insieme di dati.

Il sistema encoder/decoder quindi confronta ogni singola immagine in ciascuna cartella l'una con l'altra, sostenendo, migliorando e ripetendo questa operazione per centinaia di migliaia di iterazioni (spesso fino a una settimana), finché non comprende le caratteristiche essenziali di entrambe le identità abbastanza bene da scambiarle a piacimento.

Per ciascuna delle due persone che vengono scambiate nel processo, ciò che l'architettura deepfake apprende sull'identità è intrecciato con il contesto. Non può apprendere e applicare principi su una posa generica "per sempre", ma ha bisogno di abbondanti esempi nel set di dati di addestramento, per ogni singola identità che sarà coinvolta nello scambio di volti.

Pertanto, se vuoi scambiare due identità che stanno facendo qualcosa di più insolito del semplice sorridere o guardare dritto alla telecamera, avrai bisogno molti istanze di quella particolare posa/identità attraverso i due set di volti:

Poiché l'ID facciale e le caratteristiche della posa sono attualmente così intrecciate, è necessaria un'ampia parità di espressione, posa della testa e (in misura minore) illuminazione su due set di dati facciali per addestrare un modello deepfake efficace su sistemi come DeepFaceLab. Meno una configurazione particolare (come "vista laterale/sorridente/illuminato dal sole") è presente in entrambi i set di volti, meno accuratamente verrà renderizzata in un video deepfake, se necessario.

Se il set A contiene la posa insolita, ma il set B ne è privo, sei praticamente sfortunato; non importa per quanto tempo alleni il modello, non imparerà mai a riprodurre bene quella posa tra le identità, perché aveva solo la metà delle informazioni necessarie quando è stato addestrato.

Anche se hai immagini corrispondenti, potrebbe non essere sufficiente: se il set A ha la posa corrispondente, ma con una forte illuminazione laterale, rispetto alla posa equivalente a luce piatta nell'altro set di volti, la qualità dello scambio ha vinto non sarebbe buono come se ognuno condividesse caratteristiche di illuminazione comuni.

Perché i dati sono scarsi

A meno che tu non venga arrestato regolarmente, probabilmente non avrai così tante foto di profilo laterale di te stesso. Qualunque cosa sia venuta fuori, probabilmente l'hai buttata via. Dal momento che le agenzie fotografiche fanno lo stesso, le foto del profilo sono difficili da trovare.

I deepfaker spesso includono più copie dei dati limitati del profilo della vista laterale che hanno per un'identità in un set di volti, solo così quella posa ottiene almeno un piccolo attenzione e tempo durante l'allenamento, invece di essere scontato come un valore anomalo.

Ma ci sono molti più possibili tipi di immagini del viso con vista laterale di quanti potrebbero essere disponibili per l'inclusione in un set di dati: sorridente, accigliato, urlando, pianto, oscuramente illuminato, sprezzante, annoiato, allegro, illuminato, guardando in alto, guardando giù, occhi aperti, Occhi chiusi…e così via. Ognuna di queste pose, in più combinazioni, potrebbe essere necessaria in un video di destinazione deepfake.

E questo è solo profili. Quante foto hai di te stesso che guardi verso l'alto? Ne hai abbastanza per rappresentare ampiamente il 10,000 possibili espressioni potresti indossare mentre mantieni quella posa esatta da quell'esatta angolazione della telecamera, coprendo almeno parte del un milione di possibili ambienti di illuminazione?

È probabile che tu non abbia nemmeno prima foto di te stesso che guardi in alto. E questi sono solo due angoli dei cento o più necessari per una copertura completa.

Anche se fosse possibile generare una copertura completa di un volto da tutte le angolazioni in una gamma di condizioni di illuminazione, il set di dati risultante sarebbe troppo grande per essere addestrato, nell'ordine di centinaia di migliaia di immagini; e anche se lo potuto essere addestrati, la natura del processo di addestramento per gli attuali framework deepfake getterebbe via la stragrande maggioranza di quei dati extra a favore di un numero limitato di funzionalità derivate, perché gli attuali framework sono riduzionisti e poco scalabili.

Sostituzione sintetica

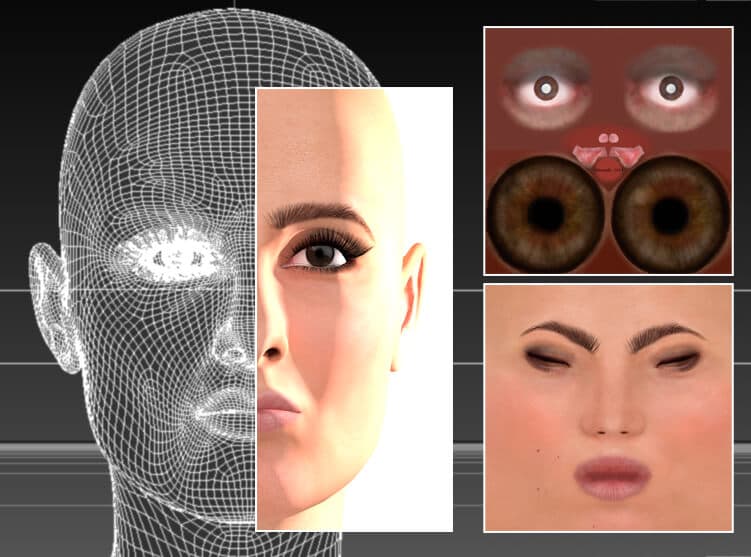

Dall'alba dei deepfake, i deepfaker hanno sperimentato l'utilizzo di immagini in stile CGI, teste realizzate in applicazioni 3D come Cinema4D e Maya, per generare quelle "pose mancanti".

Nessuna intelligenza artificiale necessaria; un'attrice viene ricreata in un programma CGI tradizionale, Cinema 4D, utilizzando mesh e texture bitmap, una tecnologia che risale agli anni '1960, ma che ha raggiunto un uso diffuso solo dagli anni '1990 in poi. In teoria, questo modello facciale potrebbe essere utilizzato per generare dati sorgente deepfake per pose insolite, stili di illuminazione ed espressioni facciali. In realtà, è stato di utilità limitata o nulla nel deepfaking, poiché la "falsità" dei rendering tende a trasparire nei video scambiati. Fonte: immagine dell'autore di questo articolo su https://rossdawson.com/futurist/implications-of-ai/comprehensive-guide-ai-artificial-intelligence-visual-effects-vfx/

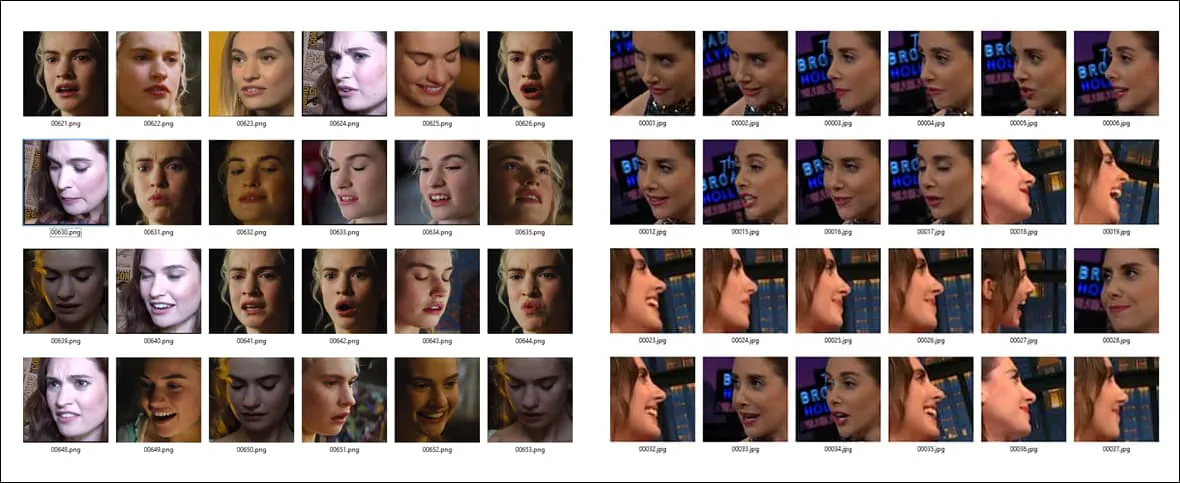

Questo metodo viene generalmente abbandonato presto dai nuovi professionisti del deepfake, perché sebbene possa fornire pose ed espressioni che altrimenti non sarebbero disponibili, l'aspetto sintetico dei volti CGI di solito passa attraverso gli scambi a causa dell'intreccio di ID e informazioni contestuali/semantiche.

Ciò può portare all'improvviso lampeggiare di volti della "valle perturbante" in un video deepfake altrimenti convincente, poiché l'algoritmo inizia ad attingere agli unici dati che potrebbe avere per una posa o un'espressione insolita: volti manifestamente falsi.

Tra i soggetti più popolari per i deepfaker c'è un algoritmo di deepfake 3D per l'attrice australiana Margot Robbie incluso nell'installazione predefinita di DeepFaceLive, una versione di DeepFaceLab in grado di eseguire deepfake in live streaming, come una sessione webcam. Una versione CGI, come nella foto sopra, potrebbe essere utilizzata per ottenere angoli "mancanti" insoliti nei set di dati deepfake. Source: https://sketchfab.com/3d-models/margot-robbie-bust-for-full-color-3d-printing-98d15fe0403b4e64902332be9cfb0ace

CGI Faces come linee guida distaccate e concettuali

Invece, il nuovo metodo Delta-GAN Encoder (DGE) dei ricercatori israeliani è più efficace, perché la posa e le informazioni contestuali dalle immagini CGI sono state completamente separate dalle informazioni di "identità" del bersaglio.

Possiamo vedere questo principio in azione nell'immagine sottostante, in cui sono stati ottenuti vari orientamenti della testa utilizzando le immagini CGI come linea guida. Poiché le caratteristiche dell'identità non sono correlate alle caratteristiche contestuali, non c'è trasparenza né dell'aspetto sintetico dall'aspetto falso del volto CGI, né dell'identità rappresentata in esso:

Con il nuovo metodo, non è necessario trovare tre immagini di origine reali separate per eseguire un deepfake da più angolazioni: puoi semplicemente ruotare la testa CGI, le cui caratteristiche astratte di alto livello sono imposte all'identità senza far trapelare alcun ID informazione.

Encoder Delta-GAN. Gruppo in alto a sinistra: l'angolo di un'immagine sorgente può essere modificato in un secondo per rendere una nuova immagine sorgente, che si riflette nell'output; gruppo in alto a destra: anche l'illuminazione viene svincolata dall'identità, consentendo la sovrapposizione di stili di illuminazione; gruppo in basso a sinistra: più dettagli facciali vengono alterati per creare un'espressione "triste"; gruppo in basso a destra: viene modificato un singolo dettaglio dell'espressione facciale, in modo che gli occhi siano socchiusi.

Questa separazione tra identità e contesto si realizza nella fase di formazione. La pipeline per la nuova architettura deepfake cerca il vettore latente in un GAN (Generative Adversarial Network) pre-addestrato che corrisponde all'immagine da trasformare: una metodologia Sim2Real che si basa su un 2018 progetto dalla sezione di ricerca AI di IBM.

I ricercatori osservano:

“Con solo pochi campioni, che differiscono per un attributo specifico, si può apprendere il comportamento districato di un modello generativo entangled pre-addestrato. Non sono necessari campioni esatti del mondo reale per raggiungere tale obiettivo, il che non è necessariamente fattibile.

"Utilizzando campioni di dati non realistici, lo stesso obiettivo può essere raggiunto sfruttando la semantica dei vettori latenti codificati." L'applicazione delle modifiche desiderate su campioni di dati esistenti può essere eseguita senza alcuna esplicita esplorazione del comportamento nello spazio latente.'

I ricercatori prevedono che i principi fondamentali del districamento esplorati nel progetto potrebbero essere trasferiti ad altri domini, come le simulazioni di architettura d'interni, e che il metodo Sim2Real adottato per Delta-GAN-Encoder potrebbe eventualmente abilitare strumenti deepfake basati su semplici schizzi, piuttosto che Input in stile CGI.

Si potrebbe sostenere che la misura in cui il nuovo sistema israeliano potrebbe o meno essere in grado di sintetizzare video deepfake è molto meno significativa dei progressi compiuti dalla ricerca nel districare il contesto dall'identità, nel processo ottenendo un maggiore controllo sullo spazio latente di un GAN.

Il districamento è un campo attivo di ricerca nella sintesi delle immagini; nel gennaio del 2021, una ricerca guidata da Amazon carta dimostrato un simile controllo della posa e districamento, e nel 2018 a carta degli Istituti di tecnologia avanzata di Shenzhen presso l'Accademia cinese delle scienze ha compiuto progressi nella generazione di punti di vista arbitrari in un GAN.