Kecerdasan Buatan

Mengapa Mahasiswa Bergelar Sarjana Sastra Terlalu Memikirkan Teka-teki yang Mudah tetapi Menyerah pada Teka-teki yang Sulit

Kecerdasan buatan telah membuat kemajuan yang luar biasa, dengan Model Bahasa Besar (LLM) dan rekan-rekannya yang lebih maju, Model Penalaran Besar (LRM), mendefinisikan ulang cara mesin memproses dan menghasilkan teks seperti manusia. Model-model ini dapat menulis esai, menjawab pertanyaan, dan bahkan memecahkan masalah matematika. Namun, terlepas dari kemampuannya yang mengesankan, model-model ini menunjukkan perilaku yang aneh: mereka sering kali memperumit masalah sederhana saat berjuang dengan masalah yang rumit. belajar oleh para peneliti Apple memberikan wawasan berharga tentang fenomena ini. Artikel ini membahas mengapa LLM dan LRM berperilaku seperti ini dan apa artinya bagi masa depan AI.

Memahami LLM dan LRM

Untuk memahami mengapa LLM dan LRM berperilaku seperti ini, pertama-tama kita perlu mengklarifikasi apa saja model-model ini. LLM, seperti GPT-3 atau BERT, dilatih pada kumpulan data teks yang sangat banyak untuk memprediksi kata berikutnya dalam suatu urutan. Hal ini membuat LLM sangat baik dalam tugas-tugas seperti pembuatan teks, penerjemahan, dan peringkasan. Namun, LLM pada dasarnya tidak dirancang untuk penalaran, yang melibatkan deduksi logis atau pemecahan masalah.

LRM adalah kelas model baru yang dirancang untuk mengatasi kesenjangan ini. Model ini menggabungkan teknik-teknik seperti Rantai Pikiran (CoT) prompting, di mana model menghasilkan langkah-langkah penalaran menengah sebelum memberikan jawaban akhir. Misalnya, saat memecahkan soal matematika, LRM mungkin memecahnya menjadi beberapa langkah, seperti yang dilakukan manusia. Pendekatan ini meningkatkan kinerja pada tugas-tugas yang kompleks tetapi menghadapi tantangan saat berhadapan dengan masalah dengan kompleksitas yang bervariasi, seperti yang diungkapkan studi Apple.

Studi Penelitian

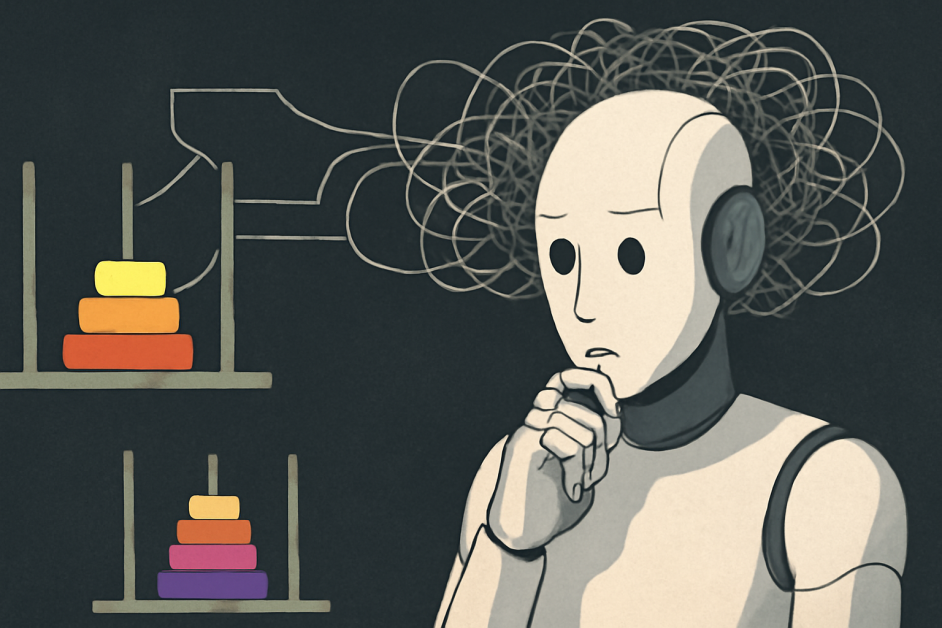

Tim peneliti Apple mengambil pendekatan berbeda pendekatan untuk mengevaluasi kemampuan penalaran LLM dan LRM. Alih-alih mengandalkan tolok ukur tradisional seperti tes matematika atau pengkodean, yang dapat dipengaruhi oleh kontaminasi data (di mana model menghafal jawaban), mereka menciptakan lingkungan teka-teki yang terkendali. Ini termasuk teka-teki terkenal seperti Menara Hanoi, Melompati Checker, Penyeberangan Sungai, dan Blocks World. Misalnya, Menara Hanoi melibatkan pemindahan cakram di antara pasak dengan mengikuti aturan tertentu, dengan kompleksitas yang meningkat seiring bertambahnya cakram. Dengan menyesuaikan kompleksitas teka-teki ini secara sistematis sambil mempertahankan struktur logis yang konsisten, para peneliti mengamati bagaimana model bekerja di berbagai tingkat kesulitan. Metode ini memungkinkan mereka menganalisis tidak hanya jawaban akhir tetapi juga proses penalaran, yang memberikan pandangan lebih mendalam tentang bagaimana model ini "berpikir."

Temuan tentang Berpikir Berlebihan dan Menyerah

Studi ini mengidentifikasi tiga rezim kinerja berbeda berdasarkan kompleksitas masalah:

- Pada tingkat kompleksitas rendah, LLM standar sering kali berkinerja lebih baik daripada LRM karena LRM cenderung dipikirkan secara berlebihan, menghasilkan langkah-langkah tambahan yang tidak diperlukan, sementara LLM standar lebih efisien.

- Untuk permasalahan dengan kompleksitas sedang, LRM menunjukkan kinerja yang unggul karena kemampuannya menghasilkan jejak penalaran terperinci yang membantu mereka mengatasi tantangan ini secara efektif.

- Untuk permasalahan dengan kompleksitas tinggi, baik LLM maupun LRM gagal total; LRM, khususnya, mengalami penurunan total dalam akurasi dan mengurangi upaya penalarannya meskipun tingkat kesulitannya meningkat.

Untuk teka-teki sederhana, seperti Menara Hanoi dengan satu atau dua cakram, LLM standar lebih efisien dalam memberikan jawaban yang benar. Namun, LRM sering kali terlalu memikirkan masalah ini, menghasilkan jejak penalaran yang panjang bahkan ketika solusinya mudah. Hal ini menunjukkan bahwa LRM dapat meniru penjelasan yang dilebih-lebihkan dari data pelatihannya, yang dapat menyebabkan inefisiensi.

Dalam skenario yang cukup rumit, LRM berkinerja lebih baik. Kemampuannya untuk menghasilkan langkah-langkah penalaran yang terperinci memungkinkannya untuk mengatasi masalah yang memerlukan beberapa langkah logis. Hal ini memungkinkannya untuk mengungguli LLM standar, yang kesulitan untuk mempertahankan koherensi.

Namun, untuk teka-teki yang sangat rumit, seperti Menara Hanoi dengan banyak cakram, kedua model gagal sepenuhnya. Anehnya, LRM mengurangi upaya penalaran mereka saat kompleksitas meningkat melampaui titik tertentu meskipun memiliki cukup sumber daya komputasi. Perilaku "menyerah" ini menunjukkan keterbatasan mendasar dalam kemampuan mereka untuk meningkatkan kemampuan penalaran.

Mengapa Ini Terjadi?

Berpikir berlebihan terhadap teka-teki sederhana kemungkinan besar berasal dari cara LLM dan LRM dilatih. Model-model ini belajar dari kumpulan data besar yang mencakup penjelasan ringkas dan terperinci. Untuk soal-soal mudah, mereka mungkin secara default menghasilkan jejak penalaran yang bertele-tele, meniru contoh-contoh panjang dalam data pelatihan mereka, bahkan ketika jawaban langsung sudah cukup. Perilaku ini tidak selalu merupakan cacat tetapi merupakan cerminan dari pelatihan mereka, yang memprioritaskan penalaran daripada efisiensi.

Kegagalan pada teka-teki yang rumit mencerminkan ketidakmampuan LLM dan LRM untuk belajar menggeneralisasikan aturan-aturan logis. Seiring meningkatnya kompleksitas masalah, ketergantungan mereka pada pencocokan pola pun berkurang, yang menyebabkan penalaran yang tidak konsisten dan penurunan kinerja. Studi tersebut menemukan bahwa LRM gagal menggunakan algoritme eksplisit dan bernalar secara tidak konsisten di berbagai teka-teki. Hal ini menyoroti bahwa meskipun model-model ini dapat mensimulasikan penalaran, mereka tidak benar-benar memahami logika yang mendasarinya sebagaimana manusia.

Perspektif Beragam

Studi ini telah memicu diskusi di komunitas AI. Beberapa ahli membantah bahwa temuan ini mungkin disalahartikanMereka berpendapat bahwa meskipun LLM dan LRM mungkin tidak bernalar seperti manusia, keduanya tetap menunjukkan pemecahan masalah yang efektif dalam batasan kompleksitas tertentu. Mereka menekankan bahwa "penalaran" dalam AI tidak perlu mencerminkan kognisi manusia, agar bernilai. Demikian pula, diskusi di platform seperti Hacker News memuji pendekatan studi yang ketat tetapi menyoroti perlunya penelitian lebih lanjut untuk meningkatkan penalaran AI. Perspektif ini menekankan perdebatan yang sedang berlangsung tentang apa yang dimaksud dengan penalaran dalam AI dan bagaimana kita harus mengevaluasinya.

Implikasi dan Arah Masa Depan

Temuan studi ini memiliki implikasi signifikan bagi pengembangan AI. Meskipun LRM menunjukkan kemajuan dalam meniru penalaran manusia, keterbatasannya dalam menangani masalah kompleks dan upaya penalaran skala besar menunjukkan bahwa model saat ini masih jauh dari mencapai penalaran yang dapat digeneralisasi. Hal ini menyoroti perlunya metode evaluasi baru yang berfokus pada kualitas dan kemampuan beradaptasi proses penalaran, bukan hanya keakuratan jawaban akhir.

Penelitian di masa mendatang harus bertujuan untuk meningkatkan kemampuan model dalam menjalankan langkah-langkah logis secara akurat dan menyesuaikan upaya penalaran berdasarkan kompleksitas masalah. Mengembangkan tolok ukur yang mencerminkan tugas penalaran di dunia nyata, seperti diagnosis medis atau argumentasi hukum, dapat memberikan wawasan yang lebih bermakna tentang kemampuan AI. Selain itu, mengatasi ketergantungan model yang berlebihan pada pengenalan pola dan meningkatkan kemampuan mereka untuk menggeneralisasi aturan logis akan sangat penting untuk memajukan penalaran AI.

The Bottom Line

Studi ini memberikan analisis kritis terhadap kemampuan penalaran LLM dan LRM. Studi ini menunjukkan bahwa meskipun model-model ini menganalisis teka-teki sederhana secara berlebihan, mereka kesulitan dengan teka-teki yang lebih rumit, sehingga memperlihatkan kekuatan dan keterbatasan mereka. Meskipun mereka bekerja dengan baik dalam situasi tertentu, ketidakmampuan mereka untuk mengatasi masalah yang sangat rumit menyoroti kesenjangan antara penalaran simulasi dan pemahaman yang sebenarnya. Studi ini menekankan perlunya mengembangkan sistem AI yang dapat secara adaptif bernalar di berbagai tingkat kompleksitas, sehingga memungkinkannya untuk mengatasi masalah dengan kompleksitas yang bervariasi, seperti halnya manusia.