Kecerdasan Buatan

UniTune: Teknik Pengeditan Gambar Neural Alternatif Google

Google Research, tampaknya, sedang menyerang penyuntingan gambar berbasis teks dari berbagai sisi, dan, mungkin, menunggu untuk melihat apa yang 'berhasil'. Mengikuti jejak rilis minggu ini dari Kertas imaji, raksasa pencarian telah mengusulkan metode berbasis difusi laten tambahan untuk melakukan pengeditan berbasis AI yang tidak mungkin dilakukan pada gambar melalui perintah teks, kali ini disebut UniTune.

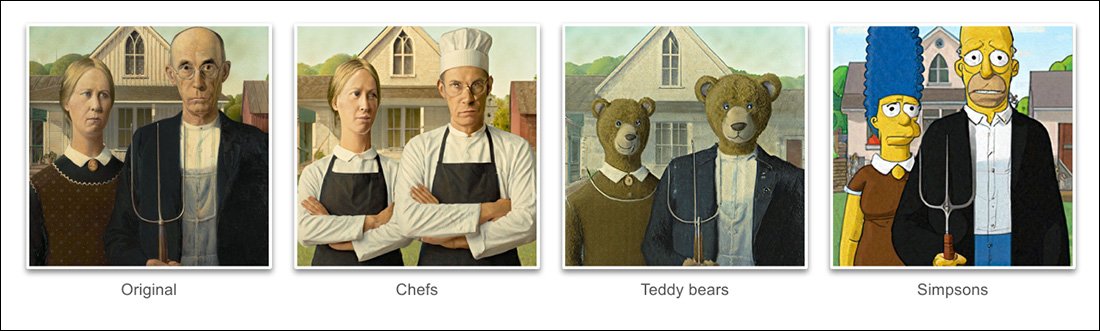

Berdasarkan contoh-contoh yang diberikan dalam proyek kertas baru, UniTune telah mencapai tingkat yang luar biasa penguraian dr kekusutan pose semantik dan ide dari konten gambar keras yang sebenarnya:

Penguasaan UniTune dalam komposisi semantik sungguh luar biasa. Perhatikan bagaimana pada baris gambar paling atas, wajah kedua orang tersebut tidak terdistorsi oleh transformasi luar biasa pada gambar sumber lainnya (kanan). Sumber: https://arxiv.org/pdf/2210.09477.pdf

Seperti yang akan dipelajari oleh penggemar Difusi Stabil sekarang, menerapkan pengeditan pada sebagian bagian gambar tanpa mengubah sisa gambar dapat menjadi operasi yang rumit, terkadang tidak mungkin. Padahal distribusi populer seperti OTOMATIS1111 dapat membuat topeng untuk pengeditan lokal dan terbatas, prosesnya berliku-liku dan seringkali tidak dapat diprediksi.

Jawaban yang jelas, setidaknya bagi praktisi visi komputer, adalah dengan menempatkan lapisan segmentasi semantik yang mampu mengenali dan mengisolasi objek dalam gambar tanpa campur tangan pengguna, dan, sesungguhnya, akhir-akhir ini telah ada beberapa inisiatif baru yang sejalan dengan pemikiran ini.

Lain kemungkinan untuk mengunci operasi penyuntingan gambar saraf yang berantakan dan kusut adalah dengan memanfaatkan Pelatihan Pra-Bahasa Kontrastif Gambar OpenAI yang berpengaruh (CLIP) modul, yang merupakan inti dari model difusi laten seperti DALL-E 2 dan Stable Diffusion, untuk bertindak sebagai filter pada titik di mana model teks-ke-gambar siap mengirim render yang ditafsirkan kembali ke pengguna . Dalam konteks ini, CLIP harus bertindak sebagai modul penjaga dan kontrol kualitas, menolak render yang cacat atau tidak sesuai. Ini akan dilembagakan (Tautan Discord) di portal berbasis API DreamStudio milik Stability.ai.

Akan tetapi, karena CLIP bisa dibilang merupakan penyebab sekaligus solusi dalam skenario semacam itu (karena pada dasarnya CLIP juga menginformasikan cara gambar tersebut dikembangkan), dan karena persyaratan perangkat keras mungkin melebihi apa yang mungkin tersedia secara lokal bagi pengguna akhir, pendekatan ini mungkin tidak ideal.

Bahasa Terkompresi

UniTune yang diusulkan justru 'menyempurnakan' model difusi yang sudah ada – dalam kasus ini, Imagen milik Google sendiri, meskipun para peneliti menyatakan bahwa metode tersebut kompatibel dengan arsitektur difusi laten lainnya – sehingga token unik disuntikkan ke dalamnya yang dapat dipanggil dengan memasukkannya dalam perintah teks.

Pada nilai nominal, ini terdengar seperti Google bilik mimpi, saat ini menjadi obsesi di antara penggemar dan pengembang Stable Diffusion, yang dapat menyuntikkan karakter atau objek baru ke pos pemeriksaan yang ada, seringkali dalam waktu kurang dari satu jam, hanya berdasarkan beberapa gambar sumber; atau yang lain seperti Pembalikan Tekstual, yang membuat file 'sidecar' untuk titik pemeriksaan, yang kemudian diperlakukan seolah-olah file tersebut awalnya dilatih ke dalam model, dan dapat memanfaatkan sumber daya model yang sangat besar dengan memodifikasi pengklasifikasi teksnya, sehingga menghasilkan file yang sangat kecil (dibandingkan dengan titik pemeriksaan DreamBooth yang dipangkas minimal 2GB).

Faktanya, para peneliti menegaskan, UniTune menolak kedua pendekatan tersebut. Mereka menemukan bahwa Inversi Tekstual menghilangkan terlalu banyak detail penting, sedangkan DreamBooth 'berkinerja lebih buruk dan membutuhkan waktu lebih lama' daripada solusi yang akhirnya mereka selesaikan.

Meskipun demikian, UniTune menggunakan pendekatan 'metaprompt' semantik terkapsulasi yang sama seperti DreamBooth, dengan perubahan terlatih yang dipanggil oleh kata-kata unik yang dipilih oleh pelatih, yang tidak akan berbenturan dengan istilah apa pun yang saat ini ada dalam model rilis publik yang dilatih dengan susah payah.

'Untuk melakukan operasi penyuntingan, kami mengambil sampel model yang telah disetel dengan baik dengan perintah “[rare_tokens] edit_prompt” (misalnya “beikkpic dua anjing di sebuah restoran” atau “beikkpic seekor minion”).'

Proses

Meskipun membingungkan mengapa dua makalah yang hampir identik, dalam hal fungsionalitas akhirnya, harus tiba dari Google di minggu yang sama, ada, meskipun ada banyak kesamaan antara kedua inisiatif tersebut, setidaknya ada satu perbedaan yang jelas antara UniTune dan Imagic – yang terakhir menggunakan perintah bahasa alami yang 'tidak terkompresi' untuk memandu operasi penyuntingan gambar, sedangkan UniTune berlatih dalam token gaya DreamBooth yang unik.

Oleh karena itu, jika Anda mengedit dengan Imagic dan ingin melakukan transformasi seperti ini…

Dari makalah UniTune – UniTune bersaing ketat dengan framework penyuntingan neural favorit Google, SDEdit. Hasil UniTune ada di paling kanan, sementara perkiraan maskernya terlihat pada gambar kedua dari kiri.

.. di Imagic, Anda akan memasukkan 'orang ketiga, duduk di latar belakang, sebagai monster berbulu yang lucu'.

Perintah UniTune yang setara adalah 'Pria di belakang sebagai [x]', Di mana x adalah kata aneh dan unik apa pun yang terkait dengan konsep terlatih yang terkait dengan karakter monster berbulu.

Sementara sejumlah gambar dimasukkan ke dalam DreamBooth atau Textual Inversion dengan maksud untuk membuat abstraksi gaya deepfake yang dapat diperintahkan ke dalam banyak pose, baik UniTune maupun Imagic malah memasukkan satu gambar ke dalam sistem – gambar asli dan asli.

Hal ini serupa dengan cara kerja banyak alat penyuntingan berbasis GAN dalam beberapa tahun terakhir ini – dengan mengubah citra masukan menjadi kode laten dalam ruang laten GAN, kemudian mengalamatkan kode-kode tersebut dan mengirimkannya ke bagian lain ruang laten untuk dimodifikasi (yakni memasukkan citra orang muda berambut gelap dan memproyeksikannya melalui kode laten yang diasosiasikan dengan 'tua' atau 'pirang', dsb.).

Namun, hasilnya, dalam model difusi, dan dengan metode ini, sangat akurat jika dibandingkan, dan jauh lebih ambigu:

Proses Penyetelan Halus

Metode UniTune pada dasarnya mengirimkan gambar asli melalui model difusi beserta serangkaian instruksi tentang cara memodifikasinya, menggunakan repositori data yang luas dan telah dilatih ke dalam model tersebut. Sebenarnya, Anda dapat melakukannya sekarang juga dengan Stable Diffusion. img2img fungsionalitas – tetapi bukan tanpa pembengkokan atau dengan cara tertentu mengubah bagian gambar yang ingin Anda pertahankan.

Selama proses UniTune, sistem ini menyempurnakand, artinya UniTune memaksa model untuk melanjutkan pelatihan, dengan sebagian besar lapisannya dibekukan (lihat di bawah). Dalam kebanyakan kasus, penyetelan halus akan mengurangi keseluruhan umum nilai kerugian dari model berkinerja tinggi yang diperoleh dengan susah payah demi menyuntikkan atau menyempurnakan beberapa aspek lain yang diinginkan untuk dibuat atau ditingkatkan.

Namun, dengan UniTune, tampaknya salinan model yang diproses, meskipun mungkin berbobot beberapa gigabita atau lebih, akan diperlakukan sebagai "cangkang" kolateral sekali pakai, dan dibuang di akhir proses, karena hanya memiliki satu tujuan. Tonase data acak seperti ini menjadi krisis penyimpanan sehari-hari bagi penggemar DreamBooth, yang modelnya sendiri, bahkan setelah dipangkas, berukuran tidak kurang dari 2GB per subjek.

Seperti Imagic, penyetelan utama di UniTune terjadi di dua bagian bawah dari tiga lapisan di Imagen (base 64px, 64px>256px, dan 256px>1024px). Tidak seperti Imagic, para peneliti melihat beberapa nilai potensial dalam mengoptimalkan penyetelan juga untuk lapisan resolusi super terakhir dan terbesar ini (walaupun mereka belum mencobanya).

Untuk lapisan 64px terendah, model dicondongkan ke gambar dasar selama pelatihan, dengan beberapa pasangan duplikat gambar/teks dimasukkan ke dalam sistem selama 128 iterasi pada ukuran batch 4, dan dengan Adafaktor sebagai fungsi kerugian, beroperasi pada laju pembelajaran 0.0001. Meskipun pembuat kode T5 sendirian dibekukan selama penyetelan halus ini, itu juga dibekukan selama pelatihan utama Imagen

Operasi di atas kemudian diulangi untuk layer 64>256px, menggunakan prosedur augmentasi noise yang sama yang digunakan dalam pelatihan asli Imagen.

Sampling

Ada banyak metode pengambilan sampel yang memungkinkan perubahan yang dibuat dapat diperoleh dari model yang disetel dengan baik, termasuk Bimbingan Gratis Pengklasifikasi (CFG), yang juga merupakan andalan Difusi Stabil. CFG pada dasarnya mendefinisikan sejauh mana model bebas untuk 'mengikuti imajinasinya' dan mengeksplorasi kemungkinan rendering – atau, pada pengaturan yang lebih rendah, sejauh mana model harus mematuhi data sumber input, dan membuat perubahan yang tidak terlalu besar atau dramatis.

Seperti Textual Inversion (kurang begitu dengan DreamBooth), UniTune dapat menerapkan gaya grafis yang berbeda ke gambar asli, serta lebih banyak pengeditan fotorealistik.

Para peneliti juga bereksperimen dengan SDSuntingTeknik 'late start' dari ` ...

Para peneliti juga dieksploitasi cepat-ke-cepat sebagai teknik berbasis teks tambahan untuk mengkondisikan model:

'Dalam pengaturan "cepat ke cepat", kami menemukan bahwa teknik yang kami sebut Bimbingan Cepat sangat membantu untuk menyetel kesetiaan dan ekspresif.

Panduan Prompt serupa dengan Panduan Bebas Pengklasifikasi, hanya saja baseline-nya adalah prompt yang berbeda, bukan model tanpa syarat. Ini memandu model menuju delta antara kedua prompt tersebut.

Namun, panduan yang cepat, kata penulis, hanya diperlukan sesekali dalam kasus di mana CFG gagal mendapatkan hasil yang diinginkan.

Pendekatan pengambilan sampel baru lainnya yang ditemui selama pengembangan UniTune adalah interpolasi, di mana area gambar cukup berbeda sehingga gambar asli dan yang diubah sangat mirip komposisinya, sehingga memungkinkan penggunaan interpolasi yang lebih 'naif'.

Interpolasi dapat membuat proses UniTune dengan upaya yang lebih tinggi menjadi redundan jika area yang akan diubah terpisah dan terpinggirkan dengan baik.

Penulis menyarankan bahwa interpolasi berpotensi bekerja dengan sangat baik, untuk sejumlah besar gambar sumber target, sehingga dapat digunakan sebagai pengaturan default, dan mengamati juga bahwa ia memiliki kekuatan untuk menghasilkan transformasi luar biasa dalam kasus-kasus di mana oklusi kompleks tidak perlu dinegosiasikan dengan metode yang lebih intensif.

UniTune dapat melakukan pengeditan lokal dengan atau tanpa topeng edit, tetapi juga dapat memutuskan secara sepihak di mana menempatkan pengeditan, dengan kombinasi kekuatan interpretasi yang tidak biasa dan esensialisasi yang kuat dari data masukan sumber:

Pada gambar paling atas di kolom kedua, UniTune, yang bertugas menyisipkan 'kereta merah di latar belakang', telah menempatkannya pada posisi yang tepat dan autentik. Perhatikan pada contoh lain bagaimana integritas semantik pada gambar sumber tetap terjaga bahkan di tengah perubahan luar biasa pada konten piksel dan gaya inti gambar.

Latensi

Meskipun iterasi pertama dari sistem baru apa pun akan berjalan lambat, dan meskipun mungkin saja keterlibatan komunitas atau komitmen korporat (biasanya tidak keduanya) pada akhirnya akan mempercepat dan mengoptimalkan rutinitas yang membutuhkan banyak sumber daya, baik UniTune maupun Imagic melakukan beberapa manuver pembelajaran mesin yang cukup besar untuk membuat perubahan yang luar biasa ini, dan patut dipertanyakan sejauh mana proses yang membutuhkan banyak sumber daya seperti itu dapat diperkecil untuk penggunaan domestik, daripada akses yang digerakkan oleh API (meskipun yang terakhir mungkin lebih diinginkan oleh Google).

Saat ini, proses bolak-balik dari input ke hasil memakan waktu sekitar 3 menit pada GPU T4, dengan tambahan sekitar 30 detik untuk inferensi (seperti pada rutinitas inferensi lainnya). Para penulis mengakui bahwa ini memiliki latensi yang tinggi, dan hampir tidak memenuhi syarat sebagai 'interaktif', tetapi mereka juga mencatat bahwa model tersebut tetap tersedia untuk pengeditan lebih lanjut setelah penyetelan awal, hingga pengguna selesai dengan prosesnya, yang mengurangi waktu per pengeditan.

Pertama kali diterbitkan 21 Oktober 2022.