Kecerdasan Buatan

Lebih Sedikit Itu Lebih Baik: Mengapa Mengambil Lebih Sedikit Dokumen Dapat Meningkatkan Jawaban AI

Generasi Augmented Pengambilan (RAG) adalah pendekatan untuk membangun sistem AI yang menggabungkan model bahasa dengan sumber pengetahuan eksternal. Secara sederhana, AI pertama-tama mencari dokumen yang relevan (seperti artikel atau halaman web) yang terkait dengan pertanyaan pengguna, lalu menggunakan dokumen tersebut untuk menghasilkan jawaban yang lebih akurat. Metode ini telah dikenal karena membantu model bahasa besar (LLM) Tetaplah berpegang pada fakta dan kurangi halusinasi dengan mendasarkan respons mereka pada data nyata.

Secara intuitif, orang mungkin berpikir bahwa semakin banyak dokumen yang diambil AI, semakin baik pula jawabannya. Namun, penelitian terkini menunjukkan hal yang mengejutkan: dalam hal memberikan informasi kepada AI, terkadang lebih sedikit lebih baik.

Lebih Sedikit Dokumen, Jawaban Lebih Baik

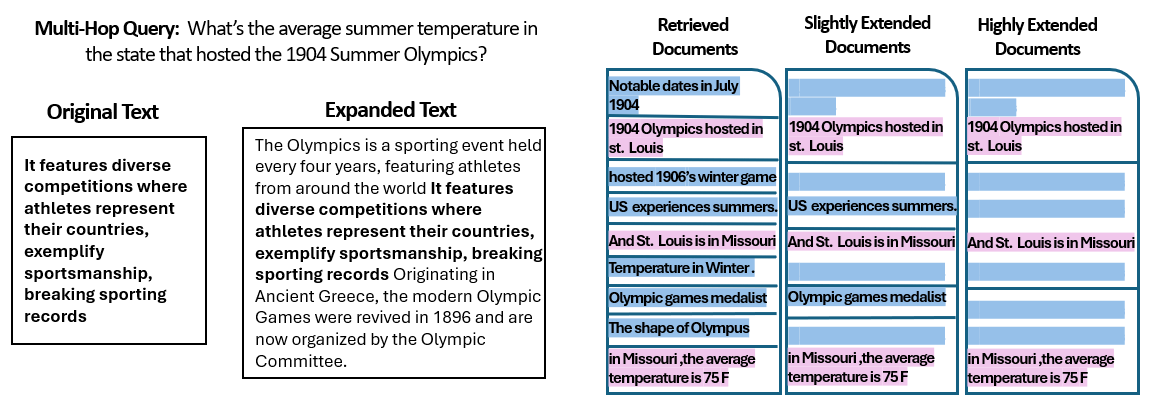

A baru studi oleh para peneliti di Universitas Ibrani Yerusalem meneliti bagaimana jumlah dokumen yang diberikan ke sistem RAG memengaruhi kinerjanya. Yang terpenting, mereka menjaga jumlah total teks tetap konstan – artinya jika lebih sedikit dokumen yang diberikan, dokumen-dokumen tersebut sedikit diperluas agar panjangnya sama dengan banyak dokumen. Dengan cara ini, setiap perbedaan kinerja dapat dikaitkan dengan kuantitas dokumen, bukan hanya karena input yang lebih pendek.

Para peneliti menggunakan kumpulan data tanya jawab (MuSiQue) dengan pertanyaan-pertanyaan sepele, yang masing-masing awalnya dipasangkan dengan 20 paragraf Wikipedia (hanya beberapa yang benar-benar berisi jawaban, sedangkan sisanya hanya pengalih perhatian). Dengan memangkas jumlah dokumen dari 20 menjadi hanya 2-4 dokumen yang benar-benar relevan – dan menambahkan sedikit konteks tambahan untuk mempertahankan panjang yang konsisten – mereka menciptakan skenario di mana AI memiliki lebih sedikit materi untuk dipertimbangkan, tetapi jumlah kata yang harus dibaca masih kurang lebih sama.

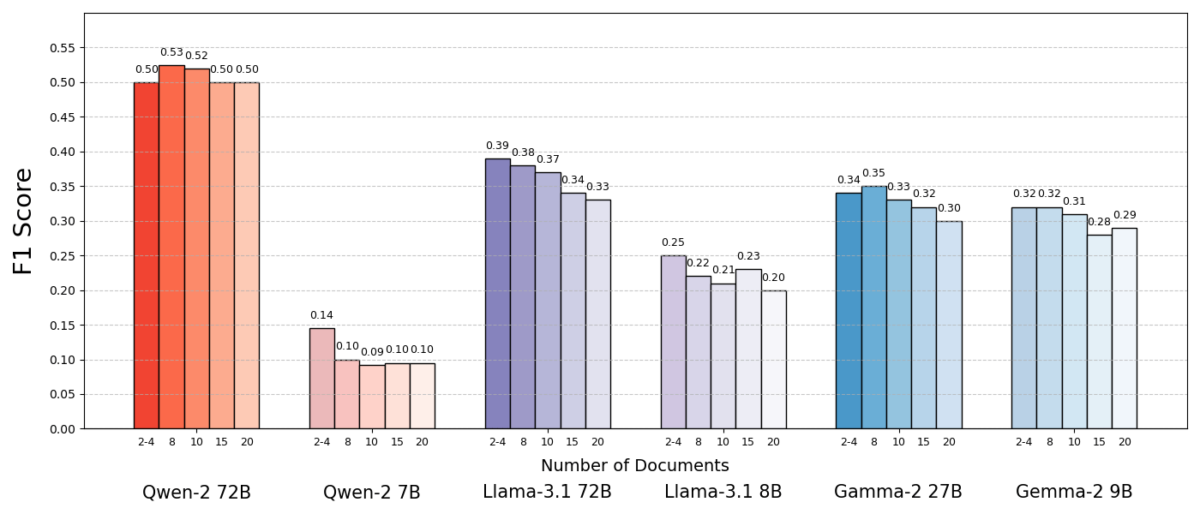

Hasilnya sangat mengejutkan. Dalam kebanyakan kasus, model AI memberikan jawaban yang lebih akurat ketika diberikan lebih sedikit dokumen daripada kumpulan dokumen yang lengkap. Performa meningkat secara signifikan – dalam beberapa kasus hingga 10% dalam akurasi (skor F1) ketika sistem hanya menggunakan beberapa dokumen pendukung, bukan kumpulan dokumen yang banyak. Peningkatan yang berlawanan dengan intuisi ini diamati di beberapa model bahasa sumber terbuka yang berbeda, termasuk varian Llama milik Meta dan lainnya, yang menunjukkan bahwa fenomena tersebut tidak terkait dengan satu model AI.

Satu model (Qwen-2) merupakan pengecualian penting yang menangani beberapa dokumen tanpa penurunan skor, tetapi hampir semua model yang diuji berkinerja lebih baik dengan lebih sedikit dokumen secara keseluruhan. Dengan kata lain, menambahkan lebih banyak materi referensi di luar bagian-bagian penting yang relevan sebenarnya lebih sering merusak kinerja mereka daripada membantu.

Sumber: Levy et al.

Mengapa ini begitu mengejutkan? Biasanya, sistem RAG dirancang dengan asumsi bahwa mengambil informasi yang lebih luas akan membantu AI – lagipula, jika jawabannya tidak ada di beberapa dokumen pertama, mungkin ada di dokumen kesepuluh atau kedua puluh.

Studi ini membalikkan skenario tersebut, dengan menunjukkan bahwa menambahkan dokumen tambahan tanpa pandang bulu dapat menjadi bumerang. Bahkan ketika panjang teks total tetap konstan, keberadaan banyak dokumen berbeda (masing-masing dengan konteks dan kekhasannya sendiri) membuat tugas menjawab pertanyaan menjadi lebih menantang bagi AI. Tampaknya setelah melewati titik tertentu, setiap dokumen tambahan menimbulkan lebih banyak gangguan daripada sinyal, yang membingungkan model dan mengganggu kemampuannya untuk mengekstrak jawaban yang benar.

Mengapa Lebih Sedikit Bisa Lebih Baik dalam RAG

Hasil "less is more" ini masuk akal jika kita mempertimbangkan bagaimana model bahasa AI memproses informasi. Ketika AI hanya diberi dokumen yang paling relevan, konteks yang dilihatnya terfokus dan bebas dari gangguan, seperti siswa yang diberi halaman yang tepat untuk dipelajari.

Dalam penelitian tersebut, model berkinerja jauh lebih baik ketika hanya diberikan dokumen pendukung, dengan materi yang tidak relevan dihilangkan. Konteks yang tersisa tidak hanya lebih pendek tetapi juga lebih jelas – konteks tersebut berisi fakta yang secara langsung mengarah ke jawaban dan tidak ada yang lain. Dengan lebih sedikit dokumen yang harus ditangani, model dapat mencurahkan perhatian penuhnya pada informasi yang relevan, sehingga kecil kemungkinannya untuk teralihkan atau bingung.

Di sisi lain, ketika banyak dokumen diambil, AI harus menyaring campuran konten yang relevan dan tidak relevan. Sering kali dokumen tambahan ini "mirip tetapi tidak terkait" – dokumen tersebut mungkin memiliki topik atau kata kunci yang sama dengan kueri tetapi sebenarnya tidak berisi jawaban. Konten tersebut dapat menyesatkan model. AI mungkin membuang-buang tenaga untuk mencoba menghubungkan titik-titik di seluruh dokumen yang sebenarnya tidak mengarah ke jawaban yang benar, atau lebih buruk lagi, AI mungkin menggabungkan informasi dari beberapa sumber secara tidak benar. Hal ini meningkatkan risiko halusinasi – contoh saat AI menghasilkan jawaban yang kedengarannya masuk akal tetapi tidak didasarkan pada satu sumber.

Intinya, memasukkan terlalu banyak dokumen ke dalam model dapat mengencerkan informasi yang berguna dan menimbulkan rincian yang saling bertentangan, sehingga mempersulit AI untuk memutuskan mana yang benar.

Menariknya, para peneliti menemukan bahwa jika dokumen tambahan tersebut jelas tidak relevan (misalnya, teks acak yang tidak terkait), model tersebut lebih baik dalam mengabaikannya. Masalah sebenarnya berasal dari data yang mengganggu yang tampak relevan: ketika semua teks yang diambil memiliki topik yang sama, AI berasumsi bahwa ia harus menggunakan semuanya, dan mungkin kesulitan untuk mengetahui detail mana yang sebenarnya penting. Hal ini sejalan dengan pengamatan penelitian bahwa pengalih perhatian yang acak menyebabkan lebih sedikit kebingungan dibandingkan pengalih perhatian yang realistis dalam input. AI dapat menyaring omong kosong yang mencolok, tetapi informasi yang sedikit menyimpang dari topik adalah perangkap yang licin – ia menyelinap masuk dengan kedok relevansi dan menggagalkan jawaban. Dengan mengurangi jumlah dokumen hanya menjadi yang benar-benar diperlukan, kita menghindari perangkap ini sejak awal.

Ada juga manfaat praktis: mengambil dan memproses lebih sedikit dokumen menurunkan beban komputasi untuk sistem RAG. Setiap dokumen yang ditarik harus dianalisis (disematkan, dibaca, dan ditangani oleh model), yang menggunakan waktu dan sumber daya komputasi. Menghilangkan dokumen yang tidak perlu membuat sistem lebih efisien – sistem dapat menemukan jawaban lebih cepat dan dengan biaya lebih rendah. Dalam skenario di mana akurasi ditingkatkan dengan berfokus pada lebih sedikit sumber, kita mendapatkan keuntungan: jawaban yang lebih baik dan proses yang lebih ramping dan lebih efisien.

Sumber: Levy et al.

Memikirkan Kembali RAG: Arah Masa Depan

Bukti baru ini yang menunjukkan bahwa kualitas sering kali mengalahkan kuantitas dalam pencarian memiliki implikasi penting bagi masa depan sistem AI yang bergantung pada pengetahuan eksternal. Bukti ini menunjukkan bahwa perancang sistem RAG harus memprioritaskan penyaringan cerdas dan pemeringkatan dokumen daripada volume semata. Daripada mengambil 100 bagian yang mungkin dan berharap jawabannya terkubur di suatu tempat, mungkin lebih bijaksana untuk hanya mengambil beberapa bagian teratas yang sangat relevan.

Penulis studi menekankan perlunya metode pengambilan untuk "menemukan keseimbangan antara relevansi dan keberagaman" dalam informasi yang mereka berikan kepada suatu model. Dengan kata lain, kami ingin menyediakan cakupan topik yang cukup untuk menjawab pertanyaan, tetapi tidak terlalu banyak sehingga fakta inti tenggelam dalam lautan teks yang tidak relevan.

Ke depannya, para peneliti kemungkinan akan mengeksplorasi teknik yang membantu model AI menangani banyak dokumen dengan lebih baik. Salah satu pendekatannya adalah mengembangkan sistem pengambil atau pemeringkat ulang yang lebih baik yang dapat mengidentifikasi dokumen mana yang benar-benar memberikan nilai tambah dan mana yang hanya menimbulkan konflik. Sudut pandang lain adalah meningkatkan model bahasa itu sendiri: jika satu model (seperti Qwen-2) berhasil menangani banyak dokumen tanpa kehilangan akurasi, memeriksa bagaimana model tersebut dilatih atau disusun dapat memberikan petunjuk untuk membuat model lain lebih tangguh. Mungkin model bahasa besar di masa mendatang akan menggabungkan mekanisme untuk mengenali ketika dua sumber mengatakan hal yang sama (atau saling bertentangan) dan fokus sesuai dengan itu. Tujuannya adalah untuk memungkinkan model memanfaatkan berbagai macam sumber tanpa menjadi mangsa kebingungan – secara efektif mendapatkan yang terbaik dari kedua dunia (luasnya informasi dan kejelasan fokus).

Perlu juga dicatat bahwa Sistem AI memperoleh jendela konteks yang lebih besar (kemampuan untuk membaca lebih banyak teks sekaligus), hanya membuang lebih banyak data ke dalam prompt bukanlah solusi yang tepat. Konteks yang lebih besar tidak secara otomatis berarti pemahaman yang lebih baik. Studi ini menunjukkan bahwa meskipun AI secara teknis dapat membaca 50 halaman sekaligus, memberinya 50 halaman informasi dengan kualitas yang beragam mungkin tidak akan memberikan hasil yang baik. Model tersebut tetap diuntungkan dengan memiliki konten yang dikurasi dan relevan untuk digunakan, daripada membuangnya secara sembarangan. Faktanya, pengambilan data secara cerdas mungkin menjadi lebih penting di era jendela konteks raksasa – untuk memastikan kapasitas ekstra digunakan untuk pengetahuan yang berharga daripada gangguan.

Temuan dari “Lebih Banyak Dokumen, Panjangnya Sama” (makalah yang berjudul tepat) mendorong pemeriksaan ulang asumsi kita dalam penelitian AI. Terkadang, memberi AI semua data yang kita miliki tidak seefektif yang kita kira. Dengan berfokus pada informasi yang paling relevan, kita tidak hanya meningkatkan keakuratan jawaban yang dihasilkan AI tetapi juga membuat sistem lebih efisien dan lebih mudah dipercaya. Ini adalah pelajaran yang berlawanan dengan intuisi, tetapi memiliki konsekuensi yang menarik: sistem RAG di masa depan mungkin lebih cerdas dan ramping dengan memilih lebih sedikit dokumen yang lebih baik untuk diambil.