Andersonin kulma

Visuaalisten analogioiden tuominen tekoälyyn

Nykyiset tekoälymallit eivät tunnista kuvien "relationaalisia" samankaltaisuuksia, kuten sitä, miten maapallon kerrokset ovat samankaltaisia kuin persikan, joten niistä puuttuu keskeinen osa ihmisten kuvien havaitsemista.

Vaikka niitä on monia tietokoneen visio mallit, jotka pystyvät vertailemaan kuvia ja löytämään niiden välisiä yhtäläisyyksiä, nykyisen sukupolven vertailujärjestelmissä on vain vähän tai ei lainkaan mielikuvituksellinen kapasiteetti. Mietipä joitakin 1960-luvun klassisen laulun sanoituksia, Mielesi tuulimyllyt:

Kuin karuselli joka pyörii, kiertää kuun ympäri

Kuin kello, jonka viisarit pyyhkäisevät ohi minuuttien ajan

Ja maailma on kuin omena, joka pyörii hiljaa avaruudessa

Tällaiset vertailut edustavat runollisen viittauksen aluetta, jolla on ihmisille merkitystä paljon taiteellisen ilmaisun ulkopuolella; pikemminkin se liittyy siihen, miten kehitämme havaintojärjestelmiämme; luodessamme 'objekti'-alueemme kehitämme kyky visuaaliseen samankaltaisuuteen, niin että – esimerkiksi – persikkaa ja Maata kuvaavat poikkileikkaukset tai fraktaalirekursiot, kuten kahvispiraalit ja galaksin oksat, rekisteröidä analogiseksi kanssamme.

Tällä tavoin voimme päätellä yhteyksiä näennäisesti toisiinsa liittymättömien objektien ja objektityyppien välillä, ja päättelyjärjestelmät (kuten painovoima, liikemäärä ja pinnan koheesio), joita voidaan soveltaa useilla eri aloilla ja eri mittakaavoissa.

Näkeminen

Jopa uusimman sukupolven kuvien vertailuun perustuvat tekoälyjärjestelmät, kuten oppinut havainnollinen kuvapatch-similaarisuus (LPIPS) Ja DINO, jotka perustuvat ihmisen palautteeseen, suorittavat vain kirjaimellisia pintavertailuja.

Heidän kykynsä löytää kasvoja sieltä, missä niitä ei ole – eli, pareidolia – ei edusta samanlaisia visuaalisia samankaltaisuusmekanismeja kuin ihmiset kehittävät, vaan pikemminkin siksi, että kasvojentunnistusalgoritmit hyödyntävät matalan tason kasvorakennetta piirteet jotka joskus sopivat yhteen satunnaisten objektien kanssa:

Esimerkkejä vääristä positiivisista kasvojentunnistuksesta 'Kasvot, joissa on esineitä' -aineistossa. Lähde

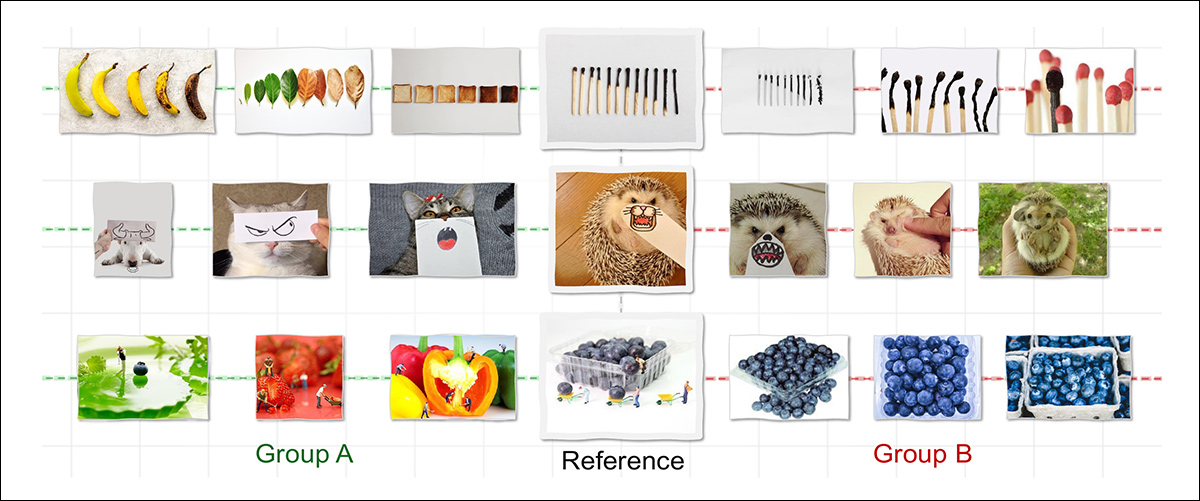

Selvittääkseen, voivatko koneet todella kehittää mielikuvitustamme visuaalisen samankaltaisuuden tunnistamiseksi eri alueilla, yhdysvaltalaiset tutkijat ovat tehneet tutkimuksen opiskella noin Relaatiollinen visuaalinen samankaltaisuus, kuratoimalla ja kouluttamalla uutta tietojoukkoa, jonka tarkoituksena on pakottaa abstrakteja suhteita muodostumaan eri objektien välille, jotka ovat kuitenkin yhteydessä toisiinsa abstraktin suhteen kautta:

Useimmat tekoälymallit tunnistavat samankaltaisuuden vain silloin, kun kuvilla on yhteisiä pintapiirteitä, kuten muoto tai väri, minkä vuoksi ne linkittäisivät viitteeseen vain ryhmän B (yllä). Ihmiset taas näkevät ryhmän A samankaltaisena – ei siksi, että kuvat näyttävät samanlaisilta, vaan koska ne noudattavat samaa taustalla olevaa logiikkaa, kuten ajan myötä tapahtuvaa muutosta. Uusi työ pyrkii toistamaan tällaista rakenteellista tai suhteellista samankaltaisuutta ja pyrkii tuomaan koneellisen havaintokyvyn lähemmäksi ihmisen päättelykykyä.. Lähde: https://arxiv.org/pdf/2512.07833

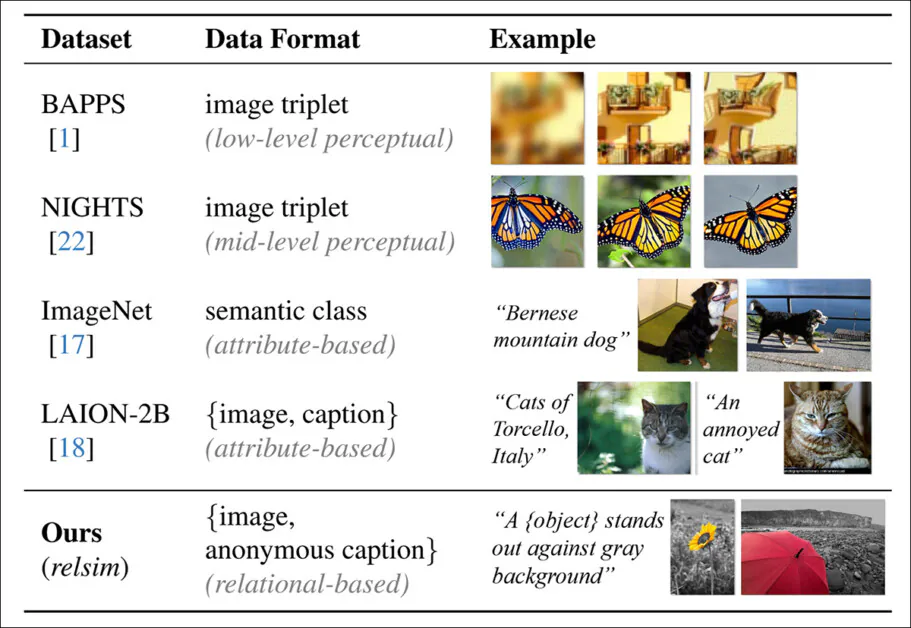

Aineistolle kehitetty tekstitysjärjestelmä mahdollistaa epätavallisen abstraktien merkintöjen tekemisen, joiden tarkoituksena on pakottaa tekoälyjärjestelmät keskittymään perusominaisuuksiin tiettyjen paikallisten yksityiskohtien sijaan:

Ennustetut 'anonyymit' kuvatekstit, jotka vaikuttavat kirjoittajien 'relsim'-mittariin.

Kuratoitu kokoelma ja sen epätavallinen kuvatekstitystyyli ruokkivat kirjoittajien uutta ehdottamaa mittaria relsim, jonka kirjoittajat ovat hienosäätää visio-kielimalliksi (VLM).

Tyypillisten tietojoukkojen kuvatekstitystyylien vertailu, jossa keskitytään ominaisuuksien samankaltaisuuteen, kun taas relsim-lähestymistavassa (alarivi) korostetaan relaatioiden samankaltaisuutta.

Uusi lähestymistapa hyödyntää kognitiotieteen menetelmiä, erityisesti Dedre Gentnerin Rakennekartoitusteoria (analogiatutkimus) ja Amos Tverskyn määritelmä relaatiosamankaltaisuudesta ja ominaisuuksien samankaltaisuudesta.

Esimerkki relationaalisesta samankaltaisuudesta asiaan liittyvältä projektin verkkosivustolta. Lähde

Kirjoittajat toteavat:

"[Ihmiset] käsittelevät samankaltaisuuden määrittämisen aistimuksen kautta, mutta relationaalinen samankaltaisuus vaatii käsitteellistä abstraktiota, jota usein tukee kieli tai aiempi tieto. Tämä viittaa siihen, että relationaalisen samankaltaisuuden tunnistaminen edellyttää ensin kuvan ymmärtämistä, tiedon hyödyntämistä ja sen taustalla olevan rakenteen abstraktiota."

RFID lukija NFC lukija uusi paperi on otsikko Relaatiollinen visuaalinen samankaltaisuus, ja mukana tulee hankkeen verkkosivuilla (katso artikkelin lopussa oleva video).

Menetelmä

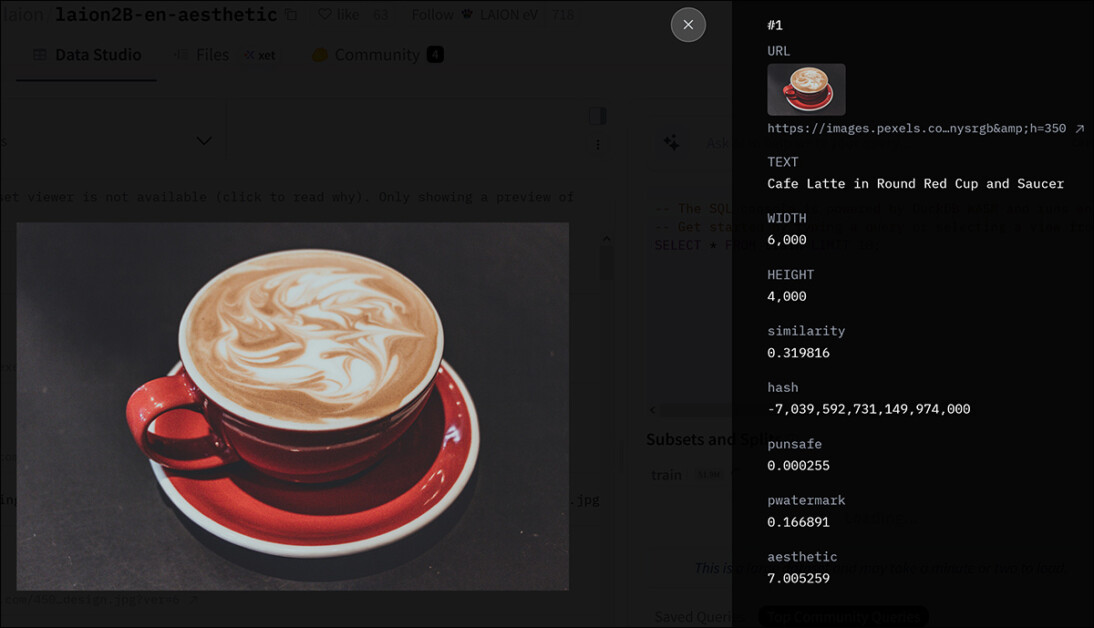

Tutkijat käyttivät yhtä tunnetuimmista hyperskaala-aineistoista lähtökohtana omalle kokoelmalleen – LAION-2B:

LAION-2B-kokoelman merkinnän metatiedot. Lähde

LAION-2B-aineistosta erotettiin 114 000 kuvaa, jotka todennäköisesti sisältävät elastisia relaatiorakenteita. Tähän liittyen suodatettiin pois monet minimaalisesti kuratoidussa aineistossa olevat heikkolaatuiset kuvat.

Tämän valintaprosessin putken luomiseksi kirjoittajat käyttivät Qwen2.5-VL-7B, hyödyntäen 1 300 positiivista ja 11 000 negatiivista ihmisillä merkittyä esimerkkiä:

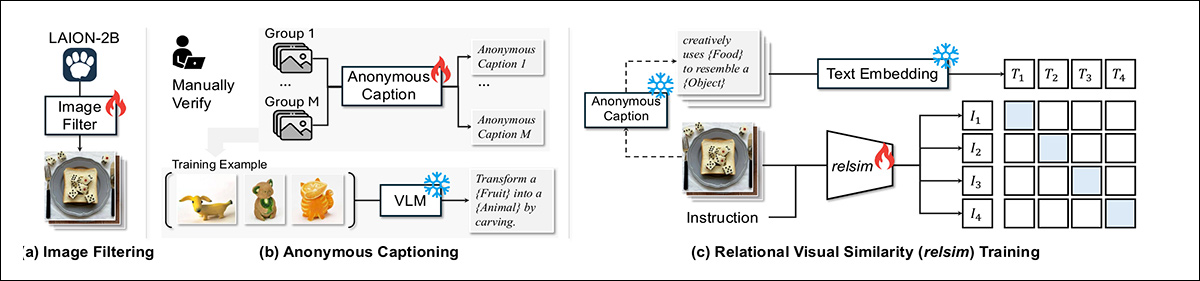

relsim-järjestelmää koulutetaan kolmessa vaiheessa: LAION-2B:n kuvien suodattaminen relaatiosisällön varalta; jokaiselle ryhmälle yhteisen anonyymin kuvatekstin määrittäminen, joka kuvaa niiden taustalla olevaa logiikkaa; ja kuvien ja kuvatekstien yhdistämisen oppiminen kontrastiivisen häviön avulla.

Paperissa todetaan:

”Annotaattoreille annettiin ohjeet: ”Näettekö tässä kuvassa mitään relaatiokuviota, logiikkaa tai rakennetta, joka voisi olla hyödyllinen toisen kuvan luomisessa tai linkittämisessä siihen?” Hienosäädetty malli saavuttaa 93 %:n yhteensopivuuden ihmisen arvioiden kanssa, ja LAION-2B:hen sovellettuna se tuottaa N = 114 000 kuvaa, jotka on tunnistettu relaatiollisesti mielenkiintoisiksi.”

Suhteellisten tunnisteiden luomiseksi tutkijat pyysivät Qwen-mallia kuvaamaan kuvajoukkojen taustalla olevaa yhteistä logiikkaa nimeämättä tiettyjä objekteja. Tätä abstraktiota oli vaikea saavuttaa, kun malli näki vain yhden kuvan, mutta siitä tuli toimiva, kun useat esimerkit osoittivat taustalla olevan kuvion.

Tuloksena syntyneissä ryhmätason kuvateksteissä tietyt termit korvattiin paikkamerkeillä, kuten '{Aihe}' or '{Liiketyyppi}', mikä tekee niistä laajasti sovellettavissa olevia.

Ihmisen tekemän tarkistuksen jälkeen jokainen kuvateksti yhdistettiin kaikkiin sen ryhmän kuviin. Mallin kouluttamiseen käytettiin yli 500 tällaista ryhmää, ja mallia sovellettiin sitten 114 000 suodatettuun kuvaan, jolloin saatiin suuri joukko abstrakteja, relaatioannotoituja näytteitä.

Tiedot ja testit

Kun relaatio-ominaisuudet oli erotettu Qwen2.5-VL-7B:llä, mallia hienosäädettiin datan perusteella käyttämällä LoRA, 15 000 askeleen ajan kahdeksan A100-grafiikkasuorittimen* kautta. Tekstipuolelle upotettiin relaatiotekstit käyttämällä all-MiniLM-L6-v2 mistä Lausemuuntajien kirjasto.

114 000 kuvateksteillä varustetun kuvan aineisto oli jakaa 100 000:een koulutusta varten ja 14 000:een arviointia varten. Järjestelmän testaamiseksi käytettiin hakuasetelmaa: annettiin kyselykuva, ja mallin piti löytää 28 000 alkion valikoimasta eri kuva, joka ilmaisi saman relaatioidean. Hakuvalikoimaan kuului 14 000 arviointikuvaa ja 14 000 lisänäytettä LAION-2B:stä, ja vertailuanalyysia varten arviointijoukosta valittiin satunnaisesti 1 000 kyselyä.

Haun laadun arvioimiseksi GPT-4o käytettiin pisteyttämään kunkin kyselyn ja haetun kuvan välisen relationaalisen samankaltaisuuden asteikolla 0–10. Käyttäjien mieltymysten arvioimiseksi tehtiin myös erillinen ihmiskoe (katso alla).

Jokaiselle osallistujalle näytettiin anonymisoitu kyselykuva, jossa oli kaksi vaihtoehtoa, toinen ehdotetulla menetelmällä ja toinen lähtötilanteen avulla. Osallistujilta kysyttiin, kumpi kuva oli suhteellisesti samankaltaisempi kyselyn kanssa tai olivatko molemmat yhtä lähellä sitä. Jokaista lähtötilannetta varten luotiin 300 kolmikkoa, jotka vähintään kolme henkilöä arvioi kukin, jolloin saatiin noin 900 vastausta.

Relsim-lähestymistapaa verrattiin useisiin vakiintuneisiin kuva-kuva-samankaltaisuusmenetelmiin, mukaan lukien edellä mainitut LPIPS ja DINO, sekä dreamsimja CLIP-IKuvaparien välisiä samankaltaisuuspisteitä suoraan laskevien lähtötasojen, kuten LPIPS:n, DINO:n, dreamsimin ja CLIP-I:n, lisäksi kirjoittajat testasivat myös kuvateksteihin perustuvia menetelmiä, joissa Qweniä käytettiin anonyymin tai abstraktin kuvatekstin luomiseen jokaiselle kuvalle; tämä toimi sitten hakukyselynä.

Arvioitiin kaksi hakuvarianttia: CLIP-pohjainen tekstistä kuvaksi -haku (CLIP-T) tekstistä kuvaksi -hakuun ja Qwen-T tekstistä tekstiksi -hakuun. Molemmat kuvatekstiin perustuvat lähtötasot käyttivät alkuperäistä esikoulutettua Qwen-mallia relaatiologiikan perusteella hienosäädetyn version sijaan. Tämä mahdollisti kirjoittajille ryhmäpohjaisen koulutuksen vaikutuksen eristämisen, koska hienosäädetty malli oli altistettu kuvajoukoille yksittäisten esimerkkien sijaan.

Olemassa olevat mittarit ja relaatioiden samankaltaisuus

Kirjoittajat testasivat aluksi, voisivatko olemassa olevat mittarit tallentaa relationaalisen samankaltaisuuden:

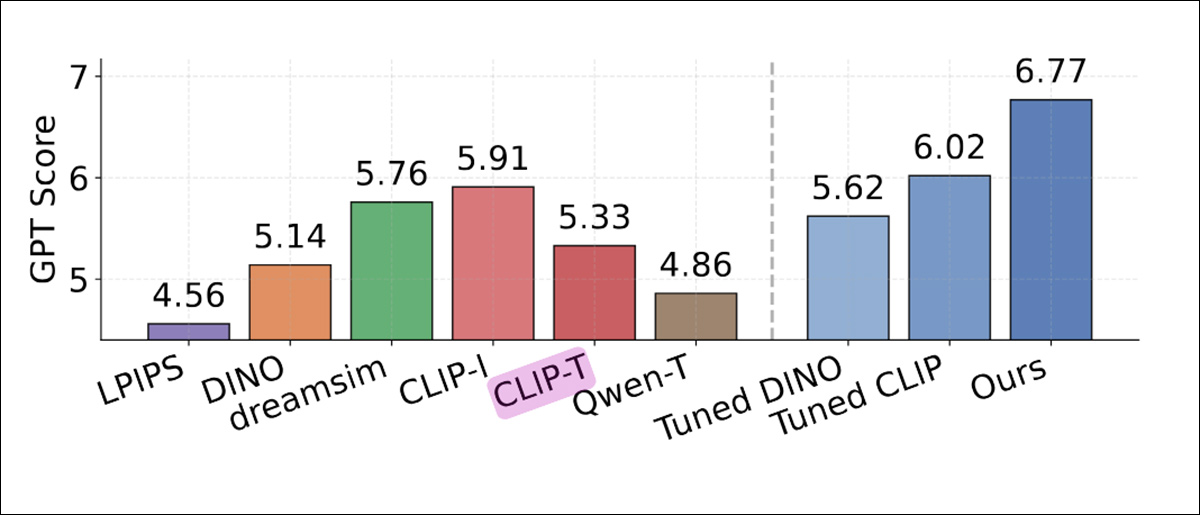

GPT-4o:n arvioiman hakutuloksen vertailu, jossa näkyy kunkin menetelmän keskimääräinen relationaalinen samankaltaisuuspistemäärä. Perinteiset samankaltaisuusmittarit, kuten LPIPS, DINO ja CLIP-I, saivat alhaisemmat pisteet. Myös kuvateksteihin perustuvat lähtötasot Qwen-T ja CLIP-T suoriutuivat heikommin. Korkeimman pistemäärän saavutti relsim (6.77, oikeanpuoleisin sininen sarake), mikä osoittaa, että ryhmäpohjaisten relaatiomallien hienosäätö paransi yhdenmukaisuutta GPT-4o:n arviointien kanssa.

Näistä tuloksista kirjoittajat toteavat**:

'[LPIPS], joka keskittyy puhtaasti havaintomuotoiseen samankaltaisuuteen, saavuttaa alhaisimman pistemäärän (4.56). [DINO] suoriutuu vain hieman paremmin (5.14), todennäköisesti siksi, että sitä koulutetaan yksinomaan itseohjautuvalla tavalla kuvadatan avulla. [CLIP-I] antaa vahvimmat tulokset lähtötasojen joukossa (5.91), oletettavasti siksi, että kuvateksteissä on joskus jonkin verran abstraktiota.'

”CLIP-I on kuitenkin edelleen suorituskyvyltään menetelmäämme heikompi, sillä paremman pistemäärän saavuttaminen saattaa edellyttää kykyä saavuttaa vielä korkeamman tason abstraktioita, kuten anonyymejä kuvatekstejä.”

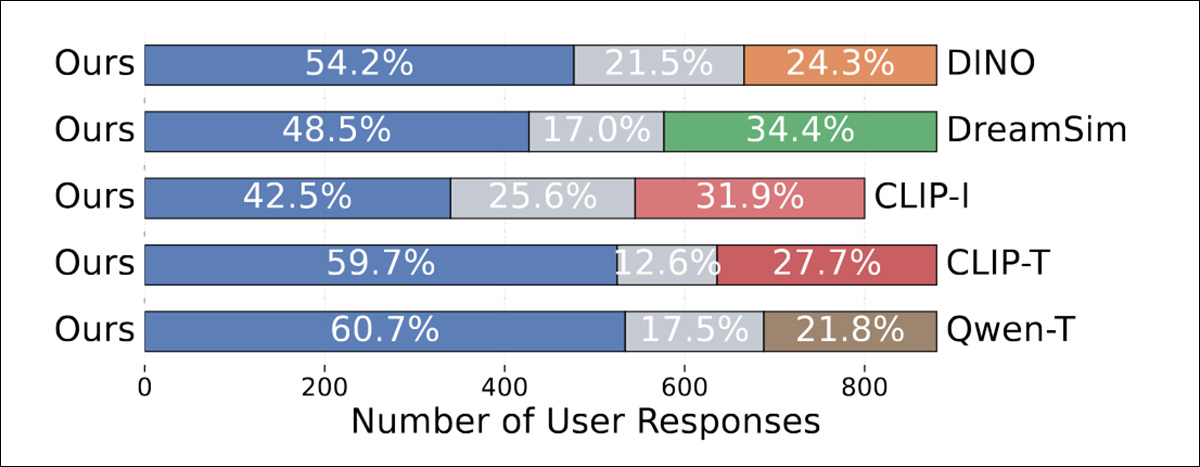

Käyttäjätutkimuksessa ihmiset suosivat johdonmukaisesti relsim-menetelmää kaikissa lähtötilanteissa:

GPT-4o:n kullekin menetelmälle antamat relaatioiden samankaltaisuuspisteet. Standardit samankaltaisuusmittarit, kuten LPIPS, DINO ja CLIP-I, saivat alhaisemmat pisteet, ja kuvatekstiin perustuvat variantit Qwen-T ja CLIP-T suoriutuivat vain hieman paremmin. Edes DINOn ja CLIPin viritetyt versiot eivät kuroneet umpeen eroa. Korkeimman pistemäärän, 6.77, saavutti relsim-malli, jota koulutettiin ryhmäpohjaisella ohjauksella.

Kirjailijat huomauttavat:

Tämä on erittäin rohkaisevaa, sillä se osoittaa paitsi että mallimme, relsim, voi onnistuneesti hakea suhteellisesti samankaltaisia kuvia, mutta myös jälleen kerran vahvistaa, että ihmiset havaitsevat suhteellisesti samankaltaisia – eivätkä vain määritä samankaltaisuutta!

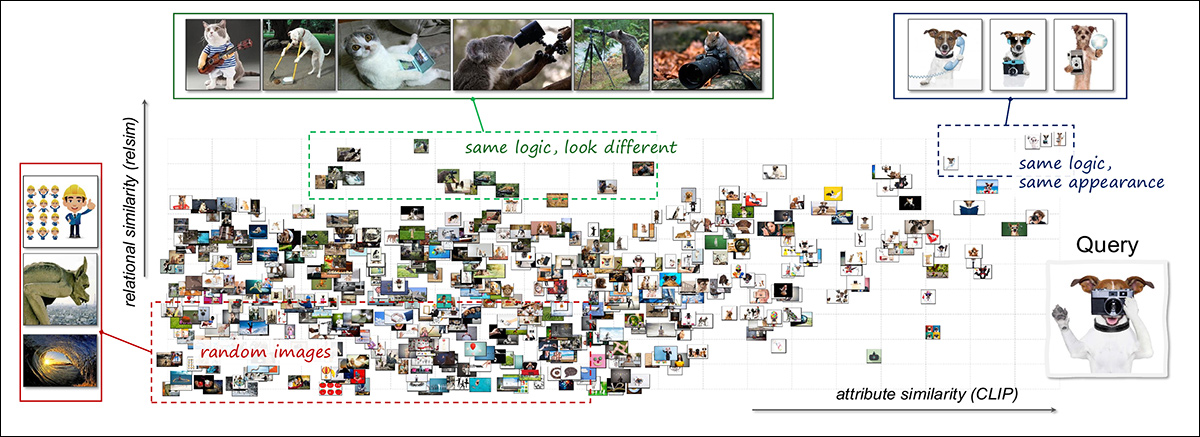

Tutkiakseen, miten relaatio- ja ominaisuussamankaltaisuus voisivat täydentää toisiaan, tutkijat käyttivät yhdistettyä visualisointimenetelmää. Yksi kyselykuva ("Koira pitelee kameraa") verrattiin 3 000 satunnaiseen kuvaan, ja samankaltaisuus laskettiin käyttämällä sekä relaatio- että ominaisuuspohjaisia malleja:

Visuaalisen samankaltaisuusavaruuden yhdistetty visualisointi relaatio- ja attribuuttiakseleiden avulla. Yhtä kyselykuvaa, joka esittää kameraa käyttävää koiraa, verrattiin 3 000 muuhun kuvaan. Tulokset järjestettiin relaatiosamankaltaisuuden (pystysuora) ja attribuuttisamankaltaisuuden (vaakasuora) mukaan. Oikeassa yläkulmassa on kuvia, jotka muistuttavat kyselyä sekä logiikaltaan että ulkonäöltään, kuten muut koirat käyttävät työkaluja. Vasemmassa yläkulmassa on semanttisesti toisiinsa liittyviä, mutta visuaalisesti erillisiä tapauksia, kuten eri eläimet suorittavat kameraan liittyviä toimintoja. Useimmat jäljellä olevat esimerkit ryhmittyvät alemmaksi avaruudessa, mikä heijastaa heikompaa samankaltaisuutta. Asettelu havainnollistaa, kuinka relaatio- ja attribuuttimallit korostavat visuaalisen datan täydentäviä näkökohtia. Katso parempi resoluutio lähdejulkaisusta.

Tulokset paljastivat klustereita, jotka vastasivat erityyppisiä samankaltaisuuksia: jotkut kuvat olivat sekä suhteellisesti että visuaalisesti samankaltaisia, kuten muut koirat ihmisen kaltaisissa asennoissa; toiset jakoivat suhteellista logiikkaa, mutta eivät ulkonäköä, kuten eri eläimet matkivat ihmisen toimia; loput eivät osoittaneet kumpaakaan.

Tämä analyysi viittaa siihen, että näillä kahdella samankaltaisuustyypillä on erilliset roolit ja ne tuottavat yhdistettynä rikkaamman rakenteen.

Käytä koteloita

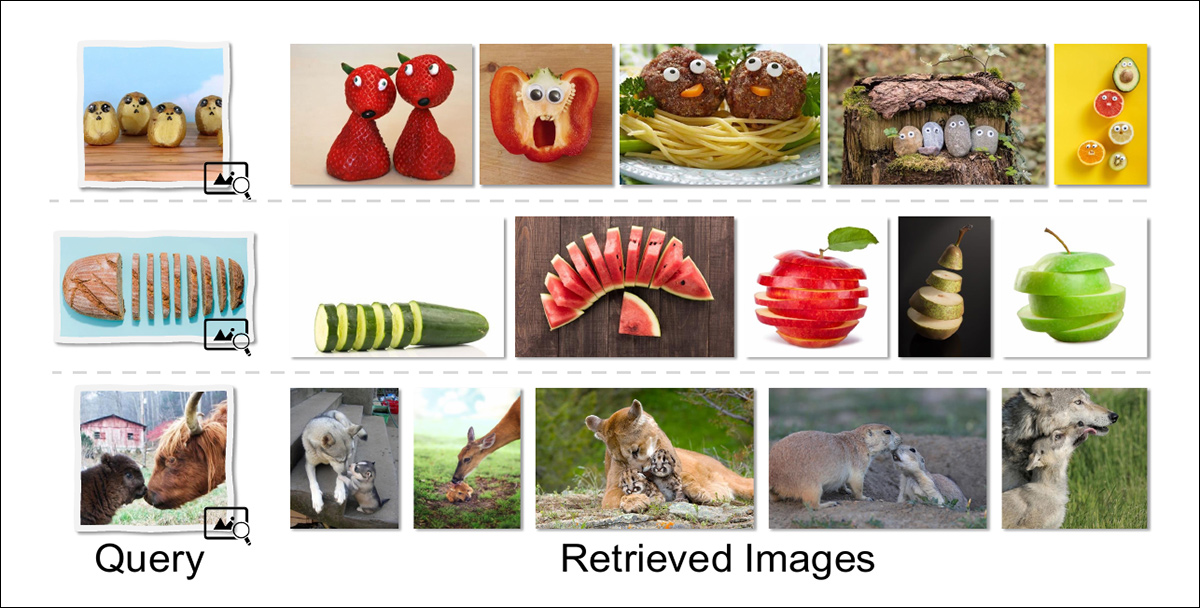

Artikkelissa tarkastellaan myös joitakin mahdollisia relationaalisen samankaltaisuuden loppukäyttötapauksia, mukaan lukien relaatiokuvien haku, joka mahdollistaa kuvahaun, joka on paremmin linjassa ihmisten oman luovan tavan kanssa tarkastella maailmaa:

Relaatiohaku palauttaa kuvia, joilla on syvempi käsitteellinen rakenne kyselyn kanssa, sen sijaan, että ne vastaisivat pintapiirteitä. Esimerkiksi kasvoja muistuttavaksi muotoiltu ruoka-aine hakee muita antropomorfisia aterioita; viipaloitu esine tuottaa muita viipaloituja muotoja; ja aikuisen ja jälkeläisen vuorovaikutuskohtaukset palauttavat kuvia, joilla on samankaltaiset relaatioroolit, vaikka lajit ja koostumus eroaisivat toisistaan.

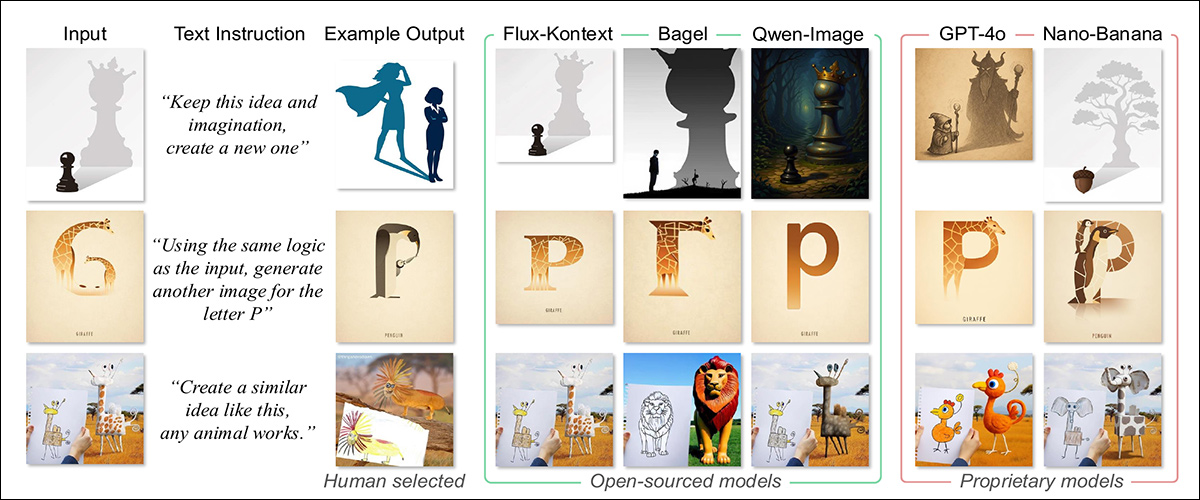

Toinen mahdollisuus on analogisen kuvan generointi, mikä mahdollistaisi sellaisten kyselyiden synteesin, jotka käyttävät relaatiorakenteita suorien kuvausten sijaan. Vertailemalla nykyisen sukupolven huippuluokan tekstistä kuvaksi -malleilla saatuja tuloksia voimme nähdä, että tällaisen lähestymistavan tulokset ovat todennäköisesti monimuotoisempia:

Malleille annettiin syötekuva ja relaatiokehote, ja niiden piti luoda uusi kuva, joka ilmentäisi samaa taustalla olevaa käsitettä. Avoimen lähdekoodin mallit tuottivat tarkempia analogioita säilyttäen rakenteellisen logiikan suurista muodonmuutoksista huolimatta, kun taas avoimen lähdekoodin mallit pyrkivät regressoimaan kirjaimellisiin tai tyylillisiin vastaavuuksiin, eivätkä ne onnistuneet siirtämään syvempää ajatusta. Tuotoksia verrattiin ihmisen kuratoimiin analogioihin, jotka havainnollistavat tarkoitettua muutosta.

Yhteenveto

Generatiivisia tekoälyjärjestelmiä näyttäisi parantavan huomattavasti kyky sisällyttää abstrakteja representaatioita käsitteellistämiseensa. Nykytilanteessa käsitepohjaisten kuvien, kuten "vihan" tai "onnellisuuden", pyytäminen palauttaa yleensä kuvia, jotka on muotoiltu tietojoukon suosituimpien tai yleisimpien kuvien mukaan, joilla on näitä yhteyksiä; mikä on ulkoa ottaminen abstraktion sijaan.

Oletettavasti tämä periaate voisi olla vielä hyödyllisempi, jos sitä voitaisiin soveltaa generatiiviseen kirjoittamiseen – erityisesti analyyttiseen, spekulatiiviseen tai fiktiiviseen tuotokseen.

Paina toistaaksesi. Lähde

* A100-mallissa voi olla 40 Gt tai 80 Gt VRAM-muistia; tätä ei ole eritelty artikkelissa.

** Kirjoittajien viittaukset ovat tarpeettomia ja jätetty pois.**

Julkaistu ensimmäisen kerran tiistaina 16