Tekoäly

Täydellinen opas suurten kielimallien hienosäätöön

Sisällysluettelo

Suuret kielimallit (LLM:t), kuten GPT-4, LaMDA, PaLM ja muut, ovat valloittaneet maailman myrskyisillä kyvyllään ymmärtää ja luoda ihmismäistä tekstiä monista eri aiheista. Nämä mallit on esikoulutettu massiivisiin tietokokonaisuuksiin, jotka sisältävät miljardeja sanoja Internetistä, kirjoista ja muista lähteistä.

Tämä esikoulutusvaihe täyttää mallit laajalla yleistiedolla kielestä, aiheista, päättelykyvystä ja jopa tietyistä koulutustiedoissa esiintyvistä harhoista. Kuitenkin uskomattomasta laajuudestaan huolimatta näiltä esikoulutetuilta LLM:iltä puuttuu erityisasiantuntemus tietyille aloille tai tehtäviin.

Tässä tulee esiin hienosäätö – prosessi, jossa esikoulutettu LLM mukautetaan loistamaan tietyssä sovelluksessa tai käyttötapauksessa. Kouluttamalla mallia edelleen pienemmällä, tehtäväkohtaisella tietojoukolla voimme virittää sen ominaisuudet vastaamaan kyseisen toimialueen vivahteita ja vaatimuksia.

Hienosäätö on analogista korkeasti koulutetun generalistin laaja-alaisen tietämyksen siirtämiseen tiettyyn alaan erikoistuneen aiheen asiantuntijaksi. Tässä oppaassa tutkimme mitä, miksi ja miten hienosäätää LLM:itä.

Mikä on hienosäätö?

Sen ydin, hienosäätö edellyttää suuren esiopetetun mallin ottamista ja sen parametrien päivittämistä käyttämällä toista koulutusvaihetta kohdetehtävällesi tai -alueelle räätälöidyssä tietojoukossa. Tämä antaa mallille mahdollisuuden oppia ja sisäistää tälle kapeammalle alueelle ominaiset vivahteet, mallit ja tavoitteet.

Vaikka esikoulutus kaappaa laajan kielen ymmärtämisen valtavasta ja monipuolisesta tekstikorpuksesta, hienosäätö erikoistuu tähän yleiseen osaamiseen. Se on kuin renessanssin miehen ottamista ja heistä alan asiantuntijan muokkaamista.

Esiopetetun mallin painoja, jotka koodaavat sen yleistietoa, käytetään hienosäätöprosessin lähtökohtana tai alustuksena. Tämän jälkeen mallia koulutetaan edelleen, mutta tällä kertaa loppusovellukseen suoraan liittyvillä esimerkeillä.

Altistamalla malli tälle erikoistuneelle tiedonjakelulle ja virittämällä mallin parametrit vastaavasti teemme LLM:stä tarkemman ja tehokkaamman kohdekäyttötapauksessa, samalla kun hyödynnämme perustana laajat valmiiksi koulutetut ominaisuudet.

Miksi Fine-Tune LLM:t?

On useita keskeisiä syitä, miksi saatat haluta hienosäätää suurta kielimallia:

- Verkkotunnuksen mukauttaminen: Jokaisella alalla, juridiikasta lääketieteeseen ja ohjelmistosuunnitteluun, on omat vivahteet kielikonventiot, ammattikieltä ja kontekstit. Hienosäädön avulla voit mukauttaa yleisen mallin ymmärtämään ja tuottamaan tekstiä, joka on räätälöity tietylle toimialueelle.

- Tehtävän erikoistuminen: LLM:itä voidaan hienosäätää erilaisiin luonnollisen kielen käsittelytehtäviin, kuten tekstin yhteenvetoon, konekääntämiseen, kysymyksiin vastaamiseen ja niin edelleen. Tämä erikoistuminen parantaa suorituskykyä tavoitetehtävässä.

- Tietojen noudattaminen: Tiukasti säännellyillä aloilla, kuten terveydenhuollon ja rahoituksen alalla, on tiukat tietosuojavaatimukset. Hienosäädön avulla LLM:t voidaan kouluttaa omistusoikeudellisiin organisaatiotietoihin ja samalla suojata arkaluonteisia tietoja.

- Rajoitettu merkitty tieto: Suurten merkittyjen tietojoukkojen saaminen harjoitusmalleille alusta alkaen voi olla haastavaa. Hienosäätö mahdollistaa tehokkaan tehtävien suorituskyvyn rajallisista valvotuista esimerkeistä hyödyntämällä esikoulutetun mallin ominaisuuksia.

- Mallin päivitys: Kun verkkotunnuksessa tulee saataville ajan mittaan uutta dataa, voit hienosäätää malleja edelleen sisällyttääksesi uusimman tiedon ja ominaisuudet.

- Lieventäviä harhoja: LLM:t voivat poimia yhteiskunnallisia ennakkoluuloja laajasta koulutusta edeltävästä tiedosta. Kuroitujen tietojoukkojen hienosäätö voi auttaa vähentämään ja korjaamaan näitä ei-toivottuja harhoja.

Pohjimmiltaan hienosäätö muodostaa sillan yleisen, laajan mallin ja erikoissovelluksen kohdistettujen vaatimusten välillä. Se parantaa mallitulosteiden tarkkuutta, turvallisuutta ja relevanssia kohdennetuissa käyttötapauksissa.

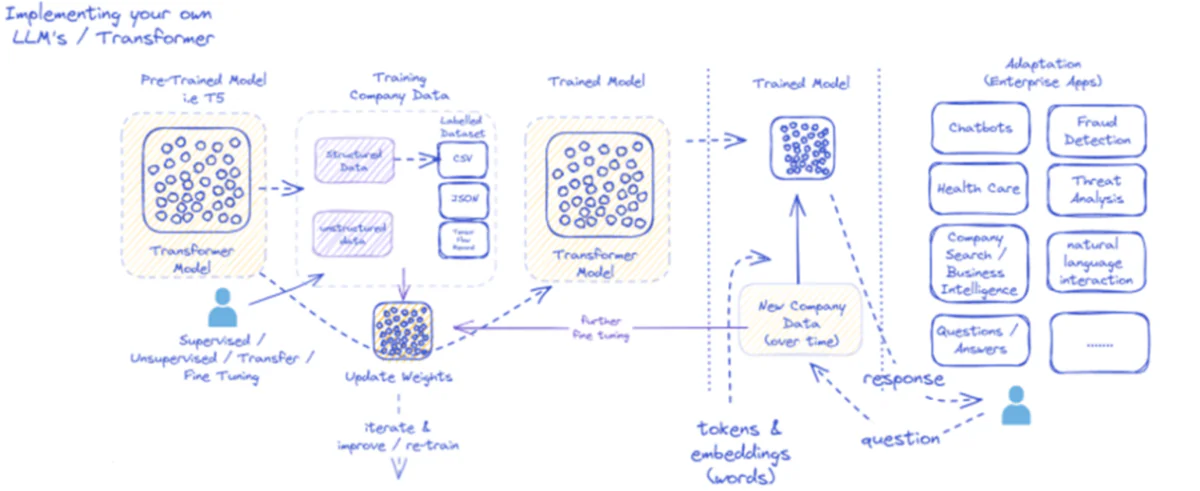

Toimitettu kaavio hahmottelee suurten kielimallien (LLM) käyttöönotto- ja hyödyntämisprosessia erityisesti yrityssovelluksissa. Aluksi esikoulutettu malli, kuten T5, syötetään strukturoitua ja strukturoimatonta yritystietoa, joka voi olla eri muodoissa, kuten CSV tai JSON. Nämä tiedot käyvät läpi valvottuja, valvomattomia tai siirron hienosäätöprosesseja, mikä parantaa mallin osuvuutta yrityksen erityistarpeisiin.

Kun mallia on hienosäädetty yritystiedoilla, sen painot päivitetään vastaavasti. Koulutettu malli toistuu sitten jatkokoulutusjaksojen läpi ja parantaa jatkuvasti vastauksiaan ajan myötä uusilla yritystiedoilla. Prosessi on iteratiivinen ja dynaaminen, ja malli oppii ja koulutetaan uudelleen sopeutuakseen muuttuviin tietomalleja.

Tämän koulutetun mallin tulos – sanoja edustavat tunnukset ja upotukset – otetaan sitten käyttöön erilaisissa yrityssovelluksissa. Nämä sovellukset voivat vaihdella chatboteista terveydenhuoltoon, ja jokainen vaatii mallin ymmärtämään toimialakohtaisia kyselyitä ja vastaamaan niihin. Rahoituksessa sovelluksiin kuuluvat petosten havaitseminen ja uhka-analyysi; terveydenhuollossa mallit voivat auttaa potilaskyselyissä ja diagnostiikassa.

Koulutetun mallin kyky käsitellä ja reagoida uusiin yritystietoihin ajan mittaan varmistaa, että sen hyödyllisyys säilyy ja kasvaa. Tämän seurauksena yrityskäyttäjät voivat olla vuorovaikutuksessa mallin kanssa sovellusten kautta, esittää kysymyksiä ja saada tietoisia vastauksia, jotka kuvastavat mallin koulutusta ja toimialuekohtaisten tietojen hienosäätöä.

Tämä infrastruktuuri tukee laajaa valikoimaa yrityssovelluksia, ja se osoittaa LLM:ien monipuolisuuden ja sopeutumiskyvyn, kun ne toteutetaan ja ylläpidetään oikein liiketoimintaympäristössä.

Hienosäätölähestymistavat

Suurten kielimallien hienosäädössä on kaksi ensisijaista strategiaa:

1) Täysi mallin hienosäätö

Täysi hienosäätömenetelmässä kaikki esiopetetun mallin parametrit (painot ja poikkeamat) päivitetään toisen harjoitusvaiheen aikana. Malli altistetaan tehtäväkohtaiselle merkitylle tietojoukolle, ja vakiokoulutusprosessi optimoi koko mallin kyseiselle datajakelulle.

Tämän ansiosta malli voi tehdä kattavampia säätöjä ja mukautua kokonaisvaltaisesti kohdetehtävään tai -alueeseen. Täydellä hienosäädöllä on kuitenkin joitain haittoja:

- Se vaatii huomattavia laskennallisia resursseja ja aikaa harjoitella, kuten esikoulutusvaiheessa.

- Tallennusvaatimukset ovat korkeat, koska jokaista tehtävää varten on ylläpidettävä erillistä hienosäädettyä kopiota mallista.

- On olemassa "katastrofaalisen unohtamisen" riski, jossa hienosäätö aiheuttaa sen, että malli menettää joitain esikoulutuksen aikana opittuja yleisiä ominaisuuksia.

Näistä rajoituksista huolimatta täydellinen hienosäätö on edelleen tehokas ja laajalti käytetty tekniikka, kun resurssit sen sallivat ja kohdetehtävä poikkeaa merkittävästi yleisestä kielestä.

2) Tehokkaat hienosäätömenetelmät

Täydellisen hienosäädön laskennallisten haasteiden voittamiseksi tutkijat ovat kehittäneet tehokkaita strategioita, jotka päivittävät vain pienen osajoukon mallin parametreista hienosäädön aikana. Nämä parametrisesti tehokkaat tekniikat löytävät tasapainon erikoistumisen ja resurssitarpeiden vähentämisen välillä.

Joitakin suosittuja tehokkaita hienosäätömenetelmiä ovat:

Etuliitteen viritys: Tässä otetaan käyttöön pieni määrä tehtäväkohtaisia vektoreita tai "etuliitteitä" ja niitä opetetaan ohjaamaan esikoulutetun mallin huomion kohdetehtävään. Vain nämä etuliitteet päivitetään hienosäädön aikana.

LoRA (Low-Rank Adaption): LoRA ruiskuttaa koulutettavia matala-arvoisia matriiseja esiopetetun mallin jokaiseen kerrokseen hienosäädön aikana. Nämä pienet arvosäädöt auttavat erikoistumaan malliin, jossa on paljon vähemmän harjoitettavia parametreja kuin täydellinen hienosäätö.

Toki voin tarjota yksityiskohtaisen selityksen LoRA:sta (Low-Rank Adaptation) sekä matemaattisen muotoilun ja koodiesimerkit. LoRA on suosittu parametritehokas hienosäätötekniikka (PEFT), joka on saavuttanut merkittävää vetovoimaa suurten kielimallien (LLM) mukauttamisessa.

Mikä on LoRA?

LoRA on hienosäätömenetelmä, joka tuo esikoulutettuun LLM:ään pienen joukon koulutettavia parametreja, mikä mahdollistaa tehokkaan mukauttamisen loppupään tehtäviin säilyttäen samalla suurimman osan alkuperäisen mallin tietämyksestä. Kaikkien LLM:n parametrien hienosäädön sijaan LoRA ruiskuttaa mallin kerroksiin tehtäväkohtaisia matala-arvoisia matriiseja, mikä mahdollistaa merkittävät laskennalliset ja muistisäästöt hienosäätöprosessin aikana.

Matemaattinen muotoilu

LoRA (Low-Rank Adaptation) on hienosäätömenetelmä suurille kielimalleille (LLM), joka tuo mukanaan matalan tason päivityksen painomatriiseihin. Painomatriisille 0∈W0----∈Rd×k, LoRA lisää matalaluokkaisen matriisin BA, kanssa A∈Rr×k ja B∈Rd×r, Jossa r on sijoitus. Tämä lähestymistapa vähentää merkittävästi koulutettavien parametrien määrää, mikä mahdollistaa tehokkaan mukauttamisen loppupään tehtäviin minimaalisilla laskentaresursseilla. Päivitetyn painomatriisin antaa W=W0----+B⋅A.

Tämä alemman tason päivitys voidaan tulkita alkuperäisen painomatriisin $W_{0}$ muokkaamiseksi lisäämällä matalan tason matriisi $BA$. Tämän muotoilun tärkein etu on, että kaikkien $d \times k$ parametrien päivittämisen sijaan $W_{0}$, LoRA tarvitsee vain optimoida $r \times (d + k)$ parametrit $A$ ja $B. $, mikä vähentää merkittävästi koulutettavien parametrien määrää.

Tässä on esimerkki Pythonissa käyttämällä peft kirjasto soveltaa LoRAa esikoulutettuun LLM:ään tekstin luokittelua varten:

</div> <div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color="">from</span> transformers <span class="token" data-darkreader-inline-color="">import</span> AutoModelForSequenceClassification </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color="">from</span> peft <span class="token" data-darkreader-inline-color="">import</span> get_peft_model<span class="token" data-darkreader-inline-color="">,</span> LoraConfig<span class="token" data-darkreader-inline-color="">,</span> TaskType </code></div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Load pre-trained model</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color="">model <span class="token" data-darkreader-inline-color="">=</span> AutoModelForSequenceClassification<span class="token" data-darkreader-inline-color="">.</span>from_pretrained<span class="token" data-darkreader-inline-color="">(</span><span class="token" data-darkreader-inline-color="">"bert-base-uncased"</span><span class="token" data-darkreader-inline-color="">,</span> num_labels<span class="token" data-darkreader-inline-color="">=</span><span class="token" data-darkreader-inline-color="">2</span><span class="token" data-darkreader-inline-color="">)</span> </code></div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Define LoRA configuration</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color="">peft_config <span class="token" data-darkreader-inline-color="">=</span> LoraConfig<span class="token" data-darkreader-inline-color="">(</span>task_type<span class="token" data-darkreader-inline-color="">=</span>TaskType<span class="token" data-darkreader-inline-color="">.</span>SEQ_CLS<span class="token" data-darkreader-inline-color="">, </span>r<span class="token" data-darkreader-inline-color="">=</span><span class="token" data-darkreader-inline-color="">8</span><span class="token" data-darkreader-inline-color="">,</span> <span class="token" data-darkreader-inline-color=""># Rank of the low-rank update</span> lora_alpha<span class="token" data-darkreader-inline-color="">=</span><span class="token" data-darkreader-inline-color="">16</span><span class="token" data-darkreader-inline-color="">,</span></code><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Scaling factor for the low-rank update</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""> target_modules<span class="token" data-darkreader-inline-color="">=</span><span class="token" data-darkreader-inline-color="">[</span><span class="token" data-darkreader-inline-color="">"q_lin"</span><span class="token" data-darkreader-inline-color="">,</span> <span class="token" data-darkreader-inline-color="">"v_lin"</span><span class="token" data-darkreader-inline-color="">]</span><span class="token" data-darkreader-inline-color="">,</span> <span class="token" data-darkreader-inline-color=""># Apply LoRA to the query and value layers</span> <span class="token" data-darkreader-inline-color="">)</span> </code></div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Create the LoRA-enabled model</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color="">model <span class="token" data-darkreader-inline-color="">=</span> get_peft_model<span class="token" data-darkreader-inline-color="">(</span>model<span class="token" data-darkreader-inline-color="">,</span> peft_config<span class="token" data-darkreader-inline-color="">)</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Fine-tune the model with LoRA</span> </code></div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># ... (training code omitted for brevity)</span></code></div> </div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color="">

Tässä esimerkissä lataamme valmiiksi koulutetun BERT-mallin sekvenssiluokitusta varten ja määritämme LoRA-konfiguraation. The r parametri määrittää matalan tason päivityksen arvon ja lora_alpha on päivityksen skaalaustekijä. The target_modules parametri osoittaa, mitkä mallin kerrokset saavat alemman tason päivitykset. Kun LoRA-yhteensopiva malli on luotu, voimme jatkaa hienosäätöprosessia käyttämällä tavallista koulutusmenettelyä.

Adapterikerrokset: Samanlainen kuin LoRA, mutta matalaluokkaisten päivitysten sijaan ohuita "sovitin"-kerroksia asetetaan esiopetetun mallin jokaiseen muuntajalohkoon. Vain näiden muutamien uusien kompaktien kerrosten parametrit opetetaan.

Pikaviritys: Tämä lähestymistapa pitää esikoulutetun mallin täysin jäädytettynä. Sen sijaan koulutettavat "kehote"-upotukset otetaan käyttöön syötteenä, joka aktivoi mallin esikoulutetun tiedon kohdetehtävää varten.

Nämä tehokkaat menetelmät voivat vähentää laskentaa jopa 100-kertaisesti täydelliseen hienosäätöön verrattuna, mutta silti saavuttaa kilpailukykyisen suorituskyvyn monissa tehtävissä. Ne myös vähentävät tallennustarvetta välttämällä täydellisen mallin päällekkäisyyden.

Niiden suorituskyky voi kuitenkin jäädä täyden hienosäädön jälkeen sellaisille tehtäville, jotka eroavat huomattavasti yleisestä kielestä tai vaativat kokonaisvaltaisempaa erikoistumista.

Hienosäätöprosessi

Hienosäätöstrategiasta riippumatta koko LLM:n erikoistumisprosessi noudattaa yleistä kehystä:

- Tietojoukon valmistelu: Sinun on hankittava tai luotava merkitty tietojoukko, joka kartoittaa syötteet (kehotteet) kohdetehtäväsi haluttuihin lähtöihin. Tekstin luontitehtävissä, kuten yhteenvedossa, tämä olisi syöttöteksti tiivistetyille tulospareille.

- Tietojoukon jakaminen: Parhaiden käytäntöjen mukaisesti jaa merkitty tietojoukko koulutus-, validointi- ja testijoukkoon. Tämä erottaa tiedot mallin koulutusta, hyperparametrien viritystä ja loppuarviointia varten.

- Hyperparametrien viritys: Parametrit, kuten oppimisnopeus, eräkoko ja harjoitusaikataulu, on säädettävä, jotta tietojesi hienosäätö on tehokkainta. Tämä sisältää yleensä pienen validointijoukon.

- Malliharjoittelu: Käytä viritettyjä hyperparametreja ja suorita optimointiprosessin hienosäätö koko harjoitussarjassa, kunnes mallin suorituskyky vahvistusjoukossa lakkaa paranemasta (varhainen pysähtyminen).

- Arviointi: Arvioi hienosäädetyn mallin suorituskykyä pidennetyssä testisarjassa, joka sisältää ihanteellisesti todellisia esimerkkejä kohdekäyttötapausta varten, jotta voit arvioida todellisen tehokkuuden.

- Käyttöönotto ja seuranta: Kun hienosäädetty malli on tyydyttävä, sitä voidaan käyttää uusien tulojen päättelemiseksi. On ratkaisevan tärkeää seurata sen suorituskykyä ja tarkkuutta ajan mittaan konseptien siirtymisen varalta.

Vaikka tämä hahmottaa koko prosessin, monet vivahteet voivat vaikuttaa tietyn LLM:n tai tehtävän onnistumiseen. Strategiat, kuten opetussuunnitelman oppiminen, monen tehtävien hienosäätö ja muutaman otoksen kehotus, voivat parantaa suorituskykyä entisestään.

Lisäksi tehokkaat hienosäätömenetelmät edellyttävät lisähuomiota. Esimerkiksi LoRA vaatii tekniikoita, kuten esikoulutetun mallin tulosteiden muokkaamista yhdistävän kerroksen kautta. Pikaviritys vaatii huolellisesti suunniteltuja kehotteita oikean toiminnan aktivoimiseksi.

Edistynyt hienosäätö: Ihmisten palautteen sisällyttäminen

Vaikka tavallinen valvottu hienosäätö leimattujen tietojoukkojen avulla on tehokasta, jännittävä raja on LLM:ien kouluttaminen suoraan käyttämällä ihmisten mieltymyksiä ja palautetta. Tämä ihminen silmukassa -lähestymistapa hyödyntää vahvistamisoppimisen tekniikoita:

PPO (Proksimaalinen käytännön optimointi): Tässä LLM:tä käsitellään vahvistavana oppimisagenttina, jonka tuotokset ovat "toimia". Palkkiomalli on koulutettu ennustamaan näiden tulosten ihmisten arvioita tai laatupisteitä. Sitten PPO optimoi LLM:n tuottaakseen tuloksia, jotka maksimoivat palkkiomallin pisteet.

RLHF (Ihmisten palautteesta oppimisen vahvistaminen): Tämä laajentaa PPO:ta sisällyttämällä suoraan ihmisen palautteen oppimisprosessiin. Kiinteän palkkiomallin sijaan palkkiot tulevat iteratiivisista ihmisen arvioinneista LLM:n tuotoksille hienosäädön aikana.

Vaikka nämä menetelmät ovatkin laskennallisesti intensiivisiä, ne mahdollistavat LLM-käyttäytymisen muokkaamisen tarkemmin ihmisten arvioimien haluttujen ominaisuuksien perusteella, sen lisäksi, mitä staattiseen tietoaineistoon voidaan tallentaa.

Anthropicin kaltaiset yritykset käyttivät RLHF:ää lisätäkseen kielimalleihinsa, kuten Claude, parannettua totuudenmukaisuutta, etiikkaa ja turvallisuustietoisuutta pelkän tehtävätaidon lisäksi.

Mahdolliset riskit ja rajoitukset

Vaikka LLM:t ovatkin erittäin tehokkaita, hienosäätöön ei liity riskejä, joita on hallittava huolellisesti:

Bias Amplification: Jos hienosäätötiedot sisältävät yhteiskunnallisia harhoja sukupuolen, rodun, iän tai muiden ominaisuuksien suhteen, malli voi vahvistaa näitä ei-toivottuja harhoja. Edustavien ja puolueettomien tietojoukkojen kuratointi on ratkaisevan tärkeää.

Tosiasiallinen ajautuminen: Jopa korkealaatuisen datan hienosäädön jälkeen kielimallit voivat "hallusinoida" vääriä tosiasioita tai koulutusesimerkkien kanssa ristiriidassa olevia tuloksia pidempien keskustelujen tai kehotteiden aikana. Faktanhakumenetelmiä voidaan tarvita.

Skaalautuvuuden haasteet: GPT-3:n kaltaisten valtavien mallien täydellinen hienosäätö vaatii valtavia laskentaresursseja, jotka saattavat olla mahdottomia monille organisaatioille. Tehokas hienosäätö lieventää tätä osittain, mutta siinä on kompromisseja.

Katastrofaalinen unohtaminen: Täydellisen hienosäädön aikana mallit voivat kokea katastrofaalista unohtamista, jolloin ne menettävät joitain esikoulutuksen aikana opittuja yleisiä ominaisuuksia. Monitehtäväoppiminen saattaa olla tarpeen.

IP- ja tietosuojariskit: Hienosäätämiseen käytetyt omistusoikeudelliset tiedot voivat vuotaa julkisesti julkaistuihin kielimallituloksiin, mikä aiheuttaa riskejä. Eriytetyt yksityisyyden ja tietovaaran lieventämistekniikat ovat aktiivisia tutkimusalueita.

Kaiken kaikkiaan hienosäätö on poikkeuksellisen hyödyllinen, mutta se on vivahteikas prosessi, joka vaatii huolellisuutta tietojen laadusta, identiteettiin liittyvistä näkökohdista, riskien vähentämisestä ja suorituskyvyn ja tehokkuuden kompromissien tasapainottamisesta käyttötapausvaatimusten perusteella.

Tulevaisuus: Kielimallin räätälöinti mittakaavassa

Jatkossa hienosäätö- ja mallien mukauttamistekniikoiden edistyminen on ratkaisevan tärkeää suurten kielimallien täyden potentiaalin vapauttamiseksi eri sovelluksissa ja aloilla.

Tehokkaammat menetelmät, jotka mahdollistavat entistä suurempien mallien, kuten PaLM:n hienosäädön rajallisilla resursseilla, voisivat demokratisoida pääsyn. Tietojoukon luontiputkien automatisointi ja nopea suunnittelu voisivat tehostaa erikoistumista.

Itsevalvotut tekniikat, joilla hienosäädetään raakadataa ilman etikettejä, voivat avata uusia rajoja. Ja koostumuslähestymistavat eri tehtäviin tai tietoihin koulutettujen hienosäädettyjen alimallien yhdistämiseksi voisivat mahdollistaa erittäin räätälöityjen mallien rakentamisen tarpeen mukaan.

Viime kädessä, kun LLM:t yleistyvät, kyky räätälöidä ja erikoistella niitä saumattomasti jokaiseen käyttötapaukseen on ratkaisevan tärkeää. Hienosäätö ja siihen liittyvät mallien mukauttamisstrategiat ovat keskeisiä askeleita toteutettaessa näkemystä suurista kielimalleista joustavina, turvallisina ja tehokkaina tekoälyavustajina, jotka lisäävät ihmisen kykyjä kaikilla aloilla ja pyrkimyksissä.

Olen viettänyt viimeiset viisi vuotta uppoutuen koneoppimisen ja syväoppimisen kiehtovaan maailmaan. Intohimoni ja asiantuntemukseni ovat saaneet minut osallistumaan yli 50:een erilaiseen ohjelmistosuunnitteluprojektiin keskittyen erityisesti tekoälyyn/ML:ään. Jatkuva uteliaisuuteni on myös vetänyt minut kohti luonnollisen kielen käsittelyä, alaa, jota olen innokas tutkimaan lisää.

Saatat pitää

Kaikki mitä sinun tarvitsee tietää Llama 3:sta | Tehokkain avoimen lähdekoodin malli tähän mennessä | Käyttökonseptit

BlackMamba: Asiantuntijoiden sekoitus valtio-avaruusmalleihin

AI GPT:t PostgreSQL-tietokannassa: voivatko ne toimia?

VUOHI (hyvä aritmeettisissa tehtävissä): kielitaidosta matematiikan nerokseen

Avoimen lähdekoodin vs. suljetun lähdekoodin kielimallien taistelu: tekninen analyysi

Suurten kielimallien arviointi: Tekninen opas

Uusimmat viestit

- 5 parasta AI SOP (Standard Operating Procedures) -generaattoria vuonna 2024

- SIMA: AI-agenttien lisääminen virtuaalimaailmoihin erilaisiin sovelluksiin

- Fredrik Danielsson, Tinyn päätuotepäällikkö – Haastattelusarja

- MaxDiff RL -algoritmi parantaa robottioppimista "suunniteltujen satunnaisten" avulla

- Lalal.ai-arvostelu: #1 AI-taustamelun poistaja?