Andersonin kulma

Tekoälyvideo tekee kissaselfiestä täydellisen

Tekoälyllä toimivat videogeneraattorit antavat usein lähellä todellista laatua olevia tuloksia tekstikehotteen toivoman sisällön toimittamisen suhteen. Uusi korkean tason ratkaisu tekee kuitenkin kaiken eron.

Generatiivisilla videojärjestelmillä on usein vaikeuksia tehdä todella luovia tai villejä videoita, eivätkä ne usein vastaa käyttäjien tekstikehotteiden odotuksia.

Osa syystä tähän on kietoutuminen – se, että visio-/kielimallien on tehtävä kompromisseja lähdedatan koulutusajan suhteen. Liian vähän koulutusta ja käsitteet ovat joustavia, mutta eivät täysin muodostuneita – liian vähän koulutusta ja käsitteet ovat tarkkoja, mutta eivät enää riittävän joustavia sisällytettäväksi uusiin yhdistelmiin.

Voit saada idean alla olevasta videosta. Vasemmalla on eräänlainen puolitiehen vedetty kompromissi, jonka monet tekoälyjärjestelmät tarjoavat vastauksena vaativaan kehotteeseen (kehote on videon yläosassa kaikissa neljässä esimerkissä), jossa pyydetään elementtien rinnakkaisuutta, joka on liian fantastinen ollakseen todellinen harjoitusesimerkki. Oikealla on tekoälyn tuloste, joka pysyy kehotteessa paljon paremmin:

Toista (ei ääntä). Oikealla näemme 'faktoroitu' WAN 2.2:n todella toimivan kehotteiden mukaisesti, verrattuna vasemmalla olevaan epämääräiseen 'vanilla' WAN 2.2:n tulkintaan. Katso lähdetiedostoista parempi resoluutio ja paljon muita esimerkkejä, vaikka tässä nähtyjä kuratoituja versioita ei ole olemassa projektisivustolla ja ne on koottu tätä artikkelia varten. Lähde

No, vaikka meidän on annettava anteeksi taputtavan ankan ihmiskädet (!), on selvää, että oikeanpuoleiset esimerkit noudattavat alkuperäistä tekstikehotetta paljon paremmin kuin vasemmanpuoleiset.

Mielenkiintoista kyllä, molemmat esitellyt arkkitehtuurit ovat pohjimmiltaan sama arkkitehtuuri – suosittu ja erittäin kyvykäs Wan 2.2, kiinalainen julkaisu, joka on saavuttanut merkittävää jalansijaa avoimen lähdekoodin ja harrastajien yhteisöissä tänä vuonna.

Ero on siinä, että toinen generatiivinen putkilinja on tekijöihin jaettu, mikä tässä tapauksessa tarkoittaa, että videon ensimmäisen (alku)ruudun uudelleentulkintaan on käytetty laajaa kielimallia (LLM), jotta järjestelmän on paljon helpompi toimittaa käyttäjän pyytämä.

Tämä 'visuaalinen ankkurointi' tarkoittaa LLM-parannetusta kehotteesta luodun kuvan syöttämistä generatiiviseen prosessiin 'aloituskehyksenä' ja a:n käyttöä. LoRA tulkintamalli, joka auttaa integroimaan 'tunkeilija'-ruudun videonluontiprosessiin.

Tulokset ovat tarkkuuden suhteen varsin huomattavia, erityisesti ratkaisulle, joka vaikuttaa melko elegantilta:

Toista (ei ääntä). Lisää esimerkkejä 'faktoroitujen' videoiden generoinnista, jotka todella pitävät kiinni käsikirjoituksesta. Katso lähdetiedostoista parempi resoluutio ja paljon muita esimerkkejä, vaikka tässä nähtyjä kuratoituja versioita ei ole olemassa projektisivustolla ja ne on koottu tätä artikkelia varten.

Tämä ratkaisu on seuraavanlainen: uusi paperi Faktorisoitu videon generointi: Kohtauksen rakentamisen ja ajallisen synteesin irrottaminen tekstistä videoon -diffuusiomalleissaja sen mukana tuleva videopainotteinen hankkeen verkkosivuilla.

Vaikka monet nykyiset järjestelmät pyrkivät parantamaan tarkkuutta käyttämällä kielimalleja epämääräisen tai alimitoitettuun tekstiin, uusi tutkimus väittää, että tämä strategia johtaa edelleen epäonnistumiseen, kun mallin sisäisen kohtauksen esitys on virheellinen.

Vaikka kehote olisi kirjoitettu yksityiskohtaisesti uudelleen, tekstistä videoksi -mallit usein sommittavat avainelementtejä väärin tai luovat yhteensopimattomia alkutiloja, jotka rikkovat animaation logiikan. Niin kauan kuin ensimmäinen ruutu ei vastaa kehotteen kuvaamaa, tuloksena olevaa videota ei voida palauttaa, olipa liikemalli kuinka hyvä tahansa.

Lehdessä lukee*:

'[Tekstistä videoksi] -mallit tuottavat usein jakauman suhteen siirtyneitä ruutuja, mutta saavuttavat silti [arviointipisteet], jotka ovat verrattavissa I2V-malleihin, mikä osoittaa, että niiden liikemallinnus pysyy kohtuullisen luonnollisena, vaikka kohtauksen tarkkuus olisi suhteellisen heikko.

'[Kuvasta videoon] -mallit osoittavat täydentävää käyttäytymistä, vahvoja [arviointipisteitä] tarkoista alkukohtauksista ja heikompaa ajallista koherenssia, kun taas I2V+teksti tasapainottaa molempia näkökohtia.

"Tämä kontrasti viittaa siihen, että rakenteellinen epäsuhta nykyisissä T2V-malleissakohtauksen maadoitus ja ajallinen synteesi hyötyvät erillisistä induktiivisista vinoumista, mutta olemassa olevat arkkitehtuurit pyrkivät oppimaan molemmat samanaikaisesti yhden mallin sisällä.

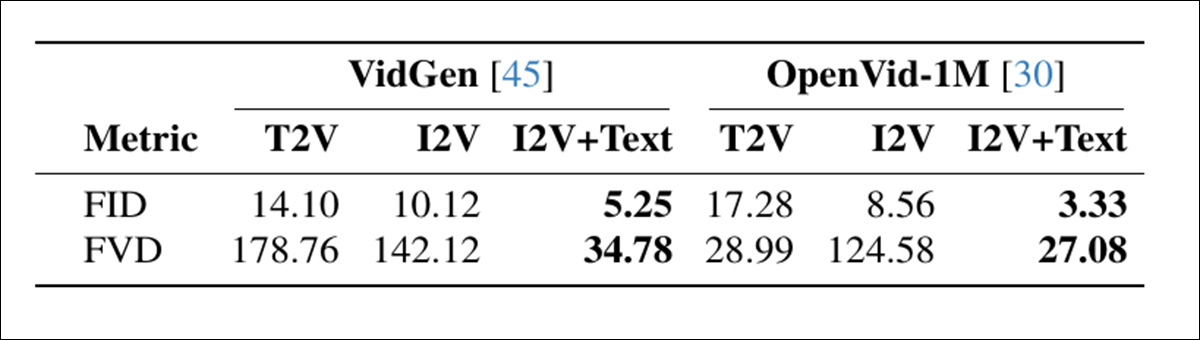

Sukupolvimoodien diagnostinen vertailu osoitti, että mallit, joissa ei ollut eksplisiittistä kohtauksen ankkurointia, pärjäsivät hyvin liikkeen osalta, mutta usein tinkivät kohtauksen asettelusta, kun taas kuvaan perustuvat lähestymistavat osoittivat päinvastaista kaavaa:

Kahden tietojoukon videonluontitilojen vertailu osoittaa, että I2V+text saavuttaa parhaan kuvanlaadun (FID) ja ajallisen koherenssin (FVD), mikä korostaa kohtauksen rakentamisen ja liikkeen erottamisen etuja. Lähde

Nämä löydökset viittaavat rakenteelliseen virheeseen, jossa nykyiset mallit yrittävät oppia sekä kohtauksen asettelun että animaation yhdellä kertaa, vaikka nämä kaksi tehtävää vaativat erilaisia taitoja. induktiivinen ennakkoluuloja ne on parempi käsitellä erikseen.

Ehkä mielenkiintoisinta on, että tätä "temppua" voidaan mahdollisesti soveltaa paikallisiin asennuksiin malleissa, kuten Wan 2.1 ja 2.2, ja vastaavissa videon diffuusiomalleissa, kuten Hunyuan videoAnekdoottisesti harrastelijatuottajien tuotoksen laatua verrattaessa kaupallisiin generatiivisiin portaaleihin, kuten Klingiin ja Runwayhin, useimmat suuret API-tarjoajat parantavat avoimen lähdekoodin tarjouksiaan, kuten WAN-verkkoja LoRA-rajapinnoilla, ja – näyttää siltä – käyttävät uudessa artikkelissa nähtyjä temppuja. Siksi tämä lähestymistapa voisi olla tapa kuroa umpeen eroa FOSS-osallistujille.

Menetelmälle tehdyt testit osoittavat, että tämä yksinkertainen ja modulaarinen lähestymistapa tarjoaa uuden huipputeknologian T2V-CompBench-vertailuarvo...parantaa merkittävästi kaikkia testattuja malleja. Kirjoittajat toteavat lopuksi, että vaikka heidän järjestelmänsä parantaa radikaalisti tarkkuutta, se ei käsittele (eikä sitä ole suunniteltu käsittelemään) identiteetin ajautuminen, tällä hetkellä generatiivisen tekoälytutkimuksen vitsaus.

Uusi paperi on peräisin neljältä Ecole Polytechnique Fédérale de Lausannen (EPFL) tutkijalta Sveitsistä.

Menetelmä ja tiedot

Uuden tekniikan keskeinen väite on, että tekstistä videoon (T2V) -diffuusiomallit on "ankkuroitava" aloituskehyksiin, jotka todella sopivat haluttuun tekstikehotteeseen.

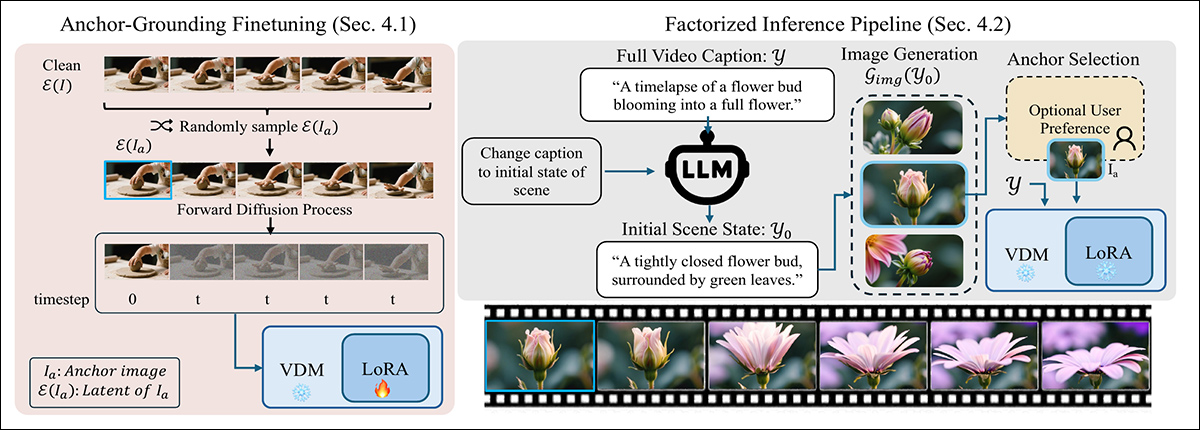

Jotta malli noudattaisi lähtökehystä, uusi menetelmä häiritsee standardi diffuusioprosessi ruiskuttamalla puhdasta piilevä ankkurikuvasta aikasaskelessa nolla, korvaamalla yhden tavallisista kohinaisista syötteistä. Tämä epätavallinen syöte hämmentää mallia aluksi, mutta LoRA:lla on minimaalinen hienosäätö, se oppii käsittelemään injektoitua kehystä kiinteänä visuaalisena ankkurina sen sijaan, että se olisi osa kohinareittiä:

Kaksivaiheinen menetelmä tekstistä videoksi -generoinnin maadoittamiseksi visuaalisella ankkurilla: Vasemmalla mallia hienosäädetään kevyen LoRA:n avulla, jolloin injektoitu puhdas latentti käsitellään kiinteänä kohtausrajoitteena. Oikealla kehote jaetaan ensimmäisen ruudun kuvatekstiksi, jota käytetään videota ohjaavan ankkurikuvan luomiseen.

Päättelyvaiheessa metodi kirjoittaa kehotteen uudelleen kuvaamaan vain ensimmäinen kehys, käyttäen LLM:ää uskottavan alkutilanteen poimimiseen keskittyen asetteluun ja ulkonäköön.

Tämä uudelleenkirjoitettu kehote välitetään kuvageneraattorille, joka tuottaa ankkurikehyksen (jota käyttäjä voi halutessaan tarkentaa). Valittu kehys koodataan latenttikuvaksi ja ruiskutetaan diffuusioprosessiin korvaamalla ensimmäinen aika-askel, jolloin malli voi luoda loput videosta. pysyen samalla ankkuroituna alkuperäiseen kohtaukseen – prosessi, joka toimii ilman muutoksia taustalla olevaan arkkitehtuuriin.

Prosessia testattiin luomalla LoRA-objekteja Wan2.2-14B, Wan2.1-1Bja CogVideo1.5-5BLoRA-koulutus suoritettiin sijoitus 256:sta, 5000 satunnaisesti otetusta videoleikkeestä UltraVideo kokoelma.

Harjoittelu kesti 6000 askelta ja vaati 48 GPU-tuntia† Wan-1B:lle ja CogVideo-5B:lle ja 96 GPU-tuntia Wan-14B:lle. Kirjoittajat huomauttavat, että Wan-5B tukee natiivisti vain teksti - ja teksti-kuva -muokkausta (jotka tässä tapauksessa on siirretty vanhempiin kehyksiin), eikä siksi vaatinut hienosäätöä.

Testit

Prosessille tehdyissä kokeissa kutakin tekstikehotetta jalostettiin aluksi käyttämällä Qwen2.5-7B-Ohje, joka käytti tulosta luodakseen yksityiskohtaisen 'siemenkuva'-kuvatekstin, joka sisälsi kuvauksen koko kohtauksesta. Tämä välitettiin sitten palvelimelle QwenImage, jonka tehtävänä oli luoda diffuusioprosessiin lisättävä 'taikakehys'.

Järjestelmän arvioinnissa käytettyihin vertailuarvoihin kuuluivat edellä mainittu T2V-CompBench, jolla testattiin sommittelun ymmärtämistä pisteyttämällä, kuinka hyvin mallit säilyttivät objektit, ominaisuudet ja toiminnot yhtenäisessä kohtauksessa; ja VBench 2.0, laajemman päättelyn ja johdonmukaisuuden arvioimiseksi 18 mittarin osalta, jotka on ryhmitelty luovuus, maalaisjärkinen päättely, ohjattavuus, ihmisen uskollisuusja fysiikka:

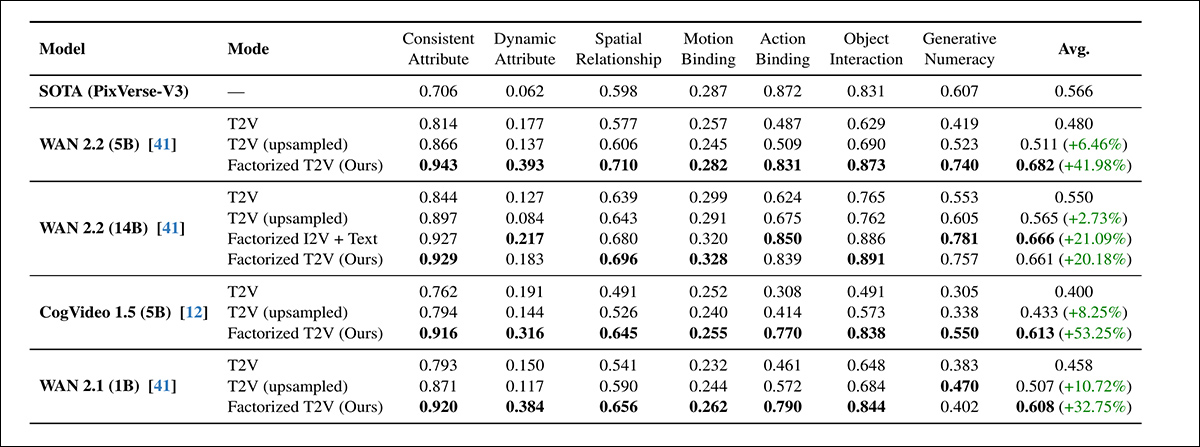

Kaikissa seitsemässä T2V-CompBenchin arviointikategoriassa faktorisoitu T2V-menetelmä ylitti sekä standardin että ylösnäytteistetyt T2V-perustasot jokaisessa testatussa mallissa, ja parannukset olivat jopa 53.25 %. Korkeimman pistemäärän saaneet variantit vastasivat usein PixVerse-V3:n omaa vertailuarvoa tai ylittivät sen.

Tämän ensimmäisen testikierroksen osalta kirjoittajat toteavat*:

Kaikissa malleissa ankkurikuvan lisääminen parantaa johdonmukaisesti sommittelun suorituskykyä. Kaikki pienemmät faktorisoidut mallit (CogVideo 5B, Wan 5B ja Wan 1B) suoriutuvat paremmin kuin suurempi Wan 14B T2V -malli.

"Faktoroitu Wan 5B -mallimme suoriutuu myös kaupallisesta PixVerse-V3-perusmallista paremmin, joka on vertailun parhaiten raportoitu malli. Tämä osoittaa, että visuaalinen maadoitus parantaa merkittävästi kohtausten ja toiminnan ymmärtämistä jopa pienikokoisemmissa malleissa.

”Kussakin malliperheessä faktorisoitu versio suoriutuu alkuperäisestä mallista paremmin. Merkittävää on, että kevyt, ankkuriin maadoitettu LoRA WAN 14B:ssä saavuttaa suorituskyvyn, joka on verrattavissa sen esikoulutettuun I2V 14B -varianttiin (0.661 vs. 0.666), vaikka se ei vaadikaan täyttä uudelleenkoulutusta.”

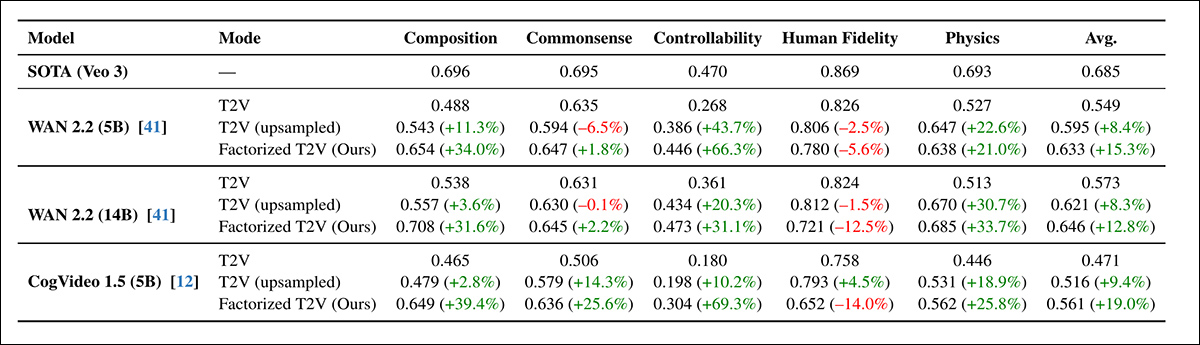

Seuraavaksi oli vuorossa VBench2.0-kierros:

Faktorisoitu T2V-lähestymistapa paransi johdonmukaisesti VBench 2.0:n suorituskykyä sommittelun, maalaisjärjen mukaisen päättelyn, hallittavuuden ja fysiikan osalta, ja jotkut parannukset ylittivät 60 % – vaikka ihmisen havaitseman tarkkuuden ei havaittu ylittävänkään Veo 3:n omaa perustasoa.

Kaikissa arkkitehtuureissa faktorisoitu lähestymistapa paransi pisteitä kaikissa VBench-kategorioissa paitsi ihmisen uskollisuus, joka laski hieman jopa nopeasta ylösotannasta huolimatta. WAN 5B suoriutui paremmin kuin suurempi WAN 14B, mikä vahvisti aiempia T2V-CompBench-tuloksia, joiden mukaan visuaalinen maadoitus vaikutti enemmän kuin mittakaava.

Vaikka VBenchillä saavutetut parannukset olivat johdonmukaisia, ne olivat pienempiä kuin T2V-CompBenchillä havaitut, ja kirjoittajat pitävät tätä VBenchin tiukemman binäärisen pisteytysjärjestelmän ansioksi.

Laadullisia testejä varten artikkelissa on staattisia kuvia, mutta viittaamme lukijaan tässä artikkelissa esitettyihin komposiittivideoihin selkeämmän kuvan saamiseksi. Huomionarvoista on, että lähdevideoita on enemmän ja ne ovat monipuolisempia ja niillä on suurempi resoluutio ja yksityiskohdat. Löydä ne. tätäLaadullisten tulosten osalta artikkelissa todetaan:

"Ankkuroiduissa videoissa kohtausten sommittelu on johdonmukaisesti tarkempaa, objektin ja attribuutin välillä on vahvempi yhteys ja ajallinen eteneminen on selkeämpää."

Faktorisoitu menetelmä pysyi vakaana, vaikka diffuusioaskeleiden määrä vähennettiin 50:stä 15:een, eikä suorituskyky heikkene juurikaan T2V-CompBench-testissä. Sitä vastoin sekä tekstipohjaiset että ylösnäytteistetyt lähtötasot heikkenivät jyrkästi samoissa olosuhteissa.

Vaikka vaiheiden vähentäminen voisi teoriassa kolminkertaistaa nopeuden, koko generointiprosessi nopeutui käytännössä vain 2.1 kertaa ankkurikuvien generoinnin kiinteiden kustannusten vuoksi. Tulokset kuitenkin osoittivat, että ankkurointi paitsi paransi näytteen laatua myös auttoi vakauttamaan diffuusioprosessia, tukien nopeampaa ja tehokkaampaa generointia tarkkuuden heikkenemättä.

Projektin verkkosivusto tarjoaa esimerkkejä ylöspäin otettujen ja uusien metodien luomisesta, joista tarjoamme tässä muutamia (pienemmän resoluution) muokattuja esimerkkejä:

Toista (ei ääntä). Ylösnäytteistetyt lähtölähteet vs. kirjoittajien faktorisoitu lähestymistapa.

Kirjoittajat päättelevät:

Tuloksemme viittaavat siihen, että parempi maadoitus voi olla yhtä tärkeää kuin pelkkä kapasiteetin kasvu. Viimeaikaiset edistysaskeleet T2V-diffuusiossa ovat perustuneet vahvasti mallin koon ja harjoitusdatan kasvattamiseen, mutta jopa suurilla malleilla on usein vaikeuksia päätellä johdonmukainen alkukohtaus pelkästään tekstistä.

Tämä on ristiriidassa kuvan diffuusion kanssa, jossa skaalaus on suhteellisen suoraviivaista; videomalleissa jokaisen arkkitehtuurisen parannuksen on toimittava ylimääräisen ajallisen ulottuvuuden yli, mikä tekee skaalauksesta huomattavasti resursseja vaativampaa.

"Tuloksemme osoittavat, että parannettu maadoitus voi täydentää mittakaavaa ratkaisemalla toisen pullonkaulan: oikean kohtauksen luomisen ennen liikesynteesin alkamista."

"Yhdistämällä videon generoinnin kohtauksen sommitteluun ja ajalliseen mallintamiseen lievennämme useita yleisiä vikaantumistyyppejä ilman, että vaaditaan huomattavasti suurempia malleja. Pidämme tätä täydentävänä suunnitteluperiaatteena, joka voi ohjata tulevia arkkitehtuureja kohti luotettavampaa ja jäsennellympää videosynteesiä."

Yhteenveto

Vaikka kietoutumisen ongelmat ovat hyvin todellisia ja saattavat vaatia erityisiä ratkaisuja (kuten parannettuja kuratointi- ja jakauma-arviointeja ennen koulutusta), on ollut silmiä avaavaa nähdä, kuinka faktorointi "irrottaa" useita itsepäisiä ja "jumissa" olevia konseptikehotteiden orkestraatioita paljon tarkemmiksi renderöinneiksi – vain kohtuullisella LoRA-ehdollistamiskerroksella ja huomattavasti parannetun aloitus-/siemenkuvan avulla.

Paikallisten harrastajien päätelmien ja kaupallisten ratkaisujen välinen resurssiero ei ehkä olekaan niin suuri kuin oletetaan, koska lähes kaikki tarjoajat pyrkivät järkeistämään huomattavaa GPU-resurssikulutustaan kuluttajille.

Anekdoottisesti hyvin suuri osa nykyisistä generatiivisen videon tarjoajista näyttää käyttävän kiinalaisten FOSS-mallien brändättyjä ja yleisesti ottaen "viritettyjä" versioita. Näiden "välikäteisjärjestelmien" tärkein "etu" näyttää olevan se, että ne ovat vaivautuneet kouluttamaan LoRA-objekteja tai muuten – suuremmilla kustannuksilla ja hieman suuremmalla palkkiolla – suorittaneet mallin painojen täydellisen hienosäädön.††.

Tällaiset näkemykset voisivat auttaa kuromaan umpeen tätä kuilua entisestään julkaisuympäristössä, jossa kiinalaiset näyttävät olevan päättäneet (ei välttämättä altruistisista tai idealistisista syistä) demokratisoida tekoälyn sukupolvea, kun taas länsimaiset liike-elämän intressit kenties mieluummin näkisivät, että mallin koon kasvattaminen ja sääntely lopulta sulkisivat kaikki todella hyvät mallit API-rajapintojen ja useiden sisällönsuodatuskerrosten taakse.

* Kirjoittajien painotukset, eivät minun.

† Artikkelissa ei täsmennetä, mikä näytönohjain valittiin tai kuinka montaa niitä käytettiin.

†† Vaikka LoRA-reitti on todennäköisempi sekä taloudellisen helppokäyttöisyyden että täydellisten painojen vuoksi kvantisoitu painoja ei ole aina saatavilla.

Julkaistu ensimmäisen kerran perjantaina 19