Η γωνία του Άντερσον

Το βίντεο με τεχνητή νοημοσύνη τελειοποιεί τη selfie με τη γάτα

Οι γεννήτριες βίντεο με τεχνητή νοημοσύνη συχνά δίνουν αποτελέσματα που είναι κοντά, αλλά καθόλου αδιαμφισβήτητα, όσον αφορά την απόδοση αυτού που ήθελε η προτροπή κειμένου σας. Αλλά μια νέα επιδιόρθωση υψηλού επιπέδου κάνει όλη τη διαφορά.

Τα συστήματα δημιουργίας βίντεο με γενετική τροποποίηση συχνά δυσκολεύονται να δημιουργήσουν βίντεο που είναι πραγματικά δημιουργικά ή πρωτότυπα και συχνά δεν ανταποκρίνονται στις προσδοκίες των μηνυμάτων κειμένου των χρηστών.

Μέρος του λόγου για αυτό είναι μπλέξιμο – το γεγονός ότι τα μοντέλα όρασης/γλώσσας πρέπει να κάνουν συμβιβασμούς ως προς το χρονικό διάστημα που θα εκπαιδεύονται στα δεδομένα πηγής τους. Πολύ λίγη εκπαίδευση και οι έννοιες είναι ευέλικτες, αλλά όχι πλήρως διαμορφωμένες – πάρα πολλή εκπαίδευση και οι έννοιες είναι ακριβείς, αλλά όχι πλέον αρκετά ευέλικτες για να ενσωματωθούν σε νέους συνδυασμούς.

Μπορείτε να πάρετε την ιδέα από το ενσωματωμένο βίντεο παρακάτω. Στα αριστερά βρίσκεται το είδος του συμβιβασμού που προσφέρουν πολλά συστήματα Τεχνητής Νοημοσύνης ως απάντηση σε μια απαιτητική προτροπή (η προτροπή βρίσκεται στην κορυφή του βίντεο και στα τέσσερα παραδείγματα) που ζητά κάποια αντιπαράθεση στοιχείων που είναι πολύ φανταστική για να αποτελέσει ένα πραγματικό παράδειγμα εκπαίδευσης. Στα δεξιά, βρίσκεται μια έξοδος Τεχνητής Νοημοσύνης που προσκολλάται στην προτροπή πολύ καλύτερα:

Κάντε κλικ για αναπαραγωγή (χωρίς ήχο). Στα δεξιά, βλέπουμε το «παραγοντικό» WAN 2.2 να ανταποκρίνεται στις προτροπές, σε σύγκριση με τις αόριστες ερμηνείες του «βανίλια» Wan 2.2, στα αριστερά. Ανατρέξτε στα αρχεία βίντεο πηγής για καλύτερη ανάλυση και πολλά άλλα παραδείγματα, αν και οι επιμελημένες εκδόσεις που εμφανίζονται εδώ δεν υπάρχουν στον ιστότοπο του έργου και συγκεντρώθηκαν για αυτό το άρθρο. Πηγή

Λοιπόν, αν και πρέπει να συγχωρήσουμε τα ανθρώπινα χέρια της πάπιας που χειροκροτεί (!), είναι σαφές ότι τα παραδείγματα στα δεξιά ακολουθούν το αρχικό κείμενο-προτροπή πολύ καλύτερα από αυτά στα αριστερά.

Είναι ενδιαφέρον ότι και οι δύο αρχιτεκτονικές που παρουσιάζονται είναι ουσιαστικά οι ίδιο αρχιτεκτονική – η δημοφιλής και πολύ ικανή Wan 2.2, μια κινεζική έκδοση που έχει κερδίσει σημαντικό έδαφος στις κοινότητες ανοιχτού κώδικα και χομπίστων φέτος.

Η διαφορά είναι ότι ο δεύτερος παραγωγικός αγωγός είναι παραγοντοποιημένος, το οποίο σε αυτήν την περίπτωση σημαίνει ότι έχει χρησιμοποιηθεί ένα μεγάλο γλωσσικό μοντέλο (LLM) για την επανερμηνεία του πρώτου (αρχικού) καρέ του βίντεο, έτσι ώστε να είναι πολύ πιο εύκολο για το σύστημα να παραδώσει αυτό που ζητά ο χρήστης.

Αυτή η «οπτική αγκύρωση» περιλαμβάνει την εισαγωγή μιας εικόνας που δημιουργήθηκε από αυτήν την προτροπή ενισχυμένη με LLM στον παραγωγικό αγωγό ως «πλαίσιο έναρξης» και τη χρήση ενός LoRA ερμηνευτικό μοντέλο για να βοηθήσει στην ενσωμάτωση του πλαισίου του «εισβολέα» στη διαδικασία δημιουργίας βίντεο.

Τα αποτελέσματα, όσον αφορά την άμεση πιστότητα, είναι αρκετά αξιοσημείωτα, ειδικά για μια λύση που φαίνεται μάλλον κομψή:

Κάντε κλικ για αναπαραγωγή (χωρίς ήχο). Περαιτέρω παραδείγματα «παραγοντικών» γενεών βίντεο που τηρούν πιστά το σενάριο. Ανατρέξτε στα αρχεία βίντεο πηγής για καλύτερη ανάλυση και πολλά άλλα παραδείγματα, αν και οι επιμελημένες εκδόσεις που εμφανίζονται εδώ δεν υπάρχουν στον ιστότοπο του έργου και συγκεντρώθηκαν για αυτό το άρθρο.

Αυτή η λύση έρχεται με τη μορφή του νέο χαρτί Παραγοντική Δημιουργία Βίντεο: Αποσύνδεση Κατασκευής Σκηνής και Χρονικής Σύνθεσης σε Μοντέλα Διάχυσης Κειμένου σε Βίντεο, και το γεμάτο βίντεο συνοδευτικό του ιστοσελίδα του έργου.

Ενώ πολλά τρέχοντα συστήματα προσπαθούν να ενισχύσουν την άμεση ακρίβεια χρησιμοποιώντας γλωσσικά μοντέλα για να ξαναγράψουν ασαφές ή υποπροσδιορισμένο κείμενο, η νέα εργασία υποστηρίζει ότι αυτή η στρατηγική εξακολουθεί να οδηγεί σε αποτυχία όταν το μοντέλο... εσωτερική αναπαράσταση σκηνής είναι ελαττωματικό.

Ακόμα και με μια λεπτομερή ξαναγραμμένη προτροπή, τα μοντέλα μετατροπής κειμένου σε βίντεο συχνά δεν συνθέτουν σωστά τα βασικά στοιχεία ή δημιουργούν ασύμβατες αρχικές καταστάσεις που διαταράσσουν τη λογική της κινούμενης εικόνας. Εφόσον το πρώτο καρέ δεν αντικατοπτρίζει αυτό που περιγράφει η προτροπή, το βίντεο που προκύπτει δεν μπορεί να ανακάμψει, ανεξάρτητα από το πόσο καλό είναι το μοντέλο κίνησης.

Η εφημερίδα αναφέρει*:

Τα μοντέλα [Text-to-video] συχνά παράγουν καρέ με κατανεμημένη μετατόπιση, αλλά εξακολουθούν να επιτυγχάνουν [βαθμολογίες αξιολόγησης] συγκρίσιμες με τα μοντέλα I2V, γεγονός που υποδηλώνει ότι η μοντελοποίηση της κίνησής τους παραμένει αρκετά φυσική ακόμη και όταν η πιστότητα της σκηνής είναι σχετικά χαμηλή.

Τα μοντέλα [Εικόνα-σε-Βίντεο] παρουσιάζουν συμπληρωματική συμπεριφορά, ισχυρές [βαθμολογίες αξιολόγησης] από ακριβείς αρχικές σκηνές και ασθενέστερη χρονική συνοχή, ενώ το I2V+κείμενο εξισορροπεί και τις δύο πτυχές.

«Αυτή η αντίθεση υποδηλώνει ένα δομική αναντιστοιχία στα τρέχοντα μοντέλα T2VΗ γείωση σκηνής και η χρονική σύνθεση επωφελούνται από διακριτές επαγωγικές προκαταλήψεις, ωστόσο οι υπάρχουσες αρχιτεκτονικές προσπαθούν να μάθουν και τις δύο ταυτόχρονα μέσα σε ένα μόνο μοντέλο.

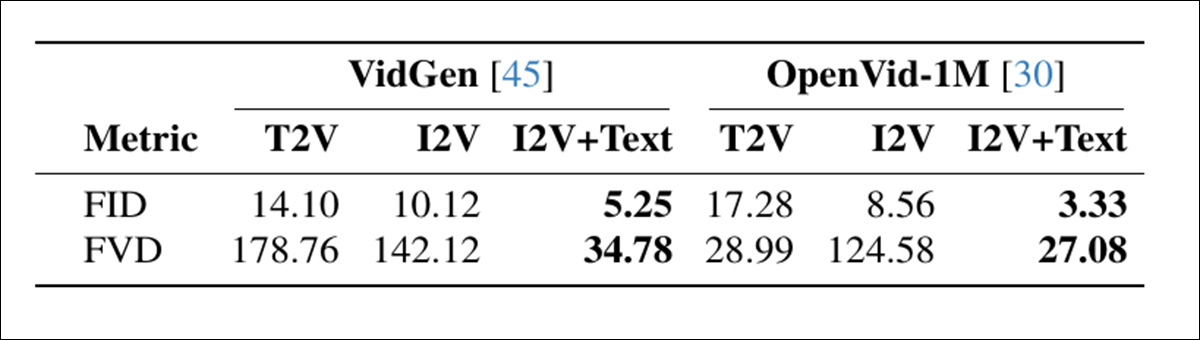

Μια διαγνωστική σύγκριση των τρόπων δημιουργίας διαπίστωσε ότι τα μοντέλα χωρίς σαφή αγκύρωση σκηνής βαθμολογήθηκαν καλά στην κίνηση, αλλά συχνά συμβιβάζονταν στη διάταξη της σκηνής, ενώ οι προσεγγίσεις που εξαρτώνται από την εικόνα έδειξαν το αντίθετο μοτίβο:

Σύγκριση των τρόπων δημιουργίας βίντεο σε δύο σύνολα δεδομένων, που δείχνει ότι το I2V+κείμενο επιτυγχάνει την καλύτερη ποιότητα καρέ (FID) και χρονική συνοχή (FVD), υπογραμμίζοντας το όφελος του διαχωρισμού της κατασκευής σκηνής από την κίνηση. Πηγή

Αυτά τα ευρήματα υποδεικνύουν ένα δομικό ελάττωμα όπου τα τρέχοντα μοντέλα προσπαθούν να μάθουν τόσο τη διάταξη της σκηνής όσο και την κίνηση ταυτόχρονα, παρόλο που οι δύο εργασίες απαιτούν διαφορετικά είδη επαγωγική προκατάληψηκαι αντιμετωπίζονται καλύτερα ξεχωριστά.

Ίσως το μεγαλύτερο ενδιαφέρον είναι ότι αυτό το «κόλπο» μπορεί ενδεχομένως να εφαρμοστεί σε τοπικές εγκαταστάσεις μοντέλων όπως τα Wan 2.1 και 2.2, και παρόμοια μοντέλα διάχυσης βίντεο όπως το Βίντεο HunyuanΑνεκδοτολογικά, συγκρίνοντας την ποιότητα της παραγωγής για χομπίστες με εμπορικές πύλες δημιουργίας όπως οι Kling και Runway, οι περισσότεροι από τους μεγάλους παρόχους API βελτιώνουν τις προσφορές ανοιχτού κώδικα όπως το WAN με LoRAs και - όπως φαίνεται - με κόλπα του είδους που παρατηρούνται στη νέα εργασία. Επομένως, αυτή η συγκεκριμένη προσέγγιση θα μπορούσε να αντιπροσωπεύει μια κάλυψη του χαμένου εδάφους για την ομάδα FOSS.

Οι δοκιμές που διεξήχθησαν για τη μέθοδο δείχνουν ότι αυτή η απλή και αρθρωτή προσέγγιση προσφέρει μια νέα, σύγχρονη τεχνολογία. Συγκριτική αξιολόγηση T2V-CompBench, βελτιώνοντας σημαντικά όλα τα δοκιμασμένα μοντέλα. Οι συγγραφείς σημειώνουν συμπερασματικά ότι ενώ το σύστημά τους βελτιώνει ριζικά την πιστότητα, δεν αντιμετωπίζει (ούτε έχει σχεδιαστεί για να αντιμετωπίσει) μετατόπιση ταυτότητας, που αποτελεί επί του παρόντος την κατάρα της έρευνας για την παραγωγική τεχνητή νοημοσύνη.

Η νέα εργασία προέρχεται από τέσσερις ερευνητές της Ecole Polytechnique Fédérale de Lausanne (EPFL) στην Ελβετία.

Μέθοδος και Δεδομένα

Η κεντρική πρόταση της νέας τεχνικής είναι ότι τα μοντέλα διάχυσης κειμένου σε βίντεο (T2V) πρέπει να «αγκυροβοληθούν» σε αρχικά καρέ που ταιριάζουν πραγματικά στην επιθυμητή προτροπή κειμένου.

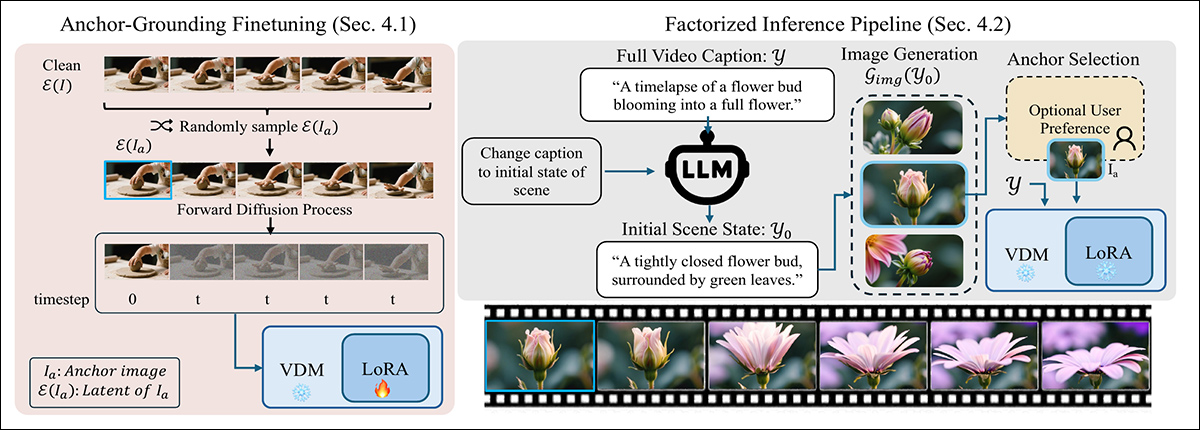

Για να διασφαλιστεί ότι το μοντέλο σέβεται το αρχικό πλαίσιο, η νέα μέθοδος διαταράσσει το τυπική διαδικασία διάχυσης με την έγχυση ενός καθαρού λανθάνουσα από την εικόνα αγκύρωσης στο χρονικό βήμα μηδέν, αντικαθιστώντας μία από τις συνήθεις θορυβώδεις εισόδους. Αυτή η άγνωστη είσοδος μπερδεύει το μοντέλο στην αρχή, αλλά με ελάχιστη LoRA τελειοποίηση, μαθαίνει να αντιμετωπίζει το εγχυμένο πλαίσιο ως μια σταθερή οπτική άγκυρα και όχι ως μέρος της τροχιάς θορύβου:

Μια μέθοδος δύο σταδίων για τη γείωση της δημιουργίας κειμένου σε βίντεο με μια οπτική άγκυρα: Αριστερά, το μοντέλο βελτιστοποιείται χρησιμοποιώντας ένα ελαφρύ LoRA για να αντιμετωπίσει ένα εγχυμένο καθαρό λανθάνον στοιχείο ως σταθερό περιορισμό σκηνής. Δεξιά, η προτροπή χωρίζεται σε μια λεζάντα πρώτου καρέ, η οποία χρησιμοποιείται για τη δημιουργία της εικόνας άγκυρας που καθοδηγεί το βίντεο.

Κατά την εξαγωγή συμπερασμάτων, η μέθοδος ξαναγράφει την προτροπή για να περιγράψει μόνο το πρώτο καρέ, χρησιμοποιώντας ένα LLM για την εξαγωγή μιας εύλογης αρχικής κατάστασης σκηνής με επίκεντρο τη διάταξη και την εμφάνιση.

Αυτή η ξαναγραμμένη προτροπή διαβιβάζεται σε μια γεννήτρια εικόνων για να παράγει ένα υποψήφιο πλαίσιο αγκύρωσης (το οποίο μπορεί προαιρετικά να βελτιωθεί από τον χρήστη). Το επιλεγμένο πλαίσιο κωδικοποιείται σε ένα λανθάνον πλαίσιο και εισάγεται στη διαδικασία διάχυσης αντικαθιστώντας το πρώτο χρονικό βήμα, επιτρέποντας στο μοντέλο να δημιουργήσει το υπόλοιπο βίντεο. ενώ παραμένει προσκολλημένος στην αρχική σκηνή – μια διαδικασία που λειτουργεί χωρίς να απαιτούνται αλλαγές στην υποκείμενη αρχιτεκτονική.

Η διαδικασία δοκιμάστηκε με τη δημιουργία LoRAs για Wan2.2-14B, Wan2.1-1B, να CogVideo1.5-5BΗ εκπαίδευση LoRA πραγματοποιήθηκε σε κατατάσσουν από 256, σε 5000 τυχαία επιλεγμένα αποσπάσματα από το Υπερβίντεο συλλογής.

Η εκπαίδευση διήρκεσε 6000 βήματα και απαιτούσε 48 ώρες GPU.† για Wan-1B και CogVideo-5B, και 96 ώρες GPU για Wan-14B. Οι συγγραφείς σημειώνουν ότι το Wan-5B υποστηρίζει εγγενώς την επεξεργασία μόνο κειμένου και κειμένου-εικόνας (η οποία σε αυτήν την περίπτωση έχει επιβληθεί στα παλαιότερα frameworks) και ως εκ τούτου δεν απαιτούσε καμία βελτίωση.

Δοκιμές

Στα πειράματα που εκτελέστηκαν για τη διαδικασία, κάθε μήνυμα κειμένου αρχικά βελτιστοποιήθηκε χρησιμοποιώντας Qwen2.5-7B-Instruct, το οποίο χρησιμοποίησε το αποτέλεσμα για να δημιουργήσει μια λεπτομερή λεζάντα «εικόνας εκκίνησης» που περιείχε μια περιγραφή ολόκληρης της σκηνής. Αυτή στη συνέχεια διαβιβάστηκε στο QwenImage, το οποίο είχε ως έργο τη δημιουργία του «μαγικού πλαισίου» που θα παρεμβαλλόταν στη διαδικασία διάχυσης.

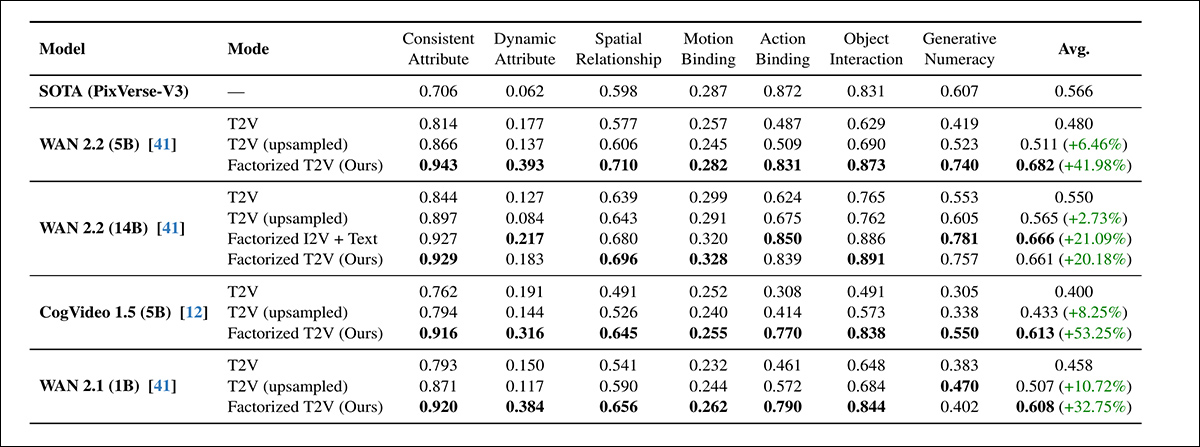

Τα κριτήρια αξιολόγησης που χρησιμοποιήθηκαν για την αξιολόγηση του συστήματος περιελάμβαναν το προαναφερθέν T2V-CompBench, για τον έλεγχο της κατανόησης της σύνθεσης, βαθμολογώντας πόσο καλά τα μοντέλα διατήρησαν αντικείμενα, χαρακτηριστικά και ενέργειες μέσα σε μια συνεκτική σκηνή· και VBench 2.0, για την αξιολόγηση ευρύτερης συλλογιστικής και συνέπειας σε 18 μετρήσεις, ομαδοποιημένες σε δημιουργικότητα, λογική σκέψη, χαλιναγώγηση, ανθρώπινη πιστότητα, να φυσική:

Και στις επτά κατηγορίες αξιολόγησης του T2V-CompBench, η παραγοντοποιημένη μέθοδος T2V ξεπέρασε τόσο τις τυπικές όσο και τις αναδειγματοληπτικές βασικές γραμμές T2V για κάθε μοντέλο που δοκιμάστηκε, με κέρδη που έφτασαν έως και 53.25%. Οι παραλλαγές με την υψηλότερη βαθμολογία συχνά αντιστοιχούσαν ή ξεπερνούσαν το ιδιόκτητο benchmark PixVerse-V3.

Σχετικά με αυτόν τον αρχικό γύρο δοκιμών, οι συγγραφείς δηλώνουν*:

«[Σε] όλα τα μοντέλα, η προσθήκη μιας εικόνας αγκύρωσης βελτιώνει σταθερά τις συνθετικές επιδόσεις. Όλα τα μικρότερα μοντέλα με παραγοντοποίηση (CogVideo 5B, Wan 5B και Wan 1B) έχουν καλύτερες επιδόσεις από το μεγαλύτερο μοντέλο Wan 14B T2V.»

»Το παραγοντοποιημένο Wan 5B μας ξεπερνά επίσης σε απόδοση το εμπορικό βασικό μοντέλο PixVerse-V3, το οποίο είναι το καλύτερα αναφερόμενο μοντέλο στο benchmark. Αυτό καταδεικνύει ότι η οπτική γείωση βελτιώνει σημαντικά την κατανόηση της σκηνής και της δράσης ακόμη και σε μοντέλα μικρότερης χωρητικότητας.

«Μέσα σε κάθε οικογένεια μοντέλων, η παραγοντοποιημένη έκδοση ξεπερνά σε απόδοση το αρχικό μοντέλο. Αξιοσημείωτο είναι ότι το ελαφρύ LoRA μας με αγκύρωση γείωσης σε WAN 14B φτάνει σε απόδοση συγκρίσιμη με την προ-εκπαιδευμένη παραλλαγή I2V 14B (0.661 έναντι 0.666), παρά το γεγονός ότι δεν απαιτείται πλήρης επανεκπαίδευση.»

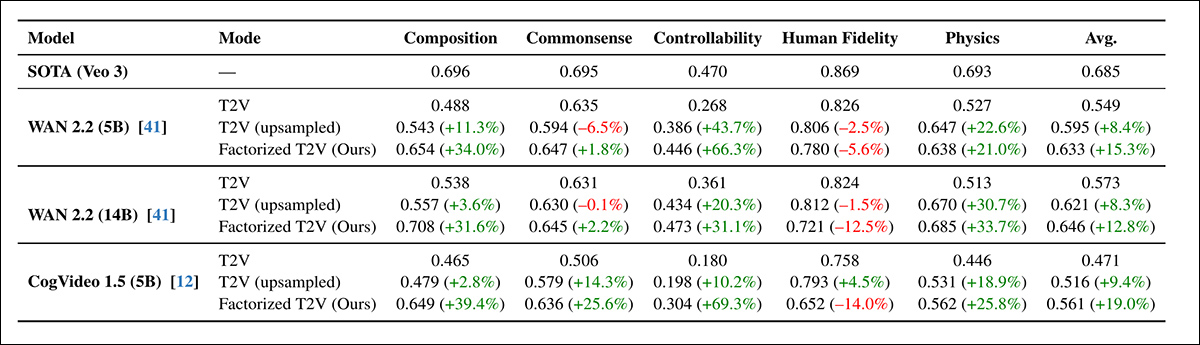

Στη συνέχεια ακολούθησε ο γύρος VBench2.0:

Η παραγοντοποιημένη προσέγγιση T2V βελτίωνε σταθερά την απόδοση του VBench 2.0 σε όλους τους τομείς της σύνθεσης, της λογικής, της ελεγξιμότητας και της φυσικής, με ορισμένα κέρδη να ξεπερνούν το 60% - αν και η ανθρώπινη πιστότητα παρέμεινε κάτω από την ιδιόκτητη βασική γραμμή του Veo 3.

Σε όλες τις αρχιτεκτονικές, η παραγοντική προσέγγιση αύξησε τις βαθμολογίες σε κάθε κατηγορία VBench εκτός από ανθρώπινη πιστότητα, η οποία μειώθηκε ελαφρώς ακόμη και με άμεση αναβάθμιση δειγματοληψίας. Το WAN 5B ξεπέρασε σε απόδοση το μεγαλύτερο WAN 14B, ενισχύοντας προηγούμενα αποτελέσματα του T2V-CompBench ότι η οπτική γείωση συνέβαλε περισσότερο από την κλίμακα.

Ενώ τα κέρδη στο VBench ήταν σταθερά, ήταν μικρότερα από αυτά που παρατηρήθηκαν στο T2V-CompBench και οι συγγραφείς το αποδίδουν στο αυστηρότερο καθεστώς δυαδικής βαθμολόγησης του VBench.

Για τις ποιοτικές δοκιμές, η εργασία παρέχει στατικές εικόνες, αλλά παραπέμπουμε τον αναγνώστη στα σύνθετα βίντεο που ενσωματώνονται σε αυτό το άρθρο, για μια πιο σαφή εικόνα, με την επιφύλαξη ότι τα βίντεο πηγής είναι πιο πολλά και ποικίλα, καθώς και μεγαλύτερης ανάλυσης και λεπτομέρειας. Βρείτε τα. εδώΌσον αφορά τα ποιοτικά αποτελέσματα, η εργασία αναφέρει:

«Τα αγκυρωμένα βίντεο παρουσιάζουν σταθερά ακριβέστερη σύνθεση σκηνής, ισχυρότερη σύνδεση αντικειμένου-χαρακτηριστικού και σαφέστερη χρονική εξέλιξη.»

Η παραγοντοποιημένη μέθοδος παρέμεινε σταθερή ακόμη και όταν ο αριθμός των βημάτων διάχυσης μειώθηκε από 50 σε 15, δείχνοντας σχεδόν καμία απώλεια απόδοσης στο T2V-CompBench. Αντίθετα, τόσο οι γραμμές βάσης μόνο με κείμενο όσο και οι γραμμές βάσης με αναδειγματοληψία υποβαθμίστηκαν απότομα υπό τις ίδιες συνθήκες.

Παρόλο που η μείωση των βημάτων θα μπορούσε θεωρητικά να τριπλασιάσει την ταχύτητα, η πλήρης παραγωγή έγινε στην πράξη μόνο 2.1 φορές ταχύτερη, λόγω του πάγιου κόστους από τη δημιουργία εικόνας αγκύρωσης. Ωστόσο, τα αποτελέσματα έδειξαν ότι η αγκύρωση όχι μόνο βελτίωσε την ποιότητα του δείγματος αλλά βοήθησε και στη σταθεροποίηση της διαδικασίας διάχυσης, υποστηρίζοντας ταχύτερη και πιο αποτελεσματική παραγωγή χωρίς απώλεια ακρίβειας.

Ο ιστότοπος του έργου παρέχει παραδείγματα αναδειγματοληπτικών και νέων γενεών μεθόδων, από τις οποίες προσφέρουμε μερικά επεξεργασμένα παραδείγματα (χαμηλότερης ανάλυσης) εδώ:

Κάντε κλικ για αναπαραγωγή (χωρίς ήχο). Αναβαθμισμένες αρχικές πηγές έναντι της παραγοντοποιημένης προσέγγισης των συγγραφέων.

Οι συντάκτες συμπεραίνουν:

«Τα αποτελέσματά μας υποδηλώνουν ότι η βελτιωμένη γείωση, και όχι μόνο η αυξημένη χωρητικότητα, μπορεί να είναι εξίσου σημαντική. Οι πρόσφατες εξελίξεις στη διάχυση T2V έχουν βασιστεί σε μεγάλο βαθμό στην αύξηση του μεγέθους του μοντέλου και των δεδομένων εκπαίδευσης, ωστόσο ακόμη και τα μεγάλα μοντέλα συχνά δυσκολεύονται να συμπεράνουν μια συνεκτική αρχική σκηνή μόνο από το κείμενο».

Αυτό έρχεται σε αντίθεση με τη διάχυση εικόνας, όπου η κλιμάκωση είναι σχετικά απλή. Στα μοντέλα βίντεο, κάθε αρχιτεκτονική βελτίωση πρέπει να λειτουργεί σε μια πρόσθετη χρονική διάσταση, καθιστώντας την κλιμάκωση σημαντικά πιο απαιτητική σε πόρους.

«Τα ευρήματά μας δείχνουν ότι η βελτιωμένη γείωση μπορεί να συμπληρώσει την κλίμακα αντιμετωπίζοντας ένα διαφορετικό σημείο συμφόρησης: τη δημιουργία της σωστής σκηνής πριν ξεκινήσει η σύνθεση κίνησης».

«Ενσωματώνοντας την παραγωγή βίντεο στη σύνθεση της σκηνής και στη χρονική μοντελοποίηση, μετριάσουμε αρκετές συνήθεις λειτουργίες αστοχίας χωρίς να απαιτούμε σημαντικά μεγαλύτερα μοντέλα. Θεωρούμε αυτό ως μια συμπληρωματική αρχή σχεδιασμού που μπορεί να καθοδηγήσει τις μελλοντικές αρχιτεκτονικές προς μια πιο αξιόπιστη και δομημένη σύνθεση βίντεο.»

Συμπέρασμα

Αν και τα προβλήματα της εμπλοκής είναι πολύ πραγματικά και μπορεί να απαιτούν εξειδικευμένες λύσεις (όπως βελτιωμένες αξιολογήσεις επιμέλειας και κατανομής πριν από την εκπαίδευση), ήταν αποκαλυπτικό να βλέπουμε την παραγοντοποίηση να «ξεκολλάει» αρκετές επίμονες και «κολλημένες» ενορχηστρώσεις εννοιών σε πολύ πιο ακριβείς αποδόσεις - με μόνο ένα μέτριο επίπεδο προετοιμασίας LoRA και την παρέμβαση μιας αξιοσημείωτα βελτιωμένης εικόνας έναρξης/αρχικού πυρήνα.

Το χάσμα στους πόρους μεταξύ της συμπερασματολογίας των τοπικών ερασιτεχνών και των εμπορικών λύσεων μπορεί να μην είναι τόσο τεράστιο όσο υποτίθεται, δεδομένου ότι σχεδόν όλοι οι πάροχοι επιδιώκουν να εξορθολογίσουν τη σημαντική δαπάνη πόρων GPU προς τους καταναλωτές.

Σύμφωνα με ανεκδοτολογικές πληροφορίες, ένας πολύ μεγάλος αριθμός της τρέχουσας γενιάς παρόχων δημιουργικού βίντεο φαίνεται να χρησιμοποιεί επώνυμες και γενικά «ενισχυμένες» εκδόσεις κινεζικών μοντέλων ΕΛ/ΛΑΚ. Το κύριο «εμπόδιο» που φαίνεται να έχουν αυτά τα συστήματα «μεσαζόντων» είναι ότι έχουν μπει στον κόπο να εκπαιδεύσουν LoRAs ή, διαφορετικά - με μεγαλύτερο κόστος και ελαφρώς μεγαλύτερη ανταμοιβή - να πραγματοποιήσουν μια πλήρη βελτίωση των βαρών των μοντέλων.††.

Τέτοιου είδους γνώσεις θα μπορούσαν να βοηθήσουν στην περαιτέρω κάλυψη αυτού του κενού, στο πλαίσιο μιας σκηνής κυκλοφορίας όπου οι Κινέζοι φαίνονται αποφασισμένοι (όχι απαραίτητα για αλτρουιστικούς ή ιδεαλιστικούς λόγους) να εκδημοκρατίσουν την Τεχνητή Νοημοσύνη γενιάς, ενώ τα δυτικά επιχειρηματικά συμφέροντα ίσως θα προτιμούσαν η αύξηση του μεγέθους των μοντέλων και των κανονισμών να κρύβει τελικά τυχόν πραγματικά καλά μοντέλα πίσω από API και πολλαπλά επίπεδα φίλτρων περιεχομένου.

* Τονίσεις των συγγραφέων, όχι δικές μου.

† Το έγγραφο δεν διευκρινίζει ποια GPU επιλέχθηκε ή πόσες χρησιμοποιήθηκαν.

†† Αν και η διαδρομή LoRA είναι πιο πιθανή, τόσο για οικονομική ευκολία χρήσης, όσο και επειδή τα πλήρη βάρη, αντί κβαντισμένη τα βάρη, δεν είναι πάντα διαθέσιμα.

Πρώτη δημοσίευση Παρασκευή, 19 Δεκεμβρίου 2025