Künstliche Intelligenz

Stability AI stellt Stable Audio 2.0 vor: Unterstützt Entwickler mit fortschrittlichem KI-generiertem Audio

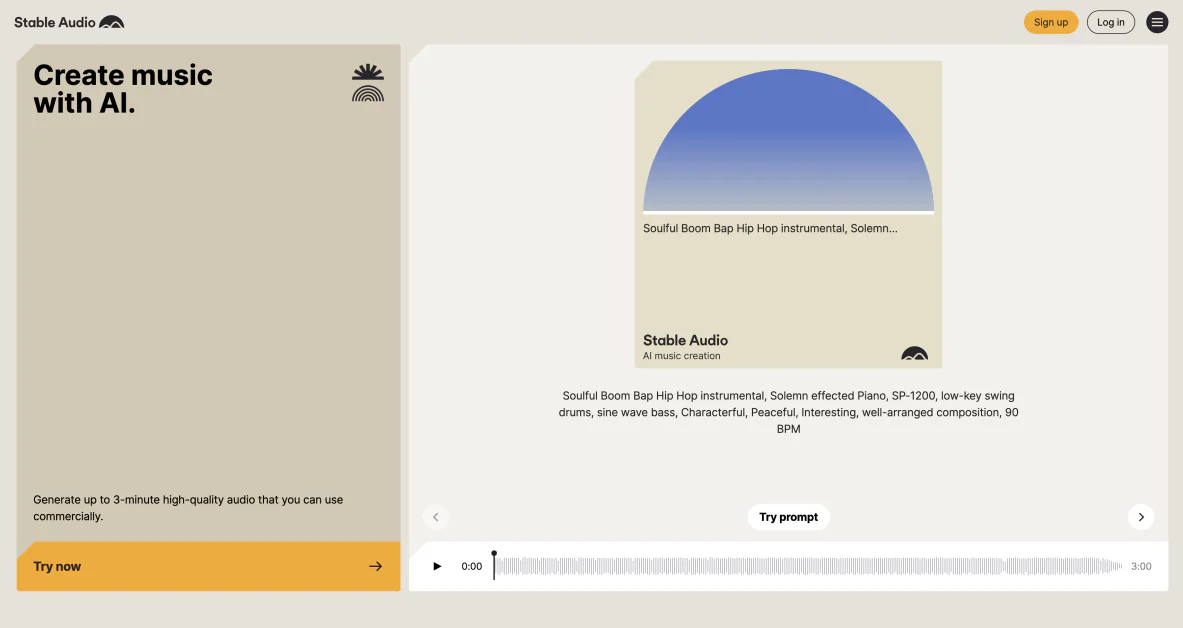

Stability AI hat mit der Veröffentlichung von erneut die Grenzen der Innovation verschoben Stabiles Audio 2.0. Dieses hochmoderne Modell baut auf dem Erfolg seines Vorgängers auf und führt eine Vielzahl bahnbrechender Funktionen ein, die versprechen, die Art und Weise, wie Künstler und Musiker Audioinhalte erstellen und bearbeiten, zu revolutionieren.

Stable Audio 2.0 stellt einen bedeutenden Meilenstein in der Entwicklung von KI-generiertem Audio dar und setzt einen neuen Standard für Qualität, Vielseitigkeit und kreatives Potenzial. Mit seiner Fähigkeit, Tracks in voller Länge zu generieren, Audio-Samples mithilfe von Eingabeaufforderungen in natürlicher Sprache umzuwandeln und eine breite Palette von Soundeffekten zu erzeugen, eröffnet dieses Modell eine Welt voller Möglichkeiten für Content-Ersteller in verschiedenen Branchen.

Da die Nachfrage nach innovativen Audiolösungen weiter wächst, ist das neueste Angebot von Stability AI bereit, ein unverzichtbares Werkzeug für Profis zu werden, die ihre kreative Leistung verbessern und ihren Arbeitsablauf optimieren möchten. Durch die Nutzung der Leistungsfähigkeit fortschrittlicher KI-Technologie ermöglicht Stable Audio 2.0 Benutzern die Erkundung unbekannter Gebiete in der Musikkomposition, dem Sounddesign und der Audio-Postproduktion.

Was sind die Hauptmerkmale von Stable Audio 2.0?

Stable Audio 2.0 verfügt über eine beeindruckende Reihe von Funktionen, die die Landschaft des KI-generierten Audios neu definieren könnten. Von der Generierung vollständiger Tracks über die Audio-zu-Audio-Transformation bis hin zur verbesserten Soundeffektproduktion und Stilübertragung bietet dieses Modell den Entwicklern ein umfassendes Toolkit, mit dem sie ihre Hörvisionen zum Leben erwecken können.

Vollständige Track-Generierung

Stable Audio 2.0 hebt sich von anderen KI-generierten Audiomodellen durch die Möglichkeit ab, komplette Tracks mit einer Länge von bis zu drei Minuten zu erstellen. Bei diesen Kompositionen handelt es sich nicht nur um erweiterte Snippets, sondern um strukturierte Stücke, die unterschiedliche Abschnitte wie Intro, Durchführung und Outro umfassen. Mit dieser Funktion können Benutzer vollständige Musikwerke mit einer kohärenten Erzählung und Progression erstellen und so das Potenzial für die KI-gestützte Musikerstellung erhöhen.

Darüber hinaus verfügt das Modell über Stereo-Soundeffekte, die dem erzeugten Audio Tiefe und Dimension verleihen. Durch die Einbeziehung räumlicher Elemente werden der Realismus und die immersive Qualität der Titel noch weiter verbessert, sodass sie für eine Vielzahl von Anwendungen geeignet sind, von Hintergrundmusik in Videos bis hin zu eigenständigen Musikkompositionen.

Audio-zu-Audio-Generierung

Eine der aufregendsten Ergänzungen von Stable Audio 2.0 ist die Fähigkeit zur Audio-zu-Audio-Generierung. Benutzer können jetzt ihre eigenen Audiobeispiele hochladen und diese mithilfe von Eingabeaufforderungen in natürlicher Sprache umwandeln. Diese Funktion eröffnet eine Welt voller kreativer Möglichkeiten und ermöglicht Künstlern und Musikern, mit Klangmanipulation und -regeneration auf bisher unvorstellbare Weise zu experimentieren.

Durch die Nutzung der Leistungsfähigkeit der KI können Benutzer vorhandene Audio-Assets problemlos an ihre spezifischen Bedürfnisse oder künstlerischen Visionen anpassen. Ganz gleich, ob es darum geht, die Klangfarbe eines Instruments zu ändern, die Stimmung eines Stücks zu ändern oder völlig neue Sounds auf der Grundlage vorhandener Samples zu erstellen – Stable Audio 2.0 bietet eine intuitive Möglichkeit, die Audiotransformation zu erkunden.

Verbesserte Soundeffektproduktion

Zusätzlich zu seinen Fähigkeiten zur Musikgenerierung zeichnet sich Stable Audio 2.0 durch die Erstellung vielfältiger Soundeffekte aus. Von subtilen Hintergrundgeräuschen wie dem Rascheln von Blättern oder dem Summen von Maschinen bis hin zu immersiveren und komplexeren Klanglandschaften wie belebten Straßen in der Stadt oder natürlichen Umgebungen kann das Modell eine breite Palette an Audioelementen erzeugen.

Diese verbesserte Funktion zur Produktion von Soundeffekten ist besonders wertvoll für Content-Ersteller, die in den Bereichen Film, Fernsehen, Videospiele und Multimedia-Projekte arbeiten. Mit Stable Audio 2.0 können Benutzer schnell und einfach hochwertige Soundeffekte erzeugen, die sonst umfangreiche Geräuschemissionen oder kostspielige lizenzierte Ressourcen erfordern würden.

Stilübertragung

Stable Audio 2.0 führt eine Stilübertragungsfunktion ein, die es Benutzern ermöglicht, die ästhetischen und klanglichen Qualitäten generierter oder hochgeladener Audiodaten nahtlos zu ändern. Mit dieser Funktion können Entwickler die Audioausgabe an die spezifischen Themen, Genres oder emotionalen Untertöne ihrer Projekte anpassen.

Durch die Anwendung der Stilübertragung können Benutzer mit verschiedenen Musikstilen experimentieren, Genres mischen oder völlig neue Klangpaletten erstellen. Diese Funktion ist besonders nützlich, um zusammenhängende Soundtracks zu erstellen, Musik an bestimmte visuelle Inhalte anzupassen oder kreative Mashups und Remixe zu erkunden.

Technologische Fortschritte von Stable Audio 2.0

Unter der Haube wird Stable Audio 2.0 von modernster KI-Technologie angetrieben, die eine beeindruckende Leistung und hochwertige Ausgabe ermöglicht. Die Architektur des Modells wurde sorgfältig entwickelt, um den besonderen Herausforderungen bei der Generierung kohärenter Audiokompositionen in voller Länge gerecht zu werden und gleichzeitig eine feinkörnige Kontrolle über die Details zu behalten.

Latente Diffusionsmodellarchitektur

Das Herzstück von Stable Audio 2.0 ist eine latente Diffusionsmodellarchitektur, die für die Audioerzeugung optimiert wurde. Diese Architektur besteht aus zwei Schlüsselkomponenten: einer hochkomprimierten Autoencoder und einem Diffusionstransformator (DiT).

Der Autoencoder ist für die effiziente Komprimierung roher Audiowellenformen in kompakte Darstellungen verantwortlich. Diese Komprimierung ermöglicht es dem Modell, die wesentlichen Merkmale des Audios zu erfassen und gleichzeitig weniger wichtige Details herauszufiltern, was zu einer kohärenteren und strukturierteren generierten Ausgabe führt.

Der Diffusionstransformator, ähnlich dem, der im bahnbrechenden Modell Stable Diffusion 3 von Stability AI verwendet wird, ersetzt die traditionelle U-Net-Architektur, die in früheren Versionen verwendet wurde. Der DiT eignet sich besonders gut für den Umgang mit langen Datensequenzen und eignet sich daher gut für die Verarbeitung und Erstellung umfangreicher Audiokompositionen.

Verbesserte Leistung und Qualität

Die Kombination aus hochkomprimiertem Autoencoder und Diffusionstransformator ermöglicht es Stable Audio 2.0, im Vergleich zu seinem Vorgänger bemerkenswerte Verbesserungen sowohl bei der Leistung als auch bei der Ausgabequalität zu erzielen.

Durch die effiziente Komprimierung des Autoencoders kann das Modell Audio schneller verarbeiten und generieren, wodurch die erforderlichen Rechenressourcen reduziert werden und es einem breiteren Benutzerkreis zugänglicher wird. Gleichzeitig sorgt die Fähigkeit des Diffusionstransformators, großflächige Strukturen zu erkennen und zu reproduzieren, dafür, dass der erzeugte Ton ein hohes Maß an Kohärenz und musikalischer Integrität behält.

Diese technologischen Fortschritte gipfeln in einem Modell, das erstaunlich realistische und emotional resonante Audiosignale erzeugen kann, egal ob es sich um eine Musikkomposition in voller Länge, eine komplexe Klanglandschaft oder einen subtilen Soundeffekt handelt. Die Architektur von Stable Audio 2.0 legt den Grundstein für zukünftige Innovationen im Bereich KI-generiertes Audio und ebnet den Weg für noch ausgefeiltere und ausdrucksstärkere Tools für Entwickler.

Urheberrechte mit Stable Audio 2.0

Da KI-generiertes Audio immer weiter voranschreitet und zugänglicher wird, ist es von entscheidender Bedeutung, die ethischen Auswirkungen zu berücksichtigen und sicherzustellen, dass die Rechte der Urheber geschützt werden. Stability AI hat proaktive Schritte unternommen, um der ethischen Entwicklung und einer fairen Vergütung für Künstler Priorität einzuräumen, deren Arbeit zur Ausbildung von Stable Audio 2.0 beiträgt.

Stable Audio 2.0 wurde ausschließlich auf einem lizenzierten Datensatz von AudioSparx trainiert, einer seriösen Quelle für hochwertige Audioinhalte. Dieser Datensatz besteht aus über 800,000 Audiodateien, einschließlich Musik, Soundeffekten und Stems einzelner Instrumente, sowie entsprechenden Textmetadaten. Durch die Verwendung eines lizenzierten Datensatzes stellt Stability AI sicher, dass das Modell auf einer Grundlage legal erworbener und entsprechend zugeordneter Audiodaten aufbaut.

Stability AI erkannte die Bedeutung der Autonomie des Urhebers und bot allen Künstlern, deren Werke im AudioSparx-Datensatz enthalten sind, die Möglichkeit, die Verwendung ihrer Audiodaten für das Training von Stable Audio 2.0 abzulehnen. Dieser Opt-out-Mechanismus ermöglicht es den Erstellern, die Kontrolle darüber zu behalten, wie ihre Arbeit genutzt wird, und stellt sicher, dass nur diejenigen in den Datensatz aufgenommen werden, die damit einverstanden sind, dass ihre Audiodaten für das KI-Training verwendet werden.

Stability AI setzt sich dafür ein, dass Entwickler, deren Arbeit zur Entwicklung von Stable Audio 2.0 beiträgt, für ihre Bemühungen angemessen entlohnt werden. Durch die Lizenzierung des AudioSparx-Datensatzes und die Bereitstellung von Opt-out-Optionen demonstriert das Unternehmen sein Engagement für die Schaffung eines nachhaltigen und gerechten Ökosystems für KI-generiertes Audio, in dem Urheber für ihre Beiträge respektiert und belohnt werden.

Um die Rechte der Urheber weiter zu schützen und Urheberrechtsverletzungen vorzubeugen, ist Stability AI eine Partnerschaft mit Audible Magic eingegangen, einem führenden Anbieter von Inhaltserkennungstechnologie. Durch die Integration des ACR-Systems (Advanced Content Recognition) von Audible Magic in den Audio-Upload-Prozess kann Stable Audio 2.0 potenziell rechtsverletzende Inhalte identifizieren und kennzeichnen und so sicherstellen, dass auf der Plattform nur Original- oder ordnungsgemäß lizenzierte Audiodaten verwendet werden.

Durch diese ethischen Überlegungen und schöpferzentrierten Initiativen schafft Stability AI einen starken Präzedenzfall für eine verantwortungsvolle KI-Entwicklung im Audiobereich. Durch die Priorisierung der Rechte der Urheber und die Festlegung klarer Richtlinien für die Datennutzung und Vergütung fördert das Unternehmen ein kollaboratives und nachhaltiges Umfeld, in dem KI und menschliche Kreativität koexistieren und gedeihen können.

Mit Stabilitäts-KI die Zukunft der Audio-Erstellung gestalten

Stable Audio 2.0 markiert einen bedeutenden Meilenstein im Bereich KI-generiertes Audio und bietet Entwicklern eine umfassende Suite von Tools, mit denen sie neue Grenzen in den Bereichen Musik, Sounddesign und Audioproduktion erkunden können. Mit seiner hochmodernen latenten Diffusionsmodellarchitektur, seiner beeindruckenden Leistung und seinem Engagement für ethische Überlegungen und Urheberrechte steht Stability AI an vorderster Front bei der Gestaltung der Zukunft der Audioproduktion. Während sich diese Technologie weiterentwickelt, ist es klar, dass KI-generiertes Audio eine immer wichtigere Rolle in der kreativen Landschaft spielen wird und Künstlern und Musikern die Werkzeuge an die Hand gibt, die sie benötigen, um die Grenzen ihres Handwerks zu erweitern und neu zu definieren, was in der Welt möglich ist von Klang.