Künstliche Intelligenz

RigNeRF: Eine neue Deepfakes-Methode, die neuronale Strahlungsfelder nutzt

Neue bei Adobe entwickelte Forschungsergebnisse bieten die erste praktikable und effektive Deepfakes-Methode, die darauf basiert Neuronale Strahlungsfelder (NeRF) – vielleicht die erste echte Innovation in der Architektur oder im Ansatz in den fünf Jahren seit dem Aufkommen von Deepfakes im Jahr 2017.

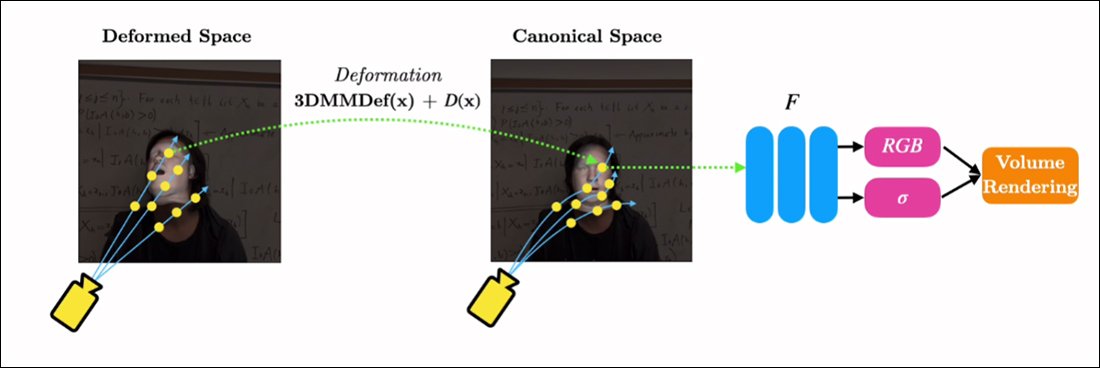

Die Methode mit dem Titel RigNeRF, Verwendet 3D-morphbare Gesichtsmodelle (3DMMs) als interstitielle Instrumentalitätsebene zwischen der gewünschten Eingabe (d. h. der Identität, die in das NeRF-Rendering eingefügt werden soll) und dem neuronalen Raum, eine Methode, die es gab in den letzten Jahren weit verbreitet von Generative Adversarial Network (GAN) Ansätze zur Gesichtssynthese, von denen noch keiner funktionale und nützliche Gesichtsersatz-Frameworks für Videos hervorgebracht hat.

Im Gegensatz zu herkömmlichen Deepfake-Videos ist hier absolut nichts von den bewegten Inhalten „echt“, sondern ein erforschbarer neuronaler Raum, der anhand kurzer Filmsequenzen trainiert wurde. Rechts sehen wir das 3D-morphable Gesichtsmodell (3DMM), das als Schnittstelle zwischen den gewünschten Manipulationen („Lächeln“, „Nach links schauen“, „Nach oben schauen“ usw.) und den meist unlösbaren Parametern einer Visualisierung des neuronalen Strahlungsfelds fungiert. Eine hochauflösende Version dieses Clips sowie weitere Beispiele finden Sie im Projekt-Seite, oder die eingebetteten Videos am Ende dieses Artikels. Quelle: https://shahrukhathar.github.io/2022/06/06/RigNeRF.html

3DMMs sind im Grunde CGI-Modelle von Gesichtern, deren Parameter an abstraktere Bildsynthesesysteme wie NeRF und GAN angepasst werden können, die ansonsten schwer zu steuern sind.

Was Sie im Bild oben (mittleres Bild, Mann im blauen Hemd) sowie im Bild direkt darunter (linkes Bild, Mann im blauen Hemd) sehen, ist kein „echtes“ Video, in das ein kleiner Ausschnitt eines „falschen“ Gesichts eingeblendet wurde, sondern eine vollständig synthetisierte Szene, die ausschließlich als volumetrische neuronale Darstellung existiert – einschließlich Körper und Hintergrund:

Im Beispiel direkt darüber wird das Realvideo rechts (Frau im roten Kleid) verwendet, um die erfasste Identität (Mann im blauen Hemd) links über RigNeRF zu „manipulieren“. RigNeRF ist (laut den Autoren) das erste NeRF-basierte System, das eine Trennung von Pose und Ausdruck erreicht und gleichzeitig neuartige Ansichtssynthesen durchführen kann.

Die männliche Figur links im Bild oben wurde aus einem 70-sekündigen Smartphone-Video „aufgenommen“ und die Eingabedaten (einschließlich der gesamten Szeneninformationen) wurden anschließend auf 4 V100-GPUs trainiert, um die Szene zu erhalten.

Da parametrische Rigs im 3DMM-Stil auch als verfügbar sind Ganzkörperparametrische CGI-Proxys (statt nur Gesichts-Rigs) eröffnet RigNeRF möglicherweise die Möglichkeit von Ganzkörper-Deepfakes, bei denen echte menschliche Bewegungen, Texturen und Ausdrucksformen an die CGI-basierte parametrische Ebene übergeben werden, die dann Aktion und Ausdruckskraft in gerenderte NeRF-Umgebungen und -Videos übersetzen würde .

Was RigNeRF betrifft – gilt es als Deepfake-Methode im aktuellen Sinne, in dem die Schlagzeilen den Begriff verstehen? Oder ist es nur ein weiterer halb behinderter Mitläufer von DeepFaceLab und anderen arbeitsintensiven Autoencoder-Deepfake-Systemen aus dem Jahr 2017?

Die Forscher der neuen Studie sind in diesem Punkt eindeutig:

„Da RigNeRF eine Methode ist, mit der Gesichter wiederbelebt werden können, besteht die Gefahr, dass böswillige Akteure sie missbrauchen, um Deepfakes zu erstellen.“

The new Krepppapier ist betitelt RigNeRF: Vollständig steuerbare neuronale 3D-Porträts, und stammt von ShahRukh Atha von der Stonybrook University, einem Praktikanten bei Adobe während der Entwicklung von RigNeRF, und vier weiteren Autoren von Adobe Research.

Jenseits von Autoencoder-basierten Deepfakes

Die meisten viralen Deepfakes, die in den letzten Jahren für Schlagzeilen gesorgt haben, werden von produziert Autoencoder-basierte Systeme, abgeleitet von dem Code, der 2017 im prompt verbotenen Subreddit r/deepfakes veröffentlicht wurde – allerdings nicht vorher kopiert auf GitHub, wo es derzeit geforkt wurde über tausend Mal, nicht zuletzt in die populäre (if umstritten) DeepFaceLab Verteilung, und auch die Gesicht tauschen Projekt einfliessen.

Neben GAN und NeRF haben auch Autoencoder-Frameworks mit 3DMMs als „Richtlinien“ für verbesserte Gesichtssynthese-Frameworks experimentiert. Ein Beispiel hierfür ist das HifiFace-Projekt ab Juli 2021. Allerdings scheinen sich aus diesem Ansatz bisher keine brauchbaren oder populären Initiativen entwickelt zu haben.

Daten für RigNeRF-Szenen werden durch die Aufnahme kurzer Smartphone-Videos gewonnen. Für das Projekt verwendeten die Forscher von RigNeRF für alle Experimente ein iPhone XR oder ein iPhone 12. In der ersten Hälfte der Aufnahme wird die Versuchsperson gebeten, eine Vielzahl von Gesichtsausdrücken und Sprechweisen nachzuahmen und dabei den Kopf ruhig zu halten, während die Kamera um sie herum bewegt wird.

In der zweiten Hälfte der Aufnahme behält die Kamera eine feste Position bei, während das Motiv seinen Kopf bewegen und dabei eine Vielzahl von Gesichtsausdrücken zeigen muss. Die resultierenden 40–70 Sekunden Filmmaterial (ca. 1200–2100 Bilder) stellen den gesamten Datensatz dar, der zum Trainieren des Modells verwendet wird.

Reduzierung der Datenerfassung

Im Gegensatz dazu erfordern Autoencoder-Systeme wie DeepFaceLab das relativ mühsame Sammeln und Kuratieren Tausender unterschiedlicher Fotos, die oft aus YouTube-Videos und anderen Social-Media-Kanälen sowie aus Filmen (im Fall von Promi-Deepfakes) stammen.

Die so trainierten Autoencoder-Modelle sind oft für den Einsatz in verschiedenen Situationen vorgesehen. Die anspruchsvollsten „Promi“-Deepfaker trainieren jedoch möglicherweise ganze Modelle von Grund auf für ein einziges Video, obwohl das Training eine Woche oder länger dauern kann.

Trotz der Warnung der Forscher in der neuen Arbeit ist es unwahrscheinlich, dass die „Flickenteppiche“ und breit angelegten Datensätze, die KI-Pornos und den beliebten „Deepfake-Recastings“ von YouTube/TikTok zugrunde liegen, in einem Deepfake-System wie RigNeRF, das eine szenenspezifische Methodik verwendet, akzeptable und konsistente Ergebnisse liefern. Angesichts der in der neuen Arbeit dargelegten Einschränkungen bei der Datenerfassung könnte sich dies in gewissem Maße als zusätzlicher Schutz gegen den beiläufigen Identitätsmissbrauch durch böswillige Deepfaker erweisen.

Anpassung von NeRF an Deepfake-Video

NeRF ist eine auf Photogrammetrie basierende Methode, bei der eine kleine Anzahl von Quellbildern, die aus verschiedenen Blickwinkeln aufgenommen wurden, zu einem erforschbaren 3D-Neuronalraum zusammengesetzt werden. Dieser Ansatz wurde Anfang des Jahres bekannt, als NVIDIA seine vorstellte Sofortiges NeRF System, das in der Lage ist, die exorbitanten Trainingszeiten für NeRF auf Minuten oder sogar Sekunden zu reduzieren:

Sofortiges NeRF. Quelle: https://www.youtube.com/watch?v=DJ2hcC1orc4

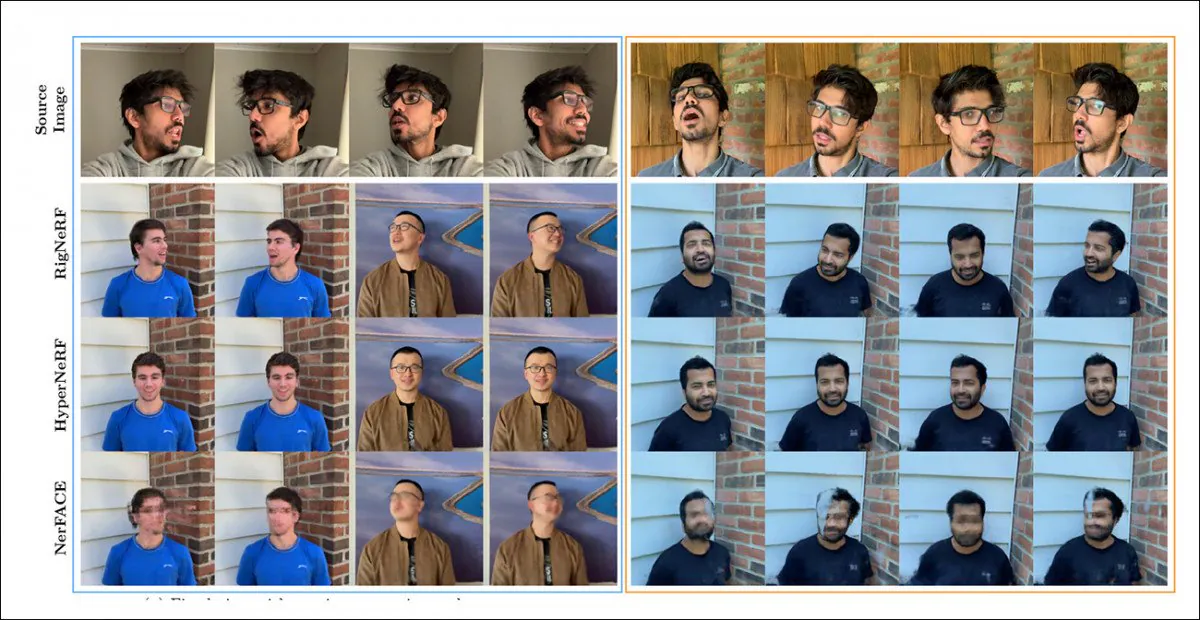

Die resultierende Neural Radiance Field-Szene ist im Wesentlichen eine statische Umgebung, die erkundet werden kann, dies aber auch ist schwierig zu bearbeiten. Die Forscher stellen fest, dass zwei frühere NeRF-basierte Initiativen – HyperNeRF + E/P und NerFACE – haben einen Versuch mit der Gesichtsvideosynthese unternommen und (anscheinend der Vollständigkeit und Sorgfalt halber) RigNeRF in einer Testrunde mit diesen beiden Frameworks verglichen:

Ein qualitativer Vergleich zwischen RigNeRF, HyperNeRF und NerFACE. Versionen in höherer Qualität finden Sie in den verlinkten Quellvideos und im PDF. Statische Bildquelle: https://arxiv.org/pdf/2012.03065.pdf

In diesem Fall sind die Ergebnisse, die RigNeRF begünstigen, jedoch aus zwei Gründen ziemlich anomal: Erstens stellen die Autoren fest, dass „es keine Arbeit für einen direkten Vergleich gibt“; zweitens hat dies die Einschränkung der Fähigkeiten von RigNeRF erforderlich gemacht, um zumindest teilweise die eingeschränktere Funktionalität der früheren Systeme zu erreichen.

Da die Ergebnisse keine schrittweise Verbesserung gegenüber früheren Arbeiten darstellen, sondern vielmehr einen „Durchbruch“ in der Editierbarkeit und Nützlichkeit von NeRF repräsentieren, lassen wir die Testrunde beiseite und schauen uns stattdessen an, was RigNeRF anders macht als seine Vorgänger.

Kombinierte Stärken

Die Hauptbeschränkung von NerFACE, das Pose-/Ausdruckskontrolle in einer NeRF-Umgebung ermöglicht, besteht darin, dass das Quellmaterial mit einer statischen Kamera aufgenommen wird. Dies bedeutet, dass keine neuen Ansichten erstellt werden können, die über die Aufnahmebeschränkungen hinausgehen. Das Ergebnis ist ein System, das zwar „bewegte Porträts“ erstellen kann, aber für Deepfake-Videos ungeeignet ist.

HyperNeRF hingegen ist zwar in der Lage, neuartige und hyperreale Ansichten zu generieren, verfügt jedoch über keine Instrumente, die es ermöglichen, Kopfhaltungen oder Gesichtsausdrücke zu ändern, was wiederum keinerlei Konkurrenz für Autoencoder-basierte Deepfakes darstellt.

RigNeRF kann diese beiden isolierten Funktionen kombinieren, indem es einen „kanonischen Raum“ erstellt, eine Standardbasislinie, von der aus Abweichungen und Verformungen über Eingaben vom 3DMM-Modul vorgenommen werden können.

Erstellen eines „kanonischen Raums“ (keine Pose, kein Ausdruck), auf den die über das 3DMM erzeugten Deformationen (d. h. Posen und Ausdrücke) einwirken können.

Da das 3DMM-System nicht exakt auf das aufgenommene Objekt abgestimmt ist, ist es wichtig, dies im Prozess zu kompensieren. RigNeRF erreicht dies mit einem Deformationsfeld, das aus einem Mehrschichtiges Perzeptron (MLP), abgeleitet aus dem Quellmaterial.

Die zur Berechnung der Verformungen notwendigen Kameraparameter werden über gewonnen COLMAP, während die Ausdrucks- und Formparameter für jeden Rahmen aus erhalten werden DER, DASS.

Die Positionierung wird dadurch weiter optimiert Wahrzeichen passend und die Kameraparameter von COLMAP. Aufgrund von Einschränkungen der Rechenressourcen wird die Videoausgabe für das Training auf eine Auflösung von 256×256 heruntergerechnet (ein hardwarebeschränkter Verkleinerungsprozess, der auch die Deepfaking-Szene des Autoencoders plagt).

Anschließend wird das Deformationsnetzwerk auf den vier V100 trainiert – einer beeindruckenden Hardware, die für Gelegenheitsenthusiasten wahrscheinlich nicht erschwinglich ist (beim Training des maschinellen Lernens ist es jedoch oft möglich, Gewicht gegen Zeit einzutauschen und einfach zu akzeptieren, dass das Modelltraining eine Frage von Tagen oder sogar Wochen sein wird).

Abschließend stellen die Forscher fest:

„Im Gegensatz zu anderen Methoden ist RigNeRF dank der Verwendung eines 3DMM-gesteuerten Deformationsmoduls in der Lage, Kopfhaltung, Gesichtsausdrücke und die vollständige 3D-Porträtszene mit hoher Genauigkeit zu modellieren und so bessere Rekonstruktionen mit scharfen Details zu ermöglichen.“

Weitere Details und Ergebnismaterial finden Sie in den unten eingebetteten Videos.

Erstveröffentlichung am 15. Juni 2022.