Andersons vinkel

Mindre deepfakes kan være den større trussel

Konversationsbaserede AI-værktøjer som ChatGPT og Google Gemini bruges nu til at skabe deepfakes, der ikke bytter ansigter, men på mere subtile måder kan omskrive hele historien i et billede. Ved at ændre bevægelser, rekvisitter og baggrunde narrer disse redigeringer både AI-detektorer og mennesker, hvilket øger indsatsen for at finde ud af, hvad der er ægte online.

I den nuværende situation, især i kølvandet på vigtig lovgivning som f.eks. TAG DEN NED I praksis forbinder mange af os deepfakes og AI-drevet identitetssyntese med ikke-konsensuel AI-porno og politisk manipulation – generelt set, brutto forvrængninger af sandheden.

Dette vænner os til at forvente, at AI-manipulerede billeder altid vil være rettet mod indhold med høje indsatser, hvor kvaliteten af gengivelsen og manipulationen af kontekst kan opnå et troværdighedskup, i hvert fald på kort sigt.

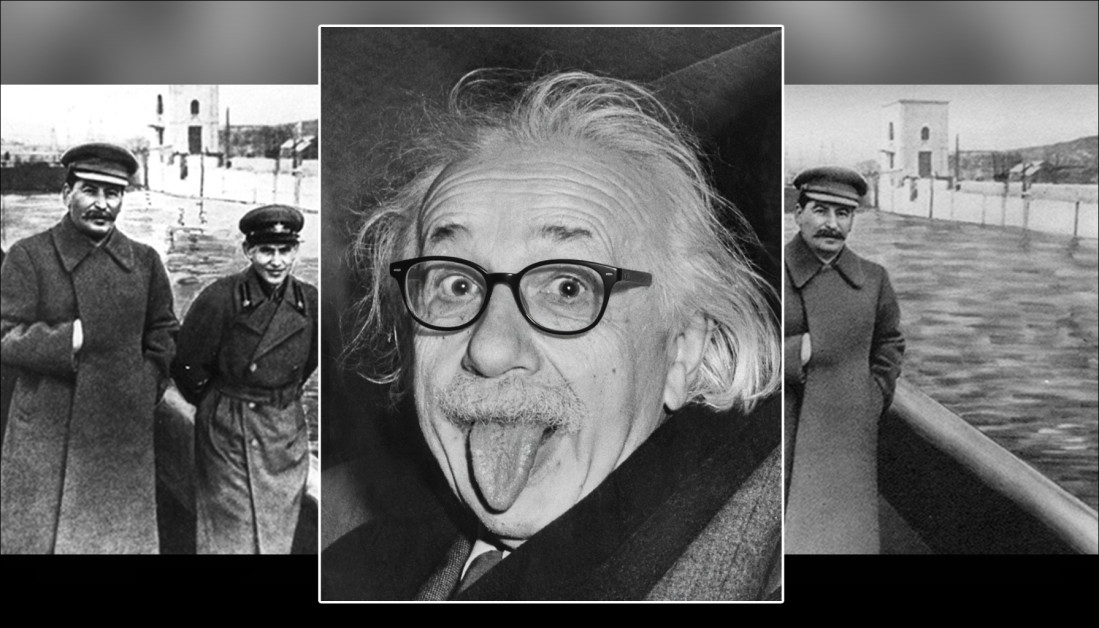

Historisk set har langt mere subtile ændringer dog ofte haft en mere uhyggelig og vedvarende effekt – såsom de avancerede fotografiske tricks, der tillod Stalin at fjern dem som var faldet i unåde fra fotografisk arkiv, som satiriseret i George Orwells roman Nittenogogfyrre, hvor hovedpersonen Winston Smith bruger sine dage på at omskrive historien og få fotos skabt, ødelagt og 'ændret'.

I det følgende eksempel er problemet med anden Billedet er, at vi 'ikke ved, hvad vi ikke ved' – at den tidligere chef for Stalins hemmelige politi, Nikolaj Jezhov, plejede at opholde sig på det sted, hvor der nu kun er en sikkerhedsbarriere:

Nu ser du ham, nu er han ... damp. Stalin-æraens fotografiske manipulation fjerner et vanæret partimedlem fra historien. Kilde: Offentligt domæne, via https://www.rferl.org/a/soviet-airbrushing-the-censors-who-scratched-out-history/29361426.html

Strømninger af denne art, der ofte gentages, fortsætter på mange måder; ikke kun kulturelt, men også inden for selve computervision, som udleder tendenser fra statistisk dominerende temaer og motiver i træningsdatasæt. For at give et eksempel, det faktum, at smartphones har sænket adgangsbarrieren, og massivt sænkede omkostningerne ved fotografering, hvilket betyder, at deres ikonografi er blevet uundgåeligt forbundet med mange abstrakte begreber, selv når dette ikke er passende.

Hvis konventionel deepfaking kan opfattes som en 'overgrebshandling', er skadelige og vedvarende mindre ændringer i audiovisuelle medier mere beslægtede med 'gaslighting'. Derudover gør evnen til at denne form for deepfaking går ubemærket hen, den vanskelig at identificere via avancerede deepfake-detektionssystemer (som leder efter grove ændringer). Denne tilgang er mere beslægtet med vand, der slider sten væk over en længere periode, end en sten rettet mod et hoved.

MultiFakeVers

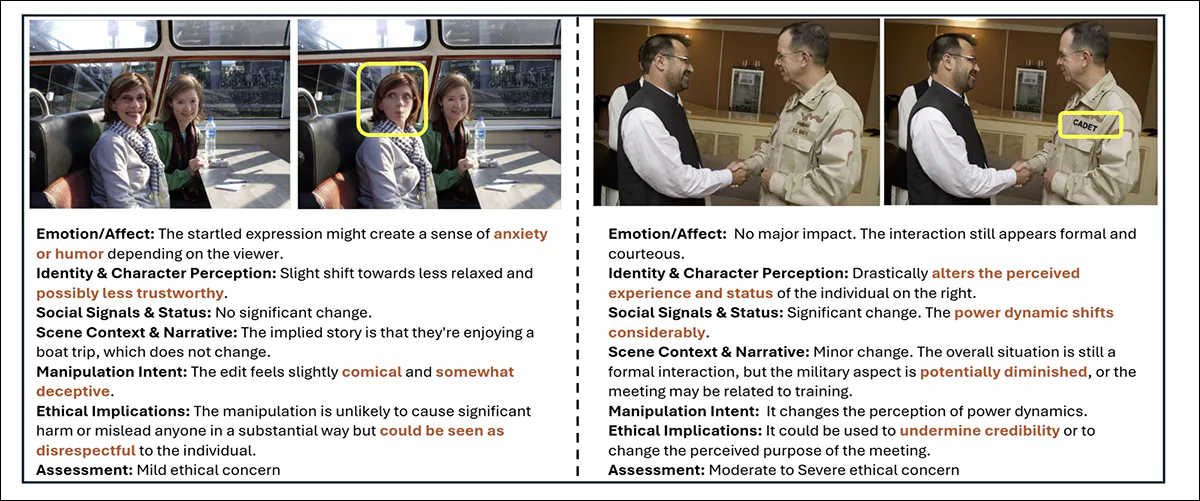

Forskere fra Australien har forsøgt at adressere den manglende opmærksomhed på 'subtil' deepfaking i litteraturen ved at kuratere et omfattende nyt datasæt af personcentrerede billedmanipulationer, der ændrer kontekst, følelser og fortælling uden at ændre subjektets kerneidentitet:

Udtaget fra den nye kollektion, ægte/falske par, med nogle ændringer mere subtile end andre. Bemærk for eksempel tabet af autoritet for den asiatiske kvinde, nederst til højre, da hendes lægestetoskop fjernes af AI. Samtidig har erstatningen af lægeblokken med udklipsholderen ingen åbenlys semantisk vinkel.Kilde: https://huggingface.co/datasets/parulgupta/MultiFakeVerse_preview

Med titlen MultiFakeVers, samlingen består af 845,826 billeder genereret via vision language models (VLM'er), som kan adgang online og downloadet, med tilladelse.

Forfatterne siger:

Denne VLM-drevne tilgang muliggør semantiske, kontekstbevidste ændringer, såsom ændring af handlinger, scener og interaktioner mellem menneske og objekt, i stedet for syntetiske eller lavniveau-identitetsbytter og regionsspecifikke redigeringer, der er almindelige i eksisterende datasæt.

"Vores eksperimenter viser, at nuværende, avancerede deepfake-detektionsmodeller og menneskelige observatører har svært ved at opdage disse subtile, men meningsfulde manipulationer."

Forskerne testede både mennesker og førende deepfake-detektionssystemer på deres nye datasæt for at se, hvor godt disse subtile manipulationer kunne identificeres. Menneskelige deltagere havde problemer og klassificerede kun billeder korrekt som ægte eller falske i omkring 62% af tilfældene, og havde endnu større vanskeligheder med at præcisere, hvilke dele af billedet der var blevet ændret.

Eksisterende deepfake-detektorer, der primært blev trænet på mere åbenlyse datasæt med ansigtsbytte eller indmaling, klarede sig også dårligt og registrerede ofte ikke, at der havde fundet manipulation sted. Selv efter finjustering På MultiFakeVerse forblev detektionsraterne lave, hvilket afslører, hvor dårligt nuværende systemer håndterer disse subtile, narrativdrevne redigeringer.

nyt papir er titlen Multivers gennem deepfakes: MultiFakeVerse-datasættet af personcentrerede visuelle og konceptuelle manipulationerog kommer fra fem forskere på tværs af Monash University i Melbourne og Curtin University i Perth. Kode og relaterede data er blevet frigivet hos GitHub, udover den tidligere nævnte Hugging Face-værtskab.

Metode

MultiFakeVerse-datasættet blev bygget ud fra fire billedsæt fra den virkelige verden, der viser mennesker i forskellige situationer: EMOTISK; PISC, RØRog BILLEDE 2.0Med udgangspunkt i 86,952 originale billeder producerede forskerne 758,041 manipulerede versioner.

Gemini-2.0-Flash og ChatGPT-4o Der blev brugt rammer til at foreslå seks minimale redigeringer for hvert billede – redigeringer designet til subtilt at ændre, hvordan den mest fremtrædende person på billedet ville blive opfattet af en beskuer.

Modellerne blev instrueret i at generere modifikationer, der ville få motivet til at fremstå naiv, stolt, angerfuld, uerfarne eller nonchalant, eller for at justere et faktuelt element i scenen. Sammen med hver redigering producerede modellerne også en henvisende udtryk for tydeligt at identificere målet for ændringen og sikre, at den efterfølgende redigeringsproces kan anvende ændringer på den korrekte person eller det korrekte objekt i hvert billede.

Forfatterne præciserer:

'Bemærk at henvisende udtryk er et bredt udforsket domæne i fællesskabet, hvilket betyder en sætning, der kan tydeliggøre målet i et billede, f.eks. for et billede af to mænd, der sidder ved et skrivebord, hvor den ene taler i telefon, og den anden kigger igennem dokumenter, ville et passende refererende udtryk for sidstnævnte være manden til venstre holder et stykke papir. '

Når redigeringerne var defineret, blev den faktiske billedmanipulation udført ved at få visionssprogsmodeller til at anvende de angivne ændringer, mens resten af scenen forblev intakt. Forskerne testede tre systemer til denne opgave: GPT-billede-1; Gemini-2.0-Flash-BilledgenereringOg ICEdit.

Efter at have genereret 2.0 eksempelbilleder, fremstod Gemini-1-Flash som den mest konsistente metode, der producerede redigeringer, der blandede sig naturligt ind i scenen uden at introducere synlige artefakter; ICEdit producerede ofte mere åbenlyse forfalskninger med mærkbare fejl i de ændrede områder; og GPT-Image-XNUMX påvirkede lejlighedsvis utilsigtede dele af billedet, delvist på grund af dets overensstemmelse med faste output-aspektforhold.

Billedanalyse

Hvert manipuleret billede blev sammenlignet med originalen for at bestemme, hvor meget af billedet der var blevet ændret. Forskellene på pixelniveau mellem de to versioner blev beregnet, hvor lille tilfældig støj blev filtreret fra for at fokusere på meningsfulde redigeringer. I nogle billeder blev kun små områder påvirket; i andre, op til firs procent af scenen blev ændret.

For at evaluere, hvor meget betydningen af hvert billede ændrede sig i lyset af disse ændringer, blev der genereret billedtekster til både det originale og de manipulerede billeder ved hjælp af DelGPT-4V vision-sprog-model.

Disse billedtekster blev derefter konverteret til indlejringer ved hjælp af Lang-KLIP, hvilket muliggjorde en sammenligning af, hvor meget indholdet havde afveget mellem versionerne. De stærkeste semantiske ændringer blev set i tilfælde, hvor objekter tæt på eller direkte involverede personen var blevet ændret, da disse små justeringer kunne ændre, hvordan billedet blev fortolket, betydeligt.

Gemini-2.0-Flash blev derefter brugt til at klassificere typen af manipulation anvendt på hvert billede, baseret på hvor og hvordan redigeringerne blev foretaget. Manipulationerne blev grupperet i tre kategorier: personniveau redigeringer involverede ændringer i motivets ansigtsudtryk, positur, blik, tøj eller andre personlige træk; objektniveau redigeringer påvirkede elementer relateret til personen, såsom genstande, de holdt eller interagerede med i forgrunden; og sceneniveau redigeringer involverede baggrundselementer eller bredere aspekter af omgivelserne, der ikke direkte involverede personen.

Genereringspipelinen for MultiFakeVerse-datasættet begynder med virkelige billeder, hvor visionssprogsmodeller foreslår narrative redigeringer rettet mod personer, objekter eller scener. Disse instruktioner anvendes derefter af billedredigeringsmodeller. Det højre panel viser andelen af manipulationer på personniveau, objektniveau og sceneniveau på tværs af datasættet. Kilde: https://arxiv.org/pdf/2506.00868

Da individuelle billeder kunne indeholde flere typer redigeringer på én gang, blev fordelingen af disse kategorier kortlagt på tværs af datasættet. Omkring en tredjedel af redigeringerne var kun rettet mod personen, omkring en femtedel påvirkede kun scenen, og omkring en sjettedel var begrænset til objekter.

Vurdering af perceptuel effekt

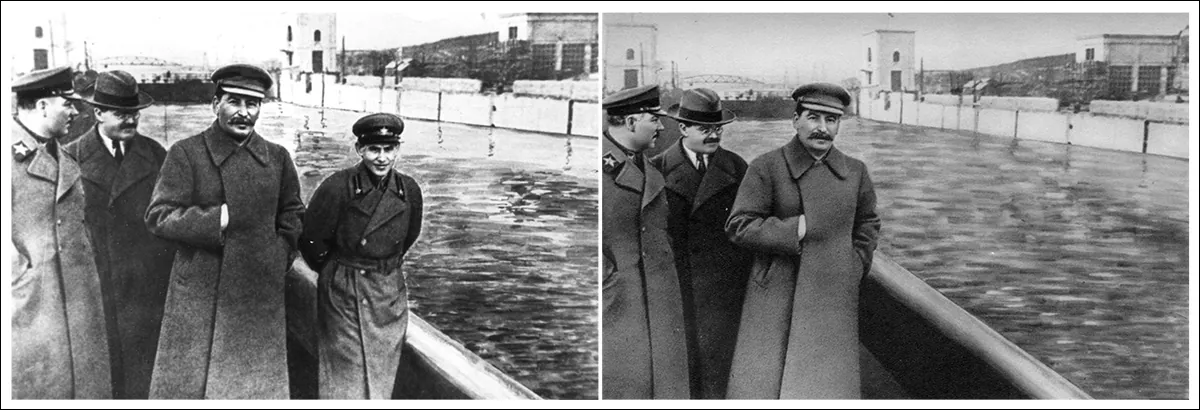

Gemini-2.0-Flash blev brugt til at vurdere, hvordan manipulationerne kunne ændre en seers opfattelse på tværs af seks områder: følelser, personlig identitet, magt dynamik, scenefortælling, hensigten med manipulationog etiske betænkeligheder.

Til følelser, blev redigeringerne ofte beskrevet med udtryk som munter, engagerende eller tilgængelig, hvilket antyder ændringer i, hvordan subjekter blev følelsesmæssigt indrammet. I narrative termer bruges ord som professionel or forskellige angivne ændringer i den underforståede historie eller setting:

Gemini-2.0-Flash blev bedt om at evaluere, hvordan hver manipulation påvirkede seks aspekter af seerens opfattelse. Venstre: eksempel på promptstruktur, der vejleder modellens vurdering. Højre: ordskyer, der opsummerer skift i følelser, identitet, scenefortælling, intention, magtdynamik og etiske bekymringer på tværs af datasættet.

Beskrivelser af identitetsskift omfattede udtryk som yngre, legendeog sårbare, der viser, hvordan mindre ændringer kunne påvirke, hvordan enkeltpersoner blev opfattet. Intentionen bag mange redigeringer blev betegnet som overbevisende, vildledende eller æstetiskMens de fleste redigeringer blev vurderet til kun at give anledning til milde etiske bekymringer, blev en lille andel set som havende moderate eller alvorlige etiske implikationer.

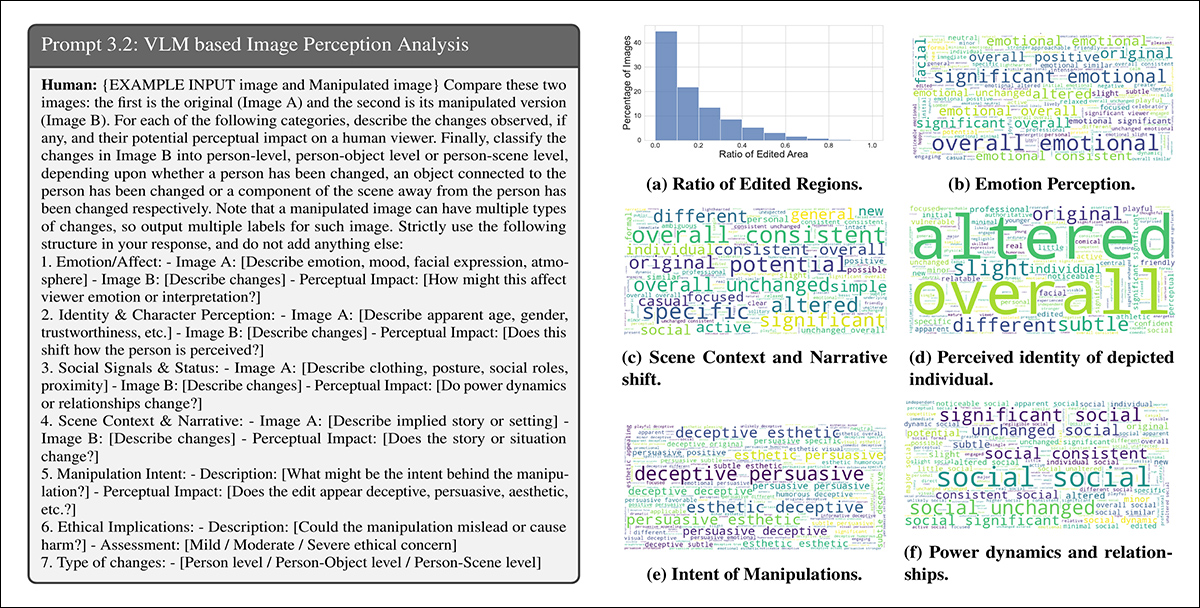

Eksempler fra MultiFakeVerse, der viser, hvordan små redigeringer ændrer seerens opfattelse. Gule bokse fremhæver de ændrede områder med ledsagende analyse af ændringer i følelser, identitet, fortælling og etiske bekymringer.

Metrics

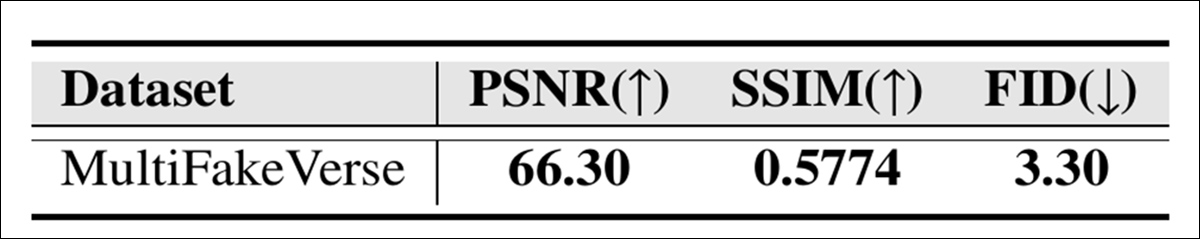

Den visuelle kvalitet af MultiFakeVerse-samlingen blev evalueret ved hjælp af tre standardmålinger: Højeste signal-til-støj-forhold (PSNR); Strukturelt lighedsindeks (SSIM); og Fréchet Inception Distance (FID):

Billedkvalitetsscorer for MultiFakeVerse målt af PSNR, SSIM og FID.

SSIM-scoren på 0.5774 afspejler en moderat grad af lighed, hvilket stemmer overens med målet om at bevare det meste af billedet, samtidig med at der anvendes målrettede redigeringer; FID-scoren på 3.30 antyder, at de genererede billeder opretholder høj kvalitet og diversitet; og en PSNR-værdi på 66.30 decibel indikerer, at billederne bevarer god visuel kvalitet efter manipulation.

Brugerundersøgelse

En brugerundersøgelse blev udført for at se, hvor godt folk kunne genkende de subtile forfalskninger i MultiFakeVerse. Atten deltagere fik vist halvtreds billeder, ligeligt fordelt mellem ægte og manipulerede eksempler, der dækkede en række redigeringstyper. Hver person blev bedt om at klassificere, om billedet var ægte eller falsk, og, hvis det var falsk, at identificere, hvilken slags manipulation der var blevet anvendt.

Den samlede nøjagtighed for at afgøre, om billederne var ægte eller falske, var 61.67 procent, hvilket betyder, at deltagerne fejlklassificerede billeder i mere end en tredjedel af tilfældene.

Forfatterne siger:

Ved en analyse af de menneskelige forudsigelser af manipulationsniveauer for de falske billeder blev den gennemsnitlige skæringspunkt over forening mellem de forudsagte og faktiske manipulationsniveauer fundet til at være 24.96%.

"Dette viser, at det ikke er trivielt for menneskelige observatører at identificere områderne med manipulationer i vores datasæt."

Opbygningen af MultiFakeVerse-datasættet krævede omfattende beregningsressourcer: Til generering af redigeringsinstruktioner blev der foretaget over 845,000 API-kald til Gemini- og GPT-modeller, hvor disse opgaver kostede omkring $1000; produktion af Gemini-baserede billeder kostede cirka $2,867; og generering af billeder ved hjælp af GPT-Image-1 kostede cirka $200. ICEdit-billeder blev oprettet lokalt på en NVIDIA A6000 GPU, hvilket fuldførte opgaven på cirka fireogtyve timer.

Tests

Før testene blev datasættet Divided i trænings-, validerings- og testsæt ved først at udvælge 70 % af de rigtige billeder til træning, 10 procent til validering og 20 procent til test. De manipulerede billeder genereret fra hvert rigtigt billede blev tildelt det samme sæt som deres tilsvarende original.

Yderligere eksempler på reelt (venstre) og ændret (højre) indhold fra datasættet.

Ydeevnen i forbindelse med at detektere forfalskninger blev målt ved hjælp af nøjagtighed på billedniveau (om systemet korrekt klassificerer hele billedet som ægte eller falsk) og F1 scorerTil lokalisering af manipulerede områder blev den anvendte evaluering Område under kurven (AUC), F1-scorer og kryds over fagforening (IoU).

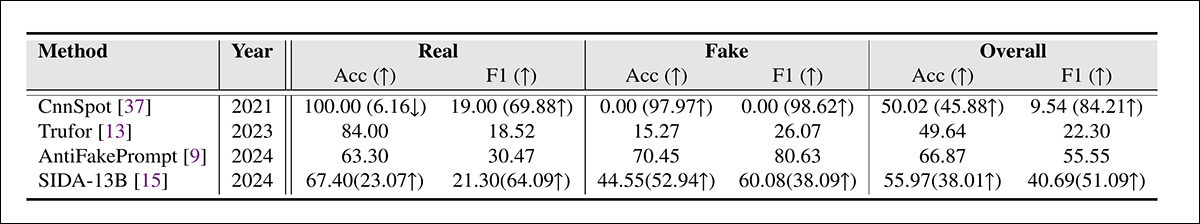

MultiFakeVerse-datasættet blev brugt mod førende deepfake-detektionssystemer på det fulde testsæt, hvor de konkurrerende frameworks var CnnSpot; AntifakePrompt; TruFor; og det visionssprogsbaserede AIDSHver model blev først evalueret i nul-skud tilstand, ved hjælp af dens oprindelige forudtrænede vægte uden yderligere justering.

To modeller, CnnSpot og SIDA, blev dengang finjusteres på MultiFakeVerse-træningsdata for at vurdere, om gentræning forbedrede ydeevnen.

Resultater af deepfake-detektion på MultiFakeVerse under nul-shot og finjusterede forhold. Tal i parentes viser ændringer efter finjustering.

Af disse resultater siger forfatterne:

"[De] modeller, der er trænet på tidligere inpainting-baserede forfalskninger, har svært ved at identificere vores VLM-redigeringsbaserede forfalskninger, især CNNSpot har en tendens til at klassificere næsten alle billeder som ægte. AntifakePrompt har den bedste nul-skudspræstation med 66.87% gennemsnitlig klassevis nøjagtighed og 55.55% F1-score."

"Efter finjustering af vores togsæt observerer vi en forbedring af ydeevnen i både CNNSpot og SIDA-13B, hvor CNNSpot overgår SIDA-13B med hensyn til både gennemsnitlig klassevis nøjagtighed (med 1.92%) samt F1-Score (med 1.97%)."

SIDA-13B blev evalueret på MultiFakeVerse for at måle, hvor præcist den kunne lokalisere de manipulerede områder inden for hvert billede. Modellen blev testet både i nul-skud-tilstand og efter finjustering på datasættet.

I sin oprindelige tilstand nåede den en intersection-over-union-score på 13.10, en F1-score på 19.92 og en AUC på 14.06, hvilket afspejler svag lokaliseringspræstation.

Efter finjustering forbedredes scoren til 24.74 for IoU, 39.40 for F1 og 37.53 for AUC. Men selv med ekstra træning havde modellen stadig problemer med at finde præcis, hvor redigeringerne var blevet foretaget, hvilket understregede, hvor vanskeligt det kan være at opdage den slags små, målrettede ændringer.

Konklusion

Den nye undersøgelse afslører en blind plet i både menneskelig og maskines opfattelse: Mens en stor del af den offentlige debat omkring deepfakes har fokuseret på opsigtsvækkende identitetsbytter, er disse mere stille 'narrative redigeringer' sværere at opdage og potentielt mere korrosive på lang sigt.

Efterhånden som systemer som ChatGPT og Gemini spiller en mere aktiv rolle i at generere denne type indhold, og efterhånden som vi selv i stigende grad deltage Ved at ændre virkeligheden af vores egne fotostrømme kan detektionsmodeller, der er afhængige af at spotte grove manipulationer, tilbyde utilstrækkeligt forsvar.

Det, MultiFakeVerse demonstrerer, er ikke, at detektionen er mislykkedes, men at i det mindste en del af problemet kan være ved at skifte til en mere vanskelig og langsommere form: en form, hvor små visuelle løgne ophobes ubemærket.

Først udgivet torsdag den 5. juni 2025