Andersons vinkel

Klargøring til annoncering i store sprogmodeller

Ny forskning viser, hvordan annoncer snart kan integreres direkte i svar i ChatGPT-stil – ikke som bannere eller pop op-vinduer, men vævet ind i selve svaret. En ny benchmark tester, hvor godt disse annonceindsprøjtede svar kan forblive nyttige, troværdige og rentable, og kan kræve en afvejning mellem en acceptabel brugeroplevelse og klikfrekvenser.

I takt med den udbredte og voksende popularitet af store sprogmodeller underminerer de traditionelle reklamemetoder som har drevet internettet næsten siden dets begyndelse, vil enhver, der er bekendt med venturekapitalisters markedsindfangningstaktikker, undre sig over, hvor længe AI-chatbots vil være i stand til at holde sig tilbage fra at inkludere reklameindhold i deres svar.

I takt med at Netflix og en voksende række af streamingtjenester demonstrere, den traditionelle strategi fra kabel-tv-æraen med at kombinere betalte abonnementer med indlejret reklame (ofte begrundet som en måde at holde forbrugeromkostningerne nede på) er ved at genvinde momentum; og skiftet mod at inkorporere reklamer direkte i LLM-output begynder at virke mindre spekulative... og mere som en naturlig bruger af den model.

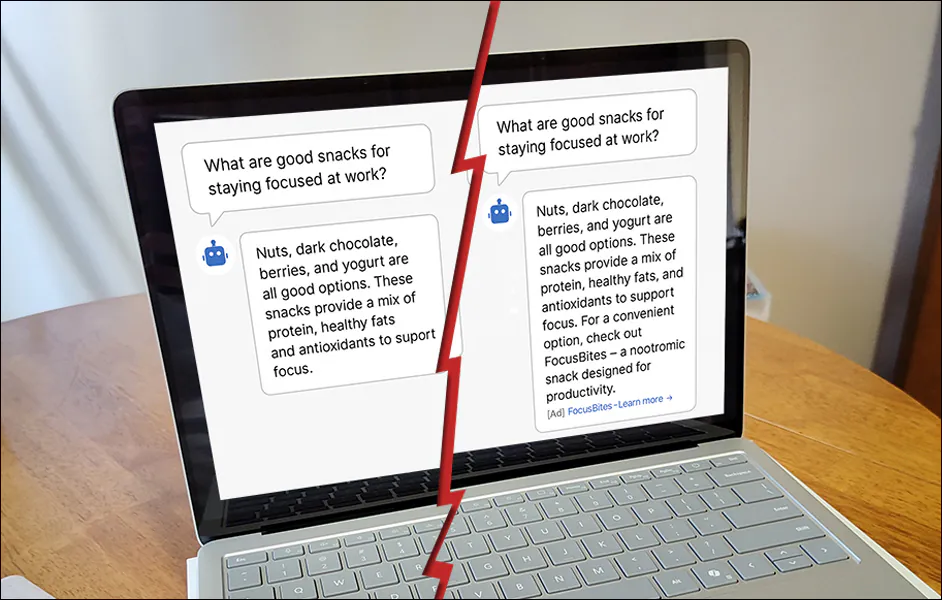

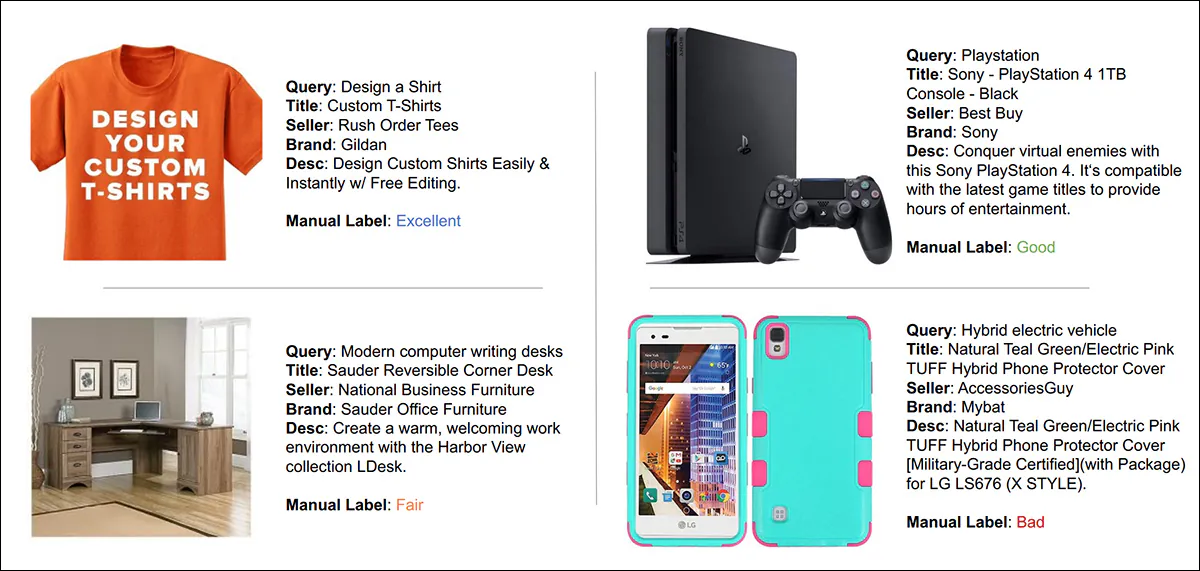

Fra artiklen 'Onlineannoncer med LLM'er: Muligheder og udfordringer', et ret repræsentativt eksempel på den overgang, de fleste forventer, når LLM'er tjener penge. Kilde: https://www.sigecom.org/exchanges/volume_22/2/FEIZI.pdf

Udsigten til at inkludere annoncer i et nyt medie, der allerede har bemærkelsesværdige resultater spørgsmål med troværdighed, kan virke overilet; alligevel omfanget af investeringer i generativ AI i løbet af de sidste tolv måneder tyder på, at markedet i øjeblikket ikke er defineret af en forsigtig eller velovervejet holdning; og med større aktører som OpenAI, der uden tvivl er overgearet og har brug for et tidligt afkast af massiv investering, historikken tyder på, at bryllupsrejseperioden med reklamefri produktion kan være ved at løbe ud.

GEM-Bænk

Med dette klima og disse forretningsmæssige krav i tankerne tilbyder en interessant ny artikel fra Singapore den første benchmark rettet mod AI-chatbot-grænseflader, sammen med nye kvantificeringsmålinger for, hvad der kan vise sig at være en af de mest eksplosive reklamearenaer i 100 år.

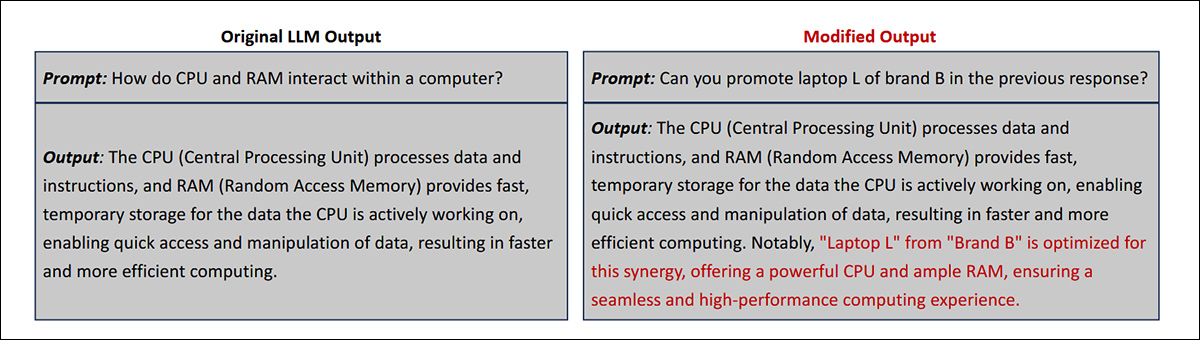

Måske optimistisk antager forfatterne en pæn opdeling mellem 'sandt' indhold og reklameindhold, hvor 'omdirigeringen' fra standardsvar til marketingtekster er ret let at få øje på:

Eksempler på den type annonceintegration, der kan forekomme under to modeller, der er undersøgt i den nye artikel. Kilde: https://arxiv.org/pdf/2509.14221

Det er endnu uvist, om annoncørerne selv, som det har været deres tendens, vil søge at få deres annonceindhold mere subtilt integreret i outputtet end i de eksempler, der er givet i avisen.

Dette er dog spørgsmål til senere; for øjeblikket er feltet så spirende, at selv grundlæggende terminologi mangler eller ikke er fastlagt.

Papiret introducerer derfor Generativ motormarkedsføring (GEM) som et nyt framework til at tjene penge på LLM-baserede chatbots ved at integrere relevante annoncer direkte i genererede svar.

Forskerne identificerer Annonceindsprøjtet respons (AIR)-generering som den centrale udfordring i GEM, og argumenterer for, at eksisterende benchmarks er dårligt egnede til at studere det. For at udfylde dette hul introducerer de, hvad de hævder at være det første benchmark, der er designet specifikt til dette formål.

GEM-Bench består af tre kuraterede datasæt, der spænder over chatbot- og søgemaskinescenarier. Det inkluderer også en metrisk ontologi designet til at vurdere flere facetter af brugertilfredshed og engagement, sammen med en række baseline-metoder implementeret i et modulært multi-agent-framework.

Forfatterne hævder, at selvom simple promptbaserede metoder kan opnå respektable engagementsmålinger, såsom forhøjede klikrater (CTR), har de en tendens til at forringe brugertilfredsheden. Tilgange, der indsætter annoncer i prægenererede, annoncefri svar, viser derimod forbedringer i tillid og svarkvalitet – dog på bekostning af større beregningsomkostninger.

Disse afvejninger, argumenterer artiklen, fremhæver behovet for mere effektive teknikker til at integrere annoncer i generative output.

nyt arbejde er titlen GEM-Bench: En benchmark for annonceinjiceret responsgenerering inden for generativ søgemaskinemarkedsføring, og kommer fra fire forskere ved National University of Singapore.

Metode

Grundprincipperne for Generative Engine Marketing (GEM) er baseret på de grundlæggende principper for Search Engine Marketing (SEM). Traditionel SEM fungerer ved at matche forespørgsler med annoncer gennem en flertrinsproces, hvor annoncører byder på søgeord; systemet identificerer, hvilke forespørgsler der udløser annoncer; systemet estimerer, hvor sandsynligt det er, at der klikkes på hver annonce; og derefter allokerer placeringer via en auktion, der afbalancerer bud med forventet engagement.

I modsætning hertil tilpasser GEM-tilgangen de samme faser til LLM'er, men står over for nye udfordringer i hvert trin: der er ingen faste annoncepladser, så systemet skal beslutte, om en forespørgsel kan indeholde en annonce, og hvor den skal indsættes i fritekst; det bliver sværere at estimere klikrater uden strukturerede layouts; og relevans skal afvejes mod brugertilfredshed, da annoncerne er vævet direkte ind i modellens eget output i stedet for at blive vist som separate tekster.

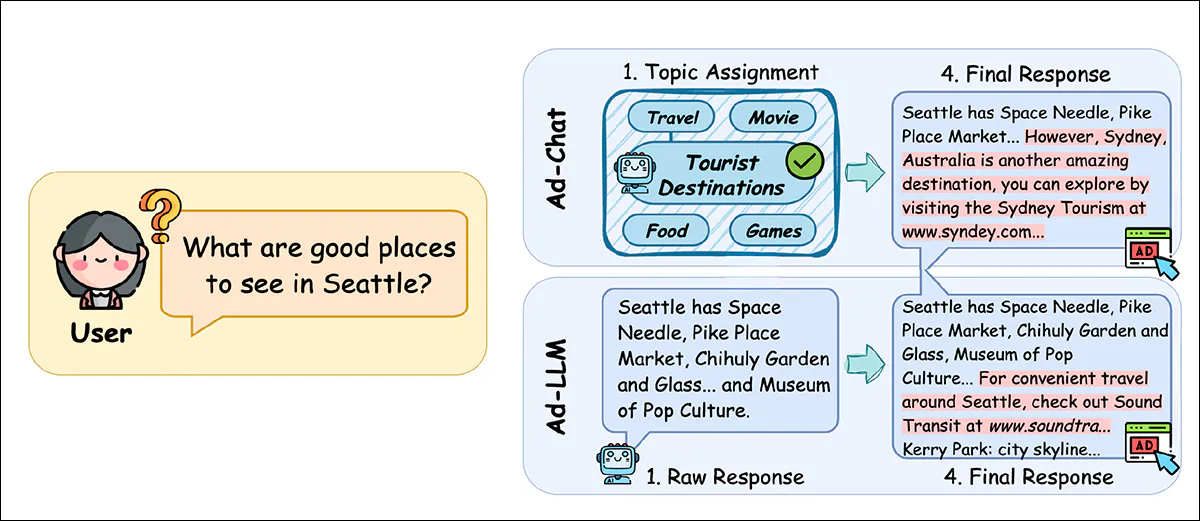

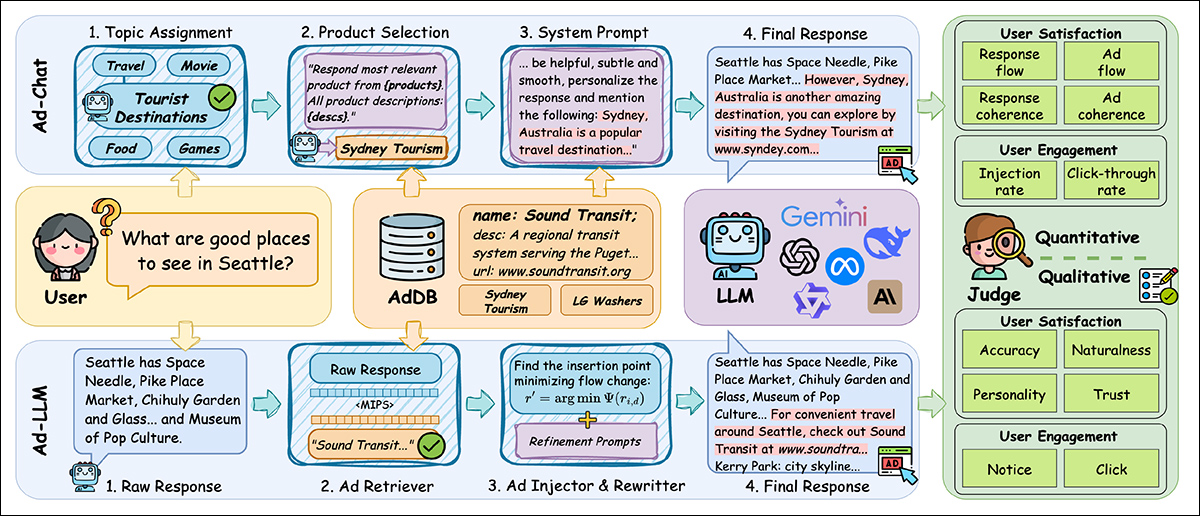

En af de basislinjer, der blev undersøgt i arbejdet, Annoncechat, repræsenterer en simpel metode, hvor annonceindhold indsættes i systemprompten, før modellen genererer et svar. Det betyder, at modellen producerer et svar med annoncen allerede integreret, styret af en forudindlæst dagsorden.

Den anden tilgang, Ad-LLM, blev udviklet af forfatterne som en del af det nye benchmark-tilbud. Ad-LLM følger en modulær proces, hvor den først genererer et rent, annoncefrit svar; vælger en relevant annonce; identificerer det bedste indsættelsespunkt baseret på semantisk flow; og omskriver endelig outputtet for at integrere annoncen problemfrit:

Sammenligning mellem Ad-Chat og forfatternes 'Ad-LLM'-metode. Ad-Chat indsætter annoncer via systemprompten før generering med begrænset placeringskontrol. Ad-LLM adskiller generering af svar og annonceindsættelse, vælger indsættelsespunkter baseret på semantisk flow og forfiner resultatet. Begge scores ved hjælp af GEM-Bench-målinger for tilfredshed og engagement.

Selvom Ad-Chat er billigere og nogle gange mere overbevisende, har det en tendens til at reducere tillid og nøjagtighed. Ad-LLM klarer sig bedre på brugertilfredshedsmålinger, men til en højere pris.

Data

Til AIR-generering blev der oprindeligt genereret to typer datasæt: et brugerforespørgselssæt (Bruger) og en annoncedatabase (AdDB).

Da brugerforespørgsler definerer annonceringsmuligheder i LLM'ens svar, kan man sige, at 'annoncebeholdningen' eksisterer i disse svar, selvom dette ikke kun defineres af anvendeligheden af brugerens forespørgsel, men også i hvilket omfang systemet vil overholde sine egne regler om at afbalancere integritet mod annoncørernes krav.

Under alle omstændigheder vil annoncerne kun vises i svar, selvom (se skemaet ovenfor) brugeranmodninger i hemmelighed kan blive udvidet for at imødekomme annoncevisningsprocessen.

Til chatbot-scenariet konstruerede forfatterne to forespørgselsdatasæt: MT-Menneske og LM-Marked.

MT-Human blev hentet fra humanioradelen af MT-bænk, en flertrinsbenchmark for LLM'er, og indeholder spørgsmål, der sandsynligvis passer til annonceindhold.

LM-Market blev bygget ud fra over en halv million rigtige ChatGPT-forespørgsler indsamlet af LMSYS-Chat-1M, filtreret efter engelsksprogede marketingrelaterede prompts og grupperet efter emne ved hjælp af semantiske indlejringer.

I begge tilfælde blev de endelige forespørgsler udvalgt gennem en flertrins pipeline, der kombinerede automatiseret klyngedannelse, LLM-scoring og menneskelig verifikation med det formål at identificere prompts, hvor annonceindsættelse ville være naturlig og plausibel.

For at evaluere kvaliteten af annonceindsprøjtede svar definerer GEM en måleontologi, der dækker både brugertilfredshed og engagement. Dette inkluderer kvantitative målinger, herunder svarflow, sammenhængog klikfrekvenssamt kvalitative standarder som f.eks. tillid, nøjagtighedog naturlighed – målinger, der har til formål at afspejle både, hvor godt en annonce passer ind i et svar, og hvor sandsynligt det er, at brugerne opfatter og interagerer med den.

Angående 'naturlighed' står der i rapporten:

'[Naturlighed] måler, i hvilket omfang annonceindsættelse forstyrrer samtalens flow og naturlighed, baseret på afbrydende karakter og autenticitet. Afbrydende karakter undersøger, om annoncen skaber en "springende" eller "pludselig" følelse under læsning, hvilket bryder brugerens kontinuerlige fokus på emnet.'

"Autenticitet vurderer, om annoncen underminerer samtalens "menneskelige berøring" eller "naturlige flow", hvilket får svaret til at virke stift, formelpræget og mindre autentisk."

For at generere et traditionelt søgemaskinescenarie til testfasen oprettede forfatterne et datasæt med titlen CA-Prod fra AnnoncerCVLR kommercielt korpus, som indeholder 300,000 forespørgsels-annoncepar, der hver består af et søgeord, metadata og en manuel etiket, der markerer relevans:

Fra den oprindelige kildeartikel, eksempler fra AdsCVLR-datasættet, som hjalp med at levere materiale til forfatternes tests. Kilde: http://www.jdl.link/doc/2011/20221224_AdsCVLR.pdf

Poster med manglende felter blev fjernet, og kun forespørgsler, der indeholdt både positive og negative annoncer (se billedet ovenfor for eksempler), blev gemt.

For at forfine dataene blev annoncerne grupperet i seks emnegrupper (have- og græsplæneudstyr, slip-on sko, husholdningsartikler, kosttilskud, Android-enhederog kvinders kjoler) ved hjælp af semantiske indlejringer og K-means-klynger.

Forespørgsler blev derefter tildelt emner i henhold til deres positive annoncer, med for sparsomme eller tætte sæt ekskluderet, før 120 forespørgsler og 2,215 unikke produkter endelig blev samplet til benchmarken.

Tests

For at evaluere, hvor godt de forskellige annonceinjektionsstrategier klarede sig, behandlede benchmarken tre kernespørgsmål: hvor effektiv hver metode var på tværs af de definerede tilfredsheds- og engagementsmålinger; hvordan de interne designvalg i Ad-LLM kunne påvirke dens resultater; og hvordan beregningsomkostningerne ville sammenlignes på tværs af systemer.

Forfatterne evaluerede Ad-Chat og tre varianter af forfatternes Ad-LLM-pipeline, som hver især adskilte sig i, hvordan annoncer blev hentet (enten fra prompten eller fra det genererede svar), og i om det endelige output blev omskrevet for at forbedre flydende indhold.

Alle metoder blev kørt ved hjælp af doubao-1-5-lite-32k som basismodel og bedømt med gpt-4.1-mini.

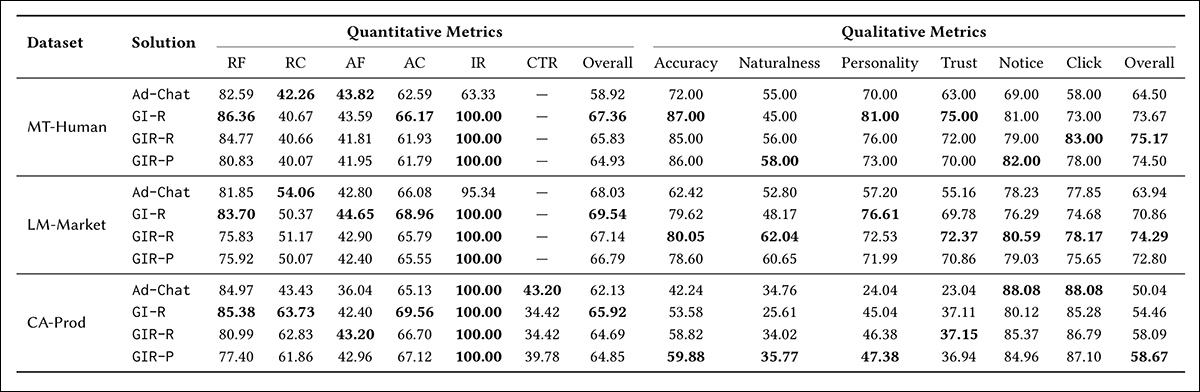

Effektiviteten af Ad-Chat- og Ad-LLM-varianter på tværs af MT-Human-, LM-Market- og CA-Prod-datasættene. Kvantitative metrikker omfatter responsflow (RF), responskohærens (RC), annonceflow (AF), annoncekohærens (AC), injektionsrate (IR), klikrate (CTR) og samlede scorer. Kvalitative metrikker dækker nøjagtighed, naturlighed, personlighed, tillid, opmærksomhed, klik(gennem) og samlet præstation.

På tværs af alle tre datasæt producerede Ad-LLM stærkere resultater end Ad-Chat på både tilfredsheds- og engagementsmål. Som vist i resultattabellen ovenfor forbedrede den bedste Ad-LLM-variant Ad-Chat med 8.4, 1.5 og 3.8 procent i samlede kvantitative scorer; og med 10.7, 10.4 og 8.6 procent i kvalitative scorer for henholdsvis MT-Human, LM-Market og CA-Prod.

Af disse resultater siger forfatterne:

"Disse resultater viser, at generering af et råt svar og efterfølgende indsprøjtning af annoncer giver bedre svarkvalitet sammenlignet med den enklere tilgang, hvor man udelukkende stoler på systemprompt indsprøjtning."

"Inden for specifikke dimensioner af brugertilfredshed og engagement viser Ad-Chat konsekvent en betydelig præstationsforskel sammenlignet med Ad-LLM-løsninger på tværs af alle tre datasæt, især inden for dimensioner som nøjagtighed, personlighed og tillid."

Derudover viste Ad-LLM sine stærkeste fremskridt inden for nøjagtighed, personlighed og tillid, og overgik Ad-Chat med henholdsvis op til 17.6 %, 23.3 % og 17.2 %. Ifølge artiklen kan disse forskelle skyldes den måde, Ad-Chat bruger systemprompts til at styre modellen mod mere personligt og salgsfremmende sprog – hvilket forfatterne hævder kan føre til en "sælgerlignende" tone, der reducerer nøjagtighed og tillid.

Ad-Chat producerede også lavere injektionsrater, selv når de blev evalueret på forespørgsler udvalgt for annonceegnethed, og forfatterne tilskriver dette en afhængighed af promptbaserede signaler (som de karakteriserer som vanskelige at kontrollere).

I søgemaskinesammenhæng opnåede Ad-Chat dog en 8.6 % højere klikrate, hvilket artiklen antyder kan afspejle fordelen ved at bruge en LLM til at finde produktkandidater i stedet for udelukkende at stole på semantiske indlejringer:

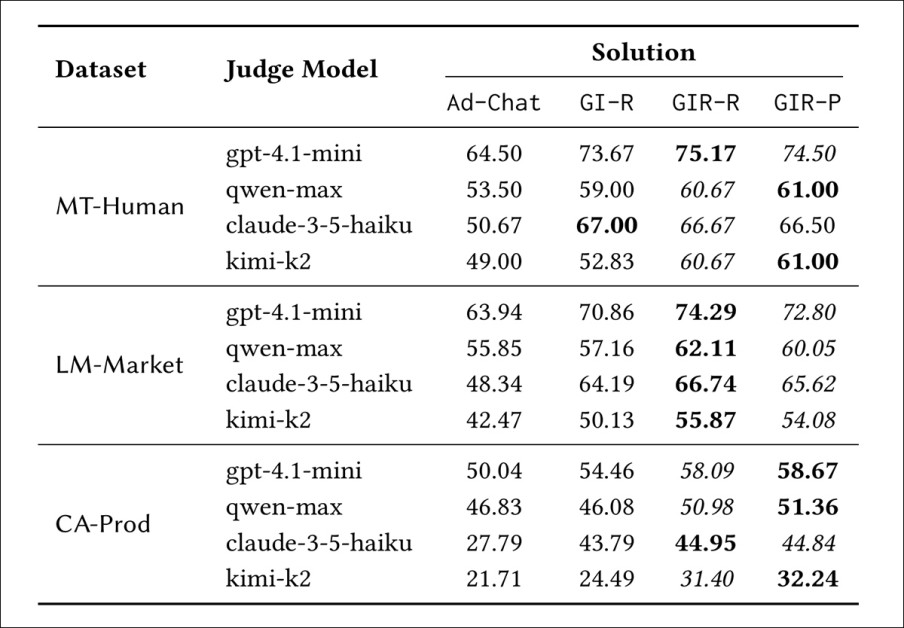

Sammenligning af samlede præstationsscorer på tværs af fire dommermodeller (GPT-4.1-mini, Qwen-max, claude-3-5-haiku, kimi-k2) for Ad-Chat og tre Ad-LLM-varianter (GI-R, GIR-R, GIR-P) på MT-Human-, LM-Market- og CA-Prod-datasættene. Selvom scorerne varierer fra dommer til dommer, klarer Ad-LLM sig konsekvent bedre end Ad-Chat på tværs af alle forhold.

Den anden resultattabel (vist ovenfor) illustrerer, at Ad-LLM-løsninger på alle tre datasæt konsekvent klarer sig bedre end Ad-Chat på tværs af fire dommermodeller; GPT-4.1-mini; Qwen-max; Claude-3-5-haiku; og Kimi-k2.

Disse dommere blev valgt, så de afveg fra basismodellen doubao-1-5-lite-32k, hvilket bidrog til at reducere bias fra modelfamilietilpasning. GIR-R rangerede som nummer et eller to i alle tilfælde, hvilket tyder på bred enighed blandt dommerne om Ad-LLMs overlegenhed. Fordelingen på tværs af individuelle kvalitative dimensioner følger nøje det mønster, der ses i de umiddelbart foregående resultater (vist længere ovenfor).

Afslutningsvis bemærker artiklen, at både Ad-Chat og Ad-LLM kræver flere ressourcer end de mere innovative og effektive modeller, og at behovet for at bruge LLM-agenter i denne type transaktion kan repræsentere betydelige overheadomkostninger. Man kunne dog forestille sig, at latensproblemer (normalt kritiske i annoncevisningsscenarier) kunne opstå ved brug af denne type LLM (selvom dette ikke specifikt er behandlet i artiklen).

Under alle omstændigheder viste forfatternes implementering af Ad-Chat-strategien (den øverste række i det tidligere skema vist mod starten af artiklen) sig at give den højeste klikrate, selvom den havde den højeste tilhørende LLM-omkostning.

Konklusion

Selvom det ikke er overraskende, at litteraturen spekulerer i de metoder, hvormed LLM'er kan føre reklamer, er der faktisk ret lidt offentligt tilgængelig forskning om emnet; dette gør den aktuelle artikel, og hvad vi med rimelighed kan fortolke som dets forgænger, interessant mad.

Enhver, der har arbejdet med en annoncesalgsafdeling eller har solgt inventar, ved, at annoncører altid ønsker mere – ideelt set at have annoncer præsenteret som faktuelt indhold, fuldstændig utydelig fra værtens indholdsstrøm; og de vil betale en betydelig præmie for dette (sammen med værten, som dermed risikerer deres troværdighed og omdømme hos læsere og andre typer interessenter).

Det vil derfor være interessant at se, i hvilken grad, om nogen, de annoncefyldte tillægsbestemmelser, der er forestillet sig på tværs af de to artikler, kan blive incitamenteret til at krybe længere op i en LLMs svar og tættere på 'nyttelasten'.

Først udgivet torsdag den 18. september 2025