Andersons vinkel

Tilføjelse af dialog til rigtig video med AI

Et nyt AI-framework kan omskrive, fjerne eller tilføje en persons ord i video uden at skulle optage igen, i et enkelt end-to-end-system.

For tre år siden ville internettet have været forbløffet over et hvilket som helst af de 20-30 AI-videoredigeringsframeworks, der udgives ugentligt på akademiske portaler; som det er nu, er denne populære forskningsstreng blevet så produktiv, at den næsten udgør endnu en gren af 'AI Slop', og jeg dækker langt færre af den slags udgivelser, end jeg ville have gjort for to eller tre år siden.

Men én aktuel udgivelse i denne serie fangede min opmærksomhed: et integreret system, der kan gribe ind i rigtige videoklip og indsætte ny tale i den eksisterende video (i stedet for at skabe et helt generativt klip ud fra et ansigt eller en ramme, hvilket er langt mere almindeligt).

I eksemplerne nedenfor, som jeg redigerede sammen fra en lang række eksempelvideoer, der er tilgængelige på udgivelsens projektets hjemmeside, ser vi først det rigtige kildeklip, og derefter, nedenunder, den pålagte AI-tale midt i klippet, inklusive stemmesyntese og læbesynkronisering:

Klik for at spille. Lokal redigering med sammensætning – en af flere metoder, der tilbydes af FacEDiT. Se kildewebstedet for bedre opløsning. Kilde – https://facedit.github.io/

Denne tilgang er en af tre, der er udviklet til den nye metode, denne med titlen 'lokal redigering med sammenføjning', og den, der interesserer forfatterne (såvel som mig selv) mest. I bund og grund forlænges klippet ved at bruge en af de midterste billeder som udgangspunkt for en ny AI-fortolkning, og dens efterfølgende (virkelige) billede som et mål, som det generative indsatte klip skal sigte mod at matche. I klippene ovenfor er disse 'seed'- og 'target'-billeder repræsenteret af den øverste video, der pauserer, mens den ændrede video nedenfor giver generativ udfyldning.

Forfatterne beskriver denne tilgang til ansigts- og vokalsyntese som den første fuldt integrerede end-to-end-metode til AI-videoredigering af denne art og observerer potentialet i et fuldt udviklet framework som dette til tv- og filmproduktion:

Filmskabere og medieproducenter har ofte brug for at revidere specifikke dele af optagede videoer – måske blev et ord sagt forkert, eller manuskriptet blev ændret efter optagelsen. For eksempel i den ikoniske scene fra Titanic (1997) hvor Rose siger, "Jeg giver aldrig slip, Jack," direktøren kan senere beslutte, at det skal være "Jeg vil aldrig glemme dig, Jack".

"Traditionelt kræver sådanne ændringer, at hele scenen optages igen, hvilket er dyrt og tidskrævende. Syntese af talende ansigter tilbyder et praktisk alternativ ved automatisk at ændre ansigtsbevægelser, så de matcher den ændrede tale, hvilket eliminerer behovet for nye optagelser."

Selvom AI-indgreb af denne art kan stå over for kulturelle eller modstand fra industrien, kan de også udgøre en ny type funktionalitet i menneskestyrede VFX-systemer og værktøjspakker. Under alle omstændigheder er udfordringerne for øjeblikket strengt tekniske.

Udover at forlænge et klip med yderligere AI-genereret dialog, kan det nye system også ændre eksisterende tale:

Klik for at spille. Et eksempel på ændring af eksisterende dialog i stedet for at indsætte yderligere dialog. Se kildewebstedet for en bedre opløsning.

State of the art

Der findes i øjeblikket ingen end-to-end-systemer, der tilbyder denne form for syntesekapacitet; selvom et stigende antal generative AI-platforme som f.eks. Googles Veo-serien, kan generere lyd, og forskellige andre frameworks kan skabe deepfaked lyd, man er i øjeblikket nødt til at skabe en ret kompliceret pipeline af forskellige arkitekturer og tricks for at kunne forstyrre rigtige optagelser på den måde, det nye system – med titlen FaceEDiT – kan opnå.

Systemet bruger Diffusionstransformatorer (DiT) i kombination med Flow Matching at skabe ansigtsbevægelser betinget af omgivende (kontekstuelle) bevægelser og tale-lydindhold. Systemet udnytter eksisterende populære pakker, der beskæftiger sig med ansigtsrekonstruktion, herunder LivePortræt (for nylig overtaget af Kling).

Ud over denne metode, da deres tilgang er den første til at integrere disse udfordringer i en enkelt løsning, har forfatterne skabt en ny benchmark kaldet FaceEDiTBench, sammen med adskillige helt nye evalueringsmålinger, der er relevante for denne meget specifikke opgave.

nyt arbejde er titlen FacEDiT: Samlet redigering og generering af talende ansigter via ansigtsbevægelsesinfill, og kommer fra fire forskere fra Koreas Pohang University of Science and Technology (POSTECH), Korea Advanced Institute of Science & Technology (KAIST) og University of Texas i Austin.

Metode

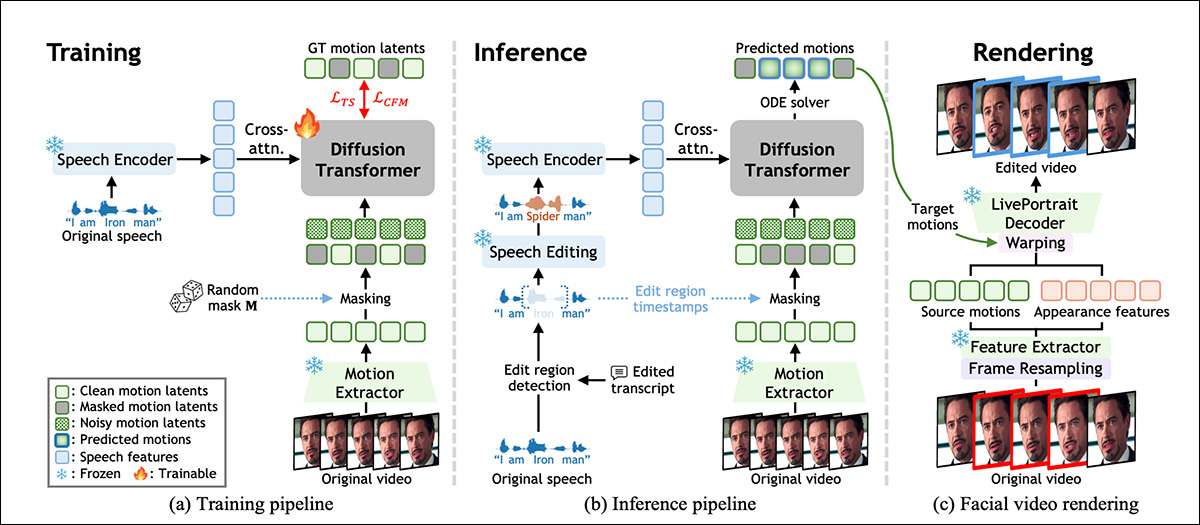

FacEDiT er trænet til at rekonstruere ansigtsbevægelser ved at lære at udfylde manglende dele af en skuespillers originale præstation baseret på den omgivende bevægelse og talelyden. Som vist i skemaet nedenfor, tillader denne proces modellen at fungere som en mellemrumsudfylder under træningen og forudsige ansigtsbevægelser, der matcher stemmen, samtidig med at de forbliver konsistente med den originale video:

Oversigt over FacEDiT-systemet, der viser, hvordan ansigtsbevægelse læres gennem selvovervåget infilling under træning, guides af redigeret tale ved inferens og endelig gengives tilbage til video ved at genbruge udseendet af den originale optagelse, mens kun den målrettede bevægelse erstattes. Kilde

Ved inferenstidspunktet understøtter den samme arkitektur to forskellige output afhængigt af hvor meget af videoen der maskeres: delvise redigeringer, hvor kun en sætning ændres, og resten forbliver uændret; eller generering af hele sætninger, hvor ny bevægelse syntetiseres helt fra bunden.

Modellen trænes via flow matching, som behandler videoredigeringer som en slags sti mellem to versioner af ansigtsbevægelse.

I stedet for at lære at gætte, hvordan et redigeret ansigt skal se ud fra bunden, lærer flowmatching at bevæge sig gradvist og jævnt mellem en støjende pladsholder og den korrekte bevægelse. For at muliggøre dette repræsenterer systemet ansigtsbevægelse som et kompakt sæt tal udtrukket fra hver frame ved hjælp af en version af det førnævnte LivePortrait-system (se skema ovenfor).

Disse bevægelsesvektorer er designet til at beskrive ansigtsudtryk og hovedpositur uden sammenfiltring identitet, således at ændringer i tale kan lokaliseres uden at påvirke personens samlede udseende.

FaceEDiT-træning

For at træne FacEDiT blev hvert videoklip opdelt i en serie af ansigtsbevægelsessnapshots, og hver frame blev parret med det tilsvarende lydstykke. Tilfældige dele af bevægelsesdataene blev derefter skjult, og modellen blev bedt om at gætte, hvordan de manglende bevægelser skulle se ud, ved hjælp af både talen og den omgivende, umaskerede bevægelse som kontekst.

Fordi de maskerede spændvidder og deres positioner varierer fra et træningseksempel til det næste, lærer modellen gradvist at håndtere både små interne redigeringer og længere mellemrum til generering af en fuld sekvens, afhængigt af hvor meget information den får.

Systemets førnævnte Diffusion Transformer lærer at gendanne maskeret bevægelse ved at forfine støjende input over tid. I stedet for at føre tale og bevægelse ind i modellen på én gang, føres lyden ind i hver behandlingsblok gennem krydsopmærksomhed, hvilket hjælper systemet med at matche læbebevægelser mere præcist med den lydlige tale.

For at bevare realismen på tværs af redigeringer er opmærksomheden skævvredet mod tilstødende billeder i stedet for hele tidslinjen, hvilket tvinger modellen til at fokusere på lokal kontinuitet og forhindrer flimren eller bevægelsesspring i kanterne af ændrede områder. Positionsindlejringer (som fortæller modellen, hvor hvert billede vises i sekvensen) hjælper yderligere modellen med at opretholde et naturligt tidsmæssigt flow og kontekst.

Under træningen lærer systemet at forudsige manglende ansigtsbevægelse ved at rekonstruere maskerede spænd baseret på tale og nærliggende umaskeret bevægelse. Ved inferenstidspunktet genbruges den samme opsætning, men maskerne styres nu af redigeringer i talen.

Når et ord eller en sætning indsættes, fjernes eller ændres, lokaliserer systemet det berørte område, maskerer det og regenererer bevægelse, der matcher den nye lyd. Generering af fuld sekvens behandles som et specialtilfælde, hvor hele området maskeres og syntetiseres fra bunden.

Data og test

Systemets rygrad består af 22 lag til diffusionstransformeren, hver med 16 opmærksomhedshoveder og feedforward-dimensioner på 1024 og 2024px. Bevægelses- og udseendefunktioner udvindes ved hjælp af frosset LivePortrait-komponenter og tale kodet via WavLM og modificeret ved hjælp af VoiceCraft.

Et dedikeret projektionslag kortlægger de 786-dimensionelle talefunktioner i DiT'ens latente rum, hvor kun DiT- og projektionsmodulerne trænes fra bunden.

Træningen blev udført under AdamW optimerer med en målindlæringshastighed på 1e‑4, for en million trin, på to A6000 GPU'er (hver med 48 GB VRAM), i alt batch størrelse af otte.

FaceEDiTBench

FacEDiTBench-datasættet indeholder 250 eksempler, hver med et videoklip af den originale og redigerede tale, samt transskriptioner af begge. Videoerne kommer fra tre kilder, med 100 klip fra HDTF, 100 fra Hej 3og 50 fra CelebV-DubHver af dem blev manuelt kontrolleret for at bekræfte, at både lyd og video var tydelige nok til evaluering.

GPT-4o blev brugt til at revidere hver transskription for at skabe grammatisk gyldige redigeringer. Disse reviderede transskriptioner blev sammen med den originale tale sendt til VoiceCraft for at producere ny lyd; og i hvert trin blev både transskriptionen og den genererede tale manuelt gennemgået for kvalitet.

Hver prøve blev mærket med typen af redigering, tidspunktet for ændringen og længden af det ændrede tidsrum, og redigeringerne blev klassificeret som indsættelser, sletninger eller substitutionerAntallet af ændrede ord varierede fra korte redigeringer på 1 til 3 ord, mellemlange redigeringer på 4 til 6 ord og længere redigeringer på 7 til 10 ord.

Tre brugerdefinerede metrikker blev defineret til at evaluere redigeringskvaliteten. Fotometrisk kontinuitet, for at måle, hvor godt belysningen og farven i et redigeret segment passer til den omgivende video, ved at sammenligne forskelle på pixelniveau ved grænserne; bevægelseskontinuitet, for at vurdere konsistensen af ansigtsbevægelser ved at måle ændringer i optisk flow på tværs af redigerede og uredigerede billeder; og identitetsbevarelse, for at vurdere, om motivets udseende forbliver ensartet efter redigering, ved at sammenligne ansigtsindlejringer fra de originale og genererede sekvenser ved hjælp af ArcFace ansigtsgenkendelsesmodel.

Tests

Testmodellen blev trænet på materiale fra de tre ovennævnte datasæt, i alt omkring 200 timers videoindhold, herunder vlogs og film, samt YouTube-videoer i høj opløsning.

For at evaluere redigering af talende ansigter blev FacEDiTBench brugt, udover HDTF-testsplittet, som er blevet en benchmarkstandard for denne række opgaver.

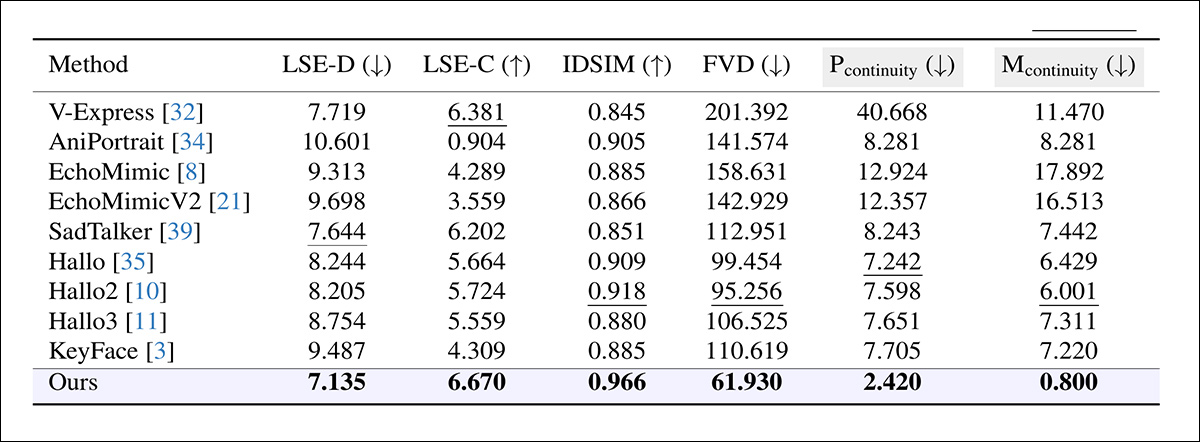

Da der ikke fandtes direkte sammenlignelige systemer, der var i stand til at indkapsle denne form for end-to-end-funktionalitet, valgte forfatterne en række forskellige frameworks, der reproducerede i det mindste noget af målfunktionaliteten og kunne fungere som basislinjer; nemlig, Nøgleflade; EchoMimic; EchoMimicV2; Hej; Hej 2; Hej 3; V-Express; AniPortrætOg TristTalker.

Adskillige etablerede målinger blev også brugt til at vurdere genererings- og redigeringskvalitet, hvor lipsync-nøjagtigheden blev evalueret gennem SyncNet, der rapporterer både den absolutte fejl mellem læbebevægelser og lyd (LSE-D) og en konfidensscore (LSE-C); Fréchet Video Distance (FVD) kvantificerer, hvor realistisk videoen samlet set virkede; og Lærte Perceptual Similarity Metrics (LPIPS), der måler perceptuel lighed mellem genererede og originale billeder.

Til redigering blev alle målinger undtagen LPIPS kun anvendt på det modificerede segment; til generering blev hele videoen evalueret, hvor grænsekontinuitet blev ekskluderet.

Hver model blev lavet til at syntetisere et matchende videosegment, som derefter blev splejset ind i det originale klip (forskerne bemærker, at denne metode ofte introducerede synlige diskontinuiteter, hvor den redigerede sektion mødte det omgivende optagelse). En anden tilgang blev også testet, hvor hele videoen blev regenereret fra den modificerede lyd – men dette overskrev uundgåeligt uredigerede områder og bevarede ikke den originale ydeevne:

Sammenligning af redigeringsydelse på tværs af systemer, der oprindeligt var designet til generering af talende ansigter, hvor FacEDiT overgik alle baselines på tværs af alle metrikker og opnåede lavere lip-sync-fejl (LSE-D), højere synkroniseringssikkerhed (LSE-C), stærkere identitetsbevarelse (IDSIM), større perceptuel realisme (FVD) og glattere overgange på tværs af redigeringsgrænser (Pcontinuity, Mcontinuity). Gråskraverede kolonner fremhæver de vigtigste kriterier for vurdering af grænsekvalitet; fede og understregede værdier angiver henholdsvis de bedste og næstbedste resultater.

Forfatterne kommenterer følgende vedrørende disse resultater:

"[Vores] model overgår betydeligt eksisterende metoder til redigeringsopgaven. Den opnår stærk grænsekontinuitet og høj identitetsbevarelse, hvilket demonstrerer dens evne til at opretholde tidsmæssig og visuel konsistens under redigering. Derudover afspejler dens overlegne lip-sync-nøjagtighed og lave FVD realismen i den syntetiserede video."

Klik for at spille. Resultater, samlet af denne forfatter fra de offentliggjorte videoer på det understøttende projektwebsted. Se kildewebstedet for bedre opløsning.

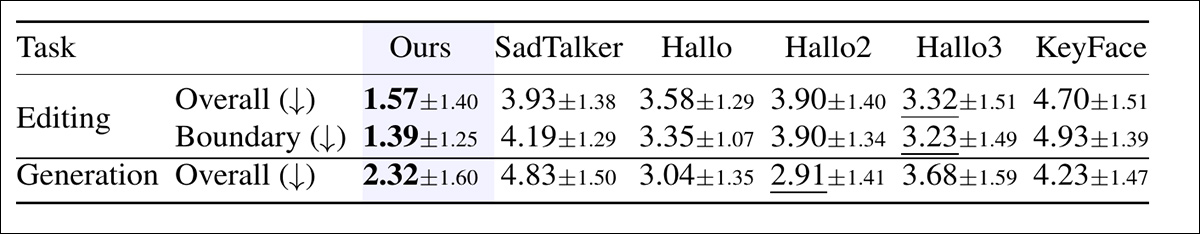

Derudover blev der udført et studie på mennesker for at evaluere den oplevede kvalitet på tværs af både redigering og generering.

For hver sammenligning så deltagerne seks videoer og rangerede dem efter samlet kvalitet, under hensyntagen til lip-sync-nøjagtighed, naturlighed og realisme i hovedbevægelser. I redigeringsforsøg vurderede deltagerne også overgangenes glathed mellem redigerede og uredigerede segmenter:

Gennemsnitlige rangeringer tildelt af menneskelige evaluatorer, hvor lavere betyder bedre. I både redigering og generering bedømte deltagerne, hvor naturlig og velsynkroniseret hver video så ud. I redigering vurderede de også, hvor jævn overgangen var mellem redigeret og uredigeret tale. Fed og understregede tal angiver de to højeste scorer.

I undersøgelsen blev FacEDiT konsekvent rangeret højest med en klar føring, både for redigeringskvalitet og problemfri overgange, og fik også stærke scorer i genereringssammenhængen, hvilket tyder på, at dets målte fordele omsættes til perceptuelt foretrukne output.

På grund af pladsmangel henviser vi læseren til kildeartiklen for yderligere detaljer om ablationsstudier og yderligere tests, der blev udført og rapporteret i det nye arbejde. I virkeligheden har prototypiske forskningstilbud af denne art svært ved at generere meningsfulde testresultater, da selve kernetilbuddet uundgåeligt er en potentiel baseline for senere arbejde.

Konklusion

Selv til inferens kan systemer som dette kræve betydelige computerressourcer på inferenstidspunktet, hvilket gør det vanskeligt for downstream-brugere – her formodentlig VFX-butikker – at holde arbejdet lokalt. Derfor vil tilgange, der kan tilpasses realistiske lokale ressourcer, altid blive foretrukket af udbydere, som er juridisk forpligtet til at beskytte kundernes optagelser og generelle IP.

Det er ikke for at kritisere det nye tilbud, som meget vel kan fungere perfekt under kvantiserede vægte eller andre optimeringer, og som er det første tilbud af sin slags, der tiltrækker mig tilbage til denne forskningskanal i et stykke tid.

Først udgivet onsdag den 17. december 202. Redigeret kl. 20.10 EET, samme dag, for ekstra plads i første afsnit.