Andersonův úhel

Směrem k úplné kontrole v AI Video Generation

Videozákladové modely jako např Hunyuan si Wan 2.1, přestože jsou výkonné, nenabízejí uživatelům takové podrobné ovládání, jaké vyžaduje filmová a televizní produkce (zejména produkce VFX).

V profesionálních studiích vizuálních efektů se modely s otevřeným zdrojovým kódem, jako jsou tyto, spolu s dřívějšími modely založenými na obrázcích (spíše než na videu), jako např. Stabilní difúze, Kandinsky si Proudění, se obvykle používají spolu s řadou podpůrných nástrojů, které přizpůsobují svůj nezpracovaný výstup tak, aby vyhovoval konkrétním kreativním potřebám. Když režisér řekne, "To vypadá skvěle, ale můžeme to udělat trochu víc [n]?" nemůžete odpovědět tím, že model není dostatečně přesný, aby takové požadavky zvládl.

Místo toho bude tým AI VFX používat řadu tradičních CGI a kompoziční techniky spojené s vlastními postupy a pracovními postupy vyvinutými v průběhu času, aby se pokusily posunout limity syntézy videa o něco dále.

Takže analogicky je základní video model velmi podobný výchozí instalaci webového prohlížeče, jako je Chrome; zvládne spoustu věcí ihned po instalaci, ale pokud chcete, aby se přizpůsobil vašim potřebám, a ne naopak, budete potřebovat nějaké pluginy.

Control Freaks

Ve světě syntézy obrazu založené na difúzi je nejdůležitější takový systém třetích stran ControlNet.

ControlNet je technika pro přidání strukturovaného řízení ke generativním modelům založeným na difúzi, která uživatelům umožňuje řídit generování obrazu nebo videa pomocí dalších vstupů, jako je např. okrajové mapy, hloubkové mapynebo představovat informace.

Různé metody ControlNet umožňují generování obrazu lidí a zvířat s využitím metody hloubková segmentace (horní řádek), sémantická segmentace s využitím obrazu (vlevo dole) a generování obrazu lidí a zvířat s využitím metody řízené pózou (vlevo dole).

Místo spoléhání se pouze na textové výzvy zavádí ControlNet samostatné větve neuronové sítě, popř adaptéry, které zpracovávají tyto podmíněné signály při zachování generativních schopností základního modelu.

To umožňuje jemně vyladěné výstupy, které přesněji odpovídají uživatelským specifikacím, což je zvláště užitečné v aplikacích, kde je vyžadována přesná kompozice, struktura nebo řízení pohybu:

S vodící pozicí lze přes ControlNet získat různé typy přesných výstupů. Zdroj: https://arxiv.org/pdf/2302.05543

Avšak rámce založené na adaptérech tohoto druhu působí externě na sadě nervových procesů, které jsou velmi vnitřně zaměřeny. Tyto přístupy mají několik nevýhod.

Nejprve jsou adaptéry trénovány nezávisle, což vede k pobočkové konflikty při kombinaci více adaptérů, což může mít za následek zhoršenou kvalitu generování.

Za druhé, představují redundance parametrů, vyžadující další výpočet a paměť pro každý adaptér, takže škálování je neefektivní.

Za třetí, navzdory své flexibilitě adaptéry často vyrábějí suboptimální výsledky ve srovnání s modely, které jsou plně vyladěný pro generování více podmínek. Tyto problémy způsobují, že metody založené na adaptéru jsou méně účinné pro úlohy vyžadující bezproblémovou integraci více řídicích signálů.

V ideálním případě by byly vyškoleny kapacity ControlNet nativní do modelu, modulárním způsobem, který by mohl pojmout pozdější a velmi očekávané zjevné inovace, jako je simultánní generování videa/audia nebo nativní funkce synchronizace rtů (pro externí zvuk).

V současné době každá další funkcionalita představuje buď postprodukční úlohu, nebo nenativní proceduru, která se musí orientovat v úzce svázaných a citlivých vahách základního modelu, na kterém pracuje.

FullDiT

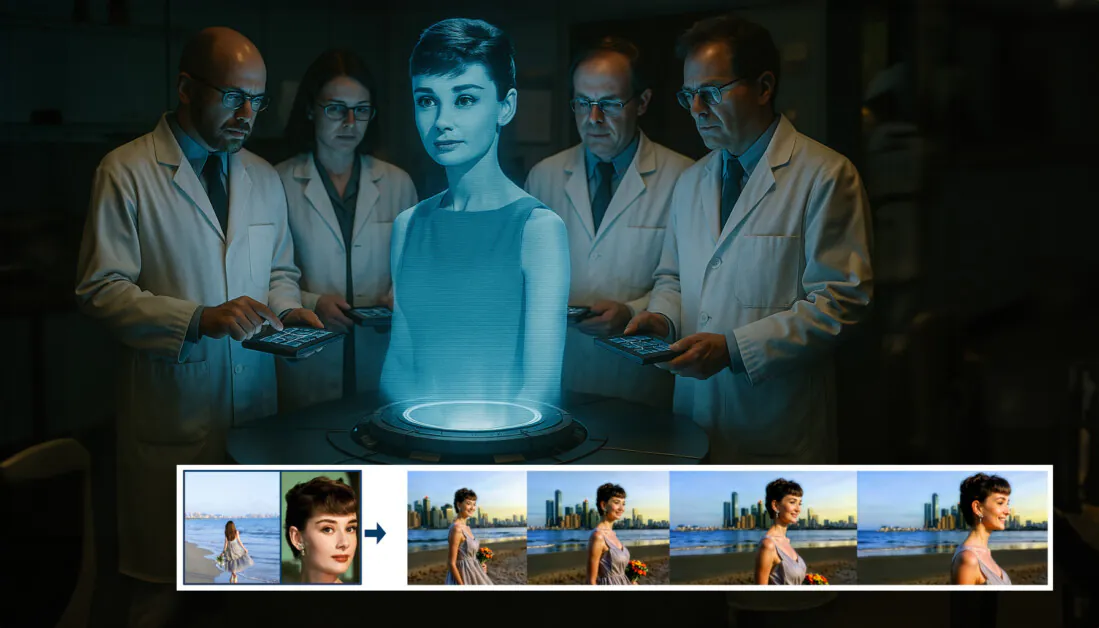

Do této patové situace přichází nová nabídka z Číny, která předpokládá systém, ve kterém jsou opatření ve stylu ControlNet zapékána přímo do generativního video modelu v době školení, namísto toho, aby byla odkázána na dodatečný nápad.

Z nového článku: přístup FullDiT dokáže začlenit vkládání identity, hloubku a pohyb kamery do nativní generace a dokáže shromáždit jakoukoli jejich kombinaci najednou. Zdroj: https://arxiv.org/pdf/2503.19907

Titulovaný FullDiT, nový přístup spojuje víceúkolové podmínky, jako je přenos identity, hloubkové mapování a pohyb kamery, do integrované části trénovaného generativního video modelu, pro který autoři vytvořili prototyp trénovaného modelu, a doprovodných videoklipů na stránky projektu.

V níže uvedeném příkladu vidíme generace, které zahrnují pohyb kamery, informace o identitě a textové informace (tj. vodící textové výzvy uživatele):

Klepnutím přehrajte. Příklady uživatelského vyřazení ve stylu ControlNet pouze s nativním trénovaným modelem základů. Zdroj: https://fulldit.github.io/

Je třeba poznamenat, že autoři nenavrhují svůj experimentální trénovaný model jako funkční základní model, ale spíše jako proof-of-concept pro nativní modely text-to-video (T2V) a image-to-video (I2V), které uživatelům nabízejí více kontroly než jen obrazovou výzvu nebo textovou výzvu.

Protože zatím žádné podobné modely tohoto druhu neexistují, vytvořili výzkumníci nový benchmark s názvem FullBench, pro vyhodnocování multi-task videí a prohlašovat nejmodernější výkon v podobných testech, které vymysleli proti předchozím přístupům. Jelikož však FullBench navrhli sami autoři, jeho objektivita není otestována a jeho datový soubor 1,400 případů může být příliš omezený na širší závěry.

Snad nejzajímavějším aspektem architektury, kterou článek předkládá, je její potenciál začlenit nové typy ovládání. Autoři uvádějí:

„V této práci zkoumáme pouze podmínky řízení kamery, identity a informace o hloubce. Dále jsme nezkoumali další podmínky a modality, jako je zvuk, řeč, mračno bodů, ohraničující rámečky objektů, optický tok atd. Ačkoli návrh FullDiT dokáže bezproblémově integrovat další modality s minimální úpravou architektury, jak rychle a nákladově efektivně přizpůsobit stávající modely novým podmínkám a modalitám, je stále důležitou otázkou, která si zaslouží další zkoumání.“

Ačkoli výzkumníci prezentují FullDiT jako krok vpřed ve víceúkolovém generování videa, je třeba vzít v úvahu, že tato nová práce spíše staví na existujících architekturách, než aby zaváděla zásadně nové paradigma.

Nicméně FullDiT v současné době stojí (pokud vím) samostatně jako model pro video s „pevně zakódovanými“ funkcemi ve stylu ControlNet – a je dobré vidět, že navrhovaná architektura dokáže pojmout i pozdější inovace.

Klepnutím přehrajte. Příklady uživatelem řízených pohybů kamery z místa projektu.

Jedno nový papír je s názvem FullDiT: Multi-Task Video Generative Foundation Model s plnou pozornostía pochází od devíti výzkumníků z Kuaishou Technology a Čínské univerzity v Hong Kongu. Stránka projektu je zde a nová srovnávací data jsou v Hugging Face.

Metoda

Autoři tvrdí, že sjednocený mechanismus pozornosti FullDiT umožňuje silnější učení crossmodální reprezentace tím, že zachycuje prostorové i časové vztahy napříč podmínkami:

Podle nového dokumentu FullDiT integruje více vstupních podmínek prostřednictvím plné sebepozornosti a převádí je do jednotné sekvence. Naproti tomu modely založené na adaptéru (vlevo nahoře) používají samostatné moduly pro každý vstup, což vede k redundanci, konfliktům a slabšímu výkonu.

Na rozdíl od nastavení založených na adaptéru, která zpracovávají každý vstupní tok samostatně, tato struktura sdílené pozornosti zabraňuje konfliktům větví a snižuje režii parametrů. Tvrdí také, že architektura se může škálovat na nové typy vstupů bez zásadního přepracování – a že schéma modelu vykazuje známky zobecnění na kombinace podmínek, které nejsou vidět během tréninku, jako je propojení pohybu kamery s identitou postavy.

Klepnutím přehrajte. Příklady generování identity z místa projektu.

V architektuře FullDiT jsou všechny kondicionační vstupy – jako je text, pohyb kamery, identita a hloubka – nejprve převedeny do jednotného formátu tokenů. Tyto tokeny jsou poté zřetězeny do jediné dlouhé sekvence, která je zpracována prostřednictvím zásobníku transformátor vrstvy využívající plnou sebepozornost. Tento přístup navazuje na předchozí práce jako např Plán Open-Sora si Film Gen.

Tento návrh umožňuje modelu učit se časové a prostorové vztahy společně za všech podmínek. Každý transformátorový blok pracuje v celé sekvenci a umožňuje dynamické interakce mezi modalitami, aniž by se spoléhal na samostatné moduly pro každý vstup – a jak jsme poznamenali, architektura je navržena tak, aby byla rozšiřitelná, takže je mnohem snazší začlenit v budoucnu další řídicí signály bez velkých strukturálních změn.

Síla tří

FullDiT převádí každý řídicí signál do standardizovaného formátu tokenu, takže všechny podmínky mohou být zpracovány společně v rámci jednotného rámce pozornosti. Pro pohyb kamery model kóduje sekvenci vnějších parametrů – jako je poloha a orientace – pro každý snímek. Tyto parametry jsou časově označeny a promítnuty do vkládacích vektorů, které odrážejí časovou povahu signálu.

S informacemi o identitě se zachází odlišně, protože jsou ze své podstaty spíše prostorové než časové. Model používá mapy identity, které označují, které znaky jsou přítomny ve kterých částech každého rámce. Tyto mapy se dělí na skvrnys každým patchem promítnutým do an vkládání který zachycuje podněty prostorové identity a umožňuje modelu přidružit konkrétní oblasti snímku ke konkrétním entitám.

Hloubka je časoprostorový signál a model s ním pracuje rozdělením hloubkových videí do 3D polí, která pokrývají prostor i čas. Tyto záplaty jsou pak vloženy způsobem, který zachovává jejich strukturu napříč snímky.

Po vložení jsou všechny tyto tokeny podmínek (kamera, identita a hloubka) zřetězeny do jediné dlouhé sekvence, což umožňuje FullDiT zpracovávat je společně pomocí plného sebe-pozornost. Tato sdílená reprezentace umožňuje modelu učit se interakce napříč modalitami a časem, aniž by se spoléhal na izolované toky zpracování.

Data a testy

Trénovací přístup FullDiT se spoléhal na selektivně anotované datové sady přizpůsobené každému typu podmiňování, spíše než na požadavek, aby všechny podmínky byly přítomny současně.

Pro textové podmínky se iniciativa řídí přístupem strukturovaných titulků popsaným v dokumentu MiraData projekt.

Sběr videí a anotační kanál z projektu MiraData. Zdroj: https://arxiv.org/pdf/2407.06358

Pro pohyb kamery je Nemovitosti 10 tis dataset byl hlavním zdrojem dat díky vysoce kvalitním anotacím parametrů kamery.

Autoři však pozorovali, že trénování výhradně na souborech dat kamer se statickou scénou, jako je RealEstate10K, mělo tendenci snižovat dynamické pohyby objektů a lidí v generovaných videích. Aby tomu zabránili, provedli další jemné doladění pomocí interních datových sad, které zahrnovaly dynamičtější pohyby kamery.

Anotace identity byly generovány pomocí kanálu vyvinutého pro ConceptMaster projekt, který umožnil efektivní filtrování a extrakci jemnozrnných informací o identitě.

Rámec ConceptMaster je navržen tak, aby řešil problémy s oddělením identity při zachování věrnosti konceptu v přizpůsobených videích. Zdroj: https://arxiv.org/pdf/2501.04698

Hloubkové anotace byly získány z Panda-70M pomocí datové sady Hloubka Cokoli.

Optimalizace prostřednictvím objednávání dat

Autoři také zavedli progresivní tréninkový plán, který zavedl náročnější podmínky dříve v tréninku zajistit, aby model získal robustní reprezentace před přidáním jednodušších úloh. Tréninkový rozkaz vyšel z (souhrnně „Stránka (Stránky)“), a naše postupy pro shromažďování, využívání, uchovávání, ochranu a zpřístupnění takových informací. Tyto zásady platí pro informace, které shromažďujeme na těchto stránkách nebo v e-mailu, textových a jiných elektronických zprávách mezi vámi a těmito stránkami. Rovněž popisují vaše možnosti týkající se využívání vašich osobních údajů, přístupu k nim a jejich opravě. na pokoj podmínky tedy identity, a nakonec hloubka, se snazšími úkoly obecně představenými později as menším počtem příkladů.

Autoři zdůrazňují hodnotu uspořádání pracovní zátěže tímto způsobem:

„Během předškolní fáze jsme si všimli, že náročnější úkoly vyžadují delší dobu školení a měly by být zavedeny dříve v procesu učení. Tyto náročné úkoly zahrnují složité distribuce dat, které se výrazně liší od výstupního videa, což vyžaduje, aby model měl dostatečnou kapacitu pro jejich přesné zachycení a reprezentaci.

„Naopak, příliš brzké zavedení jednodušších úkolů může vést model k tomu, že se jim nejprve bude věnovat, protože poskytují okamžitější zpětnou vazbu k optimalizaci, což brání konvergenci náročnějších úkolů.“

Ilustrace datového tréninkového řádu přijatého výzkumníky, přičemž červená značí větší objem dat.

Po počátečním předběžném tréninku se v závěrečné fázi jemného ladění model dále zdokonalil, aby se zlepšila vizuální kvalita a dynamika pohybu. Poté následovalo školení standardního difúzního rámce*: šum přidaný k latentnímu videu a modelu naučit se to předvídat a odstraňovat, přičemž jako vodítko použijeme vložené tokeny podmínek.

Aby bylo možné efektivně vyhodnotit FullDiT a poskytnout spravedlivé srovnání se stávajícími metodami a při absenci jiného vhodného měřítka, autoři zavedli FullBench, kurátorská sada benchmarků sestávající z 1,400 XNUMX různých testovacích případů.

Instance průzkumníku dat pro nový benchmark FullBench. Zdroj: https://huggingface.co/datasets/KwaiVGI/FullBench

Každý datový bod poskytoval základní pravdivé anotace pro různé kondicionační signály, včetně pohyb kamery, identita, a hloubka.

Metrics

Autoři hodnotili FullDiT pomocí deseti metrik pokrývajících pět hlavních aspektů výkonu: zarovnání textu, ovládání kamery, podobnost identity, přesnost hloubky a obecná kvalita videa.

Zarovnání textu bylo měřeno pomocí CLIP podobnost, zatímco kontrola kamery byla posouzena prostřednictvím chyba otáčení (RotErr), chyba překladu (TransErr), A konzistence pohybu kamery (CamMC), po přiblížení CamI2V (v CameraCtrl projekt).

Podobnost identity byla hodnocena pomocí DINO-I si CLIP-Ia přesnost kontroly hloubky byla kvantifikována pomocí Střední absolutní chyba (MAE).

Kvalita videa byla posuzována pomocí tří metrik z MiraData: podobnost CLIP na úrovni snímku pro plynulost; vzdálenost pohybu založená na optickém toku pro dynamiku; a LAION-Estetické skóre pro vizuální přitažlivost.

Trénink

Autoři trénovali FullDiT pomocí interního (nezveřejněného) modelu difúze textu do videa obsahujícího zhruba jednu miliardu parametrů. Záměrně zvolili skromnou velikost parametru, aby zachovali spravedlivost ve srovnání s předchozími metodami a zajistili reprodukovatelnost.

Jelikož se tréninková videa lišila délkou a rozlišením, autoři každé standardizovali várka změnou velikosti a vložením videa do běžného rozlišení, vzorkováním 77 snímků na sekvenci a použitím aplikované pozornosti a ztrátové masky pro optimalizaci efektivity tréninku.

Jedno Adam Optimalizátor byl použit v a rychlost učení 1 × 10-5 v klastru 64 GPU NVIDIA H800, dohromady tedy 5,120 XNUMX GB VRAM (uvažte, že v komunitách nadšenců pro syntézu, 24GB na RTX 3090 je stále považován za luxusní standard).

Model byl trénován pro přibližně 32,000 20 kroků, zahrnujících až tři identity na video, spolu s 21 snímky podmínek kamery a 77 snímků hloubkových podmínek, obojí rovnoměrně odebrané z celkových XNUMX snímků.

Pro odvození, model generoval videa v rozlišení 384 × 672 pixelů (zhruba pět sekund při 15 snímcích za sekundu) s 50 difuzními inferenčními kroky a pěti stupnicí bez klasifikátoru.

Předchozí metody

Pro hodnocení z kamery na video autoři porovnávali FullDiT s MotionCtrl, CameraCtrl a CamI2V se všemi modely vyškolenými pomocí datové sady RealEstate10k, aby byla zajištěna konzistence a spravedlnost.

Vzhledem k tomu, že při generaci podmíněné identitou nebyly k dispozici žádné srovnatelné modely s více identitami s otevřeným zdrojovým kódem, byl model porovnán s modelem ConceptMaster s 1B parametrem za použití stejných školicích dat a architektury.

U úloh s hloubkou videa byla provedena srovnání s Ctrl-Adaptér si ControlVideo.

Kvantitativní výsledky pro generování videa s jedním úkolem. FullDiT byl porovnán s MotionCtrl, CameraCtrl a CamI2V pro generování z kamery na video; ConceptMaster (verze s parametrem 1B) pro identitu-video; a Ctrl-Adapter a ControlVideo pro hloubku videa. Všechny modely byly hodnoceny pomocí jejich výchozího nastavení. Pro konzistenci bylo z každé metody jednotně odebráno 16 snímků, které odpovídaly výstupní délce předchozích modelů.

Výsledky naznačují, že FullDiT, navzdory tomu, že zpracovává více signálů kondicionování současně, dosáhl špičkového výkonu v metrikách souvisejících s textem, pohybem kamery, identitou a ovládáním hloubky.

V celkových metrikách kvality systém obecně překonal ostatní metody, i když jeho plynulost byla o něco nižší než u ConceptMasteru. Autoři k tomu říkají:

„Jemnost FullDiT je o něco nižší než u ConceptMaster, protože výpočet hladkosti je založen na podobnosti CLIP mezi sousedními snímky. Protože FullDiT vykazuje výrazně vyšší dynamiku ve srovnání s ConceptMaster, je metrika hladkosti ovlivněna velkými rozdíly mezi sousedními snímky.

„Pokud jde o estetické hodnocení, jelikož hodnotící model upřednostňuje obrázky v malířském stylu a ControlVideo obvykle generuje videa v tomto stylu, dosahuje vysokého skóre v estetice.“

Pokud jde o kvalitativní srovnání, může být vhodnější odkázat na ukázková videa na stránce projektu FullDiT, protože příklady PDF jsou nevyhnutelně statické (a také příliš velké na to, aby je bylo možné zde úplně reprodukovat).

První část kvalitativních výsledků v PDF. Další příklady, které jsou příliš rozsáhlé na to, aby je zde bylo možné reprodukovat, naleznete ve zdrojovém dokumentu.

Autoři komentují:

„FullDiT demonstruje vynikající ochranu identity a generuje videa s lepší dynamikou a vizuální kvalitou ve srovnání s [ConceptMaster]. Vzhledem k tomu, že ConceptMaster a FullDiT jsou trénovány na stejné páteři, podtrhuje to účinnost kondiční injekce s plnou pozorností.

„…[Ostatní] výsledky prokazují vynikající ovladatelnost a kvalitu generování FullDiT ve srovnání se stávajícími metodami hloubky-do-video a kamery-do-video.“

Část PDF s příklady výstupu FullDiT s více signály. Další příklady naleznete ve zdrojovém dokumentu a na stránkách projektu.

Proč investovat do čističky vzduchu?

Ačkoli je FullDiT vzrušující vpád do plnohodnotnějšího typu modelu základů videa, je třeba si klást otázku, zda poptávka po nástrojích ve stylu ControlNet někdy ospravedlní implementaci takových funkcí ve velkém měřítku, alespoň pro projekty FOSS, které by bez komerční podpory měly potíže s získáním enormního množství potřebného výpočetního výkonu GPU.

Primárním problémem je, že používání systémů jako Depth a Pose obecně vyžaduje netriviální znalost relativně složitých uživatelských rozhraní, jako je ComfyUI. Zdá se tedy, že funkční model FOSS tohoto druhu s největší pravděpodobností vyvine kádr menších VFX společností, kterým chybí peníze (nebo vůle, vzhledem k tomu, že takové systémy rychle zastarávají modernizací modelů) na to, aby takový model za zavřenými dveřmi spravovaly a trénovaly.

Na druhou stranu, systémy „rent-an-AI“ řízené API mohou být dobře motivované k vývoji jednodušších a uživatelsky přívětivějších interpretačních metod pro modely, do kterých byly přímo natrénovány pomocné řídicí systémy.

Klepnutím přehrajte. Ovládací prvky Depth+Text uložené při generování videa pomocí FullDiT.

* Autoři neuvádějí žádný známý základní model (např. SDXL atd.)

Poprvé publikováno ve čtvrtek 27. března 2025