网络安全

为什么对抗性图像攻击不是玩笑

在过去的五年里,用精心制作的对抗性图像来攻击图像识别系统一直被认为是一种有趣但微不足道的概念验证。 然而,澳大利亚的新研究表明,商业人工智能项目随意使用高度流行的图像数据集可能会造成持久的新安全问题。

几年来,阿德莱德大学的一组学者一直试图解释一些关于基于人工智能的图像识别系统的未来的真正重要的事情。

这个问题很难解决(而且非常昂贵) 现在可以做些什么一旦图像识别研究的当前趋势在 5 到 10 年后完全发展为商业化和工业化部署,补救的成本将高得不合理。

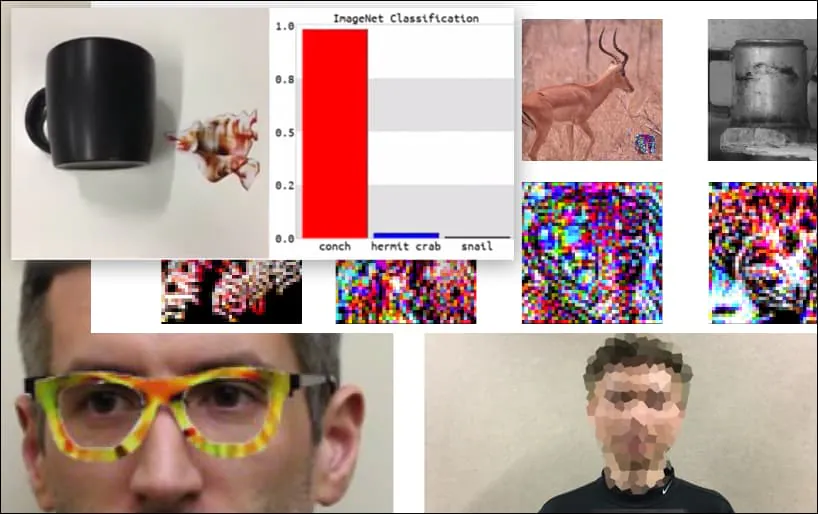

在我们开始讨论之前,让我们先来看看一朵被归类为巴拉克·奥巴马总统的花,这是该团队在 项目页:

来源:https://www.youtube.com/watch?v=Klepca1Ny3c

在上图中,一个能够清晰识别巴拉克·奥巴马的面部识别系统,却被一个匿名男子以 80% 的准确率误认为是巴拉克·奥巴马,尽管他手里拿着一张精心制作、打印出来的花朵对抗图像。该系统甚至不在乎这张“假脸”是在对方胸前,而不是肩膀上。

尽管令人印象深刻的是,研究人员能够通过生成连贯图像(一朵花)而不是通常的随机噪声来完成这种身份捕获,但在计算机视觉的安全研究中,类似这样的愚蠢漏洞似乎经常出现。例如,那些能够欺骗人脸识别的奇怪图案的眼镜 早在2016,或特制的对抗性图像 尝试重写路标.

如果你感兴趣的话,上面例子中受到攻击的卷积神经网络 (CNN) 模型是 VGGFace (VGG-16),在哥伦比亚大学的 PubFig 数据集上进行训练。研究人员开发的其他攻击样本使用了不同的资源,并以不同的组合进行训练。

在 ImageNet 上的 WideResNet50 模型中,键盘被重新分类为海螺。 研究人员还确保该模型对海螺没有偏见。 请访问 https://www.youtube.com/watch?v=dhTTjjrxIcU 查看完整视频以了解扩展和其他演示

图像识别作为新兴的攻击媒介

研究人员概述和阐述的众多令人印象深刻的攻击并非针对单个数据集或使用它们的特定机器学习架构。它们也无法通过切换数据集或模型、重新训练模型或任何其他导致机器学习从业者对此类零星演示嗤之以鼻的“简单”补救措施来轻松防御。

相反,阿德莱德队的功绩体现了 中枢弱点 在当前图像识别AI开发的整个架构中; 这一弱点可能会使许多未来的图像识别系统容易被攻击者操纵,并使任何后续的防御措施处于不利地位。

想象一下,最新的对抗性攻击图像(例如上面的花朵)作为“零日漏洞”添加到未来的安全系统中,就像当前的反恶意软件和防病毒框架每天更新其病毒定义一样。

新型对抗性图像攻击的可能性是无穷无尽的,因为系统的基础架构没有预见到下游问题,正如所发生的 通过互联网, 千年虫 和 比萨斜塔.

那么,我们以什么方式为此设置场景呢?

获取攻击数据

诸如上文“花”示例之类的对抗性图像是通过访问用于训练计算机模型的图像数据集生成的。您无需拥有对训练数据(或模型架构)的“特权”访问权限,因为最流行的数据集(以及许多经过训练的模型)在强大且不断更新的 torrent 场景中广泛可用。

例如,计算机视觉数据集 ImageNet 中令人尊敬的巨人 可用于洪流 在所有的多次迭代中,绕过了它的惯例 限制,并提供关键的次要元素,例如 验证集.

资料来源:https://academictorrents.com

如果你有数据,你就可以(正如阿德莱德研究人员所观察到的)有效地对任何流行的数据集进行“逆向工程”,例如 城市景观 或 国际金融交易会.

以 PubFig 为例,也就是之前例子中的“奥巴马之花”数据集,哥伦比亚大学通过指导研究人员如何 复制 通过精选链接获取数据集,而不是直接提供汇编,观察 “这似乎是其他大型网络数据库的发展方式”.

大多数情况下,这不是必需的:Kaggle 估计 计算机视觉中十个最流行的图像数据集是:CIFAR-10 和 CIFAR-100(都是 可直接下载); CALTECH-101 和 256(均可用,且目前均以种子形式提供); MNIST(正式可用,也在种子上); ImageNet(见上文); 帕斯卡 VOC (可使用,也在种子上); 可可女士(可使用,以及种子); 运动-1M (可使用); 和 YouTube-8M(可使用).

这种可用性也代表了可用的计算机视觉图像数据集的更广泛的范围,因为在“不发表就灭亡”的开源开发文化中,默默无闻就意味着死亡。

无论如何,稀缺性 管理 新数据集、图像集开发的高成本、对“旧收藏”的依赖,以及 只需调整旧数据集 所有这些都加剧了阿德莱德新论文中概述的问题。

对对抗性图像攻击方法的典型批评

机器学习工程师对最新对抗性图像攻击技术的有效性最常见和持续的批评是,这种攻击是 特定于特定数据集、特定模型或两者;它不能“推广”到其他系统;因此,它仅代表一种微不足道的威胁。

第二个最常见的抱怨是对抗性图像攻击是 “白盒”,这意味着您需要直接访问训练环境或数据。 在大多数情况下,这确实是一种不太可能发生的情况——例如,如果您想利用面部识别系统的训练过程 伦敦警察厅,你必须通过黑客手段进入 NEC,使用控制台或斧头。

热门计算机视觉数据集的长期“DNA”

关于第一个批评,我们不仅应该考虑到少数计算机视觉数据集逐年在行业中占据主导地位(即用于多种类型物体的 ImageNet、用于驾驶场景的 CityScapes 以及 FF总部 它们不仅可用于面部识别),而且作为简单的带注释的图像数据,它们具有“平台无关性”且可高度转移性。

根据其功能,任何计算机视觉训练架构都会发现 一些 ImageNet 数据集中的对象和类的特征。 某些架构可能会比其他架构发现更多功能,或者比其他架构建立更有用的连接,但是 所有 应该至少找到最高级别的特征:

正是这些“高级”特征区分并“指纹化”了数据集,并且是挂载长期对抗性图像攻击方法的可靠“钩子”,该方法可以跨越不同的系统,并随着“旧”数据集在新研究和新产品中的延续而与“旧”数据集同步增长。

更复杂的架构将产生更准确、更精细的标识、特征和类别:

然而,对抗性攻击生成器越依赖这些 降低 特征(例如“年轻白人男性”而不是“脸”),在交叉或后续使用 不同的版本 原始数据集的 - 例如子集或过滤集,其中完整数据集中的许多原始图像不存在:

对“归零”预训练模型的对抗性攻击

如果您只是下载一个最初在非常流行的数据集上训练的预训练模型,并为其提供全新的数据,那么情况又如何呢?

该模型已经在(例如)ImageNet 上进行了训练,剩下的就是 权重,它可能需要几周或几个月的时间来训练,现在可以帮助您识别与原始(现在不存在)数据中存在的类似对象。

这些重量很有价值。 没有数据 or 权重,本质上是一个没有数据的空架构。你必须从头开始训练它,这会耗费大量的时间和计算资源,就像原作者那样(可能要使用更强大的硬件,并且预算也比你现有的预算更高)。

问题在于,这些权重本身就已经相当成熟且具有弹性。虽然它们在训练中会有所调整,但它们在新数据上的表现将与在原始数据上的表现类似,从而产生对抗性攻击系统可以重新利用的标志性特征。

从长远来看,这也保留了计算机视觉数据集的“DNA”, 十二岁或以上,并且可能经历了从开源工作到商业化部署的显着演变——即使原始训练数据在项目开始时就被完全抛弃了。 其中一些商业部署可能需要数年时间才能实现。

无需白盒

关于对抗性图像攻击系统的第二个常见批评,新论文的作者发现,他们用精心制作的花朵图像欺骗识别系统的能力在多种架构中具有高度可移植性。

在观察到他们的“通用自然对抗补丁”(TnT)方法是第一个使用可识别图像(而不是随机扰动噪声)来欺骗图像识别系统的方法的同时,作者还指出:

'[TnTs] 可有效对抗多种最先进的分类器,包括广泛使用的分类器 WideResNet50 在大规模视觉识别任务中 影像网 人脸识别任务中的数据集到VGG-face模型 酒吧无花果 两者中的数据集 针对 与 无目标 攻击。

TnT 可以拥有: i) 通过木马攻击方法中使用的触发器可实现的自然主义; ii) 的概括性和可移植性 对抗性例子 到其他网络。

“这引发了对已部署的 DNN 以及未来 DNN 部署的安全性担忧,攻击者可以使用不显眼的自然物体补丁来误导神经网络系统,而不会篡改模型并冒被发现的风险。”

作者建议采用传统的对策,例如降低 Clean Acc 的性能。 理论上可以提供一些针对 TnT 补丁的防御,但是 “TnT 仍然可以成功绕过这种 SOTA 可证明的防御方法,并且大多数防御系统的鲁棒性达到 0%”。

可能的其他解决方案包括 联合学习其中贡献图像的来源受到保护,以及可以在训练时直接“加密”数据的新方法,例如 最近建议 由南京航空航天大学主办。

即使在这些情况下,真正进行培训也很重要 新 图像数据——目前,最流行的 CV 数据集中的图像和相关注释已经深深嵌入到世界各地的开发周期中,它们看起来更像软件而不是数据;而这些软件通常多年来都没有进行过显著的更新。

结语

对抗性图像攻击不仅可以通过开源机器学习实践实现,还可以通过企业人工智能开发文化实现,这种文化倾向于重复使用成熟的计算机视觉数据集,原因如下:它们已被证明是有效的;它们比“从头开始”便宜得多;并且它们由学术界和工业界的先锋思想和组织维护和更新,其资金和人员水平是单个公司难以复制的。

此外,在许多情况下,数据不是原始的(与城市景观不同),这些图像是在最近有关隐私和数据收集实践的争议之前收集的,使这些旧数据集处于一种 半合法的炼狱 从公司的角度来看,这可能看起来像一个令人欣慰的“安全港”。

TNT 攻击! 针对深度神经网络系统的通用自然对抗补丁 由阿德莱德大学的 Bao Gia Doan、薛民辉、Ehsan Abbasnejad、Damith C. Ranasinghe 以及罗格斯大学计算机科学系的 Shiqing Ma 共同撰写。

更新于 1 年 2021 月 7 日上午 06:2 GMT+XNUMX – 更正了拼写错误。