人工智能

UniTune:谷歌的替代神经图像编辑技术

谷歌研究似乎正在从多个方面攻击基于文本的图像编辑,并且大概正在等待看看“会发生什么”。 本周发布的热门产品 意象纸,这家搜索巨头提出了一种额外的基于潜在扩散的方法,通过文本命令对图像执行原本不可能的基于人工智能的编辑,这次称为 优调.

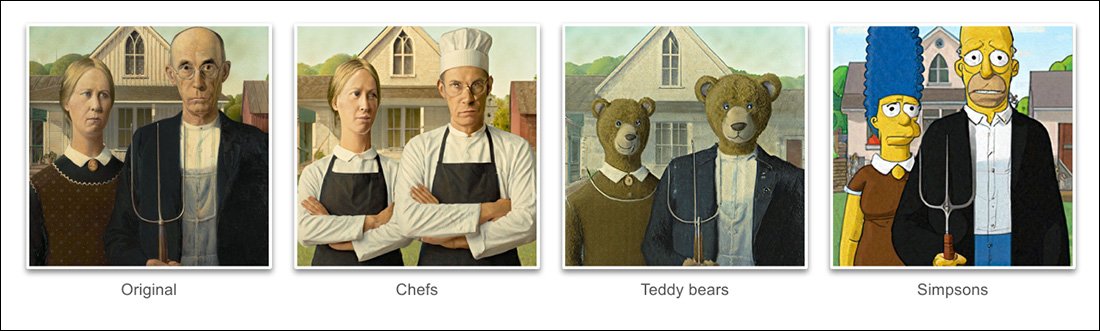

根据项目中给出的示例 新文, UniTune 取得了非凡的程度 解开 来自实际硬图像内容的语义姿势和想法:

UniTune 对语义组合的掌握非常出色。 请注意,在最上面一排图片中,两个人的脸部并未因源图像其余部分(右)的非凡变换而扭曲。 资料来源:https://arxiv.org/pdf/2210.09477.pdf

正如《稳定扩散》粉丝现在已经了解到的那样,对图片的部分部分进行编辑而不会对图像的其余部分产生不利影响可能是一项棘手的操作,有时甚至是不可能的操作。 尽管流行的发行版例如 自动1111 可以为本地和受限编辑创建蒙版,但该过程是曲折的且常常不可预测。

至少对于计算机视觉从业者来说,显而易见的答案是插入一层 语义分割 它能够在没有用户干预的情况下识别和隔离图像中的对象,事实上,最近沿着这个思路出现了一些新的举措。

另一个 可能性 锁定混乱和纠缠的神经图像编辑操作的方法是利用 OpenAI 颇具影响力的对比语言-图像预训练(CLIP) 模块,它是 DALL-E 2 和稳定扩散等潜在扩散模型的核心,在文本到图像模型准备将解释的渲染发送回用户时充当过滤器。 在这种情况下,CLIP 应充当哨兵和质量控制模块,拒绝格式错误或其他不合适的渲染。 这是 即将设立 (Discord 链接)位于 Stability.ai 的 DreamStudio API 驱动门户。

然而,由于 CLIP 可以说是这种情况下的罪魁祸首和解决方案(因为它本质上还告知了图像的演变方式),并且由于硬件要求可能超出最终用户本地可用的硬件要求,这种方法可能并不理想。

压缩语言

相反,提议的 UniTune 会“微调”现有的扩散模型——在本例中是谷歌自己的 Imagen,尽管研究人员表示该方法与其他潜在扩散架构兼容——以便将一个独特的令牌注入其中,可以调用该模型将其包含在文本提示中。

从表面上看,这听起来像谷歌 梦想展位目前,Stable Diffusion 粉丝和开发者非常着迷,它可以根据少量源图片将新颖的角色或物体注入现有的检查点,通常在不到一个小时的时间内; 或者像 文本倒装,它为检查点创建“sidecar”文件,然后将其视为最初训练到模型中的文件,并且可以通过修改其文本分类器来利用模型自身的大量资源,从而产生一个很小的文件(与DreamBooth 的至少 2GB 修剪检查点)。

事实上,研究人员断言,UniTune 拒绝了这两种方法。 他们发现 Textual Inversion 遗漏了太多重要细节,而 DreamBooth “表现更差,花费的时间更长” 比他们最终确定的解决方案更重要。

尽管如此,UniTune 使用与 DreamBooth 相同的封装语义“元提示”方法,通过培训师选择的独特单词召唤经过训练的更改,这不会与当前经过艰苦训练的公开发布模型中存在的任何术语发生冲突。

“为了执行编辑操作,我们使用提示“[rare_tokens] edit_prompt”(例如“beikkpic 餐馆里的两只狗”或“beikkpic a minion”)对微调后的模型进行采样。”

流程

尽管令人费解的是,为什么 Google 在同一周内收到了两篇在最终功能方面几乎相同的论文,尽管这两项举措之间存在大量相似之处,但 UniTune 和 Imagic 之间至少存在一个明显的区别:后者使用“未压缩”的自然语言提示来指导图像编辑操作,而 UniTune 采用独特的 DreamBooth 风格标记进行训练。

因此,如果您正在使用 Imagic 进行编辑并希望实现这种性质的转换......

..在 Imagic 中,您需要输入 “第三人称,坐在背景中,作为一个可爱的毛茸茸的怪物”.

等效的 UniTune 命令是 “后面的那个人是[x]”,其中 x 任何奇怪而独特的词都与毛茸茸的怪物角色相关的经过严格训练的概念绑定在一起。

尽管将许多图像输入到 DreamBooth 或 Textual Inversion 中,目的是创建可以控制为多种姿势的 Deepfake 风格的抽象,但 UniTune 和 Imagic 都将单个图像输入到系统中 - 原始的原始图像。

这类似于过去几年许多基于 GAN 的编辑工具的操作方式——将输入图像转换为 GAN 潜在空间中的潜在代码,然后对这些代码进行寻址并将其发送到潜在空间的其他部分。修改空间(即输入一个年轻的黑发人的图片并通过与“老”或“金发”等相关的潜在代码来投影它)。

然而,通过比较,在扩散模型中并通过这种方法得到的结果相当惊人地准确,并且远没有那么模糊:

微调过程

UniTune 方法本质上是通过扩散模型发送原始图像,并使用一组训练到模型中的可用数据存储库来修改原始图像。 实际上,您现在可以使用稳定扩散来做到这一点 图像2图像 功能 - 但并非没有扭曲或以某种方式改变您希望保留的图像部分。

在 UniTune 过程中,系统 微调d,也就是说 UniTune 强制模型恢复训练,其中大部分层都未冻结(见下文)。 在大多数情况下,微调会降低整体性能 一般 来之不易的高性能模型的损失值有利于注入或完善需要创建或增强的其他一些方面。

然而,对于 UniTune 来说,所执行的模型副本虽然可能重达几 GB 或更多,但将被视为一次性抵押品“外壳”,并在流程结束时被丢弃,只服务于单一目标。 这种随意的数据量正在成为 DreamBooth 粉丝的日常存储危机,他们自己的模型即使经过修剪,每个主题也不少于 2GB。

与 Imagic 一样,UniTune 中的主要调整发生在 Imagen 中三层中的较低两层(基础 64px、64px>256px 和 256px>1024px)。 与 Imagic 不同的是,研究人员看到了优化最后一个也是最大的超分辨率层的调整的一些潜在价值(尽管他们还没有尝试过)。

对于最低的 64px 层,模型在训练期间偏向于基础图像,将多个重复的图像/文本对输入到系统中,以批量大小 128 进行 4 次迭代,并且 适配器 作为损失函数,学习率为 0.0001。 虽然 T5编码器 在此微调期间单独被冻结,在 Imagen 的初级训练期间也被冻结

然后,使用 Imagen 原始训练中使用的相同噪声增强程序,对 64>256px 层重复上述操作。

打样

有许多可能的采样方法可以从微调模型中引出所做的更改,包括无分类器指导(CFG),也是稳定扩散的支柱。 CFG 基本上定义了模型可以自由“遵循其想象力”并探索渲染可能性的程度 - 或者,在较低的设置下,它应遵循输入源数据的程度,并进行较少的彻底或显着的更改。

研究人员还进行了实验 SD编辑的“晚启动”技术,鼓励系统从一开始就只是部分“噪音”,从而保留原始细节,而是保持其基本特征。 尽管研究人员仅在最低层(64 像素)上使用了此技术,但他们相信这在未来可能是一种有用的辅助采样技术。

研究人员还利用 提示到提示 作为附加的基于文本的技术来调节模型:

在“提示提示”设置中,我们发现一种称为“提示指导”的技术对于调整保真度和表现力特别有帮助。

“提示指导与无分类器指导类似,只是基线是不同的提示而不是无条件模型。 这引导模型走向两个提示之间的增量。

然而,作者指出,只有在 CFG 未能获得预期结果的情况下,偶尔才需要及时指导。

UniTune 开发过程中遇到的另一种新颖的采样方法是 插值,其中图像的区域足够明显,原始图像和更改后的图像在构图上非常相似,从而允许使用更“朴素”的插值。

作者认为,对于大量目标源图像,插值可能会非常有效,因此可以将其用作默认设置,并且还观察到,在复杂遮挡无法实现的情况下,插值有能力实现非凡的变换。需要采取更加深入的方式进行谈判。

UniTune 可以在有或没有编辑掩码的情况下执行本地编辑,但也可以单方面决定编辑位置,具有解释能力和源输入数据的强大本质化的不寻常组合:

在第二列最上面的图像中,负责插入“背景中的红色火车”的 UniTune 将其放置在适当且真实的位置。 请注意,在其他示例中,即使在图像的像素内容和核心样式发生巨大变化的情况下,如何保持源图像的语义完整性。

潜伏

尽管任何新系统的第一次迭代都会很慢,并且社区参与或企业承诺(通常不会两者兼而有之)最终可能会加速和优化资源密集型例程,但 UniTune 和 Imagic 都在执行一些操作为了创建这些令人惊叹的编辑,需要相当大的机器学习操作,而且这样一个资源匮乏的过程在多大程度上可以缩小到国内使用,而不是 API 驱动的访问(尽管后者可能更适合 Google),这是值得怀疑的)。

目前,在 T3 GPU 上,从输入到结果的往返时间约为 4 分钟,还有大约 30 秒的额外时间用于推理(根据任何推理例程)。 作者承认这是高延迟,很难称得上是“交互式”,但他们也指出,一旦最初调整,模型就可以进行进一步编辑,直到用户完成该过程,从而减少了每次编辑时间。

首次发布于 21 年 2022 月 XNUMX 日。