Штучний Інтелект

Повний посібник із тонкого налаштування великих мовних моделей

By

Ааюш МітталЗміст

Великі мовні моделі (LLM), такі як GPT-4, LaMDA, PaLM та інші, захопили світ своєю дивовижною здатністю розуміти та генерувати текст, схожий на людину, на широке коло тем. Ці моделі попередньо навчені на масивних наборах даних, що містять мільярди слів з Інтернету, книг та інших джерел.

Цей етап попереднього навчання наповнює моделі широкими загальними знаннями про мову, теми, здібності до міркування та навіть певні упередження, присутні в навчальних даних. Однак, незважаючи на їх неймовірну широту, цим попередньо підготовленим LLM не вистачає спеціалізованих знань для конкретних областей або завдань.

Ось тут і з’являється тонке налаштування – процес адаптації попередньо навченого LLM для досягнення успіху в певній програмі чи випадку використання. Шляхом подальшого навчання моделі на меншому наборі даних для конкретного завдання ми можемо налаштувати її можливості відповідно до нюансів і вимог цієї області.

Тонка настройка аналогічна передачі широких знань високоосвіченого широкого фахівця для створення фахівця в певній галузі. У цьому посібнику ми розглянемо, що, чому та як потрібно тонко налаштовувати LLM.

Що таке тонке налаштування?

В основі тонка настройка передбачає взяття великої попередньо навченої моделі та оновлення її параметрів за допомогою другої фази навчання на наборі даних, адаптованому до вашого цільового завдання чи домену. Це дозволяє моделі вивчити й засвоїти нюанси, шаблони та цілі, характерні для цієї вужчої області.

У той час як попереднє навчання забезпечує широке розуміння мови з величезного та різноманітного текстового корпусу, точне налаштування спеціалізується на цій загальній компетенції. Це те саме, що взяти людину епохи Відродження та сформувати з неї експерта галузі.

Вагові коефіцієнти попередньо підготовленої моделі, які кодують її загальні знання, використовуються як відправна точка або ініціалізація для процесу тонкого налаштування. Потім модель навчається далі, але цього разу на прикладах, які безпосередньо стосуються кінцевої програми.

Піддаючи модель цьому спеціалізованому розповсюдженню даних і відповідно налаштовуючи параметри моделі, ми робимо LLM більш точним і ефективним для цільового сценарію використання, водночас користуючись широкими попередньо навченими можливостями як основою.

Навіщо проводити тонку настройку LLM?

Є кілька ключових причин, чому вам може знадобитися точно налаштувати велику мовну модель:

- Налаштування домену: Кожна сфера, від юриспруденції до медицини та програмної інженерії, має свої нюанси мовних умов, жаргону та контексту. Тонка настройка дозволяє налаштувати загальну модель для розуміння та створення тексту, адаптованого до конкретної області.

- Спеціалізація завдання: LLMs можуть бути налаштовані для різних завдань обробки природної мови, таких як резюмування тексту, машинний переклад, відповіді на запитання тощо. Ця спеціалізація підвищує ефективність виконання цільового завдання.

- Відповідність даних: Суворо регульовані галузі, такі як охорона здоров’я та фінанси, мають суворі вимоги щодо конфіденційності даних. Тонке налаштування дозволяє навчати LLM на закритих організаційних даних, одночасно захищаючи конфіденційну інформацію.

- Обмежені позначені дані: Отримання великих позначених наборів даних для навчальних моделей з нуля може бути складним завданням. Тонка настройка дозволяє досягти високої продуктивності завдання з обмежених контрольованих прикладів шляхом використання можливостей попередньо навченої моделі.

- Оновлення моделі: коли нові дані з часом стають доступними в домені, ви можете додатково налаштувати моделі, щоб включити останні знання та можливості.

- Пом'якшення упереджень: LLMs можуть підхопити суспільні упередження з широких даних перед навчанням. Точне налаштування підібраних наборів даних може допомогти зменшити та виправити ці небажані упередження.

По суті, точне налаштування долає розрив між загальною широкою моделлю та зосередженими вимогами спеціалізованої програми. Це підвищує точність, безпеку та релевантність вихідних даних моделі для цільових випадків використання.

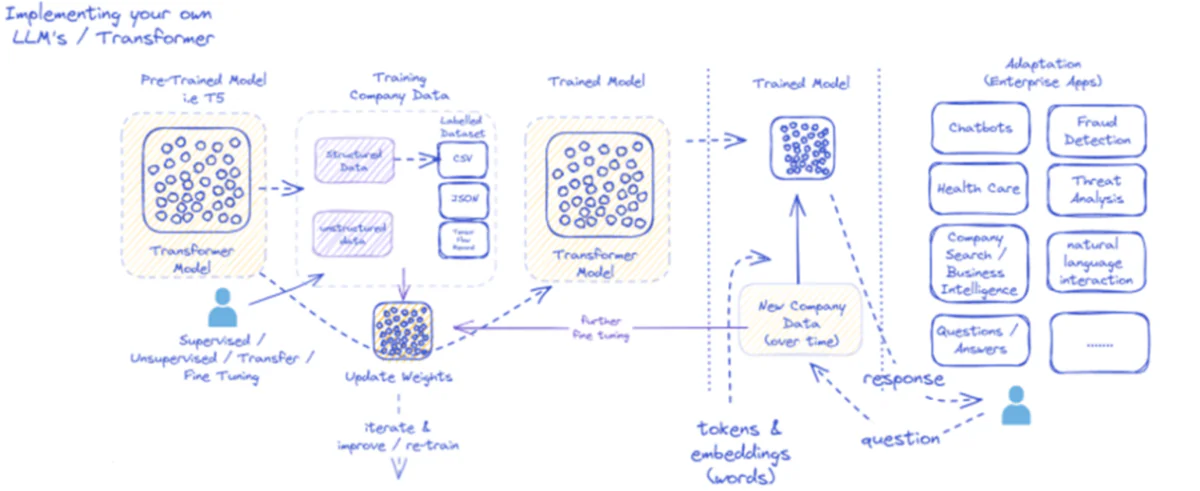

Надана діаграма описує процес впровадження та використання великих мовних моделей (LLM) спеціально для корпоративних програм. Спочатку в попередньо навчену модель, як-от T5, надходять структуровані та неструктуровані дані компанії, які можуть надходити в різних форматах, наприклад CSV або JSON. Ці дані проходять контрольовані, неконтрольовані процеси або процеси точного налаштування передачі, підвищуючи релевантність моделі конкретним потребам компанії.

Після точного налаштування моделі за допомогою даних компанії її ваги відповідно оновлюються. Потім навчена модель повторює подальші цикли навчання, постійно покращуючи свої відповіді з часом за допомогою нових даних компанії. Процес є ітеративним і динамічним, з вивченням моделі та перенавчанням для адаптації до змінних моделей даних.

Вихідні дані цієї навченої моделі — маркери та вбудовування, що представляють слова — потім розгортаються для різних корпоративних програм. Ці програми можуть варіюватися від чат-ботів до охорони здоров’я, кожна з яких вимагає від моделі розуміння галузевих запитів і відповідей на них. У сфері фінансів програми включають виявлення шахрайства та аналіз загроз; в охороні здоров'я моделі можуть допомогти пацієнтам із запитами та діагностикою.

Здатність навченої моделі обробляти нові дані компанії та реагувати на них з часом забезпечує збереження та зростання її корисності. У результаті корпоративні користувачі можуть взаємодіяти з моделлю за допомогою програм, ставлячи запитання та отримуючи обґрунтовані відповіді, які відображають навчання моделі та її тонке налаштування даних, що стосуються предметної області.

Ця інфраструктура підтримує широкий спектр корпоративних додатків, демонструючи універсальність і адаптивність LLM за належного впровадження та підтримки в бізнес-контексті.

Підходи до тонкого налаштування

Є дві основні стратегії, коли справа доходить до тонкого налаштування великих мовних моделей:

1) Повне тонке налаштування моделі

У підході повного тонкого налаштування всі параметри (ваги та зміщення) попередньо навченої моделі оновлюються під час другого етапу навчання. Модель піддається набору даних із мітками для конкретного завдання, і стандартний процес навчання оптимізує всю модель для цього розподілу даних.

Це дозволяє моделі вносити більш комплексні коригування та цілісно адаптуватися до цільового завдання чи домену. Однак повне тонке налаштування має деякі недоліки:

- Це вимагає значних обчислювальних ресурсів і часу для навчання, подібно до фази попереднього навчання.

- Вимоги до зберігання високі, оскільки вам потрібно підтримувати окрему точно налаштовану копію моделі для кожного завдання.

- Існує ризик «катастрофічного забуття», коли тонке налаштування призводить до того, що модель втрачає деякі загальні можливості, набуті під час попереднього навчання.

Незважаючи на ці обмеження, повне тонке налаштування залишається потужним і широко використовуваним методом, коли дозволяють ресурси та цільове завдання значно відрізняється від загальної мови.

2) Ефективні методи тонкого налаштування

Щоб подолати обчислювальні проблеми повного тонкого налаштування, дослідники розробили ефективні стратегії, які оновлюють лише невелику підмножину параметрів моделі під час тонкого налаштування. Ці параметрично ефективні методи встановлюють баланс між спеціалізацією та зменшенням вимог до ресурсів.

Деякі популярні ефективні методи тонкого налаштування включають:

Налаштування префіксів: Тут представлено та навчено невелику кількість векторів, специфічних для завдання, або «префіксів», щоб зумовити увагу попередньо навченої моделі для цільового завдання. Лише ці префікси оновлюються під час тонкого налаштування.

LoRA (адаптація низького рангу): Лора вводить матриці низького рангу, які можна навчити, у кожен шар попередньо навченої моделі під час тонкого налаштування. Ці невеликі коригування рангу допомагають спеціалізувати модель із набагато меншою кількістю параметрів, які можна навчити, ніж повне тонке налаштування.

Звичайно, я можу надати детальне пояснення LoRA (адаптації низького рангу) разом із математичним формулюванням і прикладами коду. LoRA — це популярна методика точного налаштування параметрів (PEFT), яка набула значного поширення в області адаптації великої мовної моделі (LLM).

Що таке LoRA?

LoRA — це метод тонкого налаштування, який вводить невелику кількість параметрів, які можна навчити, до попередньо навченого LLM, що дозволяє ефективно адаптуватися до наступних завдань, зберігаючи при цьому більшість знань початкової моделі. Замість тонкого налаштування всіх параметрів LLM, LoRA вводить специфічні для завдання матриці низького рангу в шари моделі, забезпечуючи значну економію обчислень і пам’яті під час процесу тонкого налаштування.

Математична формулювання

LoRA (адаптація низького рангу) — це метод тонкого налаштування великих мовних моделей (LLM), який вводить оновлення низького рангу до вагових матриць. Для вагової матриці 0∈W0∈Rd×k, LoRA додає матрицю низького рангу BA, С A∈Rr×k та B∈Rd×r, Де r це ранг. Цей підхід значно зменшує кількість параметрів, які можна навчити, забезпечуючи ефективну адаптацію до наступних завдань з мінімальними обчислювальними ресурсами. Оновлена вагова матриця представлена W=W0+B⋅A.

Це оновлення низького рангу можна інтерпретувати як зміну вихідної вагової матриці $W_{0}$ шляхом додавання матриці низького рангу $BA$. Ключова перевага цього формулювання полягає в тому, що замість оновлення всіх $d \times k$ параметрів у $W_{0}$ LoRA потрібно оптимізувати лише параметри $r \times (d + k)$ у $A$ і $B $, значно зменшуючи кількість параметрів, які можна навчити.

Ось приклад у Python із використанням peft бібліотека для застосування LoRA до попередньо навченого LLM для класифікації тексту:

</div> <div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color="">from</span> transformers <span class="token" data-darkreader-inline-color="">import</span> AutoModelForSequenceClassification </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color="">from</span> peft <span class="token" data-darkreader-inline-color="">import</span> get_peft_model<span class="token" data-darkreader-inline-color="">,</span> LoraConfig<span class="token" data-darkreader-inline-color="">,</span> TaskType </code></div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Load pre-trained model</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color="">model <span class="token" data-darkreader-inline-color="">=</span> AutoModelForSequenceClassification<span class="token" data-darkreader-inline-color="">.</span>from_pretrained<span class="token" data-darkreader-inline-color="">(</span><span class="token" data-darkreader-inline-color="">"bert-base-uncased"</span><span class="token" data-darkreader-inline-color="">,</span> num_labels<span class="token" data-darkreader-inline-color="">=</span><span class="token" data-darkreader-inline-color="">2</span><span class="token" data-darkreader-inline-color="">)</span> </code></div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Define LoRA configuration</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color="">peft_config <span class="token" data-darkreader-inline-color="">=</span> LoraConfig<span class="token" data-darkreader-inline-color="">(</span>task_type<span class="token" data-darkreader-inline-color="">=</span>TaskType<span class="token" data-darkreader-inline-color="">.</span>SEQ_CLS<span class="token" data-darkreader-inline-color="">, </span>r<span class="token" data-darkreader-inline-color="">=</span><span class="token" data-darkreader-inline-color="">8</span><span class="token" data-darkreader-inline-color="">,</span> <span class="token" data-darkreader-inline-color=""># Rank of the low-rank update</span> lora_alpha<span class="token" data-darkreader-inline-color="">=</span><span class="token" data-darkreader-inline-color="">16</span><span class="token" data-darkreader-inline-color="">,</span></code><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Scaling factor for the low-rank update</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""> target_modules<span class="token" data-darkreader-inline-color="">=</span><span class="token" data-darkreader-inline-color="">[</span><span class="token" data-darkreader-inline-color="">"q_lin"</span><span class="token" data-darkreader-inline-color="">,</span> <span class="token" data-darkreader-inline-color="">"v_lin"</span><span class="token" data-darkreader-inline-color="">]</span><span class="token" data-darkreader-inline-color="">,</span> <span class="token" data-darkreader-inline-color=""># Apply LoRA to the query and value layers</span> <span class="token" data-darkreader-inline-color="">)</span> </code></div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Create the LoRA-enabled model</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color="">model <span class="token" data-darkreader-inline-color="">=</span> get_peft_model<span class="token" data-darkreader-inline-color="">(</span>model<span class="token" data-darkreader-inline-color="">,</span> peft_config<span class="token" data-darkreader-inline-color="">)</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Fine-tune the model with LoRA</span> </code></div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># ... (training code omitted for brevity)</span></code></div> </div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color="">

У цьому прикладі ми завантажуємо попередньо підготовлену модель BERT для класифікації послідовності та визначаємо конфігурацію LoRA. The r параметр визначає ранг оновлення низького рангу, і lora_alpha є коефіцієнтом масштабування для оновлення. The target_modules Параметр вказує, які рівні моделі повинні отримувати оновлення низького рангу. Після створення моделі з підтримкою LoRA ми можемо продовжити процес тонкого налаштування за допомогою стандартної процедури навчання.

Адаптерні шари: Подібно до LoRA, але замість оновлень низького рангу в кожен блок трансформатора попередньо навченої моделі вставляються тонкі шари «адаптера». Навчаються лише параметри цих кількох нових компактних шарів.

Оперативна настройка: цей підхід дозволяє повністю заморозити попередньо навчену модель. Замість цього вводяться тренувальні «підказкові» вбудовування як вхідні дані для активації попередньо навчених знань моделі для цільового завдання.

Ці ефективні методи можуть забезпечити до 100-кратного скорочення обсягу обчислень порівняно з повним тонким налаштуванням, при цьому досягаючи конкурентоспроможної продуктивності для багатьох завдань. Вони також зменшують потреби в сховищі, уникаючи повного дублювання моделі.

Однак їх продуктивність може відставати від повного тонкого налаштування для завдань, які значно відрізняються від загальної мови або вимагають більш цілісної спеціалізації.

Процес тонкого налаштування

Незалежно від стратегії тонкого налаштування, загальний процес спеціалізації LLM відповідає загальній структурі:

- Підготовка набору даних: Вам потрібно буде отримати або створити позначений набір даних, який зіставляє вхідні дані (підказки) з бажаними результатами для вашого цільового завдання. Для завдань генерування тексту, як-от резюмування, це буде пара вхідного тексту до резюмованого виведення.

- Розбиття набору даних: дотримуючись найкращих практик, розділіть свій набір даних із мітками на набори для навчання, перевірки та тестування. Це розділяє дані для навчання моделі, налаштування гіперпараметрів і остаточної оцінки.

- Налаштування гіперпараметрів: Такі параметри, як швидкість навчання, розмір партії та графік навчання, потрібно налаштувати для найбільш ефективного точного налаштування ваших даних. Зазвичай це передбачає невеликий набір перевірок.

- Модельне навчання: використовуючи налаштовані гіперпараметри, запустіть процес оптимізації точного налаштування на повному навчальному наборі, доки продуктивність моделі на перевірочному наборі не перестане покращуватися (дострокова зупинка).

- Оцінка: Оцініть продуктивність налаштованої моделі на тестовому наборі, який в ідеалі містить реальні приклади для цільового використання, щоб оцінити реальну ефективність.

- Розгортання та моніторинг: після того, як модель стане задовільною, її можна розгортати для висновків щодо нових вхідних даних. Дуже важливо відстежувати його продуктивність і точність протягом певного часу для зміни концепції.

Хоча це окреслює загальний процес, багато нюансів можуть вплинути на успіх точного налаштування для конкретного LLM або завдання. Такі стратегії, як вивчення навчального плану, тонке налаштування кількох завдань і поодинокі підказки, можуть ще більше підвищити ефективність.

Крім того, ефективні методи тонкого налаштування потребують додаткових міркувань. Наприклад, LoRA вимагає таких методів, як кондиціонування попередньо навчених виходів моделі за допомогою рівня об’єднання. Для швидкого налаштування потрібні ретельно розроблені підказки для активації правильних дій.

Розширене тонке налаштування: врахування відгуків людини

У той час як стандартне контрольоване точне налаштування з використанням мічених наборів даних є ефективним, захоплюючим напрямком є навчання LLM безпосередньо з використанням уподобань людини та відгуків. Цей підхід «людина в циклі» використовує методи навчання з підкріпленням:

РРО (Оптимізація проксимальної політики): тут LLM розглядається як агент навчання з підкріпленням, а його результати є «діями». Модель винагороди навчена передбачати людські оцінки або показники якості для цих результатів. Потім PPO оптимізує LLM для отримання результатів, що максимізують бали моделі винагороди.

RLHF (Навчання з підкріпленням за допомогою відгуків людини): це розширює PPO шляхом безпосереднього включення відгуків людини в процес навчання. Замість фіксованої моделі винагороди винагороди надходять від ітеративних людських оцінок результатів LLM під час тонкого налаштування.

Незважаючи на інтенсивність обчислень, ці методи дозволяють точніше формувати поведінку LLM на основі бажаних характеристик, оцінених людьми, крім того, що можна зафіксувати в статичному наборі даних.

Такі компанії, як Anthropic, використовували RLHF, щоб наповнити свої мовні моделі, як-от Claude, покращеною правдивістю, етикою та усвідомленням безпеки, окрім компетенції щодо завдань.

Потенційні ризики та обмеження

Хоча LLM надзвичайно потужні, точне налаштування не позбавлене ризиків, якими потрібно ретельно керувати:

Посилення зсуву: якщо дані точного налаштування містять суспільні упередження щодо статі, раси, віку чи інших атрибутів, модель може посилити ці небажані упередження. Курування репрезентативних і де-упереджених наборів даних має вирішальне значення.

Фактичний дрейф: Навіть після точного налаштування високоякісних даних, мовні моделі можуть «галюцинувати» неправильні факти або результати, несумісні з навчальними прикладами, протягом довгих розмов або підказок. Можуть знадобитися методи пошуку фактів.

Проблеми масштабованості: Повне тонке налаштування величезних моделей, таких як GPT-3, потребує величезних обчислювальних ресурсів, які можуть бути неможливими для багатьох організацій. Ефективне тонке налаштування частково пом’якшує це, але має компроміси.

Катастрофічне забуття: під час повного тонкого налаштування моделі можуть катастрофічно забувати, коли вони втрачають деякі загальні можливості, набуті під час попереднього навчання. Може знадобитися багатозадачне навчання.

IP та ризики конфіденційності: Власні дані, які використовуються для тонкого налаштування, можуть просочуватися в загальнодоступні вихідні дані мовної моделі, створюючи ризики. Методи диференціальної конфіденційності та інформаційної небезпеки є активними напрямками досліджень.

Загалом, незважаючи на виняткову корисність, точне налаштування — це нюансований процес, який вимагає уваги до якості даних, міркувань ідентичності, пом’якшення ризиків і збалансування компромісів між продуктивністю та ефективністю на основі вимог сценарію використання.

Майбутнє: налаштування мовної моделі в масштабі

Заглядаючи вперед, прогрес у техніках тонкого налаштування та адаптації моделі буде мати вирішальне значення для розкриття повного потенціалу великих мовних моделей у різноманітних програмах і доменах.

Більш ефективні методи, які дозволяють тонко налаштовувати навіть більші моделі, такі як PaLM, з обмеженими ресурсами могли б демократизувати доступ. Автоматизація конвеєрів створення набору даних і оперативне проектування могли б оптимізувати спеціалізацію.

Методи самоконтролю для точного налаштування з необроблених даних без міток можуть відкрити нові межі. А композиційні підходи до поєднання точно налаштованих підмоделей, навчених на різних завданнях або даних, можуть дозволити будувати високоспеціалізовані моделі на вимогу.

Зрештою, оскільки магістратури стають все більш поширеними, здатність легко налаштовувати та спеціалізувати їх для будь-якого можливого випадку використання буде мати вирішальне значення. Точне налаштування та відповідні стратегії адаптації моделі є ключовими кроками в реалізації бачення великих мовних моделей як гнучких, безпечних і потужних помічників штучного інтелекту, які розширюють можливості людини в будь-якій області та діяльності.

Останні п’ять років я провів, занурюючись у захоплюючий світ машинного та глибокого навчання. Моя пристрасть і досвід допомогли мені внести свій внесок у понад 50 різноманітних проектів розробки програмного забезпечення, зосередивши особливу увагу на ШІ/ML. Моя постійна цікавість також привела мене до обробки природної мови, галузі, яку я хочу досліджувати далі.

Вам може сподобатися

Розкриття ChatGPT-4o: функції наступного покоління та їх трансформаційний вплив

Все, що вам потрібно знати про Llama 3 | Найпотужніша модель із відкритим вихідним кодом | Концепції використання

BlackMamba: суміш експертів для моделей стану та простору

GPT AI для бази даних PostgreSQL: чи можуть вони працювати?

GOAT (добре справляється з арифметичними завданнями): від знання мови до генія математики

Битва між моделями мови з відкритим кодом і закритим кодом: технічний аналіз