Штучний Інтелект

Краща продуктивність машинного навчання завдяки зміні розміру зображення на основі CNN

Дослідження Google запропонували новий метод підвищення ефективності та точності робочих процесів навчання комп’ютерного зору на основі зображень шляхом покращення способу зменшення зображень у наборі даних на етапі попередньої обробки.

У папір Навчання змінювати розміри зображень для завдань комп’ютерного зору, дослідники Хоссейн Талебі та Пейман Міланфар використовують CNN для створення нової гібридної архітектури зміни розміру зображення, яка забезпечує помітне покращення результатів розпізнавання, отриманих у чотирьох популярних наборах даних комп’ютерного зору.

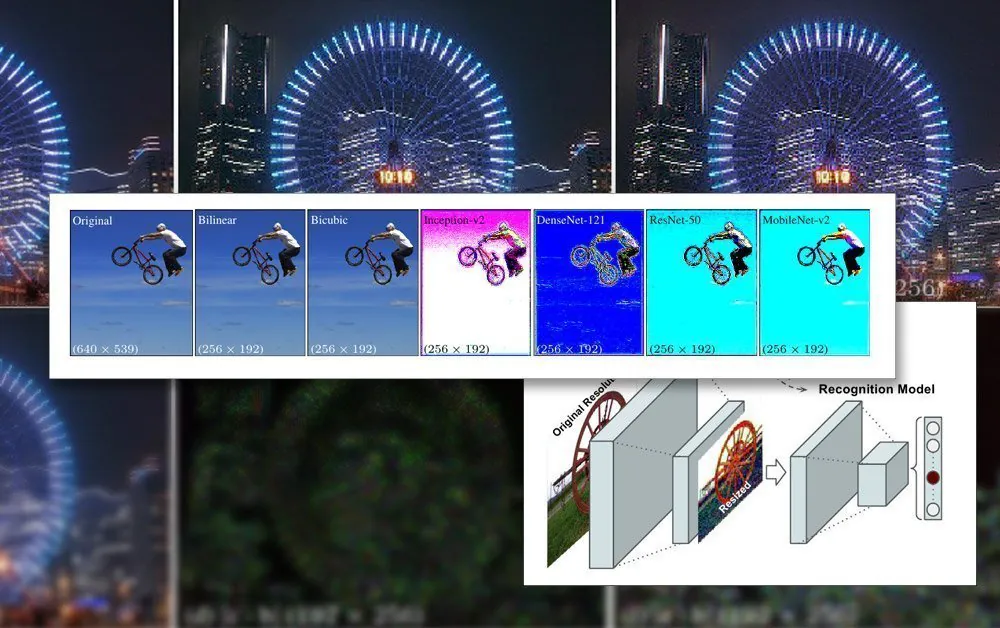

Запропонована спільна основа для розпізнавання та зміни розміру. Джерело: https://arxiv.org/pdf/2103.09950.pdf

У документі зазначається, що методи масштабування/зміни розміру, які зараз використовуються в конвеєрах автоматизованого машинного навчання, застаріли на десятиліття і часто використовують лише базові білінійні, бікубічні та найближчі сусіди. зміна розміру – методи, які обробляють усі пікселі без розбору.

Навпаки, запропонований метод доповнює дані зображення через CNN і включає ці вхідні дані в зображення зі зміненим розміром, які в кінцевому підсумку проходитимуть через архітектуру моделі.

Обмеження зображення в навчанні ШІ

Щоб навчити модель, яка має справу з зображеннями, система машинного навчання включатиме етап попередньої обробки, на якому різноманітні зображення різного розміру, колірного простору та роздільної здатності (які сприятимуть навчальному набору даних) систематично обрізаються та змінений у відповідні розміри та стабільний єдиний формат.

Загалом це включатиме певний компроміс, заснований на форматі PNG, де буде встановлено компроміс між часом/ресурсами обробки, розміром файлу та якістю зображення.

У більшості випадків кінцеві розміри обробленого зображення дуже малі. Нижче ми бачимо приклад зображення з роздільною здатністю 80 × 80, на якому деякі з найдавніших наборів даних deepfakes були створені:

Оскільки обличчя (та інші можливі об’єкти) рідко вписуються в необхідний квадратний коефіцієнт, може знадобитися додати чорні смуги (або дозволити втрачений простір), щоб уніфікувати зображення, ще більше скорочуючи фактично придатні для використання дані зображення:

Тут обличчя було виділено з більшої області зображення, доки воно не буде обрізано настільки економічно, наскільки це можливо, щоб охопити всю область обличчя. Однак, як видно праворуч, велика частина решти області не буде використана під час навчання, додаючи більшої ваги важливості якості зображення змінених даних.

Оскільки за останні роки можливості графічного процесора покращилися, нове покоління карт NVIDIA оснащено збільшення сум відеопам’яті (VRAM), середні розміри зображення починають збільшуватися, хоча 224 × 224 пікселів все ще є досить стандартним (наприклад, це розмір ResNet-50 набір даних).

Зображення розміром 224×244 пікселя без змін.

Встановлення пакетів у VRAM

Причина, по якій усі зображення мають бути однакового розміру, полягає в тому градієнтний спуск, метод, за допомогою якого модель покращується з часом, вимагає однорідних даних навчання.

Причина, по якій зображення мають бути такими малими, полягає в тому, що їх потрібно завантажувати (повністю розпаковувати) у VRAM під час навчання невеликими партіями, зазвичай від 6 до 24 зображень на партію. Занадто мало зображень на партію, і недостатньо групового матеріалу для хорошого узагальнення, крім того, що це збільшує час навчання; занадто багато, і модель може не отримати необхідних характеристик і деталей (див. нижче).

Цей розділ «живого завантаження» навчальної архітектури називається латентний простір. Тут ознаки неодноразово витягуються з одних і тих самих даних (тобто тих самих зображень), доки модель не наблизиться до стану, коли вона має всі узагальнені знання, необхідні для виконання перетворень на пізніших невидимих даних подібного типу.

Цей процес зазвичай займає кілька днів, хоча для досягнення корисного узагальнення може знадобитися навіть місяць або більше постійного та непохитного високого обсягу цілодобового мислення. Збільшення розміру відеопам’яті корисно лише до певної міри, оскільки навіть незначне збільшення роздільної здатності зображення може мати значний вплив на потужність обробки та відповідний вплив на точність, що не завжди може бути сприятливим.

Використання більшої ємності VRAM для розміщення більших розмірів пакетів також є змішаним благословенням, оскільки це забезпечує більшу швидкість навчання. ймовірно буде компенсовано за менш точними результатами.

Тому, оскільки навчальна архітектура настільки обмежена, все, що може вплинути на покращення в рамках існуючих обмежень конвеєра, є помітним досягненням.

Як чудове скорочення допомагає

Доведено, що найкраща якість зображення, яке буде включено до навчального набору даних, покращує результати навчання, зокрема в задачах розпізнавання об'єктів. У 2018 році дослідники з Інституту інтелектуальних систем Макса Планка суперечив що вибір методу повторної вибірки значно впливає на ефективність навчання та результати.

Крім того, попередні роботи Google (у співавторстві з авторами нової статті) показали, що точність класифікації можна покращити збереження контролю артефакти надмірного стиснення в зображеннях набору даних.

Модель CNN, вбудована в новий resampler, поєднує білінійне змінення розміру з функцією «пропуску з’єднання», яка може включати вихідні дані з навченої мережі в змінене зображення.

На відміну від типової архітектури кодера/декодера, нова пропозиція може діяти не лише як вузьке місце прямої подачі, але й як зворотне вузьке місце для масштабування до будь-якого цільового розміру та/або співвідношення сторін. Крім того, «стандартний» метод повторної вибірки можна замінити будь-яким іншим відповідним традиційним методом, наприклад Ланчош.

Високочастотні деталі

Новий метод створює зображення, які, здається, «запікають» ключові характеристики (які зрештою будуть розпізнані в процесі навчання) безпосередньо у вихідному зображенні. В естетичному плані результати нетрадиційні:

Новий метод застосовується в чотирьох мережах – Inception V2; DenseNet-121; ResNet-50; і MobileNet-V2. Результати методу зменшення дискретизації/зміни розміру зображень Google Research створюють зображення з очевидним агрегуванням пікселів, передбачаючи ключові особливості, які будуть виявлені під час процесу навчання.

Дослідники відзначають, що ці початкові експерименти оптимізовані виключно для завдань розпізнавання зображень, і що під час тестів їх «навчений змінник розміру» на основі CNN зміг досягти кращого рівня помилок у таких завданнях. У майбутньому дослідники мають намір застосувати цей метод до інших типів програм комп’ютерного зору на основі зображень.