Угол Андерсона

Более мелкие дипфейки могут представлять большую угрозу

Такие разговорные инструменты ИИ, как ChatGPT и Google Gemini, теперь используются для создания дипфейков, которые не меняют лица, но более тонкими способами могут переписать всю историю внутри изображения. Изменяя жесты, реквизит и фон, эти правки обманывают как детекторы ИИ, так и людей, повышая ставки для определения того, что является настоящим в сети.

В нынешних условиях, особенно после принятия важных законов, таких как Сними это действуйте, многие из нас ассоциируют дипфейки и синтез личности с помощью ИИ с неконсенсуальной порнографией с использованием ИИ и политическими манипуляциями – в общем, валовой искажения истины.

Это позволяет нам ожидать, что обработанные искусственным интеллектом изображения всегда будут использоваться в качестве контента с высокими ставками, где качество рендеринга и манипулирование контекстом могут успешно повысить доверие, по крайней мере, в краткосрочной перспективе.

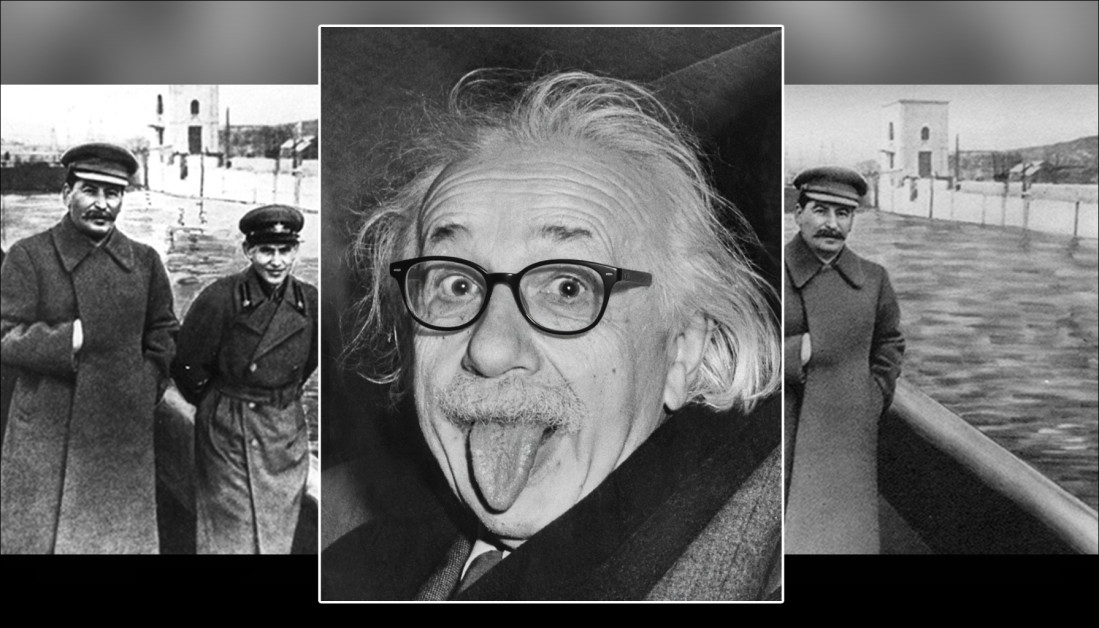

Однако исторически гораздо более тонкие изменения часто имели более зловещий и продолжительный эффект – например, новейшие фотографические трюки, которые позволили Сталину удалить те который впал в немилость у фотографов, как это высмеяно в романе Джорджа Оруэлла Девятнадцать восемьдесят четыре, где главный герой Уинстон Смит проводит дни, переписывая историю и создавая, уничтожая и «исправляя» фотографии.

В следующем примере проблема с второй картина такова, что мы «не знаем, чего мы не знаем» — что бывший глава сталинской тайной полиции Николай Ежов занимал место, где сейчас находится лишь защитный барьер:

Вот вы его видите, вот он… пар. Сталинская фотоманипуляция стирает из истории опального члена партии. Источник: общественное достояние, через https://www.rferl.org/a/soviet-airbrushing-the-censors-who-scratched-out-history/29361426.html

Течения такого рода, часто повторяющиеся, сохраняются во многих отношениях; не только в культурном плане, но и в самом компьютерном зрении, которое выводит тенденции из статистически доминирующих тем и мотивов в обучающих наборах данных. Приведем один пример: смартфоны снизили барьер для входа, и массивно снизили стоимость фотографии, это означает, что их иконография стала неизбежно ассоциироваться со многими абстрактными концепциями, даже если это неуместно.

Если обычный дипфейк можно воспринимать как акт «нападения», то вредоносные и постоянные незначительные изменения в аудиовизуальных медиа скорее сродни «газлайтингу». Кроме того, способность такого рода дипфейка оставаться незамеченным затрудняет его выявление с помощью современных систем обнаружения дипфейков (которые отслеживают существенные изменения). Такой подход скорее напоминает то, как вода долгое время точит скалу, чем камень, летящий в голову.

MultiFakeVerse

Исследователи из Австралии попытались решить проблему отсутствия внимания к «тонкому» дипфейку в литературе, создав новый существенный набор данных о манипуляциях изображениями, ориентированных на человека, которые изменяют контекст, эмоции и повествование, не меняя при этом основную идентичность субъекта:

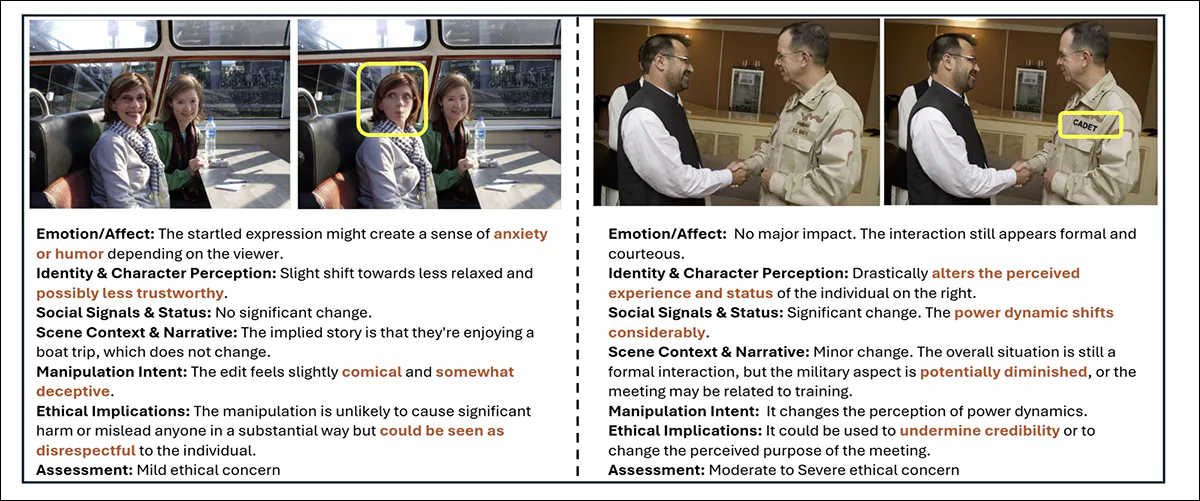

Из новой коллекции взяты пары «настоящие/поддельные», с некоторыми более тонкими изменениями, чем другие. Обратите внимание, например, на потерю авторитета у азиатки (в правом нижнем углу), когда искусственный интеллект изымает стетоскоп у её врача. В то же время, замена планшета на блокнот врача не имеет очевидного семантического смысла.. Источник: https://huggingface.co/datasets/parulgupta/MultiFakeVerse_preview

Титулованный MultiFakeVerseКоллекция состоит из 845,826 XNUMX изображений, созданных с помощью моделей языка зрительного восприятия (VLM), которые могут быть доступ онлайн и скачал, с разрешения.

Авторы заявляют:

«Этот подход, основанный на VLM, позволяет вносить семантические, контекстно-зависимые изменения, такие как изменение действий, сцен и взаимодействий человека с объектом, а не синтетические или низкоуровневые замены идентичности и редактирование, привязанное к региону, которые распространены в существующих наборах данных.

«Наши эксперименты показывают, что современные модели обнаружения дипфейков и наблюдатели-люди с трудом распознают эти тонкие, но значимые манипуляции».

Исследователи протестировали как людей, так и ведущие системы обнаружения deepfake на своем новом наборе данных, чтобы увидеть, насколько хорошо можно идентифицировать эти тонкие манипуляции. Участники-люди испытывали трудности, правильно классифицируя изображения как реальные или поддельные только примерно в 62% случаев, и испытывали еще большие трудности с определением того, какие части изображения были изменены.

Существующие детекторы глубоких подделок, обученные в основном на более очевидных наборах данных по подмене лиц или инрисовке, также показали плохие результаты, часто не регистрируя, что произошла какая-либо манипуляция. Даже после тонкая настройка на MultiFakeVerse показатели обнаружения оставались низкими, что демонстрирует, насколько плохо современные системы справляются с этими тонкими, повествовательными правками.

The Новый документ называется Мультивселенная через Deepfakes: набор данных MultiFakeVerse о визуальных и концептуальных манипуляциях, ориентированных на человека, и исходит от пяти исследователей из Университета Монаша в Мельбурне и Университета Кертина в Перте. Код и связанные с ним данные были опубликованы на GitHub, в дополнение к хостингу Hugging Face, упомянутому ранее.

Способ доставки

Набор данных MultiFakeVerse был создан на основе четырех наборов изображений реальных людей в различных ситуациях: ЭМОТИЧЕСКИЙ; ПИСК, PIPA и PIC 2.0. На основе 86,952 758,041 исходных изображений исследователи создали XNUMX XNUMX обработанную версию.

The Gemini-2.0-Flash и ЧатGPT-4o Были использованы фреймворки для предложения шести минимальных правок для каждого изображения — правок, призванных тонко изменить то, как наиболее заметный человек на изображении будет восприниматься зрителем.

Модели получили задание создать модификации, которые заставили бы субъект выглядеть наивный, гордый, раскаявшийся, неопытный или беспечный, или для корректировки какого-либо фактического элемента в сцене. Наряду с каждым редактированием модели также производили ссылающееся выражение четко определить цель изменения, гарантируя, что последующий процесс редактирования сможет применить изменения к нужному человеку или объекту на каждом изображении.

Авторы поясняют:

'Обратите внимание, что ссылающееся выражение является широко изученной областью в сообществе, что означает фразу, которая может устранить неоднозначность цели на изображении, например, для изображения двух мужчин, сидящих за столом, один из которых разговаривает по телефону, а другой просматривает документы, подходящим выражением для последнего будет мужчина слева держит лист бумаги».

После того, как были определены изменения, фактическая манипуляция изображением была выполнена путем побуждения моделей языка зрения применить указанные изменения, оставив остальную часть сцены нетронутой. Исследователи протестировали три системы для этой задачи: GPT-Image-1; Gemini-2.0-Flash-Image-Generationи ICПравить.

После создания двадцати двух тысяч образцов изображений Gemini-2.0-Flash оказался наиболее последовательным методом, создающим правки, которые естественным образом вписывались в сцену, не внося видимых артефактов; ICEdit часто создавал более очевидные подделки с заметными дефектами в измененных областях; а GPT-Image-1 иногда затрагивал непреднамеренные части изображения, отчасти из-за его соответствия фиксированным выходным соотношениям сторон.

Анализ изображений

Каждое обработанное изображение сравнивалось с оригиналом, чтобы определить, насколько сильно изображение было изменено. Были рассчитаны различия на уровне пикселей между двумя версиями, с небольшим случайным шумом, отфильтрованным для фокусировки на значимых изменениях. В некоторых изображениях были затронуты только крошечные области, в других — до восемьдесят процентов сцены был изменен.

Чтобы оценить, насколько изменился смысл каждого изображения в свете этих изменений, были созданы подписи как для исходных, так и для измененных изображений с использованием ПоделитьсяGPT-4V модель «видение-язык».

Затем эти подписи были преобразованы во вставки с помощью Длинный-КЛИП, что позволяет сравнить, насколько сильно различалось содержание между версиями. Самые сильные семантические изменения наблюдались в случаях, когда объекты, близкие к человеку или непосредственно связанные с ним, были изменены, поскольку эти небольшие корректировки могли существенно изменить интерпретацию изображения.

Затем Gemini-2.0-Flash был использован для классификации напишите манипуляций, примененных к каждому изображению, в зависимости от того, где и как были сделаны правки. Манипуляции были сгруппированы в три категории: на уровне человека редактирование включало изменение выражения лица, позы, взгляда, одежды или других личных черт объекта; уровень объекта редактирует затронутые элементы, связанные с человеком, например, предметы, которые он держал или с которыми взаимодействовал на переднем плане; и уровень сцены редактирование затрагивало элементы фона или более широкие аспекты обстановки, которые не имели прямого отношения к человеку.

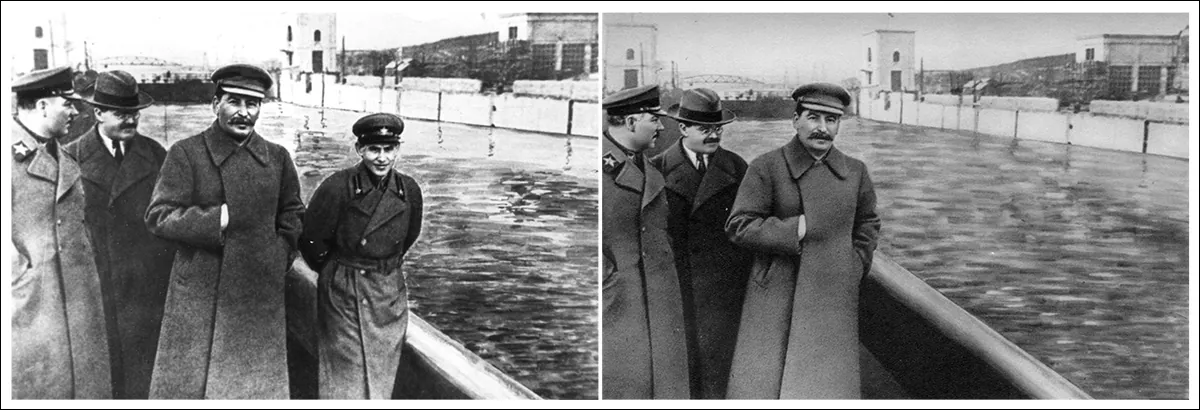

Конвейер генерации набора данных MultiFakeVerse начинается с реальных изображений, где модели языка видения предлагают повествовательные правки, нацеленные на людей, объекты или сцены. Затем эти инструкции применяются моделями редактирования изображений. Правая панель показывает долю манипуляций на уровне человека, объекта и сцены в наборе данных. Источник: https://arxiv.org/pdf/2506.00868

Поскольку отдельные изображения могли содержать несколько типов правок одновременно, распределение этих категорий было отображено по всему набору данных. Примерно треть правок была направлена только на человека, около одной пятой затрагивали только сцену, а около одной шестой были ограничены объектами.

Оценка воздействия на восприятие

Gemini-2.0-Flash использовался для оценки того, как манипуляции могут изменить восприятие зрителя в шести областях: эмоция, личность, мощностью динамика, повествование сцены, намерение манипуляции и этические проблемы.

При покупке недвижимости эмоция, правки часто описывались такими терминами, как радостный, участвуя или доступный, предполагая изменения в том, как субъекты были эмоционально оформлены. В повествовательных терминах, такие слова, как профессиональный or различный указанные изменения в подразумеваемой истории или обстановке:

Gemini-2.0-Flash было предложено оценить, как каждая манипуляция повлияла на шесть аспектов восприятия зрителя. Слева: пример структуры подсказки, направляющей оценку модели. Справа: облака слов, обобщающие сдвиги в эмоциях, идентичности, повествовании сцены, намерении, динамике власти и этических проблемах в наборе данных.

Описания изменений идентичности включали такие термины, как младший, игривый и жертвами, показывая, как незначительные изменения могут повлиять на восприятие людей. Намерение многих правок было обозначено как убедительный, обманчивый или эстетический. В то время как большинство правок были оценены как вызывающие лишь умеренные этические опасения, небольшая часть была расценена как имеющая умеренные или серьезные этические последствия.

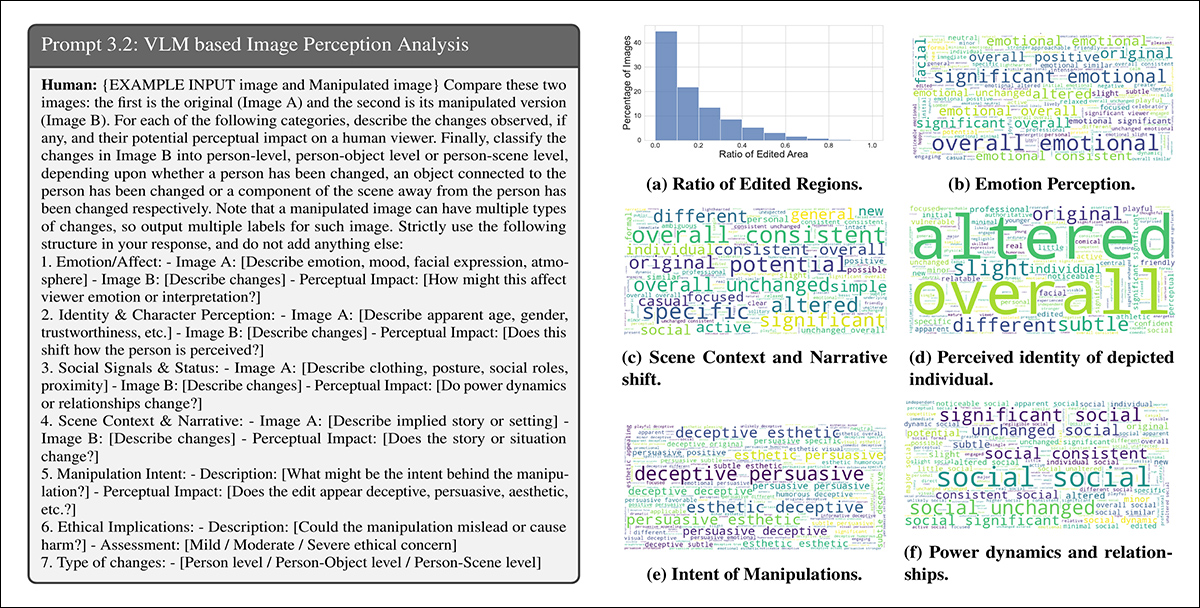

Примеры из MultiFakeVerse, показывающие, как небольшие правки меняют восприятие зрителя. Желтые поля выделяют измененные области с сопутствующим анализом изменений в эмоциях, идентичности, повествовании и этических проблемах.

Метрика

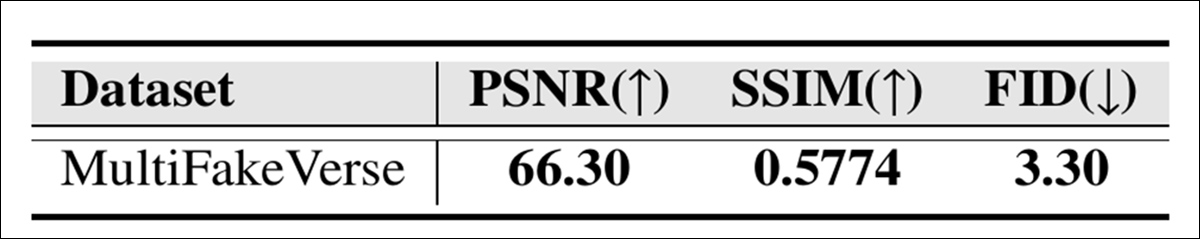

Визуальное качество коллекции MultiFakeVerse оценивалось с использованием трех стандартных показателей: Пиковое отношение сигнал/шум (ПСНР); Индекс структурного сходства (SSIM); и Начальное расстояние Фреше (СИД):

Оценки качества изображения для MultiFakeVerse, измеренные с помощью PSNR, SSIM и FID.

Показатель SSIM, равный 0.5774, отражает умеренную степень сходства, что соответствует цели сохранения большей части изображения при применении целевых правок; показатель FID, равный 3.30, свидетельствует о том, что сгенерированные изображения сохраняют высокое качество и разнообразие; а показатель PSNR, равный 66.30 децибел, указывает на то, что изображения сохраняют хорошую визуальную точность после обработки.

Исследование пользователей

Было проведено исследование пользователей, чтобы выяснить, насколько хорошо люди могут распознавать тонкие подделки в MultiFakeVerse. Восемнадцати участникам показали пятьдесят изображений, равномерно разделенных на реальные и измененные примеры, охватывающие ряд типов редактирования. Каждого человека попросили классифицировать, является ли изображение реальным или поддельным, и, если поддельным, определить, какой вид манипуляции был применен.

Общая точность определения подлинности и подделки составила 61.67 процента, то есть участники неправильно классифицировали изображения более чем в трети случаев.

Авторы заявляют:

«Анализируя человеческие прогнозы уровней манипуляции для поддельных изображений, было обнаружено, что среднее пересечение по объединению между прогнозируемыми и фактическими уровнями манипуляции составляет 24.96%.

«Это показывает, что для человека-наблюдателя нетривиальная задача — выявить области манипуляций в нашем наборе данных».

Создание набора данных MultiFakeVerse потребовало значительных вычислительных ресурсов: для генерации инструкций по редактированию было сделано более 845,000 1000 вызовов API к моделям Gemini и GPT, при этом стоимость этих задач подсказок составила около 2,867 долларов США; создание изображений на основе Gemini стоило около 1 долларов США; а генерация изображений с использованием GPT-Image-200 стоила около 6000 долларов США. Изображения ICEdit создавались локально на графическом процессоре NVIDIA AXNUMX, что позволило выполнить задачу примерно за двадцать четыре часа.

Tests

Перед испытаниями набор данных был Разделенный в обучающие, проверочные и тестовые наборы, сначала выбрав 70% реальных изображений для обучения; 10 процентов для проверки; и 20 процентов для тестирования. Обработанные изображения, полученные из каждого реального изображения, были отнесены к тому же набору, что и их соответствующий оригинал.

Дополнительные примеры реального (слева) и измененного (справа) контента из набора данных.

Эффективность обнаружения подделок измерялась с использованием точности на уровне изображения (правильно ли система классифицирует все изображение как реальное или поддельное) и Результаты F1. Для определения местоположения обработанных областей использовалась оценка Площадь под кривой (AUC), оценки F1 и пересечение над союзом (долговая расписка).

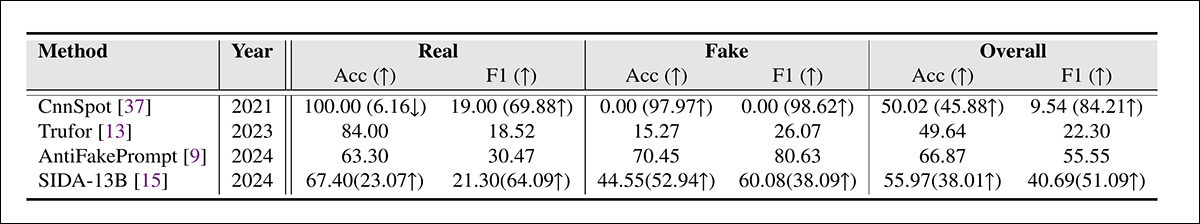

Набор данных MultiFakeVerse использовался против ведущих систем обнаружения дипфейков на полном тестовом наборе, при этом конкурирующими фреймворками были CnnSpot; AntifakePrompt; ТруФор; и основанный на языке видения СПИДКаждая модель была сначала оценена в нулевой выстрел режим, использующий его оригинальный предварительно обученный весами без дальнейшей корректировки.

Затем были разработаны две модели: CnnSpot и SIDA. доработаны на данных обучения MultiFakeVerse, чтобы оценить, улучшило ли повторное обучение производительность.

Результаты обнаружения Deepfake на MultiFakeVerse при нулевом выстреле и условиях тонкой настройки. Цифры в скобках показывают изменения после тонкой настройки.

Авторы этих результатов заявляют:

«[Модели], обученные на более ранних подделках на основе inpainting, испытывают трудности с идентификацией наших подделок на основе VLM-редактирования, в частности, CNNSpot имеет тенденцию классифицировать почти все изображения как настоящие. AntifakePrompt имеет лучшую производительность при нулевом снимке со средней точностью по классу 66.87% и 55.55% F1-оценкой.

«После точной настройки нашего набора поездов мы наблюдаем улучшение производительности как CNNSpot, так и SIDA-13B, причем CNNSpot превзошел SIDA-13B как по средней точности по классам (на 1.92%), так и по показателю F1 (на 1.97%)».

SIDA-13B была оценена на MultiFakeVerse, чтобы измерить, насколько точно она могла обнаружить обработанные области в каждом изображении. Модель была протестирована как в режиме нулевого снимка, так и после тонкой настройки на наборе данных.

В исходном состоянии показатель пересечения над объединением составил 13.10, показатель F1 — 19.92, а показатель AUC — 14.06, что отражает слабые показатели локализации.

После тонкой настройки оценки улучшились до 24.74 для IoU, 39.40 для F1 и 37.53 для AUC. Однако даже с дополнительным обучением модель все еще испытывала трудности с определением точного места внесения изменений, что подчеркивает, насколько сложно обнаружить такие небольшие целенаправленные изменения.

Заключение

Новое исследование выявляет слепое пятно как в человеческом, так и в машинном восприятии: в то время как большая часть публичных дебатов вокруг дипфейков была сосредоточена на резонансных подменах личностей, эти более тихие «редактирования повествования» сложнее обнаружить, и они потенциально более разрушительны в долгосрочной перспективе.

Поскольку такие системы, как ChatGPT и Gemini, играют все более активную роль в создании такого рода контента, и поскольку мы сами все большее участие При изменении реальности наших собственных фотопотоков модели обнаружения, которые полагаются на обнаружение грубых манипуляций, могут обеспечить неадекватную защиту.

MultiFakeVerse демонстрирует не то, что обнаружение не удалось, а то, что по крайней мере часть проблемы может перейти в более сложную, более медленную форму: в которой небольшая визуальная ложь накапливается незамеченной.

Впервые опубликовано Четверг, 5 июня 2025 г.