Искусственный интеллект

Наши подсознательные навыки обнаружения дипфейков могут привести в действие автоматизированные системы будущего

Новое исследование, проведенное в Австралии, показывает, что наш мозг прекрасно распознает сложные дипфейки, даже когда мы осознанно верим, что изображения, которые мы видим, реальны.

Это открытие также подразумевает возможность использования нейронных реакций людей на фейковые лица (а не их высказываемых мнений) для обучения автоматизированных систем обнаружения дипфейков. Такие системы будут обучаться на фейковых характеристиках изображений не на основе смутных оценок их правдоподобности, а на основе наших инстинктивных перцептивных механизмов распознавания лиц.

«Хотя мозг может «распознавать» разницу между реальными и реалистичными лицами, наблюдатели не могут сознательно различать их. Наши выводы о диссоциации между реакцией мозга и поведением имеют значение для того, как мы изучаем восприятие поддельных лиц, для вопросов, которые мы задаем, исследуя распознавание поддельных изображений, и для возможных способов установления защитных стандартов против неправомерного использования поддельных изображений».

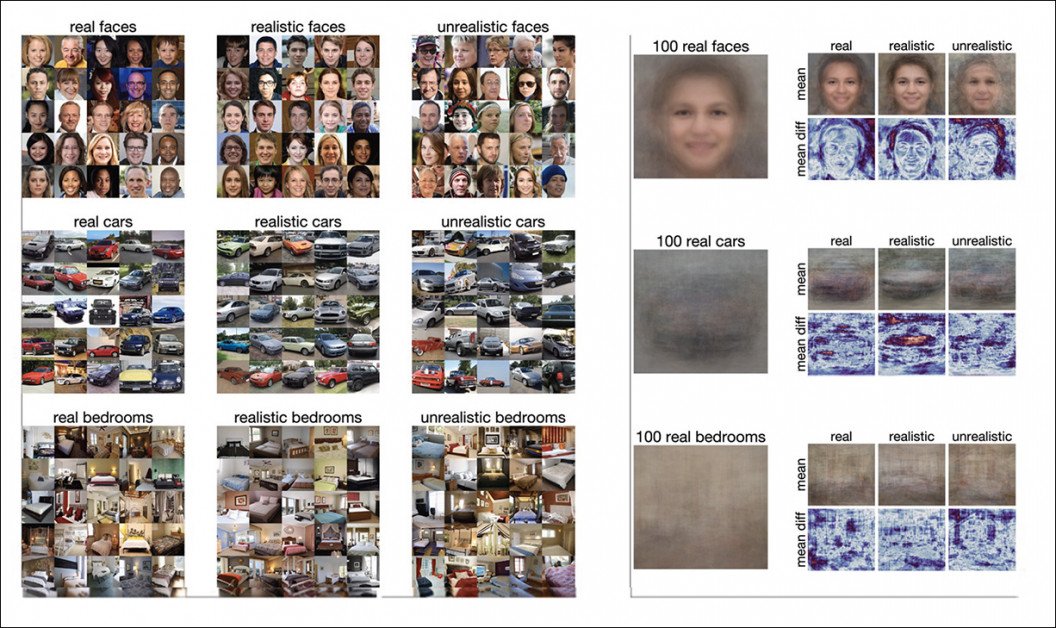

Результаты были получены в ходе тестов, предназначенных для оценки того, как люди реагируют на ложные образы, включая изображения явно фальшивых лиц, автомобилей, внутренних помещений и перевернутых (то есть вверх ногами) лиц.

Различные варианты и подходы к экспериментам включали две группы испытуемых, которым необходимо было классифицировать кратко показанное изображение как «поддельное» или «настоящее». Первый раунд проводился на платформе Amazon Mechanical Turk с участием 200 добровольцев, а второй раунд включал меньшее количество добровольцев, которые отвечали на тесты, будучи подключенными к электроэнцефалографам. Источник: https://tijl.github.io/tijl-grootswagers-pdf/Moshel_et_al_-_2022_-_Are_you_for_real_Decoding_realistic_AI-generated_.pdf

В документе утверждается:

«Наши результаты показывают, что даже при беглом взгляде наблюдатели могут распознать фальшивые лица. Однако им труднее отличить настоящие лица от поддельных, и в некоторых случаях они считали поддельные лица более реальными, чем настоящие.

«Однако, используя ЭЭГ с временным разрешением и методы классификации многомерных паттернов, мы обнаружили, что можно декодировать как нереалистичные, так и реалистичные лица из реальных лиц, используя мозговую активность.

«Эта диссоциация между поведением и нейронными реакциями на реалистичные лица дает важные новые доказательства о восприятии поддельных лиц, а также выводы, касающиеся все более реалистичного класса лиц, генерируемых GAN».

В статье высказывается предположение, что новая работа имеет «несколько последствий» для прикладной кибербезопасности и что разработка классификаторов на основе глубокого обучения, возможно, должна основываться на подсознательной реакции, измеряемой по показаниям ЭЭГ в ответ на поддельные изображения, а не на сознательной оценке зрителем достоверности изображения.

Комментарии авторов*:

«Это напоминает данные о том, что люди с прозопагнозией, которые не могут поведенчески классифицировать или распознавать лица как знакомые или незнакомые, тем не менее демонстрируют более сильные вегетативные реакции на знакомые лица, чем незнакомые лица.

«Аналогичным образом, в этом исследовании мы показали, что, хотя мы могли точно определить разницу между реальными и реалистичными лицами по нейронной активности, эта разница не проявлялась в поведении. Вместо этого наблюдатели ошибочно идентифицировали 69% реальных лиц как поддельные».

Радиус корня новая работа называется Ты серьезно? Декодирование реалистичных лиц, сгенерированных ИИ, по нейронной активности, и исходит от четырех исследователей из Сиднейского университета, Университета Маккуори, Университета Западного Сиднея и Университета Квинсленда.

Данные

Результаты были получены в результате более широкого исследования способности человека различать явно ложные, гиперреалистичные (но все же ложные) и реальные изображения, проведенного в ходе двух раундов тестирования.

Исследователи использовали изображения, созданные генеративно-состязательными сетями (GAN). общие от NVIDIA.

Изображения человеческого лица, сгенерированные GAN, предоставлены NVIDIA. Source: https://drive.google.com/drive/folders/1EDYEYR3IB71-5BbTARQkhg73leVB9tam

Данные включали 25 лиц, автомобилей и спален с уровнями рендеринга от «нереспективного» до «реалистичного». Для сравнения лиц (т.е. для поиска подходящего неподдельного материала) авторы использовали выборки из исходных данных NVIDIA Flickr-Faces-HQ (FFHQ). Набор данных. Для сравнения других сценариев они использовали материал из ЛСУН набор данных.

В конечном итоге изображения будут представлены испытуемому либо в правильном направлении, либо в перевернутом виде и в диапазоне частот, при этом все изображения будут изменены до 256 × 256 пикселей.

После того, как весь материал был собран, для тестов было отобрано 450 изображений стимулов.

Tests

Сами тесты изначально проводились онлайн, через jsPsych на pavlovia.org, где 200 участников оценивали различные подмножества общих собранных данных тестирования. Изображения показывались в течение 200 мс, после чего появлялся пустой экран, который сохранялся до тех пор, пока зритель не принимал решение о том, было ли мигающее изображение реальным или фальшивым. Каждое изображение предъявлялось только один раз, и весь тест занимал 3-5 минут.

Во втором и более показательном раунде использовались личные испытуемые, оснащенные мониторами ЭЭГ, и он был представлен на Психопи2 Платформа. Каждая из двадцати последовательностей содержала 40 изображений, из которых 18,000 XNUMX изображений были представлены во всем транше тестовых данных.

Собранные данные ЭЭГ декодировали с помощью MATLAB с набором инструментов CoSMoMVPA, используя перекрестная проверка без исключения схема при линейном дискриминантном анализе (LDA).

Классификатор LDA был тем компонентом, который был способен различать реакцию мозга на поддельные стимулы и собственное мнение испытуемого о том, является ли изображение поддельным.

Результаты

Заинтересованные в том, могут ли испытуемые ЭЭГ различать поддельные и настоящие лица, исследователи объединили и обработали результаты, обнаружив, что участники могли легко отличить настоящие лица от нереалистичных, но, по-видимому, изо всех сил пытались идентифицировать реалистичные, сгенерированные GAN поддельные лица. Было ли изображение перевернутым или нет, казалось, не имело большого значения.

Поведенческая дискриминация реальных и искусственно сгенерированных лиц, во втором туре.

Однако данные ЭЭГ говорили о другом.

В документе говорится:

«Хотя у наблюдателей возникали трудности с различением настоящих лиц от поддельных, и они имели тенденцию переклассифицировать поддельные лица, данные ЭЭГ содержали сигнальную информацию, относящуюся к этому различию, которая существенно различалась между реалистичными и нереалистичными лицами, и этот сигнал, по-видимому, ограничивался относительно короткой стадией обработки».

Здесь несоответствие между точностью ЭЭГ и сообщенным мнением испытуемых (т. е. относительно того, были ли изображения лиц фальшивыми) не идентичны, а записи ЭЭГ ближе к истине, чем явное восприятие вовлеченных людей.

Исследователи приходят к выводу, что, хотя наблюдатели могут испытывать трудности с негласной идентификацией поддельных лиц, эти лица имеют «четкие представления в зрительной системе человека».

Обнаруженное несоответствие заставило исследователей задуматься о потенциальной применимости их результатов для будущих механизмов безопасности:

«В прикладных задачах, таких как кибербезопасность или Deepfakes, изучение способности распознавания реалистичных лиц может быть наиболее эффективным с помощью классификаторов машинного обучения, применяемых к данным нейровизуализации, а не с учетом поведенческих характеристик».

Они заключают:

«Понимание диссоциации между мозгом и поведением при распознавании фальшивых лиц будет иметь практические последствия для того, как мы будем бороться с потенциально вредоносным и повсеместным распространением искусственно созданной информации».

* Мое преобразование встроенных цитат в гиперссылки.

Впервые опубликовано 11 июля 2022 г.