Inteligența artificială

AnomalyGPT: Detectarea anomaliilor industriale folosind LVLM

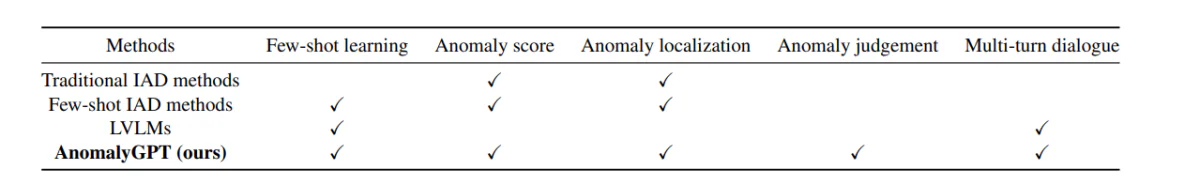

Recent, Large Vision Language Models (LVLM) precum LLava și MiniGPT-4 au demonstrat capacitatea de a înțelege imagini și de a obține o precizie și eficiență ridicate în mai multe sarcini vizuale. În timp ce LVLM excelează în recunoașterea obiectelor comune datorită seturilor lor extinse de date de antrenament, le lipsesc cunoștințe specifice domeniului și au o înțelegere limitată a detaliilor localizate din imagini. Acest lucru limitează eficacitatea lor în sarcinile de detectare a anomaliilor industriale (IAD). Pe de altă parte, cadrele IAD existente pot identifica doar sursele de anomalii și necesită setări manuale ale pragului pentru a face distincția între eșantioanele normale și anormale, limitând astfel implementarea lor practică.

Scopul principal al unui cadru IAD este de a detecta și localiza anomalii în scenariile industriale și imaginile produselor. Cu toate acestea, din cauza impredictibilității și rarității mostrelor de imagini din lumea reală, modelele sunt de obicei antrenate numai pe date normale. Ele diferențiază probele anormale de cele normale pe baza abaterilor de la probele tipice. În prezent, cadrele și modelele IAD oferă în primul rând scoruri de anomalii pentru probele de testare. Mai mult decât atât, distincția între instanțe normale și anormale pentru fiecare clasă de elemente necesită specificarea manuală a pragurilor, făcându-le inadecvate pentru aplicațiile din lumea reală.

Pentru a explora utilizarea și implementarea modelelor de limbaj pentru vederi mari în abordarea provocărilor prezentate de cadrele IAD, a fost introdusă AnomalyGPT, o nouă abordare IAD bazată pe LVLM. AnomalyGPT poate detecta și localiza anomalii fără a fi nevoie de setări manuale ale pragului. În plus, AnomalyGPT poate oferi, de asemenea, informații pertinente despre imagine pentru a interacționa interactiv cu utilizatorii, permițându-le să pună întrebări ulterioare pe baza anomaliei sau a nevoilor lor specifice.

Detectarea anomaliilor industriale și modele de limbaj pentru vederi mari

Cadrele IAD existente pot fi clasificate în două categorii.

- IAD bazat pe reconstrucție.

- IAD bazat pe încorporarea caracteristicilor.

Într-un cadru IAD bazat pe reconstrucție, scopul principal este de a reconstrui eșantioanele de anomalii în eșantioanele lor normale și de a detecta anomalii prin calculul erorii de reconstrucție. SCADN, RIAD, AnoDDPM și InTra folosesc diferitele cadre de reconstrucție, de la rețele generative adverse (GAN) și autoencodere, până la modele de difuzie și transformatoare.

Pe de altă parte, într-un cadru IAD bazat pe Feature Embedding, motivul principal este să se concentreze pe modelarea caracteristicilor încorporate a datelor normale. Metode precum PatchSSVD încearcă să găsească o hipersferă care poate încapsula strâns eșantioanele normale, în timp ce cadre precum PyramidFlow și Cfl proiectează eșantioane normale într-o distribuție Gaussiană folosind fluxuri de normalizare. Cadrele CFA și PatchCore au stabilit o bancă de memorie de mostre normale din încorporarea patch-urilor și utilizează distanța dintre eșantionul de testare care înglobează încorporarea normală pentru a detecta anomaliile.

Ambele metode urmează „un model de clasa unu”, o paradigmă de învățare care necesită o cantitate mare de eșantioane normale pentru a învăța distribuțiile fiecărei clase de obiecte. Cerința pentru o cantitate mare de mostre normale o face nepractică pentru categorii noi de obiecte și cu aplicații limitate în medii dinamice de produs. Pe de altă parte, cadrul AnomalyGPT folosește o paradigmă de învățare în context pentru categoriile de obiecte, permițându-i să permită interferența doar cu o mână de mostre normale.

Mergând mai departe, avem modele de limbaj pentru vederi mari sau LVLM. LLM sau modele lingvistice mari s-au bucurat de un succes extraordinar în industria NLP și sunt acum explorați pentru aplicațiile lor în sarcini vizuale. Cadrul BLIP-2 folosește Q-former pentru a introduce caracteristici vizuale din Vision Transformer în modelul Flan-T5. În plus, cel cadru MiniGPT conectează segmentul de imagine al cadrului BLIP-2 și modelul Vicuna cu un strat liniar și efectuează un proces de reglare fină în două etape folosind date imagine-text. Aceste abordări indică faptul că cadrele LLM ar putea avea unele aplicații pentru sarcini vizuale. Cu toate acestea, aceste modele au fost instruite pe date generale și le lipsește expertiza specifică domeniului necesară pentru aplicații pe scară largă.

Cum funcționează AnomalyGPT?

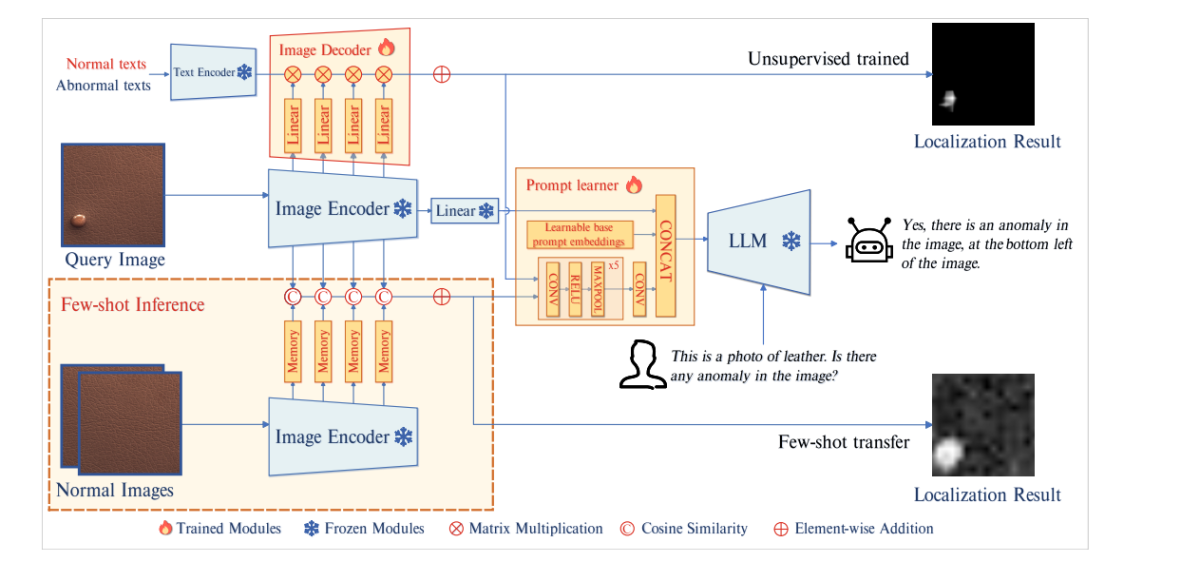

AnomalyGPT la baza sa este un nou model conversațional IAD de limbaj de viziune mare conceput în principal pentru detectarea anomaliilor industriale și identificarea locației lor exacte folosind imagini. Cadrul AnomalyGPT folosește un LLM și un codificator de imagine pre-antrenat pentru a alinia imaginile cu descrierile textuale corespunzătoare, folosind date de anomalii stimulate. Modelul introduce un modul de decodor și un modul de învățare prompt pentru a îmbunătăți performanța sistemelor IAD și a obține o ieșire de localizare la nivel de pixel.

Arhitectura model

Imaginea de mai sus prezintă arhitectura AnomalyGPT. Modelul transmite mai întâi imaginea de interogare la codificatorul de imagine înghețată. Modelul extrage apoi caracteristici la nivel de patch din straturile intermediare și transmite aceste caracteristici unui decodor de imagine pentru a calcula similaritatea lor cu textele anormale și normale pentru a obține rezultate pentru localizare. Cel care învață prompt le convertește apoi în înglobări prompte care sunt potrivite pentru a fi utilizate ca intrări în LLM alături de intrările de text ale utilizatorului. Modelul LLM folosește apoi înglobările prompte, intrările de imagini și intrările textuale furnizate de utilizator pentru a detecta anomalii și pentru a identifica locația acestora și pentru a crea răspunsuri finale pentru utilizator.

decodor

Pentru a realiza localizarea anomaliilor la nivel de pixel, modelul AnomalyGPT implementează un decodor de imagini ușor bazat pe potrivirea caracteristicilor, care acceptă atât cadre IAD cu câteva fotografii, cât și cadre IAD nesupravegheate. Designul decodorului utilizat în AnomalyGPT este inspirat de cadrele WinCLIP, PatchCore și APRIL-GAN. Modelul împarte codificatorul de imagine în 4 etape și extrage caracteristicile nivelului de corecție intermediar în fiecare etapă.

Cu toate acestea, aceste caracteristici intermediare nu au trecut prin alinierea finală imagine-text, motiv pentru care nu pot fi comparate direct cu caracteristicile. Pentru a rezolva această problemă, modelul AnomalyGPT introduce straturi suplimentare pentru a proiecta caracteristici intermediare și a le alinia cu caracteristicile de text care reprezintă semantică normală și anormală.

Învățător prompt

Cadrul AnomalyGPT introduce un cursant prompt care încearcă să transforme rezultatul localizării în înglobări prompte pentru a valorifica semantica fină din imagini și, de asemenea, menține consistența semantică între decodor și ieșirile LLM. În plus, modelul încorporează încorporarea promptă care poate fi învățată, fără legătură cu ieșirile decodorului, în cursantul prompt pentru a oferi informații suplimentare pentru sarcina IAD. În cele din urmă, modelul furnizează încorporarea și informațiile originale ale imaginii către LLM.

Persoana care învață prompt constă din încorporarea promptului de bază care poate fi învățată și o rețea neuronală convoluțională. Rețeaua convertește rezultatul localizării în înglobări prompte și formează un set de încorporare prompte care sunt apoi combinate cu încorporarea imaginii în LLM.

Simularea anomaliilor

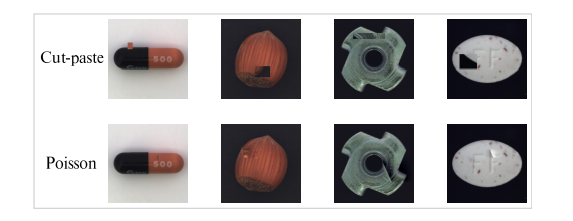

Modelul AnomalyGPT adoptă metoda NSA pentru a simula date anormale. Metoda NSA folosește tehnica Cut-paste folosind metoda Poisson de editare a imaginii pentru a atenua discontinuitatea introdusă prin lipirea segmentelor de imagine. Cut-paste este o tehnică frecvent utilizată în cadrele IAD pentru a genera imagini de anomalii simulate.

Metoda Cut-paste implică tăierea aleatorie a unei regiuni bloc dintr-o imagine și lipirea acesteia într-o locație aleatorie dintr-o altă imagine, creând astfel o porțiune de anomalie simulată. Aceste probe de anomalii simulate pot îmbunătăți performanța modelelor IAD, dar există un dezavantaj, deoarece pot produce adesea discontinuități vizibile. Metoda de editare Poisson urmărește să cloneze perfect un obiect dintr-o imagine în alta prin rezolvarea ecuațiilor cu diferențe parțiale Poisson.

Imaginea de mai sus ilustrează comparația dintre editarea imaginii Poisson și Cut-paste. După cum se poate observa, există discontinuități vizibile în metoda cut-paste, în timp ce rezultatele de la editarea Poisson par mai naturale.

Conținut de întrebări și răspunsuri

Pentru a efectua reglarea promptă a modelului de limbaj de viziune mare, modelul AnomalyGPT generează o interogare textuală corespunzătoare pe baza imaginii anomaliei. Fiecare interogare constă din două componente majore. Prima parte a interogării constă într-o descriere a imaginii de intrare care oferă informații despre obiectele prezente în imagine împreună cu atributele așteptate ale acestora. A doua parte a interogării este de a detecta prezența anomaliilor în interiorul obiectului sau de a verifica dacă există o anomalie în imagine.

LVLM răspunde mai întâi la întrebarea dacă există o anomalie în imagine? Dacă modelul detectează anomalii, continuă să precizeze locația și numărul zonelor anormale. Modelul împarte imaginea într-o grilă 3×3 de regiuni distincte pentru a permite LVLM să indice verbal poziția anomaliilor, așa cum se arată în figura de mai jos.

Modelul LVLM este alimentat cu cunoștințele descriptive ale intrării cu cunoștințe fundamentale ale imaginii de intrare care ajută modelul să înțeleagă mai bine componentele imaginii.

Seturi de date și valori de evaluare

Modelul își desfășoară experimentele în principal pe seturile de date VisA și MVTec-AD. Setul de date MVTech-AD constă din 3629 de imagini în scopuri de instruire și 1725 de imagini pentru testare, care sunt împărțite în 15 categorii diferite, motiv pentru care este unul dintre cele mai populare seturi de date pentru cadrele IAD. Imaginea de antrenament prezintă doar imagini normale, în timp ce imaginile de testare prezintă atât imagini normale, cât și anormale. Pe de altă parte, setul de date VisA constă din 9621 de imagini normale și aproape 1200 de imagini anormale care sunt împărțite în 12 categorii diferite.

Mergând de-a lungul, la fel ca cadrul IAD existent, modelul AnomalyGPT folosește AUC sau Area Under the Receiver Operating Characteristics ca metrică de evaluare, cu AUC la nivel de pixel și la nivel de imagine utilizate pentru a evalua performanța de localizare a anomaliilor și, respectiv, detectarea anomaliilor. Cu toate acestea, modelul utilizează, de asemenea, acuratețea la nivel de imagine pentru a evalua performanța abordării propuse, deoarece permite în mod unic determinarea prezenței anomaliilor fără a fi necesară setarea manuală a pragurilor.

REZULTATE

Rezultate cantitative

Detectarea anomaliilor industriale cu câteva lovituri

Modelul AnomalyGPT compară rezultatele sale cu cadrele IAD anterioare, incluzând PaDiM, SPADE, WinCLIP și PatchCore ca linii de bază.

Figura de mai sus compară rezultatele modelului AnomalyGPT în comparație cu cadrele IAD cu câteva rezultate. În ambele seturi de date, metoda urmată de AnomalyGPT depășește abordările adoptate de modelele anterioare în ceea ce privește AUC la nivel de imagine și oferă, de asemenea, o acuratețe bună.

Detectarea anomaliilor industriale nesupravegheate

Într-un cadru de antrenament nesupravegheat cu un număr mare de mostre normale, AnomalyGPT antrenează un singur model pe eșantioane obținute din toate clasele dintr-un set de date. Dezvoltatorii AnomalyGPT au optat pentru cadrul UniAD, deoarece este antrenat sub aceeași configurație și va acționa ca o bază pentru comparație. În plus, modelul se compară și cu cadrele JNLD și PaDim folosind aceeași setare unificată.

Figura de mai sus compară performanța AnomalyGPT în comparație cu alte cadre.

Rezultatele calitative

Imaginea de mai sus ilustrează performanța modelului AnomalyGPT în metoda de detectare nesupravegheată a anomaliilor, în timp ce figura de mai jos demonstrează performanța modelului în învățarea în context 1-shot.

Modelul AnomalyGPT este capabil să indice prezența anomaliilor, să marcheze locația acestora și să ofere rezultate de localizare la nivel de pixel. Când modelul este în metoda de învățare în context 1-shot, performanța de localizare a modelului este ușor mai scăzută în comparație cu metoda de învățare nesupravegheată din cauza absenței instruirii.

Concluzie

AnomalyGPT este un nou model de limbaj conversațional IAD-vizual conceput pentru a valorifica capabilitățile puternice ale modelelor de limbaj de viziune mari. Nu numai că poate identifica anomaliile dintr-o imagine, ci și locațiile exacte ale acestora. În plus, AnomalyGPT facilitează dialogurile cu mai multe rânduri axate pe detectarea anomaliilor și prezintă performanțe remarcabile în învățarea în context cu câteva fotografii. AnomalyGPT analizează potențialele aplicații ale LVLM-urilor în detectarea anomaliilor, introducând noi idei și posibilități pentru industria IAD.