Liderzy myśli

Wyścig o wdrożenie: dlaczego strategia chłodzenia decyduje o sukcesie sztucznej inteligencji na dużą skalę

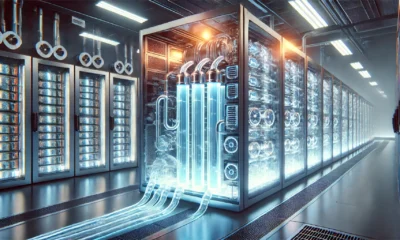

Podczas gdy nagłówki skupiają się na możliwościach sztucznej inteligencji i niedoborach chipów, w centrach danych na całym świecie rozwija się cichy kryzys. Najnowsze procesory AI generować więcej ciepła niż cokolwiek w historii informatyki – do 1,200 W na chip i wciąż rośnie. To fundamentalne wyzwanie fizyczne stało się prawdziwym wąskim gardłem we wdrażaniu sztucznej inteligencji, oddzielając zwycięzców od przegranych na rynku.

Organizacje, które rozwiązują tę zagadkę termiczną, nie tylko korzystają z chłodniejszych systemów – wdrażają możliwości sztucznej inteligencji o miesiące szybciej niż konkurencja, wydobywając więcej mocy obliczeniowej z każdego cennego megawata i budując trwałą przewagę konkurencyjną, która z czasem się kumuluje. Twoja strategia chłodzenia stała się Twoją strategią sztucznej inteligencji, decydującą o tym, jak szybko możesz spieniężyć inwestycje w sztuczną inteligencję i jak efektywnie możesz ją skalować.

Skala tego wyzwania staje się jasna, gdy przyjrzymy się najnowszym danym rynkowym. IDC Prognozy wskazują, że wydatki na infrastrukturę AI osiągną około 90 miliardów dolarów do 2028 roku. Wiele organizacji odkrywa jednak, że ich istniejąca infrastruktura chłodzenia nie jest w stanie sprostać wymaganiom termicznym współczesnych obciążeń AI. Ta luka infrastrukturalna tworzy nową dynamikę konkurencyjną, w której możliwości zarządzania temperaturą bezpośrednio decydują o pozycji rynkowej.

Dlaczego chłodzenie jest teraz Twoją kluczową ścieżką do wartości AI

Bariera fizyczna, której nie da się obejść za pomocą kodu

Dzisiejsze serwery AI zużywają 10-12 kW każdy, a szafy rack przekraczają 100 kW – natężenie, którego tradycyjne metody chłodzenia po prostu nie są w stanie obsłużyć. Dla porównania, typowa szafa serwerowa klasy enterprise zużywa 5-10 kW, co oznacza 10-20-krotny wzrost gęstości mocy. Chipy nowej generacji przekroczą 2,000 W, a gęstość mocy w szafach rack zbliży się do 600 kW.

Wyzwanie termiczne wykracza poza pojedyncze procesory i fundamentalnie zmienia infrastrukturę centrów danych. Wraz z szybkim rozwojem sprzętu AI w cyklach rocznych, organizacje muszą projektować systemy chłodzenia, które będą w stanie dostosować się do stale rosnącej gęstości mocy. Obecne wymagania dotyczące szaf rack o mocy 132 kW wymuszają obowiązkowe wdrażanie rozwiązania chłodzenia cieczą, ponieważ tradycyjne chłodzenie powietrzem po prostu nie jest w stanie rozproszyć ciepła generowanego przez te konfiguracje o wysokiej gęstości. Stwarza to złożone wyzwanie planistyczne: operatorzy centrów danych muszą jednocześnie obsługiwać obecne wdrożenia, przygotowując infrastrukturę dla procesorów nowej generacji, które jeszcze bardziej zwiększą zapotrzebowanie na ciepło.

To nie jest problem na przyszłość, ale bezpośrednie ograniczenie wdrożeniowe, które opóźnia dziś inicjatywy związane ze sztuczną inteligencją. Organizacje, które traktują zarządzanie temperaturą jako strategiczny priorytet, a nie jako kwestię drugorzędną, zyskują miesiące przewagi konkurencyjnej w zakresie czasu wprowadzania produktów na rynek.

Od centrum kosztów do przewagi strategicznej

Tradycyjny pogląd na chłodzenie jako niezbędny wydatek operacyjny zasadniczo błędnie interpretuje jego rolę w nowoczesnej infrastrukturze AI. Efektywność chłodzenia bezpośrednio decyduje o tym, ile mocy obliczeniowej można uzyskać z każdego ograniczonego megawata. Tradycyjne systemy chłodzenia zużywają do 40% mocy centrum danych, co generuje ogromne koszty alternatywne we wdrażaniu sztucznej inteligencji, gdzie każdy wat mocy obliczeniowej przekłada się bezpośrednio na wartość biznesową.

Organizacje wdrażające zaawansowane rozwiązania chłodzenia osiągają o 20% większą moc obliczeniową przy tym samym zużyciu energii – efektywnie przekształcając wydajność chłodzenia w dodatkową moc obliczeniową AI bez konieczności korzystania z nowych źródeł energii. Ten wzrost wydajności staje się jeszcze bardziej krytyczny, ponieważ ograniczenia mocy stają się głównym czynnikiem ograniczającym rozbudowę infrastruktury AI.

Konsekwencje ekonomiczne są znaczące. W przypadku typowego wdrożenia sztucznej inteligencji w przedsiębiorstwie zużywającego 1 MW energii, 20% poprawa efektywności chłodzenia przekłada się na 200 kW dodatkowej mocy obliczeniowej – co odpowiada około 20 dodatkowym serwerom sztucznej inteligencji bez konieczności inwestowania w dodatkową infrastrukturę energetyczną.

Trzyczęściowy model decyzyjny

Decyzja dotycząca strategii chłodzenia wymaga obecnie oceny trzech kluczowych czynników, z których każdy ma istotne implikacje biznesowe:

Obecne i przyszłe wymagania dotyczące gęstości: Tradycyjne chłodzenie staje się niepraktyczne powyżej 50 kW na szafę, a rozwiązania dwufazowe oferują znaczące korzyści przy mocy powyżej 100 kW. Organizacje muszą ocenić nie tylko obecne wymagania, ale także prognozowane zapotrzebowanie na gęstość mocy w ciągu najbliższych 3-5 lat. Analizy branżowe sugerują, że gęstość mocy obciążeń AI będzie rosła o 15-20% rocznie, co sprawia, że przyszłościowa architektura chłodzenia jest niezbędna.

Presja związana z harmonogramem wdrożenia: Na konkurencyjnych rynkach sztucznej inteligencji (AI) czas wdrożenia jest bezpośrednio skorelowany z przewagą rynkową. Rozwiązania, które przyspieszają wprowadzanie produktów na rynek, często przynoszą lepsze rezultaty biznesowe pomimo wyższych kosztów początkowych. Organizacje wdrażające modułowe rozwiązania chłodzenia deklarują o 40-60% krótszy czas wdrożenia w porównaniu z tradycyjnymi modernizacjami systemów chłodzenia, często odzyskując zwrot z inwestycji już w pierwszym roku użytkowania.

Ograniczenia obiektu: Istniejąca infrastruktura zasilania i chłodzenia nakłada twarde ograniczenia na opcje wdrażania. Podejścia hybrydowe umożliwiają ukierunkowane wdrożenia o wysokiej gęstości w ramach istniejącej infrastruktury, unikając kosztownej rozbudowy, która może trwać 12-18 miesięcy i wymagać znacznych nakładów inwestycyjnych.

Zaleta składania

Przyszłe procesory AI tylko zaostrzą wyzwania termiczne. Niezależnie od tego, czy chodzi o AMD, MI300X lub niestandardowego krzemu od Google, Amazon i Meta, branża dąży do wyższych gęstości mocy, które generują niespotykane dotąd zapotrzebowanie na chłodzenie. Wszystkie te procesory zostały zaprojektowane z myślą o maksymalnej gęstości wydajności, co sprawia, że zaawansowane zarządzanie temperaturą jest niezbędne w konkurencyjnych wdrożeniach AI.

Organizacje wdrażające dziś skalowalne architektury chłodzenia tworzą korzyści, które przekładają się na wiele generacji sprzętu. Najbardziej przyszłościowi operatorzy projektują systemy z mocą ponad 250 kW na szafę, wdrażają zaawansowane systemy monitorowania temperatury i opracowują zintegrowane podejścia, które optymalizują chłodzenie, dystrybucję energii i zasoby obliczeniowe jako jeden, ujednolicony system.

Nowa rzeczywistość infrastruktury AI

Rynek wyraźnie dzieli się obecnie na organizacje, które uznają chłodzenie za strategiczny imperatyw, i te, które traktują je jako wyzwanie taktyczne. Wraz z przyspieszeniem wdrożeń sztucznej inteligencji w 2025 roku, ta przepaść będzie się dramatycznie powiększać. Wiodący operatorzy już teraz osiągają terminy wdrożeń mierzone w miesiącach, a nie latach, uzyskując znacznie więcej mocy obliczeniowej przy ograniczonych zasobach energii i tworząc bardziej zrównoważone operacje przy zmniejszonym zużyciu energii.

Równie istotne są implikacje dla zrównoważonego rozwoju. Tradycyjne systemy chłodzenia zużywają do 40% energii w centrach danych, a zaawansowane technologie chłodzenia, które redukują te koszty, bezpośrednio wspierają zarówno efektywność operacyjną, jak i cele zrównoważonego rozwoju środowiskowego.

Podejmowanie działań: droga naprzód

Czas stopniowego chłodzenia minął. Organizacje, które chcą być liderami w dziedzinie sztucznej inteligencji, muszą teraz gruntownie przemyśleć swoją strategię termiczną. Ta transformacja wymaga postrzegania infrastruktury chłodniczej nie jako systemu wspomagającego, ale jako podstawowego czynnika umożliwiającego wykorzystanie możliwości sztucznej inteligencji.

Skuteczne wdrożenia rozpoczynają się od kompleksowej oceny termicznej, która porównuje obecne możliwości infrastruktury z przewidywanymi wymaganiami dotyczącymi obciążenia AI. Organizacje powinny nawiązać współpracę z dostawcami technologii chłodzenia na wczesnym etapie procesu planowania AI, aby upewnić się, że strategie termiczne są zgodne z harmonogramem wdrożenia i celami biznesowymi.

Najbardziej udane wdrożenia sztucznej inteligencji integrują strategię chłodzenia z początkowym procesem planowania infrastruktury, zamiast traktować ją jako kwestię drugorzędną. To zintegrowane podejście umożliwia szybsze wdrożenie, efektywniejsze wykorzystanie zasobów i większą długoterminową skalowalność.

W erze sztucznej inteligencji infrastruktura chłodzenia nie tylko wspiera technologię, ale także decyduje o tym, jak szybko można z niej wygenerować wartość. Przyszłość należy do tych, którzy potrafią szybko wdrażać, efektywnie skalować i dostosowywać się do dynamicznie zmieniających się wymagań dotyczących gęstości. Pytanie nie brzmi, czy transformować podejście do chłodzenia, ale jak szybko można to zrobić.