Artificial Intelligence

Pułap 75%: czy modele sztucznej inteligencji osiągnęły szczytową wydajność przy zastosowaniu obecnych metod?

Antropiczny oraz OpenAI zaprezentowała pionierskie modele sztucznej inteligencji (AI) w odstępie dwóch dni, przy czym oba osiągnęły praktycznie identyczną dokładność na poziomie 74-75% w branżowych testach kodowania, co wskazuje na potencjalny pułap wydajności dla obecnych architektur AI, jednocześnie przyjmując zupełnie inne podejścia do dystrybucji i wdrażania.

Niemal jednoczesne wydanie oprogramowania rodzi fundamentalne pytania o to, czy rozwój sztucznej inteligencji osiągnął już poziom szczytowy przy obecnych metodach szkolenia, nawet jeśli firmy mają bardzo rozbieżne poglądy na temat sposobu dostarczania tych możliwości użytkownikom i programistom na całym świecie.

Benchmark Convergence wskazuje na osiągnięcie kamienia milowego w dziedzinie technologii

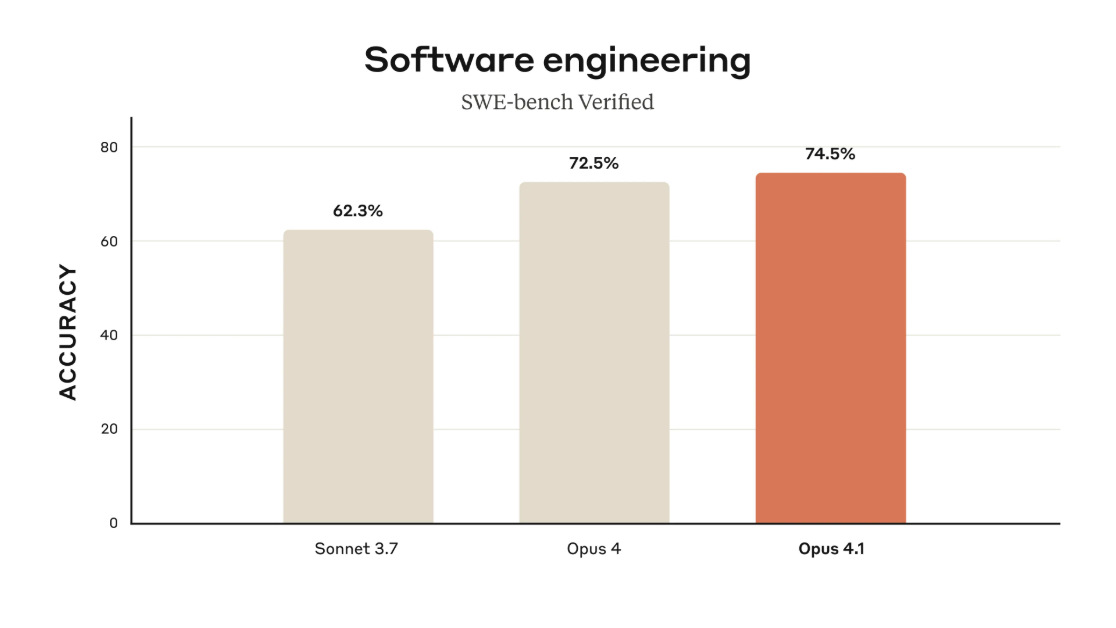

Claude Opus 4.1, wydany 5 sierpnia przez Anthropic, uzyskał wynik 74.5% w SWE-bench Verified, standardowym branżowym teście kodowania. GPT-5 OpenAI, ogłoszona 7 sierpnia, osiągnęła wynik 74.9% w tym samym teście — jest to statystyczny remis sugerujący, że obie firmy wykorzystały obecne architektury do podobnych granic, mimo że działały niezależnie.

Różnica 0.4% pomiędzy modelami mieści się w granicach szumu statystycznego dla tego typu testów porównawczych.

Jednakże podejścia architektoniczne różnią się znacząco. OpenAI zbudował GPT-5 jako system wielomodelowy z inteligentnym routingiem – zapytania są kierowane do szybkich odpowiedzi w przypadku prostych zadań, modeli wnioskowania w przypadku złożonych problemów lub mini wersji po osiągnięciu limitów obliczeniowych. W Opus 4.1 firma Anthropic utrzymała podejście jednomodelowe, stawiając spójność ponad specjalistyczną optymalizację.

Źródło: Anthropic

Strategie dystrybucji ujawniają konkurujące ze sobą filozofie

OpenAI natychmiast udostępniło GPT-5 wszystkim użytkownikom ChatGPT, w tym tym korzystającym z bezpłatnej wersji, docierając do około 700 milionów aktywnych użytkowników tygodniowo bez żadnych kosztów. Microsoft jednocześnie zintegrował model na platformach GitHub Copilot, Visual Studio Code, M365 Copilot i Azure.

Anthropic utrzymuje bardziej tradycyjne ograniczenia dostępu, oferując Opus 4.1 dla płatnych użytkowników Claude, za pośrednictwem Claude Code dla programistów oraz poprzez dostęp do API. Firma wydaje się być skoncentrowana na obsłudze programistów i przedsiębiorstw wymagających niezawodnej i spójnej wydajności, a nie na maksymalizacji zasięgu dystrybucji.

Ceny GPT-5 są agresywne, a twórcy sprzętu zauważają korzystny stosunek ceny do możliwości, co może wywrzeć presję na konkurencję i zmusić ją do dostosowania strategii cenowych.

Wymagania infrastrukturalne zmieniają ekonomię przemysłu

Wymagania obliczeniowe ujawniają ogromną skalę rozwoju pionierskiej sztucznej inteligencji. Według doniesień OpenAI utrzymuje Roczny kontrakt z Oracle na pojemność o wartości 30 miliardów dolarów, po przeszkoleniu GPT-5 na platformie Microsoft Azure przy użyciu procesorów graficznych NVIDIA H200. Meta ogłosiła plany wydania 72 miliardów dolarów na infrastrukturę AI tylko w 2025 roku.

Obie firmy zgłaszają znaczną poprawę w praktycznych zastosowaniach wykraczającą poza surowe testy porównawcze. OpenAI twierdzi, że GPT-5 wykazuje „około 45% mniej błędów niż GPT-4o” przy włączonym wyszukiwaniu w sieci, a tryb myślenia osiąga wyniki podobne do ich modelu o3, zużywając o 50-80% mniej tokenów – co oznacza znaczny wzrost wydajności.

Raporty GitHub Opus 4.1 pokazuje „znaczny wzrost wydajności przy refaktoryzacji kodu składającego się z wielu plików”, natomiast Cursor, popularny asystent kodowania AI, opisuje GPT-5 jako „niezwykle inteligentny i łatwy w obsłudze” – zgodnie z dokumentacją dla programistów OpenAI.

Źródło: OpenAI

Pułap techniczny sugeruje nadchodzącą zmianę paradygmatu

Zbieżność podobnych wskaźników wydajności w różnych firmach sugeruje, że obecne paradygmaty szkoleniowe mogą zbliżać się do swoich granic. Wiele modeli skupia się na poziomie dokładności 74-75% w testy kodowania oznacza, że kolejne duże ulepszenia mogą wymagać fundamentalnych innowacji, a nie stopniowego skalowania.

Kompromisy architektoniczne pomiędzy złożonym systemem routingu OpenAI a Zunifikowane podejście Anthropic odzwierciedlają różne filozofie, bez wyraźnego zwycięzcy. Wielomodelowy system GPT-5 oferuje elastyczność, ale wprowadza potencjalne punkty awarii, podczas gdy spójność Claude'a może oznaczać poświęcenie specjalistycznej wydajności na rzecz niezawodności.

Demokratyzacja pionierskich możliwości sztucznej inteligencji – z funkcjami, które dwa lata temu kosztowały tysiące dolarów rocznie, teraz dostępnymi za darmo – przyspiesza adopcję w różnych branżach. To przejście od sztucznej inteligencji jako usługi premium do infrastruktury użyteczności publicznej może umożliwić zupełnie nowe kategorie aplikacji.

Implikacje rynkowe i dalsze kroki

Obserwatorzy branży spodziewają się, że Anthropic zareaguje na strategię cenową OpenAI, choć najprawdopodobniej nie poprzez bezpośrednie dopasowywanie cen. DeepMind firmy Google a Meta, która początkowo była stosunkowo milcząca, prawdopodobnie podejmie działania w nadchodzących miesiącach.

48-godzinne okno czasowe między wydaniami ujawniło transformację sztucznej inteligencji z technologii eksperymentalnej w niezawodną infrastrukturę. Kiedy wiele firm osiąga niemal identyczne wyniki w testach porównawczych, różniąc się jedynie ułamkami procenta, konkurencja przesuwa się w kierunku efektywności wdrażania, jakości integracji i niezawodności usług.

Praktyczne udoskonalenia liczą się bardziej niż przewaga w testach porównawczych. SWE-bench Verified mierzy zdolność sztucznej inteligencji do identyfikowania i naprawiania rzeczywistych błędów w oprogramowaniu open source, a wyniki obu modeli odzwierciedlają znaczący postęp w zakresie możliwości autonomicznego kodowania.

W miarę jak modele sztucznej inteligencji stają się coraz bardziej zaawansowane pod względem rozumowania i możliwości kodowania, konkurencja przesuwa się od surowych wskaźników wydajności do praktycznej implementacji i niezawodności w środowiskach produkcyjnych. Zaskakująca prawda? Ta stabilność może umożliwić bardziej transformacyjne zmiany niż kolejny przełom.