Artificial Intelligence

Multimodalna sztuczna inteligencja ewoluuje w miarę jak ChatGPT zyskuje na popularności dzięki GPT-4V(ision)

W ramach ciągłych wysiłków, aby sztuczna inteligencja bardziej przypominała ludzi, modele GPT OpenAI nieustannie przesuwają granice. GPT-4 może teraz akceptować monity zawierające zarówno tekst, jak i obrazy.

Multimodalność w generatywnej sztucznej inteligencji oznacza zdolność modelu do tworzenia różnych wyników, takich jak tekst, obrazy lub dźwięk, w oparciu o dane wejściowe. Modele te, wytrenowane na konkretnych danych, uczą się podstawowych wzorców, aby generować podobne nowe dane, wzbogacając aplikacje AI.

Ostatnie postępy w multimodalnej sztucznej inteligencji

Niedawny znaczący postęp w tej dziedzinie widać po integracji DALL-E 3 z ChatGPT, co stanowi znaczące ulepszenie technologii zamiany tekstu na obraz OpenAI. Ta mieszanka pozwala na płynniejszą interakcję, podczas gdy ChatGPT pomaga w tworzeniu precyzyjnych podpowiedzi dla DALL-E 3, zamieniając pomysły użytkowników w żywą grafikę generowaną przez sztuczną inteligencję. Tak więc, chociaż użytkownicy mogą bezpośrednio wchodzić w interakcję z DALL-E 3, połączenie ChatGPT sprawia, że proces tworzenia grafiki AI jest znacznie bardziej przyjazny dla użytkownika.

Sprawdź więcej na temat DALL-E 3 i jego integracji z ChatGPT tutaj. Ta współpraca nie tylko prezentuje postęp w multimodalnej sztucznej inteligencji, ale także sprawia, że tworzenie dzieł sztuki AI jest dla użytkowników proste.

Z drugiej strony wprowadzono zdrowie Google Med-PaLM M w czerwcu tego roku. Jest to multimodalny model generatywny, który doskonale radzi sobie z kodowaniem i interpretacją różnorodnych danych biomedycznych. Osiągnięto to poprzez dostrojenie modelu językowego PaLM-E pod kątem potrzeb dziedzin medycznych przy użyciu benchmarku typu open source MultiMedBench. Ten test porównawczy składa się z ponad 1 miliona próbek z 7 typów danych biomedycznych i 14 zadań, takich jak odpowiadanie na pytania medyczne i generowanie raportów radiologicznych.

Różne branże wdrażają innowacyjne multimodalne narzędzia AI, aby przyspieszyć rozwój firmy, usprawnić operacje i zwiększyć zaangażowanie klientów. Postęp w zakresie możliwości sztucznej inteligencji w zakresie głosu, wideo i tekstu napędza rozwój multimodalnej sztucznej inteligencji.

Przedsiębiorstwa poszukują multimodalnych aplikacji AI zdolnych do zmiany modeli i procesów biznesowych, otwierając możliwości wzrostu w całym ekosystemie generatywnej sztucznej inteligencji, od narzędzi danych po powstające aplikacje AI.

Po marcowej premierze GPT-4 niektórzy użytkownicy zaobserwowali spadek jakości odpowiedzi w miarę upływu czasu, co było obawą powtarzaną przez znanych programistów i na forach OpenAI. Początkowo odrzucony przez OpenAI, później „The Puzzle of Monogamous Marriage” potwierdził problem. Wykazało spadek dokładności GPT-4 z 97.6% do 2.4% w okresie od marca do czerwca, co wskazuje na spadek jakości odpowiedzi wraz z kolejnymi aktualizacjami modelu.

Szum wokół Otwórz AI ChatGPT powraca teraz. Teraz jest wyposażony w funkcję widzenia GPT-4V, umożliwiając użytkownikom GPT-4 analizowanie dostarczonych przez nich obrazów. Jest to najnowsza funkcja udostępniona użytkownikom.

Dodanie analizy obrazu do dużych modeli językowych (LLM), takich jak GPT-4, jest przez niektórych postrzegane jako duży krok naprzód w badaniach i rozwoju sztucznej inteligencji. Ten rodzaj multimodalnego LLM otwiera nowe możliwości, wyciągając modele językowe poza tekst, aby oferować nowe interfejsy i rozwiązywać nowe rodzaje zadań, tworząc nowe doświadczenia dla użytkowników.

Szkolenie GPT-4V zakończono w 2022 r., a wczesny dostęp został wprowadzony w marcu 2023 r. Funkcje wizualne w GPT-4V są obsługiwane przez technologię GPT-4. Proces szkolenia pozostał taki sam. Początkowo model szkolono tak, aby przewidywał następne słowo w tekście, korzystając z ogromnego zbioru danych składającego się zarówno z tekstu, jak i obrazów z różnych źródeł, w tym z Internetu.

Później dostrojono go, dodając więcej danych, stosując metodę zwaną uczeniem się przez wzmacnianie na podstawie informacji zwrotnych od ludzi (RLHF) w celu wygenerowania preferowanych przez ludzi wyników.

Mechanika wizyjna GPT-4

Niezwykłe możliwości języka wizyjnego GPT-4, choć imponujące, mają ukryte metody, które pozostają na powierzchni.

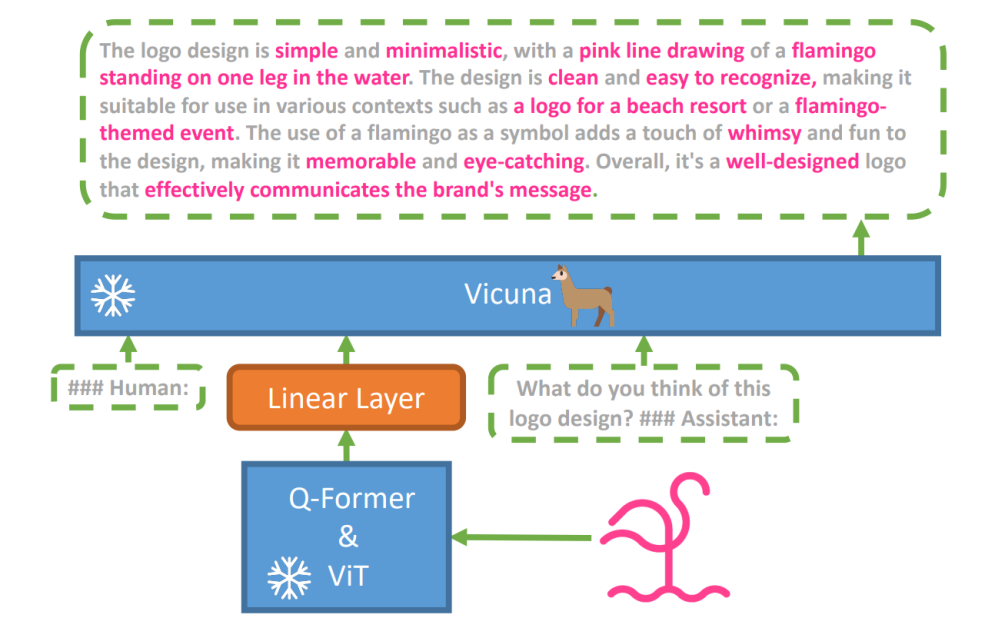

Aby zbadać tę hipotezę, opracowano nowy model języka wizyjnego, miniGPT-4 został wprowadzony, wykorzystując zaawansowany LLM o nazwie Wigoń. Model ten wykorzystuje koder wizyjny ze wstępnie wytrenowanymi komponentami do percepcji wzrokowej, dopasowując zakodowane cechy wizualne do modelu języka Vicuna za pośrednictwem pojedynczej warstwy projekcyjnej. Architektura MiniGPT-4 jest prosta, ale skuteczna i skupia się na dostosowaniu funkcji wizualnych i językowych w celu poprawy możliwości komunikacji wizualnej.

Architektura MiniGPT-4 obejmuje koder wizyjny z wstępnie wytrenowanym ViT i Q-Former, pojedynczą warstwę projekcji liniowej oraz zaawansowany model wielkojęzykowy Vicuna.

Wzrosła również tendencja do stosowania autoregresyjnych modeli językowych w zadaniach wzrokowo-językowych, wykorzystujących transfer międzymodalny w celu dzielenia się wiedzą między dziedzinami językowymi i multimodalnymi.

MiniGPT-4 łączy domeny wizualne i językowe, dostosowując informacje wizualne z wstępnie przeszkolonego kodera wizyjnego do zaawansowanego LLM. Model wykorzystuje Vicuna jako dekoder języka i opiera się na dwuetapowym podejściu szkoleniowym. Początkowo jest szkolony na dużym zbiorze danych składającym się z par obraz-tekst, aby uchwycić wiedzę związaną z wizją i językiem, a następnie dostraja się na mniejszym, wysokiej jakości zbiorze danych, aby zwiększyć niezawodność i użyteczność generowania.

Aby poprawić naturalność i użyteczność generowanego języka w MiniGPT-4, badacze opracowali dwuetapowy proces dopasowywania, mający na celu wyeliminowanie braku odpowiednich zbiorów danych dotyczących dopasowania wzroku i języka. W tym celu stworzyli specjalistyczny zbiór danych.

Początkowo model generował szczegółowe opisy obrazów wejściowych, zwiększając szczegółowość za pomocą podpowiedzi konwersacyjnych dostosowanych do formatu modelu języka Vicuna. Ten etap miał na celu wygenerowanie bardziej kompleksowych opisów obrazów.

Początkowy monit o opis obrazu:

###Człowiek: Opisz szczegółowo ten obraz. Podaj jak najwięcej szczegółów. Powiedz wszystko, co widzisz. ###Asystent:

Na potrzeby postprocessingu danych wszelkie niespójności lub błędy w wygenerowanych opisach zostały poprawione za pomocą ChatGPT, a następnie przeprowadzono ręczną weryfikację w celu zapewnienia wysokiej jakości.

Podpowiedź dostrajania drugiego etapu:

###Człowiek: ###Asystent:

Ta eksploracja otwiera okno na zrozumienie mechaniki multimodalnej generatywnej sztucznej inteligencji, takiej jak GPT-4, rzucając światło na to, jak można skutecznie zintegrować modalności wzrokowe i językowe w celu wygenerowania spójnych i bogatych kontekstowo wyników.

Odkrywanie wizji GPT-4

Określanie pochodzenia obrazu za pomocą ChatGPT

GPT-4 Vision zwiększa zdolność ChatGPT do analizowania obrazów i określania ich pochodzenia geograficznego. Ta funkcja przenosi interakcje użytkownika z samego tekstu na mieszankę tekstu i elementów wizualnych, stając się przydatnym narzędziem dla osób zainteresowanych różnymi miejscami za pomocą danych obrazowych.

Złożone pojęcia matematyczne

GPT-4 Vision specjalizuje się w zagłębianiu się w złożone koncepcje matematyczne poprzez analizę wyrażeń graficznych lub pisanych odręcznie. Ta funkcja stanowi przydatne narzędzie dla osób chcących rozwiązywać skomplikowane problemy matematyczne, co oznacza, że GPT-4 Vision jest godną uwagi pomocą w dziedzinach edukacyjnych i akademickich.

Konwersja odręcznego wprowadzania danych na kody LaTeX

Jedną z niezwykłych możliwości GPT-4V jest jego zdolność do tłumaczenia odręcznych danych wejściowych na kody LaTeX. Ta funkcja jest dobrodziejstwem dla badaczy, pracowników akademickich i studentów, którzy często muszą konwertować odręczne wyrażenia matematyczne lub inne informacje techniczne na format cyfrowy. Transformacja z pisma ręcznego na LaTeX poszerza horyzonty digitalizacji dokumentów i upraszcza proces technicznego pisania.

Wyodrębnianie szczegółów tabeli

GPT-4V charakteryzuje się umiejętnością wydobywania szczegółów z tabel i odpowiadania na powiązane zapytania, co jest istotnym atutem w analizie danych. Użytkownicy mogą wykorzystywać GPT-4V do przeglądania tabel, zbierania kluczowych spostrzeżeń i rozwiązywania pytań opartych na danych, co czyni go solidnym narzędziem dla analityków danych i innych specjalistów.

Zrozumienie wskazywania wzrokowego

Unikalna zdolność GPT-4V do zrozumienia wskazań wizualnych dodaje nowy wymiar interakcji użytkownika. Rozumiejąc wskazówki wizualne, GPT-4V może odpowiadać na zapytania z większym zrozumieniem kontekstu.

Tworzenie prostych makiet stron internetowych na podstawie rysunku

Motywowany tym ćwierkać, podjąłem próbę stworzenia makiety witryny unite.ai.

Chociaż wynik nie do końca odpowiadał mojej początkowej wizji, oto wynik, który osiągnąłem.

Ograniczenia i wady GPT-4V (ision)

Aby przeanalizować GPT-4V, zespół Open AI przeprowadził oceny jakościowe i ilościowe. Testy jakościowe obejmowały testy wewnętrzne i recenzje ekspertów zewnętrznych, natomiast ilościowe mierzyły odmowy modeli i dokładność w różnych scenariuszach, takich jak identyfikacja szkodliwych treści, rozpoznawanie danych demograficznych, obawy dotyczące prywatności, geolokalizacja, cyberbezpieczeństwo i multimodalne jailbreaki.

Jednak model nie jest idealny.

Połączenia papier podkreśla ograniczenia GPT-4V, takie jak nieprawidłowe wnioski i brakujący tekst lub znaki na obrazach. Może wywoływać halucynacje lub wymyślać fakty. W szczególności nie nadaje się do identyfikowania substancji niebezpiecznych na obrazach, często powodując ich błędną identyfikację.

W obrazowaniu medycznym GPT-4V może dawać niespójne odpowiedzi i brak świadomości standardowych praktyk, co prowadzi do potencjalnych błędnych diagnoz.

Niewiarygodne działanie do celów medycznych (Źródło)

Nie wychwytuje również niuansów niektórych symboli nienawiści i może generować nieodpowiednie treści na podstawie danych wizualnych. OpenAI odradza używanie GPT-4V do krytycznych interpretacji, szczególnie w kontekstach medycznych lub wrażliwych.

Owijanie w górę

Utworzono przy użyciu Fast Stable Diffusion XL https://huggingface.co/spaces/google/sdxl

Pojawienie się GPT-4 Vision (GPT-4V) niesie ze sobą mnóstwo ciekawych możliwości i nowe przeszkody do przeskakiwania. Przed jego wprowadzeniem włożono wiele wysiłku w to, aby ryzyko, szczególnie jeśli chodzi o zdjęcia ludzi, zostało dobrze zbadane i ograniczone. To imponujące widzieć, jak GPT-4V przyspieszył, wykazując wiele obietnic w trudnych obszarach, takich jak medycyna i nauka.

Teraz na stole leży kilka ważnych pytań. Na przykład, czy te modele powinny być w stanie rozpoznać sławne osoby na podstawie zdjęć? Czy powinni odgadnąć płeć, rasę lub uczucia danej osoby na podstawie zdjęcia? Czy należy wprowadzić specjalne usprawnienia, aby pomóc osobom niedowidzącym? Te pytania otwierają puszkę robaków na temat prywatności, uczciwości i tego, jak sztuczna inteligencja powinna wpasować się w nasze życie, a jest to coś, w czym każdy powinien mieć coś do powiedzenia.