Artificial Intelligence

Mniej znaczy więcej: dlaczego pobieranie mniejszej liczby dokumentów może poprawić odpowiedzi AI

Generacja wzmocniona odzyskiwaniem (RAG) jest podejściem do budowania systemów AI, które łączy model języka z zewnętrznym źródłem wiedzy. Mówiąc prościej, AI najpierw wyszukuje odpowiednie dokumenty (takie jak artykuły lub strony internetowe) związane z zapytaniem użytkownika, a następnie używa tych dokumentów do wygenerowania dokładniejszej odpowiedzi. Ta metoda została doceniona za pomoc duże modele językowe (LLM) trzymać się faktów i ograniczać halucynacje, opierając swoje odpowiedzi na prawdziwych danych.

Intuicyjnie można by pomyśleć, że im więcej dokumentów AI pobierze, tym bardziej świadoma będzie jego odpowiedź. Jednak ostatnie badania sugerują zaskakujący zwrot akcji: jeśli chodzi o dostarczanie informacji AI, czasami mniej znaczy więcej.

Mniej dokumentów, lepsze odpowiedzi

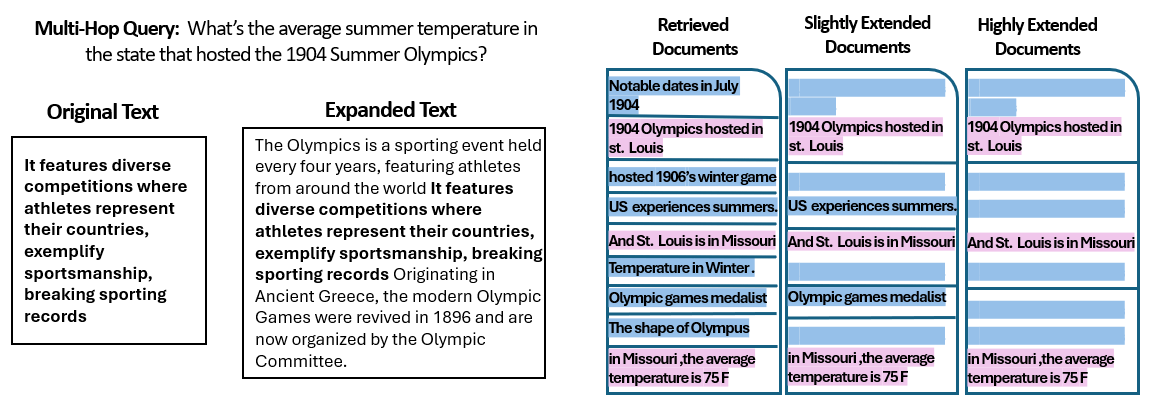

A Nowe badania przez naukowców z Uniwersytetu Hebrajskiego w Jerozolimie zbadali, w jaki sposób numer dokumentów przekazanych do systemu RAG wpływa na jego wydajność. Co najważniejsze, zachowali oni stałą całkowitą ilość tekstu – co oznacza, że jeśli dostarczono mniej dokumentów, dokumenty te były nieznacznie rozszerzane, aby wypełnić tę samą długość, co wiele innych dokumentów. W ten sposób wszelkie różnice w wydajności można było przypisać ilości dokumentów, a nie po prostu krótszemu wprowadzaniu danych.

Naukowcy wykorzystali zestaw danych typu pytanie-odpowiedź (MuSiQue) z pytaniami typu quiz, z których każde było pierwotnie połączone z 20 akapitami Wikipedii (tylko kilka z nich zawierało odpowiedź, a reszta była rozpraszająca). Zmniejszając liczbę dokumentów z 20 do zaledwie 2–4 naprawdę istotnych – i uzupełniając je odrobiną dodatkowego kontekstu, aby zachować spójną długość – stworzyli scenariusze, w których sztuczna inteligencja miała mniej materiałów do rozważenia, ale nadal mniej więcej taką samą liczbę słów do przeczytania.

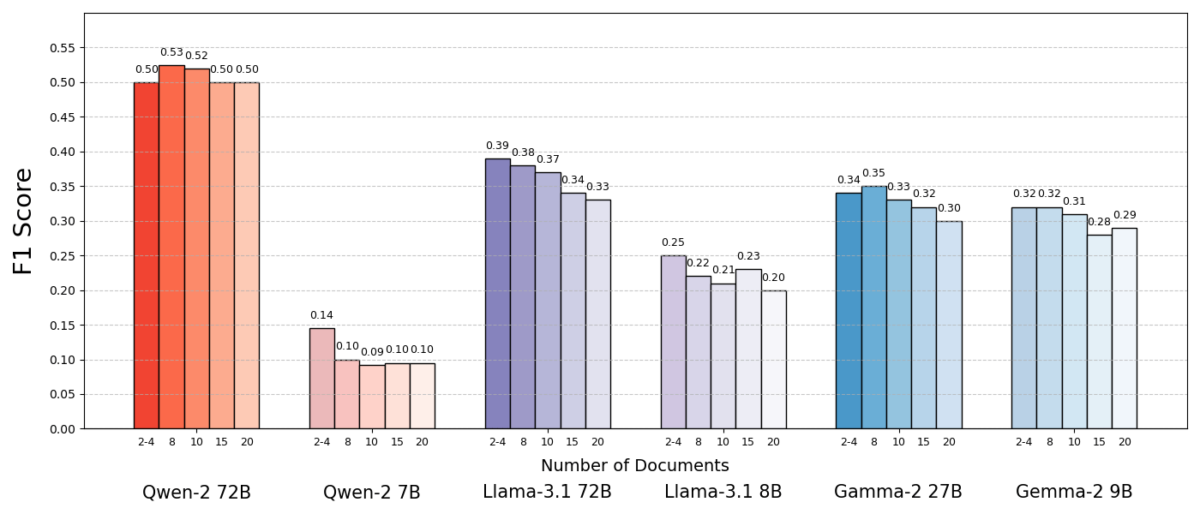

Wyniki były uderzające. W większości przypadków modele AI odpowiadały dokładniej, gdy podano im mniej dokumentów, a nie cały zestaw. Wydajność znacznie się poprawiła – w niektórych przypadkach nawet o 10% dokładności (wynik F1), gdy system używał tylko kilku dokumentów pomocniczych zamiast dużej kolekcji. Ten kontrintuicyjny wzrost zaobserwowano w kilku różnych modelach języka open source, w tym wariantach Meta's Llama i innych, co wskazuje, że zjawisko to nie jest związane z pojedynczym modelem AI.

Jeden model (Qwen-2) był godnym uwagi wyjątkiem, który obsługiwał wiele dokumentów bez spadku wyniku, ale prawie wszystkie testowane modele działały lepiej przy mniejszej liczbie dokumentów. Innymi słowy, dodawanie większej ilości materiałów referencyjnych poza kluczowymi istotnymi fragmentami faktycznie częściej szkodziło ich wydajności niż pomagało.

Źródło: Levy i in.

Dlaczego to takie zaskakujące? Zazwyczaj systemy RAG są projektowane z założeniem, że pobieranie szerszego zakresu informacji może pomóc tylko AI – w końcu jeśli odpowiedź nie znajduje się w pierwszych kilku dokumentach, może znajdować się w dziesiątym lub dwudziestym.

To badanie odwraca ten scenariusz, pokazując, że bezmyślne dokładanie dodatkowych dokumentów może przynieść odwrotny skutek. Nawet gdy całkowita długość tekstu była stała, sama obecność wielu różnych dokumentów (każdy z własnym kontekstem i dziwactwami) sprawiała, że zadanie pytania-odpowiedzi było trudniejsze dla AI. Wydaje się, że po przekroczeniu pewnego punktu każdy dodatkowy dokument wprowadzał więcej szumu niż sygnału, co dezorientowało model i upośledzało jego zdolność do wyodrębnienia prawidłowej odpowiedzi.

Dlaczego mniej może znaczyć więcej w RAG

Ten wynik „mniej znaczy więcej” ma sens, gdy weźmiemy pod uwagę, jak modele językowe AI przetwarzają informacje. Gdy AI otrzymuje tylko najbardziej istotne dokumenty, kontekst, który widzi, jest skupiony i wolny od rozproszeń, podobnie jak uczeń, któremu podano dokładnie odpowiednie strony do nauki.

W badaniu modele działały znacznie lepiej, gdy podano im tylko dokumenty pomocnicze, z usuniętym nieistotnym materiałem. Pozostały kontekst był nie tylko krótszy, ale i czystszy – zawierał fakty, które bezpośrednio wskazywały na odpowiedź i nic więcej. Mając mniej dokumentów do żonglowania, model mógł poświęcić całą uwagę odpowiednim informacjom, co zmniejszało prawdopodobieństwo zboczenia z tematu lub zdezorientowania.

Z drugiej strony, gdy odzyskiwano wiele dokumentów, AI musiała przeszukiwać mieszankę istotnych i nieistotnych treści. Często te dodatkowe dokumenty były „podobne, ale niezwiązane” – mogły mieć wspólny temat lub słowa kluczowe z zapytaniem, ale w rzeczywistości nie zawierać odpowiedzi. Taka treść może wprowadzić model w błąd. AI może marnować wysiłek, próbując połączyć punkty w dokumentach, które w rzeczywistości nie prowadzą do prawidłowej odpowiedzi, lub co gorsza, może łączyć informacje z wielu źródeł niepoprawnie. Zwiększa to ryzyko halucynacji – przypadków, w których AI generuje odpowiedź, która brzmi wiarygodnie, ale nie jest oparta na żadnym pojedynczym źródle.

Zasadniczo wprowadzenie do modelu zbyt wielu dokumentów może rozwodnić przydatne informacje i wprowadzić sprzeczne szczegóły, utrudniając sztucznej inteligencji ocenę, co jest prawdą.

Co ciekawe, badacze odkryli, że jeśli dodatkowe dokumenty były ewidentnie nieistotne (na przykład losowy, niezwiązany tekst), modele lepiej je ignorowały. Prawdziwy problem polega na rozpraszaniu uwagi danymi, które wydają się istotne: gdy wszystkie pobrane teksty dotyczą podobnych tematów, sztuczna inteligencja zakłada, że powinna wykorzystać wszystkie z nich i może mieć trudności z określeniem, które szczegóły są rzeczywiście ważne. Jest to zgodne z obserwacją badania, że losowe rozpraszacze uwagi powodowały mniejsze zamieszanie niż realistyczne rozpraszacze uwagi w danych wejściowych. AI może filtrować oczywiste bzdury, ale subtelnie niezwiązane z tematem informacje są sprytną pułapką – wślizgują się pod pozorem trafności i wykolejają odpowiedź. Ograniczając liczbę dokumentów do tych naprawdę niezbędnych, unikamy zastawiania tych pułapek.

Istnieje również praktyczna korzyść: pobieranie i przetwarzanie mniejszej liczby dokumentów obniża obciążenie obliczeniowe systemu RAG. Każdy wciągnięty dokument musi zostać przeanalizowany (osadzony, odczytany i obsłużony przez model), co zużywa czas i zasoby obliczeniowe. Eliminacja zbędnych dokumentów sprawia, że system jest bardziej wydajny – może znajdować odpowiedzi szybciej i przy niższych kosztach. W scenariuszach, w których dokładność wzrosła dzięki skupieniu się na mniejszej liczbie źródeł, uzyskujemy sytuację korzystną dla obu stron: lepsze odpowiedzi i szczuplejszy, bardziej wydajny proces.

Źródło: Levy i in.

Nowe spojrzenie na RAG: przyszłe kierunki

Ten nowy dowód, że jakość często pokonuje ilość w wyszukiwaniu, ma ważne implikacje dla przyszłości systemów AI, które polegają na zewnętrznej wiedzy. Sugeruje, że projektanci systemów RAG powinni stawiać inteligentne filtrowanie i rankingowanie dokumentów na pierwszym miejscu, a nie samą objętość. Zamiast pobierać 100 możliwych fragmentów i mieć nadzieję, że odpowiedź jest gdzieś tam ukryta, mądrzej byłoby pobrać tylko kilka najważniejszych, najbardziej istotnych.

Autorzy badania podkreślają potrzebę metod wyszukiwania, aby „zachować równowagę między trafnością a różnorodnością” w informacjach, które dostarczają modelowi. Innymi słowy, chcemy zapewnić wystarczające pokrycie tematu, aby odpowiedzieć na pytanie, ale nie tak bardzo, aby podstawowe fakty utonęły w morzu zbędnego tekstu.

Idąc dalej, badacze prawdopodobnie będą badać techniki, które pomogą modelom AI obsługiwać wiele dokumentów bardziej elegancko. Jednym z podejść jest opracowanie lepszych systemów wyszukiwania lub re-rankerów, które mogą identyfikować, które dokumenty naprawdę dodają wartości, a które jedynie wprowadzają konflikt. Innym kątem jest ulepszanie samych modeli językowych: jeśli jeden model (taki jak Qwen-2) poradził sobie z wieloma dokumentami bez utraty dokładności, zbadanie, w jaki sposób został wyszkolony lub ustrukturyzowany, może dać wskazówki, jak uczynić inne modele bardziej wytrzymałymi. Być może przyszłe duże modele językowe będą zawierać mechanizmy rozpoznawania, kiedy dwa źródła mówią to samo (lub sobie zaprzeczają) i odpowiednio się na nich skupiać. Celem byłoby umożliwienie modelom wykorzystania bogatej różnorodności źródeł bez popadania w zamieszanie – skutecznie uzyskując to, co najlepsze z obu światów (szerokość informacji i jasność skupienia).

Warto również zauważyć, że Systemy AI zyskują szersze okna kontekstowe (możliwość odczytania większej ilości tekstu na raz), samo wrzucenie większej ilości danych do monitu nie jest panaceum. Większy kontekst nie oznacza automatycznie lepszego zrozumienia. To badanie pokazuje, że nawet jeśli sztuczna inteligencja technicznie może przeczytać 50 stron na raz, dostarczenie jej 50 stron informacji o mieszanej jakości może nie przynieść dobrych rezultatów. Model nadal korzysta z posiadania wyselekcjonowanej, istotnej treści do pracy, a nie bezładnego zrzutu. W rzeczywistości inteligentne pobieranie może stać się jeszcze ważniejsze w erze gigantycznych okien kontekstowych – aby zapewnić, że dodatkowa pojemność zostanie wykorzystana na cenną wiedzę, a nie na szum.

Wyniki z „Więcej dokumentów, ta sama długość” (odpowiednio zatytułowany artykuł) zachęca do ponownego zbadania naszych założeń w badaniach nad sztuczną inteligencją. Czasami dostarczanie sztucznej inteligencji wszystkich posiadanych przez nas danych nie jest tak skuteczne, jak nam się wydaje. Skupiając się na najbardziej istotnych informacjach, nie tylko poprawiamy dokładność odpowiedzi generowanych przez sztuczną inteligencję, ale także sprawiamy, że systemy są bardziej wydajne i łatwiejsze do zaufania. To lekcja kontrintuicyjna, ale o ekscytujących konsekwencjach: przyszłe systemy RAG mogą być zarówno inteligentniejsze, jak i szczuplejsze dzięki ostrożnemu wybieraniu mniejszej liczby lepszych dokumentów do pobrania.