Kąt Andersona

Naprawianie ograniczonego zrozumienia luster i odbić przez modele dyfuzyjne

Od czasu, gdy sztuczna inteligencja generatywna zaczęła budzić zainteresowanie opinii publicznej, badania nad komputerowym widzeniem pogłębiły zainteresowanie opracowywaniem modeli sztucznej inteligencji zdolnych do rozumienia i powielania praw fizyki. Jednak wyzwaniem jest nauczenie systemów uczenia maszynowego symulowania zjawisk takich jak grawitacja i dynamika cieczy jest znaczącym obszarem zainteresowania badawczego co najmniej od ostatnie pięć lat.

Ponieważ modele dyfuzji ukrytej (LDM) zaczęły dominować na scenie generatywnej sztucznej inteligencji w 2022 r., jak twierdzą badacze coraz bardziej skupiony O ograniczonej zdolności architektury LDM do rozumienia i odtwarzania zjawisk fizycznych. Kwestia ta zyskała na znaczeniu dzięki przełomowemu rozwojowi generatywnego modelu wideo OpenAI. Sorze, i (prawdopodobnie) bardziej znaczące ostatnie wydanie oprogramowania typu open source wideo modele Wideo Hunyuan oraz Wan 2.1.

Odbijanie się źle

Większość badań mających na celu poprawę zrozumienia fizyki przez LDM skupiała się na takich obszarach, jak symulacja chodu, fizyka cząstek elementarnych i inne aspekty ruchu Newtona. Obszary te przyciągnęły uwagę, ponieważ niedokładności w podstawowych zachowaniach fizycznych natychmiast podważyłyby autentyczność wideo generowanego przez AI.

Jednakże niewielki, ale rosnący nurt badań skupia się na jednej z największych słabości LDM – względna niezdolność produkować dokładne refleksje.

W artykule ze stycznia 2025 r. pt. „Odbijanie rzeczywistości: umożliwienie modelom dyfuzji generowania wiernych odbić lustrzanych” przedstawiono przykłady „niepowodzenia odbicia” w zestawieniu z podejściem samych badaczy. Źródło: https://arxiv.org/pdf/2409.14677

Ten problem stanowił również wyzwanie w erze CGI i nadal stanowi je w dziedzinie gier wideo, gdzie Ray-śledzenia algorytmy symulują ścieżkę światła, gdy oddziałuje ono na powierzchnie. Ray-tracing oblicza, w jaki sposób wirtualne promienie światła odbijają się od obiektów lub przechodzą przez nie, aby tworzyć realistyczne odbicia, załamania i cienie.

Jednakże, ponieważ każde dodatkowe odbicie znacznie zwiększa koszty obliczeniowe, aplikacje czasu rzeczywistego muszą szukać kompromisu pomiędzy opóźnieniem a dokładnością, ograniczając liczbę dozwolonych odbić promieni świetlnych.

![Reprezentacja wirtualnie obliczonej wiązki światła w tradycyjnym scenariuszu opartym na 3D (tj. CGI), wykorzystującym technologie i zasady opracowane po raz pierwszy w latach 1960. XX wieku, które osiągnęły apogeum w latach 1982–93 (okres między filmami Tron [1982] i Jurassic Park [1993]. Źródło: https://www.unrealengine.com/en-US/explainers/ray-tracing/what-is-real-time-ray-tracing](https://www.unite.ai/wp-content/uploads/2025/04/ray-tracing.jpg)

Reprezentacja wirtualnie obliczonej wiązki światła w tradycyjnym scenariuszu 3D (tj. CGI), wykorzystująca technologie i zasady opracowane po raz pierwszy w latach 1960. XX wieku, a które osiągnęły szczyt w latach 1982–93 (między „Tronem” [1982] a „Parkiem Jurajskim” [1993]). Źródło: https://www.unrealengine.com/en-US/explainers/ray-tracing/what-is-real-time-ray-tracing

Każde dodatkowe odbicie znacznie zwiększa koszty obliczeniowe, często podwajając czas renderowania, co przyspiesza obsługę odbić jedna z najważniejszych okazji w celu poprawy jakości renderowania z wykorzystaniem śledzenia promieni.

Naturalnie, odbicia występują i są niezbędne w fotorealizmie w znacznie mniej oczywistych scenariuszach – na przykład w odblaskowej powierzchni miejskiej ulicy lub pola bitwy po deszczu, w odbiciu przeciwległej ulicy w oknie sklepowym lub szklanych drzwiach wejściowych albo w okularach przedstawionych postaci, gdzie wymagane może być pojawienie się obiektów i otoczenia.

Symulowane odbicie bliźniacze uzyskane za pomocą tradycyjnej kompozycji w kultowej scenie z filmu „Matrix” (1999).

Problemy z obrazem

Z tego powodu popularne przed pojawieniem się modeli dyfuzyjnych ramy, takie jak Neuronowe pola promieniowania (NeRF) i kilku nowszych konkurentów, takich jak Rozpryskiwanie Gaussa podtrzymywali własne zmagania, aby w naturalny sposób wyrażać swoje refleksje.

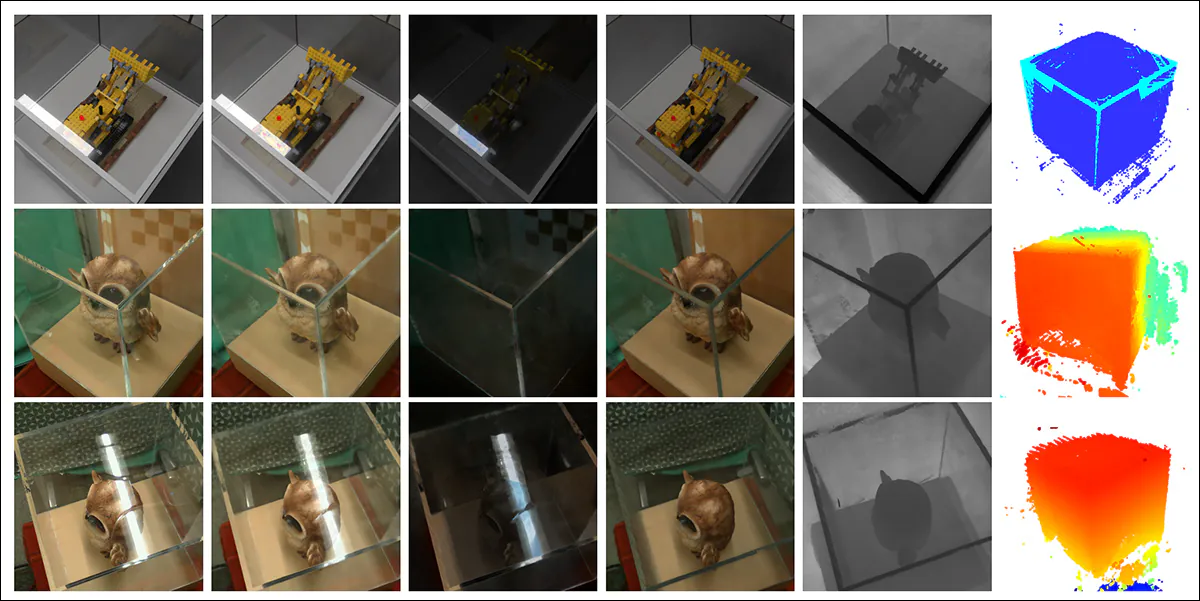

RE2-NeRF projekt (przedstawiony poniżej) zaproponował metodę modelowania opartą na NeRF dla scen zawierających szklaną gablotę. W tej metodzie refrakcja i odbicie były modelowane przy użyciu elementów zależnych i niezależnych od perspektywy widza. To podejście pozwoliło badaczom oszacować powierzchnie, na których wystąpiło załamanie, w szczególności powierzchnie szklane, i umożliwiło rozdzielenie i modelowanie zarówno bezpośrednich, jak i odbitych składowych światła.

Przykłady z artykułu Ref2Nerf. Źródło: https://arxiv.org/pdf/2311.17116

Inne rozwiązania refleksyjne z ostatnich 4–5 lat skierowane na NeRF obejmowały Nie, Odzwierciedlanie rzeczywistościi Meta 2024 Pola promieniowania neuronowego uwzględniające odbicie planarne projekt.

W przypadku GSplat artykuły takie jak: Lustro-3DGS, Odblaskowe rozpryskiwanie Gaussa, RefGaussa zaproponował rozwiązania dotyczące problemu odbicia, podczas gdy w 2023 r. Projekt Nero zaproponował specjalną metodę włączania cech refleksyjnych do reprezentacji neuronalnych.

Lustrzany Werset

Sprawienie, aby model dyfuzji respektował logikę odbicia, jest prawdopodobnie trudniejsze niż w przypadku jawnie strukturalnych, niesemantycznych podejść, takich jak Gaussian Splatting i NeRF. W modelach dyfuzji reguła tego rodzaju prawdopodobnie zostanie niezawodnie osadzona tylko wtedy, gdy dane treningowe zawierają wiele zróżnicowanych przykładów w szerokim zakresie scenariuszy, co sprawia, że jest ona silnie zależna od dystrybucji i jakości oryginalnego zestawu danych.

Tradycyjnie dodawanie konkretnych zachowań tego typu jest domeną LoRA albo strojenie modelu bazowego; nie są to jednak rozwiązania idealne, ponieważ LoRA ma tendencję do przechylania wyników w kierunku własnych danych treningowych, nawet bez podpowiedzi, podczas gdy dostrajanie – oprócz tego, że jest kosztowne – może nieodwracalnie oddzielić główny model od głównego nurtu i wygenerować mnóstwo powiązanych niestandardowych narzędzi, które nigdy nie będą działać z żadnym Inne odkształcenie modelu, łącznie z oryginalnym.

Ogólnie rzecz biorąc, ulepszanie modeli dyfuzji wymaga, aby dane treningowe zwracały większą uwagę na fizykę odbicia. Jednak wiele innych obszarów również wymaga podobnej szczególnej uwagi. W kontekście hiperskalowych zestawów danych, w których niestandardowe kuratorstwo jest kosztowne i trudne, zajęcie się każdą pojedynczą słabością w ten sposób jest niepraktyczne.

Mimo to rozwiązania problemu odbicia LDM pojawiają się od czasu do czasu. Jednym z ostatnich takich wysiłków, z Indii, jest Lustrzany Werset projekt, który oferuje udoskonalony zbiór danych i metodę szkoleniową, umożliwiającą udoskonalenie najnowocześniejszych rozwiązań w tym szczególnym wyzwaniu w badaniach nad dyfuzją.

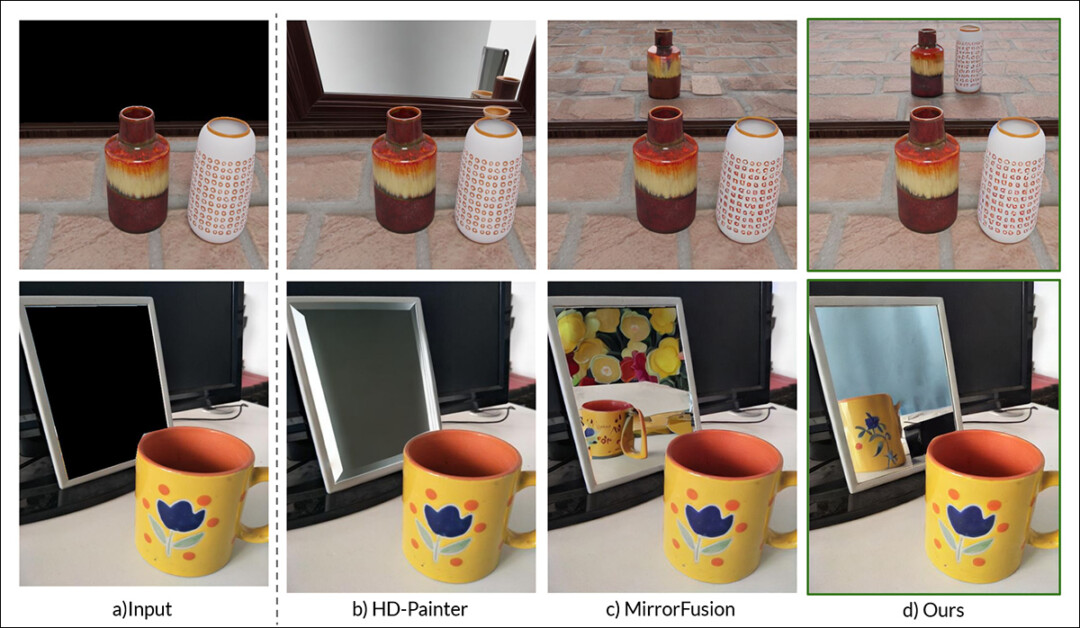

Po prawej stronie znajdują się wyniki z MirrorVerse zestawione z wynikami dwóch wcześniejszych podejść (dwie środkowe kolumny). Źródło: https://arxiv.org/pdf/2504.15397

Jak widać na powyższym przykładzie (ilustracja wyróżniająca w pliku PDF nowego badania), MirrorVerse stanowi udoskonalenie wcześniejszych rozwiązań rozwiązujących ten sam problem, ale jest dalekie od ideału.

Na zdjęciu w prawym górnym rogu widać, że ceramiczne słoiki są przesunięte nieco na prawo, niż powinny być, a na zdjęciu poniżej, które technicznie rzecz biorąc nie powinno w ogóle odzwierciedlać kubka, w prawej części umieszczono niedokładne odbicie, wbrew logice naturalnych kątów odbicia.

Przyjrzymy się zatem nowej metodzie nie tyle dlatego, że może ona reprezentować aktualny stan wiedzy w dziedzinie odbicia opartego na dyfuzji, ale również po to, by zilustrować, w jakim stopniu może się ona okazać nierozwiązywalnym problemem dla modeli dyfuzji ukrytej, zarówno statycznych, jak i wideo, ponieważ wymagane przykłady danych dotyczących odbicia najprawdopodobniej będą powiązane z określonymi działaniami i scenariuszami.

W związku z tym ta konkretna funkcja LDM może nadal nie spełniać oczekiwań w stosunku do podejść ukierunkowanych na konkretne struktury, takich jak NeRF, GSplat, a także tradycyjnego CGI.

nowy papier jest zatytułowany MirrorVerse: Wdrażanie modeli dyfuzji w celu realistycznego odzwierciedlenia światai pochodzi od trzech badaczy z Vision and AI Lab, IISc Bangalore i Samsung R&D Institute w Bangalore. Artykuł ma powiązana strona projektu, a także zbiór danych w Hugging Face, z kodem źródłowym wydany na GitHubie.

Metoda wykonania

Naukowcy już na wstępie zauważają trudności, jakie stwarzają takie modele jak stabilna dyfuzja i Topnik mieć szacunek dla podpowiedzi opartych na refleksji, zręcznie ilustrując problem:

Z artykułu: Najnowocześniejsze modele przetwarzania tekstu na obraz, SD3.5 i Flux, stwarzają poważne problemy z tworzeniem spójnych i dokładnych geometrycznie odbić po wyświetleniu monitu o ich wygenerowanie w scenie.

Naukowcy opracowali Lustrzana fuzja 2.0, generatywny model oparty na dyfuzji, mający na celu poprawę fotorealizmu i dokładności geometrycznej odbić lustrzanych w obrazach syntetycznych. Szkolenie modelu opierało się na nowo opracowanym przez badaczy zbiorze danych zatytułowanym Lustro Gen2, zaprojektowany w celu rozwiązania problemu uogólnienie słabości zaobserwowane w poprzednich podejściach.

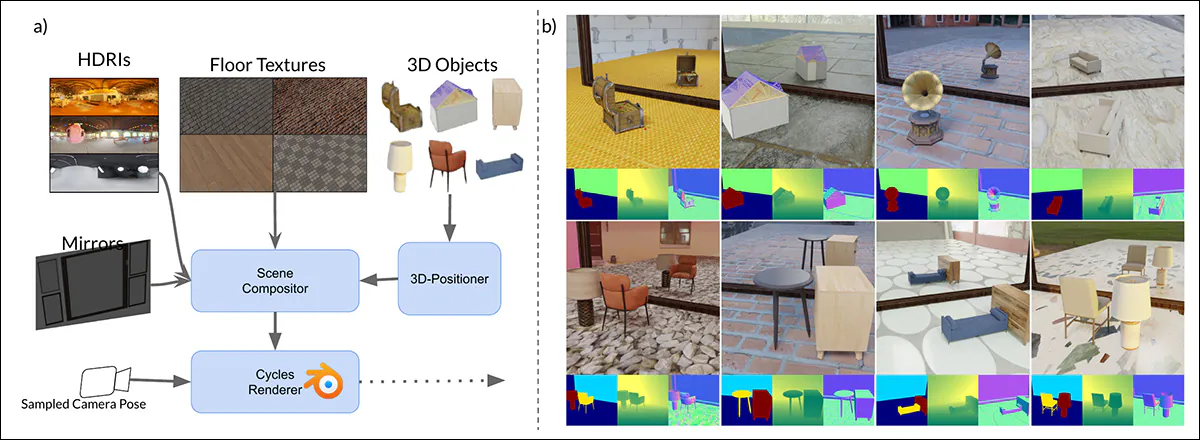

MirrorGen2 rozszerza wcześniejsze metodologie, wprowadzając losowe pozycjonowanie obiektów, losowe rotacje, wyraźne uziemienie obiektu, którego celem jest zapewnienie wiarygodności odbić w szerszym zakresie pozycji obiektów i ich umiejscowienia względem powierzchni lustra.

Schemat generowania danych syntetycznych w MirrorVerse: potok generowania zestawu danych zastosował kluczowe rozszerzenia poprzez losowe pozycjonowanie, obracanie i uziemianie obiektów w scenie za pomocą 3D-Positioner. Obiekty są również parowane w semantycznie spójnych kombinacjach, aby symulować złożone relacje przestrzenne i okluzje, umożliwiając zestawowi danych uchwycenie bardziej realistycznych interakcji w scenach z wieloma obiektami.

Aby jeszcze bardziej wzmocnić zdolność modelu do obsługi złożonych układów przestrzennych, potok MirrorGen2 obejmuje sparowany sceny obiektów, co pozwala systemowi lepiej odzwierciedlać okluzje i interakcje między wieloma elementami w środowiskach odbijających światło.

Artykuł stwierdza:

„Kategorie są ręcznie parowane, aby zapewnić spójność semantyczną – na przykład, parując krzesło ze stołem. Podczas renderowania, po ustawieniu i obróceniu głównego [obiektu], dodatkowy [obiekt] z sparowanej kategorii jest próbkowany i rozmieszczany, aby zapobiec nakładaniu się, zapewniając odrębne obszary przestrzenne w scenie”.

Jeśli chodzi o wyraźne uziemienie obiektów, autorzy zadbali o to, aby wygenerowane obiekty były „zakotwiczone” w podłożu w syntetycznych danych wyjściowych, a nie „unosiły się” w niewłaściwy sposób, co może się zdarzyć, gdy syntetyczne dane są generowane na dużą skalę lub przy użyciu wysoce zautomatyzowanych metod.

Ponieważ innowacyjność zbiorów danych stanowi istotę nowości niniejszego artykułu, przejdziemy do tej części opracowania wcześniej niż zwykle.

Dane i testy

SynMirrorV2

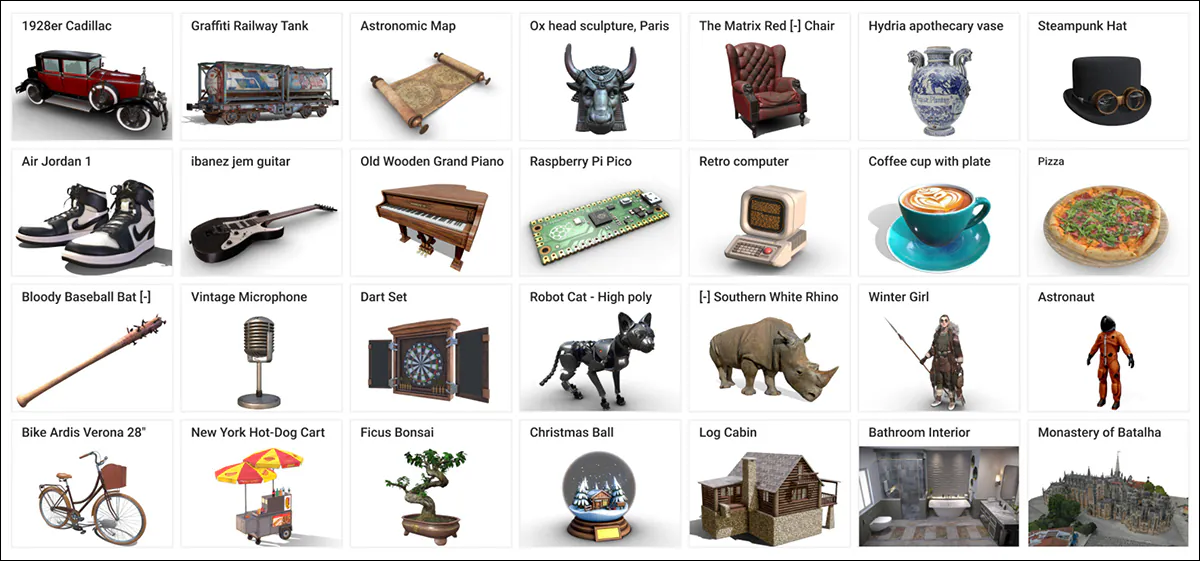

Zestaw danych SynMirrorV2 opracowany przez badaczy został opracowany w celu zwiększenia różnorodności i realizmu danych treningowych dotyczących odbić lustrzanych, obejmujących obiekty 3D pochodzące z Objaverse oraz Obiekty Amazon Berkeley (ABO) zestawy danych, przy czym te wybory są następnie udoskonalane poprzez OBIEKT 3DIToraz proces filtrowania z V1 Projekt MirrorFusion, aby wyeliminować aktywa niskiej jakości. W rezultacie powstała udoskonalona pula 66,062 XNUMX obiektów.

Przykłady ze zbioru danych Objaverse, wykorzystane przy tworzeniu zbioru danych dla nowego systemu. Źródło: https://arxiv.org/pdf/2212.08051

Konstrukcja sceny polegała na umieszczeniu tych obiektów na teksturowanych podłogach Tekstury CC i tła HDRI z PolaHaven Repozytorium CGI, wykorzystujące albo pełnościenne, albo wysokie prostokątne lustra. Oświetlenie zostało ujednolicone za pomocą światła obszarowego umieszczonego nad i za obiektami, pod kątem czterdziestu pięciu stopni. Obiekty zostały skalowane tak, aby pasowały do sześcianu jednostkowego i pozycjonowane za pomocą wstępnie obliczonego przecięcia lustra i widoku kamery ścięty, zapewniając widoczność.

Zastosowano losowe obroty wokół osi y, a w celu zapobiegania „pływającym artefaktom” zastosowano technikę uziemienia.

Aby symulować bardziej złożone sceny, zestaw danych zawierał również wiele obiektów ułożonych zgodnie z semantycznie spójnymi parami opartymi na kategoriach ABO. Obiekty drugorzędne zostały umieszczone w celu uniknięcia nakładania się, tworząc 3,140 scen wieloobiektowych zaprojektowanych w celu uchwycenia zróżnicowanych okluzjów i relacji głębokości.

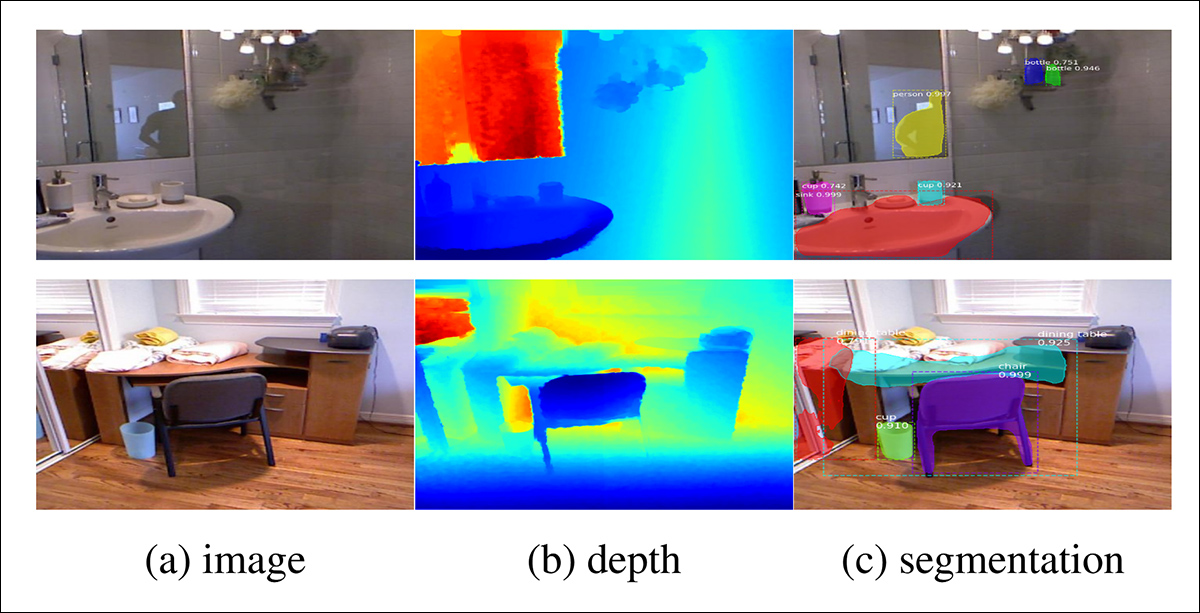

Przykłady renderowanych widoków z zestawu danych autorów zawierającego wiele (więcej niż dwa) obiektów, z ilustracjami segmentacji obiektów i wizualizacjami mapy głębi znajdują się poniżej.

Proces szkoleniowy

Uznając, że sam realizm syntetyczny nie wystarczy do solidnej generalizacji danych ze świata rzeczywistego, naukowcy opracowali trzyetapowy proces nauczania w celu szkolenia w MirrorFusion 2.0.

W etapie 1 autorzy zainicjowali Wagi zarówno gałęzi kondycjonowania, jak i generowania z dyfuzją stabilną v1.5 punkt kontrolny i dopracowałem model w oparciu o trening pojedynczego obiektu dzielić zbioru danych SynMirrorV2. W przeciwieństwie do wyżej wymienionych Odzwierciedlanie rzeczywistości projekt, naukowcy nie zamrażać gałąź generacji. Następnie trenowali model przez 40,000 XNUMX iteracji.

Na etapie 2 model udoskonalono, dostosowując go do dodatkowych 10,000 2 iteracji w ramach podziału treningu wieloobiektowego SynMirrorVXNUMX. Miało to na celu nauczenie systemu radzenia sobie z okluzjami i bardziej złożonymi układami przestrzennymi występującymi w realistycznych scenach.

Wreszcie w etapie 3 wykonano dodatkowe 10,000 XNUMX iteracji dostrajania przy użyciu rzeczywistych danych z Zestaw danych MSD, wykorzystując mapy głębokości wygenerowane przez Matterport3D jednooczny estymator głębokości.

Przykłady ze zbioru danych MSD, zawierające sceny ze świata rzeczywistego przeanalizowane na mapach głębi i segmentacji. Źródło: https://arxiv.org/pdf/1908.09101

Podczas treningu przez 20 procent czasu treningu pomijano komunikaty tekstowe, aby zachęcić model do optymalnego wykorzystania dostępnych informacji o głębokości (tj. podejście „maskowane”).

Szkolenie odbyło się na czterech procesorach graficznych NVIDIA A100 na wszystkich etapach (specyfikacja pamięci VRAM nie została podana, chociaż wynosiłaby 40 GB lub 80 GB na kartę). Szybkość uczenia się 1e-5 został użyty w partii o rozmiarze 4 na GPU, zgodnie z Adam W optymalizator.

W tym schemacie szkoleniowym stopniowo zwiększano trudność zadań stawianych przed modelem, zaczynając od prostszych scen syntetycznych i przechodząc do trudniejszych kompozycji, a wszystko to w celu rozwinięcia solidnej przenoszalności do świata rzeczywistego.

Testowanie

Autorzy porównali MirrorFusion 2.0 z poprzednią wersją MirrorFusion, która posłużyła jako punkt odniesienia, i przeprowadzili eksperymenty na zestawie danych MirrorBenchV2, obejmującym sceny z pojedynczymi i wieloma obiektami.

Dodatkowe testy jakościowe przeprowadzono na próbkach z zestawu danych MSD, a Obiekty zeskanowane przez Google Zbiór danych (GSO).

W ocenie wykorzystano 2,991 obrazów pojedynczych obiektów z kategorii widzianych i niewidzianych oraz 300 scen z dwoma obiektami z ABO. Wydajność mierzono przy użyciu Maksymalny stosunek sygnału do szumu (Prawo o ruchu drogowym); Wskaźnik podobieństwa strukturalnego (SSIM); i Nauczone podobieństwo obrazu percepcyjnego Wyniki (LPIPS) pozwalają ocenić jakość odbicia w obszarze zamaskowanego lustra. Podobieństwo CLIP-a został użyty do oceny dopasowania tekstu do wyświetlanych komunikatów.

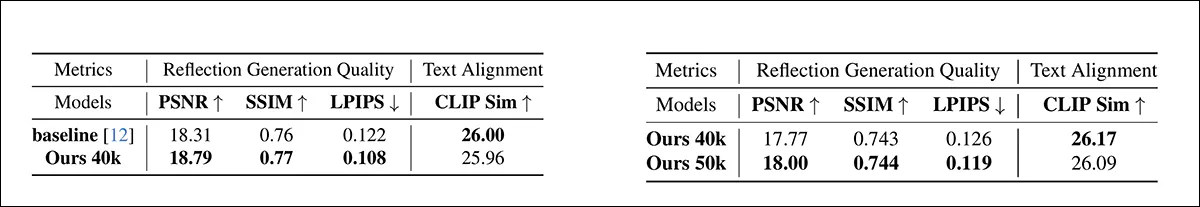

W testach ilościowych autorzy generowali obrazy, używając czterech nasion dla określonego monitu i wybierając wynikowy obraz z najlepszym wynikiem SSIM. Poniżej przedstawiono dwie zgłoszone tabele wyników dla testów ilościowych.

Po lewej, ilościowe wyniki dla jakości generowania odbić pojedynczego obiektu w MirrorBenchV2 na pojedynczym obiekcie. MirrorFusion 2.0 przewyższył linię bazową, a najlepsze wyniki są pogrubione. Po prawej, ilościowe wyniki dla jakości generowania odbić wielu obiektów w MirrorBenchV2 na wielu obiektach. MirrorFusion 2.0 trenowany z wieloma obiektami przewyższył wersję trenowaną bez nich, a najlepsze wyniki są pogrubione.

Autorzy komentują:

„[Wyniki] pokazują, że nasza metoda jest skuteczniejsza od metody bazowej, a dostrajanie na wielu obiektach poprawia rezultaty w przypadku złożonych scen”.

Większość wyników, na które kładą nacisk autorzy, dotyczy testów jakościowych. Ze względu na rozmiary tych ilustracji, możemy jedynie częściowo odtworzyć przykłady z artykułu.

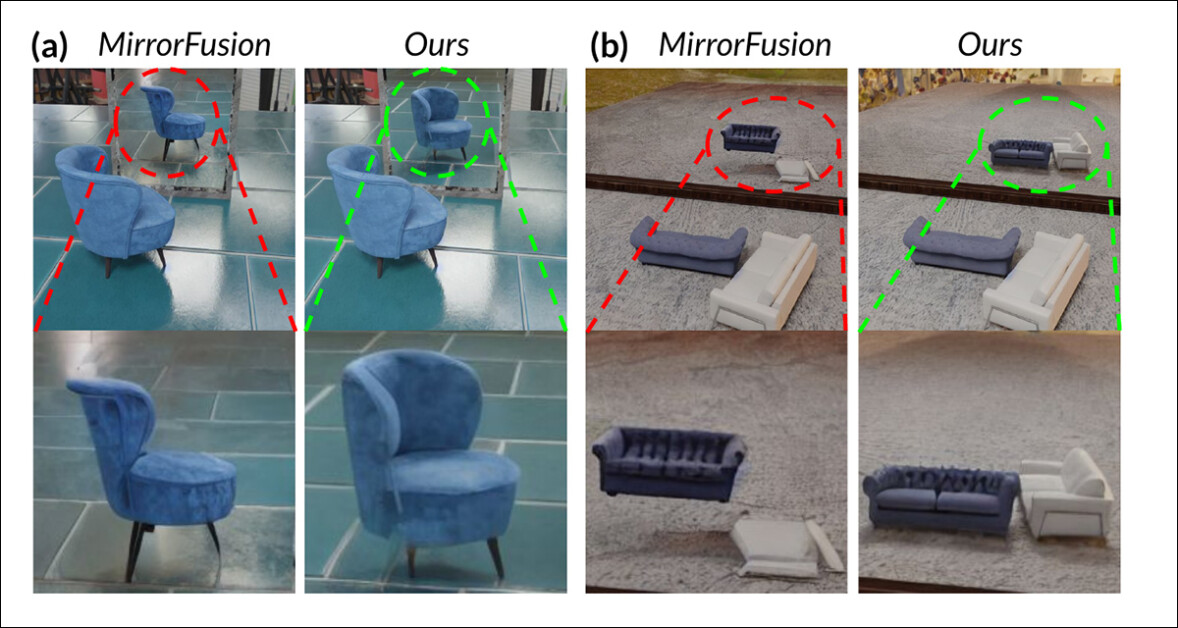

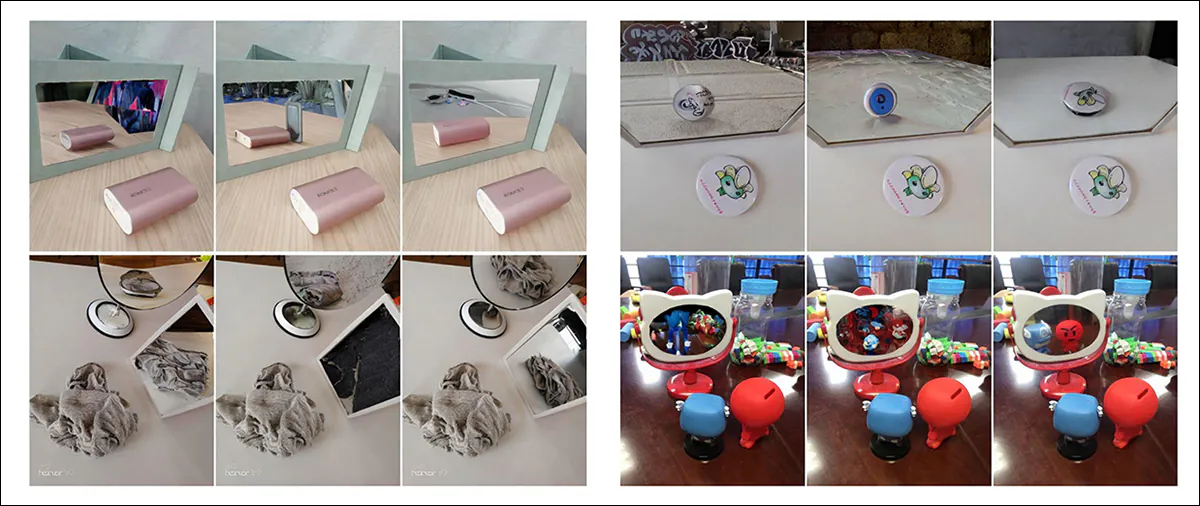

Porównanie w MirrorBenchV2: wersja bazowa nie zachowała dokładnych odbić i spójności przestrzennej, pokazując nieprawidłową orientację krzesła i zniekształcone odbicia wielu obiektów, podczas gdy (autorzy twierdzą) MirrorFusion 2.0 prawidłowo renderuje krzesło i sofy, zapewniając dokładną pozycję, orientację i strukturę.

Z tych subiektywnych wyników badacze uważają, że model bazowy nie był w stanie dokładnie oddać orientacji obiektu i relacji przestrzennych w odbiciach, często wytwarzając artefakty, takie jak nieprawidłowy obrót i obiekty unoszące się. MirrorFusion 2.0, trenowany na SynMirrorV2, jak twierdzą autorzy, zachowuje prawidłową orientację i pozycjonowanie obiektu zarówno w scenach z pojedynczym obiektem, jak i wieloma obiektami, co skutkuje bardziej realistycznymi i spójnymi odbiciami.

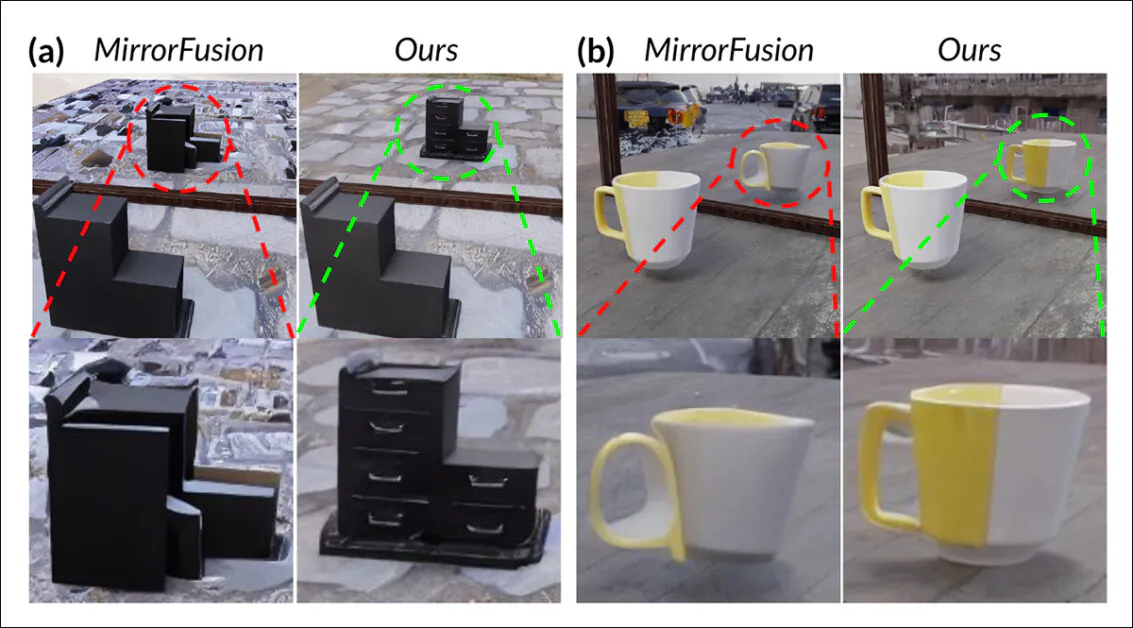

Poniżej przedstawiamy jakościowe wyniki dotyczące wspomnianego zbioru danych GSO:

Porównanie zestawu danych GSO. Linia bazowa błędnie przedstawia strukturę obiektu i generuje niekompletne, zniekształcone odbicia, podczas gdy MirrorFusion 2.0, jak twierdzą autorzy, zachowuje integralność przestrzenną i generuje dokładną geometrię, kolor i szczegóły, nawet w przypadku obiektów spoza dystrybucji.

Oto komentarz autorów:

MirrorFusion 2.0 generuje znacznie dokładniejsze i bardziej realistyczne odbicia. Na przykład na rys. 5 (a – powyżej) MirrorFusion 2.0 prawidłowo odbija uchwyty szuflad (zaznaczone na zielono), podczas gdy model bazowy generuje nieprawdopodobne odbicie (zaznaczone na czerwono).

Podobnie w przypadku „biało-żółtego kubka” przedstawionego na rys. 5 (b) MirrorFusion 2.0 zapewnia przekonującą geometrię z minimalną liczbą artefaktów, w przeciwieństwie do linii bazowej, która nie oddaje dokładnie geometrii i wyglądu obiektu.

Ostateczny test jakościowy przeprowadzono na podstawie wspomnianego wcześniej rzeczywistego zestawu danych MSD (częściowe wyniki przedstawiono poniżej):

Wyniki rzeczywistych scen porównujące MirrorFusion, MirrorFusion 2.0 i MirrorFusion 2.0, dostrojone na podstawie zestawu danych MSD. MirrorFusion 2.0, jak twierdzą autorzy, dokładniej rejestruje złożone szczegóły scen, w tym zagracone obiekty na stole i obecność wielu luster w trójwymiarowym środowisku. Tutaj przedstawiono tylko częściowe wyniki, ze względu na wymiary wyników w oryginalnym artykule, do którego odsyłamy czytelnika w celu uzyskania pełnych wyników i lepszej rozdzielczości.

Autorzy zauważają tutaj, że chociaż MirrorFusion 2.0 dobrze radził sobie z danymi MirrorBenchV2 i GSO, początkowo miał problemy ze złożonymi scenami ze świata rzeczywistego w zestawie danych MSD. Dopracowanie modelu na podzbiorze MSD poprawiło jego zdolność do radzenia sobie z zagraconymi środowiskami i wieloma lustrami, co skutkowało bardziej spójnymi i szczegółowymi refleksjami na temat odłożonego podziału testowego.

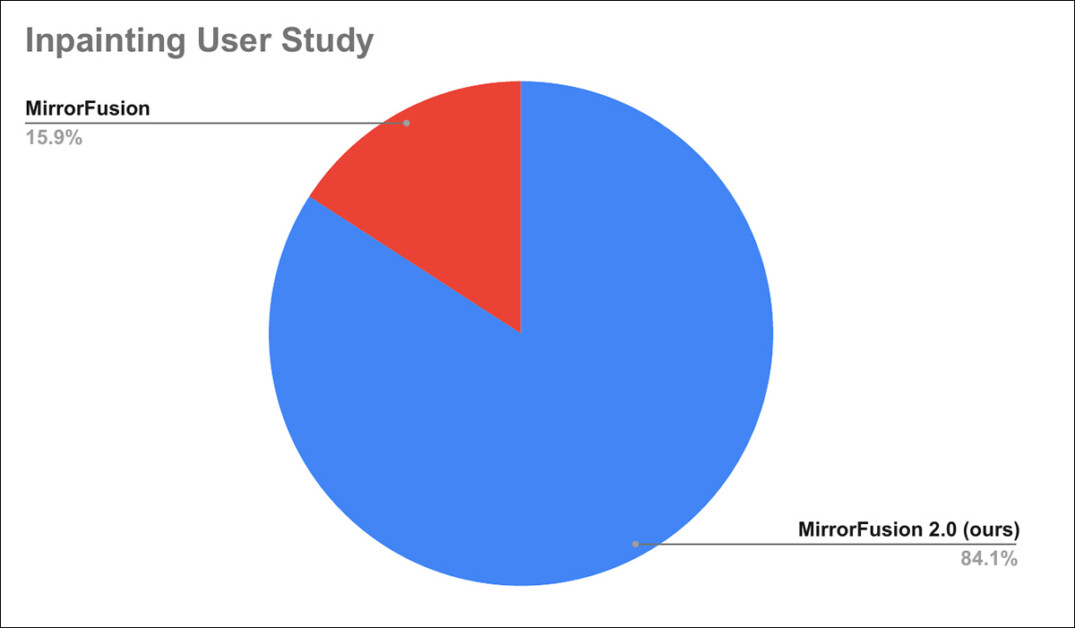

Dodatkowo przeprowadzono badanie użytkowników, z którego wynika, że 84% z nich preferowało generacje MirrorFusion 2.0 od metody bazowej.

Wyniki badania użytkowników.

Ponieważ szczegółowe informacje na temat badania użytkowników zamieszczono w załączniku do artykułu, odsyłamy czytelników do niego w celu zapoznania się ze szczegółami badania.

Podsumowanie

Chociaż kilka wyników przedstawionych w artykule to imponujące ulepszenia w stosunku do stanu techniki, stan techniki w tym konkretnym dążeniu jest tak żałosny, że nawet nieprzekonujące rozwiązanie zbiorcze może wygrać przy odrobinie wysiłku. Podstawowa architektura modelu dyfuzji jest wroga niezawodnemu uczeniu się i demonstrowaniu spójnej fizyki, więc problem jest źle postawiony i najwyraźniej nie jest nastawiony na eleganckie rozwiązanie.

Ponadto dodawanie danych do istniejących modeli jest już standardową metodą naprawiania niedociągnięć w wydajności LDM, ze wszystkimi wadami wymienionymi wcześniej. Można założyć, że gdyby przyszłe zestawy danych o dużej skali zwracały większą uwagę na dystrybucję (i adnotację) punktów danych związanych z odbiciem, moglibyśmy oczekiwać, że powstałe modele lepiej poradziłyby sobie z tym scenariuszem.

To samo dotyczy wielu innych bolączek wyników LDM – kto może powiedzieć, który z nich najbardziej zasługuje na wysiłek i pieniądze włożone w rozwiązanie, jakie proponują autorzy nowego artykułu?

Pierwsze opublikowanie w poniedziałek 28 kwietnia 2025 r. Wtorek 29 kwietnia: wprowadzono korektę gramatyczną w ostatnich akapitach.