Artificial Intelligence

Matowanie obrazu AI, które rozumie sceny

W dodatkowym dokumencie towarzyszącym wydaniu DVD z 2003 roku Alien3 (1992) legenda efektów wizualnych Richard Edlund z przerażeniem wspominał „walkę sumo” w procesie ekstrakcji matowej metodą fotochemiczną, która zdominowała prace nad efektami wizualnymi późne 1930-y i późnych lat 1980. Edlund opisał niestabilną naturę tego procesu jako „zapasy sumo” w porównaniu do technik cyfrowego niebieskiego/zielonego ekranu, które zdominowały rynek na początku lat 1990. (i ma zwrócony do metafory od).

Wyodrębnianie elementu pierwszego planu (takiego jak osoba lub model statku kosmicznego) z tła, tak aby wycięty obraz można było wkomponować w płytę tła, pierwotnie osiągano poprzez sfilmowanie obiektu na pierwszym planie na jednolitym niebieskim lub zielonym tle.

Pracochłonny proces ekstrakcji fotochemicznej na potrzeby efektów specjalnych nakręconych przez ILM do filmu „Powrót Jedi” (1983). Źródło: https://www.youtube.com/watch?v=qwMLOjqPmbQ

W powstałym materiale kolor tła byłby następnie chemicznie izolowany i używany jako szablon do ponownego wydrukowania obiektu (lub osoby) na pierwszym planie w drukarka optyczna jako „pływający” obiekt w przezroczystej komorze filmowej.

Proces ten był znany jako nakładka separacji kolorów (CSO) – chociaż termin ten ostatecznie stał się bardziej kojarzony z ropą 'Chromakey' efekty wideo w niskobudżetowych produkcjach telewizyjnych z lat 1970. i 1980. XX wieku, które osiągnięto środkami analogowymi, a nie chemicznymi czy cyfrowymi.

Demonstracja nakładania separacji kolorów w 1970 r. w brytyjskim programie dla dzieci „Blue Peter”. Źródło: https://www.bbc.co.uk/archive/blue_peter_noakes_CSO/zwb9vwx

W każdym razie, czy to w przypadku elementów filmowych, czy wideo, wyodrębniony materiał filmowy można następnie wstawić do dowolnego innego materiału filmowego.

Chociaż Disney jest zauważalnie droższy i bardziej zastrzeżony proces z parą sodu (który w szczególności był na żółtym, i też był używany do horroru Alfreda Hitchcocka z 1963 roku Ptaki) dało lepszą definicję i wyraźniejsze maty, ekstrakcja fotochemiczna pozostała żmudna i zawodna.

Opatentowany przez Disneya proces ekstrakcji oparów sodu wymagał tła zbliżonego do żółtego. W tym przypadku Angela Lansbury wisi na linach podczas produkcji sekwencji z efektami wizualnymi do filmu „Gałki od łóżka i kije od mioteł” (1971). Źródło

Więcej niż cyfrowe matowanie

W latach 1990. rewolucja cyfrowa pozbyła się chemikaliów, ale nie potrzebowała zielonych ekranów. Teraz możliwe było usunięcie zielonego (lub innego koloru) tła po prostu poprzez wyszukiwanie pikseli w zakresie tolerancji tego koloru w oprogramowaniu do edycji pikseli, takim jak Photoshop, oraz nowej generacji pakietów do komponowania wideo, które mogły automatycznie wyodrębniać kolorowe tła. Prawie całą noc, sześćdziesiąt lat branży druku optycznego odeszły do historii.

Ostatnie dziesięć lat badań nad wizją komputerową akcelerowaną przez procesor graficzny wprowadza ekstrakcję materii w trzecią erę, stawiając przed badaczami zadanie opracowania systemów, które będą w stanie wyodrębnić wysokiej jakości materię bez potrzeby stosowania zielonych ekranów. Tylko w Arxiv cotygodniowe artykuły dotyczące innowacji w zakresie ekstrakcji pierwszego planu w oparciu o uczenie maszynowe.

Przedstawienie nas w obrazie

To centrum zainteresowania środowisk akademickich i przemysłowych ekstrakcją sztucznej inteligencji wywarło już wpływ na przestrzeń konsumencką: prymitywne, ale wykonalne wdrożenia są nam wszystkim znane w postaci Powiększenie oraz Skype filtry, które mogą zastąpić tło naszego salonu z tropikalnymi wyspami itp. podczas połączeń wideokonferencyjnych.

Jednak najlepsze maty nadal wymagają zielonego ekranu, ponieważ Zoom zauważył Ostatnia środa.

Po lewej: mężczyzna przed zielonym ekranem, z dobrze wyekstrahowanymi włosami za pomocą funkcji Wirtualnego Tła w Zoomie. Po prawej: kobieta przed zwykłą domową sceną, z włosami wyekstrahowanymi algorytmicznie, mniej precyzyjnie i z większymi wymaganiami obliczeniowymi. Źródło: https://support.zoom.us/hc/en-us/articles/210707503-Changing-your-Virtual-Background-image

A dalszy post z platformy Zoom Support ostrzega, że ekstrakcja bez efektu zielonego ekranu wymaga również większej mocy obliczeniowej w urządzeniu przechwytującym.

Konieczność wycięcia

Ulepszenia w zakresie jakości, przenośności i oszczędności zasobów w przypadku systemów ekstrakcji materii „w naturze” (tj. izolowanie ludzi bez konieczności stosowania zielonych ekranów) są istotne w wielu sektorach i dziedzinach, nie tylko w przypadku filtrów wideokonferencyjnych.

W przypadku rozwoju zbioru danych ulepszone rozpoznawanie twarzy, całej głowy i całego ciała daje możliwość zapewnienia, że zewnętrzne elementy tła nie zostaną przeszkolone w modelach widzenia komputerowego osób; dokładniejsza izolacja znacznie by się poprawiła segmentacja semantyczna techniki mające na celu rozróżnienie i asymilację domen (tj 'kot', 'osoba', 'łódź'), i ulepszać ZEA oraz transformatoroparte na systemach syntezy obrazu, takich jak nowe systemy OpenAI DALL-E2; a lepsze algorytmy ekstrakcji ograniczyłyby potrzebę korzystania z drogiego podręcznika rotoskopia w kosztownych potokach efektów wizualnych.

W rzeczywistości przewaga multimodalny (zwykle tekst/obraz), w których domena taka jak „kot” jest kodowana zarówno jako obraz, jak i z powiązanymi odniesieniami tekstowymi, zyskuje już popularność w przetwarzaniu obrazów. Jednym z ostatnich przykładów jest Tekst2Na żywo architektura, która wykorzystuje szkolenia multimodalne (tekst/obraz) do tworzenia filmów wideo przedstawiających między innymi niezliczone możliwości, kryształowe łabędzie i szklane żyrafy.

Matowanie AI uwzględniające scenę

Wiele badań nad automatycznym matowaniem opartym na sztucznej inteligencji skupiało się na rozpoznawaniu granic i ocenie grupowania pikseli wewnątrz obrazu lub klatki wideo. Jednak nowe badania przeprowadzone w Chinach oferują rurociąg ekstrakcyjny, który poprzez wykorzystanie poprawia odwzorowanie i jakość kamienia opisy tekstowe sceny (podejście multimodalne, które zyskało popularność w sektorze badań nad wizją komputerową w ciągu ostatnich 3-4 lat), twierdząc, że pod wieloma względami ulepszyło wcześniejsze metody.

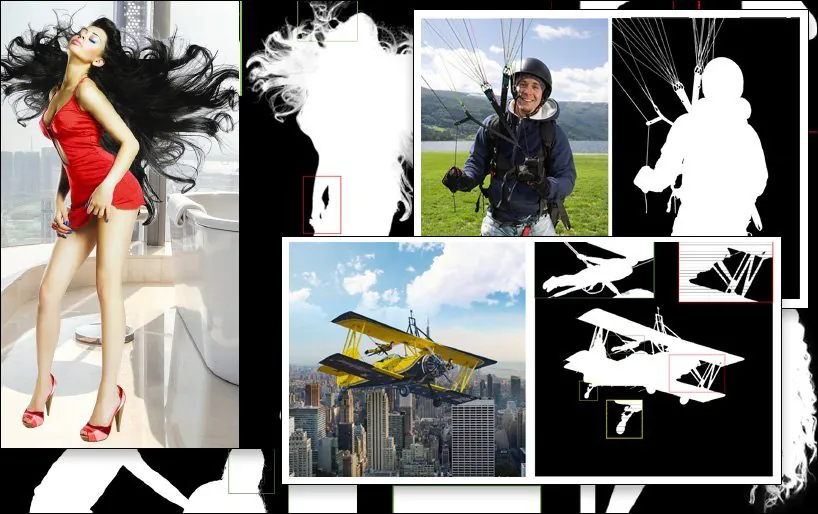

Przykładowa ekstrakcja SPG-IM (ostatnie zdjęcie, na dole po prawej) w porównaniu z wcześniejszymi, konkurencyjnymi metodami. Źródło: https://arxiv.org/pdf/2204.09276.pdf

Wyzwaniem stojącym przed podsektorem badań nad ekstrakcją jest stworzenie przepływów pracy, które wymagają minimum ręcznych adnotacji i interwencji człowieka – w idealnym przypadku żadnej. Oprócz konsekwencji kosztowych badacze piszący w nowym artykule zauważają, że adnotacje i ręczna segmentacja wykonywana przez zewnętrznych pracowników zajmujących się obsługą społecznościową w różnych kulturach mogą powodować etykietowanie lub nawet segmentację obrazów na różne sposoby, co prowadzi do niespójnych i niezadowalających algorytmów.

Przykładem tego jest subiektywna interpretacja definicji „obiektu na pierwszym planie”:

Z nowego artykułu: dotychczasowe metody LFM oraz MODNet („GT” oznacza Ground Truth, „idealny” wynik często osiągany ręcznie lub za pomocą metod niealgorytmicznych) mają różne i rozmaicie skuteczne podejście do definiowania treści na pierwszym planie, podczas gdy nowa metoda SPG-IM skuteczniej wyodrębnia „treść pokrewną” poprzez kontekst sceny.

Aby rozwiązać ten problem, naukowcy opracowali dwuetapowy proces pt Matowanie obrazu sterowane percepcją sytuacyjną (SPG-IM). Dwustopniowa architektura kodera/dekodera obejmuje destylację percepcji sytuacyjnej (SPD) i matowanie sterowane percepcją sytuacyjną (SPGM).

Po pierwsze, SPD wstępnie szkoli transformacje cech wizualnych w tekstowe, generując podpisy odpowiadające powiązanym z nimi obrazom. Następnie włącza się przewidywanie maski pierwszego planu poprzez podłączenie potoku do powieści przewidywanie istotności technika.

Następnie SPGM generuje szacunkową materię alfa na podstawie wejściowego surowego obrazu RGB i wygenerowanej maski uzyskanej w pierwszym module.

Celem jest kierowanie percepcją sytuacyjną, w ramach której system ma kontekstowe zrozumienie tego, z czego składa się obraz, co pozwala mu na ujęcie – na przykład – wyzwania polegającego na wyodrębnieniu skomplikowanych włosów z tła w oparciu o znane cechy takiego konkretnego zadania.

W poniższym przykładzie SPG-IM zakłada, że linki są nieodłączną częścią „spadochronu”, a MODNet nie potrafi zachować i zdefiniować tych szczegółów. Podobnie, cała struktura urządzenia placu zabaw jest arbitralnie tracona w MODNet.

Nowa papier jest zatytułowany Matowanie obrazu sterowane percepcją sytuacyjnąi pochodzi od naukowców z Instytutu Badawczego OPPO, PicUp.ai i Xmotors.

Inteligentne zautomatyzowane maty

SPG-IM oferuje również sieć udoskonalania adaptacyjnej transformacji ogniskowej (AFT), która może osobno przetwarzać szczegóły lokalne i kontekst globalny, ułatwiając tworzenie „inteligentnych mat”.

Zrozumienie kontekstu sceny, w tym przypadku „dziewczyny z koniem”, może potencjalnie ułatwić wyodrębnienie pierwszego planu w porównaniu z poprzednimi metodami.

Artykuł stwierdza:

„Wierzymy, że reprezentacje wizualne z zadania wizualnego na tekstowe, np W przypadku podpisów do obrazów, skup się na bardziej semantycznie kompleksowych sygnałach między a) obiektem a b) obiektem a otoczeniem, aby generować opisy, które mogą obejmować zarówno informacje globalne, jak i szczegóły lokalne. Ponadto, w porównaniu z kosztowną adnotacją pikselową w przypadku matowania obrazów, opisy tekstowe można gromadzić na masową skalę przy bardzo niskich kosztach.

Gałąź SPD architektury jest wstępnie trenowana wspólnie z Uniwersytetem Michigan VirTex dekoder tekstowy oparty na transformatorze, który uczy się reprezentacji wizualnych na podstawie gęstych semantycznie napisów.

VirTex wspólnie szkoli ConvNet i Transformers za pomocą kupletów podpisów obrazów i przekazuje uzyskane spostrzeżenia do dalszych zadań wizyjnych, takich jak wykrywanie obiektów. Źródło: https://arxiv.org/pdf/2006.06666.pdf

Naukowcy przetestowali między innymi SPG-IM w oparciu o najnowocześniejsze rozwiązania przycinaniemetody oparte na głębokim matowaniu obrazu (CIEMNY), Sieć indeksowa, Kontekstowe dopasowywanie obrazu (CAM), kierowana uwaga kontekstowa (GCA) FBAi semantyczne mapowanie obrazu (TAK).

Inne wcześniej testowane platformy obejmowały podejścia bez trimapów LFM, HAttMatting, MODNetAby zapewnić uczciwe porównanie, metody testowe dostosowano do różnych metodologii; w przypadku braku dostępnego kodu, techniki opisane w artykule odtworzono z opisanej architektury.

W nowym dokumencie czytamy:

„Nasz model SPG-IM znacznie przewyższa wszystkie konkurencyjne metody bez trimap ([LFM], [HAttMatting] i [MODNet]). Jednocześnie nasz model wykazuje również znaczną przewagę nad najnowocześniejszymi metodami opartymi na trimapach i maskach (SOTA) pod względem wszystkich czterech metryk w publicznych zbiorach danych (tj. Composition-1K, Distinction-646 i Human-2K) oraz w naszym benchmarku Multi-Object-1K”.

I kontynuuje:

„Można wyraźnie zauważyć, że nasza metoda zachowuje drobne szczegóły (np. miejsca na końcówki włosów, przezroczyste tekstury i granice) bez pomocy trimapu. Co więcej, w porównaniu z innymi konkurencyjnymi modelami bez trimapu, nasz SPG-IM może zachować lepszą globalną kompletność semantyczną”.

Opublikowano po raz pierwszy 24 kwietnia 2022 r.