Artificial Intelligence

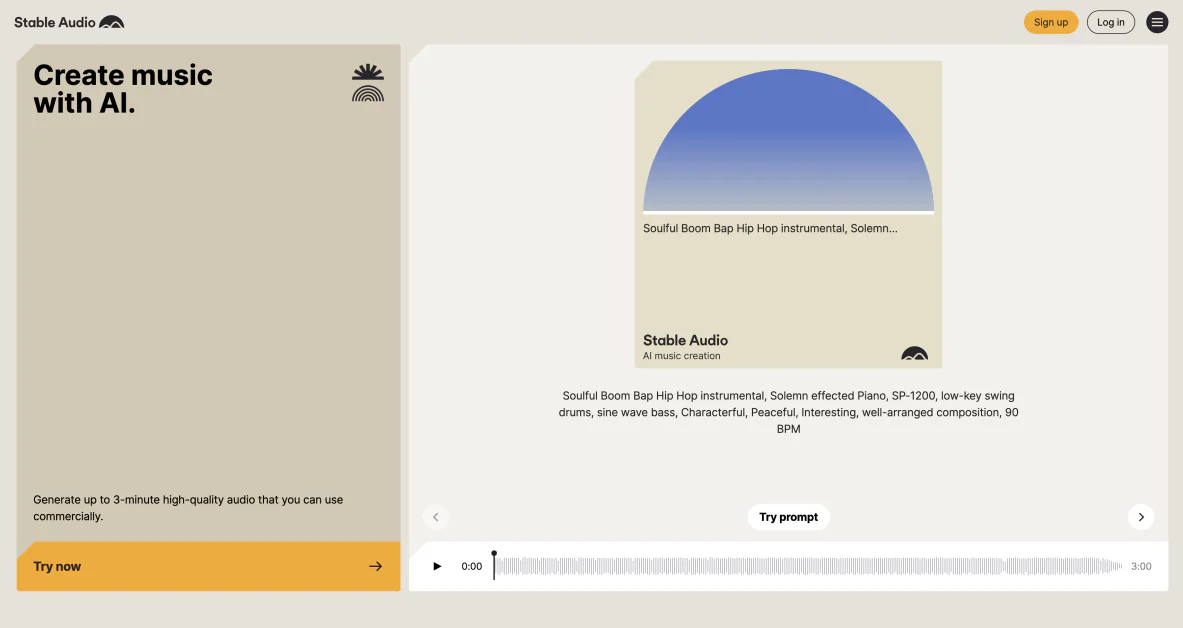

Stabilna sztuczna inteligencja przedstawia Stable Audio 2.0: wzmocnienie możliwości twórców dzięki zaawansowanemu dźwiękowi generowanemu przez sztuczną inteligencję

Stabilność AI po raz kolejny przesunęła granice innowacji wraz z wydaniem Stabilny dźwięk 2.0. Ten najnowocześniejszy model opiera się na sukcesie swojego poprzednika, wprowadzając szereg przełomowych funkcji, które zrewolucjonizują sposób, w jaki artyści i muzycy tworzą treści audio i manipulują nimi.

Stable Audio 2.0 stanowi znaczący kamień milowy w ewolucji dźwięku generowanego przez sztuczną inteligencję, ustanawiając nowy standard jakości, wszechstronności i potencjału twórczego. Dzięki możliwości generowania pełnometrażowych ścieżek, przekształcania próbek audio przy użyciu podpowiedzi w języku naturalnym i tworzenia szerokiej gamy efektów dźwiękowych, model ten otwiera świat możliwości dla twórców treści z różnych branż.

Ponieważ zapotrzebowanie na innowacyjne rozwiązania audio stale rośnie, najnowsza oferta Stability AI może stać się niezbędnym narzędziem dla profesjonalistów pragnących zwiększyć swoją kreatywność i usprawnić przepływ pracy. Wykorzystując moc zaawansowanej technologii sztucznej inteligencji, Stable Audio 2.0 umożliwia użytkownikom odkrywanie niezbadanych terytoriów w zakresie komponowania muzyki, projektowania dźwięku i postprodukcji dźwięku.

Jakie są kluczowe cechy Stable Audio 2.0

Stable Audio 2.0 oferuje imponującą gamę funkcji, które mogą na nowo zdefiniować krajobraz dźwięku generowanego przez sztuczną inteligencję. Od generowania ścieżek o pełnej długości po transformację audio na audio, ulepszoną produkcję efektów dźwiękowych i transfer stylu, model ten zapewnia twórcom kompleksowy zestaw narzędzi do ożywiania ich wizji słuchowych.

Generowanie utworów o pełnej długości

Stable Audio 2.0 wyróżnia się na tle innych modeli audio generowanych przez sztuczną inteligencję możliwością tworzenia pełnometrażowych ścieżek o długości do trzech minut. Te kompozycje to nie tylko rozszerzone fragmenty, ale raczej ustrukturyzowane fragmenty, które zawierają odrębne sekcje, takie jak wprowadzenie, rozwinięcie i zakończenie. Ta funkcja pozwala użytkownikom generować kompletne dzieła muzyczne ze spójną narracją i progresją, zwiększając potencjał tworzenia muzyki wspomaganej sztuczną inteligencją.

Co więcej, model zawiera efekty dźwiękowe stereo, dodające głębi i wymiaru generowanemu dźwiękowi. To włączenie elementów przestrzennych jeszcze bardziej zwiększa realizm i wciągającą jakość utworów, dzięki czemu nadają się do szerokiego zakresu zastosowań, od podkładu muzycznego w filmach po samodzielne kompozycje muzyczne.

Generowanie audio-do-audio

Jednym z najbardziej ekscytujących dodatków do Stable Audio 2.0 jest możliwość generowania sygnału audio na audio. Użytkownicy mogą teraz przesyłać własne próbki audio i przekształcać je za pomocą podpowiedzi w języku naturalnym. Ta funkcja otwiera świat kreatywnych możliwości, umożliwiając artystom i muzykom eksperymentowanie z manipulacją i regeneracją dźwięku w sposób, który wcześniej był niewyobrażalny.

Wykorzystując moc sztucznej inteligencji, użytkownicy mogą łatwo modyfikować istniejące zasoby audio, aby dopasować je do swoich konkretnych potrzeb lub wizji artystycznej. Niezależnie od tego, czy chodzi o zmianę barwy instrumentu, zmianę nastroju utworu, czy tworzenie zupełnie nowych dźwięków w oparciu o istniejące próbki, Stable Audio 2.0 zapewnia intuicyjny sposób odkrywania transformacji dźwięku.

Ulepszona produkcja efektów dźwiękowych

Oprócz możliwości generowania muzyki, Stable Audio 2.0 wyróżnia się tworzeniem różnorodnych efektów dźwiękowych. Od subtelnych dźwięków tła, takich jak szelest liści lub szum maszyn, po bardziej wciągające i złożone krajobrazy dźwiękowe, takie jak tętniące życiem ulice miast lub środowisko naturalne, model może generować szeroką gamę elementów dźwiękowych.

Ta ulepszona funkcja produkcji efektów dźwiękowych jest szczególnie przydatna dla twórców treści pracujących przy projektach filmowych, telewizyjnych, grach wideo i multimedialnych. Dzięki Stable Audio 2.0 użytkownicy mogą szybko i łatwo generować wysokiej jakości efekty dźwiękowe, które w innym przypadku wymagałyby obszernej pracy lub kosztownych licencjonowanych zasobów.

Transfer stylu

W Stable Audio 2.0 wprowadzono funkcję przesyłania stylu, która pozwala użytkownikom płynnie modyfikować walory estetyczne i tonalne generowanego lub przesyłanego dźwięku. Ta funkcja umożliwia twórcom dostosowanie wyjścia audio do konkretnych tematów, gatunków lub podtekstu emocjonalnego ich projektów.

Stosując transfer stylu, użytkownicy mogą eksperymentować z różnymi stylami muzycznymi, mieszać gatunki lub tworzyć zupełnie nowe palety dźwiękowe. Ta funkcja jest szczególnie przydatna do tworzenia spójnych ścieżek dźwiękowych, dostosowywania muzyki do określonych treści wizualnych lub odkrywania kreatywnych mashupów i remiksów.

Postęp technologiczny Stable Audio 2.0

Pod maską Stable Audio 2.0 kryje się najnowocześniejsza technologia AI, która zapewnia imponującą wydajność i wysoką jakość wyjściową. Architektura modelu została starannie zaprojektowana, aby sprostać wyjątkowym wyzwaniom związanym z generowaniem spójnych, pełnometrażowych kompozycji audio przy jednoczesnym zachowaniu precyzyjnej kontroli nad szczegółami.

Architektura modelu dyfuzji ukrytej

U podstaw Stable Audio 2.0 leży architektura modelu ukrytej dyfuzji, zoptymalizowana pod kątem generowania dźwięku. Architektura ta składa się z dwóch kluczowych komponentów: wysoce skompresowanego autokoder oraz transformator dyfuzyjny (DiT).

Autoenkoder jest odpowiedzialny za efektywną kompresję surowych przebiegów audio do zwartych reprezentacji. Ta kompresja umożliwia modelowi uchwycenie podstawowych cech dźwięku przy jednoczesnym odfiltrowaniu mniej ważnych szczegółów, co daje bardziej spójny i uporządkowany generowany sygnał wyjściowy.

Transformator dyfuzyjny, podobny do tego zastosowanego w przełomowym modelu Stable Diffusion 3 firmy Stability AI, zastępuje tradycyjną architekturę U-Net stosowaną w poprzednich wersjach. DiT szczególnie dobrze radzi sobie z długimi sekwencjami danych, dzięki czemu doskonale nadaje się do przetwarzania i generowania rozbudowanych kompozycji audio.

Poprawiona wydajność i jakość

Połączenie wysoce skompresowanego autoenkodera i transformatora dyfuzyjnego umożliwia Stable Audio 2.0 osiągnięcie niezwykłej poprawy zarówno pod względem wydajności, jak i jakości wyjściowej w porównaniu do swojego poprzednika.

Wydajna kompresja autoenkodera pozwala modelowi przetwarzać i generować dźwięk z większą szybkością, zmniejszając wymagane zasoby obliczeniowe i czyniąc go bardziej dostępnym dla szerszego grona użytkowników. Jednocześnie zdolność transformatora dyfuzyjnego do rozpoznawania i odtwarzania struktur o dużej skali zapewnia, że generowany dźwięk utrzymuje wysoki poziom spójności i integralności muzycznej.

Kulminacją tych postępów technologicznych jest model, który może generować oszałamiająco realistyczny i emocjonalnie rezonujący dźwięk, niezależnie od tego, czy jest to pełnometrażowa kompozycja muzyczna, złożony pejzaż dźwiękowy czy subtelny efekt dźwiękowy. Architektura Stable Audio 2.0 kładzie podwaliny pod przyszłe innowacje w zakresie dźwięku generowanego przez sztuczną inteligencję, torując drogę twórcom jeszcze bardziej wyrafinowanych i wyrazistych narzędzi.

Prawa twórcy w wersji Stable Audio 2.0

Ponieważ dźwięk generowany przez sztuczną inteligencję stale się rozwija i staje się coraz bardziej dostępny, niezwykle ważne jest zajęcie się konsekwencjami etycznymi i zapewnienie ochrony praw twórców. Stability AI podjęła proaktywne kroki, aby nadać priorytet etycznemu rozwojowi i godziwemu wynagrodzeniu dla artystów, których praca przyczynia się do szkolenia Stable Audio 2.0.

Stable Audio 2.0 zostało przeszkolone wyłącznie na licencjonowanym zestawie danych firmy AudioSparx, renomowanego źródła wysokiej jakości treści audio. Ten zbiór danych składa się z ponad 800,000 XNUMX plików audio, w tym muzyki, efektów dźwiękowych i tematów pojedynczych instrumentów, wraz z odpowiednimi metadanymi tekstowymi. Wykorzystując licencjonowany zbiór danych, Stability AI gwarantuje, że model zostanie zbudowany na podstawie legalnie uzyskanych i odpowiednio przypisanych danych audio.

Uznając znaczenie autonomii twórcy, Stability AI zapewniła wszystkim artystom, których prace znajdują się w zbiorze danych AudioSparx, możliwość rezygnacji z wykorzystywania ich dźwięku w szkoleniu Stable Audio 2.0. Ten mechanizm rezygnacji pozwala twórcom zachować kontrolę nad sposobem wykorzystania ich twórczości i zapewnia, że w zbiorze danych uwzględniane są tylko te osoby, które nie czują się komfortowo, gdy ich dźwięk jest wykorzystywany do szkolenia AI.

Stability AI dokłada wszelkich starań, aby twórcy, których praca przyczynia się do rozwoju Stable Audio 2.0, otrzymywali godziwe wynagrodzenie za swoje wysiłki. Licencjonując zbiór danych AudioSparx i zapewniając opcje rezygnacji, firma demonstruje swoje zaangażowanie w tworzenie zrównoważonego i sprawiedliwego ekosystemu dla dźwięku generowanego przez sztuczną inteligencję, w którym twórcy są szanowani i nagradzani za swój wkład.

Aby jeszcze bardziej chronić prawa twórców i zapobiegać naruszeniom praw autorskich, Stability AI nawiązała współpracę z Audible Magic, wiodącym dostawcą technologii rozpoznawania treści. Integrując system zaawansowanego rozpoznawania treści (ACR) firmy Audible Magic z procesem przesyłania dźwięku, Stable Audio 2.0 może identyfikować i oznaczać treści potencjalnie naruszające prawa, zapewniając, że na platformie używany jest wyłącznie oryginalny lub odpowiednio licencjonowany dźwięk.

Dzięki tym rozważaniom etycznym i inicjatywom skoncentrowanym na twórcach Stabilność AI ustanawia mocny precedens dla odpowiedzialnego rozwoju sztucznej inteligencji w domenie audio. Stawiając na pierwszym miejscu prawa twórców i ustanawiając jasne wytyczne dotyczące wykorzystania danych i wynagrodzeń, firma wspiera zrównoważone środowisko współpracy, w którym sztuczna inteligencja i ludzka kreatywność mogą współistnieć i rozwijać się.

Kształtowanie przyszłości tworzenia dźwięku dzięki stabilnej sztucznej inteligencji

Stable Audio 2.0 stanowi znaczący kamień milowy w dziedzinie dźwięku generowanego przez sztuczną inteligencję, zapewniając twórcom kompleksowy zestaw narzędzi do odkrywania nowych granic w muzyce, projektowaniu dźwięku i produkcji dźwięku. Dzięki najnowocześniejszej architekturze modelu ukrytej dyfuzji, imponującej wydajności oraz zaangażowaniu w względy etyczne i prawa twórcy, Stability AI przoduje w kształtowaniu przyszłości tworzenia dźwięku. W miarę ciągłego rozwoju tej technologii jasne jest, że dźwięk generowany przez sztuczną inteligencję będzie odgrywał coraz bardziej kluczową rolę w krajobrazie kreatywnym, zapewniając artystom i muzykom narzędzia potrzebne do przesuwania granic ich rzemiosła i ponownego definiowania tego, co jest możliwe na świecie dźwięku.