Andersons vinkel

AI-video perfeksjonerer katteselfien

AI-videogeneratorer gir ofte resultater som er like, men uten tvil, når det gjelder å levere det tekstmeldingen ønsket. Men en ny, overordnet løsning utgjør hele forskjellen.

Generative videosystemer har ofte problemer med å lage videoer som er virkelig kreative eller ville, og klarer ofte ikke å leve opp til forventningene til brukerens tekstmeldinger.

En del av grunnen til dette er forviklinger – det faktum at visjons-/språkmodeller må gå på akkord med hvor lenge de trener på kildedataene sine. For lite trening, og konseptene er fleksible, men ikke ferdig utviklet – for mye, og konseptene er nøyaktige, men ikke lenger fleksible nok til å innlemmes i nye kombinasjoner.

Du kan få ideen fra videoen som er innebygd nedenfor. Til venstre er den typen halvveis kompromiss som mange AI-systemer leverer som svar på en krevende oppgave (oppgaven er øverst i videoen i alle fire eksemplene) som ber om en sammenstilling av elementer som er for fantastiske til å ha vært et ekte treningseksempel. Til høyre er en AI-utdata som holder seg mye bedre til oppgaven:

Klikk for å spille (ingen lyd). Til høyre ser vi «faktorisert» WAN 2.2 som virkelig leverer på instruksjonene, sammenlignet med de vage tolkningene av «vanilla» WAN 2.2 til venstre. Se kildevideofilene for bedre oppløsning og mange flere eksempler, selv om de kuraterte versjonene som er sett her ikke finnes på prosjektsiden, og ble satt sammen for denne artikkelen. Kilde

Vel, selv om vi må tilgi den klappende andens menneskehender (!), er det tydelig at eksemplene til høyre holder seg til den originale tekstprompten mye bedre enn de til venstre.

Interessant nok er begge de omtalte arkitekturene i hovedsak de samme samme arkitektur – den populære og svært dyktige Wan 2.2, en kinesisk utgivelse som har vunnet betydelig terreng i åpen kildekode- og hobbymiljøene i år.

Forskjellen er at den andre generative pipelinen er faktorisert, som i dette tilfellet betyr at en stor språkmodell (LLM) har blitt brukt til å tolke den første (frø) rammen av videoen på nytt, slik at det blir mye enklere for systemet å levere det brukeren ber om.

Denne «visuelle forankringen» innebærer å injisere et bilde laget fra denne LLM-forbedrede prompten i den generative pipelinen som en «startramme», og bruke en LoRA tolkningsmodell for å integrere «inntrenger»-rammen i videoproduksjonsprosessen.

Resultatene, når det gjelder rask gjengivelse, er ganske bemerkelsesverdige, spesielt for en løsning som virker ganske elegant:

Klikk for å spille (ingen lyd). Ytterligere eksempler på «faktoriserte» videogenereringer som virkelig holder seg til manuset. Se kildevideofilene for bedre oppløsning og mange flere eksempler, selv om de kuraterte versjonene som er sett her ikke finnes på prosjektsiden, og ble satt sammen for denne artikkelen.

Denne løsningen kommer i form av nytt papir Faktorisert videogenerering: Frakobling av scenekonstruksjon og temporal syntese i tekst-til-video-diffusjonsmodeller, og dens videofylte tilhørende prosjekt nettsted.

Selv om mange nåværende systemer forsøker å øke nøyaktigheten ved å bruke språkmodeller til å omskrive vag eller underspesifisert tekst, argumenterer det nye arbeidet for at denne strategien fortsatt fører til feil når modellens intern scenerepresentasjon er mangelfull.

Selv med en detaljert omskrevet prompt, vil tekst-til-video-modeller ofte feilkomponere nøkkelelementer eller generere inkompatible starttilstander som bryter animasjonens logikk. Så lenge det første bildet ikke gjenspeiler det prompten beskriver, kan ikke den resulterende videoen gjenopprettes, uansett hvor god bevegelsesmodellen er.

Avisen sier*:

«[Tekst-til-video]-modeller produserer ofte distribusjonsforskjøvede bilder, men oppnår likevel [evalueringspoeng] som kan sammenlignes med I2V-modeller, noe som indikerer at» Bevegelsesmodelleringen deres forblir rimelig naturlig selv når scenekvaliteten er relativt dårlig.

«[Bilde-til-video]-modeller viser komplementær oppførsel, sterke [evalueringspoeng] fra nøyaktige innledende scener og svakere tidsmessig koherens, mens I2V+tekst balanserer begge aspekter.»

«Denne kontrasten antyder en strukturell uoverensstemmelse i nåværende T2V-modellerSceneforankring og temporal syntese drar nytte av distinkte induktive skjevheter, men eksisterende arkitekturer forsøker å lære begge samtidig innenfor en enkelt modell.

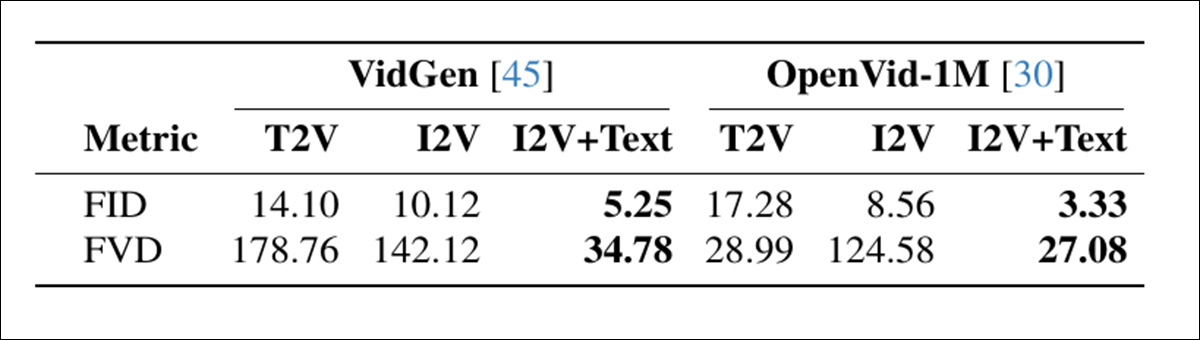

En diagnostisk sammenligning av generasjonsmoduser fant at modeller uten eksplisitt sceneforankring scoret bra på bevegelse, men ofte gikk på akkord med sceneoppsett, mens bildebetingede tilnærminger viste det motsatte mønsteret:

Sammenligning av videogenereringsmoduser på to datasett, som viser at I2V+tekst oppnår best bildekvalitet (FID) og temporal koherens (FVD), noe som fremhever fordelen med å skille scenekonstruksjon fra bevegelse. Kilde

Disse funnene peker på en strukturell feil der nåværende modeller prøver å lære både scenelayout og animasjon samtidig, selv om de to oppgavene krever forskjellige typer induktiv skjevhet, og håndteres bedre separat.

Det som kanskje er mest interessant er at dette «trikset» potensielt kan brukes på lokale installasjoner av modeller som Wan 2.1 og 2.2, og lignende videodiffusjonsmodeller som Hunyuan videoAnekdotisk, sammenlignet med kvaliteten på hobbyproduksjonen med kommersielle generative portaler som Kling og Runway, forbedrer de fleste av de store API-leverandørene tilbud med åpen kildekode som WAN med LoRA-er, og – det ser ut til – med triks av den typen som er sett i den nye artikkelen. Derfor kan denne tilnærmingen representere en innhenting for FOSS-kontingenten.

Tester utført for metoden indikerer at denne enkle og modulære tilnærmingen tilbyr en ny toppmoderne teknologi innen T2V-CompBench-referanseindeks, noe som forbedrer alle testede modeller betydelig. Forfatterne bemerker avslutningsvis at selv om systemet deres forbedrer gjengivelsen radikalt, adresserer det ikke (og er heller ikke laget for å adressere) identitetsdrift, for tiden bane for generativ AI-forskning.

Den nye artikkelen kommer fra fire forskere ved Ecole Polytechnique Fédérale de Lausanne (EPFL) i Sveits.

Metode og data

Det sentrale forslaget til den nye teknikken er at tekst-til-video (T2V) diffusjonsmodeller må «forankres» til startbilder som virkelig passer til den ønskede tekstprompten.

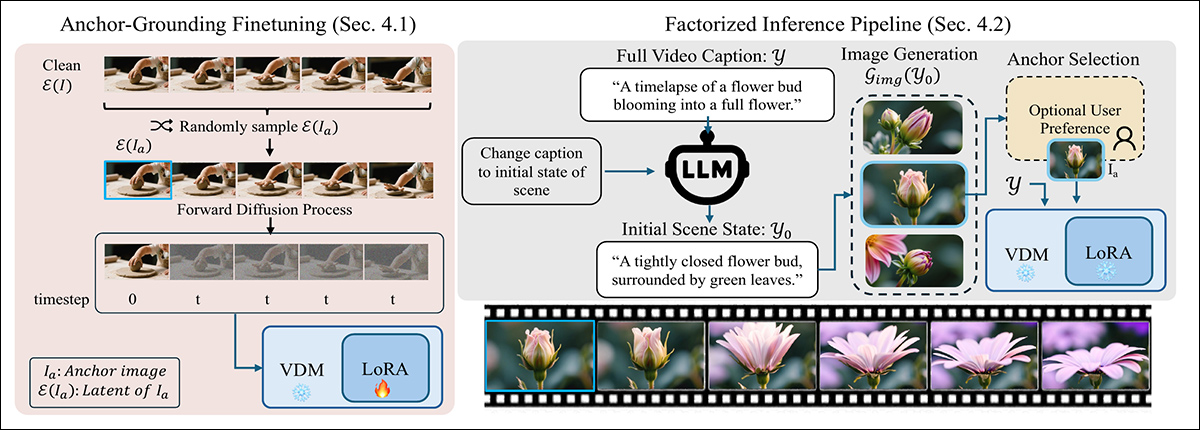

For å sikre at modellen respekterer startrammen, forstyrrer den nye metoden standard diffusjonsprosess ved å injisere en ren latent fra ankerbildet ved tidssteg null, og erstatter dermed en av de vanlige støyende inngangene. Denne ukjente inngangen forvirrer modellen først, men med minimal LoRA finjustering, lærer den å behandle den injiserte rammen som et fast visuelt anker i stedet for en del av støybanen:

En to-trinns metode for å forankre tekst-til-video-generering med et visuelt anker: Til venstre er modellen finjustert ved hjelp av en lett LoRA for å behandle en injisert ren latent som en fast scenebegrensning. Til høyre er ledeteksten delt inn i en førsterammetekst, som brukes til å generere ankerbildet som veileder videoen.

Ved inferens skriver metoden ledeteksten om for å beskrive bare den første rammen, ved bruk av en LLM for å trekke ut en plausibel initial scenetilstand fokusert på layout og utseende.

Denne omskrevne prompten sendes til en bildegenerator for å produsere en kandidatankerramme (som eventuelt kan forbedres av brukeren). Den valgte rammen kodes inn i en latent ramme og injiseres i diffusjonsprosessen ved å erstatte det første tidstrinnet, slik at modellen kan generere resten av videoen. mens man forblir forankret i den første scenen – en prosess som fungerer uten at det kreves endringer i den underliggende arkitekturen.

Prosessen ble testet ved å lage LoRA-er for Wan2.2-14B, Wan2.1-1Bog CogVideo1.5-5BLoRA-opplæringen ble gjennomført på en rangerer av 256, på 5000 tilfeldig utvalgte klipp fra UltraVideo samling.

Treningen varte i 6000 skritt og krevde 48 GPU-timer† for Wan-1B og CogVideo-5B, og 96 GPU-timer for Wan-14B. Forfatterne bemerker at Wan-5B har innebygd støtte for tekst- og tekst-bilde-kondisjonering (som i dette tilfellet blir lagt til de eldre rammeverkene), og derfor ikke krevde noen finjustering.

Tester

I eksperimentene som ble kjørt for prosessen, ble hver tekstprompt først forbedret ved hjelp av Qwen2.5-7B-instruks, som brukte resultatet til å generere en detaljert bildetekst med en beskrivelse av hele scenen. Denne ble deretter sendt til QwenImage, som hadde i oppgave å generere den «magiske rammen» som skulle plasseres i diffusjonsprosessen.

Referansepunktene som ble brukt til å vurdere systemet inkluderte den nevnte T2V-CompBench, for å teste komposisjonsforståelse ved å score hvor godt modellene bevarte objekter, attributter og handlinger i en sammenhengende scene; og VBench 2.0, for å evaluere bredere resonnement og konsistens på tvers av 18 målinger, gruppert i kreativitet, sunn fornuft resonnement, kontrollerbarhet, menneskelig trofasthetog fysikk:

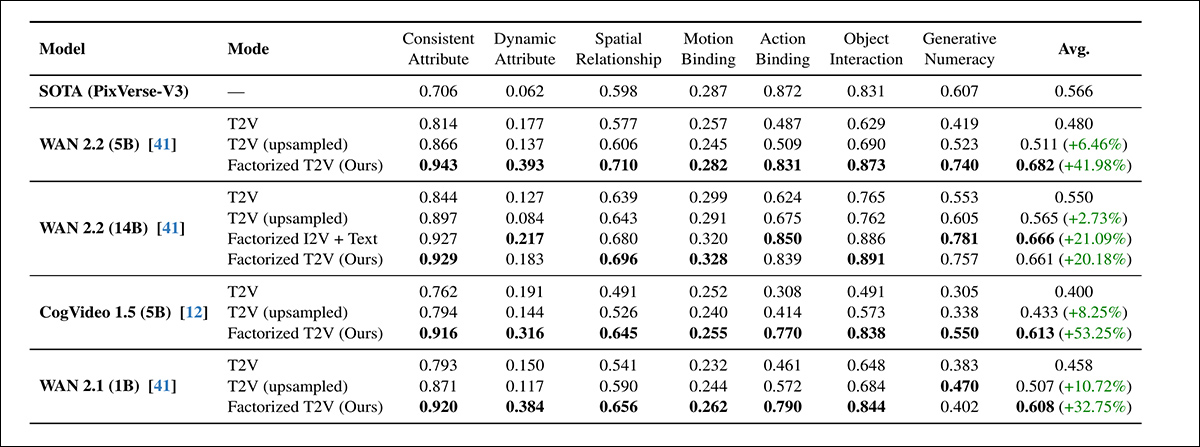

På tvers av alle sju evalueringskategoriene til T2V-CompBench, overgikk den faktoriserte T2V-metoden både standard og oppsamplede T2V-grunnlinjer for hver testede modell, med gevinster på opptil 53.25 %. Variantene med høyest poengsum samsvarte ofte med eller overgikk den proprietære PixVerse-V3-referansen.

Angående denne første runden med tester, sier forfatterne*:

«[På tvers av] alle modeller forbedrer det å legge til et ankerbilde komposisjonsytelsen konsekvent. Alle mindre faktoriserte modeller (CogVideo 5B, Wan 5B og Wan 1B) yter bedre enn den større Wan 14B T2V-modellen.»

'Vår faktoriserte Wan 5B yter også bedre enn den kommersielle PixVerse-V3-baseline, som er den best rapporterte modellen på referanseindeksen. Dette viser at visuell forankring forbedrer forståelsen av scene og handling betydelig, selv i modeller med mindre kapasitet.

«Innenfor hver modellfamilie overgår den faktoriserte versjonen den opprinnelige modellen. Det er verdt å merke seg at vår lette, forankrede LoRA på WAN 14B oppnår ytelse som er sammenlignbar med den forhåndstrente I2V 14B-varianten (0.661 vs. 0.666), til tross for at den ikke krever full omtrening.»

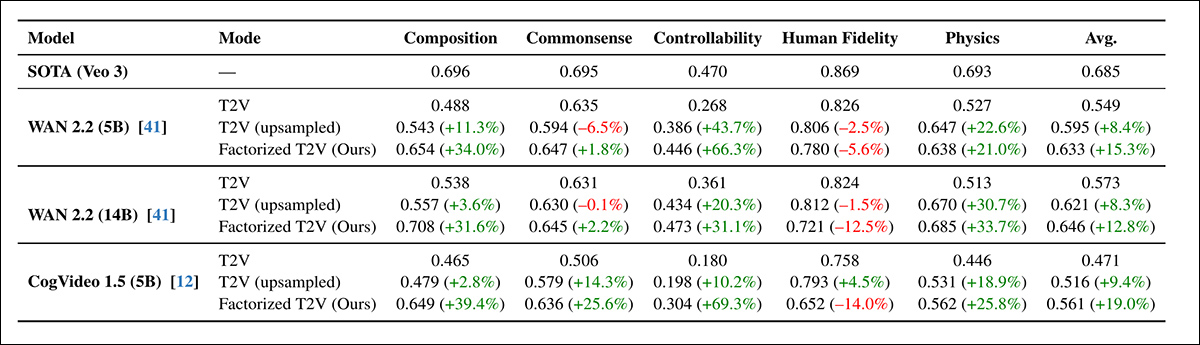

Deretter kom VBench2.0-runden:

Den faktoriserte T2V-tilnærmingen forbedret konsekvent VBench 2.0-ytelsen på tvers av komposisjon, sunn fornuft-resonnement, kontrollerbarhet og fysikk, med noen gevinster på over 60 % – selv om menneskelig gjengivelse forble under den proprietære Veo 3-grunnlinjen.

På tvers av alle arkitekturer økte den faktoriserte tilnærmingen poengsummene i alle VBench-kategorier unntatt menneskelig trofasthet, som gikk noe ned selv med rask oppsampling. WAN 5B presterte bedre enn den større WAN 14B, noe som forsterket tidligere T2V-CompBench-resultater som viste at visuell jording bidro mer enn skala.

Selv om gevinstene på VBench var konsistente, var de mindre enn de som ble sett på T2V-CompBench, og forfatterne tilskriver dette VBenchs strengere binære poengsum.

For de kvalitative testene inneholder artikkelen statiske bilder, men vi henviser leseren til de sammensatte videoene som er innebygd i denne artikkelen for en klarere idé, med forbehold om at kildevideoene er flere og mer mangfoldige, samt har større oppløsning og detaljer. Finn dem her.Når det gjelder kvalitative resultater, sier artikkelen:

«Forankrede videoer viser konsekvent mer nøyaktig scenekomposisjon, sterkere objekt-attributt-binding og tydeligere tidsmessig progresjon.»

Den faktoriserte metoden forble stabil selv når antallet diffusjonstrinn ble redusert fra 50 til 15, og viste nesten ingen ytelsestap på T2V-CompBench. Til sammenligning ble både tekstbaserte og oppsamplede baselinjer kraftig svekket under de samme forholdene.

Selv om reduksjon av trinn teoretisk sett kunne tredoble hastigheten, ble hele generasjonsrørledningen bare 2.1 ganger raskere i praksis på grunn av faste kostnader fra generering av ankerbilder. Resultatene indikerte likevel at forankring ikke bare forbedret prøvekvaliteten, men også bidro til å stabilisere diffusjonsprosessen, noe som støttet raskere og mer effektiv generering uten tap av nøyaktighet.

Prosjektets nettsted gir eksempler på oppsamplede kontra nye metodegenerasjoner, hvorav vi tilbyr noen få (lavere oppløsning) redigerte eksempler her:

Klikk for å spille (ingen lyd). Oppsamplede startkilder vs. forfatternes faktoriserte tilnærming.

Forfatterne konkluderer med:

«Resultatene våre tyder på at forbedret jording, snarere enn økt kapasitet alene, kan være like viktig. Nylige fremskritt innen T2V-diffusjon har i stor grad vært avhengige av økende modellstørrelse og treningsdata, men selv store modeller sliter ofte med å utlede en sammenhengende initial scene fra tekst alene.»

«Dette står i kontrast til bildediffusjon, hvor skalering er relativt enkel; i videomodeller må hver arkitektoniske forbedring operere over en ekstra tidsdimensjon, noe som gjør skalering betydelig mer ressurskrevende.»

«Funnene våre indikerer at forbedret jording kan utfylle skalaen ved å ta tak i en annen flaskehals: å etablere riktig scene før bevegelsessyntesen begynner.»

«Ved å faktorisere videogenerering i scenekomposisjon og tidsmodellering, reduserer vi flere vanlige feilmoduser uten å kreve vesentlig større modeller. Vi ser på dette som et komplementært designprinsipp som kan veilede fremtidige arkitekturer mot mer pålitelig og strukturert videosyntese.»

Konklusjon

Selv om problemene med sammenfiltring er svært reelle og kan kreve dedikerte løsninger (som forbedrede kuraterings- og distribusjonsevalueringer før trening), har det vært en øyeåpner å se faktorisering «avlime» flere gjenstridige og «fastlåste» konseptpromptorkestreringer til mye mer nøyaktige gjengivelser – med bare et moderat lag med LoRA-betinging og inngripen i et betydelig forbedret start-/frøbilde.

Ressursgapet mellom lokale hobbyinnslag og kommersielle løsninger er kanskje ikke så enormt som antatt, gitt at nesten alle leverandører søker å rasjonalisere sine betydelige GPU-ressursutgifter til forbrukerne.

Anekdotisk ser det ut til at et svært stort antall av den nåværende generative videoleverandørene bruker merkevarebaserte og generelt «oppgraderte» versjoner av kinesiske FOSS-modeller. Den største «gravgraven» disse «mellommannssystemene» ser ut til å ha, er at de har tatt seg bryet med å trene LoRA-er, eller – til en større kostnad og med litt større belønning – faktisk har utført en fullstendig finjustering av modellvektene.††.

Innsikt av denne typen kan bidra til å lukke dette gapet ytterligere, i sammenheng med en utgivelsesscene der kineserne ser ut til å være fast bestemt på (ikke nødvendigvis av altruistiske eller idealistiske grunner) å demokratisere generasjon AI, mens vestlige forretningsinteresser kanskje foretrekker at økende modellstørrelse og reguleringer til slutt lukker virkelig gode modeller bak API-er og flere lag med innholdsfiltre.

* Forfatternes vektlegginger, ikke mine.

† Artikkelen spesifiserer ikke hvilken GPU som ble valgt, eller hvor mange som ble brukt.

†† Selv om LoRA-ruten er mer sannsynlig, både for økonomisk brukervennlighet og fordi de fulle vektene, snarere enn kvantisert vekter, blir ikke alltid gjort tilgjengelige.

Først publisert fredag 19. desember 2025