Artificial Intelligence

GOTCHA– Een CAPTCHA-systeem voor live deepfakes

Nieuw onderzoek van de New York University draagt bij aan de groeiende aanwijzingen dat we binnenkort misschien het deepfake-equivalent van een 'dronkentest' moeten afleggen om onszelf te authenticeren, voordat we een gevoelig videogesprek beginnen - zoals een werkgerelateerde videoconferentie of een ander ander gevoelig scenario dat fraudeurs kan aantrekken realtime deepfake streaming-software.

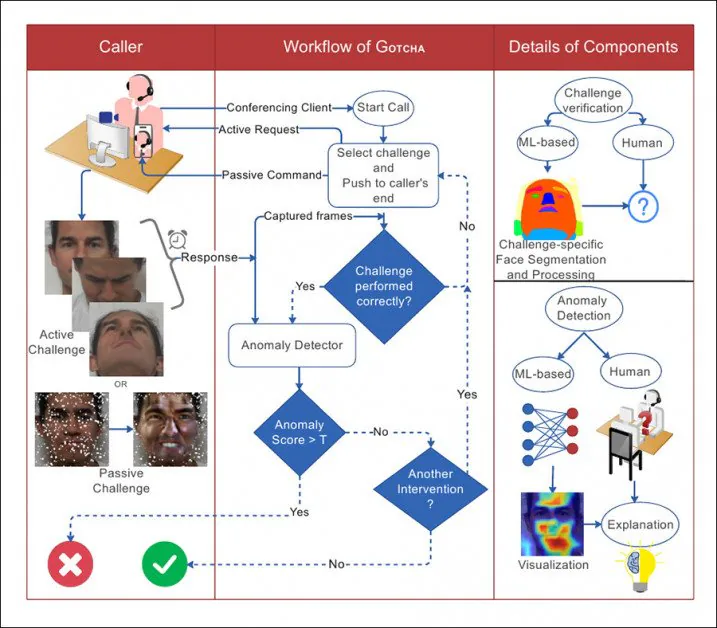

Sommige van de actieve en passieve uitdagingen waren van toepassing op scenario's voor videogesprekken in GOTCHA. De gebruiker moet voldoen aan en slagen voor de uitdagingen, terwijl aanvullende 'passieve' methoden (zoals een poging om een potentieel deepfake-systeem te overbelasten) worden gebruikt waarop de deelnemer geen invloed heeft. Bron: http://export.arxiv.org/pdf/2210.06186

Het voorgestelde systeem is getiteld GOTCHA - een eerbetoon aan de CAPTCHA-systemen die de afgelopen 10-15 jaar een steeds groter obstakel zijn geworden voor surfen op het web, waarbij geautomatiseerde systemen van de gebruiker eisen dat hij taken uitvoert waar machines slecht in zijn, zoals het identificeren van dieren of het ontcijferen van onleesbare tekst (en, ironisch genoeg, deze uitdagingen keert vaak de gebruiker om in een gratis AMT-stijl uitbestede annotator).

In wezen verlengt GOTCHA de augustus 2022 DF Captcha paper van de Ben-Gurion University, die als eerste voorstelde om de persoon aan de andere kant van de lijn door een paar visueel semantische hoepels te laten springen om hun authenticiteit te bewijzen.

De paper uit augustus 2022 van de Ben Gurion University stelde voor het eerst een reeks interactieve tests voor een gebruiker voor, waaronder het afsluiten van hun gezicht of zelfs het deprimeren van hun huid – taken die zelfs goed getrainde live deepfake-systemen misschien niet hebben verwacht of fotorealistisch aankunnen. . Bron: https://arxiv.org/pdf/2208.08524.pdf

Met name voegt GOTCHA 'passieve' methodologieën toe aan een 'cascade' van voorgestelde tests, waaronder de automatische superpositie van onwerkelijke elementen over het gezicht van de gebruiker en het 'overladen' van frames die door het bronsysteem gaan. Alleen de taken die op de gebruiker reageren, kunnen echter worden geëvalueerd zonder speciale machtigingen om toegang te krijgen tot het lokale systeem van de gebruiker - wat vermoedelijk zou komen in de vorm van lokale modules of add-ons voor populaire systemen zoals Skype en Zoom, of zelfs in de vorm van speciale propriëtaire software die specifiek is belast met het uitroeien van fakers.

Uit de paper, een illustratie van de interactie tussen de beller en het systeem in GOTCHA, met stippellijnen als beslissingsstromen.

De onderzoekers valideerden het systeem op een nieuwe dataset met meer dan 2.5 miljoen videoframes van 47 deelnemers, die elk 13 uitdagingen van GOTCHA aangingen. Ze beweren dat het raamwerk een 'consistente en meetbare' vermindering van de kwaliteit van deepfake-inhoud voor frauduleuze gebruikers veroorzaakt, waardoor het lokale systeem onder druk wordt gezet totdat duidelijke artefacten het bedrog met het blote oog duidelijk maken (hoewel GOTCHA ook enkele subtielere algoritmische analysemethoden bevat).

De nieuw papier is getiteld Gotcha: een challenge-response-systeem voor real-time deepfake-detectie (de naam van het systeem wordt in de hoofdtekst met een hoofdletter geschreven, maar niet de titel van de publicatie, hoewel het geen acroniem is).

Een scala aan uitdagingen

Volgens de Ben Gurion-paper zijn de daadwerkelijke uitdagingen voor gebruikers onderverdeeld in verschillende soorten taken.

Voor afsluiting, moet de gebruiker zijn gezicht verbergen met zijn hand of met andere objecten, of zijn gezicht presenteren in een hoek die waarschijnlijk niet is getraind in een deepfake-model (meestal vanwege een gebrek aan trainingsgegevens voor ' vreemde' poses - zie reeks afbeeldingen in de eerste illustratie hierboven).

Naast acties die de gebruiker zelf kan uitvoeren in overeenstemming met de instructies, kan GOTCHA willekeurige gezichtsuitsnijdingen, stickers en augmented reality-filters over elkaar plaatsen om de gezichtsstroom die een lokaal getraind deepfake-model mogelijk verwacht, te 'beschadigen', waardoor deze mislukt . Zoals eerder aangegeven, hoewel dit een 'passief' proces is voor de gebruiker, is het een intrusief proces voor de software, die rechtstreeks moet kunnen ingrijpen in de stream van de eindcorrespondent.

Vervolgens kan van de gebruiker worden verlangd dat hij zijn gezicht in ongebruikelijke gezichtsuitdrukkingen laat zien die waarschijnlijk ofwel afwezig of ondervertegenwoordigd zijn in een trainingsdataset, waardoor de kwaliteit van de diepvervalste uitvoer afneemt (afbeelding 'b', tweede kolom van links , in de eerste illustratie hierboven).

Als onderdeel van deze reeks tests kan van de gebruiker worden verlangd dat hij tekst voorleest of een gesprek voert dat is ontworpen om een lokaal live deepfaking-systeem uit te dagen, dat mogelijk niet voldoende fonemen of andere soorten mondgegevens heeft getraind tot een niveau waar het nauwkeurige lipbewegingen kan reconstrueren onder dergelijk nauwkeurig onderzoek.

Ten slotte (en deze lijkt de acteertalenten van de eindcorrespondent uit te dagen), kan in deze categorie de gebruiker worden gevraagd een 'micro-expressie' uit te voeren - een korte en onwillekeurige gezichtsuitdrukking die een emotie verbergt. Daarvan zegt de krant '[het] duurt meestal 0.5-4.0 seconden en is moeilijk te vervalsen'.

Hoewel het artikel niet beschrijft hoe een micro-expressie moet worden geëxtraheerd, suggereert de logica dat de enige manier om dit te doen is door een toepasselijke emotie bij de eindgebruiker te creëren, misschien met een soort verrassende inhoud die aan hen wordt gepresenteerd als onderdeel van de routine van de test. .

Gezichtsvervorming, verlichting en Onverwachte gasten

Bovendien, in overeenstemming met de suggesties van de paper van augustus, stelt het nieuwe werk voor om de eindgebruiker te vragen ongebruikelijke gezichtsvervormingen en -manipulaties uit te voeren, zoals het drukken van hun vinger op hun wang, interactie met hun gezicht en/of haar, en het uitvoeren van andere bewegingen die geen enkel huidig live deepfake-systeem waarschijnlijk goed aankan, aangezien dit marginale acties zijn - zelfs als ze aanwezig waren in de trainingsdataset, zou hun reproductie waarschijnlijk van lage kwaliteit zijn, in lijn met andere 'outlier'-gegevens.

Een glimlach, maar dit 'depressieve gezicht' wordt niet goed vertaald door een lokaal live deepfake-systeem.

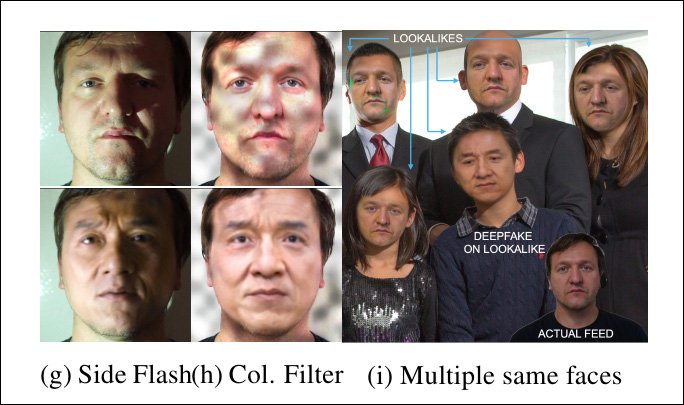

Een extra uitdaging ligt in het veranderen van de verlichtingsomstandigheden waarin de eindgebruiker zich bevindt, aangezien het mogelijk is dat de training van een deepfake-model is geoptimaliseerd voor standaard lichtsituaties voor videoconferenties, of zelfs de exacte lichtomstandigheden waarin het gesprek plaatsvindt. .

Zo kan de gebruiker worden gevraagd om de zaklamp op zijn mobiele telefoon op zijn gezicht te laten schijnen, of op een andere manier de verlichting te veranderen (en het is vermeldenswaard dat deze overstag het centrale voorstel is van nog een live deepfake-detectiedocument die deze zomer uitkwam).

Live deepfake-systemen worden uitgedaagd door onverwachte verlichting - en zelfs door meerdere mensen in de stream, waar het slechts één persoon verwachtte.

In het geval dat het voorgestelde systeem de mogelijkheid heeft om tussen te komen in de lokale gebruikersstroom (waarvan wordt vermoed dat het een deepfake-tussenpersoon herbergt), kan het toevoegen van onverwachte patronen (zie middelste kolom in de afbeelding hierboven) het vermogen van het deepfake-algoritme om een simulatie te handhaven in gevaar brengen. .

Bovendien, hoewel het onredelijk is om van een correspondent te verwachten dat hij extra mensen bij de hand heeft om hen te helpen authenticeren, kan het systeem extra gezichten tussenvoegen (meest rechtse afbeelding hierboven) en kijken of een lokaal deepfake-systeem de fout maakt om de aandacht te verleggen – of zelfs proberen om ze allemaal te deepfaken (autoencoder deepfake-systemen hebben geen 'identiteitsherkenning'-mogelijkheden die de aandacht in dit scenario op één persoon zouden kunnen richten).

Steganografie en overbelasting

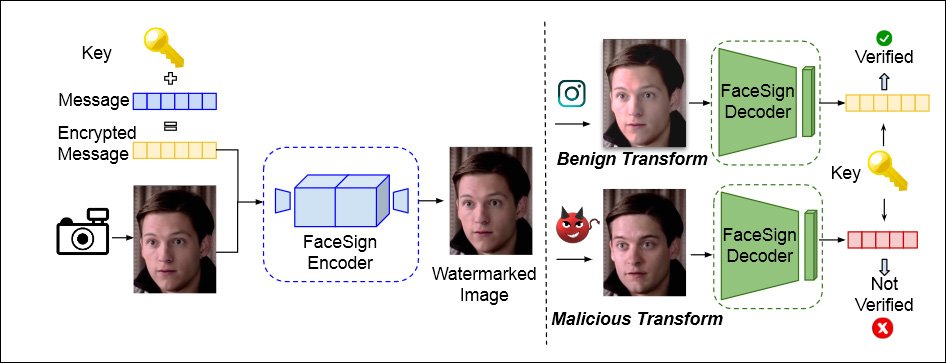

GOTCHA bevat ook een aanpak eerst voorgesteld door UC San Diego in april van dit jaar, en die steganografie gebruikt om een bericht te versleutelen in de lokale videostream van de gebruiker. Deepfake-routines zullen dit bericht volledig vernietigen, wat leidt tot een authenticatiefout.

Uit een paper uit april 2022 van de University of California San Diego en San Diego State University, een methode om de authentieke identiteit te bepalen door te kijken of een steganografisch signaal dat naar de videostream van een gebruiker wordt gestuurd, de lokale lus intact overleeft - als dat niet het geval is, deepfaking chicanes kan voor de hand liggen. Bron: https://arxiv.org/pdf/2204.01960.pdf

Bovendien is GOTCHA in staat om het lokale systeem te overbelasten (gegeven toegang en toestemming), door een stream te dupliceren en 'buitensporige' gegevens aan elk lokaal systeem te presenteren, ontworpen om replicatiefouten in een lokaal deepfake-systeem te veroorzaken.

Het systeem bevat verdere tests (zie de paper voor details), waaronder een uitdaging, in het geval van een op een smartphone gebaseerde correspondent, om hun telefoon ondersteboven te houden, wat een lokaal deepfake-systeem zal verstoren:

Nogmaals, dit soort dingen zou alleen werken met een overtuigende use-case, waarbij de gebruiker wordt gedwongen om lokale toegang tot de stream te verlenen, en kan niet worden geïmplementeerd door een simpele passieve evaluatie van gebruikersvideo, in tegenstelling tot de interactieve tests (zoals het indrukken van een vinger in iemands gezicht).

uitvoerbaarheid

In de paper wordt kort aangestipt in hoeverre dergelijke tests de eindgebruiker kunnen irriteren of op een of andere manier hinderen – bijvoorbeeld door de gebruiker te verplichten een aantal voorwerpen bij de hand te hebben die nodig kunnen zijn voor de tests, zoals een zonnebril.

Het erkent ook dat het moeilijk kan zijn om machtige correspondenten zover te krijgen dat ze zich aan de testroutines houden. Met betrekking tot het geval van een videogesprek met een CEO stellen de auteurs:

'Bruikbaarheid kan hier de sleutel zijn, dus informele of frivole uitdagingen (zoals gezichtsvervormingen of uitdrukkingen) zijn misschien niet gepast. Uitdagingen met behulp van externe fysieke artikelen zijn misschien niet wenselijk. De context is hier op de juiste manier aangepast en GOTCHA past zijn reeks uitdagingen dienovereenkomstig aan.'

Gegevens en testen

GOTCHA werd getest tegen vier soorten lokale live deepfake-systemen, waaronder twee varianten van de zeer populaire autoencoder deepfakes-maker DeepFaceLab ('DFL' vermeldt de krant echter verrassend genoeg niet DeepFaceLive, wat is geweest, sinds augustus 2021, de 'live'-implementatie van DeepFaceLab, en lijkt de meest waarschijnlijke eerste bron voor een potentiële faker).

De vier systemen werden DFL 'licht' getraind op een niet-beroemde persoon die deelnam aan tests, en een gepaarde beroemdheid; DFL trainde vollediger, tot 2m+ iteraties of stappen, waarbij je een veel performanter model zou verwachten; Latente beeldanimator (LIA); En Gezichtswisselend generatief vijandig netwerk (FSGAN).

Voor de gegevens hebben de onderzoekers de bovengenoemde videoclips vastgelegd en samengesteld, waarin 47 gebruikers 13 actieve uitdagingen uitvoeren, waarbij elke gebruiker ongeveer 5-6 minuten aan 1080p-video met 60 fps uitvoert. De auteurs stellen ook dat deze gegevens uiteindelijk openbaar zullen worden gemaakt.

Anomaliedetectie kan worden uitgevoerd door een menselijke waarnemer of algoritmisch. Voor de laatste optie is het systeem getraind op 600 gezichten van de FaceForensics-gegevensset. De regressieverliesfunctie was de krachtige Learned Perceptual Image Patch Compareity (LPIPS), terwijl binaire cross-entropie werd gebruikt om de classifier te trainen. EigenCam werd gebruikt om de gewichten van de detector te visualiseren.

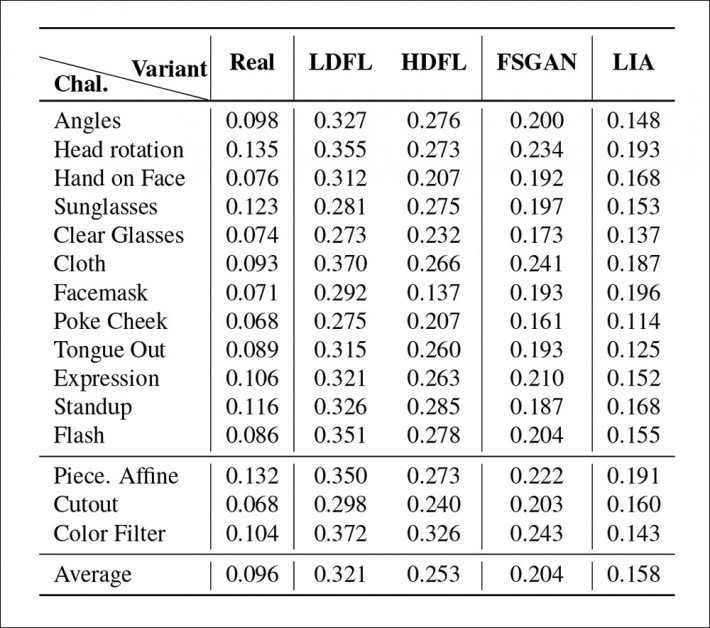

Primaire resultaten van de tests voor GOTCHA.

De onderzoekers ontdekten dat voor de volledige cascade van tests over de vier systemen, het laagste aantal en de laagste ernst van anomalieën (dwz artefacten die de aanwezigheid van een deepfake-systeem zouden onthullen) werden verkregen door de hoger opgeleide DFL-distributie. Vooral de minder getrainde versie had moeite om complexe lipbewegingen na te bootsen (die weinig van het frame in beslag nemen, maar die veel menselijke aandacht krijgen), terwijl FSGAN het midden tussen de twee DFL-versies bezette en LIA volkomen ontoereikend bleek voor de taak , waarbij de onderzoekers van mening waren dat LIA zou mislukken bij een echte implementatie.

Voor het eerst gepubliceerd op 17 oktober 2022.