Anderson's hoek

Schoonheidsfilters zijn een potentieel hulpmiddel voor deepfake-aanvallen

Schoonheidsfilters doen nu meer dan alleen oneffenheden verbergen: ze kunnen deepfakes en gezichtsmorfen helpen om detectiesystemen te omzeilen. Een nieuwe studie toont aan dat zelfs subtiele smoothing-effecten AI-detectoren in de war brengen, waardoor nepbeelden er echt uitzien en echte beelden nep. Als deze trend zich voortzet, kunnen schoonheidsfilters te maken krijgen met beperkingen in risicovolle situaties, van grenscontroles tot Zoom-gesprekken met bedrijven.

In een academisch jaar uit 2024 samenwerking Onderzoekers meldden dat tussen Spanje en Italië 90% van de vrouwen tussen de 18 en 30 jaar schoonheidsfilters gebruikte voordat ze foto's op sociale media plaatsten. Schoonheidsfilters zijn in die zin algoritmische of door AI ondersteunde methoden om gezichtsuitdrukkingen te veranderen, zodat ze zogenaamd beter zijn dan de oorspronkelijke bron.

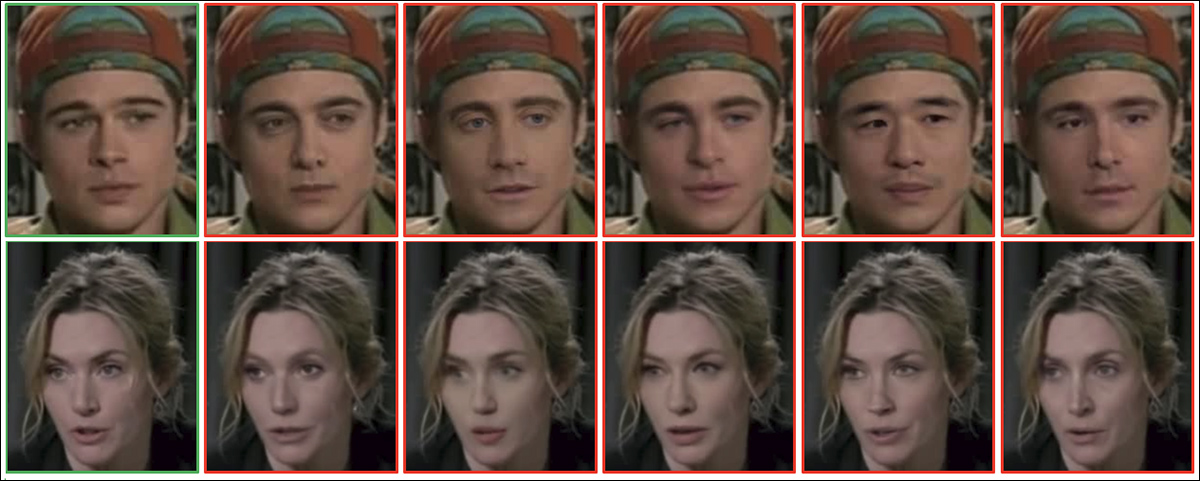

Uit het onderzoek uit 2024: voorbeelden van vrouwelijke (links) en mannelijke (rechts) gezichten, getoond voor en na beautyfiltering. Het filter verandert kenmerken zoals huidskleur, ogen, neus, lippen, kin en jukbeenderen om de aantrekkelijkheid te vergroten. Bron: https://arxiv.org/pdf/2407.11981

Dergelijke filters zijn ook algemeen beschikbaar als standaardfunctionaliteit of als aanvullende functionaliteit in populaire videosystemen, zoals Snapchat en Zoom, en bieden de mogelijkheid om 'imperfecte' huid glad te strijken en zelfs de leeftijd van het onderwerp te veranderen, tot het punt waarop gezegd kan worden dat de identiteit substantieel is gewijzigd:

Klik om af te spelen: Drie vrouwen schakelen hun videofilters voor 'verfraaiing' uit, waardoor duidelijk wordt in hoeverre hun uiterlijk wordt veranderd door de algoritmes of AI. Bron: https://www.youtube.com/watch?v=gtCpea_5qxw

Het fenomeen leek een verzadigingspunt te bereiken zodra de technologie relatief volwassen was; een 2020 studies van de City University of London bleek dat 90% van de jonge Snapchat-gebruikers in de Verenigde Staten, Frankrijk en het Verenigd Koninkrijk filters in hun apps gebruikten, terwijl Meta meldde dat meer dan 600 miljoen jongeren op dat moment filters op Facebook of Instagram hadden gebruikt.

Een onderzoek naar de negatieve effecten van dergelijke filters op de geestelijke gezondheid, uitgevoerd door Psychology Today verslag Uit het onderzoek bleek dat 90% van de jonge vrouwen, met een gemiddelde leeftijd van 20 jaar, filters gebruikte of op een of andere manier hun foto's bewerkte. De populairste filters werden gebruikt om de huidtint te egaliseren, een gebruinde uitstraling te geven, tanden witter te maken en zelfs om de lichaamslengte te verkleinen.

Face Off

Omdat gezichtsfilters zullen profiteren van de 2025 revolutie Bij videosynthese, en meer in het algemeen vanuit de aanhoudende interesse in deze onderzoekssector, wordt de mate waarin we onszelf kunnen 'herscheppen' of opnieuw kunnen uitvinden in live videochats steeds meer afgezwakt door de bezorgdheid van de veiligheidsgemeenschap over frauduleuze of criminele deepfake-videotechnieken.

Eén probleem is dat het scala aan 'makkelijke' tests ontwikkeld in de afgelopen jaren om een videodeepfaker te onthullen, die mogelijk probeert grote bedragen oplichten in een bedrijfscontext worden onvermijdelijk minder effectief, aangezien met deze achilleshielen rekening wordt gehouden in trainingsgegevens en op het moment van de gevolgtrekking:

Klik om af te spelen: Drie of vier jaar geleden was het zwaaien met je hand voor een deepfaked gezicht een betrouwbare test voor videogesprekken, maar we zien dat toegewijde inspanningen van platforms als TikTok steeds meer invloed hebben op de klassieke 'tells'. Bronnen: Ibid en https://archive.is/mofRV#wavehands

Nog kritischer is dat het wijdverbreide gebruik van gezichtsveranderende/verfraaiingsfilters de wateren vertroebelt voor een nieuwe en opkomende generatie deepfake-detectoren die de taak hebben om bedriegers buiten de videochats in bestuurskamers te houden en weg te houden van kwetsbare potentiële slachtoffers. 'ontvoering' en 'bedrieger'-fraude.

Het is makkelijker om een deepfake overtuigend te maken, of het nu een foto of video is, als de resolutie van de afbeelding is laag of het beeld is op de een of andere manier verslechterd, omdat het onderliggende namaaksysteem zijn eigen tekortkomingen kan verbergen achter wat ogenschijnlijke connectiviteits- of platformproblemen zijn.

Eigenlijk verwijderen de populairste verfraaiingsfilters een deel van het meest bruikbare materiaal voor het identificeren van deepfakes in video's, zoals de huidtextuur en andere gedetailleerde gezichtsgebieden. Daarbij is het goed om te bedenken dat hoe ouder een gezicht is, hoe meer van dergelijke details het waarschijnlijk bevat. Daarom kan het gebruik van vanity-de-agingfilters in zo'n geval erg verleidelijk zijn.

Als een detailloze 'Android'-stijl de trend is, beschikken deepfake-detectoren mogelijk niet over de benodigde apparatuur om onderscheid te maken tussen echte en nepbeelden en -personages. Bron: https://www.instagram.com/reel/DMyGerPtTPF/?hl=en

De Royal Society eind 2024 papier Wat mooi is, blijft goed: het aantrekkelijkheidshalo-effect in het tijdperk van schoonheidsfilters bevestigde dat het gebruik van filters universeel de algemene aantrekkelijkheid van beide geslachten vergroot (hoewel een grotere aantrekkelijkheid de algemene inschatting van intelligentie bij vrouwen met een schoonheidsfilter vaak verlaagt).

Je kunt dus gerust stellen dat dit een populaire technologie is, dat het werkt en dat het een cultuurschok zou zijn als er plotseling beveiligingsbeperkingen zouden gelden of als het in diverse contexten verboden zou worden.

Niettemin, in een tijdperk waarin videodeepfakes dreigen ononderscheidbaar te worden van echte videodeelnemers, zowel qua uiterlijk als spraak, is het mogelijk dat de wereldwijde 'ruis' van schoonheidsfilters in de toekomst om veiligheidsredenen moet worden gemitigeerd.

Gladde criminelen

De kwestie is onlangs onderzocht in een nieuw papier van de Universiteit van Cagliari in Italië, getiteld Misleidende schoonheid: evaluatie van de impact van schoonheidsfilters op de detectie van deepfake- en morphing-aanvallen.

In het nieuwe onderzoek hebben onderzoekers schoonheidsfilters toegepast op gezichten uit twee benchmarkdatasets en verschillende detectoren voor deepfake- en morphingaanvallen getest op zowel de originele als de aangepaste afbeeldingen.

In bijna alle gevallen daalde de detectienauwkeurigheid na verfraaiing; de meest dramatische dalingen deden zich voor wanneer filters rimpels gladstreken, de huidtint verhelderden of gelaatstrekken subtiel hertekenden. Deze veranderingen verwijderden of vervormden juist de signalen waarop detectiemodellen vertrouwen.

Zo verloor het best presterende model op MorphDB meer dan 9% aan nauwkeurigheid na filtering en bleef het probleem bestaan in meerdere detectiearchitecturen. Dit geeft aan dat huidige systemen niet bestand zijn tegen veelvoorkomende cosmetische verbeteringen.

De auteurs concluderen:

'[Verfraaiings]filters vormen een bedreiging voor de integriteit van biometrische authenticatie- en forensische analysesystemen. Daardoor is het robuust detecteren van deepfake- en morph-aanvallen onder dergelijke omstandigheden een grote uitdaging.

'Toekomstig werk zou prioriteit moeten geven aan de ontwikkeling van systemen voor het detecteren van digitale manipulatie die bestand zijn tegen dergelijke subtiele, reële wijzigingen, of deze nu kwaadaardig zijn of niet, om betrouwbare identiteitsherkenning en verificatie van inhoud te garanderen in alledaagse en beveiligingskritische contexten.'

Methode en gegevens

Om te evalueren hoe schoonheidsfilters deepfake beïnvloeden en morfdetectie, hebben de onderzoekers een progressief smoothing-filter toegepast en de resultaten getest op twee benchmark convolutionele neurale netwerken (CNN's) goed verbonden met het doelprobleem: AlexNet en VGG19.

Elk van de twee geteste benchmarkdatasets bevatte voorbeelden van toepasselijke gezichtsmanipulaties. De eerste was CelebDF, een grootschalige videobenchmark met 590 echte en 5,639 vervalste clips, gecreëerd met behulp van geavanceerde gezichtsverwisselingstechnieken. De collectie biedt een breed scala aan lichtomstandigheden, hoofdhoudingen en natuurlijke gezichtsuitdrukkingen van 59 personen, waardoor deze zeer geschikt is voor het evalueren van de veerkracht van deepfake-detectoren in realistische mediascenario's:

Voorbeelden van aangetaste gezichtsafbeeldingen, van CelebDF. Bron: https://github.com/yuezunli/celeb-deepfakeforensics

De tweede was AMSL (registratie vereist), een dataset met morphing-aanvallen, samengesteld door het Face Research Lab London Collectie, met zowel echte als synthetisch gemengde gezichten. De dataset bevat neutrale en glimlachende gezichtsuitdrukkingen van 102 proefpersonen en is gestructureerd om realistische uitdagingen te weerspiegelen voor biometrische authenticatiesystemen die worden gebruikt in contexten zoals grenscontrole.

Afbeeldingen uit de brondataset Face Research Lab London set (FRLL), gebruikt in AMSL. Bron: https://figshare.com/articles/dataset/Face_Research_Lab_London_Set/5047666?file=8541955

Elk netwerk werd getraind op 80% van de deepfake- of morphing-dataset, waarbij de resterende 20% werd gebruikt voor bevestigingOm de robuustheid tegen verfraaiing te testen, pasten de onderzoekers vervolgens een progressief smoothing-filter toe op de testbeelden, waardoor de vervagingsradius werd vergroot van 3% tot 5% van de gezichtshoogte:

Voorbeeldgezichten uit de datasets CelebDF (boven) en AMSL (onder), getoond voor en na toepassing van een op smoothing gebaseerd beautyfilter. De filterradius werd geschaald ten opzichte van de gezichtshoogte, waarbij c = 3% en c = 5% steeds sterkere effecten opleverden.

Wat de metriek betreft, werd elk model geëvalueerd met behulp van Equal Error Rate (OER) op zowel de originele als de verfraaide testmonsters. De analyse rapporteerde ook de Bona Fide Presentation Classification Error Rate (BPCER), of het percentage vals-positieve resultaten, en de Attack Presentation Classification Error Rate (APCER) of het percentage fout-negatieve uitslagen, waarbij de drempelwaarde wordt gebruikt die is ingesteld op de oorspronkelijke gegevens.

Gemorfde gezichten uit de AMSL-dataset.

Om de prestaties verder te beoordelen, is de Area Under the ROC Curve (AUC) en de scoreverdelingen voor echte en neppe afbeeldingen werden onderzocht.

Tests

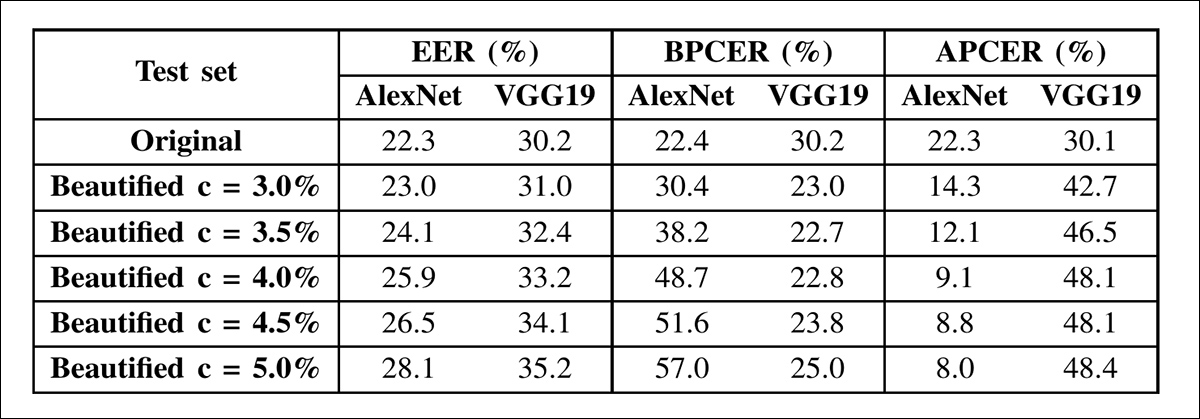

In de resultaten van de deepfake-detectie lieten beide netwerken stijgende Equal Error Rates zien naarmate de verfraaiingsintensiteit toenam. De EER van AlexNet steeg van 22.3% op de originele afbeeldingen naar 28.1% op het hoogste smoothing-niveau, terwijl die van VGG19 steeg van 30.2% naar 35.2%. De prestatiedaling volgde in beide gevallen een verschillend patroon:

Resultaten van deepfake-detectie op de CelebDF-dataset met behulp van AlexNet en VGG19. Beide modellen werden getest op originele en verfraaide afbeeldingen met toenemende niveaus van gezichtsverfijning. De getoonde statistieken omvatten de Equal Error Rate (EER), Bona Fide Presentation Classification Error Rate (BPCER) en Attack Presentation Classification Error Rate (APCER), met behulp van vaste drempelwaarden uit de oorspronkelijke testset. De detectienauwkeurigheid nam af naarmate de verfraaiingsintensiteit toenam, hoewel het patroon van degradatie verschilde tussen architecturen.

Naarmate de verfraaiing toenam, werd de kans groter dat AlexNet echte gezichten voor neppe aanzag, wat bleek uit een gestage stijging van het percentage foutpositieve resultaten (BPCER). VGG19 daarentegen had meestal moeite om de neppe resultaten zelf te detecteren, met een toenemend percentage foutnegatieve resultaten (APCER). De twee modellen reageerden verschillend op de filters, wat aangeeft dat zelfs bekende architecturen op verschillende manieren kunnen falen bij cosmetische aanpassingen.

Om deze resultaten beter te begrijpen, pasten de onderzoekers het verfraaiingsfilter afzonderlijk toe op echte en nepbeelden en maten ze de impact op de detectieprestaties. Deze verdeling, weergegeven in de onderstaande resultatentabel, verduidelijkt de bron van de kwetsbaarheid van elk model:

Detectienauwkeurigheid voor AlexNet en VGG19 onder gedeeltelijke verfraaiing in de CelebDF-dataset. De tabel toont drie scenario's: verfraaid echt versus verfraaid nep (F-Real versus F-Fake); verfraaid echt versus origineel nep (F-Real versus O-Fake); en origineel echt versus verfraaid nep (O-Real versus F-Fake), waarbij een afname in nauwkeurigheid duidt op verminderde detectorprestaties. AlexNet ondervond de grootste hinder wanneer echte afbeeldingen werden verfraaid, terwijl VGG19 het meest moeite had wanneer verfraaiing werd toegepast op nepafbeeldingen.

Voor AlexNet daalden de detectieprestaties wanneer echte afbeeldingen werden verfraaid, maar verbeterden ze wanneer alleen nepafbeeldingen werden gladgestreken. Voor VGG19 verbeterden de prestaties licht met verfraaide echte afbeeldingen, maar verslechterden ze wanneer deepfakes werden gefilterd. In alle gevallen sterkere verfraaiing verminderde nauwkeurigheid.

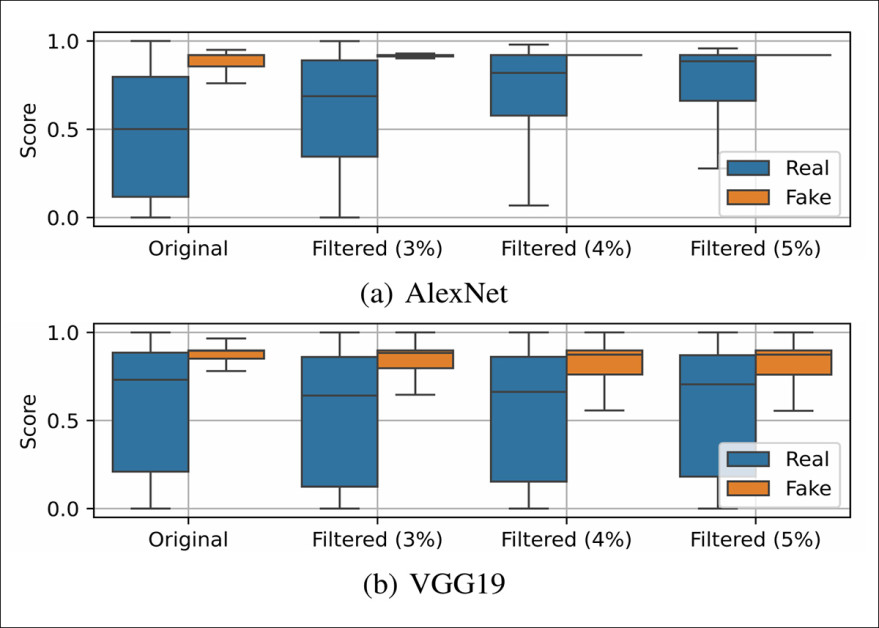

Boxplots die de verdeling van de outputscores van AlexNet en VGG19 op echte en neppe samples uit de CelebDF-dataset weergeven, onder toenemende mate van verfraaiing. Naarmate de smoothing intenser wordt, worden de scoreverdelingen voor echte en neppe afbeeldingen minder goed te onderscheiden, wat wijst op een verminderde detectiebetrouwbaarheid. AlexNet heeft minder vertrouwen in het identificeren van echte gezichten, terwijl VGG19 vaker neppe gezichten verkeerd classificeert.

Verfraaiing zorgde ervoor dat de outputscores van AlexNet uniformer waren voor zowel echte als neppe samples, terwijl VGG19 een grotere spreiding binnen elke klasse liet zien. Ondanks deze contrasterende effecten op de scorevariabiliteit, verloren beide modellen aan nauwkeurigheid. Bij AlexNet verschoven de scores voor echte gezichten meer naar die van deepfakes. Bij VGG19 begonnen de scores voor echte en neppe afbeeldingen te overlappen, waardoor het model ze minder goed van elkaar kon onderscheiden.

In de krant staat:

Deze resultaten hebben belangrijke implicaties en laten zien dat het noodzakelijk is om rekening te houden met het mogelijke gebruik van verfraaiingsfilters bij deepfake-detectie, aangezien deze een onvoorspelbare impact op de prestaties kunnen hebben. Verschillende architecturen reageren met name verschillend op gezichtsmanipulaties, zelfs als die manipulaties niet bedoeld zijn om te misleiden.

'Op basis van de specifieke deepfake-detector zouden de verfraaiingsfilters bijvoorbeeld de uitvoer aanzienlijk kunnen veranderen, waardoor echte afbeeldingen als nep worden herkend en, nog erger, deepfakes de detectie kunnen misleiden.

'Daarom is het noodzakelijk om ons te richten op de ontwikkeling van detectoren die beter bestand zijn tegen dergelijke subtiele, niet strikt kwaadaardige, veranderingen die kunnen dienen als camouflage voor kwaadaardige deepfake-manipulaties.'

In het morphing-aanvalsscenario werd een synthetisch beeld gecreëerd door gezichtskenmerken van twee personen te combineren. Dit beeld werd gebruikt om gezichtsherkenningssystemen te misleiden, waardoor beide bronidentiteiten als dezelfde persoon konden worden geverifieerd. Dergelijke aanvallen worden met name relevant geacht in beveiligingsomgevingen, waar biometrische systemen misleid kunnen worden om de gemorfde afbeelding te accepteren voor officiële identificatie.

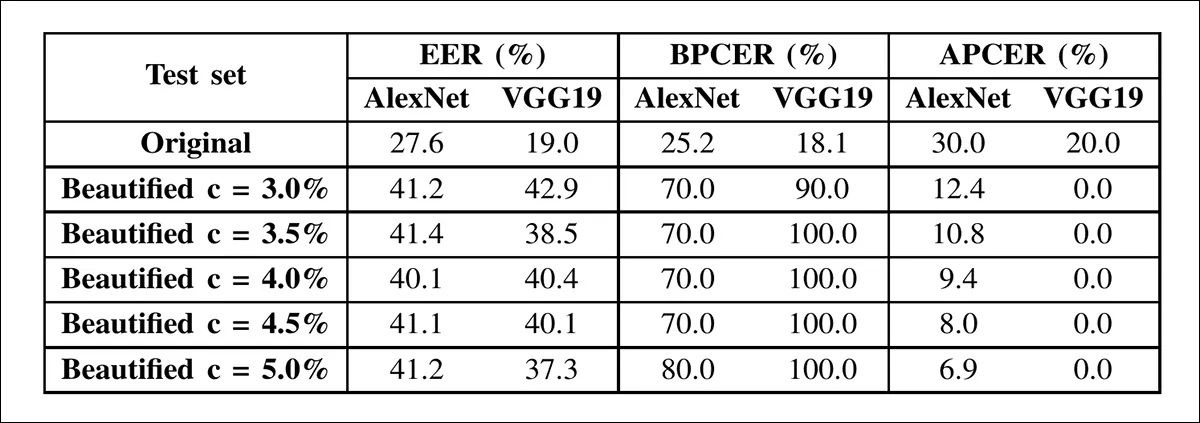

De bovenstaande tabel toont de resultaten van detectie van morphing-aanvallen op AMSL-afbeeldingen vóór en na verfraaiing. Beide netwerken vertonen een sterk toenemende foutmarge naarmate de intensiteit van de smoothing toeneemt.

In het morphing-aanvalsscenario daalden de prestaties sterker dan bij deepfake-detectie. De EER van AlexNet steeg van 27.6% naar 41.2% en die van VGG19 van 19.0% naar 37.3%, grotendeels veroorzaakt door foutpositieven: echte gezichten die ten onrechte als morphs werden geclassificeerd. Met een smoothing radius van 3% bereikte het percentage foutpositieven van VGG19 90%.

Dit patroon bleef bestaan wanneer filters selectief werden toegepast. Het gladstrijken van echte gezichten verminderde de detectie, terwijl het gladstrijken van alleen gemorfde gezichten de resultaten verbeterde. Naarmate het gladstrijken intensiever werd, vertoonden beide netwerken een kleinere scheiding tussen echte en neppe scores, waarbij VGG19 bijzonder instabiel werd.

Deze bevindingen, zo geven de auteurs aan, suggereren dat schoonheidsfilters morphs kunnen helpen om detectie te ontwijken zelfs effectiever dan deepfakes, wat tot ernstige zorgen over de veiligheid leidt.

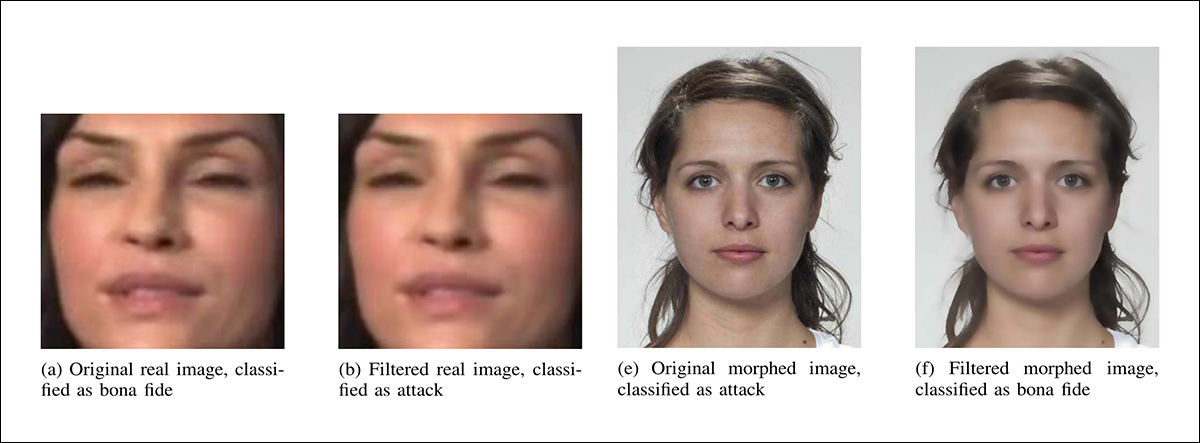

Gedeeltelijke voorbeelden (wegens ruimtegebrek) van hoe minimale verfraaiing (3% smoothing radius) de classificaties van AlexNet veranderde. Links wordt een echte afbeelding na filtering verkeerd geclassificeerd als een aanval, en rechts wordt een gemorfde afbeelding na filtering verkeerd geclassificeerd als bonafide.

Ten slotte ontdekten de onderzoekers dat zelfs milde verfraaiingsfilters de prestaties van geavanceerde deepfake- en morphingdetectoren aanzienlijk kunnen verslechteren.

De impact varieerde per architectuur, waarbij AlexNet een geleidelijke afname liet zien en VGG19 instortte bij minimale filtering. Omdat deze filters veel voorkomen en niet inherent kwaadaardig zijn, vormt hun vermogen om aanvallen te verbergen volgens de auteurs een praktische bedreiging, vooral in biometrische systemen. Het artikel benadrukt de noodzaak van detectiemodellen die bestand zijn tegen dergelijke subtiele beeldmanipulaties.

Conclusie

Eén reden waarom het lastig kan zijn om systemen voor het detecteren van deepfakes te trainen die verfraaiingsfilters kunnen negeren, is het gebrek aan contrasterend materiaal. Uiteindelijk is de 'verfraaide' versie degene die het meest wordt verspreid. En in tegenstelling tot de video die we eerder ter illustratie hebben ingevoegd, is het zeer zeldzaam dat er een 'voor'-foto wordt toegepast.

Een ander obstakel is dat veel filters precies de soort smoothing uitvoeren die typisch is voor compressiebewerkingen bij het opslaan van afbeeldingen of het comprimeren van video (een zegen voor de bandbreedte van de providers, en bovendien een digitale make-over voor degenen die het filter gebruiken).

De onderzoekssector voor deepfake-detectie is al druk bezig met het bestrijden van gevallen van echte beelddegradatie als gevolg van problemen zoals camera's van slechte kwaliteit, overmatige compressie of een haperende netwerkverbinding. Al deze omstandigheden zijn een direct voordeel voor deepfake-fraudeurs, die in een scenario met hoge kwaliteit en hoge resolutie veel harder hun best moeten doen.

Of verfraaiingsfilters uiteindelijk een bedreiging voor de veiligheid zullen worden, zal waarschijnlijk afhangen van de mate waarin ze een belemmering vormen voor deepfake-screeningmethoden, of uiteindelijk een soort van de facto een firewall die kwaadwillenden meer bevoordeelt dan degenen die hen bestrijden.

Eerste publicatie woensdag 24 september 2025