Mākslīgais intelekts

Pētnieki rada alternatīvu GPU

Datorzinātnieki no Rice universitātes kopā ar Intel līdzstrādniekiem ir izstrādājuši rentablāku alternatīvu GPU. Jauno algoritmu sauc par “sublineāro dziļās mācību dzinēju” (SLIDE), un tas izmanto vispārējas nozīmes centrālos procesorus (CPU) bez specializētas paātrināšanas aparatūras.

Rezultāti tika prezentēti Ostinas konferenču centrā, kurā notiek mašīnmācīšanās sistēmu konference MLSys.

Viens no lielākajiem mākslīgā intelekta (AI) izaicinājumiem ir saistīts ar specializētu paātrinājuma aparatūru, piemēram, grafikas apstrādes blokiem (GPU). Pirms jaunumiem tika uzskatīts, ka, lai paātrinātu dziļās mācīšanās tehnoloģiju, ir jāizmanto šī specializētā paātrinājuma aparatūra.

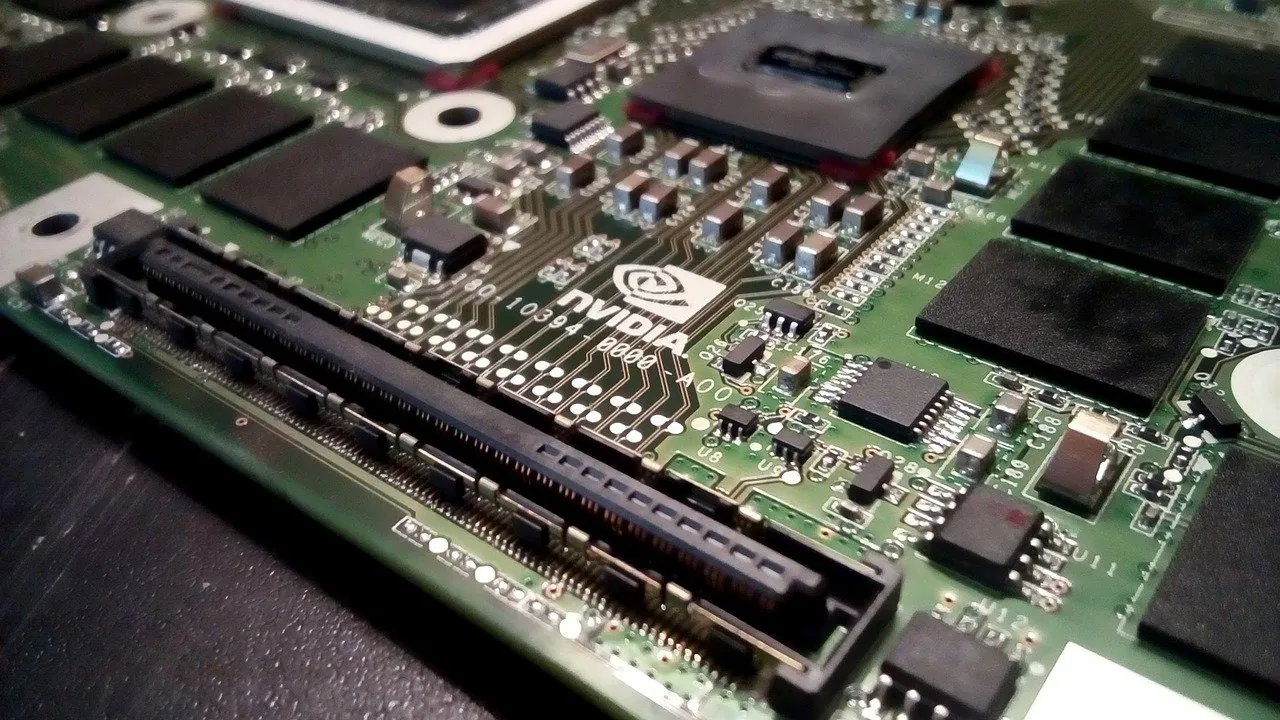

Daudzi uzņēmumi ir piešķīruši lielu nozīmi ieguldījumiem GPU un specializētā aparatūrā dziļai apmācībai, kas ir atbildīga par tādām tehnoloģijām kā digitālie palīgi, sejas atpazīšana un produktu ieteikumu sistēmas. Viens no šādiem uzņēmumiem ir Nvidia, kas rada Tesla V100 Tensor Core GPU. Nvidia nesen ziņoja, ka ceturtā ceturkšņa ieņēmumi ir palielinājušies par 41%, salīdzinot ar pagājušo gadu.

SLIDE izstrāde paver pilnīgi jaunas iespējas.

Anšumali Šrivastava ir Raisa Brauna inženierzinātņu skolas docente un palīdzēja izgudrot SLIDE kopā ar absolventiem Beidi Čenu un Tarunu Medini.

"Mūsu testi liecina, ka SLIDE ir pirmā viedā algoritmiskā dziļās mācīšanās ieviešana CPU, kas var pārspēt GPU aparatūras paātrinājumu nozares mēroga ieteikumu datu kopās ar lielām pilnībā savienotām arhitektūrām," sacīja Šrivastava.

SLIDE tiek galā ar GPU izaicinājumiem, jo tai ir pilnīgi atšķirīga pieeja dziļai mācīšanai. Pašlaik dziļo neironu tīklu standarta apmācības metode ir “atpakaļ izplatīšanās”, un tai ir nepieciešama matricas reizināšana. Šai darba slodzei ir nepieciešams izmantot GPU, tāpēc pētnieki mainīja neironu tīkla apmācību, lai to varētu atrisināt ar hash tabulām.

Šī jaunā pieeja ievērojami samazina SLIDE skaitļošanas izmaksas. Pašreizējā labākajā GPU platformā, ko tādi uzņēmumi kā Amazon un Google izmanto mākoņa padziļinātai apmācībai, ir astoņi Tesla V100, un cena ir aptuveni 100,000 XNUMX USD.

“Mums ir viens laboratorijā, un mūsu testa gadījumā mēs paņēmām darba slodzi, kas ir ideāli piemērota V100 — vienam ar vairāk nekā 100 miljoniem parametru lielos, pilnībā savienotos tīklos, kas ietilpst GPU atmiņā,” sacīja Šrivastava. “Mēs to apmācījām, izmantojot labāko (programmatūras) pakotni Google TensorFlow, un apmācība aizņēma 3 stundas.

"Pēc tam mēs parādījām, ka mūsu jaunais algoritms var veikt apmācību vienas stundas laikā, nevis ar GPU, bet ar 44 kodolu Xeon klases centrālo procesoru," viņš turpināja.

Jaukšana ir datu indeksēšanas metode, kas 1990. gados tika izgudrota meklēšanai internetā. Skaitliskās metodes tiek izmantotas, lai kodētu lielus informācijas apjomus kā ciparu virkni, ko sauc par hash. Jaucējkodi ir uzskaitīti, lai izveidotu tabulas, kurās var ātri meklēt.

"Nebūtu jēgas ieviest mūsu algoritmu TensorFlow vai PyTorch, jo pirmā lieta, ko viņi vēlas darīt, ir pārvērst visu, ko jūs darāt par matricas reizināšanas problēmu," sacīja Čens. "Tieši no tā mēs vēlējāmies atbrīvoties. Tāpēc mēs uzrakstījām paši savu C++ kodu no nulles.

Saskaņā ar Shrivastava teikto, SLIDE lielākā priekšrocība ir tā, ka tie ir paralēli.

"Ar datiem paralēli es domāju, ka, ja man ir divi datu gadījumi, kuros es vēlos trenēties, pieņemsim, ka viens ir kaķa attēls, bet otrs - autobusa attēls, tie, iespējams, aktivizēs dažādus neironus, un SLIDE var atjaunināt vai apmācīt. par šiem diviem neatkarīgi," viņš teica. "Šī ir daudz labāka paralēlisma izmantošana centrālajiem procesoriem."

"Salīdzinot ar GPU, mums ir nepieciešama liela atmiņa," viņš teica. "Galvenajā atmiņā ir kešatmiņas hierarhija, un, ja jūs ar to nerīkojaties uzmanīgi, varat saskarties ar problēmu, ko sauc par kešatmiņas ievilkšanu, kuras rezultātā rodas daudz kešatmiņas kļūdu."

SLIDE ir pavērusi durvis jauniem veidiem, kā ieviest dziļu mācīšanos, un Shrivastava uzskata, ka tas ir tikai sākums.

"Mēs tikko esam saskrāpējuši virsmu," viņš teica. “Mēs vēl varam daudz darīt, lai optimizētu. Mēs neesam izmantojuši, piemēram, vektorizāciju vai CPU iebūvētos paātrinātājus, piemēram, Intel Deep Learning Boost. Ir daudz citu triku, ko mēs joprojām varētu izmantot, lai to padarītu vēl ātrāku.