Mākslīgais intelekts

LoReFT: Representation Finetuning for Language Models

Parametru efektīvas precizēšanas vai PeFT metodes cenšas pielāgot lielus valodu modeļus, izmantojot atjauninājumus nelielam skaitam svaru. Tomēr lielākā daļa esošo interpretējamo darbu ir parādījuši, ka reprezentācijas kodē semantiski bagātu informāciju, kas liecina, ka tā varētu būt labāka un jaudīgāka alternatīva šo reprezentāciju rediģēšanai. Iepriekš apmācīti lielie modeļi bieži tiek precīzi pielāgoti, lai tos izmantotu jauniem domēniem vai uzdevumiem, un precizēšanas procesa laikā vienu bāzes modeli var pielāgot dažādiem uzdevumiem, pat ja ir pieejams tikai neliels domēna datu apjoms. uz modeli. Tomēr visa modeļa precizēšanas process ir resursietilpīgs un dārgs, īpaši valodu modeļiem ar ievērojami lielāku izmēru un parametru skaitu.

Parametru efektīvas precizēšanas vai PeFT metodes piedāvā novērst augstās izmaksas, kas saistītas ar visa modeļa precizēšanu, atjauninot tikai nelielu daudzumu no kopējā pieejamā svara, kas palīdz samazināt treniņu laiku un atmiņas izmantošanu. Vēl svarīgāk ir tas, ka parametru efektīvas precizēšanas vai PeFT metodes vairākos praktiskos iestatījumos ir uzrādījušas līdzīgu veiktspēju kā precizēšanai. Adapteri, plaši izplatīta parametru efektīvas precizēšanas vai PeFT metožu saime, apgūst rediģēšanu, ko var pievienot papildu svaru kopai, kas darbojas kopā ar iesaldēto bāzes modeli, un jaunākie adapteri, piemēram, LoRA, samazina apmācāmo parametru skaitu apgūtajā. svara atjauninājumus, izmantojot zema ranga tuvinājumus, nevis pilna svara matricas, apmācot adapterus.

Tā kā iepriekšējie darbi, kas demonstrē attēlu rediģēšanu, varētu būt labāka alternatīva parametru efektīvai precizēšanai vai PeFT metodēm, šajā rakstā mēs runāsim par attēlojuma precīzās noregulēšanas vai ReFT metodēm, kas darbojas ar iesaldētu modeli, un apgūsim uzdevumiem specifiskas metodes. iejaukšanās slēptajos attēlojumos. Šī raksta mērķis ir padziļināti aptvert ReFt vai reprezentācijas precizēšanas ietvaru, un mēs izpētām mehānismu, metodoloģiju, ietvara arhitektūru, kā arī tās salīdzinājumu ar jaunākajiem ietvariem. Tātad sāksim.

ReFT: Atveides precīza pielāgošana valodu modeļiem

Mēģinot pieņemt iepriekš apmācītus valodu modeļus jaunām jomām un uzdevumiem, pašreizējās sistēmas bieži precizē šos iepriekš apmācītos valodu modeļus, jo ar ieviesto precizēšanas procesu vienu bāzes modeli var pielāgot dažādiem uzdevumiem, pat. strādājot ar nelielu domēna datu apjomu. Lai gan precizēšanas process uzlabo kopējo veiktspēju, tas ir dārgs process, it īpaši, ja valodas modelim ir ievērojami liels parametru skaits. Lai risinātu šo problēmu un samazinātu saistītās izmaksas, izmantojiet PEFT vai parametru efektīvu precīzas regulēšanas ietvari atjauniniet tikai nelielu daļu no kopējā svara, process, kas ne tikai samazina apmācības laiku, bet arī samazina atmiņas izmantošanu, ļaujot PeFT ietvariem sasniegt līdzīgu veiktspēju, salīdzinot ar pilnīgas precizēšanas pieejām praktiskos scenārijos. Adapteri, izplatīta PEFT saime, darbojas, apgūstot rediģēšanu, ko var pievienot papildu svaru kopai, kā arī svaru apakškopu, kas darbojas unisonā ar bāzes modeli ar fiksētiem svariem. Nesenie adapteru ietvari, piemēram LoRA un QLoRA ir pierādījuši, ka ir iespējams apmācīt pilnas precizitātes adapterus papildus samazinātas precizitātes modeļiem, neietekmējot veiktspēju. Adapteri parasti ir efektīvāki un efektīvāki, salīdzinot ar citām metodēm, kas ievieš jaunus modeļa komponentus.

Pašreizējo jaunāko parametru pilnveidošanas sistēmu galvenais akcents ir tas, ka tā vietā, lai mainītu attēlojumus, tie maina svarus. Tomēr ietvari, kas nodarbojas ar interpretējamību, ir parādījuši, ka attēlojumi kodē bagātīgu semantisko informāciju, kas liecina, ka attēlojumu rediģēšana varētu būt labāka un jaudīgāka pieeja, salīdzinot ar svara atjauninājumiem. Šis pieņēmums, ka reprezentāciju rediģēšana ir labāka pieeja, ir tas, kas veido pamatu ReFT vai Representation Fine-tuning ietvaram, kas apmāca intervences, nevis pielāgo modeļa svarus, ļaujot modelim manipulēt ar nelielu daļu no visiem attēlojumiem, lai mēģinātu vadīt modeļa uzvedību. lai atrisinātu pakārtotos uzdevumus secinājumu laikā. ReFT vai Representation Precīzākas noregulēšanas metodes ir uz svara balstītas PeFT vai parametru efektīvas precizēšanas sistēmas aizstājējmetodes. ReFT pieeja smeļas iedvesmu no jaunākajiem modeļiem, kas strādā ar lielu modeļu interpretējamību, kas iejaucas attēlos, lai atrastu uzticamus cēloņsakarības mehānismus, un virza modeļa uzvedību secinājumu izdarīšanas laikā, un tāpēc to var uzskatīt par reprezentācijas rediģēšanas modeļu vispārinājumu. Pamatojoties uz to pašu, LoReFT vai zema ranga apakštelpa ReFT ir spēcīgs un efektīvs ReFT gadījums, un tā ir ReFT parametrizācija, kas iejaucas slēptos attēlojumos lineārajā telpā, ko aptver zema ranga projekcijas matrica, un balstās tieši uz DAS. vai Distributed Alignment Search ietvars.

Pretēji pilnīgai precizēšanai, PeFT vai parametru efektīvā precizēšanas sistēma apmāca tikai nelielu daļu no modeļa parametriem un spēj pielāgot modeli pakārtotajiem uzdevumiem. Parametru efektīvās precizēšanas sistēmu var iedalīt trīs galvenajās kategorijās:

- Uz adapteriem balstītas metodes: Uz adapteriem balstītas metodes apmāca papildu moduļus, piemēram, pilnībā savienotus slāņus virs iepriekš apmācīta modeļa ar sasaldētiem svariem. Sērijas adapteri ievieto komponentus starp daudzslāņu perceptronu vai MLP un LM vai lieliem modeļa uzmanības slāņiem, savukārt paralēlie adapteri pievieno moduļus līdzās esošajiem komponentiem. Tā kā adapteri pievieno jaunas sastāvdaļas, kuras nevar viegli salocīt esošajos modeļa svaros, tie rada papildu slogu secinājumu veikšanas laikā.

- LoRA: LoRA kopā ar saviem jaunākajiem variantiem aptuveno piedevu svaru treniņa laikā, izmantojot zema ranga matricas, un tiem nav nepieciešama papildu pieskaitāmā izmaksas secinājumu veikšanai, jo svara atjauninājumus var apvienot modelī, un tas ir iemesls, kāpēc tie tiek uzskatīti par pašreizējiem. spēcīgākie PEFT ietvari.

- Uz tūlītējām metodēm: Uz uzvednes balstītas metodes ievadē pievieno mīkstos marķierus, kas tiek inicializēti nejauši, un apmāca to iegulšanu, vienlaikus saglabājot iesaldētu valodas modeļa svaru. Šo metožu piedāvātā veiktspēja bieži vien nav apmierinoša, salīdzinot ar citām PeFT pieejām, un tām ir arī ievērojamas pieskaitāmās izmaksas.

Tā vietā, lai atjauninātu svarus, ReFT sistēma apgūst intervences, lai modificētu nelielu daļu no kopējā attēlojuma. Turklāt jaunākie darbi par attēlojuma inženieriju un aktivizēšanas vadību ir parādījuši, ka fiksētu stūrēšanas vektoru pievienošana atlikušajai straumei var atvieglot zināmu kontroli pār iepriekš apmācītajām lielajām modeļu paaudzēm, neprasot resursietilpīgus. laba skaņa. Citas sistēmas ir pierādījušas, ka attēlu rediģēšana ar apgūtu mērogošanas un tulkošanas darbību var mēģināt saskaņot, bet nepārspēt LoRA adapteru piedāvāto veiktspēju, veicot plašu uzdevumu klāstu ar mazāk apgūto parametru. Turklāt šo ietvaru panākumi virknē uzdevumu ir parādījuši, ka attēlojumiem, ko ievada iepriekš apmācīti valodu modeļi, ir bagātīga semantika, lai gan šo modeļu veiktspēja nav optimāla, kā rezultātā PEFT joprojām ir jaunākā pieeja. bez papildu secinājumu slodzes.

ReFT: Metodoloģija un arhitektūra

Lai stila saglabāšanas process būtu vienkāršs, ReFT ietvars kā mērķa modeli izmanto uz transformatoru balstītu lielo modeli, kas spēj radīt kontekstualizētu marķieru secības attēlojumu. Noteiktai secībai ar n ievades marķieru skaitu ReFT ietvars vispirms iegulst šos ievades marķierus attēlojumu sarakstā, pēc kura m slāņi secīgi aprēķina slēpto attēlojumu sarakstu kā funkciju no iepriekšējā slēpto attēlojumu saraksta. Katrs slēptais attēlojums ir vektors, un valodas modelis prognožu veidošanai izmanto galīgos slēptos attēlojumus. ReFT ietvars ņem vērā gan maskētu valodu modeļus, gan autorregresīvos valodu modeļus. Tagad, saskaņā ar lineārās reprezentācijas hipotēzi, neironu tīklos jēdzieni tiek kodēti reprezentāciju lineārajās apakštelpās. Jaunākie modeļi ir atklājuši, ka šis apgalvojums ir patiess neironu tīklu modeļos, kas apmācīti dabiskā valodā kopā ar citiem ievades sadalījumiem.

Turklāt interpretējamības pētījumos gadījuma abstrakcijas sistēma izmanto apmaiņas iejaukšanās, lai nejauši noteiktu neironu tīkla komponentu lomu, īstenojot noteiktu uzvedību. Loģika aiz savstarpējas apmaiņas iejaukšanās ir tāda, ka, ja tiek fiksēts priekšstats tāds, kāds tas būtu bijis hipotētiskai ievadei, un šī iejaukšanās konsekventi ietekmē modeļa izvadi tādā veidā, kā ReFT sistēmas apgalvojumi par komponentu, kas ir atbildīgs par ražošanu. ka reprezentācija, tad komponentam ir cēloņsakarība uzvedībā. Lai gan ir dažas metodes, izplatīta apmaiņas iejaukšanās ir ideāla pieeja, lai pārbaudītu, vai jēdziens ir iekodēts attēlojuma lineārajā apakštelpā, kā to apgalvo lineārās reprezentācijas hipotēze. Turklāt DAS metode tika izmantota iepriekš, lai atrastu entītiju atribūtu, noskaņojuma, lingvistisko iezīmju un matemātiskās argumentācijas lineāru attēlojumu valodas modeļos. Tomēr vairāki eksperimenti ir parādījuši, ka DAS metode ir ļoti izteiksmīga un tai piemīt spēja atrast cēloņsakarības efektīvas apakštelpas pat tad, ja transformatora valodas modelis ir inicializēts nejauši, un tāpēc tai vēl ir jāapgūst uzdevumam raksturīgi attēlojumi, kā rezultātā apspriest, vai DAS ir pietiekami efektīva un atbildīga interpretējamības uzdevumu veikšanai.

DAS piedāvātā izteiksmīgums liecina, ka pieeja varētu būt ideāls instruments, lai kontrolētu valodas modeļa uzvedību, kā arī tā darbs pie kontrolējamas ģenerēšanas un atbildīgas rediģēšanas. Tāpēc, lai pielāgotu valodas modeļus pakārtotajiem uzdevumiem, ReFT ietvars izmanto izkliedētās apmaiņas iejaukšanās operāciju, lai izveidotu jaunu parametru efektīvu metodi. Turklāt ReFT metode ir iejaukšanos kopums, un sistēma nodrošina, ka jebkurām divām intervencēm, kas darbojas vienā un tajā pašā slānī, intervences pozīcijām jābūt nesadalītām, un visu intervences funkciju parametri paliek neatkarīgi. Rezultātā ReFT ir vispārējs ietvars, kas ietver iejaukšanās slēptos attēlojumos modeļa pārejas laikā.

ReFT: eksperimenti un rezultāti

Lai novērtētu tā veiktspēju salīdzinājumā ar esošajām PEFT ietvariem, ReFT ietvars veic eksperimentus četros dažādos dabiskās valodas apstrādes etalonos un aptver vairāk nekā 20 datu kopas, un galvenais mērķis ir sniegt bagātīgu priekšstatu par LoReFT ietvara darbību dažādos scenārijos. Turklāt, kad LoReFT ietvars tiek ieviests reālajā dzīvē, izstrādātājiem ir jāizlemj, cik intervenču jāapgūst, kā arī ievades pozīcijām un slāņiem, kas jāizmanto katram no tiem. Lai pabeigtu uzdevumu, ReFT sistēma noregulē četrus hiperparametrus.

- Prefiksu pozīciju skaits, kurās jāiejaucas.

- Sufiksu pozīciju skaits, kurās jāiejaucas.

- Kādu slāņu komplektu iejaukties.

- Neatkarīgi no tā, vai saistīt intervences parametrus dažādās pozīcijās vienā slānī.

Šādi rīkojoties, ReFT sistēma vienkāršo hiperparametru meklēšanas telpu un nodrošina tikai fiksētas papildu izsecināšanas izmaksas, kas netiek mērogotas ar uzvednes garumu.

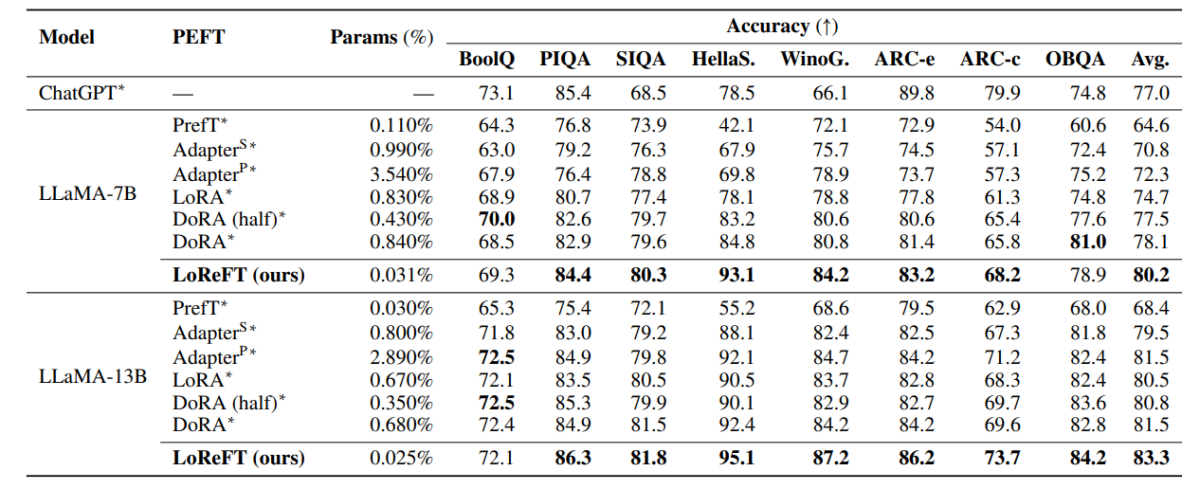

Iepriekšējā tabulā ir salīdzināta LLaMA-7B un LLaMA-13B ietvaru precizitāte ar esošajiem PEFT modeļiem, izmantojot 8 veselā saprāta datu kopas. Kā var novērot, LoReFT modelis pārspēj esošās PEFT pieejas ar pienācīgu starpību, neskatoties uz to, ka tajā ir daudz mazāk parametru, un tiek ziņots par vidējo veiktspēju trīs braucienos ar atšķirīgām LoReFT modeļa parametru sēklām. Parametru(%) aprēķina, trenējamo parametru skaitu dalot ar pamata lielā modeļa kopējo parametru skaitu.

Iepriekšējā tabulā ir apkopots LLaMA-7B un LLaMA-13B ietvaru precizitātes salīdzinājums ar esošajiem PEFT modeļiem 4 dažādās aritmētiskās spriešanas datu kopās, un sistēma ziņo par vidējo veiktspēju trīs piegājienos ar atšķirīgām nejaušām sēklām. Kā var novērot, neskatoties uz to, ka tajā ir daudz mazāk parametru (%), LoReFT ietvars ar ievērojamu starpību pārspēj esošos PEFT ietvarus.

Iepriekšējā tabulā ir apkopots RoBERTa-base un RoBERTa-large ietvaru precizitātes salīdzinājums ar esošajiem PEFT modeļiem visā GLUE etalonā, un sistēma ziņo par vidējo veiktspēju piecos braucienos ar atšķirīgām nejaušām sēklām. Kā var novērot, neskatoties uz to, ka tajā ir daudz mazāk parametru (%), LoReFT ietvars ar ievērojamu starpību pārspēj esošos PEFT ietvarus.

Final Domas

Šajā rakstā mēs runājām par LoReFT — spēcīgu alternatīvu esošajiem PEFT ietvariem, kas nodrošina spēcīgu veiktspēju četru dažādu domēnu etalonos, vienlaikus piedāvājot līdz pat 50 reizēm lielāku efektivitāti, ko piedāvā iepriekšējie jaunākie PEFT modeļi. Iepriekš apmācīti lielie modeļi bieži tiek precīzi pielāgoti, lai tos izmantotu jauniem domēniem vai uzdevumiem, un precizēšanas procesa laikā vienu bāzes modeli var pielāgot dažādiem uzdevumiem, pat ja ir pieejams tikai neliels domēna datu apjoms. uz modeli. Tomēr visa modeļa precizēšanas process ir resursietilpīgs un dārgs, īpaši valodu modeļiem ar ievērojami lielāku izmēru un parametru skaitu. Parametru efektīvas precizēšanas vai PeFT metodes piedāvā novērst augstās izmaksas, kas saistītas ar visa modeļa precizēšanu, atjauninot tikai nelielu daudzumu no kopējā pieejamā svara, kas palīdz samazināt treniņu laiku un atmiņas izmantošanu. Konkrēti, LoReFT nodrošina jaunu, mūsdienīgu veiktspēju veselā saprāta spriešanā, norādījumu ievērošanā un dabiskās valodas sapratnē, salīdzinot ar spēcīgākajiem PEFT.