인공지능

MagicDance: 실감나는 휴먼 댄스 비디오 생성

컴퓨터 비전은 광범위한 실시간 작업에 대한 잠재적인 응용 덕분에 AI 업계에서 가장 많이 논의되는 분야 중 하나입니다. 최근 몇 년 동안 컴퓨터 비전 프레임워크는 빠르게 발전하여 이제 실시간 시나리오에서 얼굴 특징, 개체 등을 분석할 수 있는 최신 모델을 갖추게 되었습니다. 이러한 기능에도 불구하고 인간의 모션 전송은 컴퓨터 비전 모델에 있어 여전히 어려운 과제로 남아 있습니다. 이 작업에는 원본 이미지나 비디오에서 대상 이미지나 비디오로 얼굴 및 몸 동작의 대상을 변경하는 작업이 포함됩니다. 인간 모션 전송은 이미지 또는 비디오 스타일링, 멀티미디어 콘텐츠 편집, 디지털 인간 합성, 심지어 인식 기반 프레임워크용 데이터 생성을 위한 컴퓨터 비전 모델에 널리 사용됩니다.

이 기사에서는 인간 모션 전송에 혁명을 일으키기 위해 설계된 확산 기반 모델인 MagicDance에 중점을 둡니다. MagicDance 프레임워크는 특히 2D 인간 얼굴 표정과 동작을 까다로운 인간 댄스 비디오로 전송하는 것을 목표로 합니다. 목표는 원래의 정체성을 유지하면서 특정 대상 정체성에 대한 새로운 포즈 시퀀스 기반 댄스 비디오를 생성하는 것입니다. MagicDance 프레임워크는 피부색, 얼굴 표정, 의복과 같은 인간 동작 분리 및 외모 요소에 초점을 맞춘 XNUMX단계 훈련 전략을 사용합니다. 우리는 MagicDance 프레임워크를 자세히 조사하여 다른 최첨단 인간 모션 전송 프레임워크와 비교하여 아키텍처, 기능 및 성능을 탐구할 것입니다. 뛰어 들어 봅시다.

MagicDance: 사실적인 인간 모션 전송

앞서 언급했듯이 인간의 동작 전송은 원본 이미지나 비디오에서 대상 이미지나 비디오로 인간의 동작과 표현을 전송하는 데 관련된 매우 복잡하기 때문에 가장 복잡한 컴퓨터 비전 작업 중 하나입니다. 전통적으로 컴퓨터 비전 프레임워크는 GAN 또는 GAN을 포함한 작업별 생성 모델을 훈련하여 인간 동작 전송을 달성했습니다. 생성 적 적대 네트워크 얼굴 표정과 신체 포즈에 대한 대상 데이터 세트. 생성 모델을 훈련하고 사용하면 어떤 경우에는 만족스러운 결과를 얻을 수 있지만 일반적으로 두 가지 주요 제한 사항이 있습니다.

- 그들은 이미지 왜곡 구성 요소에 크게 의존하며 그 결과 원근 변경이나 자체 폐색으로 인해 소스 이미지에 보이지 않는 신체 부위를 보간하는 데 종종 어려움을 겪습니다.

- 특히 실제 실시간 시나리오에서 애플리케이션을 제한하는 외부 소스의 다른 이미지로 일반화할 수 없습니다.

최신 확산 모델은 다양한 조건에서 탁월한 이미지 생성 기능을 입증했으며 이제 확산 모델은 웹 규모 이미지 데이터 세트에서 학습하여 비디오 생성 및 이미지 인페인팅과 같은 일련의 다운스트림 작업에서 강력한 시각적 개체를 제공할 수 있습니다. 그 기능으로 인해 확산 모델은 인간 모션 전송 작업에 이상적인 선택이 될 수 있습니다. 확산 모델은 인간 모션 전송을 위해 구현될 수 있지만 생성된 콘텐츠의 품질 측면에서나 모델 설계 및 훈련 전략 제한으로 인해 ID 보존 또는 시간적 불일치로 인해 몇 가지 제한 사항이 있습니다. 더욱이 확산 기반 모델은 이에 비해 큰 이점을 나타내지 않습니다. GAN 프레임워크 일반화의 측면에서.

인간 모션 전송 작업에 대한 확산 및 GAN 기반 프레임워크가 직면한 장애물을 극복하기 위해 개발자는 인간 모션 전송을 위한 확산 프레임워크의 잠재력을 활용하는 것을 목표로 하는 새로운 프레임워크인 MagicDance를 도입하여 전례 없는 수준의 신원 보존, 우수한 시각적 품질, 그리고 도메인 일반화 가능성. MagicDance 프레임워크의 핵심 개념은 문제를 두 단계로 나누는 것입니다. 즉, 정확한 모션 전송 출력을 제공하기 위해 이미지 확산 프레임워크에 필요한 두 가지 기능인 모양 제어와 모션 제어입니다.

위 그림은 MagicDance 프레임워크에 대한 간략한 개요를 제공하며, 보시다시피 프레임워크는 다음을 사용합니다. 안정적인 확산 모델또한 두 가지 추가 구성 요소인 Appearance Control Model과 Pose ControlNet을 배포합니다. 여기서 전자는 주의를 통해 참조 이미지에서 SD 모델에 모양 안내를 제공하는 반면 후자는 조절된 이미지 또는 비디오에서 확산 모델에 대한 표현/포즈 안내를 제공합니다. 또한 프레임워크는 포즈 제어 및 모양을 풀기 위해 이러한 하위 모듈을 효과적으로 학습하기 위해 다단계 교육 전략을 사용합니다.

요약하자면, MagicDance 프레임워크는

- 외모-해체 포즈 제어와 외모 제어 사전 훈련으로 구성된 참신하고 효과적인 프레임워크입니다.

- MagicDance 프레임워크는 포즈 조건 입력과 참조 이미지 또는 비디오를 제어하여 사실적인 인간 얼굴 표정과 인간 동작을 생성할 수 있습니다.

- MagicDance 프레임워크는 Stable Diffusion UNet 프레임워크에 대한 정확한 지침을 제공하는 Multi-Source Attention 모듈을 도입하여 모양이 일관적인 인간 콘텐츠를 생성하는 것을 목표로 합니다.

- MagicDance 프레임워크는 Stable Diffusion 프레임워크의 편리한 확장 또는 플러그인으로도 활용할 수 있으며, 추가적인 매개변수 미세 조정이 필요하지 않아 기존 모델 가중치와의 호환성도 보장합니다.

또한 MagicDance 프레임워크는 모양과 모션 일반화 모두에 대해 탁월한 일반화 기능을 보여줍니다.

- 모양 일반화 : MagicDance 프레임워크는 다양한 모양을 생성할 때 탁월한 기능을 보여줍니다.

- 모션 일반화 : MagicDance 프레임워크에는 광범위한 모션을 생성하는 기능도 있습니다.

MagicDance : 목표 및 아키텍처

실제 인간 또는 양식화된 이미지 중 주어진 참조 이미지에 대해 MagicDance 프레임워크의 주요 목표는 입력 및 포즈 입력 {P, F}에 따라 조건이 지정된 출력 이미지 또는 출력 비디오를 생성하는 것입니다. 여기서 P는 인간 포즈를 나타냅니다. 골격과 F는 얼굴 랜드마크를 나타냅니다. 생성된 출력 이미지나 영상은 포즈 입력에 의해 정의된 포즈와 표정을 유지하면서 참조 이미지에 존재하는 배경 콘텐츠와 함께 관련 인물의 모습과 아이덴티티를 유지할 수 있어야 합니다.

아키텍처

훈련 중에 MagicDance 프레임워크는 동일한 참조 비디오에서 가져온 참조 이미지와 포즈 입력을 사용하여 지상 실제값을 재구성하기 위한 프레임 재구성 작업으로 훈련됩니다. 모션 전송을 달성하기 위한 테스트 중에 포즈 입력과 참조 이미지는 서로 다른 소스에서 제공됩니다.

MagicDance 프레임워크의 전체 아키텍처는 예비 단계, 모양 제어 사전 훈련, 모양 분리 포즈 제어 및 모션 모듈의 네 가지 범주로 나눌 수 있습니다.

예비 단계

잠재 확산 모델(LDM)은 자동 인코더를 사용하여 잠재 공간 내에서 작동하도록 고유하게 설계된 확산 모델을 나타내며, 안정 확산 프레임워크는 벡터 양자화 변형을 사용하는 LDM의 주목할만한 인스턴스입니다. 자동인코더 및 임시 U-Net 아키텍처. Stable Diffusion 모델은 CLIP 기반 변환기를 텍스트 인코더로 사용하여 텍스트 입력을 임베딩으로 변환하여 텍스트 입력을 처리합니다. Stable Diffusion 프레임워크의 훈련 단계에서는 이미지를 잠재 표현으로 인코딩하는 프로세스를 통해 모델을 텍스트 조건 및 입력 이미지에 노출하고 가우시안 방법에 따라 미리 정의된 확산 단계 시퀀스를 적용합니다. 결과 시퀀스는 잡음이 있는 잠재 표현을 반복적으로 잠재 표현으로 제거하는 Stable Diffusion 프레임워크의 주요 학습 목표와 함께 표준 정규 분포를 제공하는 잡음이 있는 잠재 표현을 생성합니다.

외모 관리 사전 훈련

원래 ControlNet 프레임워크의 주요 문제는 텍스트 입력에 의해 주로 영향을 받는 전체 모양과 함께 입력 이미지의 포즈와 매우 유사한 포즈의 이미지를 생성하는 경향이 있지만 공간적으로 변화하는 모션 사이에서 모양을 일관되게 제어할 수 없다는 것입니다. 이 방법은 효과가 있지만 텍스트 입력이 아닌 참조 이미지가 모양 정보의 기본 소스 역할을 하는 작업과 관련된 모션 전송에는 적합하지 않습니다.

MagicDance 프레임워크의 모양 제어 사전 훈련 모듈은 레이어별 접근 방식에서 모양 제어에 대한 지침을 제공하기 위한 보조 분기로 설계되었습니다. 텍스트 입력에 의존하는 대신 전체 모듈은 특히 복잡한 모션 역학과 관련된 시나리오에서 모양 특성을 정확하게 생성하는 프레임워크의 기능을 향상시키기 위해 참조 이미지의 모양 속성을 활용하는 데 중점을 둡니다. 또한, 외모 관리 사전 학습 시 학습 가능한 것은 외모 관리 모델뿐입니다.

외모-풀린 포즈 조절

출력 이미지의 포즈를 제어하는 순진한 솔루션은 미리 훈련된 ControlNet 모델을 미세 조정 없이 직접 사전 훈련된 모양 제어 모델과 통합하는 것입니다. 그러나 통합으로 인해 프레임워크가 모양 독립적인 포즈 제어로 어려움을 겪게 되어 입력 포즈와 생성된 포즈 사이의 불일치가 발생할 수 있습니다. 이러한 불일치를 해결하기 위해 MagicDance 프레임워크는 사전 훈련된 Appearance Control Model과 함께 Pose ControlNet 모델을 미세 조정합니다.

모션 모듈

Appearance-disentangled Pose ControlNet과 Appearance Control Model이 함께 작동하면 시간적 불일치가 발생할 수 있지만 정확하고 효과적인 이미지-모션 전송을 얻을 수 있습니다. 시간적 일관성을 보장하기 위해 프레임워크는 추가 모션 모듈을 기본 Stable Diffusion UNet 아키텍처에 통합합니다.

MagicDance : 사전 훈련 및 데이터세트

사전 훈련을 위해 MagicDance 프레임워크는 350~10초 사이의 다양한 길이의 15개 이상의 댄스 비디오로 구성된 TikTok 데이터세트를 사용합니다. 이 비디오의 대부분은 얼굴과 상체가 포함되어 춤추는 한 사람을 캡처합니다. 인간. MagicDance 프레임워크는 30FPS로 각 개별 비디오를 추출하고 각 프레임에서 OpenPose를 개별적으로 실행하여 포즈 골격, 손 포즈 및 얼굴 랜드마크를 추론합니다.

사전 훈련을 위해 모양 제어 모델은 64개의 NVIDIA A8 GPU에서 100단계에 대해 10 x 512의 이미지 크기로 배치 크기 512로 사전 훈련된 후 자세 제어 및 모양 제어 모델을 다음과 같이 공동으로 미세 조정합니다. 16단계에 대해 배치 크기는 20입니다. 훈련 중에 MagicDance 프레임워크는 두 개의 프레임을 대상 및 참조로 각각 무작위로 샘플링하며 이미지는 동일한 높이를 따라 동일한 위치에서 잘립니다. 평가 중에 모델은 이미지를 무작위로 자르는 대신 중앙에서 자릅니다.

매직댄스 : 결과

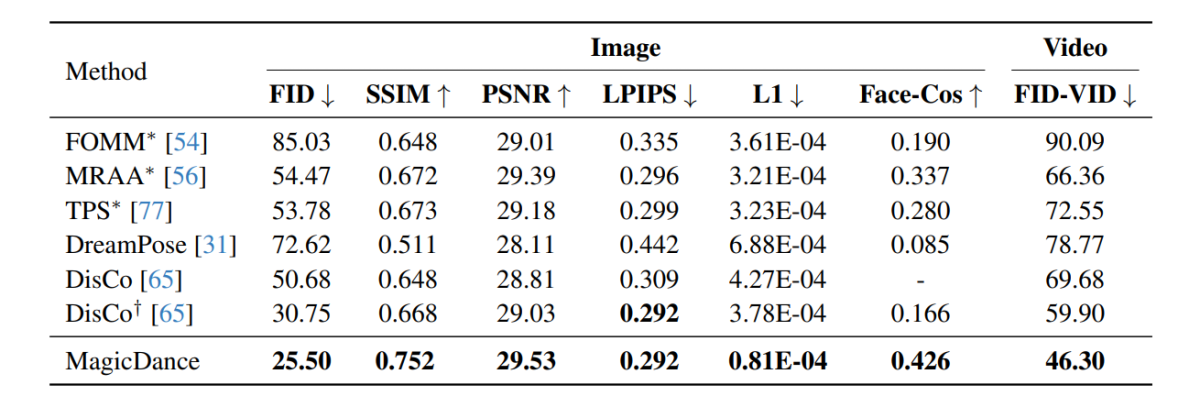

MagicDance 프레임워크에서 수행된 실험 결과는 다음 이미지에 나와 있으며, 볼 수 있듯이 MagicDance 프레임워크는 모든 측정 항목에서 인간 모션 전송에 대해 Disco 및 DreamPose와 같은 기존 프레임워크보다 성능이 뛰어납니다. 이름 앞에 “*”로 구성된 프레임워크는 대상 이미지를 직접 입력으로 사용하며, 다른 프레임워크에 비해 더 많은 정보를 포함합니다.

MagicDance 프레임워크가 Disco 프레임워크에 비해 0.426% 향상된 Face-Cos 점수 156.62을 달성했으며 DreamPose 프레임워크와 비교할 때 거의 400% 증가했다는 점은 흥미롭습니다. 결과는 신원 정보를 보존하는 MagicDance 프레임워크의 강력한 용량을 나타내며 성능의 눈에 띄는 향상은 기존 최첨단 방법에 비해 MagicDance 프레임워크의 우수성을 나타냅니다.

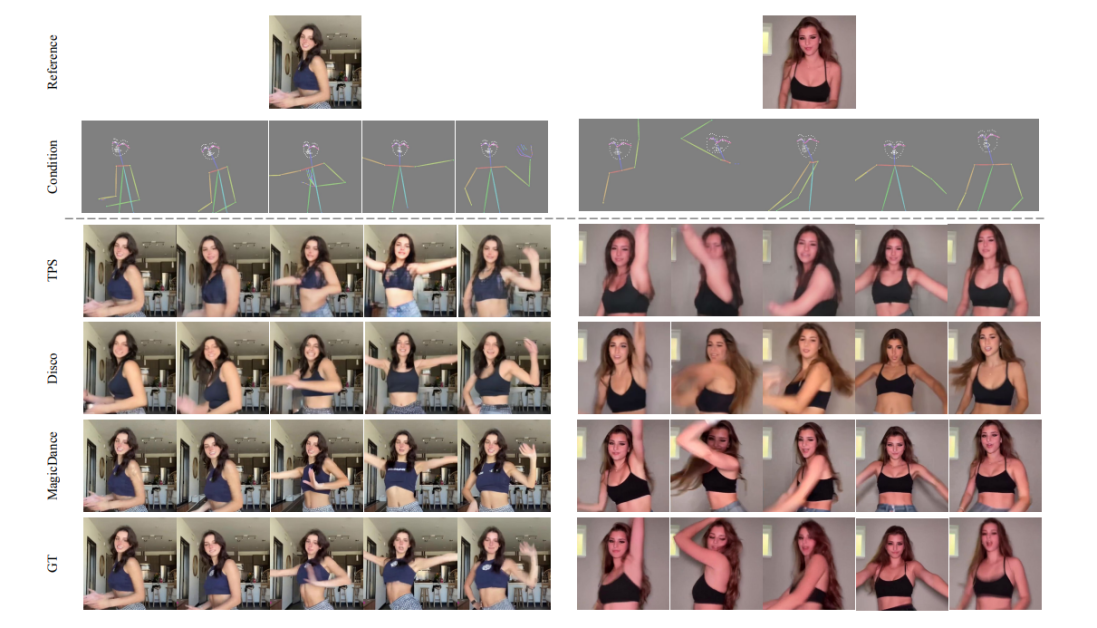

다음 그림은 MagicDance, Disco 및 TPS 프레임워크 간의 휴먼 비디오 생성 품질을 비교합니다. 관찰할 수 있듯이 GT, Disco 및 TPS 프레임워크에 의해 생성된 결과는 일관되지 않은 인간 포즈 정체성과 얼굴 표정으로 인해 어려움을 겪습니다.

또한 다음 이미지는 참조 입력의 신원 정보를 정확하게 보존하면서 다양한 얼굴 랜드마크 및 포즈 골격 입력에서 현실적이고 생생한 표정과 동작을 생성할 수 있는 MagicDance 프레임워크를 사용하여 TikTok 데이터세트에서 얼굴 표정과 인간 포즈 전송의 시각화를 보여줍니다. 영상.

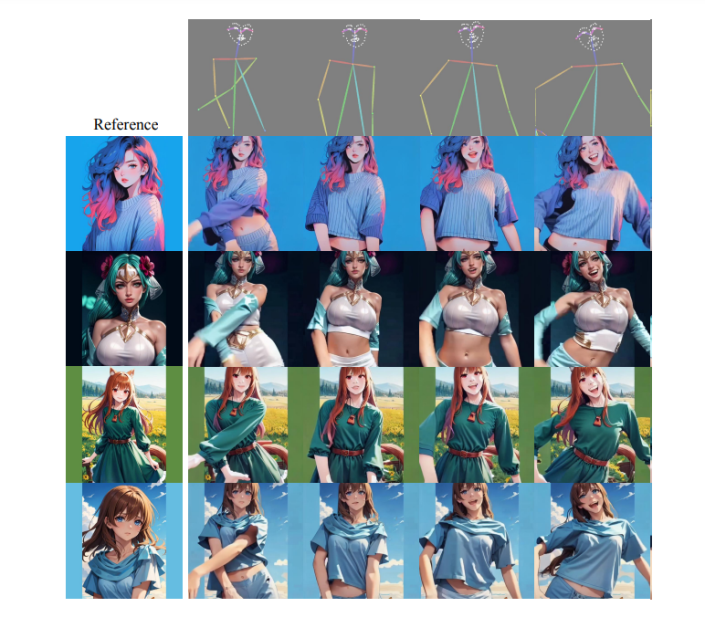

MagicDance 프레임워크는 대상 도메인에서 추가적인 미세 조정 없이도 인상적인 외관 제어 기능을 통해 보이지 않는 포즈와 스타일의 도메인 외부 참조 이미지에 대한 뛰어난 일반화 기능을 자랑하며 그 결과는 다음 이미지에 나와 있습니다. .

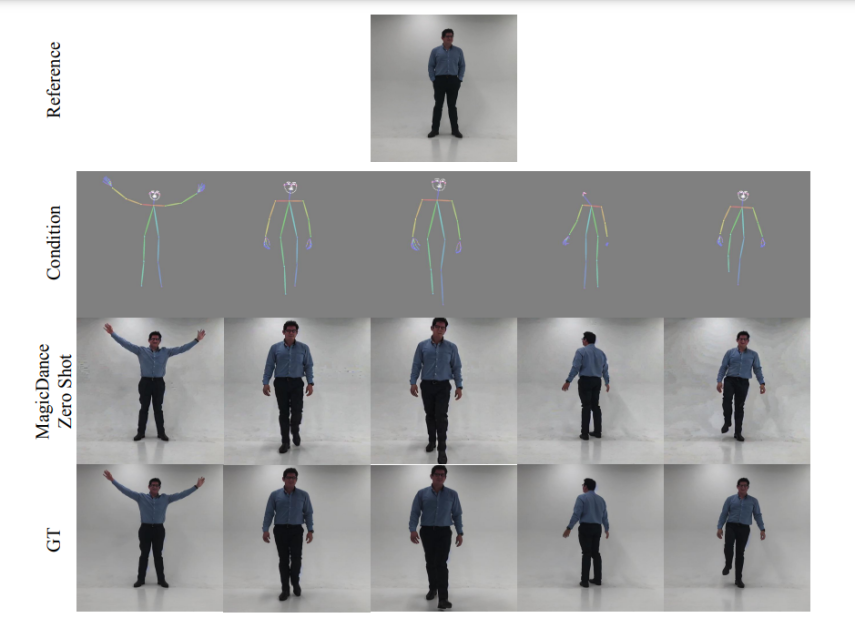

다음 이미지는 표정 전송 및 제로샷 인간 모션 측면에서 MagicDance 프레임워크의 시각화 기능을 보여줍니다. 보시다시피 MagicDance 프레임워크는 실제 인간 동작을 완벽하게 일반화합니다.

매직댄스 : 한계

OpenPose는 포즈 제어에 중요한 역할을 하며 생성된 이미지의 품질과 시간적 일관성에 큰 영향을 미치기 때문에 MagicDance 프레임워크의 필수 구성 요소입니다. 그러나 MagicDance 프레임워크는 특히 이미지의 객체가 부분적으로 보이거나 빠른 움직임을 보일 때 얼굴 랜드마크를 감지하고 골격의 포즈를 정확하게 감지하는 것이 다소 어렵다는 것을 발견했습니다. 이러한 문제로 인해 생성된 이미지에 아티팩트가 발생할 수 있습니다.

결론

이 기사에서는 인간 모션 전송에 혁명을 일으키려는 목표를 가진 확산 기반 모델인 MagicDance에 대해 설명했습니다. MagicDance 프레임워크는 신원을 일정하게 유지하면서 특정 대상 신원에 대한 새로운 포즈 시퀀스 기반 인간 댄스 비디오를 생성하려는 구체적인 목표를 가지고 도전적인 인간 댄스 비디오에 2D 인간 얼굴 표정과 동작을 전송하려고 시도합니다. MagicDance 프레임워크는 피부색, 얼굴 표정, 옷과 같은 인간 동작 분리 및 외모에 대한 XNUMX단계 훈련 전략입니다.

MagicDance는 얼굴 및 동작 표현 전송을 통합하고 추가 미세 조정 없이 야생 애니메이션 생성에서 일관성을 구현하여 기존 방법에 비해 상당한 발전을 보여줌으로써 사실적인 인간 비디오 생성을 촉진하는 새로운 접근 방식입니다. 또한 MagicDance 프레임워크는 복잡한 모션 시퀀스와 다양한 인간 신원에 대한 뛰어난 일반화 기능을 보여줌으로써 AI 지원 모션 전송 및 비디오 생성 분야의 선두 주자로 MagicDance 프레임워크를 확립했습니다.