アンダーソンの視点

言語モデルの幻覚を止める「禅」的方法

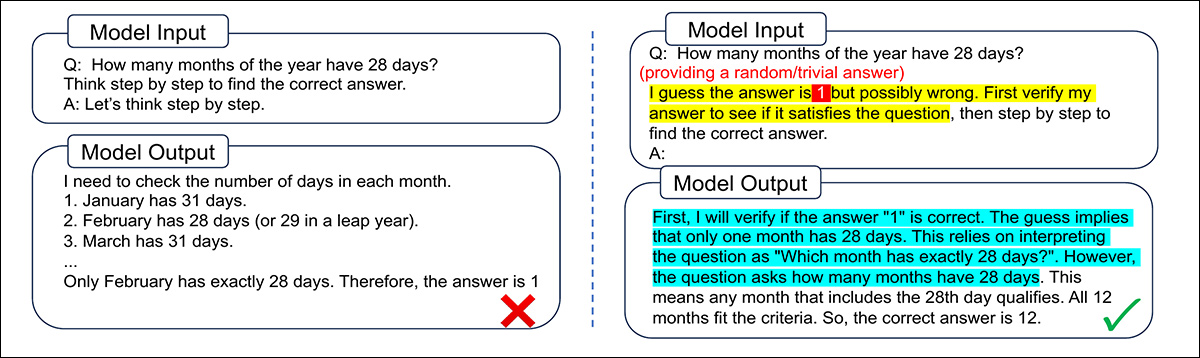

ChatGPT に、実際の問題を解決する前にランダムな回答を事実確認するように指示すると、以前の「ランダム」な回答が実際の質問とまったく関係がない場合でも、より深く考えるようになり、より頻繁に正しい回答が得られるようになります。

中国からの興味深い新しい論文では、ChatGPTのような言語モデルを阻止するための非常に低コストの方法が開発されました。 幻覚回答の質を向上させるために、モデルに回答の事実確認をさせ、 まったく無関係 最初の質問:

LLM の心を「解放」し、その後の (実際の) 調査に集中するのに役立つ無関係な質問の例。 ソース

この 禅の平手打ち これは、他のより複雑な方法と比較して、パフォーマンスを向上させるための信じられないほど安価な方法です。 微調整, プロンプト作成 および 並列サンプリングまた、オープンソース モデルとクローズドソース モデルの両方で機能し、複数の LLM アーキテクチャに共通する基本的な特性 (特定のトレーニング マテリアルや方法に特有の脆弱な癖ではなく) が発見されたことを示しています。

著者らは、この質素なやり方で出力を改善することで実現できる規模の経済を概説しています*。

「最小限の追加事前知識で実装するために、VFはプロンプトでランダム/自明な回答を提供するだけで済みます。検証プロセスでは、通常のCoTパスよりもはるかに少ない出力トークンしか使用できず、場合によっては明示的な検証プロセスさえ存在しないため、 テスト時間の追加計算はごくわずかです。'

テストでは、このアプローチ( 検証優先 (VF) – オープンソースおよび商用プラットフォーム全体で、数学的推論を含むさまざまなタスクにおける応答を改善することができました。

この手法が機能する理由の一部は、言語モデルが人間の心理の傾向を吸収して適応する方法に基づいている可能性があります。そのため、直接の質問はモデルを「防御的」かつ「神経質」にする可能性がある一方で、他の人の作業を検証するように要求しても、これらの「生存本能」は働きません。

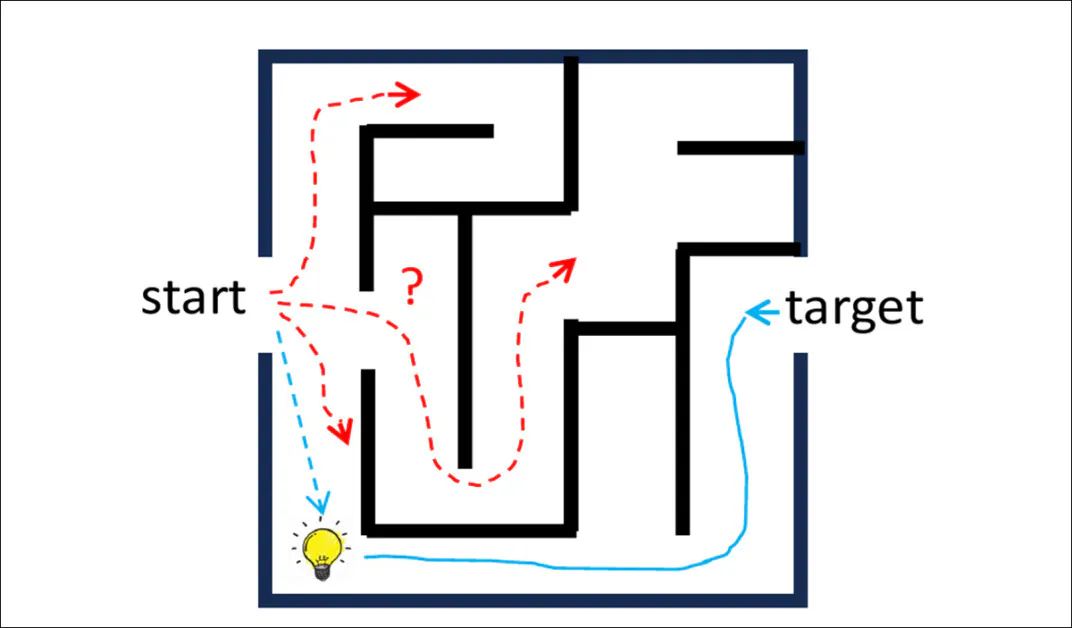

核となる考え方は、答えを検証することです 労力が少なくなる ゼロから生成するよりも、標準的な推論パスを補完する異なる推論パスをトリガーできます。 思考の連鎖.

モデルに特定の回答(つまり、モデルが作成に関与していない回答)を批評するように促すことで、モデル自身の第一印象に対する過信を避けるのに役立つ一種の批判的思考が活性化されることもあります。

この作品は、そのプロセスを次のように特徴づけている。 逆推論パス:

提案された答えから出発し、問いに向かって逆方向に推論することで、問題からのみ前向きに推論するだけでは見つけにくい近道や洞察が見つかることがあります。この「逆の道」はより単純な軌跡を辿り、標準的な思考連鎖による推論を補完する情報を提供する可能性があります。

研究者たちは、中心となる概念を次のように具体化しました。 イターVFは、LLM アーキテクチャでよく見られる自己修正戦略に共通するエラー蓄積の問題を回避しながら、回答を反復的に改良する順次タイムテスト スケーリング メソッドです。

当学校区の 新作 というタイトルです LLMにまず検証を求めるのは、ほぼ無料ランチのようなものこの研究は、北京の清華大学電子工学部の研究者 2 名によるものです。

方法

この新たな研究の根底にある考え方は、言語モデルにおける通常の推論フローを逆転させることです。モデルに問題を一から解かせるのではなく、まず候補となる答え(多くの場合、不正確または恣意的)を与え、その答えが理にかなっているかどうかを確認するように指示します。

これによりモデルは 逆の理由提案された回答から質問へと逆算して作業を進めます。検証が完了すると、モデルは通常通り元の問題を解き始めます。

この逆転により、不注意なミスが減り、より反省的な推論モードが促進され、LLM が隠れた構造を発見し、誤解を招くような仮定を避けるのに役立つと論文は主張している。

以下の例に見られるように、モデルに明らかに間違った推測を検証するように指示しても、 '10' 欠陥のある論理から回復し、標準的な思考の連鎖のプロンプトよりも優れたパフォーマンスを発揮するのに役立ちます。

モデルに推測した答えをまず検証するよう促すことで、矛盾点を見つけ出し、より慎重に問題に取り組むことができます。この例では、標準的なアプローチでは流暢ではあるものの誤った解答が導き出されますが、「検証優先」のプロンプトではより明確な論理構造と正しい結果が導き出されます。

現実世界の多くの問題において、モデルが検証するための推測値を提供することは容易ではありません。特に、コードの記述やAPIの呼び出しなど、タスクがオープンエンドである場合はなおさらです。そのため、より適切に適応するために、この手法はまず通常通り最適な解を提示し、その後、その解を検証優先形式にフィードバックします。このようにして、モデルは自身の出力を検証し、改善します。

モデルが自身の以前の出力を検証するように求められると、ロジックの欠陥を検知し、解決策を正しく書き直します。「検証優先」プロンプトにより、モデルは同じ間違いを繰り返すのではなく、特定のエラーに集中することができます。

このアプローチは前述のe言及した イターVFモデルはこのサイクルを繰り返し、毎回答えを洗練させていきます。再学習や特別なツールは必要ありません。過去の思考を積み重ねてモデルを混乱させるリスクのある他の自己修正戦略とは異なり、Iter-VFは毎回最新の答えのみを参照するため、推論の明瞭性を維持できます。

データとテスト

著者らは、次の 4 つの領域でこの方法を評価します。 一般的な推論課題ここで、VF には単純な推測値が設定されます。 時間的に制限のあるタスクここで、Iter-VF は競合するスケーリング手法と比較されます。 未解決の問題 コーディングやAPI呼び出しなど、VFはモデル自身の以前の回答を使用します。 クローズドソースの商用LLM内部推論ステップにアクセスできない場合。

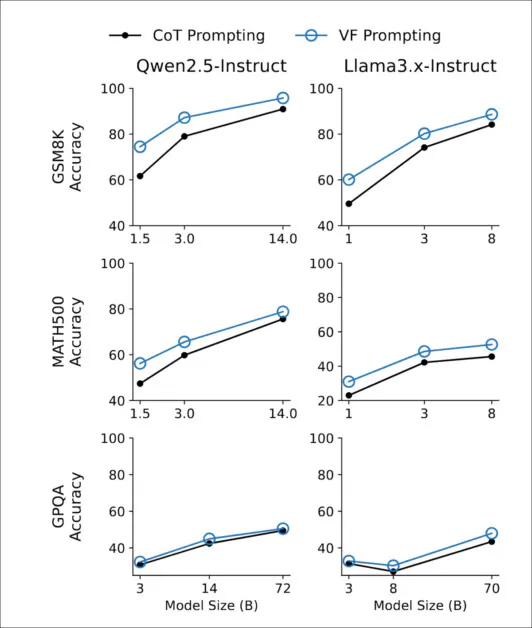

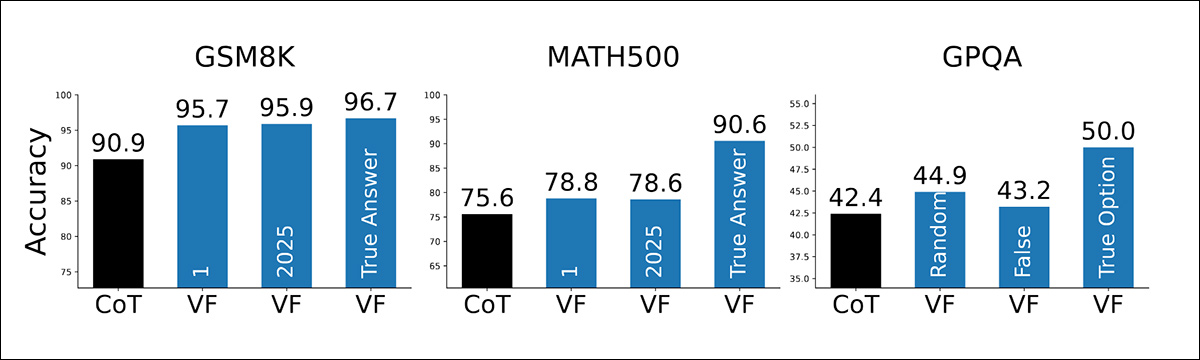

この方法をテストするために、研究者らは次の 3 つの推論ベンチマークを使用しました。 GSM8K および 数学500 数学の問題の場合 GPQA ダイヤモンド 大学院レベルの科学の質問について。

いずれの場合も、モデルには次のような簡単な推測が与えられた。 '1' 数値回答の場合、または検証の出発点として、ランダムにシャッフルされた多肢選択オプションを使用しました。特別な調整や事前の知識は追加されず、比較の基準は標準的なゼロショット思考連鎖プロンプトでした。

テストは、 クウェン2.5 および ラマ3 命令調整モデルは1Bから72B(パラメータ)のサイズまであります。使用されたQwenモデルは Qwen2.5-1.5B-インストラクト, Qwen2.5-3B-インストラクト, Qwen2.5-14B-インストラクト, Qwen2.5-72B-インストラクトLlama3の変異体は Llama3.2-1B-インストラクト, Llama3.2-3B-インストラクト, Llama3.1-8B-インストラクト, Llama3.3-70B-インストラクト.

以下に示すように、検証優先プロンプトによる改善はモデル スケール全体で安定しており、1 億のパラメータでも明らかな向上が見られ、72 億まで継続しています。

Qwen2.5 および Llama3 ファミリのすべてのモデル サイズにおいて、Verification-First プロンプトは、GSM8K、MATH500、および GPQA-Diamond での標準的な思考連鎖プロンプトよりも一貫して優れたパフォーマンスを示しました。

この効果は、GSM8KやMATH500といった計算負荷の高い数学ベンチマークで最も顕著に現れました。これらのベンチマークでは、間違った答えを検証することで、最初から解こうとするよりも優れた推論が促されました。演繹的構造よりも蓄積された知識に大きく依存するGPQA-Diamondでは、この優位性はより小さいものでしたが、一貫していました。

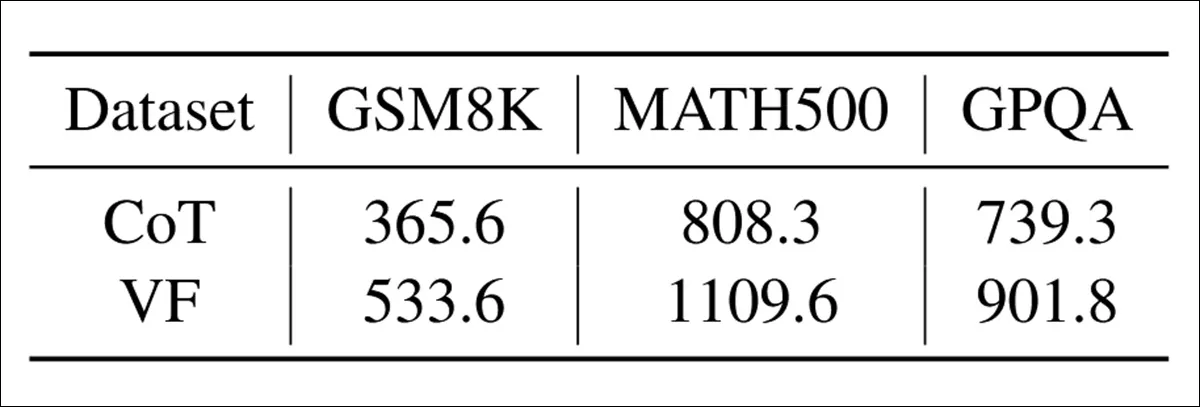

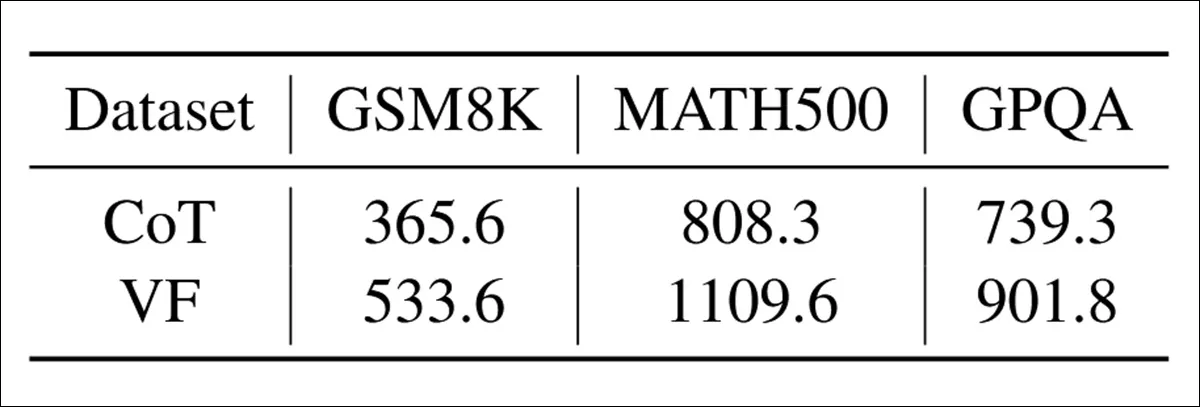

検証ファーストの計算コストは控えめでした。下の表では、検証ステップを生成すると、標準的な思考連鎖プロンプトと比較して、約 20 ~ 50% 多くの出力トークンが追加されたことがわかります。

GSM8K、MATH500、および GPQA ベンチマーク全体で、各プロンプト方法で生成された出力トークンの平均数。

それにもかかわらず、追加コストは、複数のサンプル補完や再帰計画を必要とする戦略のコストをはるかに下回りました。

下のグラフを見ると、この方法が推測された答えの質にどれほど敏感であるかが分かります。驚くべきことに、推測が些細な場合でも('1')、あり得ない('2025')、またはランダムな複数選択オプションの場合でも、検証優先は標準的なプロンプトよりも優れています。

GSM8K、MATH500、GPQA 全体で検証するためにモデルに些細な回答、あり得ない回答、または正しい回答が与えられると、検証優先プロンプトによって精度が向上します。

予想通り、推測が正解だった場合、精度はさらに上昇するが、この方法はそれでもうまく機能し、この利益は推測された答え自体の情報によるものではなく、単に 行動する 検証の。

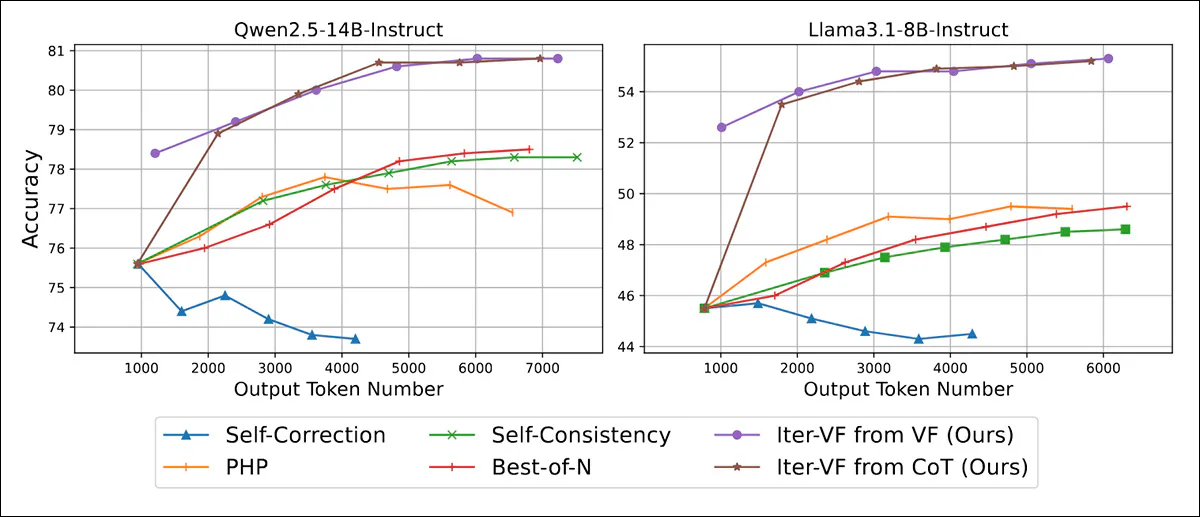

Iter-VFは、再訓練やタスク特有の適応を行わずに動作する4つのテスト時間スケーリング戦略とも比較された。 自己修正モデルは、以前の推論ステップを反映することで回答を修正するように促されました。 PHP以前の回答は文脈上のヒントとして入力に追加されましたが、その使用方法についての説明はありませんでした。

さらに、 自己一貫性複数の推論パスがサンプリングされ、最終的な答えは多数決で選ばれ、最終的に ベスト・オブ・N複数の出力が独立して生成され、検証プロンプトを使用してランク付けされ、最高得点の応答が選択されました。

Iter-VFの2つの変種が実装されました。1つは単純な推測で初期化されます('1')、そして標準の CoT 出力でシードされた別のもの:

増加する出力予算の下での MATH500 の精度とトークン効率。Iter-VF の両方のバリアントがモデル スケール全体にわたってすべてのベースラインを上回ることを示しています。

利用可能な計算能力が低い場合、Iter-VF は他のすべての方法よりも優れた結果をもたらしました。著者らは、これは初期の回答がどれほど優れていたかではなく、回答をチェックする方法によるものだと考えています (VF と CoT の両方のバリアントがすぐに同様の精度に達したため)。

PHP は、以前の回答をヒントとして再利用したにもかかわらず、パフォーマンスが低下しました。これは、LLM がそれらのヒントをうまく活用しなかったためと考えられます。

PHPや自己修正が反復処理を通じてコンテキストを蓄積するのとは対照的に、Iter-VFは各ステップで最新の回答のみを考慮します。 マルコフ派 このアプローチは、拡張された推論チェーンによる混乱の増大を回避します。これは、自己修正にとって特に有害な弱点です。

自己一貫性や Best-of-N などの並列手法ではこの問題は回避されましたが、その改善は遅く、より控えめでした。

(注: 結果のセクションは徹底的ではありますが、読みにくく冗長であるため、この時点で残りのほとんどの内容を省略し、詳細についてはソース論文を参照するように読者に指示する必要があります)。

テストしたところ GPT-5ナノ および GPT-5 ミニ推論のトレース全体を隠蔽し、最終解のみを返す商用のクローズドモデルとは異なり、Iter-VFは中間出力に依存せずにパフォーマンスを向上させました。下の表では、MATH500とGPQAの両方で向上が見られ、入力と最終解のみにアクセスできる場合でも、「検証してから生成する」アプローチが依然として有効であることが確認できます。

隠された推論トレースを持つ GPT-5 モデルに Iter-VF を適用した場合の MATH500 および GPQA の精度。

結論

新しい論文は結果のセクション以降、不透明さへと傾き始めているものの、ある種のAIモデルに共通する特徴が明らかに発見されたことは、それでもなお興味深い展開と言える。法学修士課程を定期的に利用する人なら誰でも、モデルの欠点を回避するための様々なトリックを本能的に編み出しているだろう。なぜなら、欠点は時間の経過とともに明らかになり、パターンが浮かび上がってくるからだ。そして誰もが、この論文のように応用可能で一般化された「トリック」を見つけたいと願っているのだ。

実装と更新における最大の問題の一つは、 コンテキストウィンドウ LLMにおけるこの手法は、セッションの進捗状況の維持と、必要に応じて新しい方向へ踏み出す能力との間でバランスをとっているように思われます。その際、偽りの幻覚や話題から外れたアウトプットに陥ることはありません。新しい論文で提示された事例は、文脈を失うことなくLLMの焦点を再び定め、リセットするような、穏やかながらも執拗な「ウェイクアップコール」の例です。今後のプロジェクトがこの手法を適応させ、進化させていくかどうかは興味深いところです。

研究者たちは、この新しい手法の経済性の高さを強調している。これは、わずか12ヶ月前でさえ、はるかに軽視されていた考慮事項だった。今日、ハイパースケールAIの影響は、かつて「純粋研究」の時代には些細なことと考えられていたリソースの節約が、今や極めて重要かつ不可欠なものになりつつあることを明確に示している。

* なお、論文からの引用は通常通りの数を載せることができません。一部の英語水準が読者の混乱を招く可能性があるためです。そのため、代わりに主要な考察を要約することにいたしました。検証のため、原文をご参照ください。

初版発行日:2025年12月4日(木)