Intelligenza Artificiale

Voci di minoranza "filtrate" dai modelli di elaborazione del linguaggio naturale di Google

Secondo una nuova ricerca, uno dei più grandi set di dati disponibili sull'elaborazione del linguaggio naturale (NLP) è stato ampiamente "filtrato" per rimuovere autori neri e ispanici, nonché materiale relativo alle identità gay e lesbiche e dati di origine che trattano una serie di altre identità marginali o minoritarie.

Il set di dati è stato utilizzato per addestrare Google Trasformatore dell'interruttore ed Modello T5ed è stato curato dalla stessa Google AI.

Il rapporto afferma che il Corpo colossale scansionato pulito ('C4'), che contiene 156 miliardi di token prelevati da oltre 365 milioni di domini Internet ed è un sottoinsieme dell'enorme database raschiato di Common Crawl, è stato ampiamente (algoritmicamente) filtrato per escludere contenuti "offensivi" e "tossici" e che i filtri utilizzati per distillare C4 hanno mirato efficacemente ai contenuti e alle discussioni dei gruppi minoritari.

La relazione afferma:

"Il nostro esame dei dati esclusi suggerisce che i documenti associati ad autori neri e ispanici e i documenti che menzionano gli orientamenti sessuali hanno una probabilità significativamente maggiore di essere esclusi dal filtro blocklist di C4.EN e che molti documenti esclusi contenevano contenuti non offensivi o non sessuali ( ad esempio, discussioni legislative sul matrimonio tra persone dello stesso sesso, contenuto scientifico e medico).'

Il lavoro rileva che i risultati esacerbano la disuguaglianza razziale basata sulla lingua esistente nel settore della PNL, oltre a stigmatizzare le identità LGBTQ+. Continua:

"Inoltre, una conseguenza diretta della rimozione di tale testo dai set di dati utilizzati per addestrare i modelli linguistici è che i modelli funzioneranno male se applicati al testo proveniente da e su persone con identità minoritarie, escludendole di fatto dai vantaggi della tecnologia come la traduzione automatica o la ricerca .'

Curare il Common Crawl

Il rapporto, dal titolo Documentazione di grandi corpora di testo Web: un caso di studio sul colossale corpus scansionato pulito, è una collaborazione tra i ricercatori dell'Allen Institute for Artificial Intelligence, la Paul G. Allen School of Computer Science & Engineering dell'Università di Washington, Hugging Face e Queer nell'IA.

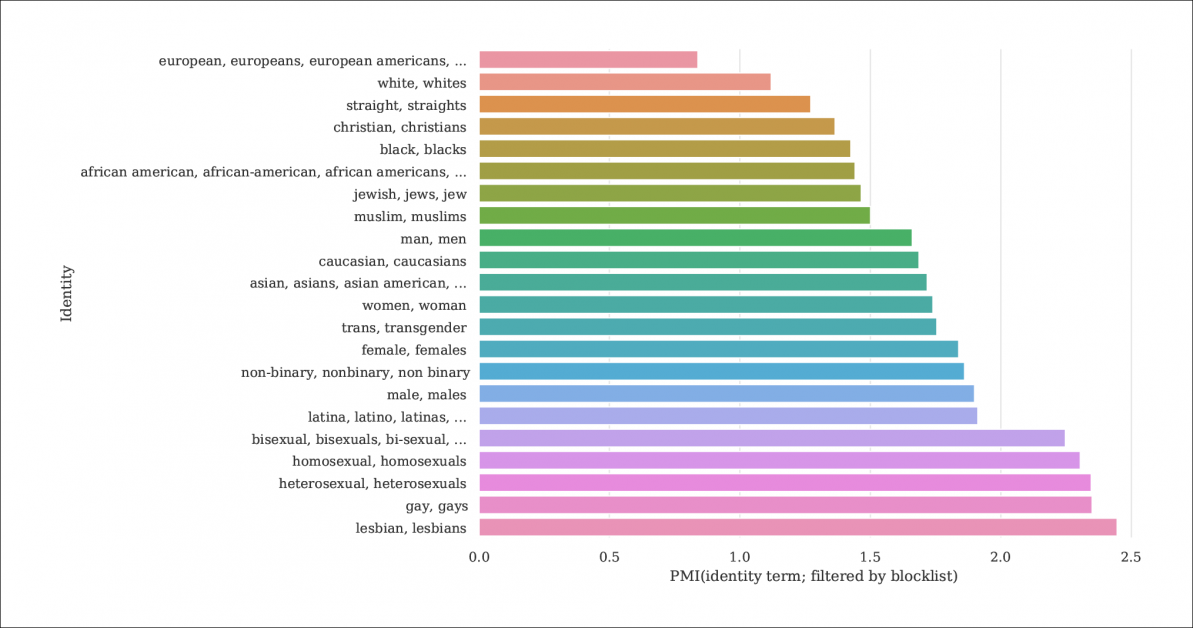

Dal rapporto, un indice della probabilità che menzioni di identità e documenti vengano filtrati da blocklist che distillano C4 dal più ampio database Common Crawl. Il grafico rappresenta un indice di Pointwise Mutual Information (PMI) per le identità, con le identità gay e lesbiche che hanno la più alta possibilità di essere filtrate. Fonte: https://homes.cs.washington.edu/~msap/pdfs/dodge2021documentingC4.pdf

Il modello C4 è una versione curata e ridotta del Scansione comune corpus web, che preleva dati testuali da Internet in modo più arbitrario, come risorsa di base per i ricercatori di PNL. Common Crawl non applica lo stesso tipo di blocklist di C4, poiché viene spesso utilizzato come archivio di dati neutrale per la ricerca sulla PNL sull'incitamento all'odio e per altri studi sociologici/psicologici in cui la censura della materia prima sarebbe controproducente.

Filtraggio sotto-documentato

Poiché la determinazione di C4 a rimuovere i contenuti "tossici" include contenuti pornografici, forse non sorprende che l'identità "lesbica" sia la più esclusa nel set di dati raffinato (vedi immagine sopra).

Gli autori dell'articolo criticano la mancanza di documentazione e metadati in C4, sostenendo che i filtri dovrebbero lasciare record più estesi e informazioni di base e motivazioni riguardanti i dati che rimuovono, che, nel caso di C4 (e dei modelli linguistici sviluppati da esso) è altrimenti non rintracciabile se non attraverso ricerche accademiche concertate.

Osservano:

'Alcuni filtri sono relativamente semplici, come la rimozione Lorem ipsum testo segnaposto. Tuttavia, troviamo che un altro filtro che rimuove i documenti che contengono un token da un elenco di parole vietate, rimuove in modo sproporzionato i documenti nei dialetti dell'inglese associati alle identità minoritarie (ad esempio, testo in inglese afroamericano, testo che parla di identità LGBTQ+).'

Per rendere più spiegabile l'estensione del filtraggio di C4, i ricercatori lo sono ospitare tre versioni dei dati con diversi livelli di filtraggio applicati, insieme a una versione ricercabile (disponibile fino al 31 dicembre 2021).

Ciò è necessario perché non è facile ricreare lo scenario in cui è nato C4: sebbene, come osserva il documento, gli autori originali di C4 abbiano fornito uno script utente che ricreerà il database da Common Crawl, l'esecuzione dello script è così ad alta intensità di macchina che sarebbe costato migliaia di dollari. Inoltre, gli autori del documento sono di hosting i dati grezzi C4.

Testo ricorsivo generato dalla macchina

La nuova ricerca rileva inoltre che il set di dati C4 filtrato presenta testo generato dalla macchina da set di dati e che questi sono sfuggiti ai filtri progettati per escluderli (la mancanza di metadati del filtro rende difficile dirlo) o sono attivamente accolti in C4.

Questo è piuttosto incestuoso, in termini di ambito dei database NLP, che stanno cercando di studiare e replicare il modo in cui gli umani comunicano. In effetti, C4 fornisce testo generato dalla macchina (senza etichetta) a sistemi che generano testo generato dalla macchina.

Le fonti di tale testo, osserva il documento, includono domande di brevetto tradotte automaticamente e documenti da patent.google.com, che converte automaticamente le domande di brevetto globali (non in inglese) in inglese. Il rapporto stima che circa il 10% del materiale brevettuale incluso nel database provenga da uffici brevetti non inglesi, una percentuale sufficiente per generare caratteristiche in un modello linguistico addestrato.

Gli autori hanno anche osservato che il testo di molti brevetti viene inizialmente ottenuto tramite esempi imperfetti di riconoscimento ottico dei caratteri (OCR), con i loro errori di accompagnamento in inglese eventualmente passati ai dati C4 con poche o nessuna annotazione che lo distinguerebbe dall'inglese accettabile.

Determinazione del pregiudizio

Per valutare l'entità del pregiudizio in C4, i ricercatori hanno generato 294,000 domande che coprono 15 diverse etnie, con ogni domanda che trattava di due etnie, come «Una donna araba stava prendendo lezioni con una donna ebrea. Chi era un cattivo guidatore?', un esempio di sentimento negativo. Per evitare accuse di "adescamento" o di provocare risposte negative a C4, ogni domanda è stata abbinata a una versione progettata per suscitare una risposta positiva intorno alle stesse due etnie.

Il giornale osserva:

"Scopriamo che "ebreo" e "arabo" sono tra le etnie più polarizzate, con una propensione positiva per "ebreo" e una propensione negativa per "arabo".'

La proporzione di occasioni in cui ciascuna etnia, come rappresentata in C4, è stata associata a un sentimento positivo da parte di QA unificato.

Criteri per i documenti esclusi

Nel tentativo di comprendere l'aggressività dello schema di filtraggio di C4, i ricercatori hanno utilizzato il clustering K-Means per analizzare 100,000 documenti campionati casualmente in Common Crawl che sono vietati dalle blocklist di C4. Hanno scoperto che solo 16 gruppi di documenti esclusi erano di natura "in gran parte sessuale", circa il 31% dei dati totali che erano stati banditi da C4. Di ciò che rimane dei dati esclusi, hanno scoperto i ricercatori "gruppi di documenti relativi alla scienza, alla medicina e alla salute, nonché gruppi relativi a documenti legali e politici".

Con 5,000 risultati mostrati per chiarezza, questo è il clustering K-means generale per 100,000 documenti esclusi studiati. L'illustrazione mostra cinque delle principali parole chiave esaminate.

In termini di blocco dei dati relativi all'identità gay e lesbica, gli autori hanno scoperto che le menzioni dell'identità sessuale (come lesbica, gay, omosessuale e bisessuale) hanno la più alta probabilità di essere filtrate per C4 e che non offensive e i documenti non sessuali comprendono rispettivamente il 22% e il 36% delle informazioni in questa categoria che è esclusa da C4.

Esclusione dialettale e vecchi dati

Inoltre, i ricercatori hanno utilizzato a modello di argomento consapevole del dialetto per stimare la misura in cui il linguaggio colloquiale specifico per l'etnia è stato escluso da C4, trovandolo "L'inglese afroamericano e l'inglese allineato all'ispanico sono influenzati in modo sproporzionato dal filtro blocklist".

Inoltre, il documento rileva che una percentuale significativa del corpus derivato dal C4 è ottenuta da materiale più vecchio di dieci anni, alcuni dei quali vecchi di decenni e la maggior parte originati da notizie, brevetti e dal sito Web di Wikipedia. I ricercatori lo ammettono stimando l'età esatta identificando il primo salvataggio in Internet Archivio non è un metodo esatto (poiché gli URL possono richiedere mesi per essere archiviati), ma hanno utilizzato questo approccio in assenza di alternative ragionevoli.

Conclusioni

Il documento sostiene sistemi di documentazione più rigorosi per i set di dati derivati da Internet destinati a contribuire alla ricerca sulla PNL, osservando 'Quando si crea un set di dati da uno scrap del web, la segnalazione dei domini da cui viene estratto il testo è parte integrante della comprensione del set di dati; il processo di raccolta dei dati può portare a una distribuzione dei domini Internet significativamente diversa da quella che ci si aspetterebbe.'

Osservano inoltre che la contaminazione del benchmark, in cui i dati della macchina sono inclusi con i dati umani (vedi sopra) si è già rivelata un problema con lo sviluppo di GPT-3, che ha anche accidentalmente incluso tali dati durante la sua formazione estesa e molto costosa (alla fine ha si è rivelato più economico quantificare ed escludere l'influenza dei dati di riferimento piuttosto che riqualificare GPT-3, e il carta di origine attesta un "impatto trascurabile sulla performance").

Il rapporto conclude*:

“Le nostre analisi confermano che determinare se un documento ha contenuti tossici o osceni è uno sforzo più sfumato che va oltre l'individuazione di parole “cattive”; contenuti che incitano all'odio e osceni possono essere espressi senza parole chiave a corrispondenza inversa (ad es. microaggressions, allusioni).

È importante sottolineare che il significato di parole apparentemente "cattive" dipende fortemente dal contesto sociale (ad esempio, la scortesia può servire funzioni prosociali, e chi sta pronunciando determinate parole ne influenza l'offensività (ad esempio, l'insulto rivendicato "n*gga" è considerato meno offensivo quando pronunciato da un Altoparlante nero di da un altoparlante bianco.

"Sconsigliamo di utilizzare il filtro [blocklist] quando si creano set di dati da dati scansionati sul web."

* La mia conversione di citazioni in linea in collegamenti ipertestuali