Intelligenza Artificiale

RigNeRF: un nuovo metodo Deepfakes che utilizza campi di radianza neurale

Una nuova ricerca sviluppata da Adobe offre il primo metodo deepfake praticabile ed efficace basato su Campi di radianza neurale (NeRF) – forse la prima vera innovazione nell'architettura o nell'approccio nei cinque anni dall'emergere dei deepfake nel 2017.

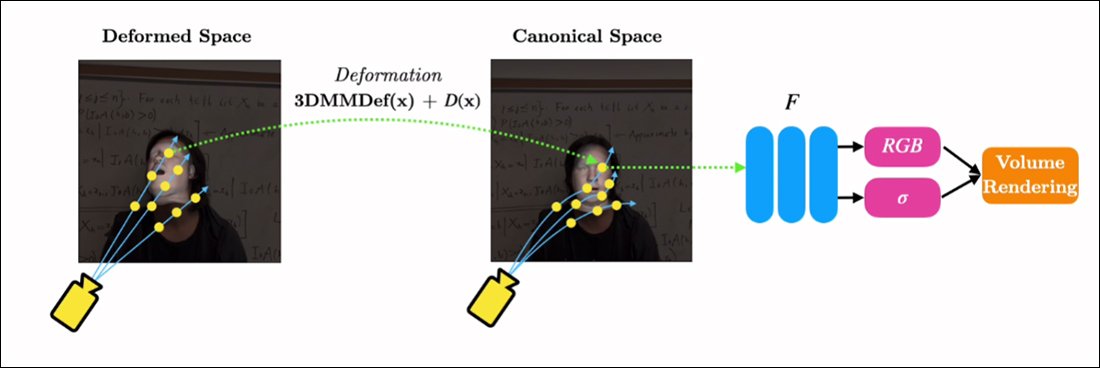

Il metodo, intitolato RigNeRF, usi Modelli di volti morphable 3D (3DMM) come strato interstiziale di strumentalità tra l'input desiderato (cioè l'identità da imporre nel rendering NeRF) e lo spazio neurale, un metodo che è stato largamente adottato negli ultimi anni da approcci di sintesi del volto del Generative Adversarial Network (GAN), nessuno dei quali ha ancora prodotto strutture funzionali e utili per la sostituzione del volto per i video.

A differenza dei tradizionali video deepfake, assolutamente nessuno dei contenuti in movimento raffigurati qui è "reale", ma piuttosto è uno spazio neurale esplorabile che è stato addestrato su brevi filmati. Sulla destra vediamo il modello facciale morphable 3D (3DMM) che funge da interfaccia tra le manipolazioni desiderate ('sorriso', 'guarda a sinistra', 'guarda in alto', ecc.) e i parametri solitamente intrattabili di un campo di radianza neurale visualizzazione. Per una versione ad alta risoluzione di questa clip, insieme ad altri esempi, vedere il file pagina del progettoo i video incorporati alla fine di questo articolo. Fonte: https://shahrukhathar.github.io/2022/06/06/RigNeRF.html

I 3DMM sono effettivamente modelli CGI di volti, i cui parametri possono essere adattati a sistemi di sintesi di immagini più astratti, come NeRF e GAN, che sono altrimenti difficili da controllare.

Quello che vedi nell'immagine qui sopra (immagine centrale, uomo con la camicia blu), così come l'immagine immediatamente sotto (immagine a sinistra, uomo con la camicia blu), non è un video "reale" in cui una piccola parte di " è stato sovrapposto il volto falso, ma una scena interamente sintetizzata che esiste esclusivamente come rendering neurale volumetrico, inclusi il corpo e lo sfondo:

Nell'esempio direttamente sopra, il video della vita reale a destra (donna in abito rosso) viene utilizzato per "burattire" l'identità catturata (uomo con camicia blu) a sinistra tramite RigNeRF, che (gli autori affermano) è il primo Sistema basato su NeRF per ottenere la separazione di posa ed espressione pur essendo in grado di eseguire nuove sintesi di viste.

La figura maschile a sinistra nell'immagine in alto è stata "catturata" da un video dello smartphone di 70 secondi e i dati di input (incluse le informazioni sull'intera scena) sono stati successivamente addestrati su 4 GPU V100 per ottenere la scena.

Poiché i rig parametrici in stile 3DMM sono disponibili anche come proxy CGI parametrici di tutto il corpo (piuttosto che solo face rig), RigNeRF apre potenzialmente la possibilità di deepfake di tutto il corpo in cui il movimento, la consistenza e l'espressione umani reali vengono passati allo strato parametrico basato su CGI, che quindi tradurrebbe l'azione e l'espressione in ambienti e video NeRF renderizzati .

Per quanto riguarda RigNeRF, si qualifica come metodo deepfake nel senso attuale in cui i titoli comprendono il termine? O è solo un altro semi-zoppicante corso anche su DeepFaceLab e altri sistemi deepfake di autoencoder dell'era 2017 ad alta intensità di manodopera?

I ricercatori del nuovo documento sono inequivocabili su questo punto:

"Essendo un metodo in grado di rianimare i volti, RigNeRF è incline all'uso improprio da parte di malintenzionati per generare deep-fake."

Il nuovo carta è intitolato RigNeRF: ritratti 3D neurali completamente controllabili, e proviene da ShahRukh Atha della Stonybrook University, stagista presso Adobe durante lo sviluppo di RigNeRF, e da altri quattro autori di Adobe Research.

Oltre i deepfake basati su autoencoder

La maggior parte dei deepfake virali che hanno fatto notizia negli ultimi anni sono prodotti da codificatore automatico-based, derivato dal codice che è stato pubblicato nel subreddit r/deepfakes prontamente bandito nel 2017, anche se non prima di essere copiato a GitHub, dove è stato attualmente biforcato più di mille volte, non da ultimo nel popolare (se controverso) DeepFaceLab distribuzione, e anche il Cambia faccia progetto.

Oltre a GAN e NeRF, anche i framework di autoencoder hanno sperimentato 3DMM come "linee guida" per migliorare i framework di sintesi facciale. Un esempio di questo è il Progetto HifiFace da luglio del 2021. Tuttavia, nessuna iniziativa fruibile o popolare sembra essersi sviluppata da questo approccio fino ad oggi.

I dati per le scene RigNeRF sono ottenuti catturando brevi video per smartphone. Per il progetto, i ricercatori di RigNeRF hanno utilizzato un iPhone XR o un iPhone 12 per tutti gli esperimenti. Per la prima metà dell'acquisizione, al soggetto viene chiesto di eseguire un'ampia gamma di espressioni facciali e discorsi mantenendo la testa ferma mentre la telecamera viene spostata intorno a lui.

Per la seconda metà dell'acquisizione, la fotocamera mantiene una posizione fissa mentre il soggetto deve muovere la testa mentre mostra un'ampia gamma di espressioni. I risultanti 40-70 secondi di filmato (circa 1200-2100 fotogrammi) rappresentano l'intero set di dati che verrà utilizzato per addestrare il modello.

Ridurre la raccolta dei dati

Al contrario, i sistemi di codifica automatica come DeepFaceLab richiedono la raccolta e la cura relativamente laboriose di migliaia di foto diverse, spesso tratte da video di YouTube e altri canali di social media, nonché da film (nel caso di deepfake di celebrità).

I modelli di autoencoder addestrati risultanti sono spesso destinati a essere utilizzati in una varietà di situazioni. Tuttavia, i deepfaker "celebrità" più esigenti possono addestrare interi modelli da zero per un singolo video, nonostante il fatto che la formazione possa richiedere una settimana o più.

Nonostante la nota di avvertimento dei ricercatori del nuovo documento, sembra improbabile che il "patchwork" e i set di dati ampiamente assemblati che alimentano il porno AI e le popolari "rifusioni deepfake" di YouTube/TikTok producano risultati accettabili e coerenti in un sistema deepfake come RigNeRF, che ha una metodologia specifica per la scena. Date le restrizioni sull'acquisizione dei dati delineate nel nuovo lavoro, ciò potrebbe rivelarsi, in una certa misura, un'ulteriore protezione contro l'appropriazione indebita casuale dell'identità da parte di malintenzionati deepfaker.

Adattamento di NeRF a Deepfake Video

NeRF è un metodo basato sulla fotogrammetria in cui un piccolo numero di immagini di origine prese da vari punti di vista viene assemblato in uno spazio neurale 3D esplorabile. Questo approccio è diventato famoso all'inizio di quest'anno, quando NVIDIA ha presentato il suo NeRF istantaneo sistema, in grado di ridurre i tempi di addestramento esorbitanti per NeRF fino a minuti, o addirittura secondi:

NeRF istantaneo. Fonte: https://www.youtube.com/watch?v=DJ2hcC1orc4

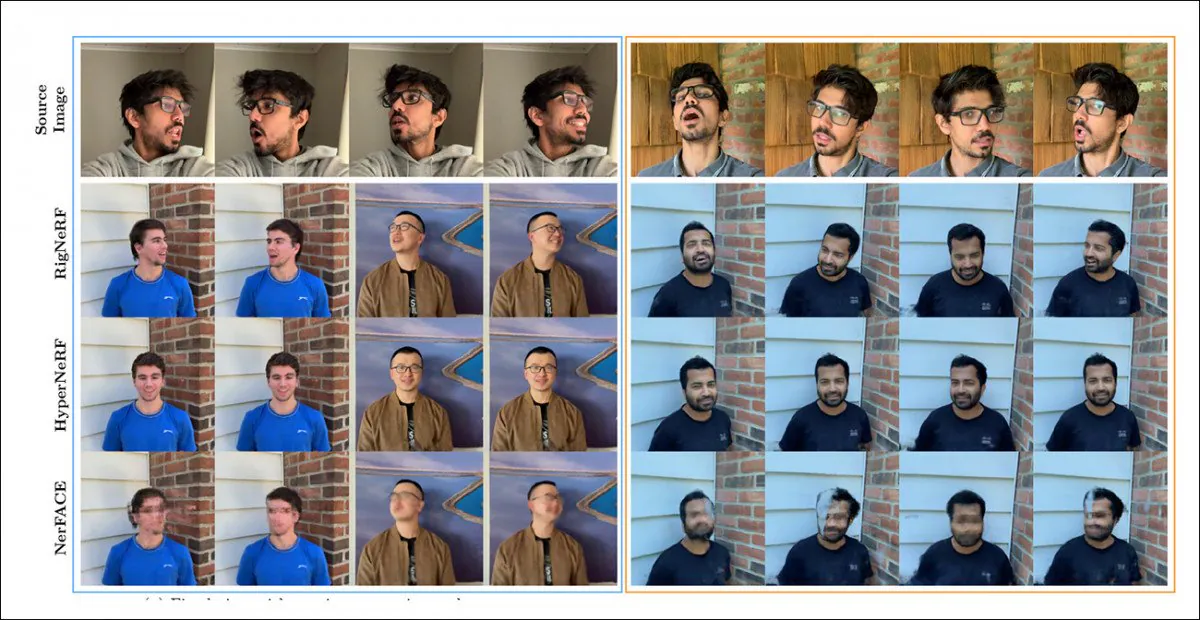

La scena Neural Radiance Field risultante è essenzialmente un ambiente statico che può essere esplorato, ma che lo è difficile da modificare. I ricercatori osservano che due precedenti iniziative basate su NeRF - HyperNeRF+E/P ed NerFACE – hanno preso una pugnalata alla sintesi video facciale e (apparentemente per completezza e diligenza) hanno messo RigNeRF contro questi due framework in un round di test:

Un confronto qualitativo tra RigNeRF, HyperNeRF e NerFACE. Guarda i video di origine collegati e il PDF per versioni di qualità superiore. Fonte immagine statica: https://arxiv.org/pdf/2012.03065.pdf

Tuttavia, in questo caso i risultati, che favoriscono RigNeRF, sono piuttosto anomali, per due motivi: in primo luogo, gli autori osservano che "non esiste alcun lavoro esistente per un confronto tra mele"; in secondo luogo, ciò ha reso necessaria la limitazione delle capacità di RigNeRF per corrispondere almeno in parte alla funzionalità più limitata dei sistemi precedenti.

Poiché i risultati non sono un miglioramento incrementale rispetto al lavoro precedente, ma rappresentano piuttosto una "svolta" nell'editabilità e nell'utilità di NeRF, lasceremo da parte il giro di test e vedremo invece cosa sta facendo RigNeRF in modo diverso dai suoi predecessori.

Forze combinate

Il limite principale di NerFACE, che può creare il controllo di posa/espressione in un ambiente NeRF, è che presuppone che il metraggio sorgente venga catturato con una telecamera statica. Ciò significa effettivamente che non può produrre nuove viste che si estendono oltre i suoi limiti di cattura. Questo produce un sistema in grado di creare "ritratti in movimento", ma che non è adatto per video in stile deepfake.

HyperNeRF, d'altra parte, pur essendo in grado di generare viste nuove e iperreali, non ha strumenti che gli permettano di cambiare le pose della testa o le espressioni facciali, il che ancora una volta non si traduce in alcun tipo di concorrente per i deepfake basati su autoencoder.

RigNeRF è in grado di combinare queste due funzionalità isolate creando uno "spazio canonico", una linea di base predefinita da cui è possibile attivare deviazioni e deformazioni tramite input dal modulo 3DMM.

Creare uno 'spazio canonico' (nessuna posa, nessuna espressione), su cui possano agire le deformazioni (ovvero pose ed espressioni) prodotte tramite il 3DMM.

Poiché il sistema 3DMM non corrisponderà esattamente al soggetto catturato, è importante compensare questo problema durante il processo. RigNeRF ottiene questo risultato con un campo di deformazione prima calcolato da a Perceptron multistrato (MLP) derivato dal metraggio sorgente.

I parametri della fotocamera necessari per calcolare le deformazioni sono ottenuti tramite COLMAPPE, mentre i parametri di espressione e forma per ogni fotogramma sono ottenuti da DECA.

Il posizionamento è ulteriormente ottimizzato attraverso raccordo punto di riferimento e i parametri della fotocamera di COLMAP e, a causa delle limitazioni delle risorse di calcolo, l'output video viene sottoposto a downsampling alla risoluzione 256 × 256 per l'addestramento (un processo di riduzione vincolato dall'hardware che affligge anche la scena del deepfaking dell'autoencoder).

Successivamente, la rete di deformazione viene addestrata sui quattro V100: un hardware formidabile che probabilmente non sarà alla portata degli appassionati occasionali (tuttavia, quando si tratta di formazione sull'apprendimento automatico, è spesso possibile scambiare peso con tempo e semplicemente accettare quel modello). la formazione sarà questione di giorni o addirittura settimane).

In conclusione, i ricercatori affermano:

"A differenza di altri metodi, RigNeRF, grazie all'uso di un modulo di deformazione guidato da 3DMM, è in grado di modellare la posa della testa, le espressioni facciali e l'intera scena del ritratto 3D con alta fedeltà, fornendo così ricostruzioni migliori con dettagli nitidi."

Guarda i video incorporati di seguito per ulteriori dettagli e filmati dei risultati.

Pubblicato per la prima volta il 15 giugno 2022.