Settore Sanitario

Riconoscere lo stress dei dipendenti attraverso l'analisi facciale sul lavoro

Nel contesto del cambiare cultura intorno all'etichetta delle riunioni di Zoom e l'emergere di Fatica dello zoom, i ricercatori di Cambridge hanno pubblicato uno studio che utilizza l'apprendimento automatico per determinare i nostri livelli di stress tramite la copertura webcam abilitata all'intelligenza artificiale delle nostre espressioni facciali al lavoro.

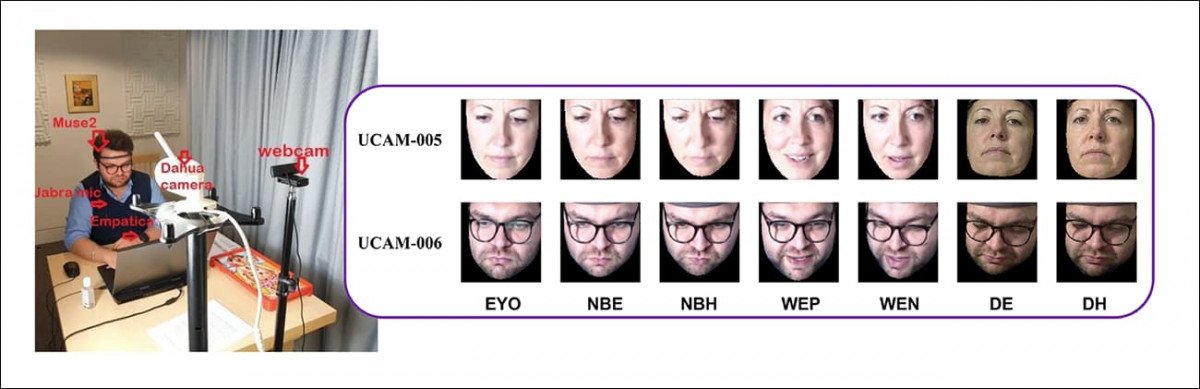

A sinistra, l'ambiente di raccolta dei dati, con più apparecchiature di monitoraggio addestrate o collegate a un volontario; a destra, esempio di espressioni facciali generate dai soggetti del test a vari livelli di difficoltà del compito. Fonte: https://arxiv.org/pdf/2111.11862.pdf

La ricerca è destinata all'analisi degli affetti (ad es. riconoscimento delle emozioni) nei sistemi di "vivenza assistita ambientale" e presumibilmente è progettato per abilitare framework di monitoraggio delle espressioni facciali basati su intelligenza artificiale basati su video in tali sistemi; sebbene il documento non approfondisca questo aspetto, lo sforzo di ricerca non ha senso in nessun altro contesto.

L'ambito specifico del progetto è l'apprendimento dei modelli di espressione facciale negli ambienti di lavoro – comprese le modalità di lavoro a distanza – piuttosto che situazioni di "svago" o "passive", come i viaggi.

Riconoscimento delle emozioni basato sul volto sul posto di lavoro

Sebbene "Ambient Assistive Living" possa sembrare un progetto per l'assistenza agli anziani, non è affatto così. Parlando degli "utenti finali" a cui si rivolge, gli autori affermano*:

'Sistemi creati per ambienti di vita assistivi ambientali [†] mirano a essere in grado di eseguire sia l'analisi affettiva automatica che la risposta. La vita assistita ambientale si basa sull'uso delle tecnologie dell'informazione e della comunicazione (TIC) per aiutare la vita quotidiana e l'ambiente di lavoro delle persone a mantenerle più sane e attive più a lungo e consentire loro di vivere in modo indipendente man mano che invecchiano. Così, la vita assistita ambientale mira a facilitare gli operatori sanitari, gli infermieri, i medici, gli operai, gli autisti, i piloti, gli insegnanti e varie industrie attraverso il rilevamento, la valutazione e l'intervento.

"Il sistema ha lo scopo di determinare lo sforzo fisico, emotivo e mentale e rispondere e adattarsi come e quando necessario, ad esempio un'auto dotata di un sistema di rilevamento della sonnolenza può informare il conducente di essere attento e può suggerirgli di fare una piccola pausa per evitare incidenti [††].'

. carta è intitolato Deduzione dell'effetto facciale dell'utente in impostazioni simili al lavoro, e proviene da tre ricercatori dell'Affettive Intelligence & Robotics Lab di Cambridge.

Condizioni di prova

Dal lavoro precedente in questo campo è dipeso in gran parte da raccolte ad hoc di immagini prelevate da Internet, i ricercatori di Cambridge hanno condotto esperimenti di raccolta dati locali con 12 volontari del campus, 5 maschi e 7 femmine. I volontari provenivano da nove paesi e avevano un'età compresa tra 22 e 41 anni.

Il progetto mirava a ricreare tre ambienti di lavoro potenzialmente stressanti: un ufficio; una linea di produzione in fabbrica; e una teleconferenza, come il tipo di chat di gruppo Zoom che è diventata un caratteristica frequente di homeworking dall'avvento della pandemia.

I soggetti sono stati monitorati con vari mezzi, tra cui tre telecamere, un microfono da collo Jabra, un Braccialetto Empatica (un dispositivo indossabile multisensore wireless che offre biofeedback in tempo reale) e un sensore per archetto Muse 2 (che offre anche biofeedback). Inoltre, ai volontari è stato chiesto di completare periodicamente dei sondaggi e di autovalutare il proprio stato d'animo.

Tuttavia, ciò non significa che i futuri sistemi di Ambient Assistive Living saranno in grado di "collegarti" a tal punto (anche solo per motivi di costo); tutte le apparecchiature e i metodi di monitoraggio senza telecamera utilizzati nella raccolta dati, comprese le autovalutazioni scritte, sono destinati a verificare i sistemi di riconoscimento degli affetti basati sul volto abilitati dalle riprese della telecamera.

Aumentare la pressione: lo scenario dell'ufficio

Nei primi due dei tre scenari ("Ufficio" e "Fabbrica"), i volontari hanno iniziato a lavorare a un ritmo lento, con la pressione che aumentava gradualmente nel corso di quattro fasi, con diversi tipi di attività per ciascuna.

Al livello più alto di stress indotto, i volontari hanno dovuto sopportare anche l'effetto "camice bianco" di qualcuno che li guardava alle spalle, più 85 dB di rumore aggiuntivo, che è solo cinque decibel sotto il limite legale per un ambiente d'ufficio negli Stati Uniti e il limite massimo esatto specificato dal National Institute for Occupational Safety and Health (NIOSH).

Nella fase di raccolta dati simile a un ufficio, i soggetti avevano il compito di ricordare le lettere precedenti che erano balenate sullo schermo, con livelli di difficoltà crescenti (come dover ricordare sequenze di due lettere che si erano verificate due schermate prima).

Lo scenario della fabbrica

Per simulare un ambiente di lavoro manuale, ai soggetti è stato chiesto di giocare Funzionamento, che mette alla prova la destrezza dell'utente, obbligando il giocatore a estrarre piccoli oggetti da una tavola attraverso strette aperture con bordi metallici, senza toccarne i lati; tale evento attiva un cicalino di "fallimento".

Quando è arrivata la fase più difficile, il volontario è stato sfidato a estrarre tutti i 12 elementi senza errori entro un minuto. Per il contesto, il record mondiale per questo compito, stabilito nel Regno Unito nel 2019, si attesta a 12.68 secondi.

Lo scenario della teleconferenza

Infine, nel test dei compiti a casa/teleconferenza, ai volontari è stato chiesto da uno sperimentatore durante una chiamata di MS Teams di richiamare i propri ricordi positivi e negativi. Per la fase più stressante di questo scenario, al volontario è stato richiesto di ricordare un ricordo molto negativo o triste del suo recente passato.

I vari compiti e scenari sono stati eseguiti in ordine casuale e compilati in un set di dati personalizzato intitolato Working-Environment-Context-Aware Dataset (WECARE-DB).

Metodo e formazione

I risultati delle autovalutazioni degli utenti sul loro umore sono stati utilizzati come dati di base e mappati in base alle dimensioni di valenza e eccitazione. Il video catturato dagli esperimenti è stato analizzato tramite un sistema di rilevamento dei punti di riferimento facciali. networke le immagini allineate inviate a a Rete ResNet-18 allenato sul AffectNet set di dati.

450,000 immagini da AffectNet, tutte estratte/etichettate da Internet utilizzando query relative alle emozioni, sono state annotate manualmente, afferma il documento, con dimensioni di valenza e eccitazione.

Successivamente, i ricercatori hanno perfezionato la rete basandosi esclusivamente sul proprio set di dati WECARE, mentre codifica della rappresentazione spettrale è stato utilizzato per riassumere le previsioni basate su frame.

Risultati

Le prestazioni del modello sono state valutate in base a tre parametri comunemente associati alla previsione automatizzata degli affetti: correlazione del coefficiente di concordanza, correlazione del coefficiente di Pearson e errore quadratico medio (RMSE).

Gli autori notano che il modello messo a punto sul proprio set di dati WECARE ha superato ResNet-18 e ne deducono che il modo in cui governiamo le nostre espressioni facciali è molto diverso in un ambiente di lavoro rispetto ai contesti più astratti da cui sono derivati studi precedenti materiale di origine da Internet.

Affermano:

Osservando la tabella, osserviamo che il modello perfezionato su WECARE-DB ha superato il modello ResNet-18 pre-addestrato su [AffectNet], il che indica che i comportamenti facciali mostrati in ambienti simili a quelli lavorativi sono diversi rispetto alle impostazioni Internet reali utilizzate nel database AffectNet. Pertanto, è necessario acquisire set di dati e addestrare modelli per il riconoscimento degli affetti facciali in ambienti simili a quelli lavorativi.

Per quanto riguarda il futuro del riconoscimento affettivo sul lavoro, abilitato da reti di telecamere puntate sui dipendenti e che fanno costantemente previsioni sui loro stati emotivi, gli autori concludono*:

"L'obiettivo finale è implementare e utilizzare i modelli addestrati in tempo reale e in contesti di lavoro reali per fornire input ai sistemi di supporto decisionale per promuovere la salute e il benessere delle persone durante la loro età lavorativa nel contesto della Progetto dell'UE sull'età lavorativa. '

* La mia enfasi.

† Qui gli autori fanno tre citazioni:

Riconoscimento Automatico, dimensionale e Continuo delle Emozioni – https://ibug.doc.ic.ac.uk/media/uploads/documents/GunesPantic_IJSE_2010_camera.pdf

Esplorare il dominio della vita assistita dall'ambiente: una revisione sistematica – https://link.springer.com/article/10.1007/s12652-016-0374-3

Una revisione delle tecnologie dell'Internet of Things per gli ambienti di vita assistiti dall'ambiente – https://mdpi-res.com/d_attachment/futureinternet/futureinternet-11-00259/article_deploy/futureinternet-11-00259-v2.pdf

†† Qui gli autori fanno due citazioni:

Rilevamento della sonnolenza del driver in tempo reale per il sistema integrato utilizzando la compressione del modello di reti neurali profonde – https://openaccess.thecvf.com/content_cvpr_2017_workshops/w4/papers/Reddy_Real-Time_Driver_Drowsiness_CVPR_2017_paper.pdf

Sistema di rilevamento della sonnolenza del conducente in tempo reale utilizzando le caratteristiche facciali – https://www.semanticscholar.org/paper/Real-Time-Driver-Drowsiness-Detection-System-Using-Deng-Wu/1f4b0094c9e70bf7aa287234e0fdb4c764a5c532