Intelligenza Artificiale

NeRF: addestramento di droni in ambienti di radiosità neurale

I ricercatori della Stanford University hanno ideato un nuovo modo di addestrare i droni a navigare in ambienti fotorealistici e altamente accurati, sfruttando il recente valanga di interesse nei campi di radianza neurale (NeRF).

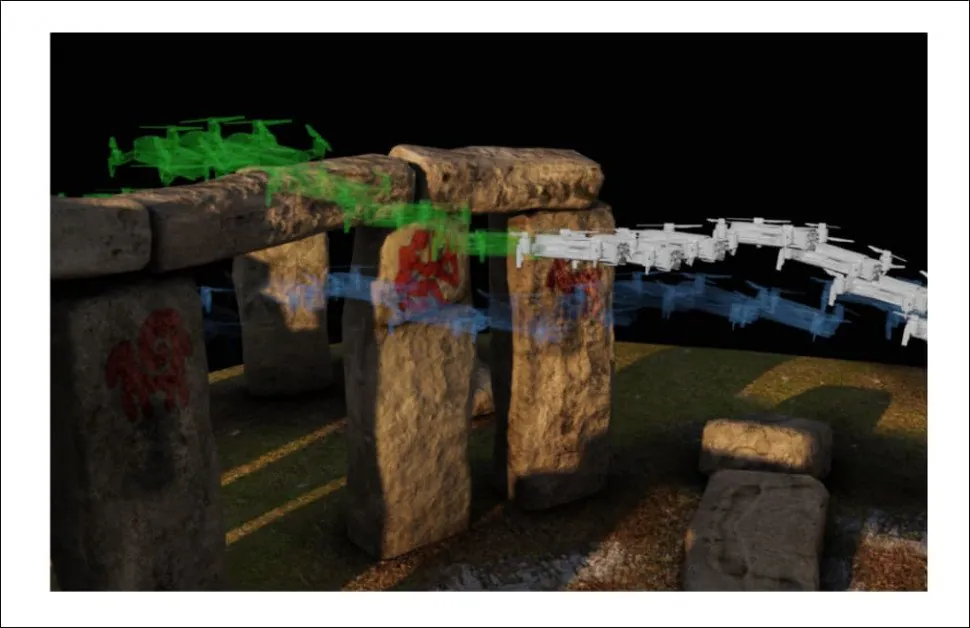

I droni possono essere addestrati in ambienti virtuali mappati direttamente da luoghi della vita reale, senza necessità di ricostruzione di scene 3D specializzate. In questa immagine del progetto, il disturbo del vento è stato aggiunto come potenziale ostacolo per il drone, e possiamo vedere il drone essere momentaneamente deviato dalla sua traiettoria e compensare all'ultimo momento per evitare un potenziale ostacolo. Fonte: https://mikh3x4.github.io/nerf-navigation/

Il metodo offre la possibilità di un addestramento interattivo di droni (o altri tipi di oggetti) in scenari virtuali che includono automaticamente informazioni sul volume (per calcolare l'evitamento delle collisioni), texture ricavate direttamente da foto reali (per aiutare ad addestrare le reti di riconoscimento delle immagini dei droni in modo più realistico) e illuminazione del mondo reale (per garantire che una varietà di scenari di illuminazione vengano addestrati nella rete, evitando un adattamento o un'ottimizzazione eccessivi rispetto all'istantanea originale della scena).

Un oggetto-divano naviga in un ambiente virtuale complesso che sarebbe stato molto difficile da mappare utilizzando l'acquisizione della geometria e il retexturing nei tradizionali flussi di lavoro AR/VR, ma che è stato ricreato automaticamente in NeRF da un numero limitato di foto. Fonte: https://www.youtube.com/watch?v=5JjWpv9BaaE

Le tipiche implementazioni NeRF non presentano meccanismi di traiettoria, dal momento che la maggior parte dei progetti NeRF negli ultimi 18 mesi si sono concentrati su altre sfide, come riilluminazione della scena, rendering riflesso, compositing e sbrogliamento di elementi catturati. Pertanto, la principale innovazione del nuovo articolo è l'implementazione di un ambiente NeRF come spazio navigabile, senza le attrezzature estese e le procedure laboriose che sarebbero necessarie per modellarlo come un ambiente 3D basato sulla cattura dei sensori e sulla ricostruzione CGI.

NeRF come VR/AR

La nuova carta è intitolato Navigazione robotica di sola visione in un mondo radioso neurale, ed è una collaborazione tra tre dipartimenti di Stanford: aeronautica e astronautica, ingegneria meccanica e informatica.

Il lavoro propone un framework di navigazione che fornisce a un robot un ambiente NeRF pre-addestrato, la cui densità di volume delimita i possibili percorsi del dispositivo. Include anche un filtro per stimare la posizione del robot all'interno dell'ambiente virtuale, basato sul riconoscimento delle immagini della telecamera RGB integrata nel robot. In questo modo, un drone o un robot è in grado di "allucinare" con maggiore precisione cosa può aspettarsi di vedere in un dato ambiente.

L'ottimizzatore di traiettoria del progetto naviga attraverso un modello NeRF di Stonehenge, generato tramite fotogrammetria e interpretazione di immagini (in questo caso, di modelli mesh), in un ambiente Neural Radiance. Il pianificatore di traiettoria calcola diversi possibili percorsi prima di stabilire una traiettoria ottimale sull'arco.

Poiché un ambiente NeRF presenta occlusioni completamente modellate, il drone può imparare a calcolare gli ostacoli più facilmente, poiché la rete neurale dietro NeRF può mappare la relazione tra le occlusioni e il modo in cui i sistemi di navigazione basati sulla visione integrati nel drone percepiscono l'ambiente. La pipeline di generazione automatica di NeRF offre un metodo relativamente semplice per creare spazi di addestramento iperrealistici con solo poche foto.

Il framework di ripianificazione online sviluppato per il progetto Stanford facilita una pipeline di navigazione resiliente e interamente basata sulla visione.

L'iniziativa di Stanford è tra le prime a considerare le possibilità di esplorare uno spazio NeRF nel contesto di un ambiente in stile VR navigabile e immersivo. I campi di radianza neurale sono una tecnologia emergente e attualmente sono soggetti a molteplici sforzi accademici per ottimizzare i loro elevati requisiti di risorse di calcolo, nonché per districare gli elementi catturati.

Nerf non è (veramente) CGI

Poiché un ambiente NeRF è una scena 3D navigabile, è diventata una tecnologia incompresa sin dalla sua comparsa nel 2020, spesso ampiamente percepita come un metodo per automatizzare la creazione di mesh e texture, piuttosto che sostituire gli ambienti 3D familiari agli spettatori dei reparti VFX di Hollywood e le scene fantastiche degli ambienti di realtà aumentata e realtà virtuale.

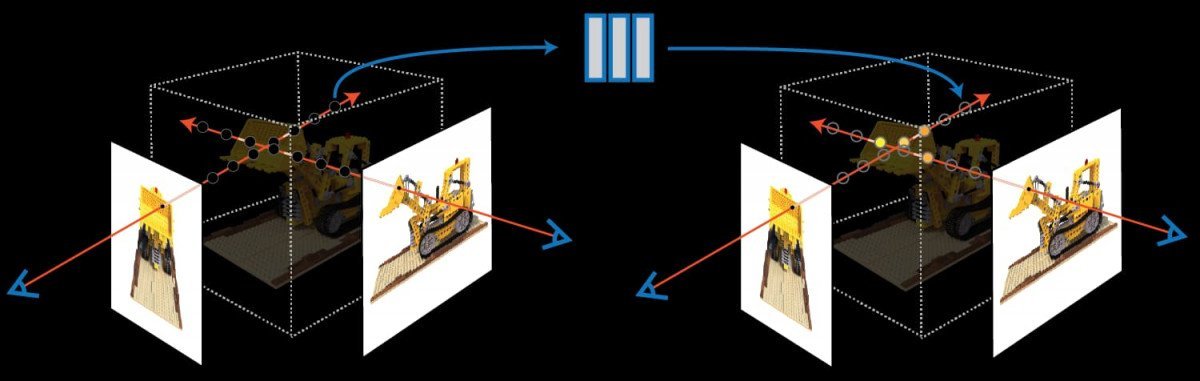

NeRF estrae le informazioni sulla geometria e sulla trama da un numero molto limitato di punti di vista dell'immagine, calcolando la differenza tra le immagini come informazioni volumetriche. Fonte: https://www.matthewtancik.com/nerf

In effetti, l'ambiente NeRF è più simile a uno spazio di rendering "live", in cui un insieme di informazioni sui pixel e sull'illuminazione viene conservato e gestito in una rete neurale attiva e in esecuzione.

La chiave del potenziale di NeRF è che richiede solo un numero limitato di immagini per ricreare gli ambienti e che gli ambienti generati contengono tutte le informazioni necessarie per una ricostruzione ad alta fedeltà, senza bisogno dei servizi di modellatori, artisti delle texture, specialisti dell'illuminazione e orde di altri collaboratori della CGI "tradizionale".

Segmentazione semantica

Anche se NeRF costituisce effettivamente una "Computer-Generated Imagery" (CGI), offre una metodologia completamente diversa e una pipeline altamente automatizzata. Inoltre, NeRF può isolare e "incapsulare" le parti in movimento di una scena, in modo che possano essere aggiunte, rimosse, accelerate e, in generale, funzionare come sfaccettature discrete in un ambiente virtuale – una capacità che va ben oltre l'attuale stato dell'arte nell'interpretazione "hollywoodiana" della CGI.

A collaborazione della Shanghai Tech University, pubblicato nell'estate del 2021, offre un metodo per individuare gli elementi NeRF in movimento in sfaccettature "incollabili" per una scena. Fonte: https://www.youtube.com/watch?v=Wp4HfOwFGP4

L'aspetto negativo è che l'architettura di NeRF è un po' una "scatola nera": al momento non è possibile estrarre un oggetto da un ambiente NeRF e manipolarlo direttamente con i tradizionali strumenti basati su mesh e immagini, anche se una serie di ricerche stanno iniziando a fare progressi nella decostruzione della matrice alla base degli ambienti di rendering live della rete neurale di NeRF.