Intelligenza Artificiale

LipSync3D di Google offre una migliore sincronizzazione del movimento della bocca "deepfaked".

A collaborazione Tra i ricercatori di Google AI e l'Indian Institute of Technology di Kharagpur, viene proposto un nuovo framework per sintetizzare teste parlanti a partire da contenuti audio. Il progetto mira a produrre metodi ottimizzati e con risorse ragionevoli per creare contenuti video di "teste parlanti" a partire dall'audio, allo scopo di sincronizzare i movimenti delle labbra con l'audio doppiato o tradotto automaticamente, e per l'utilizzo in avatar, applicazioni interattive e altri ambienti in tempo reale.

Fonte: https://www.youtube.com/watch?v=L1StbX9OznY

I modelli di machine learning addestrati nel processo – chiamati LipSync3D – richiedono solo un singolo video dell’identità del volto target come dati di input. La pipeline di preparazione dei dati separa l'estrazione della geometria facciale dalla valutazione dell'illuminazione e di altri aspetti di un video di input, consentendo una formazione più economica e mirata.

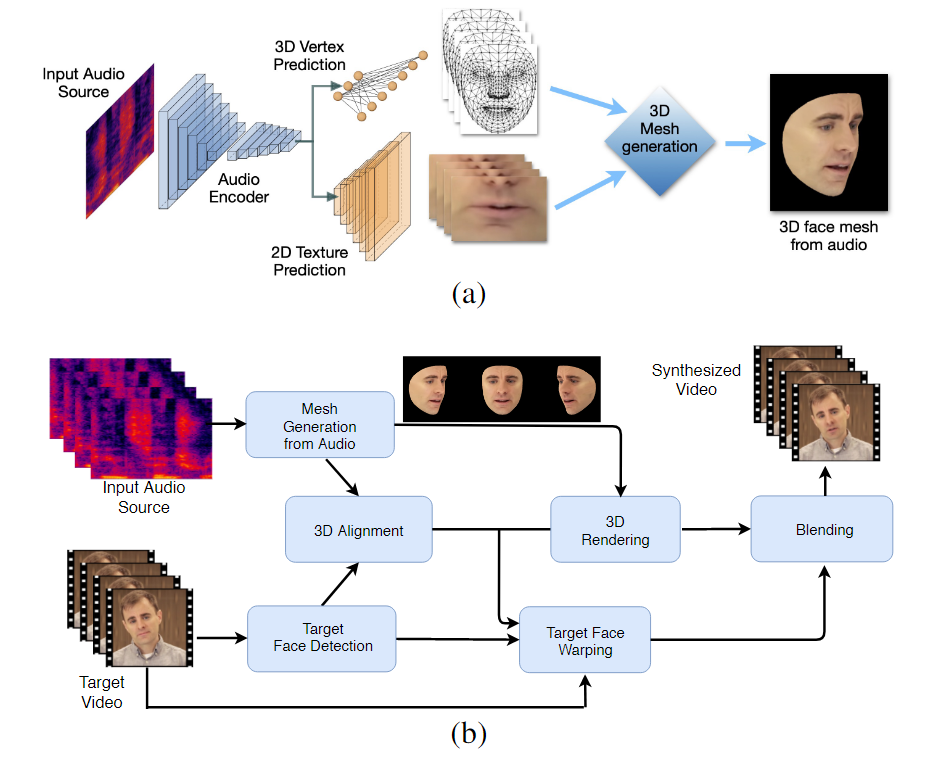

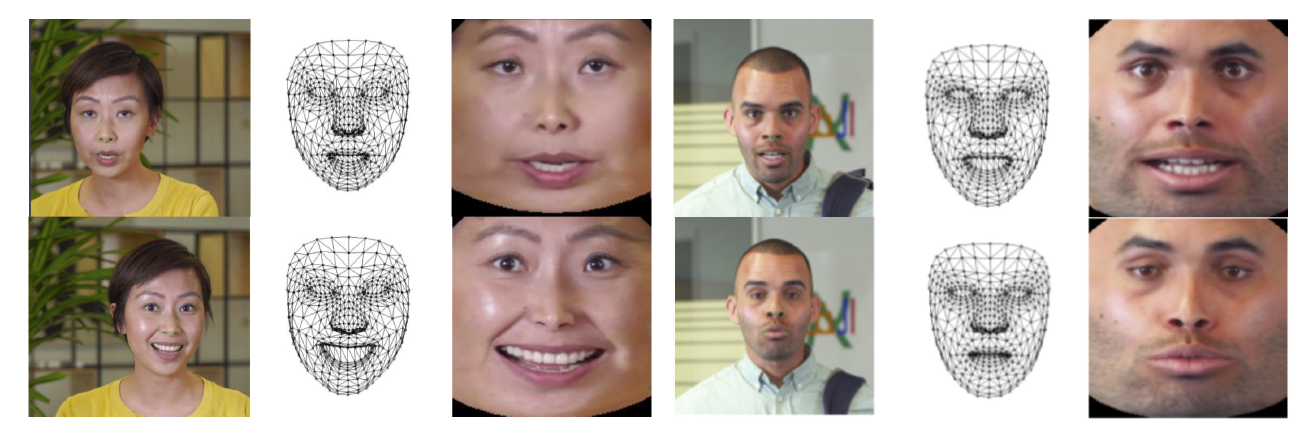

Il flusso di lavoro in due fasi di LipSync3D. In alto, la generazione di un volto 3D con texture dinamica a partire dall'audio di destinazione; in basso, l'inserimento della mesh generata in un video di destinazione.

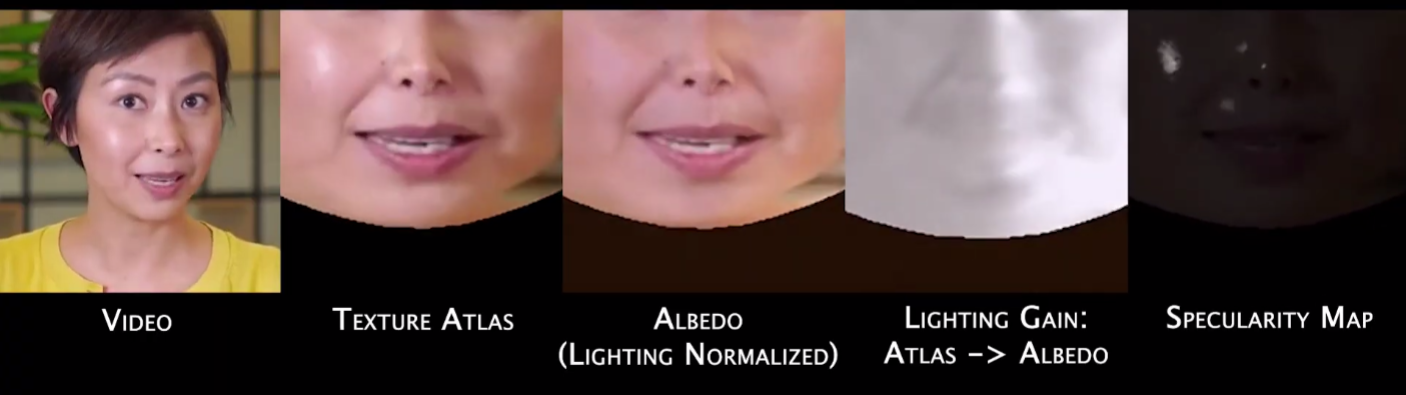

In effetti, il contributo più notevole di LipSync3D al corpus di ricerche in questo settore potrebbe essere il suo algoritmo di normalizzazione dell'illuminazione, che separa l'illuminazione di addestramento da quella di inferenza.

Disaccoppiando i dati di illuminazione dalla geometria generale, LipSync3D riesce a produrre un output di movimento delle labbra più realistico anche in condizioni difficili. Altri approcci degli ultimi anni si sono limitati a condizioni di illuminazione "fisse", che non rivelano le loro capacità più limitate in questo senso.

Durante la pre-elaborazione dei frame di dati di input, il sistema deve identificare e rimuovere i punti speculari, poiché questi sono specifici delle condizioni di illuminazione in cui è stato ripreso il video e interferiranno altrimenti con il processo di riilluminazione.

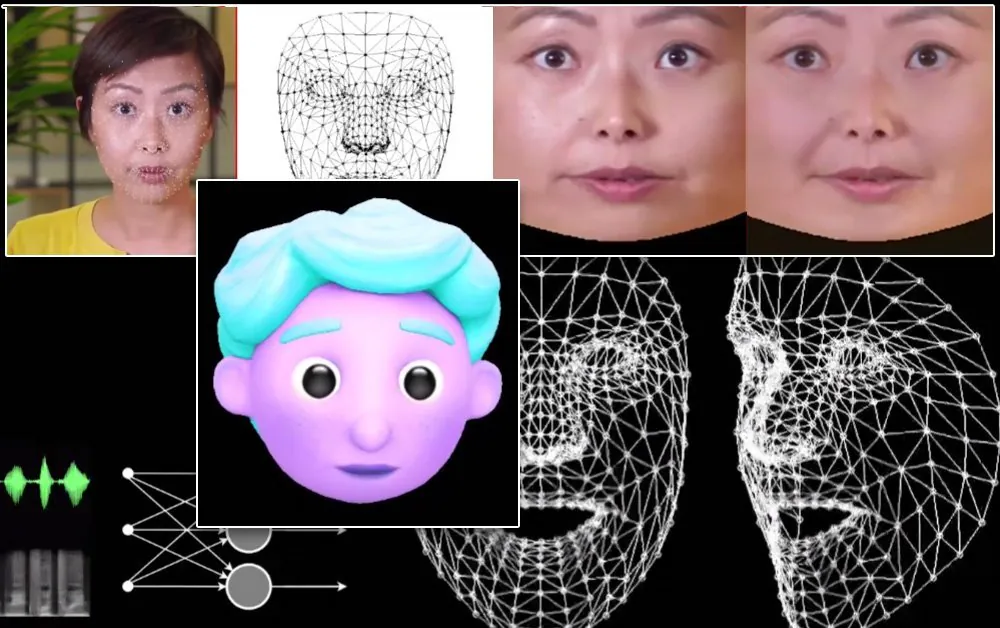

LipSync3D, come suggerisce il nome, non esegue una semplice analisi dei pixel sui volti che valuta, ma utilizza attivamente punti di riferimento facciali identificati per generare mesh mobili in stile CGI, insieme alle texture "dispiegate" che le circondano in una pipeline CGI tradizionale.

Posa normalizzazione in LipSync3D. A sinistra ci sono i frame di input e le caratteristiche rilevate; al centro, i vertici normalizzati della valutazione della mesh generata; e sulla destra, il corrispondente atlante delle trame, che fornisce la verità di base per la previsione delle trame. Fonte: https://arxiv.org/pdf/2106.04185.pdf

Oltre al nuovo metodo di riilluminazione, i ricercatori affermano che LipSync3D offre tre innovazioni principali rispetto al lavoro precedente: la separazione di geometria, illuminazione, posa e trama in flussi di dati discreti in uno spazio normalizzato; un modello di previsione della trama auto-regressiva facilmente addestrabile che produce una sintesi video coerente nel tempo; e maggiore realismo, come valutato da valutazioni umane e metriche oggettive.

La suddivisione delle varie sfaccettature delle immagini facciali video consente un maggiore controllo nella sintesi video.

LipSync3D può derivare il movimento della geometria delle labbra appropriato direttamente dall'audio analizzando fonemi e altri aspetti del discorso e traducendoli in pose muscolari corrispondenti note intorno all'area della bocca.

Questo processo utilizza una pipeline di previsione congiunta, in cui la geometria e la trama dedotte hanno codificatori dedicati in una configurazione di codificatore automatico, ma condividono un codificatore audio con il discorso che deve essere imposto al modello:

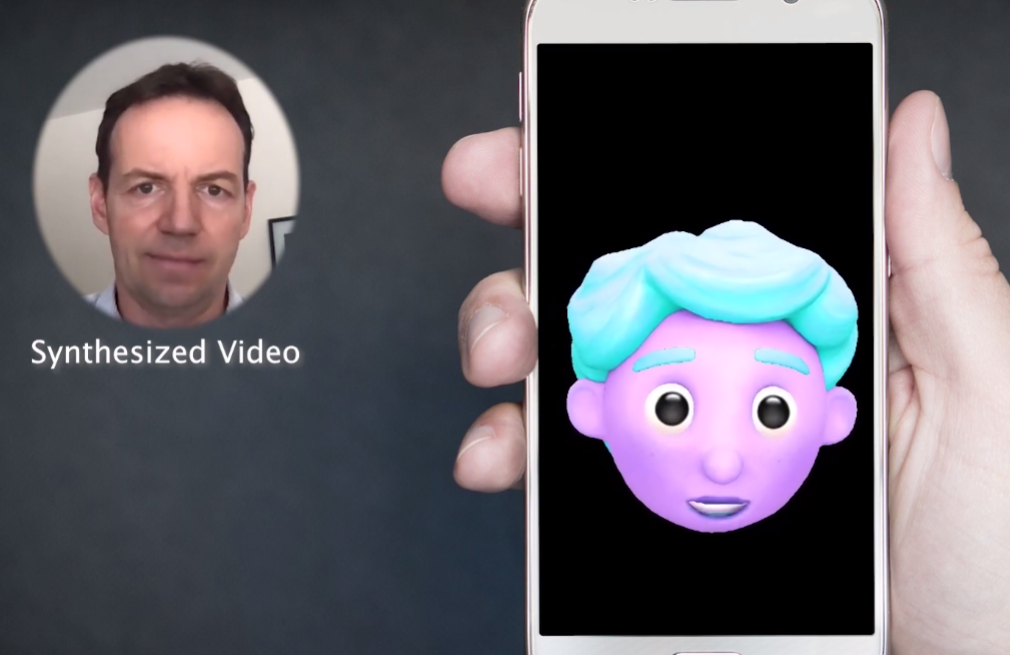

La sintesi del movimento labile di LipSync3D è pensata anche per alimentare avatar CGI stilizzati, che in effetti sono lo stesso tipo di informazioni di mesh e texture delle immagini del mondo reale:

Un avatar 3D stilizzato ha i movimenti delle labbra alimentati in tempo reale da un video del relatore sorgente. In uno scenario del genere, i migliori risultati si otterrebbero con un pre-training personalizzato.

I ricercatori prevedono anche l'uso di avatar con una sensazione leggermente più realistica:

![]()

I tempi di addestramento di esempio per i video vanno da 3-5 ore per un video di 2-5 minuti, in una pipeline che utilizza TensorFlow, Python e C++ su una GeForce GTX 1080. Le sessioni di addestramento hanno utilizzato una dimensione batch di 128 fotogrammi su 500-1000 epoche, con ogni epoca che rappresenta una valutazione completa del video.

Verso la risincronizzazione dinamica del movimento delle labbra

Il campo della risincronizzazione delle labbra per accogliere una nuova traccia audio ha ricevuto molta attenzione nella ricerca sulla visione artificiale negli ultimi anni (vedi sotto), non da ultimo perché è un sottoprodotto di una controversa tecnologia deepfake.

Nel 2017 l'Università di Washington ricerca presentata capace di imparare la sincronizzazione labiale dall'audio, usandolo per cambiare i movimenti delle labbra dell'allora presidente Obama. Nel 2018; guidato dal Max Planck Institute for Informatics un'altra iniziativa di ricerca per abilitare il trasferimento video identità>identità, con sincronizzazione labiale a sottoprodotto del processo; e nel maggio del 2021 la startup AI FlawlessAI ha rivelato la sua tecnologia proprietaria di sincronizzazione labiale TrueSync, ampiamente ricevuto sulla stampa come promotore di migliori tecnologie di doppiaggio per le principali uscite cinematografiche in tutte le lingue.

E, naturalmente, il continuo sviluppo di repository open source deepfake fornisce un altro ramo della ricerca attiva del contributo degli utenti in questa sfera della sintesi dell'immagine facciale.