Leader del pensiero

Decodifica di opportunità e sfide per gli agenti LLM nell'intelligenza artificiale generativa

Stiamo assistendo a una progressione delle applicazioni di intelligenza artificiale generativa basate su modelli linguistici di grandi dimensioni (LLM) dai prompt alla generazione aumentata di recupero (RAG) agli agenti. Si parla molto degli agenti negli ambienti industriali e di ricerca, principalmente per il potere che questa tecnologia fornisce per trasformare le applicazioni aziendali e fornire esperienze clienti superiori. Esistono modelli comuni per la creazione di agenti che consentano i primi passi verso l’intelligenza generale artificiale (AGI).

Nel mio precedente articoloAbbiamo visto una scala di intelligenza dei pattern per la creazione di applicazioni basate su LLM. A partire da prompt che catturano il dominio del problema e utilizzano la memoria interna di LLM per generare output. Con RAG, ampliamo il prompt con informazioni esterne ricercate da un database vettoriale per controllare gli output. Successivamente, concatenando le chiamate LLM, possiamo creare flussi di lavoro per realizzare applicazioni complesse. Gli agenti portano questo processo a un livello superiore determinando automaticamente come devono essere formate queste catene LLM. Vediamolo in dettaglio.

Agenti – Sotto il cofano

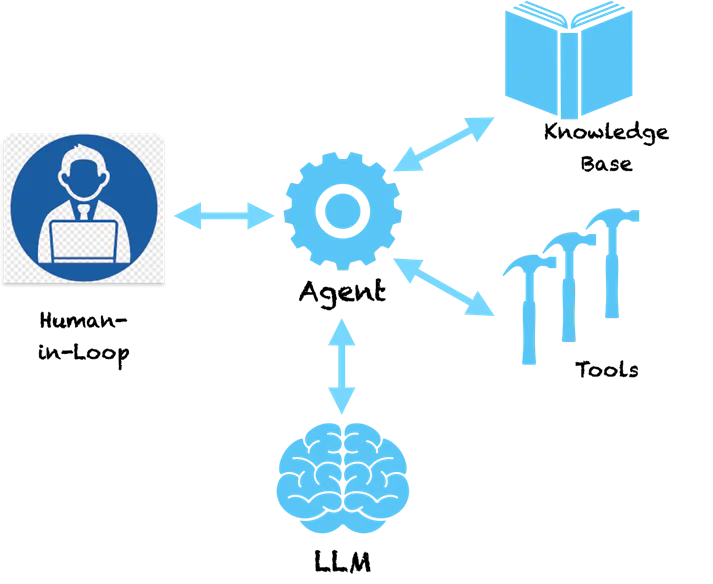

Uno schema chiave degli agenti è che sfruttano la capacità di comprensione del linguaggio di LLM per elaborare un piano su come risolvere un dato problema. L'LLM comprende il problema e fornisce una sequenza di passaggi per risolverlo. Tuttavia, non si ferma qui. Gli agenti non sono un puro sistema di supporto che fornisce consigli su come risolvere il problema e poi passa il testimone a te per seguire i passaggi consigliati. Gli agenti hanno gli strumenti per procedere e agire. Spaventoso, vero?

Se chiediamo a un agente una domanda semplice come questa:

Umani: Quale azienda ha fondato l'inventore del telefono?

Di seguito è riportato un esempio di azioni di riflessione che un agente può intraprendere.

Agente (PENSANDO):

- Pensiero: devo cercare l'inventore del telefono.

- Action: Cerca [inventore del telefono]

- Osservazione: Alexander Graham Bell

- Pensiero: devo cercare un'azienda fondata da Alexander Graham Bell

- Action: Cerca [azienda fondata da Alexander Graham Bell]

- Osservazione: Alexander Graham Bell ha co-fondato l'American Telephone and Telegraph Company (AT&T) nel 1885

- Pensiero: ho trovato la risposta. Ritornerò.

Agente (RISPOSTA): Alexander Graham Bell ha co-fondato AT&T nel 1885

Puoi vedere che l'agente segue un metodo metodico per scomporre il problema in sottoproblemi che possono essere risolti intraprendendo azioni specifiche. Le azioni qui sono raccomandate dal LLM e possiamo associarle a strumenti specifici per implementare queste azioni. Potremmo abilitare uno strumento di ricerca per l'agente in modo tale che quando si rende conto che LLM ha fornito la ricerca come azione, chiamerà questo strumento con i parametri forniti da LLM. La ricerca qui è su Internet ma può anche essere reindirizzata per cercare in una base di conoscenza interna come un database vettoriale. Il sistema ora diventa autosufficiente e può capire come risolvere problemi complessi seguendo una serie di passaggi. Quadri come LangChain e LLaMAIndex ti offrono un modo semplice per creare questi agenti e connetterti a strumenti e API. Amazon ha recentemente lanciato il framework Bedrock Agents che fornisce un'interfaccia visiva per la progettazione degli agenti.

Dietro le quinte, gli agenti seguono uno stile speciale di invio di istruzioni al LLM che li induce a generare un piano d'azione. Il modello Pensiero-Azione-Osservazione di cui sopra è popolare in un tipo di agente chiamato ReAct (Ragionamento e Azione). Altri tipi di agenti includono MRKL e Plan & Execute, che differiscono principalmente per lo stile di guida.

Per agenti più complessi, le azioni possono essere legate a strumenti che causano modifiche nei sistemi di origine. Ad esempio, potremmo connettere l'agente a uno strumento che controlla il saldo delle ferie e richiede le ferie in un sistema ERP per un dipendente. Ora potremmo creare un simpatico chatbot che interagisca con gli utenti e tramite un comando di chat richieda il congedo nel sistema. Niente più schermate complesse per la richiesta di ferie, una semplice interfaccia di chat unificata. Sembra interessante!?

Avvertenze e necessità di un’intelligenza artificiale responsabile

E se avessimo uno strumento che richiama transazioni sulla compravendita di azioni utilizzando un'API pre-autorizzata. Costruisci un'applicazione in cui l'agente studia le variazioni delle azioni (utilizzando strumenti) e prende decisioni per te sull'acquisto e la vendita di azioni. Cosa succede se l'agente vende le azioni sbagliate perché ha avuto allucinazioni e ha preso una decisione sbagliata? Poiché gli LLM sono modelli enormi, è difficile individuare il motivo per cui prendono alcune decisioni, quindi le allucinazioni sono comuni in assenza di guardrail adeguati.

Sebbene gli agenti siano tutti affascinanti, probabilmente avresti immaginato quanto possano essere pericolosi. Se hanno allucinazioni e intraprendono un'azione sbagliata, ciò potrebbe causare enormi perdite finanziarie o gravi problemi nei sistemi aziendali. Pertanto, l’intelligenza artificiale responsabile sta diventando della massima importanza nell’era delle applicazioni basate sul LLM. I principi dell’intelligenza artificiale responsabile in materia di riproducibilità, trasparenza e responsabilità cercano di mettere dei limiti alle decisioni prese dagli agenti e suggeriscono un’analisi del rischio per decidere quali azioni necessitano di un intervento umano. Man mano che vengono progettati agenti sempre più complessi, necessitano di maggiore controllo, trasparenza e responsabilità per assicurarsi che sappiamo cosa stanno facendo.

Riflessioni conclusive

La capacità degli agenti di generare un percorso di passaggi logici con le azioni li avvicina molto al ragionamento umano. Dotarli di strumenti più potenti può dare loro dei superpoteri. Modelli come ReAct cercano di emulare il modo in cui gli esseri umani risolvono il problema e vedremo modelli di agenti migliori che saranno rilevanti per contesti e domini specifici (bancario, assicurativo, sanitario, industriale, ecc.). Il futuro è qui e la tecnologia alla base degli agenti è pronta per essere utilizzata. Allo stesso tempo, dobbiamo prestare molta attenzione ai guardrail dell’IA responsabile per assicurarci di non costruire Skynet!