L'angolo di Anderson

ChatGPT-5 e Gemini 2.5 allucinano nel 40% delle query testate nella redazione

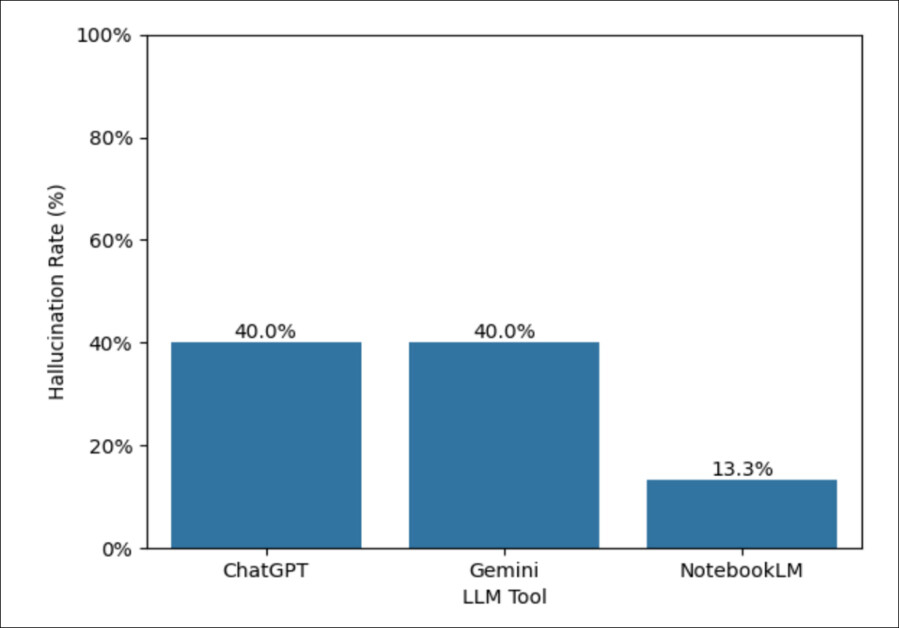

Un nuovo studio rileva che ChatGPT-5 e Google Gemini producono allucinazioni nel 40% delle query in stile redazione, spesso inventando affermazioni convincenti ma non comprovate da fatti verificabili. NotebookLM di Google ottiene risultati migliori, con solo il 13% di probabilità – una percentuale che farebbe comunque licenziare qualsiasi giornalista al mondo. Lo studio ha rilevato che i modelli spesso distorcono le fonti, trasformando le opinioni in fatti e privandoli di attribuzioni, rendendoli strumenti rischiosi per il giornalismo. Gli autori chiedono strumenti migliori e dedicati per questi compiti.

I modelli linguistici di grandi dimensioni hanno visto una rapida adozione nel giornalismo negli ultimi tempi, in ambienti di lavoro che hanno comunque ridotto costi, budget e personale sin dall'avvento del giornalismo digitale. craterizzati due secoli di tradizione Organizza una processo inesorabile che ha avuto inizio nei primi anni del 2000.

In realtà, il terreno era già fertile, poiché i media si erano abituati a tagliare posti di lavoro attraverso l'"innovazione" almeno fin dall'inizio. introduzione turbolenta della composizione digitale negli anni '1980, così come le sfide precedenti provenienti dal avvento della radio e televisione.

Tuttavia, il percorso incessante dell'intelligenza artificiale nelle redazioni e nei media non è stato privo di battute d'arresto; in un contesto in cui Il 55% delle aziende ora si pente di sostituire gli esseri umani con l'intelligenza artificiale, e dove Gartner predice che le organizzazioni ridurranno drasticamente i loro programmi di adozione dell'intelligenza artificiale entro due anni, diverse organizzazioni di notizie hanno riassunto I giornalisti sostituiti dall'intelligenza artificiale, come i gravi e spesso-imbarazzante sono emerse le carenze delle alternative basate sull'apprendimento automatico.

Errare non è solo umano

Anche se allucinazioni si sono rivelati un problema enorme per i campi in cui la citazione accurata è essenziale (con una notevole attenzione pubblica per i casi di fallimento dell'IA nel legge, riparazioni e giornalismo settori), un nuovo studio statunitense ha scoperto che l'apprendimento automatico nel giornalismo deve affrontare sfide più ampie del previsto.

La ricerca degli autori ha valutato ChatGPT, Google Gemellie più incentrato sulle citazioni NotebookLM su un compito di tipo giornalistico: utilizzando un corpus di 300 documenti incentrato sui contenziosi e sulle politiche di TikTok negli Stati Uniti.

I ricercatori hanno variato la specificità dei prompt e il numero di documenti forniti, quindi hanno analizzato i risultati utilizzando una tassonomia progettata per catturare il tipo e la gravità delle allucinazioni.

In tutti gli output, il 30% conteneva almeno un'allucinazione, mentre ChatGPT e Gemini hanno mostrato ciascuno un 40% tasso di allucinazioni: poco più di tre volte superiore al tasso di errore del 13% di NotebookLM.

Piuttosto che inventare fatti o entità, notano i ricercatori, i modelli spesso mostravano eccessiva sicurezza interpretativa, aggiungendo caratterizzazioni non supportate e trasformando le opinioni attribuite in affermazioni generali:

'Qualitativamente, la maggior parte degli errori non riguardava entità o numeri inventati; al contrario, abbiamo osservato un eccesso di sicurezza interpretativa: i modelli aggiungevano caratterizzazioni non supportate delle fonti e trasformavano le opinioni attribuite in affermazioni generali.

Questi modelli rivelano una fondamentale discrepanza epistemologica: mentre il giornalismo richiede una fonte esplicita per ogni affermazione, gli LLM generano testi che sembrano autorevoli indipendentemente dal supporto probatorio.

"Proponiamo estensioni specifiche per il giornalismo alle tassonomie delle allucinazioni esistenti e sosteniamo che gli strumenti efficaci per le redazioni necessitano di architetture che impongano un'attribuzione accurata anziché ottimizzare la fluidità".

. nuovo studio, una lettura affascinante ma breve di cinque pagine, è intitolata Non è sbagliato, ma è falso: l'eccessiva sicurezza dell'LLM nelle query basate sui documentie proviene da tre ricercatori della Northwestern University e dell'Università del Minnesota.

Teoria e metodo

La causa esatta delle allucinazioni* è controversa in vari momenti; sebbene quasi tutte le teorie concordino sul fatto che la qualità e/o la distribuzione dei dati siano un fattore contribuente al momento dell'allenamento, ha addirittura stato proposto che il 100% dell'output LLM è essenzialmente allucinazione (tranne il fatto che alcune di queste allucinazioni coincidono con la realtà).

Gli autori osservano†:

"Da una prospettiva tecnica, le allucinazioni emergono dalla capacità degli LLM di generare testo che segue schemi comuni senza possedere un Guida alle di ciò che è vero. Questa caratteristica si traduce in risposte apparentemente plausibili che non riflettono la realtà, ad esempio la giurisprudenza inventata dagli LLM che si fa strada nelle discussioni.

"E mentre le capacità LLM sono aumentate drasticamente negli ultimi cinque anni, le allucinazioni rimangono un problema, in alcuni casi addirittura in aumento man mano che i modelli diventano Scopri di più capace. '

Il settore della ricerca, osserva il documento, ha esplorato diversi modi per ridurre o comprendere meglio le allucinazioni LLM, che tendono a rientrare in tre aree principali: in primo luogo, in contesto, i modelli possono basarsi su fonti esterne quali database, raccolte di documenti o contenuti web per supportare le loro affermazioni.

Questo metodo funziona bene quando il materiale è affidabile e completo, ma lacune, informazioni obsolete o dati di scarsa qualità causano comunque errori; inoltre, i modelli tendono a fare affermazioni convincenti che vanno oltre ciò che effettivamente affermano le fonti.

In secondo luogo, suggerimento e decodifica Si riferisce all'uso di istruzioni precise per guidare i modelli. Questo può comportare la richiesta ai modelli di verificare le proprie prove, suddividere i compiti in fasi più piccole o seguire formati più rigorosi. A volte i modelli vengono persino invitati a rivedere il proprio lavoro o a confrontare più risposte.

Queste tecniche possono individuare gli errori, ma aumentano anche i costi e spesso non riescono a individuare errori sottili; pertanto, senza un controllo affidabile delle prove, gran parte dell'onere della verifica ricade ancora sull'utente.

In terzo luogo, modelli e strumenti si riferisce alla possibilità di dare agli LLM accesso a risorse che possono supportare la verifica, come motori di ricerca o calcolatrici, sebbene la precisione possa anche migliorare quando i modelli vengono addestrati su dati ben documentati o quando vengono integrate funzionalità di citazione.

Tuttavia, queste misure non sono infallibili e si basano ancora sulla qualità delle fonti, sulla chiarezza delle linee guida e sulla supervisione umana, per impedire la diffusione di informazioni false.

TikTok

Per scoprire quali approcci potrebbero essere effettivamente utili per i giornalisti, lo studio ha effettuato delle valutazioni progettate per riflettere i flussi di lavoro e gli standard reali delle redazioni, esaminando l'allucinazione nel contesto delle tipiche attività di informazione.

I modelli di frontiera sono stati testati utilizzando strategie di sollecitazione comuni e configurazioni di fondamento dei documenti, in modo da poter misurare sia la frequenza che il tipo di errori di allucinazione, insieme al significato effettivo di tali errori per l'integrazione dell'intelligenza artificiale nelle redazioni.

L'analisi si è concentrata sul tipo di interrogazione basata su documenti tipica del giornalismo investigativo e di ricerca. Gli autori hanno cercato di curare un corpus che riflettesse un tipico progetto di redazione di piccole e medie dimensioni, ma che fosse comunque sufficientemente ampio da catturare la complessità del giornalismo reale; a tal fine, hanno selezionato sforzo legale in corso per vietare TikTok negli Stati Uniti.

I documenti sono stati raccolti dal Il Washington Post, l' New York Times, ProQueste westlaw, che ha portato alla creazione di una raccolta di 300 documenti comprendente cinque articoli accademici, 150 articoli di giornale e 145 documenti legali (con la compilazione completa disponibile ai ricercatori accademici su richiesta tramite il progetto deposito).

Poiché le risposte LLM dipendono fortemente dal modo in cui viene formulata una richiesta e dal contesto fornito, gli autori hanno ideato cinque quesiti che vanno da molto ampi a molto specifici: da domande generali sui divieti di TikTok a richieste dettagliate che richiedono testimonianze da casi giudiziari specifici.

Il numero di documenti forniti a ciascun modello è stato variato a 10, 100 o tutti i 300, dall'intero corpus, con due documenti chiave inclusi in ciascun campione, per garantire la coerenza. Sono state prodotte quindici risposte per ciascun modello, ad eccezione di ChatGPT, per il quale è stato previsto un limite di dieci risposte.

Contenders

Sono stati testati tre strumenti, ognuno dei quali riflette un approccio diverso alle query basate sui documenti: ChatGPT‑5 è stato valutato utilizzando il Caratteristica dei progetti, che limitava i caricamenti a 100 documenti; Google Gemini 2.5 Pro è stato in grado di elaborare l'intero corpus di 300 documenti nel contesto (utilizzando la sua finestra di contesto di un milione di token per acquisire direttamente tutti i 923,000 token); Google NotebookLM, che offre il recupero integrato delle citazioni, è stato testato utilizzando notebook dedicati per ciascun campione.

Sebbene questi metodi di gestione dei documenti siano diversi, tutti e tre rappresentano strumenti reali attualmente a disposizione dei giornalisti; e in ogni caso, lo stato dell'arte è attualmente più sperimentale che omogeneo, con parità di funzionalità e portata inevitabilmente diverse tra le offerte attuali.

Per catturare la gamma di possibili comportamenti allucinatori, una tassonomia da un lavori precedenti al 2023 è stato utilizzato, con allucinazioni codificate da orientamento (distorsione vs. elaborazione); categoria (tipo di errore); e grado (gravità valutata come mite, moderata, o allarmante).

Tutti i risultati del modello sono stati annotati da un autore umano, che ha esaminato ogni frase e applicato questi codici. Gli errori non coperti dalla tassonomia sono stati contrassegnati come miscellaneoe successivamente analizzati per sviluppare categorie specifiche del giornalismo.

Dati e test

Nel test iniziale per prevalenza delle allucinazioni, 12 delle 40 risposte modello hanno mostrato di contenere almeno un'allucinazione, con notevoli variazioni tra gli strumenti. ChatGPT e Gemini hanno prodotto allucinazioni nel 40% dei loro output, mentre NotebookLM ha prodotto allucinazioni solo nel 13% dei casi:

Percentuali complessive di allucinazioni per ogni strumento, con Gemini e ChatGPT che producono la percentuale più alta di risposte contenenti errori. Fonte: https://arxiv.org/pdf/2509.25498

Di questi risultati, gli autori commentano:

"Ciò indica che, sebbene la maggior parte delle risposte fornite da tutti gli strumenti non contenga allucinazioni, la scelta dello strumento fa la differenza per lo stesso corpus di documenti e set di query."

Le allucinazioni raramente si verificano isolatamente, osserva l'articolo; Gemini ne ha registrate in media quattro per risposta errata, NotebookLM tre e ChatGPT 1.5. La maggior parte era di gravità moderata, ma il 14% è stato classificato come allarmanteIn un caso, ChatGPT ha inventato un movente di ritorsione dietro il ban di TikTok che non compare nella fonte:

"[In] una query ChatGPT ha inquadrato un potenziale divieto di TikTok come una misura reciproca da parte dei legislatori statunitensi in risposta alla politica cinese, un'affermazione del tutto assente dal documento originale citato."

Nel complesso, il 64% delle risposte allucinatorie presentava inesattezze fattuali o divagazioni, sollevando potenzialmente dubbi sul fatto che l'uso dell'LLM consenta effettivamente di risparmiare tempo in questo tipo di flusso di lavoro basato sulle informazioni, almeno allo stato attuale della tecnica.

In questo test iniziale, la maggior parte delle allucinazioni non rientrava nelle categorie tassonomiche esistenti, spesso comportando citazioni inventate o espansioni di acronimi errate, il che suggerisce che gli attuali quadri normativi potrebbero essere troppo ristretti per i casi d'uso giornalistici.

Il tasso di allucinazioni più basso di NotebookLM, osservano gli autori, suggerisce che il suo utilizzo basato sulle citazioni RAG Il sistema fornisce una base più affidabile rispetto alla funzionalità Progetti di ChatGPT o all'elaborazione contestuale di Gemini, soprattutto quando è necessario fare riferimento a documenti specifici.

Per quanto riguarda lo studio delle caratteristiche qualitative delle allucinazioni osservate nei risultati dei test, i ricercatori osservano che le allucinazioni non derivavano principalmente da fatti inventati, ma da eccesso interpretativo:

"I modelli hanno aggiunto caratterizzazioni convincenti sugli scopi del documento, sul pubblico e sulle intenzioni del relatore, che apparivano autorevoli ma non avevano alcun fondamento nel testo effettivo. Hanno trasformato affermazioni provvisorie o attribuite in affermazioni definitive."

L'eccesso di sicurezza assumeva due forme: in primo luogo, i modelli aggiungevano affermazioni non supportate sul pubblico o sullo scopo di un documento, come etichettare un articolo come "scritto per il pubblico" o un documento come "rivolto agli avvocati".

In secondo luogo, hanno convertito le opinioni attribuite in affermazioni simili a fatti, oscurando la fonte originale e compromettendo la valutazione della fonte.

Questi comportamenti sono apparsi in tutti gli strumenti e non erano limitati a un'architettura, e la maggior parte degli errori non erano fabbricazioni, ma piuttosto, sovrainterpretazioni.

La maggior parte delle allucinazioni venivano etichettate come miscellaneo, perché non rientravano nelle categorie esistenti, offuscando le differenze chiave tra i tipi di errore. Problemi frequenti come attribuzione mancante e le vaghe descrizioni delle fonti suggeriscono che le attuali tassonomie non tengono conto dei tipi di errori più importanti nel giornalismo, dove è essenziale una fonte chiara.

Lo osservano gli autori "I modelli aggiungono analisi affidabili che i documenti non supportano e eliminano attribuzioni cruciali".

Conclusione

Chiunque abbia sperimentato i tre modelli studiati nel nuovo articolo saprà che ognuno ha i suoi punti deboli e di forza. Sebbene NotebookLM offra prestazioni di gran lunga superiori in termini di citazioni rispetto a ChatGPT o Gemini, si potrebbe considerare che sia stato progettato specificamente per questa funzionalità e che continui a presentare un tasso di errore tale da far licenziare la maggior parte dei giornalisti, ricercatori o avvocati, con episodi ripetuti.

Inoltre, NotebookLM, pur posizionandosi come framework di ricerca, non presenta molti dei perfezionamenti UX che rendono le altre due piattaforme un'esperienza di scrittura più semplice.

Tuttavia, almeno NotebookLM sembra effettivamente leggere i documenti caricati, invece di cadere nell'abitudine incredibilmente distruttiva di ChatGPT di dedurre cosa potrebbe dire un documento caricato, basandosi su ciò che conosce sulla distribuzione generale di documenti simili. Può essere arduo far sì che qualsiasi versione di ChatGPT esegua una lettura full-text del materiale caricato, invece di basarsi sui metadati o sulle proprie presunzioni/allucinazioni.

Per i settori in cui gli standard di provenienza e citazione sono fondamentali, come il diritto, il giornalismo e la ricerca scientifica, sembra che non ci siano addestrato in modo nativo strutture negli attuali LLM leader di mercato che possono migliorare la loro limitata capacità di estrarre e gestire con precisione le informazioni a cui l'utente le indirizza.

Allo stato attuale, e in attesa dell'arrivo di sistemi ausiliari in grado di offrire un'interfaccia migliore agli LLM rispetto a un semplice richiesta del sistema or Impostazione MCP, tutto ciò che questi sistemi producono per questi settori critici per la missione deve ancora essere controllato da quegli esseri umani costosi, goffi e generalmente fastidiosi.

* Google Cloud offre una panoramica abbastanza interessante e approfondita sull'argomento Qui..

† La mia conversione delle citazioni in linea degli autori in collegamenti ipertestuali.

Pubblicato per la prima volta mercoledì 1 ottobre 2025. Modificato giovedì 2 ottobre per correggere un errore in TL:DR e correggere un errore stilistico nel primo paragrafo.